- 神经网络初步学习3——数据与损失

X Y O

神经网络学习人工智能

一、传统机器学习与神经网络前言:该部分需要一定的机器学习与数学基础(很浅的基础),如果有不理解的地方可以自行查阅。(1)区别这里不妨以图像识别为例子:(1)在传统的机器学习视角中:我们需要人工手动去设置并提取我们的特征量,例如常见的SIFT、SURF和HOG等,随后需要我们选择合适的分类器(例如:SVM、KNN等分类器),接着把我们的参数训练出来。(2)而在神经网络的视角中:我们只需要把图片喂给它

- AI驱动的个人工作革命:基于DeepSeek构建全场景智能工作助理(含源代码+多应用场景)

AI_DL_CODE

DeepSeek深度应用人工智能DeepSeek个人智能助理LangChain任务自动化知识管理大模型应用

摘要:本文详细阐述基于DeepSeek大模型构建个人工作助理的完整技术方案,通过LangChain实现任务分解、知识检索与工具调用的智能协同。方案融合向量数据库、多模态交互与个性化学习算法,构建涵盖邮件处理、会议管理、文档生成等15大核心工作场景的自动化系统。文中提供可运行代码、完整部署指南及效能测试数据,实现邮件处理效率提升13倍、会议纪要生成时间缩短100%、任务安排错误率降低83%的显著优化

- 异物检测的计算机视觉算法技术路线

思绪漂移

计算机视觉算法人工智能

异物检测的计算机视觉算法技术路线在现代智能监测系统中,异物检测有着其必要性和运维重要性,通过计算机视觉算法,可以实时识别各种异常物体,为设备安全运行提供有力保障。本文将介绍异物检测的主要技术路线。一、分类识别适应场景分类识别技术主要适用于已知目标类别的异物检测场景。在运维环境中,这类场景包括:固定区域内的障碍物监测(如轨道区域的石块、工具、动物等)关键部件的异物附着检测(如固定装置上的杂物)安全通

- PageRank:互联网的马尔可夫链平衡态

大千AI助手

人工智能Python#OTHER人工智能机器学习条件概率贝叶斯PageRank马尔科夫链MC

本文由「大千AI助手」原创发布,专注用真话讲AI,回归技术本质。拒绝神话或妖魔化。搜索「大千AI助手」关注我,一起撕掉过度包装,学习真实的AI技术!PageRank算法本质上是一个在网页图上定义的离散时间马尔可夫链(DTMC),其核心思想是将网页间的链接关系转化为状态转移概率。以下是详细分析:一、马尔可夫链的核心要素在PageRank中的体现马尔可夫链要素PageRank对应数学描述状态空间网页集

- MCMC:高维概率采样的“随机游走”艺术

大千AI助手

人工智能Python#OTHER人工智能数据挖掘机器学习算法MCMC马尔科夫概率论

MCMC(马尔可夫链蒙特卡洛)是一种从复杂概率分布中高效采样的核心算法,它解决了传统采样方法在高维空间中的“维度灾难”问题。以下是其技术本质、关键算法及实践的深度解析:本文由「大千AI助手」原创发布,专注用真话讲AI,回归技术本质。拒绝神话或妖魔化。搜索「大千AI助手」关注我,一起撕掉过度包装,学习真实的AI技术!一、MCMC要解决的核心问题目标:从目标分布(π(x)\pi(\mathbf{x})

- LeetCode 刷题:数据结构与算法的实战经验分享

LeetCode刷题:数据结构与算法的实战经验分享关键词:LeetCode、数据结构、算法、刷题经验、实战摘要:本文将围绕LeetCode刷题展开,深入探讨数据结构与算法在实际刷题过程中的应用。通过分享实战经验,帮助读者更好地理解和掌握数据结构与算法知识,提升解题能力。文章将从背景介绍入手,阐述刷题的目的和意义,接着详细解释核心概念,分析它们之间的关系,然后介绍核心算法原理和具体操作步骤,结合数学

- 高压电缆护层电流监测系统的技术实现

李子圆圆

人工智能

目录文章目录概要高精度电流监测的技术实现多级预警机制的构建逻辑极端环境下的稳定运行技术远程运维的技术支撑概要高压电缆护层作为电力传输的关键防护结构,其接地电流的异常变化是判断设备状态的重要指标。TLKS-PLGD高压电缆护层电流监测系统通过传感器技术与智能算法的结合,构建了一套完整的电缆安全监测方案。高精度电流监测的技术实现高精度电流监测的技术实现护层电流监测的核心在于数据采集的精准性。该系统采用

- 构建安全密码存储策略:核心原则与最佳实践

weixin_47233946

信息安全安全

密码是用户身份认证的第一道防线,其存储安全性直接关系到用户隐私和企业信誉。近年来频发的数据泄露事件揭示了密码管理的关键性。本文将深入探讨从加密算法到系统性防护的完整密码存储方案,帮助开发者构建企业级安全防御体系。一、密码存储基本准则绝对禁止明文存储:即使采用数据库加密措施,直接存储用户原始密码仍存在不可逆泄露风险。运维人员权限滥用或备份文件泄露都可能成为突破口。加密≠安全:AES等对称加密存在密钥

- 数据结构实验解析(C++版)——实验一 复杂度分析

拯救三金

数据结构c++算法

目录一、实验例题例题1例题2二、实验原理与背景知识1、实验原理2、背景知识三、解题思路与算法1、解题思路2、算法四、代码实现例题1代码例题2代码五、实验结果分析与总结1、实验结果分析2、该实验与数据结构的联系一、实验例题例题1时间空间限制时间限制:1SEC空间限制:128MB问题描述分析以下代码:for(i=1;iusingnamespacestd;intmain(){longlongn;//输入

- Spring Data Neo4j 与后端人工智能算法的数据交互

AI大模型应用实战

springneo4j人工智能ai

SpringDataNeo4j与后端人工智能算法的数据交互关键词:SpringDataNeo4j、图数据库、人工智能算法、数据交互、知识图谱、图神经网络、数据集成摘要:本文深入探讨了如何利用SpringDataNeo4j框架实现后端人工智能算法与图数据库的高效数据交互。文章首先介绍了图数据库和人工智能算法的基本概念,然后详细解析了SpringDataNeo4j的核心架构和原理。接着,通过实际代码示

- 【数据结构】复杂度分析

目录一、算法1.基本概念2.描述方法3.算法效率二、算法的时间复杂度三、算法的空间复杂度一、算法1.基本概念通俗的讲,算法是解决问题的方法,比如在现实生活中一道菜谱,一个安装轮椅的操作指南等。严格的说,算法是对特定问题求解步骤的一种描述,是指令的有限序列。算法具有的基本特性有:(1)有穷性。一个算法必须总是在执行有穷步之后结束,且每一步都在有求时间内完成。(2)确定性。算法中的每一条指令必须有确切

- 视觉算法之卷积神经网络

清风AI

深度学习算法详解及代码复现计算机视觉cnn神经网络深度学习python课程设计毕业设计

定义与特点卷积神经网络(ConvolutionalNeuralNetwork,CNN)是一种专为处理具有网格结构的数据而设计的深度学习模型。其独特的结构和功能使其在图像处理、语音识别等领域展现出卓越的性能:CNN的核心设计理念源于对生物视觉系统的模仿。通过模拟大脑皮层中视网膜和视觉皮层的层次化结构,CNN能够有效地捕捉图像中的局部特征并逐步抽象为高层语义信息。这种设计使得CNN特别擅长处理图像和音

- 心理健康语音分析AI模型:开启心理评估新时代

AI大模型应用实战

人工智能语音识别ai

心理健康语音分析AI模型:开启心理评估新时代关键词:心理健康评估、语音信号处理、情感计算、AI模型、多模态融合摘要:传统心理评估依赖量表问卷和人工观察,存在主观性强、效率低、难以实时监测等局限。本文将带您走进“心理健康语音分析AI模型”的世界,从基础概念到核心技术,从算法原理到实战案例,揭秘AI如何通过“听声音”读懂心理状态,开启心理评估的智能化新时代。背景介绍目的和范围心理健康问题已成为全球公共

- MySQL存储结构深度解析:Buffer Pool与Page管理

hdzw20

mysql复习mysql数据库

MySQL存储结构解析:BufferPool与Page管理在MySQL的InnoDB存储引擎中,BufferPool是其核心组件之一,它极大地提升了数据库的性能。理解BufferPool的内部结构和工作机制,对于优化MySQL数据库至关重要。本文将讨论BufferPool的结构、三大链表、改进型LRU算法以及ChangeBuffer机制。1.BufferPool结构:控制块与缓存页BufferPo

- 多模态大模型发展全景:从架构创新到应用突破

陈敬雷-充电了么-CEO兼CTO

python大模型多模态大模型AIGC机器学习深度学习DeepSeek

注:此文章内容均节选自充电了么创始人,CEO兼CTO陈敬雷老师的新书《GPT多模态大模型与AIAgent智能体》(跟我一起学人工智能)【陈敬雷编著】【清华大学出版社】《GPT多模态大模型与AIAgent智能体》新出书籍配套视频【陈敬雷】推荐算法系统实战全系列精品课【陈敬雷】文章目录GPT多模态大模型系列四多模态大模型发展全景:从架构创新到应用突破更多技术内容总结GPT多模态大模型系列四多模态大模型

- Python异步编程终极指南:用协程与事件循环重构你的高并发系统

title:Python异步编程终极指南:用协程与事件循环重构你的高并发系统date:2025/2/24updated:2025/2/24author:cmdragonexcerpt:深入剖析Python异步编程的核心机制。你将掌握:\n事件循环的底层实现原理与调度算法\nasync/await协程的6种高级用法模式\n异步HTTP请求的性能优化技巧(速度提升15倍+)\n常见异步陷阱的26种解决

- python程序基本架构_Python 程序基本架构

尤尔小喵喵

python程序基本架构

Python的一般程序基本架构为:输入,处理,输出,这三块。输入:包括两个内容,变量赋值与输入语句处理:包括算术运算,逻辑运算,算法处理这三方面输出:包括打印输出,写入文件,写入数据库这三块下面举两个例子具体了解一下Python的程序基本架构1输入:变量赋值处理:算术运算输出:打印输出x=12#变量赋值x=12y=13#变量赋值y=13z=x+y#算术运算print(z)#打印输出252输入:输入

- Hanbit便携式GIS局部放电检测仪中PRPD图的绘制方法研究

Hanbit便携式GIS局部放电检测仪中PRPD图的绘制方法研究摘要本报告详细阐述了韩国HanbitPoDAS便携式GIS局部放电检测仪软件中相分辨局部放电(PRPD)图的生成方法。报告旨在阐明其技术原理、数据采集、信号处理以及分析功能,这些功能共同实现了对气体绝缘开关设备(GIS)绝缘状态的精确评估。HanbitPoDAS系统利用超高频(UHF)传感器和智能软件算法来捕获、处理并显示PRPD模式

- 如何让AI真正理解你的意图(自适应Prompt实战指南)

nine是个工程师

大语言模型人工智能prompt

目前的LLM模型,在理解用户意图方面,正在使用自适应Prompt技术,来提升模型的理解能力。目前使用deepseek推理模型能明显看到自适应的一个过程。前言:为什么你的AI总是"答非所问"?相信很多人都遇到过这样的情况:你问:“帮我写一个Python爬虫”AI答:给你一堆理论知识和完整教程(你只想要简单代码)你问:“推荐一部电影”AI答:推荐了《教父》(你想看轻松喜剧)你问:“解释一下机器学习”A

- AI人工智能与机器学习的大数据融合应用

AI智能探索者

人工智能机器学习大数据ai

AI人工智能与机器学习的大数据融合应用关键词:AI人工智能、机器学习、大数据、融合应用、数据挖掘摘要:本文深入探讨了AI人工智能与机器学习在大数据融合应用方面的相关内容。首先介绍了研究的背景、目的、预期读者和文档结构,对核心术语进行了清晰定义。接着阐述了AI、机器学习和大数据的核心概念及相互联系,给出了形象的文本示意图和Mermaid流程图。详细讲解了核心算法原理,并通过Python源代码进行说明

- 目标检测YOLO实战应用案例100讲-基于深度学习的自动驾驶目标检测算法研究(续)

林聪木

目标检测YOLO深度学习

目录基于双蓝图卷积的轻量化自动驾驶目标检测算法5.1引言5.2DarkNet53网络冗余性分析5.3双蓝图卷积网络5.4实验结果及分析基于深度学习的自动驾驶目标检测算法研究与应用传统的目标检测算法目标检测基线算法性能对比与选择相关理论和算法基础2.1引言2.2人工神经网络2.3FCOS目标检测算法2.4复杂交通场景下的目标检测难点与FCOS改进方案基于FCOS的目标检测算法改进3.1引言3.2Re

- 百度地图迁徙大数据深度解析与实战指南

百度地图迁徙大数据深度解析与实战指南在数字化时代,人口流动数据已成为洞察社会经济活动的关键指标。百度地图依托海量位置数据和AI算法打造的"迁徙大数据"平台,为城市规划、交通管理、商业选址等领域提供了重要决策支持。本文将系统性解析百度地图迁徙大数据的查看方法、核心功能及实战应用场景,帮助读者快速掌握这一数据驱动的决策工具。一、迁徙大数据的核心价值迁徙大数据通过聚合手机用户的定位信息,构建全国范围的人

- AI人工智能遇上TensorFlow:技术融合新趋势

AI大模型应用之禅

人工智能tensorflowpythonai

AI人工智能遇上TensorFlow:技术融合新趋势关键词:人工智能、TensorFlow、深度学习、神经网络、机器学习、技术融合、AI开发摘要:本文深入探讨了人工智能技术与TensorFlow框架的融合发展趋势。我们将从基础概念出发,详细分析TensorFlow在AI领域的核心优势,包括其架构设计、算法实现和实际应用。文章包含丰富的技术细节,如神经网络原理、TensorFlow核心算法实现、数学

- 基于FPGA的快速傅里叶变换(FFT)设计在嵌入式系统中的应用

风吹麦很

fpga开发嵌入式

基于FPGA的快速傅里叶变换(FFT)设计在嵌入式系统中的应用快速傅里叶变换(FastFourierTransform,FFT)是一种重要的信号处理算法,在许多领域中都得到广泛的应用,例如通信系统、雷达技术、图像处理等。为了提高FFT的计算性能和实时性,将其设计为硬件加速器常常是一个明智的选择。本文将介绍基于现场可编程门阵列(Field-ProgrammableGateArray,FPGA)的FF

- AI人工智能领域中AI作画的技术优势

AI大模型应用之禅

人工智能AI作画ai

AI人工智能领域中AI作画的技术优势关键词:AI作画、技术优势、人工智能、艺术创作、图像生成摘要:本文深入探讨了AI人工智能领域中AI作画的技术优势。从背景介绍出发,阐述了AI作画的起源与发展,明确了文章的目的、范围、预期读者以及文档结构。接着详细分析了AI作画的核心概念,包括其原理和架构,并通过Mermaid流程图进行直观展示。对核心算法原理进行了深入剖析,结合Python代码示例进行讲解。同时

- 让 Python 代码飙升330倍:从入门到精通的四种性能优化实践

python

花下猫语:性能优化是每个程序员的必修课,但你是否想过,除了更换算法,还有哪些“大招”?这篇文章堪称典范,它将一个普通的函数,通过四套组合拳,硬生生把性能提升了330倍!作者不仅展示了“术”,更传授了“道”。让我们一起跟随作者的思路,体验一次酣畅淋漓的优化之旅。PS.本文选自最新一期Python潮流周刊,如果你对优质文章感兴趣,诚心推荐你订阅我们的专栏。作者:ItamarTurner-Traurin

- 2025B卷 - 华为OD机试七日集训第5期 - 按算法分类,由易到难,循序渐进,玩转OD

哪 吒

搬砖工逆袭Java架构师华为od算法华为OD机试2025B卷java

目录推荐刷题方法:一、适合人群二、本期训练时间三、如何参加四、七日集训第5期五、精心挑选21道高频100分经典题目,作为入门。第1天、逻辑分析第2天、逻辑分析第3天、逻辑分析第4天、字符串处理第5天、正则表达式第6天、深度优先搜索dfs第7天、深度优先搜索dfs六、集训总结国内直接使用ChatGPT4o、o3、o4-mini-high、GPT-4.5、GPT4.1、Gemini2.5pro0605

- 2025B卷 - 华为OD机试七日集训第4期 - 按算法分类,由易到难,循序渐进,玩转OD(Python/JS/C/C++)

哪 吒

搬砖工逆袭Java架构师华为od算法python华为OD机试2025B卷

目录推荐刷题方法:一、适合人群二、本期训练时间三、如何参加四、七日集训第4期五、精心挑选21道高频100分经典题目,作为入门。第1天、逻辑分析第2天、逻辑分析第3天、逻辑分析第4天、贪心算法第5天、二分查找第6天、字符串处理第7天、字符串处理六、集训总结国内直接使用ChatGPT4o、o3、o4-mini-high、GPT-4.5、GPT4.1、Gemini2.5pro0605、ClaudeSon

- 2025B卷 - 华为OD机试七日集训第2期 - 按算法分类,由易到难,循序渐进,玩转OD(Python/JS/C/C++)

目录推荐刷题方法:一、适合人群二、本期训练时间三、如何参加四、七日集训第2期五、精心挑选21道高频100分经典题目,作为入门。第1天、逻辑分析第2天、数组第3天、双指针第4天、贪心算法第5天、字符串处理第6天、深度优先搜索DFS第7天、动态规划六、集训总结国内直接使用ChatGPT4o、o3、o4-mini-high、GPT-4.5、GPT4.1、Gemini2.5pro0605、ClaudeSo

- 华为OD机试专栏--1.3 算法基础:1.3.3 动态规划入门

xiaoheshang_123

华为OD机试真题题库解析华为od面试职场和发展算法

目录1.3算法基础1.3.3动态规划入门一、动态规划的核心思想1.1什么是动态规划?1.2动态规划的特点二、动态规划的基本步骤三、经典动态规划问题3.1斐波那契数列(FibonacciSequence)问题描述动态规划解法代码实现(Python)3.2背包问题(KnapsackProblem)问题描述动态规划解法代码实现(Python)3.3最长公共子序列(LongestCommonSubsequ

- 面向对象面向过程

3213213333332132

java

面向对象:把要完成的一件事,通过对象间的协作实现。

面向过程:把要完成的一件事,通过循序依次调用各个模块实现。

我把大象装进冰箱这件事为例,用面向对象和面向过程实现,都是用java代码完成。

1、面向对象

package bigDemo.ObjectOriented;

/**

* 大象类

*

* @Description

* @author FuJian

- Java Hotspot: Remove the Permanent Generation

bookjovi

HotSpot

openjdk上关于hotspot将移除永久带的描述非常详细,http://openjdk.java.net/jeps/122

JEP 122: Remove the Permanent Generation

Author Jon Masamitsu

Organization Oracle

Created 2010/8/15

Updated 2011/

- 正则表达式向前查找向后查找,环绕或零宽断言

dcj3sjt126com

正则表达式

向前查找和向后查找

1. 向前查找:根据要匹配的字符序列后面存在一个特定的字符序列(肯定式向前查找)或不存在一个特定的序列(否定式向前查找)来决定是否匹配。.NET将向前查找称之为零宽度向前查找断言。

对于向前查找,出现在指定项之后的字符序列不会被正则表达式引擎返回。

2. 向后查找:一个要匹配的字符序列前面有或者没有指定的

- BaseDao

171815164

seda

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.SQLException;

import java.sql.PreparedStatement;

import java.sql.ResultSet;

public class BaseDao {

public Conn

- Ant标签详解--Java命令

g21121

Java命令

这一篇主要介绍与java相关标签的使用 终于开始重头戏了,Java部分是我们关注的重点也是项目中用处最多的部分。

1

- [简单]代码片段_电梯数字排列

53873039oycg

代码

今天看电梯数字排列是9 18 26这样呈倒N排列的,写了个类似的打印例子,如下:

import java.util.Arrays;

public class 电梯数字排列_S3_Test {

public static void main(S

- Hessian原理

云端月影

hessian原理

Hessian 原理分析

一. 远程通讯协议的基本原理

网络通信需要做的就是将流从一台计算机传输到另外一台计算机,基于传输协议和网络 IO 来实现,其中传输协议比较出名的有 http 、 tcp 、 udp 等等, http 、 tcp 、 udp 都是在基于 Socket 概念上为某类应用场景而扩展出的传输协

- 区分Activity的四种加载模式----以及Intent的setFlags

aijuans

android

在多Activity开发中,有可能是自己应用之间的Activity跳转,或者夹带其他应用的可复用Activity。可能会希望跳转到原来某个Activity实例,而不是产生大量重复的Activity。

这需要为Activity配置特定的加载模式,而不是使用默认的加载模式。 加载模式分类及在哪里配置

Activity有四种加载模式:

standard

singleTop

- hibernate几个核心API及其查询分析

antonyup_2006

html.netHibernatexml配置管理

(一) org.hibernate.cfg.Configuration类

读取配置文件并创建唯一的SessionFactory对象.(一般,程序初始化hibernate时创建.)

Configuration co

- PL/SQL的流程控制

百合不是茶

oraclePL/SQL编程循环控制

PL/SQL也是一门高级语言,所以流程控制是必须要有的,oracle数据库的pl/sql比sqlserver数据库要难,很多pl/sql中有的sqlserver里面没有

流程控制;

分支语句 if 条件 then 结果 else 结果 end if ;

条件语句 case when 条件 then 结果;

循环语句 loop

- 强大的Mockito测试框架

bijian1013

mockito单元测试

一.自动生成Mock类 在需要Mock的属性上标记@Mock注解,然后@RunWith中配置Mockito的TestRunner或者在setUp()方法中显示调用MockitoAnnotations.initMocks(this);生成Mock类即可。二.自动注入Mock类到被测试类 &nbs

- 精通Oracle10编程SQL(11)开发子程序

bijian1013

oracle数据库plsql

/*

*开发子程序

*/

--子程序目是指被命名的PL/SQL块,这种块可以带有参数,可以在不同应用程序中多次调用

--PL/SQL有两种类型的子程序:过程和函数

--开发过程

--建立过程:不带任何参数

CREATE OR REPLACE PROCEDURE out_time

IS

BEGIN

DBMS_OUTPUT.put_line(systimestamp);

E

- 【EhCache一】EhCache版Hello World

bit1129

Hello world

本篇是EhCache系列的第一篇,总体介绍使用EhCache缓存进行CRUD的API的基本使用,更细节的内容包括EhCache源代码和设计、实现原理在接下来的文章中进行介绍

环境准备

1.新建Maven项目

2.添加EhCache的Maven依赖

<dependency>

<groupId>ne

- 学习EJB3基础知识笔记

白糖_

beanHibernatejbosswebserviceejb

最近项目进入系统测试阶段,全赖袁大虾领导有力,保持一周零bug记录,这也让自己腾出不少时间补充知识。花了两天时间把“传智播客EJB3.0”看完了,EJB基本的知识也有些了解,在这记录下EJB的部分知识,以供自己以后复习使用。

EJB是sun的服务器端组件模型,最大的用处是部署分布式应用程序。EJB (Enterprise JavaBean)是J2EE的一部分,定义了一个用于开发基

- angular.bootstrap

boyitech

AngularJSAngularJS APIangular中文api

angular.bootstrap

描述:

手动初始化angular。

这个函数会自动检测创建的module有没有被加载多次,如果有则会在浏览器的控制台打出警告日志,并且不会再次加载。这样可以避免在程序运行过程中许多奇怪的问题发生。

使用方法: angular .

- java-谷歌面试题-给定一个固定长度的数组,将递增整数序列写入这个数组。当写到数组尾部时,返回数组开始重新写,并覆盖先前写过的数

bylijinnan

java

public class SearchInShiftedArray {

/**

* 题目:给定一个固定长度的数组,将递增整数序列写入这个数组。当写到数组尾部时,返回数组开始重新写,并覆盖先前写过的数。

* 请在这个特殊数组中找出给定的整数。

* 解答:

* 其实就是“旋转数组”。旋转数组的最小元素见http://bylijinnan.iteye.com/bl

- 天使还是魔鬼?都是我们制造

ducklsl

生活教育情感

----------------------------剧透请原谅,有兴趣的朋友可以自己看看电影,互相讨论哦!!!

从厦门回来的动车上,无意中瞟到了书中推荐的几部关于儿童的电影。当然,这几部电影可能会另大家失望,并不是类似小鬼当家的电影,而是关于“坏小孩”的电影!

自己挑了两部先看了看,但是发现看完之后,心里久久不能平

- [机器智能与生物]研究生物智能的问题

comsci

生物

我想,人的神经网络和苍蝇的神经网络,并没有本质的区别...就是大规模拓扑系统和中小规模拓扑分析的区别....

但是,如果去研究活体人类的神经网络和脑系统,可能会受到一些法律和道德方面的限制,而且研究结果也不一定可靠,那么希望从事生物神经网络研究的朋友,不如把

- 获取Android Device的信息

dai_lm

android

String phoneInfo = "PRODUCT: " + android.os.Build.PRODUCT;

phoneInfo += ", CPU_ABI: " + android.os.Build.CPU_ABI;

phoneInfo += ", TAGS: " + android.os.Build.TAGS;

ph

- 最佳字符串匹配算法(Damerau-Levenshtein距离算法)的Java实现

datamachine

java算法字符串匹配

原文:http://www.javacodegeeks.com/2013/11/java-implementation-of-optimal-string-alignment.html------------------------------------------------------------------------------------------------------------

- 小学5年级英语单词背诵第一课

dcj3sjt126com

englishword

long 长的

show 给...看,出示

mouth 口,嘴

write 写

use 用,使用

take 拿,带来

hand 手

clever 聪明的

often 经常

wash 洗

slow 慢的

house 房子

water 水

clean 清洁的

supper 晚餐

out 在外

face 脸,

- macvim的使用实战

dcj3sjt126com

macvim

macvim用的是mac里面的vim, 只不过是一个GUI的APP, 相当于一个壳

1. 下载macvim

https://code.google.com/p/macvim/

2. 了解macvim

:h vim的使用帮助信息

:h macvim

- java二分法查找

蕃薯耀

java二分法查找二分法java二分法

java二分法查找

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

蕃薯耀 2015年6月23日 11:40:03 星期二

http:/

- Spring Cache注解+Memcached

hanqunfeng

springmemcached

Spring3.1 Cache注解

依赖jar包:

<!-- simple-spring-memcached -->

<dependency>

<groupId>com.google.code.simple-spring-memcached</groupId>

<artifactId>simple-s

- apache commons io包快速入门

jackyrong

apache commons

原文参考

http://www.javacodegeeks.com/2014/10/apache-commons-io-tutorial.html

Apache Commons IO 包绝对是好东西,地址在http://commons.apache.org/proper/commons-io/,下面用例子分别介绍:

1) 工具类

2

- 如何学习编程

lampcy

java编程C++c

首先,我想说一下学习思想.学编程其实跟网络游戏有着类似的效果.开始的时候,你会对那些代码,函数等产生很大的兴趣,尤其是刚接触编程的人,刚学习第一种语言的人.可是,当你一步步深入的时候,你会发现你没有了以前那种斗志.就好象你在玩韩国泡菜网游似的,玩到一定程度,每天就是练级练级,完全是一个想冲到高级别的意志力在支持着你.而学编程就更难了,学了两个月后,总是觉得你好象全都学会了,却又什么都做不了,又没有

- 架构师之spring-----spring3.0新特性的bean加载控制@DependsOn和@Lazy

nannan408

Spring3

1.前言。

如题。

2.描述。

@DependsOn用于强制初始化其他Bean。可以修饰Bean类或方法,使用该Annotation时可以指定一个字符串数组作为参数,每个数组元素对应于一个强制初始化的Bean。

@DependsOn({"steelAxe","abc"})

@Comp

- Spring4+quartz2的配置和代码方式调度

Everyday都不同

代码配置spring4quartz2.x定时任务

前言:这些天简直被quartz虐哭。。因为quartz 2.x版本相比quartz1.x版本的API改动太多,所以,只好自己去查阅底层API……

quartz定时任务必须搞清楚几个概念:

JobDetail——处理类

Trigger——触发器,指定触发时间,必须要有JobDetail属性,即触发对象

Scheduler——调度器,组织处理类和触发器,配置方式一般只需指定触发

- Hibernate入门

tntxia

Hibernate

前言

使用面向对象的语言和关系型的数据库,开发起来很繁琐,费时。由于现在流行的数据库都不面向对象。Hibernate 是一个Java的ORM(Object/Relational Mapping)解决方案。

Hibernte不仅关心把Java对象对应到数据库的表中,而且提供了请求和检索的方法。简化了手工进行JDBC操作的流程。

如

- Math类

xiaoxing598

Math

一、Java中的数字(Math)类是final类,不可继承。

1、常数 PI:double圆周率 E:double自然对数

2、截取(注意方法的返回类型) double ceil(double d) 返回不小于d的最小整数 double floor(double d) 返回不大于d的整最大数 int round(float f) 返回四舍五入后的整数 long round

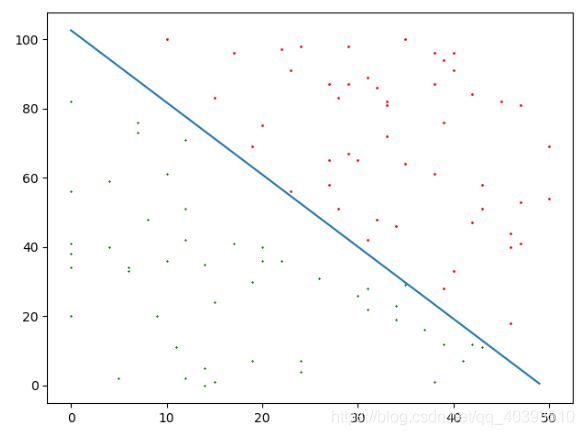

![]() 和

和 ![]() 设置为0,对误分类点

设置为0,对误分类点![]() 通过

通过![]()

![]()

![]() ,设修改了n次,则

,设修改了n次,则![]() 关于

关于![]() 的增量分别是

的增量分别是![]() 和

和![]() ,其中

,其中![]()

![]() 是该点是误分类点的次数,

是该点是误分类点的次数,![]() 是学习率,当

是学习率,当![]() 时,表示第i个实例点由于误分而进行更新的次数。

时,表示第i个实例点由于误分而进行更新的次数。![]() 时,

时,![]() 的值其实只与误分类点有关,学习率是常数。

的值其实只与误分类点有关,学习率是常数。 就是前面的

就是前面的![]() ,之前一直看不懂,理解这个就好了,可以看出w最终与误分类点和该点被误分类的次数有关,

,之前一直看不懂,理解这个就好了,可以看出w最终与误分类点和该点被误分类的次数有关,![]() 用矩阵计算好然后记录 点被误分类的次数就可以了,然后注意到

用矩阵计算好然后记录 点被误分类的次数就可以了,然后注意到

![]() 可以用矩阵先计算好,这个矩阵就是Gram矩阵(Gram matrix):

可以用矩阵先计算好,这个矩阵就是Gram矩阵(Gram matrix):![]()