损失函数篇:L1、L2、smooth L1损失函数

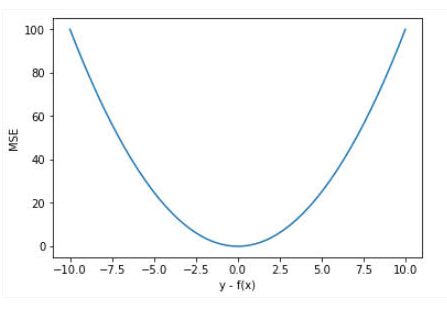

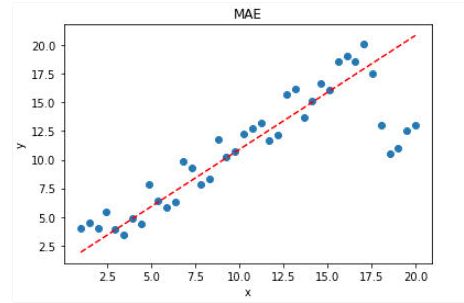

可见,使用 MSE 损失函数,受离群点的影响较大,虽然样本中只有 5 个离群点,但是拟合的直线还是比较偏向于离群点。

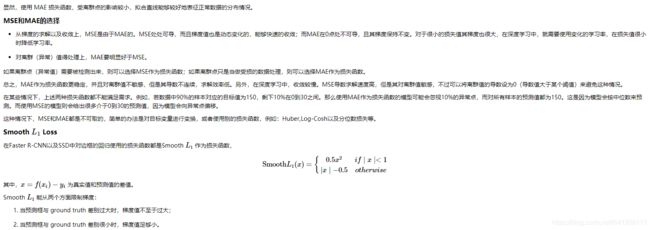

从上面可以看出,该函数实际上就是一个分段函数,在[-1,1]之间实际上就是L2损失,这样解决了L1的不光滑问题,在[-1,1]区间外,实际上就是L1损失,这样就解决了离群点梯度爆炸的问题

实现 (PyTorch)

def _smooth_l1_loss(input, target, reduction='none'):

# type: (Tensor, Tensor) -> Tensor

t = torch.abs(input - target)

ret = torch.where(t < 1, 0.5 * t ** 2, t - 0.5)

if reduction != 'none':

ret = torch.mean(ret) if reduction == 'mean' else torch.sum(ret)

return ret

也可以添加个参数beta 这样就可以控制,什么范围的误差使用MSE,什么范围内的误差使用MAE了。

def smooth_l1_loss(input, target, beta=1. / 9, reduction = 'none'):

"""

very similar to the smooth_l1_loss from pytorch, but with

the extra beta parameter

"""

n = torch.abs(input - target)

cond = n < beta

ret = torch.where(cond, 0.5 * n ** 2 / beta, n - 0.5 * beta)

if reduction != 'none':

ret = torch.mean(ret) if reduction == 'mean' else torch.sum(ret)

return ret

总结

对于大多数CNN网络,我们一般是使用L2-loss而不是L1-loss,因为L2-loss的收敛速度要比L1-loss要快得多。

对于边框预测回归问题,通常也可以选择平方损失函数(L2损失),但L2范数的缺点是当存在离群点(outliers)的时候,这些点会占loss的主要组成部分。比如说真实值为1,预测10次,有一次预测值为1000,其余次的预测值为1左右,显然loss值主要由1000决定。所以FastRCNN采用稍微缓和一点绝对损失函数(smooth L1损失),它是随着误差线性增长,而不是平方增长。

Smooth L1 和 L1 Loss 函数的区别在于,L1 Loss 在0点处导数不唯一,可能影响收敛。Smooth L1的解决办法是在 0 点附近使用平方函数使得它更加平滑。

Smooth L1的优点

- 相比于L1损失函数,可以收敛得更快。

- 相比于L2损失函数,对离群点、异常值不敏感,梯度变化相对更小,训练时不容易跑飞。

smooth L1 loss能从两个方面限制梯度:

- 当预测框与 ground truth 差别过大时,梯度值不至于过大;

- 当预测框与 ground truth 差别很小时,梯度值足够小。

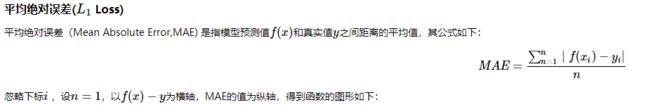

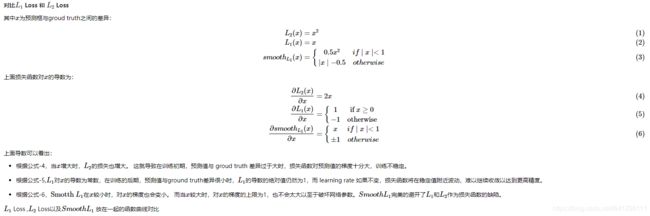

考察如下几种损失函数,其中

![]()

![]()

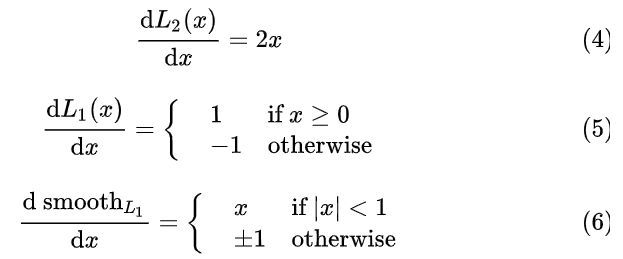

损失函数对 x 的导数分别为:

观察 (4),当 x 增大时 L2 损失对 x 的导数也增大。这就导致训练初期,预测值与 groud truth 差异过于大时,损失函数对预测值的梯度十分大,训练不稳定。

根据方程 (5),L1 对 x 的导数为常数。这就导致训练后期,预测值与 ground truth 差异很小时, L1 损失对预测值的导数的绝对值仍然为 1,而 learning rate 如果不变,损失函数将在稳定值附近波动,难以继续收敛以达到更高精度。

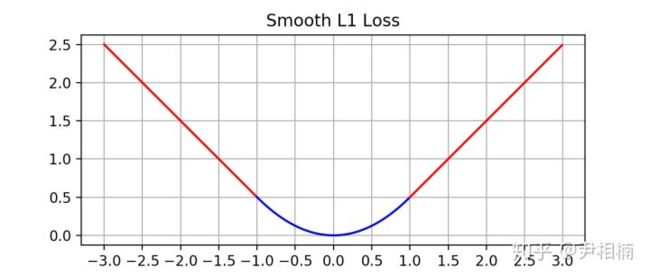

最后观察 (6),smooth L1 在 x 较小时,对 x 的梯度也会变小,而在 x 很大时,对 x 的梯度的绝对值达到上限 1,也不会太大以至于破坏网络参数。 smooth L1 完美地避开了 L1 和 L2 损失的缺陷。其函数图像如下:

由图中可以看出,它在远离坐标原点处,图像和 L1 loss 很接近,而在坐标原点附近,转折十分平滑,不像 L1 loss 有个尖角,因此叫做 smooth L1 loss。

参考文献:

https://blog.csdn.net/weixin_41940752/article/details/93159710

https://www.cnblogs.com/wangguchangqing/p/12021638.html

https://www.jianshu.com/p/19483787fa24