使用决策树预测隐形眼镜类型

目录

-

- **根据用户采集的WiFi信息采用决策树预测用户所在房间**

- **数据集**:

- **代码实现:**

-

- **a)** **基本参数:**

- **b)** **加载数据:**

根据用户采集的WiFi信息采用决策树预测用户所在房间

数据集:

数据集:训练集存于TrainDT.csv中;测试集存于 TestDT.csv中。

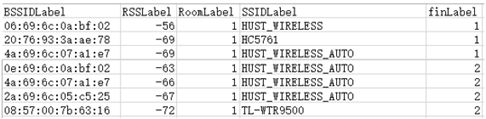

BSSIDLabel: BSSID标识符,每个AP(接入点,如路由器)拥有1个或多个不同的BSSID,但1个BSSID只属于1个AP;

RSSLabel:该BSSID的信号强度,单位dbm;

RoomLabel: 该BSSID被采集时所属的房间号,为类标签,测试集中也含该标签,主要用于计算预测准确度;

SSIDLabel: 该BSSID的名称,不唯一;

finLabel:finLabel标号相同,表示这部分BSSID在同一时刻被采集到;我们将在同一时刻采集的所有BSSID及其相应RSS构成的矢量称为一个指纹;由于BSSID的RSS在不同位置大小不同,因此指纹可以唯一的标识一个位置。

代码实现:

使用sklearn****分类决策树完成。

a) 基本参数:

'''

分类决策树

'''

DecisionTreeClassifier(criterion="gini",

splitter="best",

max_depth=None,

min_samples_split=2,

min_samples_leaf=1,

min_weight_fraction_leaf=0.,

max_features=None,

random_state=None,

max_leaf_nodes=None,

min_impurity_decrease=0.,

min_impurity_split=None,

class_weight=None,

presort=False)

'''

参数含义:

1.criterion:string, optional (default="gini")

(1).criterion='gini',分裂节点时评价准则是Gini指数。

(2).criterion='entropy',分裂节点时的评价指标是信息增益。

2.max_depth:int or None, optional (default=None)。指定树的最大深度。

如果为None,表示树的深度不限。直到所有的叶子节点都是纯净的,即叶子节点

中所有的样本点都属于同一个类别。或者每个叶子节点包含的样本数小于min_samples_split。

3.splitter:string, optional (default="best")。指定分裂节点时的策略。

(1).splitter='best',表示选择最优的分裂策略。

(2).splitter='random',表示选择最好的随机切分策略。

4.min_samples_split:int, float, optional (default=2)。表示分裂一个内部节点需要的做少样本数。

(1).如果为整数,则min_samples_split就是最少样本数。

(2).如果为浮点数(0到1之间),则每次分裂最少样本数为ceil(min_samples_split * n_samples)

5.min_samples_leaf: int, float, optional (default=1)。指定每个叶子节点需要的最少样本数。

(1).如果为整数,则min_samples_split就是最少样本数。

(2).如果为浮点数(0到1之间),则每个叶子节点最少样本数为ceil(min_samples_leaf * n_samples)

6.min_weight_fraction_leaf:float, optional (default=0.)

指定叶子节点中样本的最小权重。

7.max_features:int, float, string or None, optional (default=None).

搜寻最佳划分的时候考虑的特征数量。

(1).如果为整数,每次分裂只考虑max_features个特征。

(2).如果为浮点数(0到1之间),每次切分只考虑int(max_features * n_features)个特征。

(3).如果为'auto'或者'sqrt',则每次切分只考虑sqrt(n_features)个特征

(4).如果为'log2',则每次切分只考虑log2(n_features)个特征。

(5).如果为None,则每次切分考虑n_features个特征。

(6).如果已经考虑了max_features个特征,但还是没有找到一个有效的切分,那么还会继续寻找

下一个特征,直到找到一个有效的切分为止。

8.random_state:int, RandomState instance or None, optional (default=None)

(1).如果为整数,则它指定了随机数生成器的种子。

(2).如果为RandomState实例,则指定了随机数生成器。

(3).如果为None,则使用默认的随机数生成器。

9.max_leaf_nodes: int or None, optional (default=None)。指定了叶子节点的最大数量。

(1).如果为None,叶子节点数量不限。

(2).如果为整数,则max_depth被忽略。

10.min_impurity_decrease:float, optional (default=0.)

如果节点的分裂导致不纯度的减少(分裂后样本比分裂前更加纯净)大于或等于min_impurity_decrease,则分裂该节点。

加权不纯度的减少量计算公式为:

min_impurity_decrease=N_t / N * (impurity - N_t_R / N_t * right_impurity

\- N_t_L / N_t * left_impurity)

其中N是样本的总数,N_t是当前节点的样本数,N_t_L是分裂后左子节点的样本数,

N_t_R是分裂后右子节点的样本数。impurity指当前节点的基尼指数,right_impurity指

分裂后右子节点的基尼指数。left_impurity指分裂后左子节点的基尼指数。

11.min_impurity_split:float

树生长过程中早停止的阈值。如果当前节点的不纯度高于阈值,节点将分裂,否则它是叶子节点。

这个参数已经被弃用。用min_impurity_decrease代替了min_impurity_split。

12.class_weight:dict, list of dicts, "balanced" or None, default=None

类别权重的形式为{class_label: weight}

(1).如果没有给出每个类别的权重,则每个类别的权重都为1。

(2).如果class_weight='balanced',则分类的权重与样本中每个类别出现的频率成反比。

计算公式为:n_samples / (n_classes * np.bincount(y))

(3).如果sample_weight提供了样本权重(由fit方法提供),则这些权重都会乘以sample_weight。

13.presort:bool, optional (default=False)

指定是否需要提前排序数据从而加速训练中寻找最优切分的过程。设置为True时,对于大数据集

会减慢总体的训练过程;但是对于一个小数据集或者设定了最大深度的情况下,会加速训练过程。

属性:

1.classes_:array of shape = [n_classes] or a list of such arrays

类别的标签值。

2.feature_importances_ : array of shape = [n_features]

特征重要性。越高,特征越重要。

特征的重要性为该特征导致的评价准则的(标准化的)总减少量。它也被称为基尼的重要性

3.max_features_ : int

max_features的推断值。

4.n_classes_ : int or list

类别的数量

5.n_features_ : int

执行fit后,特征的数量

6.n_outputs_ : int

执行fit后,输出的数量

7.tree_ : Tree object

树对象,即底层的决策树。

b) 加载数据:

选择有用的数据项[‘finLabel’, ‘BSSIDLabel’, ‘RoomLabel’],

对缺失值,填入-100

Train_data_f = pd.read_csv('TrainDT.csv')

Test_data_f = pd.read_csv('TestDT.csv')

imputer = Imputer(missing_values=np.nan, strategy='constant', fill_value=-100)

Train_data = pd.DataFrame(imputer.fit_transform(Train_data_f))

Test_data = pd.DataFrame(imputer.fit_transform(Test_data_f))

Train_data.columns = Train_data_f.columns

Test_data.columns = Test_data_f.columns

feature_train = Train_data_f[['finLabel', 'BSSIDLabel', 'RoomLabel']]

feature_test = Test_data_f[['finLabel', 'BSSIDLabel', 'RoomLabel']]

a) 数据处理:

将数据按 ‘finLabel’ 聚合。

采用所有样本BSSID集合的并集作为特征,如指纹 的BSSID集合为 :

B i = 〖 B S S I D 〗 j │ 〖 B S S I D 〗 j ∈ f i 。 B_i={〖BSSID〗_j│〖BSSID〗_j∈f_i }。 Bi=〖BSSID〗j│〖BSSID〗j∈fi。

并按照:

f 1 = [ 〖 B S S I D 〗 1 : 1 , 〖 B S S I D 〗 2 : 0 , 〖 B S S I D 〗 3 : 1 , 〖 B S S I D 〗 4 : 1 , 0 ] f_1=[〖BSSID〗_1:1,〖BSSID〗_2:0,〖BSSID〗_3:1,〖BSSID〗_4:1,0] f1=[〖BSSID〗1:1,〖BSSID〗2:0,〖BSSID〗3:1,〖BSSID〗4:1,0]

f 2 = [ 〖 B S S I D 〗 1 : 1 , 〖 B S S I D 〗 2 : 1 , 〖 B S S I D 〗 3 : 1 , 〖 B S S I D 〗 4 : 0 , 1 ] f_2=[〖BSSID〗_1:1,〖BSSID〗_2:1,〖BSSID〗_3:1,〖BSSID〗_4:0,1] f2=[〖BSSID〗1:1,〖BSSID〗2:1,〖BSSID〗3:1,〖BSSID〗4:0,1]

将输入转为向量。

BSSID_v = list(set(Train_data_f['BSSIDLabel']))

BSSID_l = len(BSSID_v)

tarin_bssid = feature_train.groupby('finLabel')

tarin_input = []

Train_data_classes = []

for i, v in tarin_bssid:

tmp = np.array(v['BSSIDLabel'])

tmpa = BSSID_l * [0]

for bssidv in BSSID_v:

if bssidv in tmp:

tmpa[BSSID_v.index(bssidv)] = 1

tarin_input.append(tmpa)

roomid = np.array(v['RoomLabel'])

Train_data_classes.append(roomid[1])

Train_data_inputs = np.array(tarin_input)

b) 建立决策树:

# 建立决策树

在此全部为默认参数了

decision_tree_classifier = DecisionTreeClassifier()

decision_tree_classifier.fit(Train_data_inputs, Train_data_classes)

decision_tree_output = decision_tree_classifier.predict(Test_data_inputs)

c) 在测试集上测试:

print('真实值是:')

print(Test_data_classes)

print('预测值是:')

print(decision_tree_output)

score = accuracy_score(Test_data_classes, decision_tree_output)

print(score)

2. 实验结果:

在测试集上accuracy_score达到1.0