【吴恩达课后编程作业】Course 1 - 神经网络和深度学习 - 第三周作业

在开始之前,首先声明本文是作为一个初学者的学习笔记,在学习CSDN博主「何宽」的原创文章,原文链接:https://blog.csdn.net/u013733326/article/details/79702148 【【吴恩达课后编程作业】Course 1 - 神经网络和深度学习 - 第三周作业时,碰到一些问题,所以做了总结,方便自己之后碰到问题可以回头查阅。如有不妥的地方欢迎大家指正,如果大佬不喜欢我可以给他删掉。

——————————————————————————————————————————————————————————

大佬上传的的资料在百度网盘,提取码:qifu 。点此处下载:[百度网盘]。(https://pan.baidu.com/s/12VnFvaQf16J0RV1n1xsRvg&shfl=sharepset)

——————————————————————————————————————————————————————————

本次作业要做的目标内容:

构建具有单隐藏层的2类分类神经网络。

使用具有非线性激活功能激活函数,例如tanh。

计算交叉熵损失(损失函数)。

实现向前和向后传播。

——————————————————————————————————————————————————————————

准备软件包:

numpy:是用Python进行科学计算的基本软件包。

sklearn:为数据挖掘和数据分析提供的简单高效的工具。

matplotlib :是一个用于在Python中绘制图表的库。

testCases:提供了一些测试示例来评估函数的正确性,参见下载的资料。

planar_utils :提供了在这个任务中使用的各种有用的功能,参见下载的资料。

import numpy as np

import matplotlib.pyplot as plt

from testCases import *

import sklearn

import sklearn.datasets

import sklearn.linear_model

from planar_utils import plot_decision_boundary, sigmoid, load_planar_dataset, load_extra_datasets

np.random.seed(1)#准备一个随机数的种子

——————————————————————————————————————————————————————————

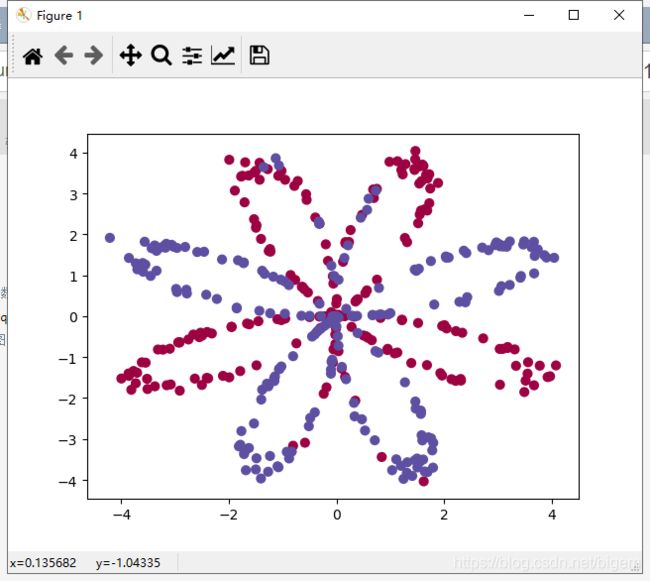

加载和查看数据集:

np.random.seed(1)#准备一个随机数的种子

#加载数据集

X, Y = load_planar_dataset()

#绘制可视化图像,X是2*n矩阵,y是颜色,s是数据的数量,cmap代表按照y不同,用不同颜色分开

plt.scatter(X[0, :] , X[1, :] , c = np.squeeze(Y) , s = 40 , cmap = plt.cm.Spectral)

plt.show()#老是忘记这一行,没有他看不到图啊

运行结果如下:

——————————————————————————————————————————————————————————

查看数据的大小:

shape_X = X.shape

shape_Y = Y.shape

m = Y.shape[1]

print ("X的维度为:" + str(shape_X))

print ("Y的维度为:" + str(shape_Y))

print ("数据集里面的数据有:" + str(m) + "个")

运行结果如下:

X的维度为:(2, 400)

Y的维度为:(1, 400)

数据集里面的数据有:400个

——————————————————————————————————————————————————————————

查看简单的Logistic回归的分类效果:

使用sklearn的内置函数来做到这一点, 运行下面的代码来训练数据集上的逻辑回归分类器:

clf = sklearn.linear_model.LogisticRegressionCV()

clf.fit(X.T,Y.T)

会有如下显示:

d:\ProgramData\Anaconda3\lib\site-packages\sklearn\utils\validation.py:724: DataConversionWarning: A column-vector y was passed when a 1d array was expected. Please change the shape of y to (n_samples, ), for example using ravel().

y = column_or_1d(y, warn=True)

d:\ProgramData\Anaconda3\lib\site-packages\sklearn\model_selection\_split.py:1978: FutureWarning: The default value of cv will change from 3 to 5 in version 0.22. Specify it explicitly to silence this warning.

warnings.warn(CV_WARNING, FutureWarning)

我们可以把逻辑回归分类器的分类绘制出来:

#绘制决策边界 , 此处做了修改,将Y进行了向量化 lambda函数的功能就是实现一个 : 之前是输入 : 之后是输出的函数

plot_decision_boundary(lambda x: clf.predict(x), X, np.squeeze(Y))

plt.title("Logistic Regression") #图标题

plt.show()#别忘记显示一下

LR_predictions = clf.predict(X.T) #预测结果

"""

关于预测准确性的式子来源:

首先LR_predictions是预测结果(只有0和1)

np.dot(Y, LR_predictions)就是真实值Y与预测值的内积(每个元素相乘加起来)

只有真实值和预测值都为1时,才有用,因为其他其他情况都为0,对结果没影响

这个np.dot(Y, LR_predictions)就是预测正确并且结果是1的那部分

同理np.dot(1 - Y,1 - LR_predictions)是预测正确并且结果是0的那部分

最后加起来求和除以总的样本就是正确率

"""

print ("逻辑回归的准确性: %d " % float((np.dot(Y, LR_predictions) +

np.dot(1 - Y,1 - LR_predictions)) / float(Y.size) * 100) +

"% " + "(正确标记的数据点所占的百分比)")

逻辑回归的准确性: 47 % (正确标记的数据点所占的百分比)

——————————————————————————————————————————————————————————

搭建神经网络:

构建神经网络的步骤:

定义神经网络结构(输入单元的数量,隐藏单元的数量等)。

初始化模型的参数

循环:

实施前向传播

计算损失

实现向后传播

更新参数(梯度下降)

我们要它们合并到一个nn_model() 函数中,当我们构建好了nn_model()并学习了正确的参数,我们就可以预测新的数据。

1、定义神经网络结构

n_x: 输入层的数量

n_h: 隐藏层的数量(这里设置为4)

n_y: 输出层的数量

def layer_sizes(X , Y):

"""

参数:

X - 输入数据集,维度为n_x * m

Y - 标签,维度为 1 * m

返回:

n_x - 输入层的数量

n_h - 隐藏层的数量

n_y - 输出层的数量

"""

n_x = X.shape[0]

n_h = 4

n_y = Y.shape[0]

return (n_x , n_h , n_y)

进行测试:

print("=========================测试layer_sizes=========================")

X_asses , Y_asses = layer_sizes_test_case()

(n_x , n_h , n_y) = layer_sizes(X_asses , Y_asses)

print("输入层节点数量为:n_x = " + str(n_x))

print("隐藏层节点数量为:n_h = " + str(n_h))

print("输出层节点数量为:n_y = " + str(n_y))

运行结果如下:

=========================测试layer_sizes=========================

输入层节点数量为:n_x = 5

隐藏层节点数量为:n_h = 4

输出层节点数量为:n_y = 2

2、初始化模型的参数

在这里,我们要实现函数initialize_parameters(),确保参数大小合适。

我们将会用随机值初始化权重矩阵,将偏向量初始化为零。

def initialize_parameters(n_x , n_h , n_y):

"""

参数:

n_x - 输入层的数量

n_h - 隐藏层的数量

n_y - 输出层的数量

返回:

parameters - 包含参数的字典

w1 - 权重矩阵,维度为n_h * n_x

b1 - 偏置向量,维度为n_h * 1

w2 - 权重矩阵,维度为n_y * n_h

b2 - 偏置向量,维度为n_y * 1

"""

np.random.seed(2)

w1 = np.random.randn(n_h,n_x) * 0.01

b1 = np.zeros(shape = (n_h,1))

w2 = np.random.randn(n_y,n_h) * 0.01

b2 = np.zeros(shape = (n_y,1))

assert(w1.shape == (n_h,n_x))

assert(b1.shape == (n_h,1))

assert(w2.shape == (n_y,n_h))

assert(b2.shape == (n_y,1))

parameters = {

"w1" : w1 ,

"b1" : b1 ,

"w2" : w2 ,

"b2" : b2

}

return parameters

测试:

#测试initialize_parameters

print("=========================测试initialize_parameters=========================")

n_x , n_h , n_y = initialize_parameters_test_case()

parameters = initialize_parameters(n_x , n_h , n_y)

print("w1 = " + str(parameters["w1"]))

print("b1 = " + str(parameters["b1"]))

print("w2 = " + str(parameters["w2"]))

print("b2 = " + str(parameters["b2"]))

运行结果如下:

=========================测试initialize_parameters=========================

w1 = [[-0.00416758 -0.00056267]

[-0.02136196 0.01640271]

[-0.01793436 -0.00841747]

[ 0.00502881 -0.01245288]]

b1 = [[0.]

[0.]

[0.]

[0.]]

w2 = [[-0.01057952 -0.00909008 0.00551454 0.02292208]]

b2 = [[0.]]

3、向前传播

def forward_propagation(X , parameters):

"""

参数:

X - 输入的数据矩阵,大小为n_x * m

parameters - 初始化的神经网络权重与偏置矩阵

返回:

A2 - 使用sigmoid()函数计算的二次激活后的数值

cache - 包含z1 a1 z2 a2的字典

"""

W1 = parameters["W1"]

b1 = parameters["b1"]

W2 = parameters["W2"]

b2 = parameters["b2"]

#向前传播

Z1 = np.dot(W1,X) + b1

A1 = np.tanh(Z1)

Z2 = np.dot(W2,A1) +b2

A2 = sigmoid(Z2)

assert (A2.shape == (1,X.shape[1]))

cache = {

"Z1": Z1 ,

"A1": A1 ,

"Z2": Z2 ,

"A2": A2

}

return (A2, cache)

#测试forward_propagation

print("=========================测试forward_propagation=========================")

X_assess, parameters = forward_propagation_test_case()

A2, cache = forward_propagation(X_assess, parameters)

print(np.mean(cache["Z1"]), np.mean(cache["A1"]), np.mean(cache["Z2"]), np.mean(cache["A2"]))

测试结果如下:

=========================测试forward_propagation=========================

-0.0004997557777419902 -0.000496963353231779 0.00043818745095914653 0.500109546852431

4、计算成本

def compute_cost(A2 , Y , parameters):

"""

参数:

A2 - 使用sigmoid()函数计算的第二次激活后的数值

Y - "True"标签向量,维度为(1,数量)

parameters - 一个包含W1,B1,W2和B2的字典类型的变量

返回:

成本 -

"""

m = Y.shape[1]

W1 = parameters["W1"]

W2 = parameters["W2"]

#计算成本

logprobs = np.multiply(np.log(A2), Y) + np.multiply((1 - Y), np.log(1 - A2))

cost = - np.sum(logprobs) / m

cost = float(np.squeeze(cost))

assert(isinstance(cost,float))

return cost

进行测试:

print("=========================测试compute_cost=========================")

A2 , Y_assess , parameters = compute_cost_test_case()

print("cost = " + str(compute_cost(A2,Y_assess,parameters)))

运行结果如下:

=========================测试compute_cost=========================

cost = 0.6929198937761266

5、向后传播

def backward_propagation(parameters , cache , X , Y):

"""

参数:

parameters - 包含我们的参数的一个字典类型的变量。

cache - 包含“Z1”,“A1”,“Z2”和“A2”的字典类型的变量。

X - 输入数据,维度为(2,数量)

Y - “True”标签,维度为(1,数量)

返回:

grads - 包含W和b的导数一个字典类型的变量。

"""

m = X.shape[1]

W1 = parameters["W1"]

W2 = parameters["W2"]

A1 = cache["A1"]

A2 = cache["A2"]

dZ2 = A2 - Y

dW2 = (1 / m) * np.dot(dZ2,A1.T)

db2 = (1 / m) * np.sum(dZ2,axis = 1,keepdims = True)

dZ1 = np.multiply(np.dot(W2.T,dZ2),1 - np.power(A1,2))

dW1 = (1 / m) * np.dot(dZ1, X.T)

db1 = (1 / m) * np.sum(dZ1,axis = 1,keepdims = True)

grads = {

"dW1": dW1,

"db1": db1,

"dW2": dW2,

"db2": db2

}

return grads

#测试backward_propagation

print("=========================测试backward_propagation=========================")

parameters, cache, X_assess, Y_assess = backward_propagation_test_case()

grads = backward_propagation(parameters, cache, X_assess, Y_assess)

print ("dW1 = "+ str(grads["dW1"]))

print ("db1 = "+ str(grads["db1"]))

print ("dW2 = "+ str(grads["dW2"]))

print ("db2 = "+ str(grads["db2"]))

测试结果如下:

=========================测试backward_propagation=========================

dW1 = [[ 0.01018708 -0.00708701]

[ 0.00873447 -0.0060768 ]

[-0.00530847 0.00369379]

[-0.02206365 0.01535126]]

db1 = [[-0.00069728]

[-0.00060606]

[ 0.000364 ]

[ 0.00151207]]

dW2 = [[ 0.00363613 0.03153604 0.01162914 -0.01318316]]

db2 = [[0.06589489]]

6、更新

def update_parameters(parameters , grads ,learning_rate = 1.2):

"""

使用上面给出的梯度下降更新规则更新参数

参数:

parameters - 包含参数的字典类型的变量。

grads - 包含导数值的字典类型的变量。

learning_rate - 学习速率

返回:

parameters - 包含更新参数的字典类型的变量。

"""

W1,W2 = parameters["W1"],parameters["W2"]

b1,b2 = parameters["b1"],parameters["b2"]

dW1,dW2 = grads["dW1"],grads["dW2"]

db1,db2 = grads["db1"],grads["db2"]

W1 = W1 - learning_rate * dW1

b1 = b1 - learning_rate * db1

W2 = W2 - learning_rate * dW2

b2 = b2 - learning_rate * db2

parameters = {

"W1": W1,

"b1": b1,

"W2": W2,

"b2": b2}

return parameters

print("=========================测试update_parameters=========================")

parameters, grads = update_parameters_test_case()

parameters = update_parameters(parameters, grads)

print("W1 = " + str(parameters["W1"]))

print("b1 = " + str(parameters["b1"]))

print("W2 = " + str(parameters["W2"]))

print("b2 = " + str(parameters["b2"]))

=========================测试update_parameters=========================

W1 = [[-0.00643025 0.01936718]

[-0.02410458 0.03978052]

[-0.01653973 -0.02096177]

[ 0.01046864 -0.05990141]]

b1 = [[-1.02420756e-06]

[ 1.27373948e-05]

[ 8.32996807e-07]

[-3.20136836e-06]]

W2 = [[-0.01041081 -0.04463285 0.01758031 0.04747113]]

b2 = [[0.00010457]]

7、整合成为一个模块

def nn_model(X,Y,n_h,num_iterations,print_cost = False):

"""

参数:

X - 数据集,维度为(2,示例数)

Y - 标签,维度为(1,示例数)

n_h - 隐藏层的数量

num_iterations - 梯度下降循环中的迭代次数

print_cost - 如果为True,则每1000次迭代打印一次成本数值

返回:

parameters - 模型学习的参数,它们可以用来进行预测。

"""

np.random.seed(3)

n_x = layer_sizes(X,Y)[0]

n_y = layer_sizes(X,Y)[2]

parameters = initialize_parameters(n_x,n_h,n_y)

W1 = parameters["W1"]

b1 = parameters["b1"]

W2 = parameters["W2"]

b2 = parameters["b2"]

for i in range(num_iterations):

A2 , cache = forward_propagation(X,parameters)

cost = compute_cost(A2 , Y , parameters)

grads = backward_propagation(parameters,cache,X,Y)

parameters = update_parameters(parameters,grads,learning_rate = 0.5)

if print_cost:

if i%1000 == 0:

print("第",i,"次循环,成本为:"+str(cost))

return parameters

8、预测

def predict(parameters,X):

"""

使用学习的参数,为X中的每个示例预测一个类

参数:

parameters - 包含参数的字典类型的变量。

X - 输入数据(n_x,m)

返回

predictions - 我们模型预测的向量(红色:0 /蓝色:1)

"""

A2 , cache = forward_propagation(X,parameters)

predictions = np.round(A2)

return predictions

这时,整个神经网络已经搭建完毕,我们对x进行预测,并于实际相比对

parameters = nn_model(X, Y, n_h = 4, num_iterations=10000, print_cost=True)

#绘制边界

plot_decision_boundary(lambda x: predict(parameters, x.T), X, np.squeeze(Y))

plt.title("Decision Boundary for hidden layer size " + str(4))

plt.show()

predictions = predict(parameters, X)

print ('准确率: %d' % float((np.dot(Y, predictions.T) + np.dot(1 - Y, 1 - predictions.T)) / float(Y.size) * 100) + '%')

第 0 次循环,成本为:0.6930480201239823

第 1000 次循环,成本为:0.3098018601352803

第 2000 次循环,成本为:0.2924326333792646

第 3000 次循环,成本为:0.2833492852647412

第 4000 次循环,成本为:0.27678077562979253

第 5000 次循环,成本为:0.26347155088593144

第 6000 次循环,成本为:0.24204413129940763

第 7000 次循环,成本为:0.23552486626608762

第 8000 次循环,成本为:0.23140964509854278

第 9000 次循环,成本为:0.22846408048352365

准确率: 90%

准确率为90%,相比于logic回归有着显著的提升!好cool