爬虫(5)一文搞懂cookie原理和使用(客官里面请,下饭文章吃饱再走)

目录

- 什么是cookie:

- cookie的格式:

- 使用cookielib库和HTTPCookieProcessor模拟登录:

-

- 1.cookie复制的方式爬取信息

- 2.实现cookie的自动化获取,并爬取信息

什么是cookie:

在网站中,http请求是无状态的。也就是说即使第一次和服务器连接后并且登录成功后,第二次请求服务器依然不能知道当前请求是哪个用户。(看过’夏洛特烦恼’的朋友应该能知道在夏洛的梦境中的那次聚会,老师不认识同学们,但是当学生提到我就是送您收音机那个的时候,老师就明白这个学生是谁了,而这个cookie就好似是学生给老师说的送过的礼物在)cookie的出现就是为了解决这个问题,第一次登录后服务器近回一些数据(cookie)给浏览器,然后浏览器保存在本地,当该用户发送第二次请求的时候,就会自动的把上次请求存储的cookie数据携带给服务器,服务器通过浏览器携带的數据就能判断当前用户是哪个了。cookle 存储的数据量有限,不同的浏览器有不同的存储大小,但一般不超过4KB。因此快用cookde只能存储一些小量的数据。

cookie的格式:

Set-Cookie: NAME-VALUE: Expires/Max-age-DATE: Path-PATH: Domain-DOMAIN_NAME : SECURE

参数意义:

- NAME: cookie的名字。

- VALUE: cookie的值。

- Expires: cookie的过期时间。

- Path: cookie作用的站径.

- Domain: cookie作用的域名。

- SECURE: 是否只在https协许下起作用。

使用cookielib库和HTTPCookieProcessor模拟登录:

Cookie是指网站服务器为了精别用户身份和进行Session跟踪。而储存在用户时览器上的文本文件,Cookie可以保持登录信息到用户下次与服务器的会话。

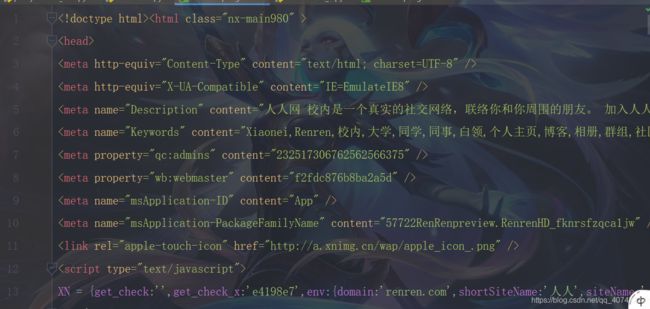

这里以人人用为例,人人网中,要访问某个人的主页。必须先登录才能访问。登录说白了就是要有cookie信息。那么如果我们使用代码的方式访问,就必须要有正确的cookie信息才能抗问。解决方案有两种。第一种是使用浏览器访问,然后将cookie信息复制到headers下.

这里先示例不使用cookie时的访问主页:

- 因为这里没有使用cookie信息,因此人人网会拒绝我们访问别人的首页而转到登录页面,而我们实际爬取到的也不是主页的信息,而是登录的页面信息.

1.cookie复制的方式爬取信息

#encoding: utf-8

from urllib import request

#人人网大鹏url=http://www.renren.com/880151247/profile

#人人网登陆url = http://www.renren.com/PLogin.do

#不使用cookie登陆

dapeng_url ='http://www.renren.com/880151247/profile'

headers= {

'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.132 Safari/537.36'

}

req = request.Request(url=dapeng_url,headers=headers)

resp = request.urlopen(req)

#为了观察的结果会更直观,我们把这个读出来的页面写入一个页面中打开,看一看爬出来的是不是大鹏的页面

#print(resp.read().decode('utf-8'))

with open('renrendapeng.html','w')as fp:

"""注意write函数只能传入一个str数据类型

resp.read()读出来的是一个bytes类型的数据

bytes -> decode ->str

str ->encode ->bytes

"""

fp.write(resp.read().decode('utf-8'))

爬取到的不是大鹏的主页而是登录的页面,现在我们使用cookie的第一种使用方式(浏览器复制方式)来添加了cookie之后在看一下爬取到的数据.

#encoding: utf-8

#使用cookie模拟登录

#人人网大鹏url=http://www.renren.com/880151247/profile

#人人网登陆url = http://www.renren.com/PLogin.do

from urllib import request

dapeng_url ='http://www.renren.com/880151247/profile'

headers= {

'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.132 Safari/537.36',

'Cookie': 'anonymid=k8wlyoy1-ny0une; depovince=GW; _r01_=1; JSESSIONID=abcE68Al2HqR_-7Do3Sfx; ick_login=c3dc2658-5708-41b8-9d34-bdf50537cd5c; taihe_bi_sdk_uid=79da7caa8254d05786dfbb1e1775e688; taihe_bi_sdk_session=019401f871b1b3589abe2676f13b7211; loginfrom=null; XNESSESSIONID=dec74922ed95; wp_fold=0; t=36b16d19d7f0427b2f537aa7fec812bb4; societyguester=36b16d19d7f0427b2f537aa7fec812bb4; id=974213094; xnsid=93156620; jebecookies=246bde88-55b9-414e-84fe-91dfcac13f4f|||||; ver=7.0; l4pager=0',

}

req = request.Request(url=dapeng_url,headers=headers)

resp = request.urlopen(req)

#为了观察的结果会更直观,我们把这个读出来的页面写入一个页面中打开,看一看爬出来的是不是大鹏的页面

#print(resp.read().decode('utf-8'))

with open('renrendapeng2.html','w')as fp:

"""注意write函数只能传入一个str数据类型

resp.read()读出来的是一个bytes类型的数据

bytes -> decode ->str

str ->encode ->bytes

"""

fp.write(resp.read().decode('utf-8'))

可以看到,这里已经成功的爬取到了大鹏的主页的信息

特别注意的一点是:

- cookie信息是会过期的,因此这也是采用了第一种方式的弊端所在,你今天写的代码是能爬取到信息的,但是当cookie过期后,即使添加了cookie信息也是爬取不到主页的信息的.

2.实现cookie的自动化获取,并爬取信息

但是每次在访问需要cookie的页面都要从浏览器中复制cookie比较麻烦,在Python处理cookie,一般是通过http.cookiejar模块和urllib模块的HTTPCookieProcessor处理类一起使用.

http.cookiejar模块主要作用是提供存储cookie对象.- 而

HTTPCookieProcessor处理器主要作用是处理这些cookie对象,并构建handler对象.

http.cookiejar模块:

该模块主要的类有CookieJar. FlleCookieJar. MozillaCookieJC LWPCookieJar.这四个类的作用分别如下:

CookieJar:管理HTTP cookie值、存储HTTP请求生成的cookie.向传出的HTTP请求添加cookie的对象。整个cookie都存储在内存中,对CookieJar实例进行垃圾回收后cookie也将丢失。FileCookieJar: (flename,delayload=None polcy=None):从CookieJar派生而来,用来创建FleCookie.Jar实例,检索cookie信息并将cookie存储到文件中。filename是存储cookie的文件名。delayload为True时支持延迟访问访问文件,即只有在需要时才读取文件或在文件中存储数据。MozillaCookieJar:(flename delayload=None policy=None),FleCookieJar派生而来,创建与Mozilla浏览器cookies txt兼容的FileCookieJar实例。LWPCookieJar: (flename,delayloadeNonepolcyaNone):从FileCookieJar派生 而来,创建与libwww-per标准的Set-Cookie3文件格式兼容的FileCookieJa实例。

利用http.cookdejar和request.HTTPCookieProcessor登录人人网。相关示例代码如下:

#encoding: utf-8

#使用cookie模拟登录

#人人网大鹏url=http://www.renren.com/880151247/profile

#人人网登陆url = http://www.renren.com/PLogin.do

from urllib import request

from urllib import parse

from http.cookiejar import CookieJar

#1.登录

#1.1创建一个cookiejar对象

cookiejar = CookieJar()

#1.2使用cookiejar创建一个HTTPCookieProcese对象

handler = request.HTTPCookieProcessor(cookiejar)

#1.3使用上一步创建的handler创建一个opener

opener = request.build_opener(handler)

#1.4使用opener发送登录的请求(人人网的邮箱和密码)

headers ={

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.132 Safari/537.36',

}

data ={

'email' : '[email protected]',

'password':'pythontest1234'

}

login_url = 'http://www.renren.com/PLogin.do'

req = request.Request(login_url,data=parse.urlencode(data).encode('utf-8'),headers=headers)

opener.open(req)

#仅仅是为了登录,所以响应什么并不重要,我们这里不接收它

#2.访问个人主页

dapeng_url = 'http://www.renren.com/880151247/profile'

'''获取我们要访问的主页时,我们直接使用上面创建好的opener,因为它已经包含了cookiejar和handler的信息'''

req = request.Request(dapeng_url,headers= headers)

resp =opener.open(req)

with open ('renrendapeng3.html','w') as fp:

fp.write(resp.read().decode('utf-8'))

代码重构后:

#encoding: utf-8

'''

实现对cookie_test3代码的重构,让可读性提高

'''

#encoding: utf-8

#使用cookie模拟登录

#人人网大鹏url=http://www.renren.com/880151247/profile

#人人网登陆url = http://www.renren.com/PLogin.do

from urllib import request

from urllib import parse

from http.cookiejar import CookieJar

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.132 Safari/537.36',

}

def get_opener():

cookiejar = CookieJar()

handler = request.HTTPCookieProcessor(cookiejar)

opener = request.build_opener(handler)

return opener

#1.4使用opener发送登录的请求(人人网的邮箱和密码)

def login_renren(opener):

data ={

'email' : '[email protected]',

'password':'pythontest1234'

}

login_url = 'http://www.renren.com/PLogin.do'

req = request.Request(login_url,data=parse.urlencode(data).encode('utf-8'),headers=headers)

opener.open(req)

#仅仅是为了登录,所以响应什么并不重要,我们这里不接收它

#2.访问个人主页

def visit_profile(opener):

dapeng_url = 'http://www.renren.com/880151247/profile'

'''获取我们要访问的主页时,我们直接使用上面创建好的opener,因为它已经包含了cookiejar和handler的信息'''

req = request.Request(dapeng_url,headers= headers)

resp =opener.open(req)

with open ('renrendapeng4.html','w') as fp:

fp.write(resp.read().decode('utf-8'))

if __name__ == '__main__':

opener = get_opener()

login_renren(opener)

visit_profile(opener)