【hadoop】完全分布式部署

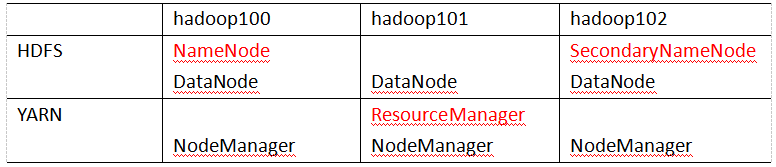

集群配置:

注意:NameNode和SecondaryNameNode不要安装在同一台服务器

(2NN备份元数据的,如果放在一台机器上,机器宕机元数据就拿不到)

注意:ResourceManager也很消耗内存,不要和NameNode、SecondaryNameNode配置在同一台机器上。

- 核心配置文件

- 配置:hadoop-env.sh(在/opt/module/hadoop-3.1.3/etc/hadoop目录下)

Linux系统中获取JDK的安装路径:

[soft863@ hadoop100 ~]# echo $JAVA_HOME

/opt/module/jdk1.8.0_212

- 在hadoop-env.sh文件中修改JAVA_HOME 路径:(在第54行修改)

export JAVA_HOME=/opt/module/jdk1.8.0_212

- 配置core-site.xml

cd $HADOOP_HOME/etc/hadoop

vim core-site.xml

文件内容如下:

fs.defaultFS

hdfs://hadoop100:9820

hadoop.data.dir

/opt/module/hadoop-3.1.3/data

HDFS配置文件:

- 配置hdfs-site.xml

vim hdfs-site.xml

文件内容如下:

dfs.namenode.name.dir

file://${ hadoop.data.dir}/name

dfs.datanode.data.dir

file://${ hadoop.data.dir}/data

dfs.namenode.checkpoint.dir

file://${hadoop.data.dir}/namesecondary

dfs.client.datanode-restart.timeout

30

dfs.namenode.http-address

hadoop100:9870

dfs.namenode.secondary.http-address

hadoop102:9868

YARN配置文件:

- 配置yarn-site.xml

vim yarn-site.xml

文件内容如下:

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.resourcemanager.hostname

hadoop101

yarn.nodemanager.env-whitelist

JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME

MapReduce配置文件:

- 配置mapred-site.xml

vim mapred-site.xml

文件内容如下:

mapreduce.framework.name

yarn

集群分发:

- 把module目录拷贝到hadoop100:

[root@hadoop102 opt]# cd /opt

[root@hadoop102 opt]# scp -r module/ hadoop100:/opt/

- 把module目录拷贝到hadoop101:

[root@hadoop102 opt]# rsync -av module hadoop101:/opt/

- 把 /etc/profile拷贝到hadoop100 hadoop101

[root@hadoop102 opt]# rsync -av /etc/profile hadoop101:/etc

[root@hadoop102 opt]# rsync -av /etc/profile hadoop100:/etc

- 在hadoop100和hadoop101上分别要进行source /etc/profile

[root@hadoop100 opt]# source /etc/profile

[root@hadoop101 opt]# source /etc/profile

分布式集群格式化:

分布式集群第一次启动之前要格式化

格式化之前,要把三个服务器上的hadoop安装目录下的 data目录和logs目录都删掉

[root@hadoop101 opt]# cd /opt/module/hadoop-3.1.3

[root@hadoop101 opt]# rm -rf data

[root@hadoop101 opt]# rm -rf logs

在指定namenode运行的服务器上执行格式化:

(namenode指定在hadoop100上运行的)

[root@hadoop100 hadoop-3.1.3]# hdfs namenode -format

单启与群启:

单启

Hadoop100:

hdfs --daemon start namenode

hdfs --daemon start datanode

yarn --daemon start nodemanager

hadoop101:

yarn --daemon start resourcemanager

hdfs --daemon start datanode

yarn --daemon start nodemanager

hadoop102:

hdfs --daemon start secondarynamenode

hdfs --daemon start datanode

yarn --daemon start nodemanager

1)启动hdfs相关

hdfs --daemon start namenode

hdfs --daemon start datanode

2)启动yarn相关

yarn --daemon start resourcemanager

yarn --daemon start nodemanager

启动集群

如果集群上已经启动hadoop相关程序,可以先执行停止。

在hadoop100上执行以下脚本,用来启动hdfs:

[root@hadoop100] start-dfs.sh

在hadoop101上执行以下脚本,用来启动yarn:

[root@hadoop101] start-yarn.sh

停止集群

在hadoop100上执行以下脚本,用来停止hdfs:

[root@hadoop100] stop-dfs.sh

在hadoop101上执行以下脚本,用来停止yarn:

[root@hadoop101] stop-yarn.sh