Kubernetes集群几种部署方式

minikube

Minikube是一个工具,可以在本地快速运行一个单点的Kubernetes,尝试Kubernetes或日常开发的用户使用。不能用于生产环境。

部署地址:https://kubernetes.io/docs/setup/minikube/

kubeadm

Kubeadm也是一个工具,提供kubeadm init和kubeadm join,用于快速部署Kubernetes集群。

部署地址:https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/

二进制

从官方下载发行版的二进制包,手动部署每个组件,组成Kubernetes集群。

下载地址:https://github.com/kubernetes/kubernetes/releases

小结: 生产环境中部署Kubernetes集群,有Kubeadm和二进制方式可选,Kubeadm降低部署门槛,但屏蔽了很多细节,遇到问题很难排查。使用二进制包部署Kubernetes集群,虽然手动部署麻烦点,但能学习很多工作原理,更有利于后期维护。

本文使用kubeadm方式部署,二进制部署的方式还是交给专业的运维去完成吧

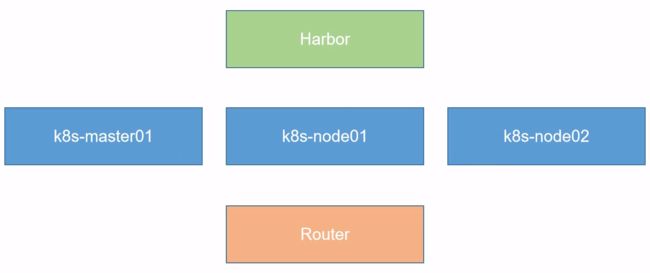

Kubernetes集群节点

VMware安装Centos7略。。。。

Kubernetes-Linux系统初始化

1、配置Linux的IP地址

vim /etc/sysconfig/network-scripts/ifcfg-ens33v

ifcfg-ens33是网卡的最新命名规范,它会从BIOS => PCIE通道里获取它的网卡文件名,如果都没有的话,再降级到eth0或者eth1的命名方式,如果需要关闭的话,ifnames=0就可以关闭了。和以前的配置文件修改方式类似。

2、设置主机名

hostnamectl set-hostname {hostName}

注意:

- 在大型集群环境中建议大家通过DNS的方式,让主机名和IP之间能够相互解析,当然也可以通过修改host文件进行配置。

- 小环境中不建议大家通过DNS的方式,如果DNS挂掉的话那么集群环境也就挂掉了。

3、修改host文件【非集群环境可省略】

vim /etc/hosts

在Linux之间相互拷贝文件

#输入完此命令后输入yes,并输入node01的root密码即可复制成功

scp /etc/hosts root@k8s-node01:/etc/hosts

scp /etc/hosts root@k8s-node02:/etc/hosts

4、安装依赖包

yum install -y conntrack ntpdate ntp ipvsadm ipset jq iptables curl sysstat libseccomp wget vim net-tools git

5、设置防火墙为lptables 并设置空规则

#关闭firewalld并取消自启动

systemctl stop firewalld && systemctl disable firewalld

#安装iptables,启动iptables,设置开机自启,清空iptables规则,保存当前规则到默认规则

yum -y install iptables-services && systemctl start iptables && systemctl enable iptables && iptables -F && service iptables save

6、关闭SELINUX

1、关闭swap分区

#关闭swap分区【虚拟内存】并且永久关闭虚拟内存。

swapoff -a && sed -i '/ swap / s/^\(.*\)$/#\1/g' /etc/fstab

kubeadm初始化Kubernetes时的过程中会检测swap分区到底有没有关闭,因为如果开启虚拟内存的话,kubernetes的容器【pod】就有可能会运行在虚拟内存上,会大大的降低容器的工作效率,因此Kubernetes会要求强制关闭,可以通过kubelet的启动参数--fail-swap-on=false更改这个限制。推荐关闭以防止容器运行在虚拟内存的情况出现。

2、关闭SELinux

setenforce 0 && sed -i 's/^SELINUX=.*/SELINUX=disabled/' /etc/selinux/config

7、相对于Kubernetes调整内核参数

cat > kubernetes.conf <#将优化内核文件拷贝到/etc/sysctl.d/文件夹下,这样优化文件开机的时候能够被调用

cp kubernetes.conf /etc/sysctl.d/kubernetes.conf

#手动刷新,让优化文件立即生效

sysctl -p /etc/sysctl.d/kubernetes.conf

非Linux4的内核下,将会弹出“sysctl:cannot stat /proc/sys/net/netfilter/nf_conntrack_max:没有那个文件或目录”,无视即可。

8、调整系统时区

#设置系统时区为中国/上海

timedatectl set-timezone Asia/Shanghai

#将当前的 UTC 时间写入硬件时钟

timedatectl set-local-rtc 0

#重启依赖于系统时间的服务

systemctl restart rsyslog

systemctl restart crond

9、关闭系统不需要的服务

#关闭及禁用邮件服务

systemctl stop postfix && systemctl disable postfix

10、设置日志的保存方式

在Centos7以后,因为引导方式改为了system.d,所以有两个日志系统同时在工作,默认的是rsyslogd,以及systemd journald

使用systemd journald更好一些,因此我们更改默认为systemd journald,只保留一个日志的保存方式。

- 1、创建保存日志的目录

mkdir /var/log/journal

- 2、创建配置文件存放目录

mkdir /etc/systemd/journald.conf.d

- 3、创建配置文件

cat > /etc/systemd/journald.conf.d/99-prophet.conf <4、重启systemd journald的配置

systemctl restart systemd-journald

11、升级Linux内核为4.44版本

CentOS 7.x 系统自带的3.10.x内核存在一些Bugs.导致运行的Docker.Kubernetes不稳定。

- 1、获取源

rpm -Uvh http://www.elrepo.org/elrepo-release-7.0-4.el7.elrepo.noarch.rpm

- 2、开始安装,安装完成后检查 /boot/grub2/grub.cfg中对应内核menuentry中是否包含 initrd16 配置,如果没有,再安装一次!

yum --enablerepo=elrepo-kernel install -y kernel-lt

- 3、查看系统中的全部内核【可忽略】

rpm -qa | grep kernel

- 4、设置开机从新内核启动

grub2-set-default 'CentoS Linux(4.4.202-1.el7.elrepo.×86_64) 7 (Core)'

12、重启启动使配置生效

reboot

13、查看正在使用的内核【可忽略】

uname -r

Linux内核相关操作操作可查看:https://www.cnblogs.com/fanqisoft/p/11301630.html

14、开启kube-proxy的ipvs的前置条件

模式改为lvs调度的方式,kube-proxy主要解决的是svc(service)与pod之间的调度关系,ipvs的调度方式可以极大的增加它的访问效率,所以这种方式现在是我们必备的一种。

- 1、加载netfilter模块

modprobe br_netfilter

- 2、编写一个引导文件,这个文件将会引导我们lvs的一些相关依赖的加载,注意这里的依赖并不是rpm包含,也是模块依赖

cat > /etc/sysconfig/modules/ipvs.modules <- 3.赋予该文件755权限并执行该文件,然后使用lsmod命令查看这些文件是否被引导。

chmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules && lsmod | grep -e ip_vs -e nf_conntrack_ipv4

安装Docker

1、安装Docker相关依赖

yum install -y yum-utils device-mapper-persistent-data lvm2

2、设置阿里云yum源

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

3、更新yum并安装Docker-ce

yum update -y && yum install -y docker-ce

4、重启

reboot

重启完成后我们之前在Centos设置默认的启动内核4.44将被恢复默认到3.10,因此我们需要再次设置一次并重启

grub2-set-default 'CentoS Linux(4.4.189-1.el7.elrepo.×86_64) 7 (Core)' && reboot

查看当前使用的内核

uname -r

5、启动Docker并设置为开机自启

systemctl start docker

systemctl enable docker

6、配置daemon文件

cat > /etc/docker/daemon.json <

- exec-opts,设置默认的组为systemd,默认情况下Centos有两个组,一个fs,一个systemd管理的,为了统一化,我们交给systemd管理。

- log-driver,让我们存储日志的方式改为json文件的形式

- log-opts,存储最大为100Mb,这样我们可以在后期通过war/log/content/去查找对应的容器的日志信息,这样就可以在EFK里去搜索对应的信息

- registry-mirrors,设置Docker镜像加速

7、创建存储Docker配置文件的目录

mkdir -p /etc/systemd/system/docker.service.d

8、重新读取配置文件并重启Docker

systemctl daemon-reload && systemctl restart docker && systemctl enable docker

安装Kubeadm(主从配置)

1、导入阿里云yum仓库

配置国内kuberneetes的yum源,由于网络原因,中国无法直接连接到google的网络,需要配置阿里云的yum源(每台master和node都需要操作)

cat < /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

2、安装kubeadm初始化工具,命令行管理工具,Docker交互工具

yum -y install kubeadm-1.16.3 kubectl-1.16.3 kubelet-1.16.3

或

[root@master ~]# yum install -y kubelet kubeadm kubectl

[root@node ~]# yum install -y kubelet kubeadm

Kubelet负责与其他节点集群通信,并进行本节点Pod和容器生命周期的管理。Kubeadm是Kubernetes的自动化部署工具,降低了部署难度,提高效率。Kubectl是Kubernetes集群管理工具

温馨提示:如果yum安装提示找不到镜像之类的,请yum makecache更新下yum源

3、设置kubelet开机自启

systemctl enable kubelet.service

或

systemctl enable kubelet

systemctl start kubelet

因为kubelet需要跟我们的容器接口进行交互,启动我们的容器,而我们的k8s通过kubeadm安装出来以后都是以pod的方式存在,也就是底层是以容器的方式运行,所以kubelet一定要是开机自启的,不然的话,重启以后k8s集群不会启动。

4、初始化k8s主节点

拉取Kubernetes镜像四种方式

1、导入离线的镜像。

kubeadm在初始化k8s集群的时候,会从GCE【谷歌云服务器】里去拉取镜像,并且这些镜像是相当大的,而且速度比较慢,最重要的是,一般都会404,因此我们直接导入离线的镜像。2、从dockerhub上下载相关镜像,然后修改成Kubernetes初始化需要的Tag即可

docker pull kubeimage/kube-apiserver-amd64:v1.16.2

docker pull kubeimage/kube-proxy-amd64:v1.16.2

docker pull kubeimage/kube-controller-manager-amd64:v1.16.2

docker pull kubeimage/kube-scheduler-amd64:v1.16.2

docker pull coredns/coredns:1.6.2

docker pull kubeimage/etcd-amd64:3.3.15-0

docker pull kubeimage/pause-amd64:3.1

将上面拉取的镜像修改成下面的tag

k8s.gcr.io/kube-apiserver:v1.16.2

k8s.gcr.io/kube-proxy:v1.16.2

k8s.gcr.io/kube-controller-manager:v1.16.2

k8s.gcr.io/kube-scheduler:v1.16.2

k8s.gcr.io/coredns:1.6.2

k8s.gcr.io/etcd:3.3.15-0

k8s.gcr.io/pause:3.1

- 3、指定镜像源从阿里云镜像仓库拉取

注意这里执行初始化用到了- -image-repository选项,指定初始化需要的镜像源从阿里云镜像仓库拉取。配置如下:

kubeadm init \

--apiserver-advertise-address=192.168.92.56 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.13.1 \

--pod-network-cidr=10.244.0.0/16

完整的从阿里云拉取Kubernetes镜像:https://www.cnblogs.com/tylerzhou/p/10971336.html

- 4、采用科学上网的方式,就不用这么麻烦了

开始初始化【这些命令应运行在主节点上】

通过如下指令创建默认的kubeadm-config.yaml文件:

kubeadm config print init-defaults > kubeadm-config.yaml

kubeadm-config.yaml组成部署说明:

- InitConfiguration: 用于定义一些初始化配置,如初始化使用的token以及apiserver地址等

- ClusterConfiguration:用于定义apiserver、etcd、network、scheduler、controller-manager等master组件相关配置项

- KubeletConfiguration:用于定义kubelet组件相关的配置项

- KubeProxyConfiguration:用于定义kube-proxy组件相关的配置项

查看并修改kubeadm-config.yaml文件

vim kubeadm-config.yaml

#修改的内容

localAPIEndpoint:

advertiseAddress: 192.168.66.77 //当前服务器的节点地址(当前ip地址)

kubernetesVersion: v1.16.3 //模板的版本可能与我们实际安装的版本不同,需要修改

networking:

podSubnet: 10.244.0.0/16 //(+)声明pod的所处网段【注意,必须要添加此内容】默认情况下我们会安装一个Flannel网络插件去实现覆盖性网路,它的默认pod网段就这么一个网段,如果这个网段不一致的话,后期我们需要进入pod一个个修改

serviceSubnet: 10.96.0.0/12

#添加的内容【请注意,在Kubernetes 1.11和更高版本中,默认SupportIPVSProxyMode设置为true,因此高版本中此部分可省略。github文档:https://github.com/kubernetes/kubernetes/blob/master/pkg/proxy/ipvs/README.md】

apiVersion: kubeproxy.config.k8s.io/v1alpha1 //把默认的调度方式改为ipvs调度模式

kind: KubeProxyConfiguration

kubeProxy:

config:

featureGates:

SupportIPVSProxyMode: true

mode: ipvs

开始进行初始化

使用指定的yaml文件进行初始化安装 自动颁发证书(1.13后支持) 把所有的信息都写入到 kubeadm-init.log中

kubeadm init --config=kubeadm-config.yaml --upload-certs | tee kubeadm-init.log

通过初始化日志查看初始化过程中的信息

vim kubeadm-init.log

日志信息一般有以下几点:

1.最开始告诉我们kubernetes的版本

2.检测当前运行环境

3.为k8s集群下载镜像【时间很长,镜像需要从Google GCE下载】

4.开始安装镜像

5.在/var/lib/kubelet/kubeadm-flags.env文件中保存了kubelet环境变量

6.在/var/lib/kubelet/config.yaml文件中保存了kubelet配置文件

7.在/etc/kubernetes/pki目录中保存了k8s所使用的所有的证书,因为k8s采用了http协议进行的C/S结构的开发,它为了安全性考虑在所有的组件通讯的时候采用的是https的双向认证的方案,所以k8s需要大量的CE证书以及私钥密钥

8.配置DNS以及当前默认的域名【svc(service)的默认名称】

9.生成k8s组件的密钥

10。指定DNS的名称及地址

11.在/etc/kubernetes目录下生成k8s组件的配置文件

12.RBAC授权

13.初始化成功

初始化完成后需要的工作

在当前的用户的Home目录下创建.kube目录(这个目录中保存我们的连接配置,kubectl和kubeApi进行https通讯,所以有一些缓存需要保存以及一些认证文件)

mkdir -p $HOME/.kube

拷贝集群管理员的配置文件到这个目录下

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

授予权限(所有者 所有组授予当前的用户)

sudo chown $(id -u):$(id -g) $HOME/.kube/config

查看k8s节点状态

kubectl get node

此时主节点状态为NotReady,因为k8s需要扁平化的网络,此时k8s中还没有构建flannel网络插件

安装flannel网络插件,下载flannel yaml文件

wget https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

安装好后,创建flannel

kubectl create -f kube-flannel.yml

查看flannel是否部署成功【系统组件默认在kube-system命名空间下】,同样使用ifconfig也可以看到flannel

kubectl get pod -n kube-system

此时查看node状态应该为Ready状态

将k8s子节点加入到k8s主节点【命令在vim kubeadm-init.log中】,该命令在子节点运行

kubeadm join masterIp:masterPort --token xxx

此时查看node节点应该有3个,但子节点状态为notReady,等待子节点的flannel初始化完成即可。

如果子节点执行加入主节点的命令报错的话,可以尝试执行kubeadm reset命令后重试

至此,Kubernetes集群部署成功

参考:

https://www.cnblogs.com/fanqisoft/p/11498049.html

https://www.cnblogs.com/fanqisoft/p/11498217.html

https://www.cnblogs.com/liangyuntao-ts/p/11055856.html

https://www.cnblogs.com/tylerzhou/p/10971336.html

https://my.oschina.net/Kanonpy/blog/3006129