Scrapy

Scrapy是用纯Python实现一个为了爬取网站数据、提取结构性数据而编写的应用框架,用途非常广泛。

框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内容以及各种图片,非常之方便。

Scrapy 使用了 Twisted['twɪstɪd] 异步网络框架来处理网络通讯,可以加快我们的下载速度,不用自己去实现异步框架,并且包含了各种中间件接口,可以灵活的完成各种需求。

Scrapy框架同步异步展示图:

异步:调用在发出之后,这个调用就直接返回,不管有无结果

非阻塞:关注的是程序在等待调用结果(消息,返回值)时的状态,指在不能立刻得到结果之前,该调用不会阻塞当前线程

Scrapy框架架构图

Scrapy的各种功能:

Scrapy Engine(引擎): 负责Spider、ItemPipeline、Downloader、Scheduler中间的通讯,信号、数据传递等。

Scheduler(调度器): 它负责接受引擎发送过来的Request请求,并按照一定的方式进行整理排列,入队,当引擎需要时,交还给引擎。

Downloader(下载器):负责下载Scrapy Engine(引擎)发送的所有Requests请求,并将其获取到的Responses交还给Scrapy Engine(引擎),由引擎交给Spider来处理,

Spider(爬虫):它负责处理所有Responses,从中分析提取数据,获取Item字段需要的数据,并将需要跟进的URL提交给引擎,再次进入Scheduler(调度器),

Item Pipeline(管道):它负责处理Spider中获取到的Item,并进行进行后期处理(详细分析、过滤、存储等)的地方.

Downloader Middlewares(下载中间件):可以自定义扩展下载功能的组件(代理、cokies等)。

Spider Middlewares(Spider中间件):可以自定扩展和操作引擎和Spider中间通信的功能组件(比如进入Spider的Responses;和从Spider出去的Requests)

Scrapy主要包括了以下组件:

引擎(Scrapy)

用来处理整个系统的数据流处理, 触发事务(框架核心)

调度器(Scheduler)

用来接受引擎发过来的请求, 压入队列中, 并在引擎再次请求的时候返回. 可以想像成一个URL(抓取网页的网址或者说是链接)的优先队列, 由它来决定下一个要抓取的网址是什么, 同时去除重复的网址

下载器(Downloader)

用于下载网页内容, 并将网页内容返回给蜘蛛(Scrapy下载器是建立在twisted这个高效的异步模型上的)

爬虫(Spiders)

爬虫是主要干活的, 用于从特定的网页中提取自己需要的信息, 即所谓的实体(Item)。用户也可以从中提取出链接,让Scrapy继续抓取下一个页面

项目管道(Pipeline)

负责处理爬虫从网页中抽取的实体,主要的功能是持久化实体、验证实体的有效性、清除不需要的信息。当页面被爬虫解析后,将被发送到项目管道,并经过几个特定的次序处理数据。

下载器中间件(Downloader Middlewares)

位于Scrapy引擎和下载器之间的框架,主要是处理Scrapy引擎与下载器之间的请求及响应。

爬虫中间件(Spider Middlewares)

介于Scrapy引擎和爬虫之间的框架,主要工作是处理蜘蛛的响应输入和请求输出。

调度中间件(Scheduler Middewares)

介于Scrapy引擎和调度之间的中间件,从Scrapy引擎发送到调度的请求和响应。

Scrapy运行流程大概如下:

引擎从调度器中取出一个链接(URL)用于接下来的抓取

引擎把URL封装成一个请求(Request)传给下载器

下载器把资源下载下来,并封装成应答包(Response)

爬虫解析Response

解析出实体(Item),则交给实体管道进行进一步的处理

解析出的是链接(URL),则把URL交给调度器等待抓取

其实Scrapy框架需要自己手写的东西只有Spider(爬虫)和Item Pipeline(管道)俩个模块,但是对于下载失败的url,scrapy会重新发起请求,只有当调度器中不存在任何request了,整个程序才会停止。

具体scrapy的安装步骤:

Scrapy框架官方网址:‘http://doc.scrapy.org/en/latest’

Scrapy中文维护站点:’http://scrapy-chs.readthedocs.io/zh_CN/latest/index.html’

Windows 安装方式

Python 3

升级pip版本:

pip3 install --upgrade pip

通过pip 安装 Scrapy 框架

pip3 install Scrapy

Ubuntu 安装方式

通过pip3 安装 Scrapy 框架

sudo pip3 install scrapy

如果安装不成功再试着添加这些依赖库:

安装非Python的依赖

sudo apt-get install python3-dev python-pip libxml2-dev libxslt1-dev zlib1g-dev libffi-dev libssl-dev

基本创建项目的命令是:

1.scrapy startproject ‘项目名称’

2. cd sp1

3. scrapy genspider xiaohuar(项目名字,运行项目的时候用:scrapy crawl xiaohuar) xiaohuar.com(域名)

4.scrapy genspider baidu baidu.com (爬虫文件)

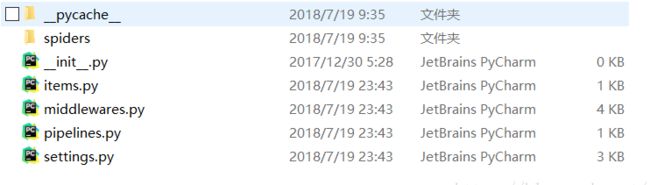

Scrapy每个文件主要的作用:

items.py 设置数据存储模板,用于结构化数据,如:Django的Model

pipelines 数据处理行为,如:一般结构化的数据持久化

settings.py 配置文件,如:递归的层数、并发数,延迟下载等

spiders 爬虫目录,如:创建文件,编写爬虫规则

.实施爬虫

定义Item

Item 是用来保存爬取到的数据的容器,创建一个 scrapy.Item 类, 并且定 义类型为 scrapy.Field 的类属性来定义一个Item。将需要爬取的内容与Field()定 义的属性对应。

.爬虫(spider)

编写第一个爬虫(Spider) 创建一个继承 scrapy.Spider 的子类Douban,且定义以下三个属性:

(1)name: 用于区别Spider。 该名字必须是唯一的---》

(2)start_urls: 包含了Spider在启动时进行爬取的url列表。 因此,第一个被获取到的 页面将是其中之一。 后续的URL则从初始的URL获取到的数据中提取。

(3)parse() 是spider的一个方法。 被调用时,每个初始URL完成下载后生成的 Response 对象将会作为唯一的参数传递给该函数。 该方法负责解析返回的数据 (response data),提取数据(生成item)以及生成需要进一步处理的URL的 Request 对象

编写第一个爬虫

数据持久化:

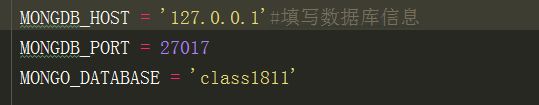

在setting.py文件中:

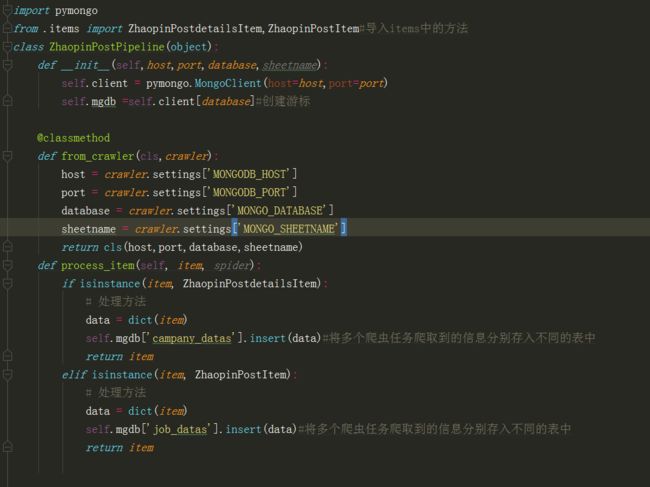

在pipelines.py文件中: