写在前面:

提升图卷积效率方法->空域卷积来源与发展及应用

空域卷积(Spatial Convolution)

我们先来介绍下空域卷积(Spatial Convolution)。从设计理念上看,空域卷积与深度学习中的卷积的应用方式类似,其核心在于聚合邻居结点的信息。比如说,一种最简单的无参卷积方式可以是:将所有直连邻居结点的隐藏状态加和,来更新当前结点的隐藏状态。这里非参式的卷积只是为了举一个简单易懂的例子,实际上图卷积在建模时需要的都是带参数、可学习的卷积核。

1、MPNN

1)介绍

信息传递网络(Message Passing Neural Networks, MPNNs)是由Gilmer等人提出的一种图神经网络通用计算框架。原文以量子化学为例,根据原子的性质(对应节点特征)和分子的结构(对应边特征)预测了13种物理化学性质。

2)理论

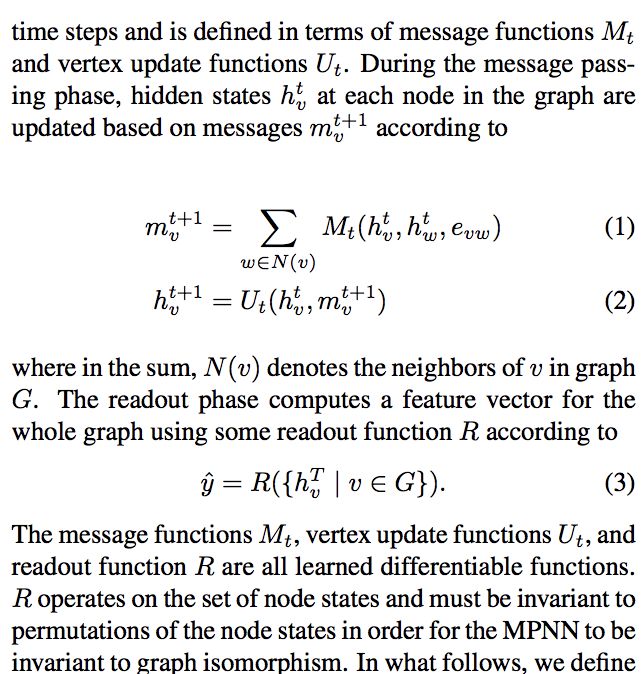

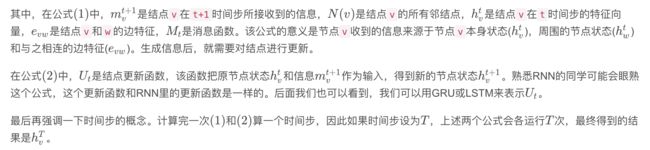

MPNN的前向传播包括两个阶段,第一个阶段称为message passing(信息传递)阶段,第二个阶段称为readout(读取)阶段。

3)实例

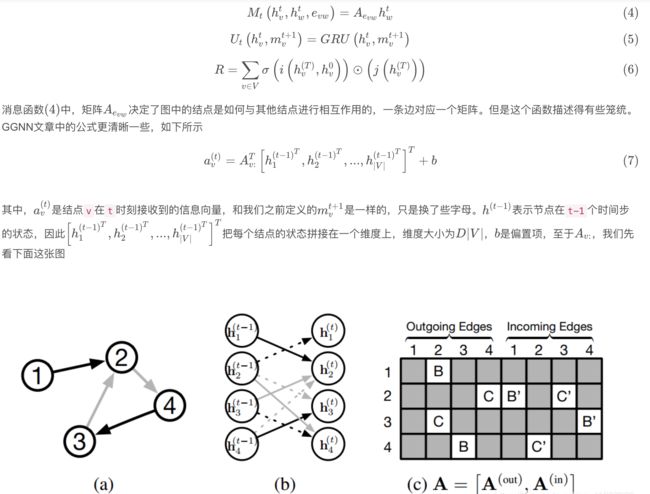

2、GSAE

PinSAGE( PinSage:第一个基于GCN的工业级推荐系统)为GCN落地提供了实践经验,而本文是PinSAGE的理论基础,同样出自斯坦福,是GCN非常经典和实用的论文。

参看资料:

1、图神经网络通用框架信息传递网络(MPNNs)

https://blog.csdn.net/qq_41987033/article/details/103532624

2、人人都能看懂的GRU

https://zhuanlan.zhihu.com/p/32481747

3、人人都能看懂的LSTM

https://zhuanlan.zhihu.com/p/32085405

4、MPNN 论文原文

Neural Message Passing for Quantum Chemistry

https://arxiv.org/pdf/1704.01212.pdf

5、GSAE 论文原文

Inductive Representation Learning on Large Graphs

https://arxiv.org/pdf/1706.02216.pdf

6、GCN 论文原文

GRAPH CONVOLUTIONAL NETWORKS

https://tkipf.github.io/graph-convolutional-networks/

7、何时能懂你的心——图卷积神经网络(GCN)

https://zhuanlan.zhihu.com/p/71200936

8、GraphSAGE: GCN落地必读论文

https://zhuanlan.zhihu.com/p/62750137

9、GraphSAGE:我寻思GCN也没我牛逼

https://zhuanlan.zhihu.com/p/74242097

补充tips:

补充LSTM:

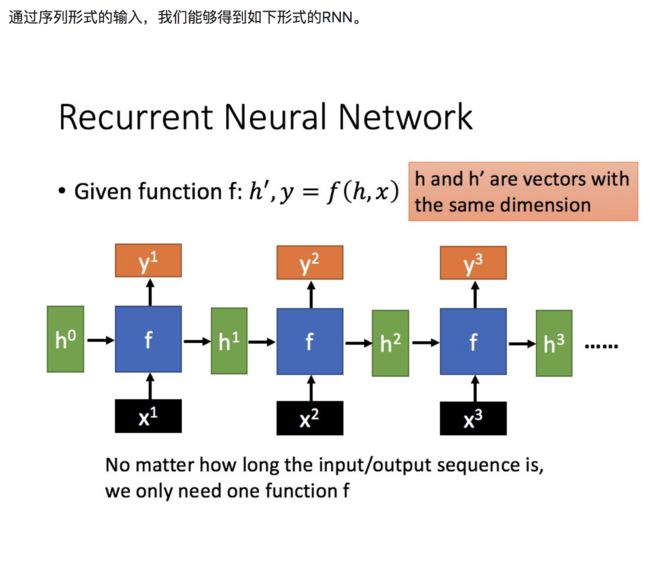

1)RNN提出原因:

循环神经网络(Recurrent Neural Network,RNN)是一种用于处理序列数据的神经网络。相比一般的神经网络来说,他能够处理序列变化的数据。比如某个单词的意思会因为上文提到的内容不同而有不同的含义,RNN就能够很好地解决这类问题。

2)LSTM提出原因:

长短期记忆(Long short-term memory, LSTM)是一种特殊的RNN,主要是为了解决长序列训练过程中的梯度消失和梯度爆炸问题。简单来说,就是相比普通的RNN,LSTM能够在更长的序列中有更好的表现。

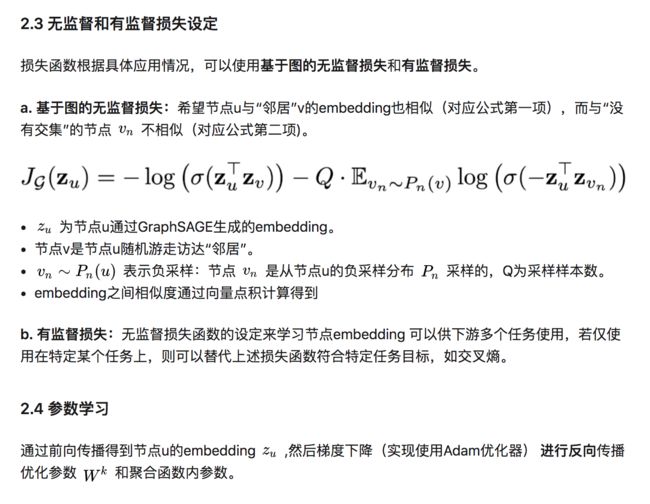

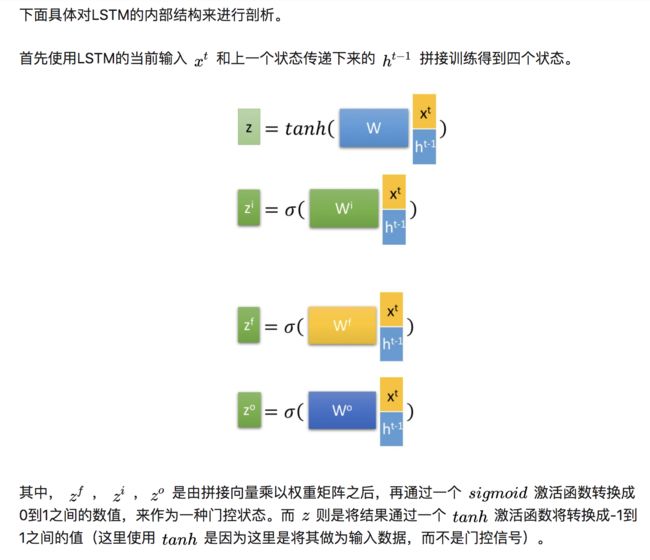

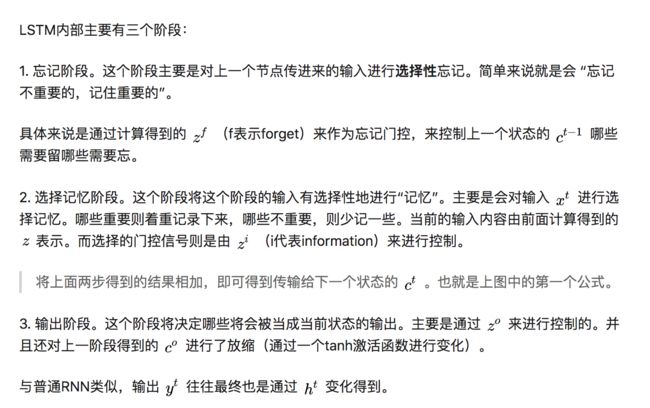

LSTM内部三阶段分析:

1、遗忘阶段

遗忘参数,通过上一次状态c(t)和输入x(t)经过参数矩阵和sigmoid计算,和上一次状态c(t)进行Hadamard乘积

2、选择记忆阶段

选择记忆参数,通过上一次状态c(t)和输入x(t)经过参数矩阵和sigmoid计算,和变化后的输入z进行Hadamard乘积

3、输出阶段

矩阵加法求出下一个状态c(t+1),将下一个状态c(t+1)进行tanh变换后和输出缩放参数计算隐藏状态

将隐藏状态h(t+1)进行sigmoid计算得出输出y

补充GRU:

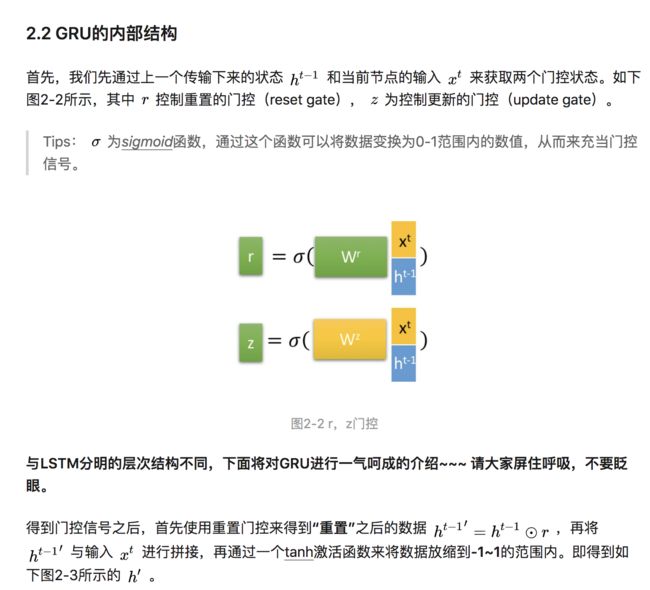

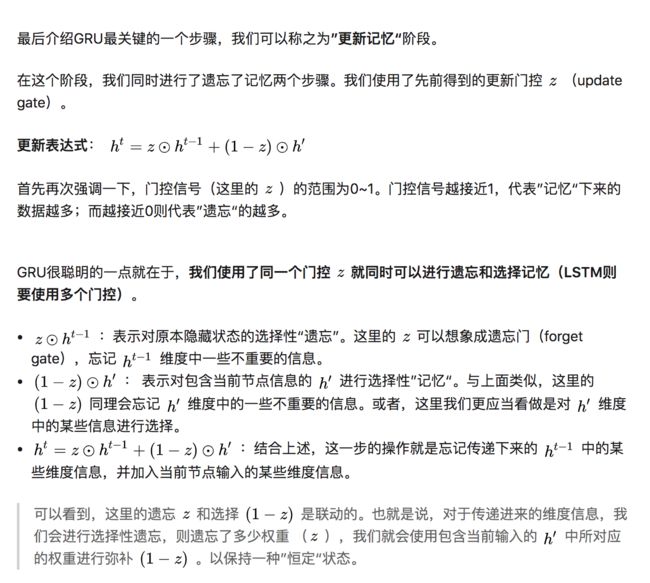

1)提出GRU的原因

GRU输入输出的结构与普通的RNN相似,其中的内部思想与LSTM相似。与LSTM相比,GRU内部少了一个”门控“,参数比LSTM少,但是却也能够达到与LSTM相当的功能。考虑到硬件的计算能力和时间成本,因而很多时候我们也就会选择更加”实用“的GRU啦。