4.1 实验目的

了解什么是YARN框架,如何搭建YARN分布式集群,并能够使用YARN集群提交一些简单的任务,理解YARN作为Hadoop生态中的资源管理器的意义。

4.2 实验要求

搭建YARN集群,并使用YARN集群提交简单的任务。观察任务提交的之后的YARN的执行过程。

4.3 实验原理

4.3.1 YARN概述

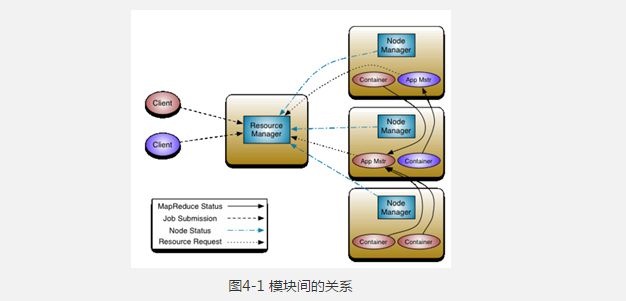

YARN是一个资源管理、任务调度的框架,采用master/slave架构,主要包含三大模块:ResourceManager(RM)、NodeManager(NM)、ApplicationMaster(AM)。其中,ResourceManager负责所有资源的监控、分配和管理,运行在主节点; NodeManager负责每一个节点的维护,运行在从节点;ApplicationMaster负责每一个具体应用程序的调度和协调,只有在有任务正在执行时存在。对于所有的applications,RM拥有绝对的控制权和对资源的分配权。而每个AM则会和RM协商资源,同时和NodeManager通信来执行和监控task。几个模块之间的关系如图4-1所示:

图4-1 模块间的关系

4.3.2 YARN运行流程

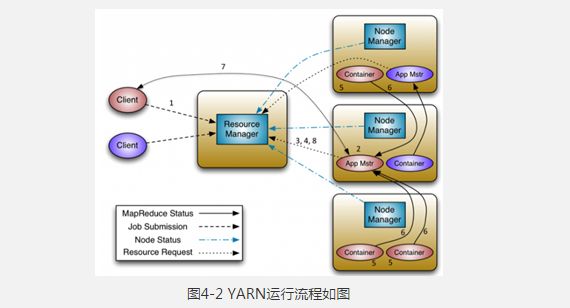

YARN运行流程如图4-2所示:

图4-2 YARN运行流程如图

client向RM提交应用程序,其中包括启动该应用的ApplicationMaster的必须信息,例如ApplicationMaster程序、启动ApplicationMaster的命令、用户程序等。

ResourceManager启动一个container用于运行ApplicationMaster。

启动中的ApplicationMaster向ResourceManager注册自己,启动成功后与RM保持心跳。

ApplicationMaster向ResourceManager发送请求,申请相应数目的container。

ResourceManager返回ApplicationMaster的申请的containers信息。申请成功的container,由ApplicationMaster进行初始化。container的启动信息初始化后,AM与对应的NodeManager通信,要求NM启动container。AM与NM保持心跳,从而对NM上运行的任务进行监控和管理。

container运行期间,ApplicationMaster对container进行监控。container通过RPC协议向对应的AM汇报自己的进度和状态等信息。

应用运行期间,client直接与AM通信获取应用的状态、进度更新等信息。

应用运行结束后,ApplicationMaster向ResourceManager注销自己,并允许属于它的container被收回。

4.4 实验步骤

该实验主要分为配置YARN的配置文件,启动YARN集群,向YARN几个简单的任务从而了解YARN工作的流程。

4.4.1 在master机上配置YARN

操作之前请确认HDFS已经启动,具体操作参考之前的实验内容。

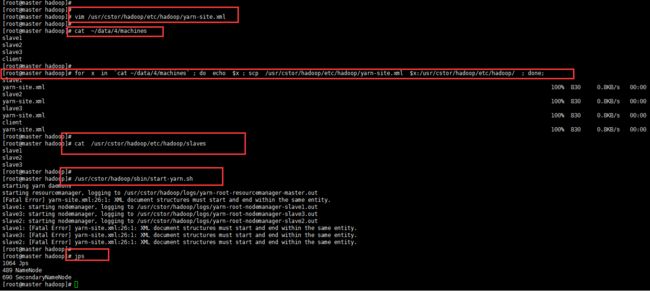

指定YARN主节点,编辑文件“/usr/cstor/hadoop/etc/hadoop/yarn-site.xml”,将如下内容嵌入此文件里configuration标签间:

yarn.resourcemanager.hostname

master

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn-site.xml是YARN守护进程的配置文件。第一句配置了ResourceManager的主机名,第二句配置了节点管理器运行的附加服务为mapreduce_shuffle,只有这样才可以运行MapReduce程序。

在master机上操作:将配置好的YARN配置文件拷贝至slaveX、client。

[root@master ~]# cat ~/data/4/machines

slave1

salve2

slave3

client

[allen@cmaster ~]# for x in `cat ~/data/4/machines` ; do echo $x ; scp /usr/cstor/hadoop/etc/hadoop/yarn-site.xml $x:/usr/cstor/hadoop/etc/hadoop/ ; done;

4.4.2 统一启动YARN

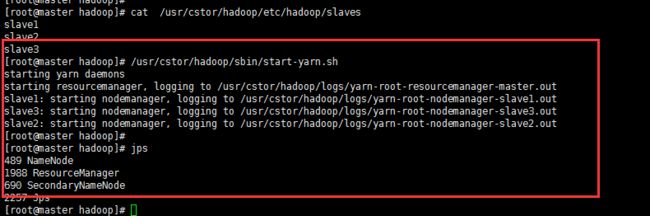

确认已配置slaves文件,在master机器上查看:

[root@master ~]# cat /usr/cstor/hadoop/etc/hadoop/slaves

slave1

slave2

slave3

[root@master ~]#

YARN配置无误,统一启动YARN:

[root@master ~]# /usr/cstor/hadoop/sbin/start-yarn.sh

4.4.3 验证YARN启动成功

读者可分别在四台机器上执行如下命令,查看YARN服务是否已启动。

[root@master ~]# jps #jps查看java进程

你会在master上看到类似的如下信息:

2347 ResourceManager

这表明在master节点成功启动ResourceManager,它负责整个集群的资源管理分配,是一个全局的资源管理系统。

而在slave1、slave2、slave3上看到类似的如下信息:

4021 NodeManager

NodeManager是每个节点上的资源和任务管理器,它是管理这台机器的代理,负责该节点程序的运行,以及该节点资源的管理和监控。YARN集群每个节点都运行一个NodeManager。

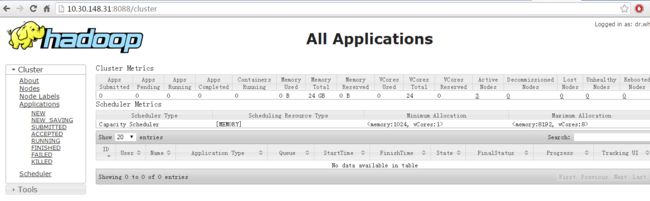

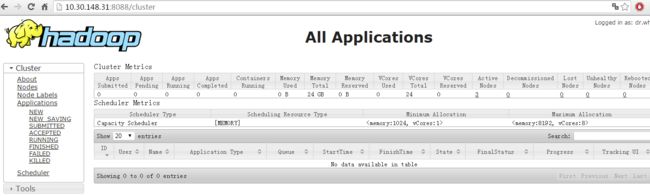

在当前的Windows机器上打开浏览器,地址栏输入master的IP和端口号8088(例:10.1.1.7:8088),即可在Web界面看到YARN相关信息。

4.4.4 在client机上提交DistributedShell任务

distributedshell,他可以看做YARN编程中的“hello world”,它的主要功能是并行执行用户提供的shell命令或者shell脚本。-jar指定了包含ApplicationMaster的jar文件,-shell_command指定了需要被ApplicationMaster执行的Shell命令。

在xshell上再打开一个client的连接,执行:

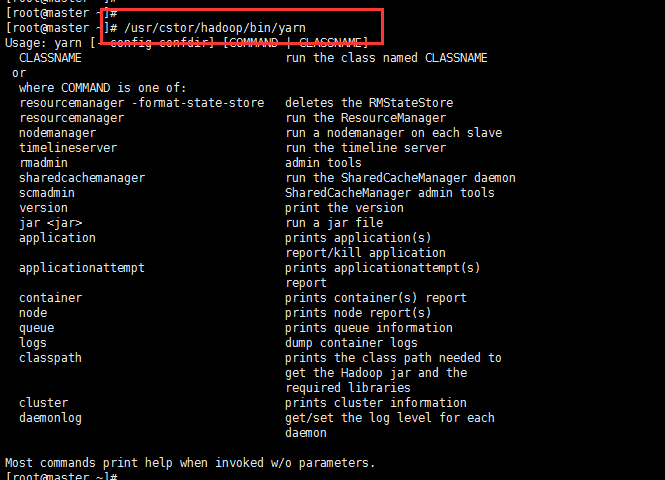

[root@client ~]# /usr/cstor/hadoop/bin/yarn

org.apache.hadoop.yarn.applications.distributedshell.Client -jar \

/usr/cstor/hadoop/share/hadoop/yarn/hadoop-yarn-applications-distributedshell-2.7.1.jar \

-shell_command uptime

【打开浏览器】

4.4.5 在client机上提交MapReduce型任务

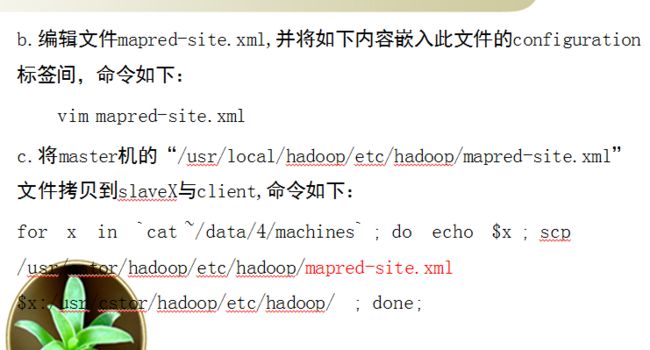

(1)指定在YARN上运行MapReduce任务

首先,在master机上,将文件“/usr/cstor/hadoop/etc/hadoop/mapred-site.xml. template”重命名为“/usr/cstor/hadoop/etc/hadoop/mapred-site.xml”。

接着,编辑此文件并将如下内容嵌入此文件的configuration标签间:

mapreduce.framework.name

yarn

最后,将master机的“/usr/local/hadoop/etc/hadoop/mapred-site.xml”文件拷贝到slaveX与client,重新启动集群。

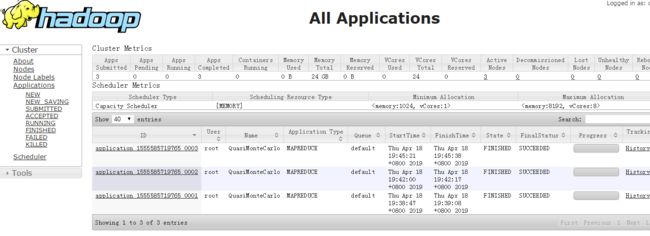

(2)在client端提交PI Estimator任务

首先进入Hadoop安装目录:/usr/cstor/hadoop/,然后提交PI Estimator任务。

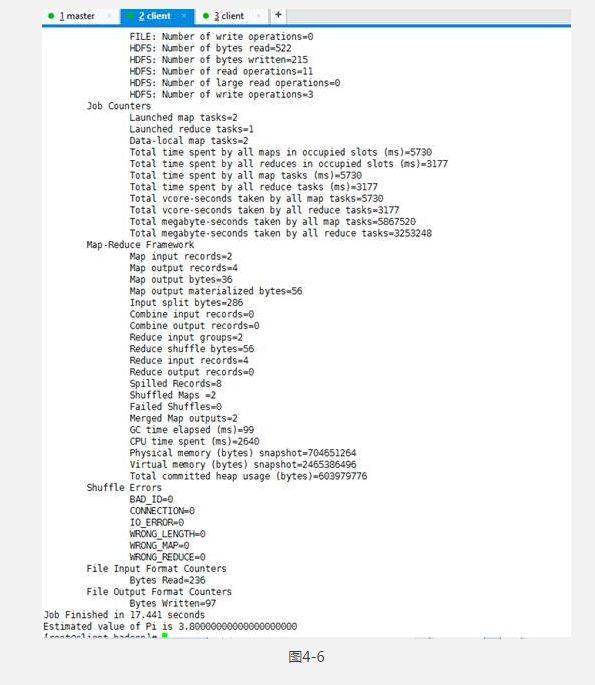

命令最后两个两个参数的含义:第一个参数是指要运行map的次数,这里是2次;第二个参数是指每个map任务,取样的个数;而两数相乘即为总的取样数。Pi Estimator使用Monte Carlo方法计算Pi值的,Monte Carlo方法自行百度。

cd /usr/cstor/hadoop

[root@client hadoop]# bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar pi 2 10

4.5 实验结果

(1)yarn启动之后在master上的web界面上能看到的界面。如图4-3所示:

图4-3

(2)提交DistributedShell任务之后web界面看到的界面应该是。如图4-4所示:

图4-4

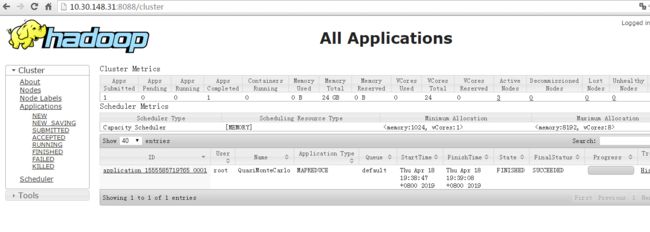

(3)提交PI任务之后web界面上看到的。如图4-5所示:

图4-5

在终端能观察到的界面。如图4-6所示:

错误日志:

【这个问题出自于第一步的配置没配好。格式出现问题,现在上面是完整的,整体复制粘贴】

[root@master hadoop]# /usr/cstor/hadoop/sbin/start-yarn.sh

starting yarn daemons

starting resourcemanager, logging to /usr/cstor/hadoop/logs/yarn-root-resourcemanager-master.out

[Fatal Error] yarn-site.xml:26:1: XML document structures must start and end within the same entity.

slave2: starting nodemanager, logging to /usr/cstor/hadoop/logs/yarn-root-nodemanager-slave2.out

slave1: starting nodemanager, logging to /usr/cstor/hadoop/logs/yarn-root-nodemanager-slave1.out

slave3: starting nodemanager, logging to /usr/cstor/hadoop/logs/yarn-root-nodemanager-slave3.out

slave2: [Fatal Error] yarn-site.xml:26:1: XML document structures must start and end within the same entity.

slave1: [Fatal Error] yarn-site.xml:26:1: XML document structures must start and end within the same entity.

slave3: [Fatal Error] yarn-site.xml:26:1: XML document structures must start and end within the same entity.