经典CNN结构完整总结

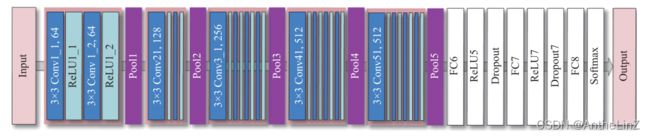

(1)AlexNet:首次采用了整流线性单元(ReLU)、dropout和局部响应归一化(LRN)等新技术,采用了数据增强技术,以提高网络的泛化程度,同时减少过拟合问题。

(2)VGG:所有卷积核的大小都是3×3,较小的卷积内核大小使VGG将CNN的层数扩展到10层以上,增强了网络的表达能力。

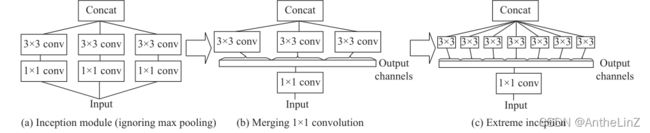

(3)Inception_v3:在Inception_v2的基础上,Inception_v3进一步分解卷积,即任何一个卷积都可以替换为一个卷积之后的一个卷积。

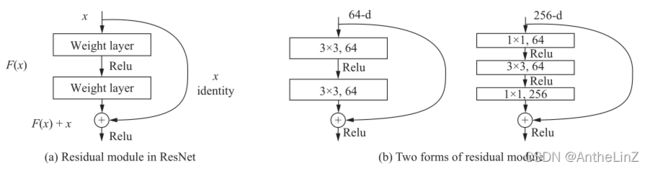

(4)ResNet:依赖于一种残差模块的快捷连接结构,将多个残差模块依次堆叠形成,克服了消失梯度和爆炸梯度问题。

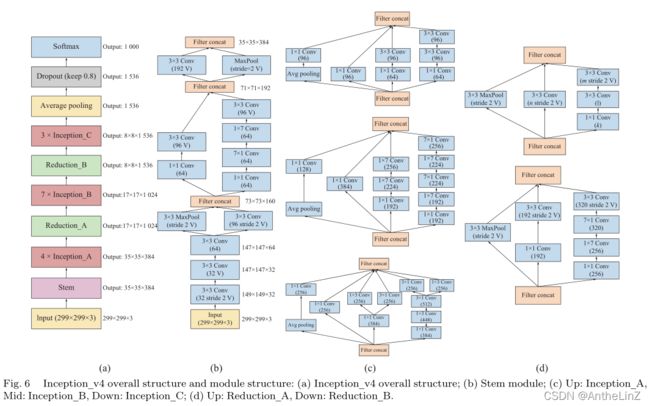

(5)Inception_v4:主要由一个输入模块、三个Inception模块和两个还原模块组成,每个模块都是单独设计的。

(6)Inception_ResNet_v2:将残差模块分别引入到inception_v3和inception_v4中,得到了inception_resnet_v1和inception_resnet_v2。

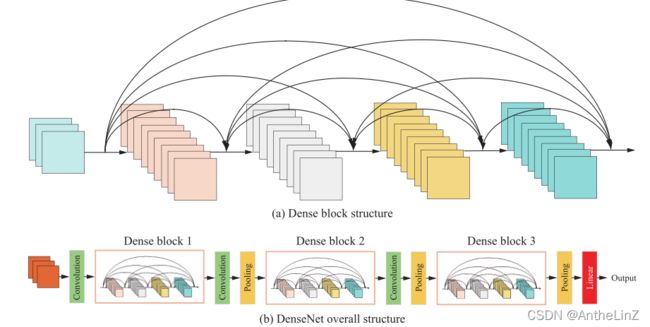

(7)DenseNet:DenseNet是ResNet的一个极端版本。DenseNet引入了从任何层到下面所有层的短连接。通过将特征连接起来,而不是在特征传递给一层之前求和,这使得网络能够更好地利用特征。

(8)Xception:Xception是Inception_v3的另一个改进版本。它基于可以独立进行空间卷积(沿feature map水平和垂直方向的卷积)和通道卷积(沿feature map channel方向的卷积)的假设,将卷积分离开来。Inception中的所有1×1卷积都可以重新表述为一个大卷积,然后在每个输出通道上单独利用卷积,形成极端的Inception。因此,一个有效的策略是执行群内逐点卷积,但不利于信道之间的信息交换。为了解决这个问题,ShuffleNet_v1提出了一种信道shuffle操作

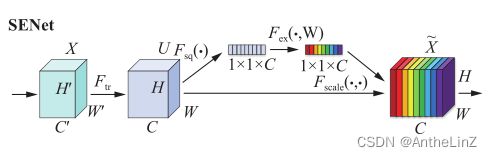

(9)SENet:它通过对特征通道之间的相关性进行建模来增强重要特征,从而提高精度。SENet块是一个子结构,可以嵌入到其他分类或检测模型中。

(10)ResNeXt:ResNeXt是ResNet的升级版本。ResNeXt在不增加参数复杂性的情况下提高了精度,甚至减少了超参数的数量。ResNeXt有三个等效的网络结构。将RseNet中原有的三层卷积块替换为并行叠加拓扑块。拓扑是相同的,但是减少了超参数,这有利于模型迁移。

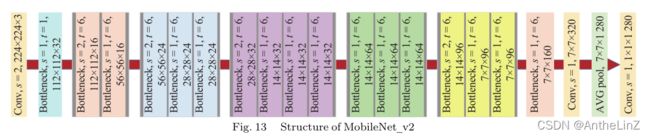

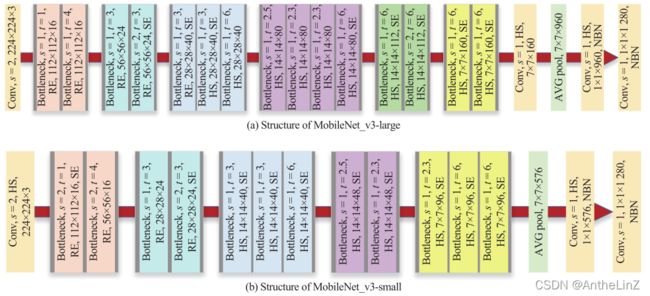

(11)MobileNet_v2 &(12)MobileNet_v3:MobileNet是基于深度可分离卷积来减少参数的数量。深度可分卷积将标准卷积分为两个步骤:深度卷积和点卷积,深度卷积分别对feature map的每个channel进行卷积,点卷积使用1×1卷积来组合feature。MobileNet_v2引入ResNet和DesNet中的快捷连接到网络。由于深度可分卷积的输出受输入通道数和瓶颈残差模块特性的限制,如果不加修改直接将残差引入网络,最初的特征压缩将导致在随后的层中可用的特征太少。因此,MobileNet_v2提出倒置残差——首先扩展特征数量,然后使用卷积提取特征,最后压缩特征。另外,MobileNet_v2取消了倒置残差末端的ReLU,因为ReLU将所有非正输入置零,在特征压缩后增加ReLU会失去特征。

(13)ShuffleNet_v2:在ResNeXt,the packet convolution strategy is applied as a compromise strategy,整个feature map的逐点卷积限制了ResNeXt的性能。

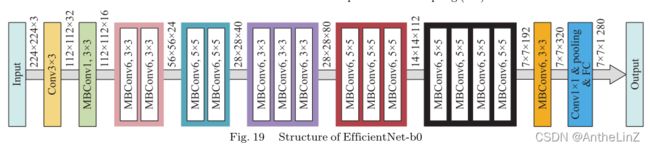

(14)EfficientNet:EfficientNet是2019年提出的,是对当前分类网络进行优化的一种更为普遍的思路。扩大网络、深化网络和提高分辨率是三个常见的网络指标,在以往的大多数网络中都是独立应用的。因此,提出复合模型缩放算法,综合优化网络宽度、网络深度和分辨率,提高精度和现有分类网络,大大减少模型参数量和计算量。EfficientNet采用EfficientNet-b0作为基本网络,设计了b0−b7八种网络结构,其中,EfficientNet-b7的准确率最高。

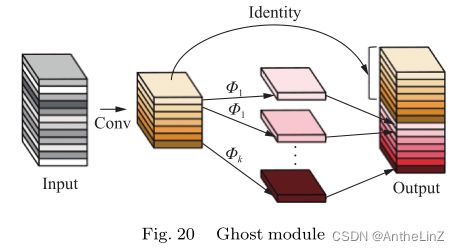

(15)GhostNet:在GhostNet中,提出了一种新颖的ghost模块,它可以用更少的参数生成更多的feature map。具体来说,深度神经网络中的卷积层分为两部分。第一部分涉及到一般的卷积,但是卷积的数量要严格控制。给出了固有特征图的第一部分,然后是采用一系列的简单的线性运算生成更多的特征图。与传统的CNN相比,在不改变输出特征图大小的情况下,ghost模块的参数总数和计算复杂度最低。

(16)RegNet:提出了一种新的网络设计范式,旨在帮助提高对网络设计的理解。重点研究参数化网络的网络设计空间的设计。整个过程类似于经典的手工网络设计,但被提升到了设计空间的层面。利用此规则搜索一个简单的低维网络,即RegNet。RegNet参数化的核心思想是一个好的网络的宽度和深度可以用一个量化的线性函数来解释。特别是,RegNet优于传统的可用模型,在gpu上运行了5倍。

(17)ResNeSt:在ResNeSt中,Zhang等人[73]探索了ResNet的简单架构修改,并在单个网络块中纳入feature map split attention。更具体地说,每个块将feature map划分为几个组(沿着通道维度)和更细粒度的子组或分割,其中,每个组的特征表示是通过其分割表示的加权组合确定的(基于全局上下文信息选择权重)。]将产生的单元称为分离注意块,它保持简单和模块化。通过堆叠几个分散的注意块,一个类似resnet的网络被称为ResNeSt。ResNeSt的架构不需要比现有resnet变体更多的计算,并且很容易被用作其他视觉任务的主干。ResNeSt的性能优于现有所有ResNet变体,在计算效率相同的情况下,比NAS生成的最先进的CNN模型在速度和精度上取得了更好的权衡。