Raki的读paper小记:SimCSE: Simple Contrastive Learning of Sentence Embeddings

Abstract & Introduction & Related Work

- 研究任务

sentence embedding - 已有方法和相关工作

- 面临挑战

- 创新思路

- 用一种非常简单的无监督对比学习方法,来预测自己,仅仅使用标准的dropout作为噪声

- 与以前的工作不同的是,之前的工作将其作为一个三分类任务(蕴含、中性和矛盾),我们利用蕴含对可以自然地作为正向实例的事实

- 实验结论

- sota

- 我们发现,dropout作为最小的数据增广,去除它就会导致表示坍缩

- 增加相应的矛盾对作为hard negatives,可以进一步提高性能

- 我们还与最近发现的预训练的词嵌入遭受各向异性的现象相联系,并证明–通过频谱视角–对比性学习目标 "平坦 "了句子嵌入空间的奇异值分布,从而提高了均匀性

Background: Contrastive Learning

对比学习的目的是通过把语义相近的邻居拉到一起,把非邻居推开来学习有效的表示

Positive instances

对比学习的关键问题在于如何构建正样本对。在视觉上的表示,一个有效的解决方法是选取一张图片的两个不同的变换(剪裁,翻转,变形,旋转)作为正样本对。相似的方法在语言表示上也被应用,通过增广技术比如词的删除,重新排序,替换。然而数据增广在NLP上有天然的困难因为它的离散性。

简单地在中间表征上使用标准的dropout,就能胜过这些离散的操作

Alignment and uniformity

Unsupervised SimCSE

将一个样本输入到encoder两次,得到两个有不同噪声的embedding,然后优化以下项

Dropout noise as data augmentation

我们把它看作是一种最小形式的数据增强:正面的一对采取完全相同的句子,他们的嵌入只在dropout掩码上有所不同

跟其他数据增强方式的对比,没有一种方法比dropout 噪声效果更好

跟nsp训练方法的比较

Why does it work?

在训练过程中,我们每隔10步对这些模型进行检查,并在图2中对排列和统一性指标3进行了可视化,同时还有一个简单的数据扩充模型 “删除一个词”。如图所示,从训练前的检查点开始,所有模型都大大改善了统一性。然而,两个特殊变体的对齐度也急剧下降,而我们的无监督SimCSE保持了稳定的对齐度,这要归功于dropout噪声的使用。这也证明了从预训练的检查点开始是至关重要的,因为它提供了良好的初始对齐。最后,"删除一个词 "改善了对齐方式,但在统一性指标上取得的收益较小,最终表现不如无监督的SimCSE

Supervised SimCSE

之前的工作证明了监督NLI数据集对学习句向量是非常有效的

Choices of labeled data

不同数据集的对比

为了公平比较,我们还用相同数量的训练对进行了实验,在所有的选项中,使用NNLI(SNLI+MNLI)数据集的蕴含对表现最好。我们认为这是合理的,因为NNLI数据集包括高质量的、来自人群的配对。另外,人类注释者要根据前提手动写出假设,而且两个句子的词汇重叠度往往较低。例如,我们发现entailment对(SNLI + MNLI)的词汇重叠率(两个词包之间测量的F1)为39%,而QQP和ParaNMT的词汇重叠率为60%和55%。

Contradiction as hard negatives

Connection to Anisotropy

学习到的嵌入在向量空间中占据一个狭窄的锥体,这严重限制了它们的表现力,用捆绑式输入/输出嵌入训练的语言模型导致了各向异性的词嵌入,语言模型中单词嵌入矩阵的奇异值会急剧下降:除了几个主要的奇异值,其他的都接近于零

在这项工作中,我们从理论和经验上表明,对比性目标也可以缓解各向异性问题

各向异性问题与均匀性有天然的联系,两者都强调嵌入应该均匀地分布在空间中,直觉上,优化对比学习的目标会促进均匀性(或减轻各向异性问题),因为objective把负样本推远,在这里,我们从单数谱的角度–这是分析词嵌入的常见做法,并表明对比性目标可以 "平坦 "句子嵌入的奇异值分布,使表征更加各向同性

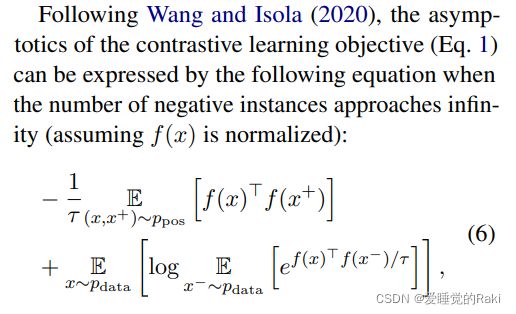

根据对比学习目标的渐进原理,公式1可以被表示为下面的公式

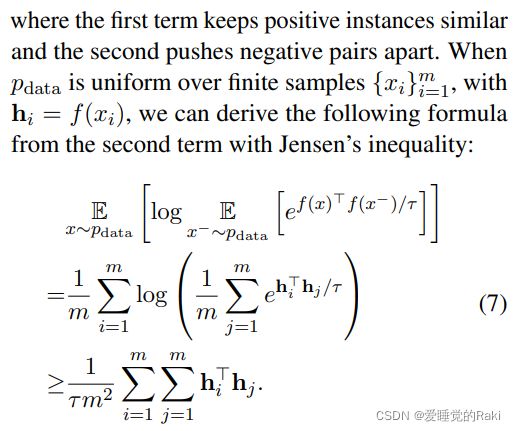

我们可以从第二项中用Jensen不等式推导出以下公式

对公式6中的第二项进行优化,实质上是最小化 W W T WW^T WWT中所有元素之和的上界

由于我们将 h i h_i hi 归一化, W W T WW^T WWT对角线上的所有元素都是1,那么 t r ( W W T ) tr(WW^T) tr(WWT)(所有特征值之和)就是一个常数。根据Merikoski(1984),如果WW>中的所有元素都是正数,根据图G.1,大多数时候都是这种情况,那么 S u m ( W W T ) Sum(WW^T) Sum(WWT)是 W W T WW^T WWT最大特征值的上限。当最小化公式6中的第二项时,我们减少了 W W T WW^T WWT 的顶部特征值,并且内在地 "平坦 "了嵌入空间的奇异谱。因此,对比性学习有望缓解表征退化问题,并提高句子嵌入的统一性

Experiment

Conclusion

在这项工作中,我们提出了SimCSE,一个简单的对比学习框架,它大大改善了最先进的句子嵌入的语义文本相似性任务。我们提出了一种无监督的方法,该方法用辍学噪音来预测输入句子本身,以及一种利用NLI数据集的监督方法。我们通过分析SimCSE与其他基线模型的一致性和统一性,进一步论证了我们方法的内部工作原理。我们相信,我们的对比目标,特别是无监督的目标,在NLP中可能有更广泛的应用。它为文本输入的数据扩充提供了一个新的视角,并且可以扩展到其他的连续表征上

Remark

简单而且work,不愧是出自cdq之手,高质量好paper