- Python爬虫热点项目之实现代理IP池(IP proxy pool)

薛定谔的猫96

Python爬虫

代理池概述代理池就是由多个稳定可用代理IP组成的池子。用来应对ip反爬,而网上的免费代理稳定可用的极少,更有甚者连收费的也不都是稳定可用。开发环境:windous,python3,sublimetext使用的主要模块:requests,lxml,pymongo,Flask完整源码请前往我的github仓库查看:https://github.com/R2h1/ProxyPool欢迎star哦!!!代

- 力扣题目算法分类【持续更新】

Gene_INNOCENT

比赛题解各类重要算法讲解力扣算法分类

基础算法二分704.二分查找-简单-整数二分34.在排序数组中查找元素的第一个和最后一个位置-中等69.x的平方根-简单-浮点二分287.寻找重复数-中等-二分答案410.分割数组的最大值-困难-二分答案4.寻找两个正序数组的中位数-困难

- python基础练习题:超市收银系统

不爱说话的分院帽

python开发语言

这个超市收银系统包含以下功能:商品管理:支持添加和显示商品信息(ID、名称、价格、库存)购物车功能:可以添加、移除商品,查看购物车和计算总价结算功能:生成收据、处理支付、计算找零并更新库存数据模型:使用面向对象设计,包含商品、购物车和超市类系统运行后会显示菜单,用户可以通过数字选择不同操作,整个流程不需要图形界面,通过命令行交互完成购物和结算过程。importdatetimeclassProduc

- Python零基础入门:魔法方法详解

一、什么是魔法方法?魔法方法(MagicMethods)是Python中一种特殊的方法,它们以双下划线(__)开头和结尾(如__init__、__str__等)。魔法方法允许你定义类在特定情况下的行为,例如初始化、字符串表示、运算符重载等。二、常见的魔法方法分类1.构造和初始化__new__(cls,[...]):创建实例时调用的第一个方法__init__(self,[...]):实例初始化方法_

- Python文件与流处理:高效读写数据的艺术

不爱说话的分院帽

python快速入门python数据库开发语言

引言作为一名程序员,我们每天都需要与文件打交道——无论是读取配置文件、处理日志文件,还是存储程序生成的数据。Python提供了强大而灵活的文件处理能力,让这些操作变得简单高效。本文将深入探讨Python中的文件与流处理,帮助你掌握这一核心技能。、一、文件操作基础1.打开文件Python使用内置的open()函数来打开文件:#基本语法file=open('example.txt','r')#打开文件

- Python 计算月头月尾

一本正经胡说八道的猫

一本正经胡说八道的猫#!/usr/bin/envpython#-*-coding:utf-8-*-importdatetimeimportcalendartime=datetime.date(2022,1,20)#年,月,日#求该月第一天first_day=datetime.date(time.year,time.month,1)print('该月第一天:%s'%(first_day))#求前一个

- python学生成绩管理系统【完整版】,Python开发基础面试题

name=self.username.get()password=self.password.get()ifname==‘hacker707’andpassword==‘admin’:self.page.destroy()MenuPage(self.root)else:showinfo(title=‘错误’,message=‘账号或密码错误!’)db.pyimportjsonclassStuden

- NiFi Processors概述

一个老冯

为了能够创建一个高效的NiFi数据数据流程,我们需要了解有哪些Processor类型可以使用。每个新的NiFi版本Processor数量都会增加,当前NiFi版本为1.12.1,内置了288个类型的Proccessor,这些Processor提供从多个不同系统接收数据、路由、转换、处理、拆分和聚合数据以及将数据分发到多个系统的功能。按照功能分类:image.png.procesor分类说明1.1数

- 【深度强化学习】MIP-DQN 实现案例(完整Python代码)

目录MIP-DQN算法概述建模基础训练阶段(Training)部署阶段(OnlineExecution)DNN网络转化为MIP表达式性能指标完整Python代码实现主函数:random_generator_battery模型函数:MIP_DQN基础/专用库包安装模型运行(完整Python代码)参数设置函数:Parameters参考本博客根据论文《Optimalenergysystemschedul

- 【DL经典回顾】激活函数大汇总(四)(Softmax & Softplus附代码和详细公式)

夺命猪头

python机器学习人工智能神经网络numpy

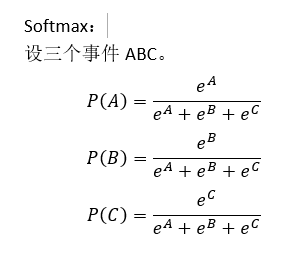

激活函数大汇总(四)(Softmax&Softplus附代码和详细公式)更多激活函数见激活函数大汇总列表一、引言欢迎来到我们深入探索神经网络核心组成部分——激活函数的系列博客。在人工智能的世界里,激活函数扮演着不可或缺的角色,它们决定着神经元的输出,并且影响着网络的学习能力与表现力。鉴于激活函数的重要性和多样性,我们将通过几篇文章的形式,本篇详细介绍两种激活函数,旨在帮助读者深入了解各种激活函数的

- 基于NanoDet的健身姿势纠正系统开发

YOLO实战营

人工智能NanoDet深度学习计算机视觉ui

1.引言在现代健身行业中,正确的运动姿势至关重要,不仅能提升训练效果,还能预防运动损伤。尤其是在进行一些高强度的力量训练时,如深蹲、俯卧撑等,错误的姿势可能导致肌肉不平衡或关节损伤。传统的健身姿势纠正方式依赖教练的人工指导,但随着人工智能技术的发展,使用计算机视觉和深度学习技术来进行姿势纠正,逐渐成为一种高效且可扩展的解决方案。本文将详细介绍如何基于NanoDet(一个轻量化目标检测模型)开发一个

- Go与Python在数据管道与分析项目中的抉择:性能与灵活性的较量

真智AI

人工智能pythongo

你正在设计一个全新数据管道或启动一个分析项目,此时你或许正在思考该选择Python还是Go。五年前,这甚至不是个值得讨论的问题——你会毫不犹豫地选择Python,故事到此为止。然而,近年来Go在数据领域,尤其是在数据基础设施和实时处理方面,正逐渐被更多人采用。实际上,这两种语言都已在现代数据技术栈中找到了各自的定位。Python依然非常适合机器学习和数据分析,而Go则逐步成为高性能数据基础设施的首

- Redis-py 实战指南:从安装到向量索引,Python 操作 Redis 全解析

佑瞻

数据库与知识图谱redispython数据库人工智能

在Python开发中,操作Redis数据库是很多场景下的刚需,而redis-py作为Redis官方推荐的Python客户端,更是我们绕不开的工具。但你是否在安装时踩过版本兼容的坑?是否在连接集群或配置TLS时犯过难?甚至想尝试向量索引却不知从何下手?今天我们就从基础到进阶,手把手带你玩转redis-py,让Python操作Redis变得简单又高效。一、redis-py安装:避坑指南首先,我们需要安

- Python返回函数完全指南:从基础到高级应用

Python_trys

python数据库开发语言Python教程Python技巧Python入门Python基础

包含编程籽料、学习路线图、爬虫代码、安装包等!【点击领取】前言在Python编程中,函数不仅可以执行操作,还可以作为返回值,这种特性为编程带来了极大的灵活性和强大的表达能力。本文将全面介绍Python中的返回函数,从基础概念到高级应用场景,帮助开发者掌握这一重要特性。一、返回函数的基本概念1.1什么是返回函数?返回函数指的是一个函数可以返回另一个函数作为其结果。在Python中,函数是一等对象,可

- Python爬虫实战:从新浪财经爬取股票新闻的完整实现

Python爬虫项目

python爬虫开发语言数据分析php

第一部分:爬虫概述1.1什么是爬虫?爬虫是指通过程序模拟浏览器的行为,自动化地抓取网络上的数据。通过爬虫技术,能够从各种网站上提取信息,广泛应用于数据采集、数据分析、机器学习等领域。1.2新浪财经简介新浪财经是中国最大的财经信息平台之一,提供股票、基金、债券、外汇等多方面的财经新闻和数据。在股票领域,新浪财经提供了大量的股票行情、实时数据、新闻报道等信息,因此爬取新浪财经的股票新闻对于投资分析和决

- AutoGen C#三步变强:比Python还野的多AI协作实战!

墨瑾轩

一起学学C#【四】c#python人工智能

关注墨瑾轩,带你探索编程的奥秘!超萌技术攻略,轻松晋级编程高手技术宝库已备好,就等你来挖掘订阅墨瑾轩,智趣学习不孤单即刻启航,编程之旅更有趣一、第一步:环境搭建——给AutoGen装上"AI乐高积木"目标:用C#搭建AutoGen基础环境,像组装乐高一样准备工具。步骤:克隆AutoGen项目:访问AutoGenGitHub仓库,克隆到本地:gitclonehttps://github.com/mi

- C#进行串口应用开发如何处理串口的异常情况

openwin_top

c#串口应用开发问题系列c#开发语言串口通讯上位机

python编程示例系列python编程示例系列二python的Web神器Streamlit如何应聘高薪职位C#视觉应用开发问题系列c#串口应用开发问题系列microPythonPython最小内核源码解析NI-motion运动控制c语言示例代码解析在C#中进行串口应用开发时,处理串口的异常情况是非常重要的。常见的串口异常包括端口不可用、数据传输错误、超时等

- Spring AI 概述与功能简介

drebander

AI编程spring人工智能java

SpringAI是一个由Spring团队开发的开源框架,旨在为人工智能(AI)和机器学习(ML)提供一个成熟且高效的开发平台。它将Spring生态系统的设计理念应用于AI开发,尤其强调模块化、可移植性以及简洁的集成。SpringAI提供了丰富的功能,涵盖从AI模型的调用到与数据库的集成等多个方面,帮助开发者构建和管理AI驱动的应用程序。1.SpringAI背景SpringAI的背景源于Spring

- python包管理神器【uv】详解

若叶.

pythonuv开发语言pipvirtualenv

目录1uv简介与安装1.1uv作用1.2安装方式一:github/release页下载。方式二:命令行安装(win)方式三:pypi安装确认安装成功1.3卸载2命令帮助3uv管理python版本3.1`uvpython--参数`3.2`uvpythonlist`3.3`uvpythoninstall`4uv运行单个脚本4.1`uvrun.py文件`4.2`uvinit--script`4.3`uv

- Spring AI从入门到精通:构建智能Spring应用的全面指南

java干货仓库

Spring八股文汇总大模型spring人工智能java

随着人工智能技术的快速发展,将大语言模型(LLM)与企业应用集成已成为趋势。SpringAI作为Spring官方推出的AI集成框架,为开发者提供了便捷、标准化的方式来构建智能应用。本文将从基础概念到高级应用,全面介绍SpringAI的核心功能与实践技巧。一、SpringAI概述1.1什么是SpringAI?SpringAI是VMware于2023年推出的开源框架,旨在简化大语言模型(LLM)与Sp

- python爬虫从入门到精通

大模型猫叔

python爬虫数据库

目录一、正确认识Python爬虫二、了解爬虫的本质1.熟悉Python编程2.了解HTML3.了解网络爬虫的基本原理4.学习使用Python爬虫库三、了解非结构化数据的存储1.本地文件2.数据库四、掌握各种技巧,应对特殊网站的反爬措施1.User-Agent2.Cookies3.IP代理五、学习爬虫框架,搭建工程化的爬虫1.创建Scrapy项目2.创建Spider3.编写Spider4.运行Spi

- 在二分类任务中如何处理包含中文的类别特征

Dush32

分类数据挖掘人工智能机器学习数据分析

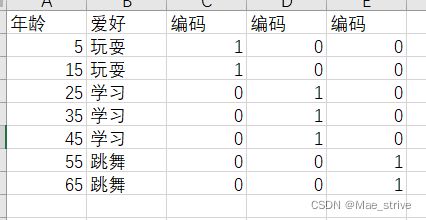

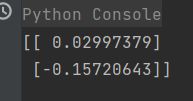

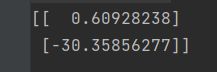

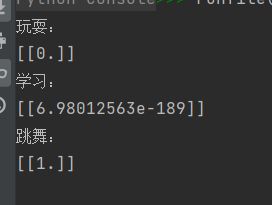

在机器学习中,处理类别特征(CategoricalFeatures)是常见的任务,特别是在中文数据中,很多类别特征如省份、城市等都是字符串类型。如何将这些类别变量转换为模型可以理解的数值格式,是每个数据科学家都必须面对的挑战。在这篇文章中,我们将探讨两种常见的类别特征编码方法:astype('category')和LabelEncoder,并比较它们在二分类任务中的效果。我们以“省份”这一类别特征

- 基于用户画像的商品推荐系统

Dush32

机器学习人工智能python推荐算法

随着人工智能和大数据技术的进步,产品推荐系统成为了现代广告与电商平台中不可或缺的部分。通过深度挖掘用户的行为数据,能够为广告主提供精准的用户画像,从而更高效地推荐相关产品,提升购买转化率。本项目基于科大讯飞AI营销云大赛的赛题,目的是利用用户画像进行产品推荐,预测用户是否会购买相应商品。我们使用了机器学习的二分类模型,通过分析用户的性别、年龄、常驻地、机型等信息,来判断用户的付费行为。项目目标:本

- 从 C# 转 Python 第三天:文件操作、异常处理与错误日志实践

AI、少年郎

java前端数据库c#文件操作异常处理

在软件开发的广阔领域中,Python和C#作为两种备受瞩目的编程语言,各自凭借独特的特性和强大的功能,在不同的应用场景中展现出卓越的性能。对于开发者而言,深入理解并熟练掌握这两门语言的核心技能,如文件操作与异常处理,不仅是提升个人编程能力的关键,更是在复杂多变的项目开发中应对各种挑战、确保程序稳定运行的必备条件。在日常的编程工作中,文件操作是实现数据持久化存储、读取配置信息以及处理各种数据文件的基

- python爬虫入门(小白五分钟从入门到精通)

一百天成为python专家

python爬虫开发语言网络爬虫python3.11ipython

网络爬虫的介绍本节主要介绍Pytbon语言中支持网络爬虫的库,此外还将介绍如何获取网站的爬取规则,读者在学习和践过程中一定要严格遵守网站提供的爬取规则。网络爬虫网络爬虫通俗来讲就是使用代码将HTML网页的内容下载到本地的过程。爬取网页主要是为了获取网中的关键信息,例如网页中的数据、图片、视频等。Python语言中提供了多个具有爬虫功能的库,下面将具urHIib库:是Python自带的标准库,无须下

- Python 虚拟环境管理工具 UV:从安装到高级用法的详细教程

Dush32

pythonuv开发语言人工智能机器学习分类

前言在Python开发中,管理不同项目的依赖包和Python版本是开发者常常遇到的问题。不同项目可能依赖不同版本的库,甚至同一个库在不同版本下的行为可能不同。为了避免这些问题,使用虚拟环境成为了解决方案。虚拟环境通过隔离每个项目的依赖,避免了版本冲突问题。在Python中,常用的虚拟环境管理工具有virtualenv、venv和一些第三方工具,如UV。本文将详细介绍如何使用UV虚拟环境管理工具,从

- python并发执行_Python的并发并行[0] -> 基本概念

weixin_39940253

python并发执行

基本概念/BasicConcept快速跳转0简介与动机/WhyMulti-Thread/Multi-Process/Coroutine在多线程(multithreaded,MT)编程出现之前,计算机程序的执行是由单个步骤序列组成的,该序列在主机的CPU中按照同步顺序执行。即无论任务多少,是否包含子任务,都要按照顺序方式进行。然而,假定子任务之间相互独立,没有因果关系,若能使这些独立的任务同时运行,

- python线程嵌套线程_Python中的嵌套并行性

weixin_39923262

python线程嵌套线程

1)WhatamImissinghere;whyshouldn’taPoolbesharedbetweenprocesses?并不是所有的对象/实例都是可挑选的/可序列化的,在这种情况下,池使用的是不可挑剔的thread.lock:>>>importthreading,pickle>>>pickle.dumps(threading.Lock())Traceback(mostrecentcallla

- 移除 GIL,可显著提升 Python 多线程性能么?

AIGC开发者

python1024程序员节python开发语言

近日,一位名叫SamGross的开发者提出了一个对全局解释器锁(GIL)进行重大修改的设想。其目标在于移除CPython中的GIL,以使得多线程能够并行执行Python代码。目前,该项目已经引起了Python核心开发团队的关注。我一直在对CPython进行修改,使其能够在没有全局解释器锁的情况下运行。我想与大家分享一个可以在没有GIL的情况下运行的概念验证。这个概念验证涉及到对CPython内部的

- InfluxDB 数据模型:桶、测量、标签与字段详解(一)

计算机毕设定制辅导-无忧

#InfluxDBdb

一、引言**在大数据和物联网蓬勃发展的当下,时间序列数据的处理需求呈爆发式增长。InfluxDB作为一款高性能的开源时序数据库,凭借其卓越的特性,在时序数据库领域占据了重要地位,被广泛应用于各种场景。InfluxDB专为时间序列数据设计,拥有高效的存储和查询性能。它采用独特的存储引擎,能够快速写入大量带有时间戳的数据,并支持灵活的查询操作。其核心设计针对时间序列数据的特点进行了优化,包括时间索引、

- 矩阵求逆(JAVA)初等行变换

qiuwanchi

矩阵求逆(JAVA)

package gaodai.matrix;

import gaodai.determinant.DeterminantCalculation;

import java.util.ArrayList;

import java.util.List;

import java.util.Scanner;

/**

* 矩阵求逆(初等行变换)

* @author 邱万迟

*

- JDK timer

antlove

javajdkschedulecodetimer

1.java.util.Timer.schedule(TimerTask task, long delay):多长时间(毫秒)后执行任务

2.java.util.Timer.schedule(TimerTask task, Date time):设定某个时间执行任务

3.java.util.Timer.schedule(TimerTask task, long delay,longperiod

- JVM调优总结 -Xms -Xmx -Xmn -Xss

coder_xpf

jvm应用服务器

堆大小设置JVM 中最大堆大小有三方面限制:相关操作系统的数据模型(32-bt还是64-bit)限制;系统的可用虚拟内存限制;系统的可用物理内存限制。32位系统下,一般限制在1.5G~2G;64为操作系统对内存无限制。我在Windows Server 2003 系统,3.5G物理内存,JDK5.0下测试,最大可设置为1478m。

典型设置:

java -Xmx

- JDBC连接数据库

Array_06

jdbc

package Util;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.ResultSet;

import java.sql.SQLException;

import java.sql.Statement;

public class JDBCUtil {

//完

- Unsupported major.minor version 51.0(jdk版本错误)

oloz

java

java.lang.UnsupportedClassVersionError: cn/support/cache/CacheType : Unsupported major.minor version 51.0 (unable to load class cn.support.cache.CacheType)

at org.apache.catalina.loader.WebappClassL

- 用多个线程处理1个List集合

362217990

多线程threadlist集合

昨天发了一个提问,启动5个线程将一个List中的内容,然后将5个线程的内容拼接起来,由于时间比较急迫,自己就写了一个Demo,希望对菜鸟有参考意义。。

import java.util.ArrayList;

import java.util.List;

import java.util.concurrent.CountDownLatch;

public c

- JSP简单访问数据库

香水浓

sqlmysqljsp

学习使用javaBean,代码很烂,仅为留个脚印

public class DBHelper {

private String driverName;

private String url;

private String user;

private String password;

private Connection connection;

privat

- Flex4中使用组件添加柱状图、饼状图等图表

AdyZhang

Flex

1.添加一个最简单的柱状图

? 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28

<?xml version=

"1.0"&n

- Android 5.0 - ProgressBar 进度条无法展示到按钮的前面

aijuans

android

在低于SDK < 21 的版本中,ProgressBar 可以展示到按钮前面,并且为之在按钮的中间,但是切换到android 5.0后进度条ProgressBar 展示顺序变化了,按钮再前面,ProgressBar 在后面了我的xml配置文件如下:

[html]

view plain

copy

<RelativeLa

- 查询汇总的sql

baalwolf

sql

select list.listname, list.createtime,listcount from dream_list as list , (select listid,count(listid) as listcount from dream_list_user group by listid order by count(

- Linux du命令和df命令区别

BigBird2012

linux

1,两者区别

du,disk usage,是通过搜索文件来计算每个文件的大小然后累加,du能看到的文件只是一些当前存在的,没有被删除的。他计算的大小就是当前他认为存在的所有文件大小的累加和。

- AngularJS中的$apply,用还是不用?

bijian1013

JavaScriptAngularJS$apply

在AngularJS开发中,何时应该调用$scope.$apply(),何时不应该调用。下面我们透彻地解释这个问题。

但是首先,让我们把$apply转换成一种简化的形式。

scope.$apply就像一个懒惰的工人。它需要按照命

- [Zookeeper学习笔记十]Zookeeper源代码分析之ClientCnxn数据序列化和反序列化

bit1129

zookeeper

ClientCnxn是Zookeeper客户端和Zookeeper服务器端进行通信和事件通知处理的主要类,它内部包含两个类,1. SendThread 2. EventThread, SendThread负责客户端和服务器端的数据通信,也包括事件信息的传输,EventThread主要在客户端回调注册的Watchers进行通知处理

ClientCnxn构造方法

&

- 【Java命令一】jmap

bit1129

Java命令

jmap命令的用法:

[hadoop@hadoop sbin]$ jmap

Usage:

jmap [option] <pid>

(to connect to running process)

jmap [option] <executable <core>

(to connect to a

- Apache 服务器安全防护及实战

ronin47

此文转自IBM.

Apache 服务简介

Web 服务器也称为 WWW 服务器或 HTTP 服务器 (HTTP Server),它是 Internet 上最常见也是使用最频繁的服务器之一,Web 服务器能够为用户提供网页浏览、论坛访问等等服务。

由于用户在通过 Web 浏览器访问信息资源的过程中,无须再关心一些技术性的细节,而且界面非常友好,因而 Web 在 Internet 上一推出就得到

- unity 3d实例化位置出现布置?

brotherlamp

unity教程unityunity资料unity视频unity自学

问:unity 3d实例化位置出现布置?

答:实例化的同时就可以指定被实例化的物体的位置,即 position

Instantiate (original : Object, position : Vector3, rotation : Quaternion) : Object

这样你不需要再用Transform.Position了,

如果你省略了第二个参数(

- 《重构,改善现有代码的设计》第八章 Duplicate Observed Data

bylijinnan

java重构

import java.awt.Color;

import java.awt.Container;

import java.awt.FlowLayout;

import java.awt.Label;

import java.awt.TextField;

import java.awt.event.FocusAdapter;

import java.awt.event.FocusE

- struts2更改struts.xml配置目录

chiangfai

struts.xml

struts2默认是读取classes目录下的配置文件,要更改配置文件目录,比如放在WEB-INF下,路径应该写成../struts.xml(非/WEB-INF/struts.xml)

web.xml文件修改如下:

<filter>

<filter-name>struts2</filter-name>

<filter-class&g

- redis做缓存时的一点优化

chenchao051

redishadooppipeline

最近集群上有个job,其中需要短时间内频繁访问缓存,大概7亿多次。我这边的缓存是使用redis来做的,问题就来了。

首先,redis中存的是普通kv,没有考虑使用hash等解结构,那么以为着这个job需要访问7亿多次redis,导致效率低,且出现很多redi

- mysql导出数据不输出标题行

daizj

mysql数据导出去掉第一行去掉标题

当想使用数据库中的某些数据,想将其导入到文件中,而想去掉第一行的标题是可以加上-N参数

如通过下面命令导出数据:

mysql -uuserName -ppasswd -hhost -Pport -Ddatabase -e " select * from tableName" > exportResult.txt

结果为:

studentid

- phpexcel导出excel表简单入门示例

dcj3sjt126com

PHPExcelphpexcel

先下载PHPEXCEL类文件,放在class目录下面,然后新建一个index.php文件,内容如下

<?php

error_reporting(E_ALL);

ini_set('display_errors', TRUE);

ini_set('display_startup_errors', TRUE);

if (PHP_SAPI == 'cli')

die('

- 爱情格言

dcj3sjt126com

格言

1) I love you not because of who you are, but because of who I am when I am with you. 我爱你,不是因为你是一个怎样的人,而是因为我喜欢与你在一起时的感觉。 2) No man or woman is worth your tears, and the one who is, won‘t

- 转 Activity 详解——Activity文档翻译

e200702084

androidUIsqlite配置管理网络应用

activity 展现在用户面前的经常是全屏窗口,你也可以将 activity 作为浮动窗口来使用(使用设置了 windowIsFloating 的主题),或者嵌入到其他的 activity (使用 ActivityGroup )中。 当用户离开 activity 时你可以在 onPause() 进行相应的操作 。更重要的是,用户做的任何改变都应该在该点上提交 ( 经常提交到 ContentPro

- win7安装MongoDB服务

geeksun

mongodb

1. 下载MongoDB的windows版本:mongodb-win32-x86_64-2008plus-ssl-3.0.4.zip,Linux版本也在这里下载,下载地址: http://www.mongodb.org/downloads

2. 解压MongoDB在D:\server\mongodb, 在D:\server\mongodb下创建d

- Javascript魔法方法:__defineGetter__,__defineSetter__

hongtoushizi

js

转载自: http://www.blackglory.me/javascript-magic-method-definegetter-definesetter/

在javascript的类中,可以用defineGetter和defineSetter_控制成员变量的Get和Set行为

例如,在一个图书类中,我们自动为Book加上书名符号:

function Book(name){

- 错误的日期格式可能导致走nginx proxy cache时不能进行304响应

jinnianshilongnian

cache

昨天在整合某些系统的nginx配置时,出现了当使用nginx cache时无法返回304响应的情况,出问题的响应头: Content-Type:text/html; charset=gb2312 Date:Mon, 05 Jan 2015 01:58:05 GMT Expires:Mon , 05 Jan 15 02:03:00 GMT Last-Modified:Mon, 05

- 数据源架构模式之行数据入口

home198979

PHP架构行数据入口

注:看不懂的请勿踩,此文章非针对java,java爱好者可直接略过。

一、概念

行数据入口(Row Data Gateway):充当数据源中单条记录入口的对象,每行一个实例。

二、简单实现行数据入口

为了方便理解,还是先简单实现:

<?php

/**

* 行数据入口类

*/

class OrderGateway {

/*定义元数

- Linux各个目录的作用及内容

pda158

linux脚本

1)根目录“/” 根目录位于目录结构的最顶层,用斜线(/)表示,类似于

Windows

操作系统的“C:\“,包含Fedora操作系统中所有的目录和文件。 2)/bin /bin 目录又称为二进制目录,包含了那些供系统管理员和普通用户使用的重要

linux命令的二进制映像。该目录存放的内容包括各种可执行文件,还有某些可执行文件的符号连接。常用的命令有:cp、d

- ubuntu12.04上编译openjdk7

ol_beta

HotSpotjvmjdkOpenJDK

获取源码

从openjdk代码仓库获取(比较慢)

安装mercurial Mercurial是一个版本管理工具。 sudo apt-get install mercurial

将以下内容添加到$HOME/.hgrc文件中,如果没有则自己创建一个: [extensions] forest=/home/lichengwu/hgforest-crew/forest.py fe

- 将数据库字段转换成设计文档所需的字段

vipbooks

设计模式工作正则表达式

哈哈,出差这么久终于回来了,回家的感觉真好!

PowerDesigner的物理数据库一出来,设计文档中要改的字段就多得不计其数,如果要把PowerDesigner中的字段一个个Copy到设计文档中,那将会是一件非常痛苦的事情。