【AI周报】DeepMind用700亿打败大数据库;OpenAI的DALL·E可二次创作;CVPR 2022论文分享

01 行业大事件

语言模型参数越多越好?DeepMind用700亿打败自家2800亿,训练优化出「小」模型

给定固定的 FLOPs 预算,应该如何权衡模型大小和训练 token 的数量?DeepMind 得出了与先前不同的结论。

最近一系列大型语言模型 (LLM) 正在崛起,其中最大的语言模型已经拥有超过 5000 亿个参数。这些大型自回归 transformer 通过使用各种评估协议(例如零样本、少样本和微调),在许多任务中表现出令人印象深刻的性能。

然而训练大型语言模型需要消耗巨大的计算和能源,并且这种消耗随着模型的增加而增加。在实践中,研究者事先分配的训练计算预算通常是预先知道的:有多少加速器可用以及我们想要使用它们多长时间。通常这些大模型只训练一次是可接受的,因此准确估计给定计算预算的最佳模型超参数至关重要。

Kaplan 等人研究 (2020) 表明,自回归语言模型 (LM) 中的参数数量与其性能之间存在幂律关系。结果是该领域一直在训练越来越大的模型,期望性能得到改善。Kaplan 等人(2020) 得出的一个值得注意的结论是,不应该将大型模型训练到其可能的最低损失,以获得计算的最佳化。

来自 DeepMind 的研究者得出了相同的结论,但他们估计大型模型可以训练的 token 数应该比作者推荐的更多。具体来说,假设计算预算增加 10 倍,其他研究者建议模型的大小应该增加 5.5 倍,而训练 token 的数量应该只增加 1.8 倍。相反,DeepMind 发现模型大小和训练 token 的数量应该以相等的比例扩展。

论文地址:https://arxiv.org/pdf/2203.15556.pdf

让模型训练速度提升2到4倍,「彩票假设」作者的这个全新PyTorch库火了

登陆 GitHub 以来,这个项目已经收获了 800 多个 Star。

随着越来越多的企业转向人工智能来完成各种各样的任务,企业很快发现,训练人工智能模型是昂贵的、困难的和耗时的。

一家公司 MosaicML 的目标正是找到一种新的方法来应对这些层出不穷的挑战。近日, MosaicML 推出了一个用于高效神经网络训练的 PyTorch 库「Composer」,旨在更快地训练模型、降低成本,并获得表现更好的模型。

Composer 是一个用 PyTorch 编写的开源库,旨在集成更好的算法来加速深度学习模型的训练,同时实现更低的成本和更高的准确度。目前项目在 GitHub 平台已经收获了超过 800 个 Star。

项目地址:https://github.com/mosaicml/composer

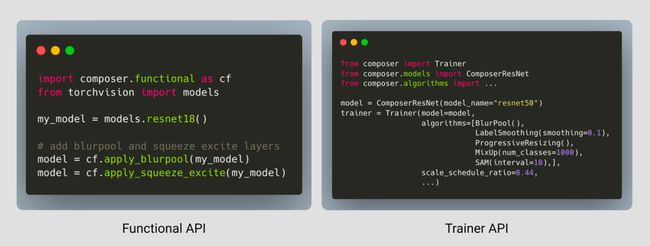

Composer 具有一个功能界面(类似于 torch.nn.functional),用户可以将其集成到自己的训练循环中;它还包含一个 Trainer,可以将高效的训练算法无缝集成到训练循环中。

项目中已经部署了 20 几种加速方法,只需几行代码就能应用在用户的训练之中,或者与内置 Trainer 一起使用。

总体而言,Composer 具备几个亮点:

-

20 多种加速计算机视觉和语言建模训练网络的方法。当 Composer 为你完成工作时,你就不需要浪费时间尝试复现研究论文。

-

一个易于使用的 Trainer,其编写的目的是尽可能提高性能,并集成了高效训练的最佳实践。

-

所有加速方法的功能形式,都允许用户将它们集成到现有的训练循环中。

-

强大、可重现的基线,让你尽可能地快开始工作。

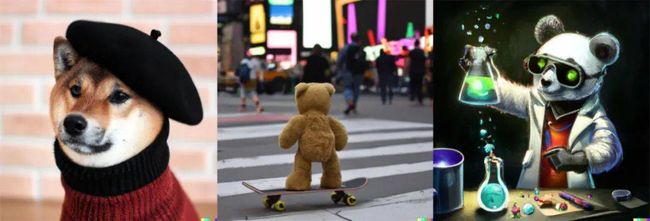

OpenAI的DALL·E迎来升级,不止文本生成图像,还可二次创作

在令人叹为观止方面,OpenAI 从不令人失望。

去年 1 月 6 日,OpenAI 发布了新模型 DALL·E,不用跨界也能从文本生成图像,打破了自然语言与视觉次元壁,引起了 AI 圈的一阵欢呼。

时隔一年多后,DALL·E 迎来了升级版本——DALL·E 2。

与 DALL·E 相比,DALL·E 2 在生成用户描述的图像时具有更高的分辨率和更低的延迟。并且,新版本还增添了一些新的功能,比如对原始图像进行编辑。

不过,OpenAI 没有直接向公众开放 DALL·E 2。目前,研究者可以在线注册预览该系统。OpenAI 希望以后可以将它用于第三方应用程序。

试玩 Waitlist 地址:https://labs.openai.com/waitlist

OpenAI 还公布了 DALL·E 2 的研究论文《Hierarchical Text-Conditional Image Generation with CLIP Latents》,OpenAI 研究科学家、共同一作 Prafulla Dhariwal 表示,「这个神经网络真是太神奇了,根据文本描述就能生成对应图像。」

论文地址:https://cdn.openai.com/papers/dall-e-2.pdf

02 程序员专区

近期优质论文分享

CVPR 2022 | 这个自蒸馏新框架新SOTA,降低了训练成本,无需修改网络

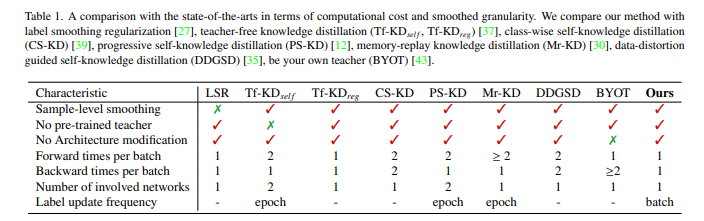

OPPO 研究院联合上海交通大学提出的新的自蒸馏框架DLB,无需额外的网络架构修改,对标签噪声具有鲁棒性,并可大幅节约训练的空间复杂度,在三个基准数据集的实验中达到了 SOTA 性能。

深度学习促进人工智能(AI)领域不断发展,实现了许多技术突破。与此同时,如何在有限硬件资源下挖掘模型潜能、提升部署模型的准确率成为了学界和业界的研究热点。其中,知识蒸馏作为一种模型压缩和增强的方法, 将泛化能力更强的「大网络模型」蕴含的知识「蒸馏」到「小网络模型」上,来提高小模型精度,广泛地应用于 AI 领域的全监督、半监督、自监督、域迁移等各个方向。

近日, OPPO 研究院联合上海交通大学将视角聚焦到知识蒸馏的范式本身,提出了新的自蒸馏框架:DLB(Self-Distillation from Last Mini-Batch),模型无需额外的网络架构修改,对标签噪声具有鲁棒性,并大幅节约训练的空间复杂度。此外,在三个基准数据的实验中,模型达到了 SOTA 性能。相关论文「Self-Distillation from the Last Mini-Batch for Consistency Regularization」已被 CVPR 2022 收录。

论文链接:https://arxiv.org/pdf/2203.16172.pdf

DLB 自蒸馏框架

如何减少蒸馏计算复杂度?

知识蒸馏通常可以划分为三类,即离线蒸馏、在线蒸馏和自蒸馏。其中,自蒸馏具有训练轻量、知识迁移效率高的特点,最近受到更多研究者的重视。

图 1:本文方法与其他自蒸馏方法的比较

但是传统的自蒸馏,例如 Be Your Own Teacher,在模型训练过程中需要对模型结构进行修改。除此以外,训练成本高、计算冗余且效率低下也是自蒸馏需要攻克的难题。

为了解决上述难题,让模型更好地部署到手机等终端设备中,OPPO 研究院和上海交通大学的研究员们提出了 DLB 自蒸馏框架。利用训练时前后 Batch 预测结果的一致性,在无需对模型进行网络结构修改的前提下,就能降低训练复杂度,增强模型泛化能力。

1. 本文的任务

提出更加轻量的自蒸馏方式,降低训练的计算复杂度,提高模型准确率和泛化性。

2. 本文创新与贡献

提出 DLB,通过保存与下个 Batch 部分样本重叠的软目标(soft targets)进行自蒸馏。节省计算内存,并且简化训练流程。

让训练样本的每次前向过程都与一次反向传播过程相关联,从而提升学习效率。

实验分析了 DLB 训练方法的动态影响,发现其正则化效果来源于即时生效的平滑标签带来的训练一致性,为自蒸馏的理论研究提供了实验基础。

极链AI云是极链科技集团下属专为AI科研与学习而设计的一站式开发平台。为开发者提供全流程的AI科研服务,让每一位用户都能拥有撬动AI变革的力量。