SwinIR_Image Restoration Using Swin Transformer论文阅读分享

论文连接:https://arxiv.org/abs/2108.10257

Abstract

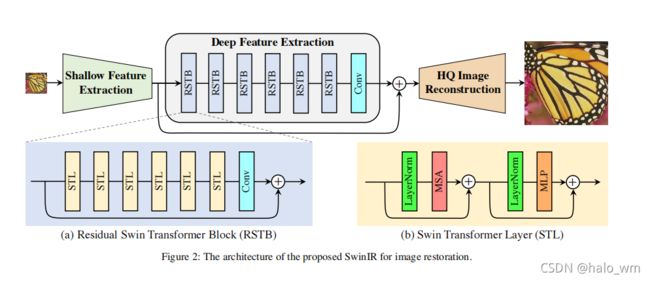

本篇文章的图像修复指的是从低质量图片恢复到高质量图片(例如超分,去噪,解压缩图片),目前主流先进的图像修复任务都是基于卷积做的,很少有人尝试用transformer做高性能的高级视觉任务。而本篇文章主要就是基于Swin_transformer做的,本方法命名为SwinIR。该方法包含三个部分:浅层特征提取器、深层特征提取器、高质量图像重建模块,针对不同的图像修任务,图像重建模块略有不同。特别的是,深层特征提取器是基于Swin_transformer做的。

Introduction

目前卷积网络是图像修复的主流,大部分的卷积网络关注精心的网络架构设计和密集连接。尽管这些方法与传统的图像修复算法相比,提升了很多,但是通常都有两个源自卷积本身的问题:1.首先,图像与卷积核之间的交互是内容上独立的,使用相同的卷积核去图像不同区域的可能不是最好的选择。2.卷积的局部处理原则对于建立长距离依赖的建模不是非常有效的。

而相较于卷积,transformer设计的self-attention机制能够捕获内容上的全局交互,在视觉任务上展现出非常大的潜力。但是tansformer直接用在视觉任务上也会造成一些问题,需要进行改进…

而最近Swin_transformer展示出了很大的潜力,因为它整合了卷积和tansformer的优势。本文正是基于Swin_transformer提出了本文的图像修复算法。

Method

本文的架构包含三个部分:浅层特征提取、深层特征提取、图像重建模块。

3.1浅层特征提取

浅层特征提取模块采用卷积实现,给定一个低质量的图片LQ,LQ ∈ R H , W , C i n \in R^{H,W,C_{in}} ∈RH,W,Cin,然后采用卷积模块 H S F ( . ) H_{SF}(.) HSF(.)去提取浅层特征 F 0 ∈ R H , W , C F_0\in R^{H,W,C} F0∈RH,W,C

F 0 = H S F ( I L Q ) F_0=H_{SF}(I_{LQ}) F0=HSF(ILQ)

卷积层很擅长用于早期的图像处理,提供了更好的方法将图像的空间映射到更高维的特征空间。

3.2深层特征提取

利用得到的浅层特征F0,对F0进行深层特征建模。深层特征提取模块包含k个residual Swin Transformer blocks(RSTB)和一个3x3的卷积层。

F i = H R S T B i , i = 1 , 2 , 3 , . . . K , F D F = H C O N V ( F K ) F_i=H_{RSTB_i},i=1,2,3,...K, F_{DF}=H_{CONV}(F_K) Fi=HRSTBi,i=1,2,3,...K,FDF=HCONV(FK)

对于每个RST blocks模块都是一个SwinTransformer layers 和一个卷积层。首先用这些block提取中间层特征 F i , 1 , F i , 2 , F i , 3 , . . , F i , L F_{i,1},F_{i,2},F_{i,3},..,F_{i,L} Fi,1,Fi,2,Fi,3,..,Fi,L

F i , j = H S T L i , j , j = 1 , 2 , 3 , . . . , L F_{i,j}=HSTL_{i,j},j=1,2,3,...,L Fi,j=HSTLi,j,j=1,2,3,...,L

这里的 H S T L i , j ( . ) H_{STL_{i,j}}(.) HSTLi,j(.)是第i个RSTB中的第j层的Swin Transformer layer。

3.3图像重建模块

针对不同的修复任务,在整个网络架构的结尾部分的重建模块需要进行调整。

超分任务

为了获得高质量的的图片 I R H Q I_{RHQ} IRHQ是通过聚合浅层特征和深层特征

I R H Q = H R E C ( F 0 + F D F ) I_{RHQ}=H_{REC}(F_0+F_{DF}) IRHQ=HREC(F0+FDF)

这里的 H R E C ( . ) H_{REC}(.) HREC(.)是重建模块,浅层特征主要包含低频信息,而深层特征专注于恢复丢失的高频信息,通过长距离的跳跃连接,SwinIR可以将低频信息直接传给重建模块,这样就能是的深层提取器更加专注于高频信息和稳定训练。对于超分任务,本文使用sub-pixel convolution layer 去上采样特征图。损失函数采用L1 pixel loss.

l o s s = ∣ ∣ I R H Q − I H Q ∣ ∣ 1 loss=|| I_{RHQ}-I_{HQ}||_1 loss=∣∣IRHQ−IHQ∣∣1

本文只用最原始的l1损失来证明所提出网络的有效性,对于实际应用时可以联合使用 pexel l1损失、GAN loss and 感知损失来提升视觉质量。

总结:

这篇论文尝试将Swin_transformer用在了图像修复领域,方法上没有很大的创新,主要是将Swin_transformer在底层视觉任务上进行应用了。并取得了非常好的实验效果。

参考文献

SwinIR: Image Restoration Using Swin Transformer

Jingyun Liang, Jiezhang Cao, Guolei Sun, Kai Zhang, Luc Van Gool, Radu Timofte

Timofte](https://arxiv.org/search/eess?searchtype=author&query=Timofte%2C+R)