图神经网络权威基准OGB的2020年“刷榜往事”

2020-12-13 04:30:35

作者 | 青暮

编辑 | 陈彩娴

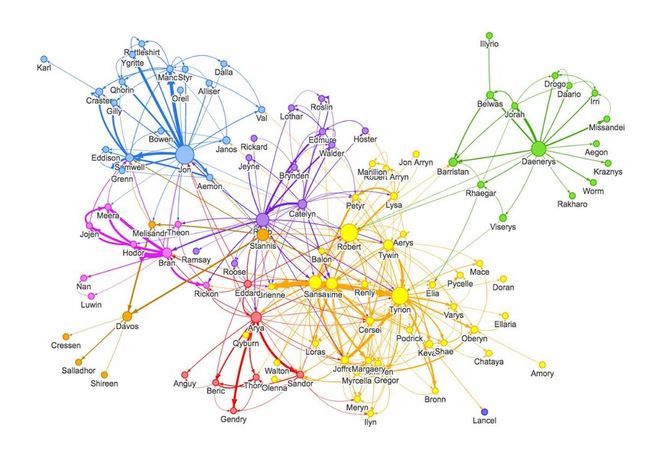

相对于传统神经网络,图神经网络有着非常明显的优势:非顺序排序的特征学习、两个节点之间依赖关系的学习、非结构化数据上的推理能力。

因此,图神经网络在多个领域的复杂关系建模和互动系统中起到关键作用,这些领域包括生物学、地图、金融、搜索、推荐、高能物理学、社会科学和经济学等。

就像计算机视觉领域有ImageNet,图神经网络领域也有自己的“ImageNet”,也就是由斯坦福大学图神经网络权威Jure Leskovec教授团队建立的大规模图学习任务的评测基准数据集OGB(Open Graph Benchmark),Yoshua Bengio、Will Hamilton、Max Welling等大牛还是构建该数据集的指导委员会成员。

OGB在NeurlPS 2019大会的演讲中正式开源,它是目前公认最权威的图学习相关基准测试数据集。针对不同的图学习任务,比如节点性质、边性质、图性质的预测等,OGB都分别提供了相应的数据集,比如亚马逊产品购买网络、学者合作网络、学术引用网络、分子图等等。斯坦福、纽约大学、康奈尔大学、华盛顿大学、Facebook等在内的多个机构都非常积极地在排行榜上竞争。

AI科技评论这次就带领大家回顾一下OGB榜单在2020年的“刷榜往事”,探寻在这个榜单上争夺荣耀的“江湖规矩”。

OGB一共包含三大类任务:节点性质预测、边性质预测、图性质预测,每种任务中又分别使用了不同的数据集,其中节点性质预测有5个数据集,边性质预测有6个数据集,图性质预测有4个数据集。加起来后,一共是15个数据集,也就对应着15个任务,和15个排行榜,排行榜信息涉及方法、测试得分、验证得分、论文、代码、参数量、硬件、提交时间等。

AI科技评论分别从三种任务中选取了一个数据集,来介绍一段“刷榜往事”。这三个数据集分别是:

节点性质预测:ogbn-products(亚马逊产品的“共同购买网络”)

边性质预测:ogbl-collab(学者协作网络)

图性质预测:ogbg-molhiv(分子图网络)

1 节点性质预测

1)数据集介绍

ogbn-products是无向、未加权图的数据集,这些图表示了亚马逊产品的“共同购买网络”。节点代表在亚马逊出售的产品,两个产品之间的边表示产品是一起购买的。

OGB按照Cluster-GCN论文来处理节点特征和目标类别。具体来说,节点特征是通过从产品描述中提取词袋特征,然后进行主成分分析以将维度减小到100来生成的。

2)预测任务

该任务是在多类别分类设置中预测产品的类别,其中47个top Level类别用于目标标签。

3)数据集拆分

与Cluster-GCN中使用的方法不同,OGB采用了更具挑战性和现实性的数据集拆分,而不是随机分配90%的节点进行训练和10%的节点进行测试(没有设置验证集), OGB使用销售排名(受欢迎程度)将节点分为训练/验证/测试集。

具体来说,OGB根据产品的销售排名对产品进行排序,并使用前8%进行训练,然后使用前2%进行验证,其余用于测试。这种拆分方法使得该数据集更具挑战性,与实际应用紧密匹配,即首先将标签分配给网络中的重要节点,然后使用ML模型对重要性较低的节点进行预测。

4)刷榜往事

今年5月,一名叫Matthias Fey的学生提交了一个实现,该实现基于图注意力网络(GAT)和近邻采样方法,在此任务上实现了0.7945的测试得分,夺得排行榜第一,模型参数量约为75万,使用的硬件配置是RTX 2080(11GB显存)。

Matthias Fey是来自德国多特蒙德大学的四年级机器学习博士生,研究兴趣是将深度学习方法推广到任意的欧式和非欧结构化数据。他本科和硕士都是计算机科学专业,曾在一家软件公司工作五年。他还是PyTorch、node.js、CSS、React、macOS、Arch Linux和Vim的开发爱好者,其开发的pytorch_geometric项目已获得了9.6k star。这位小哥不简单,他不仅仅在这个榜单上出现。

图注意力网络是由Yoshua Bengio的团队于2018年发表在ICLR上的论文“Graph Attention Networks”提出的,其利用masked self-attentional layer来解决基于图卷积或类似现有方法的缺点,该模型曾在四个图数据基准上取得SOTA结果。

Matthias Fey没有高兴太久,6月份,来自KAUST视觉计算中心的Guohao Li凭借原创的DeeperGCN模型,以三分之一的参数量(约25万)在此任务上获得了0.8098的测试得分,超越Matthias Fey拿到排行榜第一,他使用的硬件是Tesla V100(32GB显存)。

Guohao Li的本科和硕士分别毕业于哈工大和中国科学院,曾做过商汤的计算机视觉研究实习生,目前攻读沙特阿拉伯KAUST计算机科学博士学位,研究兴趣是计算机视觉、机器人技术和深度学习。

DeeperGCN是一种非常深的GCN,作者表示他们提出的方法可以有效地将其训练,该模型在节点属性预测和图属性预测的大规模图学习任务上大大提高了性能。DeeperGCN在ogbn-products上霸榜了三个月。

一直到9月份,一个名叫UniMP的超大模型(参数量是DeeperGCN的6倍)才以0.8256的测试得分将DeeperGCN打败,其使用的硬件也是Tesla V100(32GB显存)。

UniMP的相关论文“MASKED LABEL PREDICTION: UNIFIED MESSAGE PASSING MODEL FOR SEMI-SUPERVISED CLASSIFICATION”的一作是Shi Yunsheng,来自百度PaddlePaddle PGL团队,而PGL(Paddle Graph Learning)是一个基于PaddlePaddle的图学习框架。

UniMP将图神经网络(GNN)和标签传播算法(LPA)结合在一起,从而将特征传播和标签传播与共享的消息传递网络相结合,在半监督分类中可以实现更好的性能。

然而,UniMP在冠军宝座上只待了一个月,就被一个小家伙强势踢馆,小家伙名为“MLP+C&S”,它只有约十万参数量,使用的硬件是RTX 2080(11GB显存)。

MLP+C&S的相关论文“COMBINING LABEL PROPAGATION AND SIMPLE MODELS OUT-PERFORMS GRAPH NEURAL NETWORKS”的一作是来自康奈尔大学的Huang Qian,她表示自己的研究兴趣为“桥接系统1和系统2推理”,即将读博,Bengio听到后说道:“就是你了。”

MLP+C&S通过将忽略图结构的浅层模型与两个简单的后处理步骤结合起来,从而大大提升了在标准转导节点分类基准上的性能,这些步骤利用了标签结构中的两种关联:“误差关联”和“预测关联”,并且是通过从早期基于图的半监督学习方法对标准标签传播技术进行简单修改而实现的。令人惊讶的是,MLP+C&S不仅参数量非常少,训练时间也比过去的方法少了两个数量级。所以,奇迹不一定要借助大力。

截至12月,ogbn-products排行榜上的前三名如下(粗体标记表示该实现是官方的,也就是由论文的作者提供的实现):

2 边性质预测

1)数据集介绍

ogbl-collab是无向图的数据集,表示由MAG索引的作者之间的协作网络的子集。每个节点代表一个作者,边表示作者之间的协作关系。

所有节点都具有128维特征,这些特征是通过对作者发表的论文的词嵌入求平均获得的。所有边都与两个元信息相关:年份和边权重,代表该年发表的合著论文的数量。

该图可以视为动态多图,因为如果两个节点协作超过一年,则它们之间可能有多个边。

2)预测任务

基于过去的协作情况,预测未来的作者协作关系。目标是使得真实协作的排名高于虚假协作的排名。

具体来说,在100,000个随机采样的负协作中对每个真实协作进行排名,并计算排名在K位或更高(Hits @ K)的正边的比率。在初步实验中,OGB发现K = 50是一个很好的阈值。

3)数据集拆分

OGB根据时间拆分数据,以便在协作推荐中模拟实际应用。具体来说,OGB将直到2017年的协作作为训练数据,将2018年的协作作为验证数据,并将2019年的协作作为测试数据。

4)刷榜往事

今年6月,一个名为DGL的项目提交了一项实现,其使用KDD2014中发表的DeepWalk算法在该任务上达到了0.5037的测试得分,排名第一。模型参数量非常大,达到了6千万,使用的硬件是AWS云服务提供的EC2实例,配备NVIDIA T4 Tensor Core GPU以及15GB显存。DGL项目在GitHub上很受欢迎,star数达到了6.3k。

word2vec是NLP中常用的word embedding方法,通过语料库中的句子序列来描述词与词的共现关系,从而学习到词语的向量表示。DeepWalk算法与word2vec类似,使用图中节点与节点的共现关系来学习节点的向量表示。

在两个月后,名为LRGA + GCN的模型以0.6088的测试得分击败了DeepWalk,参数量只有100万出头,使用的硬件是Tesla P100(16GB显存)。

该方法由来自以色列魏茨曼科学研究所的Omri Puny提出,相关论文为“GLOBAL ATTENTION IMPROVES GRAPH NETWORKS GENERALIZATION”。低秩全局注意力(LRGA)模块是点积注意力的一种计算和存储高效变体,这篇论文主张将LRGA结合到图神经网络(GNN)中,以提高其泛化能力。研究者观察到,用LRGA增强各种GNN架构,通常可以缩小不同模型之间的性能差距。

紧接着,我们来到了10月,这个月出现了两个强者。首先,在10月19日,名为GraphSAGE的模型实现了0.5463的测试得分,超越了LRGA+GCN,参数量也进一步压缩到了LRGA+GCN的一半,大概46万左右,使用的硬件是RTX 2080(11GB显存)。值得一提的是,该实现的作者也是Matthias Fey,并且该实现在GitHub上显示属于斯坦福OGB团队。

GraphSAGE参考的论文是“Inductive Representation Learning on Large Graphs”,这是一篇发表在NeurIPS 2017上的论文。该论文介绍了一个通用的归纳框架,它可以利用节点特征信息(例如文本属性)为未见过的数据有效生成节点嵌入。GraphSAGE没有学习为每个节点训练单独的嵌入,而是学习了通过对节点的局部近邻进行采样和聚合来生成嵌入的函数。

GraphSAGE仅仅享受了三天的冠军荣耀,就杀出了一个程咬金,SEAL带着0.6364测试得分的成绩显著超越了GraphSAGE,其参数量也进一步压缩,仅有7万多,使用的硬件为RTX 2080S(8GB显存)。SEAL论文的一作为华盛顿大学计算机科学与工程系博士生张牧涵,他现为Facebook AI Applied Research的研究科学家,主要研究Facebook上的一般图形建模问题。

在SEAL中,研究者提出了连接预测的启发式学习范式,以克服强假设(关于两个节点何时可能连接)的缺陷。他们将广泛的启发式方法统一在一个框架中,并证明可以从局部子图很好地近似所有这些启发式方法。结果表明,局部子图保留了与连接存在有关的丰富信息。实验结果显示出空前的性能,可以在各种问题上始终如一地工作。

截至12月,ogbl-collab排行榜上的前三名如下:

3 图性质预测

1)数据集介绍

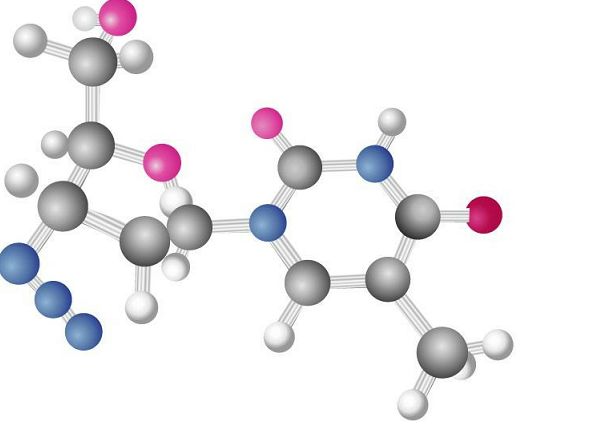

ogbg-molhiv一个分子特性预测数据集,来自MoleculeNet。所有分子均使用RDKit进行预处理。每个图表示一个分子,其中节点是原子,而边是化学键。输入节点特征为9维,包含原子序数和手性,以及其他原子特征,例如电荷和原子是否在环中。

2)预测任务

该任务是尽可能准确地预测目标分子特性,其中分子特性被标记为二元标记,例如分子是否抑制HIV病毒复制。具体来说,对于ogbg-molhiv,OGB使用ROC-AUC进行评估。

3)数据集拆分

OGB采用支架拆分(scaffold splitting)程序,根据分子的二维结构框架拆分分子。支架拆分将结构上不同的分子分成不同的子集,这在预期的实验环境中提供了对模型性能更真实的估计。

4)刷榜往事

今年5月,名为GIN+virtual node的模型在该任务上达到了0.7707的测试得分,参数量为300多万,使用的硬件为RTX 2080(11GB显存)。这个模型参考的论文是发表在ICLR 2019的“HOW POWERFUL ARE GRAPH NEURAL NETWORKS? ”,实现的作者也是论文的一作,即来自斯坦福OGB团队的胡纬华。

这篇论文提出了一个理论框架,用于分析GNN捕获不同图结构的表达能力。研究者表征了一些流行的GNN变体(例如图卷积网络或GraphSAGE)的判别力,表明它们无法学会区分某些简单的图结构。随后,他们开发出一种简单的架构,该架构被证明在GNN类中最具表达能力,并且与WeisfeilerLehman图同构测试一样强大。

短短一个月后,就有一个名为HIMP的模型超越了GIN+virtual node,它达到了0.7880的测试得分,参数量仅有15万,使用的硬件是RTX 2080(11GB显存)。实现作者又是Matthias Fey,这小哥是个专业刷子。

提出HIMP的论文是“Hierarchical Inter-Message Passing for Learning on Molecular Graphs”,研究者提出了一种用于在分子图上学习的分层神经消息传递架构。该方法能够克服传统GNN已知的一些限制,例如检测周期,同时能非常有效地进行训练。HIMP霸榜了三个月。

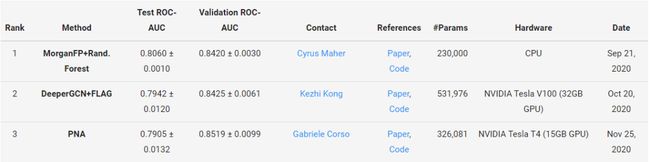

终于到9月,HIMP才遇见了对手,MorganFP+Rand. Forest以轻微的优势夺得第一,获得了0.8060的测试得分,然而这个模型的参数量更大(23万),使用的硬件是CPU(AI科技评论没记错的话,这应该是唯一一个使用CPU训练的),它也在冠军宝座上稳稳地呆了三个月。

截至12月,ogbg-molhiv排行榜上的前三名如下:

4 总结

回顾这三个榜单的刷榜往事不难看出,尽管不作为评判标准,很多模型在刷新成绩的时候,也在降低成本,这是一个值得鼓励的现象。

基准的建立不是一个学术领域的终结,而仅仅是不同的研究团队走向交流的开始。OGB细化任务提供多样数据集的做法,可以一定程度上避免盲目刷榜行为,同样值得学习。

参考资料:

https://ogb.stanford.edu/docs/leader_overview/