Datawhale-深入浅出pytorch主要组成模块和基础实战

目录

3.2 基本配置

3.3 数据读入

3.4.1 神经网络的构造

3.4.2 神经网络中常见的层

3.4.3 模型示例

3.5 模型初始化

torch.nn.init内容

torch.nn.init使用

初始化函数的封装

3.6 损失函数

3.5.1 二分类交叉熵损失函数

3.5.2 交叉熵损失函数

3.5.3 L1损失函数

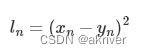

3.5.4 MSE损失函数

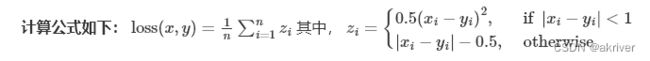

3.5.5 平滑L1 (Smooth L1)损失函数

平滑L1与L1的对比

3.5.6 目标泊松分布的负对数似然损失

3.5.7 KL散度

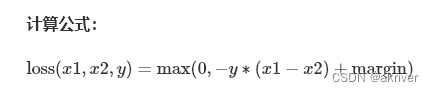

3.5.8 MarginRankingLoss

3.5.9 多标签边界损失函数

3.5.10 二分类损失函数

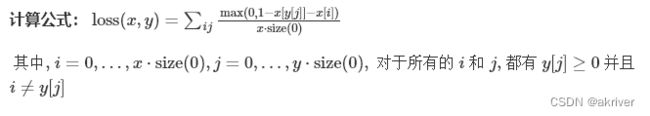

3.5.11 多分类的折页损失

3.5.12 三元组损失

3.5.13 HingEmbeddingLoss

3.5.14 余弦相似度

3.5.15 CTC损失函数

3.7 训练和评估

3.9 Pytorch优化器

3.9.1 什么是优化器

3.9.2 Pytorch提供的优化器

3.9.3 实际操作

3.9.5 实验

3.2 基本配置

首先导入必须的包。对于一个PyTorch项目,我们需要导入一些Python常用的包来帮助我们快速实现功能。常见的包有os、numpy等,此外还需要调用PyTorch自身一些模块便于灵活使用,比如torch、torch.nn、torch.utils.data.Dataset、torch.utils.data.DataLoader、torch.optimizer等等。注意这里只是建议导入的包导入的方式,可以采用不同的方案,比如涉及到表格信息的读入很可能用到pandas,对于不同的项目可能还需要导入一些更上层的包如cv2等。如果涉及可视化还会用到matplotlib、seaborn等。涉及到下游分析和指标计算也常用到sklearn。

import os

import numpy as np

import torch

import torch.nn as nn

from torch.utils.data import Dataset, DataLoader

import torch.optim as optimizer

根据前面我们对深度学习任务的梳理,有如下几个超参数可以统一设置,方便后续调试时修改:

batch size 初始学习率(初始) 训练次数(max_epochs) GPU配置

batch_size = 16 lr = 1e-4 max_epochs = 100

GPU的设置有两种常见的方式:

# 方案一:使用os.environ,这种情况如果使用GPU不需要设置

os.environ['CUDA_VISIBLE_DEVICES'] = '0,1'

# 方案二:使用“device”,后续对要使用GPU的变量用.to(device)即可

device = torch.device("cuda:1" if torch.cuda.is_available() else "cpu")

3.3 数据读入

PyTorch数据读入是通过Dataset+DataLoader的方式完成的,Dataset定义好数据的格式和数据变换形式,DataLoader用iterative的方式不断读入批次数据。

我们可以定义自己的Dataset类来实现灵活的数据读取,定义的类需要继承PyTorch自身的Dataset类。主要包含三个函数:

init: 用于向类中传入外部参数,同时定义样本集 getitem: 用于逐个读取样本集合中的元素,可以进行一定的变换,并将返回训练/验证所需的数据 len: 用于返回数据集的样本数

下面以cifar10数据集为例给出构建Dataset类的方式:

import torch from torchvision import datasets train_data = datasets.ImageFolder(train_path, transform=data_transform) val_data = datasets.ImageFolder(val_path, transform=data_transform)

这里使用了PyTorch自带的ImageFolder类的用于读取按一定结构存储的图片数据(path对应图片存放的目录,目录下包含若干子目录,每个子目录对应属于同一个类的图片)。

其中“data_transform”可以对图像进行一定的变换,如翻转、裁剪等操作,可自己定义。这里我们会在下一章通过实战加以介绍。

这里另外给出一个例子,其中图片存放在一个文件夹,另外有一个csv文件给出了图片名称对应的标签。这种情况下需要自己来定义Dataset类:

class MyDataset(Dataset):

def __init__(self, data_dir, info_csv, image_list, transform=None):

"""

Args:

data_dir: path to image directory.

info_csv: path to the csv file containing image indexes

with corresponding labels.

image_list: path to the txt file contains image names to training/validation set

transform: optional transform to be applied on a sample.

"""

label_info = pd.read_csv(info_csv)

image_file = open(image_list).readlines()

self.data_dir = data_dir

self.image_file = image_file

self.label_info = label_info

self.transform = transform

def __getitem__(self, index):

"""

Args:

index: the index of item

Returns:

image and its labels

"""

image_name = self.image_file[index].strip('\n')

raw_label = self.label_info.loc[self.label_info['Image_index'] == image_name]

label = raw_label.iloc[:,0]

image_name = os.path.join(self.data_dir, image_name)

image = Image.open(image_name).convert('RGB')

if self.transform is not None:

image = self.transform(image)

return image, label

def __len__(self):

return len(self.image_file)

构建好Dataset后,就可以使用DataLoader来按批次读入数据了,实现代码如下:

from torch.utils.data import DataLoader train_loader = torch.utils.data.DataLoader(train_data, batch_size=batch_size, num_workers=4, shuffle=True, drop_last=True) val_loader = torch.utils.data.DataLoader(val_data, batch_size=batch_size, num_workers=4, shuffle=False)

其中:

batch_size:样本是按“批”读入的,batch_size就是每次读入的样本数 num_workers:有多少个进程用于读取数据 shuffle:是否将读入的数据打乱 drop_last:对于样本最后一部分没有达到批次数的样本,使其不再参与训练

这里可以看一下我们的加载的数据。PyTorch中的DataLoader的读取可以使用next和iter来完成

import matplotlib.pyplot as plt images, labels = next(iter(val_loader)) print(images.shape) plt.imshow(images[0].transpose(1,2,0)) plt.show()

3.4.1 神经网络的构造

PyTorch中神经网络构造一般是基于 Module 类的模型来完成的,它让模型构造更加灵活。

Module 类是 nn 模块里提供的一个模型构造类,是所有神经⽹网络模块的基类,我们可以继承它来定义我们想要的模型。下面继承 Module 类构造多层感知机。这里定义的 MLP 类重载了 Module 类的 init 函数和 forward 函数。它们分别用于创建模型参数和定义前向计算。前向计算也即正向传播。

import torch

from torch import nn

class MLP(nn.Module):

# 声明带有模型参数的层,这里声明了两个全连接层

def __init__(self, **kwargs):

# 调用MLP父类Block的构造函数来进行必要的初始化。这样在构造实例时还可以指定其他函数

super(MLP, self).__init__(**kwargs)

self.hidden = nn.Linear(784, 256)

self.act = nn.ReLU()

self.output = nn.Linear(256,10)

# 定义模型的前向计算,即如何根据输入x计算返回所需要的模型输出

def forward(self, x):

o = self.act(self.hidden(x))

return self.output(o)

以上的 MLP 类中⽆须定义反向传播函数。系统将通过⾃动求梯度⽽自动⽣成反向传播所需的 backward 函数。

我们可以实例化 MLP 类得到模型变量 net 。下⾯的代码初始化 net 并传入输⼊数据 X 做一次前向计算。其中, net(X) 会调用 MLP 继承⾃自 Module 类的 call 函数,这个函数将调⽤用 MLP 类定义的forward 函数来完成前向计算。

X = torch.rand(2,784) net = MLP() print(net) net(X)

MLP( (hidden): Linear(in_features=784, out_features=256, bias=True) (act): ReLU() (output): Linear(in_features=256, out_features=10, bias=True) )tensor([[-0.0387, -0.1447, -0.1027, 0.0718, 0.0121, 0.0327, 0.1527, -0.1359, 0.0232, -0.0503], [-0.0133, -0.1672, -0.2022, 0.0219, -0.0702, 0.0655, 0.0115, 0.0490, 0.0377, -0.0802]], grad_fn=)

注意,这里并没有将 Module 类命名为 Layer (层)或者 Model (模型)之类的名字,这是因为该类是一个可供⾃由组建的部件。它的子类既可以是⼀个层(如PyTorch提供的 Linear 类),⼜可以是一个模型(如这里定义的 MLP 类),或者是模型的⼀个部分。

3.4.2 神经网络中常见的层

深度学习的一个魅力在于神经网络中各式各样的层,例如全连接层、卷积层、池化层与循环层等等。虽然PyTorch提供了⼤量常用的层,但有时候我们依然希望⾃定义层。这里我们会介绍如何使用 Module 来自定义层,从而可以被反复调用。

不含模型参数的层

我们先介绍如何定义一个不含模型参数的自定义层。下⾯构造的 MyLayer 类通过继承 Module 类自定义了一个将输入减掉均值后输出的层,并将层的计算定义在了 forward 函数里。这个层里不含模型参数。

import torch

from torch import nn

class MyLayer(nn.Module):

def __init__(self, **kwargs):

super(MyLayer, self).__init__(**kwargs)

def forward(self, x):

return x - x.mean()

测试,实例化该层,然后做前向计算

layer = MyLayer() layer(torch.tensor([1, 2, 3, 4, 5], dtype=torch.float))

tensor([-2., -1., 0., 1., 2.])

含模型参数的层

我们还可以自定义含模型参数的自定义层。其中的模型参数可以通过训练学出。

Parameter 类其实是 Tensor 的子类,如果一 个 Tensor 是 Parameter ,那么它会⾃动被添加到模型的参数列表里。所以在⾃定义含模型参数的层时,我们应该将参数定义成 Parameter ,除了直接定义成 Parameter 类外,还可以使⽤ ParameterList 和 ParameterDict 分别定义参数的列表和字典。

class MyListDense(nn.Module):

def __init__(self):

super(MyListDense, self).__init__()

self.params = nn.ParameterList([nn.Parameter(torch.randn(4, 4)) for i in range(3)])

self.params.append(nn.Parameter(torch.randn(4, 1)))

def forward(self, x):

for i in range(len(self.params)):

x = torch.mm(x, self.params[i])

return x

net = MyListDense()

print(net)

MyListDense(

(params): ParameterList(

(0): Parameter containing: [torch.FloatTensor of size 4x4]

(1): Parameter containing: [torch.FloatTensor of size 4x4]

(2): Parameter containing: [torch.FloatTensor of size 4x4]

(3): Parameter containing: [torch.FloatTensor of size 4x1]

)

)

class MyDictDense(nn.Module):

def __init__(self):

super(MyDictDense, self).__init__()

self.params = nn.ParameterDict({

'linear1': nn.Parameter(torch.randn(4, 4)),

'linear2': nn.Parameter(torch.randn(4, 1))

})

self.params.update({'linear3': nn.Parameter(torch.randn(4, 2))}) # 新增

def forward(self, x, choice='linear1'):

return torch.mm(x, self.params[choice])

net = MyDictDense()

print(net)

MyDictDense(

(params): ParameterDict(

(linear1): Parameter containing: [torch.FloatTensor of size 4x4]

(linear2): Parameter containing: [torch.FloatTensor of size 4x1]

(linear3): Parameter containing: [torch.FloatTensor of size 4x2]

)

)

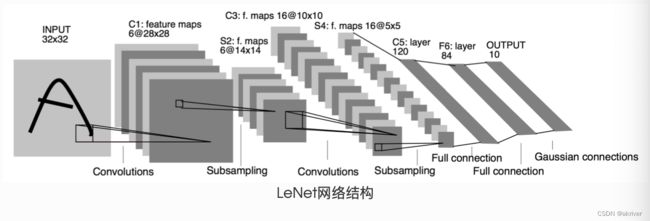

下面给出常见的神经网络的一些层,比如卷积层、池化层,以及较为基础的AlexNet,LeNet等。

二维卷积层

二维卷积层将输入和卷积核做互相关运算,并加上一个标量偏差来得到输出。卷积层的模型参数包括了卷积核和标量偏差。在训练模型的时候,通常我们先对卷积核随机初始化,然后不断迭代卷积核和偏差。

import torch

from torch import nn

# 卷积运算(二维互相关)

def corr2d(X, K):

h, w = K.shape

X, K = X.float(), K.float()

Y = torch.zeros((X.shape[0] - h + 1, X.shape[1] - w + 1))

for i in range(Y.shape[0]):

for j in range(Y.shape[1]):

Y[i, j] = (X[i: i + h, j: j + w] * K).sum()

return Y

# 二维卷积层

class Conv2D(nn.Module):

def __init__(self, kernel_size):

super(Conv2D, self).__init__()

self.weight = nn.Parameter(torch.randn(kernel_size))

self.bias = nn.Parameter(torch.randn(1))

def forward(self, x):

return corr2d(x, self.weight) + self.bias

卷积窗口形状为p x q的卷积层称为p x q卷积层。同样,p x q卷积或p x q卷积核说明卷积核的高和宽分别为p和q。 填充(padding)是指在输⼊高和宽的两侧填充元素(通常是0元素)。 下面的例子里我们创建一个⾼和宽为3的二维卷积层,然后设输⼊高和宽两侧的填充数分别为1。给定一 个高和宽为8的输入,我们发现输出的高和宽也是8。

import torch

from torch import nn

# 定义一个函数来计算卷积层。它对输入和输出做相应的升维和降维

import torch

from torch import nn

# 定义一个函数来计算卷积层。它对输入和输出做相应的升维和降维

def comp_conv2d(conv2d, X):

# (1, 1)代表批量大小和通道数

X = X.view((1, 1) + X.shape)

Y = conv2d(X)

return Y.view(Y.shape[2:]) # 排除不关心的前两维:批量和通道

# 注意这里是两侧分别填充1⾏或列,所以在两侧一共填充2⾏或列

conv2d = nn.Conv2d(in_channels=1, out_channels=1, kernel_size=3,padding=1)

X = torch.rand(8, 8)

comp_conv2d(conv2d, X).shape

torch.Size([8, 8])

当卷积核的高和宽不同时,我们也可以通过设置高和宽上不同的填充数使输出和输入具有相同的高和宽。

# 使用高为5、宽为3的卷积核。在⾼和宽两侧的填充数分别为2和1 conv2d = nn.Conv2d(in_channels=1, out_channels=1, kernel_size=(5, 3), padding=(2, 1)) comp_conv2d(conv2d, X).shape

torch.Size([8, 8])

在二维互相关运算中,卷积窗口从输入数组的最左上方开始,按从左往右、从上往下 的顺序,依次在输⼊数组上滑动。我们将每次滑动的行数和列数称为步幅(stride)。

conv2d = nn.Conv2d(1, 1, kernel_size=(3, 5), padding=(0, 1), stride=(3, 4)) comp_conv2d(conv2d, X).shape

torch.Size([2, 2])

填充可以增加输出的高和宽。这常用来使输出与输入具有相同的高和宽。

步幅可以减小输出的高和宽,例如输出的高和宽仅为输入的高和宽的 ( 为大于1的整数)。

池化层

池化层每次对输入数据的一个固定形状窗口(⼜称池化窗口)中的元素计算输出。不同于卷积层里计算输⼊和核的互相关性,池化层直接计算池化窗口内元素的最大值或者平均值。该运算也 分别叫做最大池化或平均池化。在二维最⼤池化中,池化窗口从输入数组的最左上方开始,按从左往右、从上往下的顺序,依次在输⼊数组上滑动。当池化窗口滑动到某⼀位置时,窗口中的输入子数组的最大值即输出数组中相应位置的元素。

下面把池化层的前向计算实现在pool2d函数里。

import torch

from torch import nn

def pool2d(X, pool_size, mode='max'):

p_h, p_w = pool_size

Y = torch.zeros((X.shape[0] - p_h + 1, X.shape[1] - p_w + 1))

for i in range(Y.shape[0]):

for j in range(Y.shape[1]):

if mode == 'max':

Y[i, j] = X[i: i + p_h, j: j + p_w].max()

elif mode == 'avg':

Y[i, j] = X[i: i + p_h, j: j + p_w].mean()

return Y

X = torch.tensor([[0, 1, 2], [3, 4, 5], [6, 7, 8]], dtype=torch.float) pool2d(X, (2, 2))

tensor([[4., 5.],

[7., 8.]])

pool2d(X, (2, 2), 'avg')

Out[20]:

tensor([[2., 3.],

[5., 6.]])

我们可以使用torch.nn包来构建神经网络。我们已经介绍了autograd包,nn包则依赖于autograd包来定义模型并对它们求导。一个nn.Module包含各个层和一个forward(input)方法,该方法返回output。

3.4.3 模型示例

这是一个简单的前馈神经网络 (feed-forward network)(LeNet)。它接受一个输入,然后将它送入下一层,一层接一层的传递,最后给出输出。

一个神经网络的典型训练过程如下:

定义包含一些可学习参数(或者叫权重)的神经网络

在输入数据集上迭代

通过网络处理输入

计算 loss (输出和正确答案的距离)

将梯度反向传播给网络的参数

更新网络的权重,一般使用一个简单的规则:weight = weight - learning_rate * gradient

import torch import torch.nn as nn import torch.nn.functional as F class Net(nn.Module): def __init__(self): super(Net, self).__init__() # 输入图像channel:1;输出channel:6;5x5卷积核 self.conv1 = nn.Conv2d(1, 6, 5) self.conv2 = nn.Conv2d(6, 16, 5) # an affine operation: y = Wx + b self.fc1 = nn.Linear(16 * 5 * 5, 120) self.fc2 = nn.Linear(120, 84) self.fc3 = nn.Linear(84, 10) def forward(self, x): # 2x2 Max pooling x = F.max_pool2d(F.relu(self.conv1(x)), (2, 2)) # 如果是方阵,则可以只使用一个数字进行定义 x = F.max_pool2d(F.relu(self.conv2(x)), 2) x = x.view(-1, self.num_flat_features(x)) x = F.relu(self.fc1(x)) x = F.relu(self.fc2(x)) x = self.fc3(x) return x def num_flat_features(self, x): size = x.size()[1:] # 除去批处理维度的其他所有维度 num_features = 1 for s in size: num_features *= s return num_features net = Net() print(net)Net( (conv1): Conv2d(1, 6, kernel_size=(5, 5), stride=(1, 1)) (conv2): Conv2d(6, 16, kernel_size=(5, 5), stride=(1, 1)) (fc1): Linear(in_features=400, out_features=120, bias=True) (fc2): Linear(in_features=120, out_features=84, bias=True) (fc3): Linear(in_features=84, out_features=10, bias=True) )

我们只需要定义 forward 函数,backward函数会在使用autograd时自动定义,backward函数用来计算导数。我们可以在 forward 函数中使用任何针对张量的操作和计算。

一个模型的可学习参数可以通过net.parameters()返回

params = list(net.parameters()) print(len(params)) print(params[0].size()) # conv1的权重10 torch.Size([6, 1, 5, 5])

让我们尝试一个随机的 32x32 的输入。注意:这个网络 (LeNet)的期待输入是 32x32 的张量。如果使用 MNIST 数据集来训练这个网络,要把图片大小重新调整到 32x32。

In [23]:

input = torch.randn(1, 1, 32, 32) out = net(input) print(out)

tensor([[-0.0682, -0.1005, -0.0522, -0.0700, 0.0171, -0.0961, 0.1108, 0.0406,

-0.0417, -0.0105]], grad_fn=)

清零所有参数的梯度缓存,然后进行随机梯度的反向传播:

In [24]:

net.zero_grad() out.backward(torch.randn(1, 10))

注意:torch.nn只支持小批量处理 (mini-batches)。整个 torch.nn 包只支持小批量样本的输入,不支持单个样本的输入。比如,nn.Conv2d 接受一个4维的张量,即nSamples x nChannels x Height x Width 如果是一个单独的样本,只需要使用input.unsqueeze(0) 来添加一个“假的”批大小维度。

torch.Tensor - 一个多维数组,支持诸如backward()等的自动求导操作,同时也保存了张量的梯度。 nn.Module - 神经网络模块。是一种方便封装参数的方式,具有将参数移动到GPU、导出、加载等功能。 nn.Parameter - 张量的一种,当它作为一个属性分配给一个Module时,它会被自动注册为一个参数。 autograd.Function - 实现了自动求导前向和反向传播的定义,每个Tensor至少创建一个Function节点,该节点连接到创建Tensor的函数并对其历史进行编码。

下面再介绍一个比较基础的案例AlexNet

AlexNet

In [25]:

class AlexNet(nn.Module):

def __init__(self):

super(AlexNet, self).__init__()

self.conv = nn.Sequential(

nn.Conv2d(1, 96, 11, 4), # in_channels, out_channels, kernel_size, stride, padding

nn.ReLU(),

nn.MaxPool2d(3, 2), # kernel_size, stride

# 减小卷积窗口,使用填充为2来使得输入与输出的高和宽一致,且增大输出通道数

nn.Conv2d(96, 256, 5, 1, 2),

nn.ReLU(),

nn.MaxPool2d(3, 2),

# 连续3个卷积层,且使用更小的卷积窗口。除了最后的卷积层外,进一步增大了输出通道数。

# 前两个卷积层后不使用池化层来减小输入的高和宽

nn.Conv2d(256, 384, 3, 1, 1),

nn.ReLU(),

nn.Conv2d(384, 384, 3, 1, 1),

nn.ReLU(),

nn.Conv2d(384, 256, 3, 1, 1),

nn.ReLU(),

nn.MaxPool2d(3, 2)

)

# 这里全连接层的输出个数比LeNet中的大数倍。使用丢弃层来缓解过拟合

self.fc = nn.Sequential(

nn.Linear(256*5*5, 4096),

nn.ReLU(),

nn.Dropout(0.5),

nn.Linear(4096, 4096),

nn.ReLU(),

nn.Dropout(0.5),

# 输出层。由于这里使用Fashion-MNIST,所以用类别数为10,而非论文中的1000

nn.Linear(4096, 10),

)

def forward(self, img):

feature = self.conv(img)

output = self.fc(feature.view(img.shape[0], -1))

return output

In [26]:

net = AlexNet() print(net)

AlexNet(

(conv): Sequential(

(0): Conv2d(1, 96, kernel_size=(11, 11), stride=(4, 4))

(1): ReLU()

(2): MaxPool2d(kernel_size=3, stride=2, padding=0, dilation=1, ceil_mode=False)

(3): Conv2d(96, 256, kernel_size=(5, 5), stride=(1, 1), padding=(2, 2))

(4): ReLU()

(5): MaxPool2d(kernel_size=3, stride=2, padding=0, dilation=1, ceil_mode=False)

(6): Conv2d(256, 384, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(7): ReLU()

(8): Conv2d(384, 384, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(9): ReLU()

(10): Conv2d(384, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(11): ReLU()

(12): MaxPool2d(kernel_size=3, stride=2, padding=0, dilation=1, ceil_mode=False)

)

(fc): Sequential(

(0): Linear(in_features=6400, out_features=4096, bias=True)

(1): ReLU()

(2): Dropout(p=0.5, inplace=False)

(3): Linear(in_features=4096, out_features=4096, bias=True)

(4): ReLU()

(5): Dropout(p=0.5, inplace=False)

(6): Linear(in_features=4096, out_features=10, bias=True)

)

)

3.5 模型初始化

在深度学习模型的训练中,权重的初始值极为重要。一个好的权重值,会使模型收敛速度提高,使模型准确率更精确。为了利于训练和减少收敛时间,我们需要对模型进行合理的初始化。PyTorch也在torch.nn.init中为我们提供了常用的初始化方法。 通过本章学习,你将学习到以下内容: 常见的初始化函数 初始化函数的使用

torch.nn.init内容

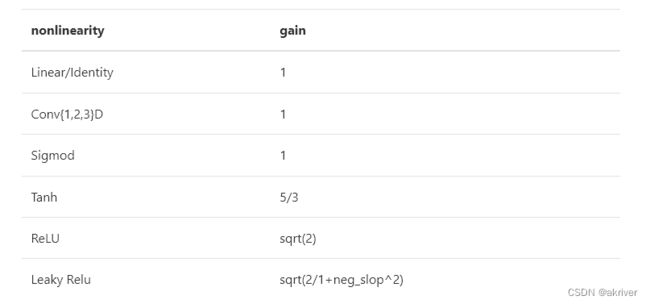

通过访问torch.nn.init的官方文档链接 ,我们发现torch.nn.init提供了以下初始化方法: 1 . torch.nn.init.uniform(tensor, a=0.0, b=1.0) 2 . torch.nn.init.normal(tensor, mean=0.0, std=1.0) 3 . torch.nn.init.constant(tensor, val) 4 . torch.nn.init.ones(tensor) 5 . torch.nn.init.zeros(tensor) 6 . torch.nn.init.eye(tensor) 7 . torch.nn.init.dirac_(tensor, groups=1) 8 . torch.nn.init.xavieruniform(tensor, gain=1.0) 9 . torch.nn.init.xaviernormal(tensor, gain=1.0) 10 . torch.nn.init.kaiminguniform(tensor, a=0, mode='fan__in', nonlinearity='leaky_relu') 11 . torch.nn.init.kaimingnormal(tensor, a=0, mode='fan_in', nonlinearity='leakyrelu') 12 . torch.nn.init.orthogonal(tensor, gain=1) 13 . torch.nn.init.sparse_(tensor, sparsity, std=0.01) 14 . torch.nn.init.calculate_gain(nonlinearity, param=None) 关于计算增益如下表:

我们可以发现这些函数除了calculate_gain,所有函数的后缀都带有下划线,意味着这些函数将会直接原地更改输入张量的值。

torch.nn.init使用

我们通常会根据实际模型来使用torch.nn.init进行初始化,通常使用isinstance来进行判断模块(回顾3.4模型构建)属于什么类型。

In [27]:

import torch import torch.nn as nn conv = nn.Conv2d(1,3,3) linear = nn.Linear(10,1) isinstance(conv,nn.Conv2d) isinstance(linear,nn.Conv2d)

Out[27]:

False

对于不同的类型层,我们就可以设置不同的权值初始化的方法。

In [28]:

# 查看随机初始化的conv参数 conv.weight.data # 查看linear的参数 linear.weight.data

Out[28]:

tensor([[ 0.2899, -0.2703, -0.2750, 0.3010, -0.1187, 0.2254, -0.1627, -0.0754,

0.0215, 0.3143]])

In [29]:

# 对conv进行kaiming初始化 torch.nn.init.kaiming_normal_(conv.weight.data) conv.weight.data # 对linear进行常数初始化 torch.nn.init.constant_(linear.weight.data,0.3) linear.weight.data

Out[29]:

tensor([[0.3000, 0.3000, 0.3000, 0.3000, 0.3000, 0.3000, 0.3000, 0.3000, 0.3000,

0.3000]])

初始化函数的封装

人们常常将各种初始化方法定义为一个initialize_weights()的函数并在模型初始后进行使用。

In [30]:

def initialize_weights(self): for m in self.modules(): # 判断是否属于Conv2d if isinstance(m, nn.Conv2d): torch.nn.init.xavier_normal_(m.weight.data) # 判断是否有偏置 if m.bias is not None: torch.nn.init.constant_(m.bias.data,0.3) elif isinstance(m, nn.Linear): torch.nn.init.normal_(m.weight.data, 0.1) if m.bias is not None: torch.nn.init.zeros_(m.bias.data) elif isinstance(m, nn.BatchNorm2d): m.weight.data.fill_(1) m.bias.data.zeros_()

这段代码流程是遍历当前模型的每一层,然后判断各层属于什么类型,然后根据不同类型层,设定不同的权值初始化方法。我们可以通过下面的例程进行一个简短的演示:

In [31]:

# 模型的定义 class MLP(nn.Module): # 声明带有模型参数的层,这里声明了两个全连接层 def __init__(self, **kwargs): # 调用MLP父类Block的构造函数来进行必要的初始化。这样在构造实例时还可以指定其他函数 super(MLP, self).__init__(**kwargs) self.hidden = nn.Conv2d(1,1,3) self.act = nn.ReLU() self.output = nn.Linear(10,1) # 定义模型的前向计算,即如何根据输入x计算返回所需要的模型输出 def forward(self, x): o = self.act(self.hidden(x)) return self.output(o) mlp = MLP() print(list(mlp.parameters())) print("-------初始化-------") initialize_weights(mlp) print(list(mlp.parameters()))[Parameter containing: tensor([[[[ 0.2840, -0.2238, 0.0503], [ 0.0648, 0.2615, 0.0964], [ 0.1866, 0.3313, -0.2463]]]], requires_grad=True), Parameter containing: tensor([-0.1269], requires_grad=True), Parameter containing: tensor([[ 0.1389, 0.1589, -0.3066, -0.2195, -0.1037, -0.2945, 0.0615, -0.0849, 0.1764, -0.3056]], requires_grad=True), Parameter containing: tensor([0.1062], requires_grad=True)] -------初始化------- [Parameter containing: tensor([[[[ 0.5707, 0.0622, 0.0665], [ 0.1418, 0.1234, -0.0789], [ 0.1773, -0.4237, -0.0734]]]], requires_grad=True), Parameter containing: tensor([0.3000], requires_grad=True), Parameter containing: tensor([[ 0.4903, 0.4000, -0.5806, 0.1440, 0.3919, 1.7338, -0.4744, -0.9704, 1.2319, 0.2605]], requires_grad=True), Parameter containing: tensor([0.], requires_grad=True)]

3.6 损失函数

在深度学习广为使用的今天,我们可以在脑海里清晰的知道,一个模型想要达到很好的效果需要学习,也就是我们常说的训练。一个好的训练离不开优质的负反馈,这里的损失函数就是模型的负反馈。

所以在PyTorch中,损失函数是必不可少的。它是数据输入到模型当中,产生的结果与真实标签的评价指标,我们的模型可以按照损失函数的目标来做出改进。

下面我们将开始探索pytorch的所拥有的损失函数。这里将列出PyTorch中常用的损失函数(一般通过torch.nn调用),并详细介绍每个损失函数的功能介绍、数学公式和调用代码。当然,PyTorch的损失函数还远不止这些,在解决实际问题的过程中需要进一步探索、借鉴现有工作,或者设计自己的损失函数。

3.5.1 二分类交叉熵损失函数

In [32]:

torch.nn.BCELoss(weight=None, size_average=None, reduce=None, reduction='mean')

Out[32]:

BCELoss()

功能:计算二分类任务时的交叉熵(Cross Entropy)函数。在二分类中,label是{0,1}。对于进入交叉熵函数的input为概率分布的形式。一般来说,input为sigmoid激活层的输出,或者softmax的输出。

主要参数:

weight:每个类别的loss设置权值 size_average:数据为bool,为True时,返回的loss为平均值;为False时,返回的各样本的loss之和。 reduce:数据类型为bool,为True时,loss的返回是标量。

In [34]:

m = nn.Sigmoid() loss = nn.BCELoss() input = torch.randn(3, requires_grad=True) target = torch.empty(3).random_(2) output = loss(m(input), target) output.backward()

In [35]:

print('BCELoss损失函数的计算结果为',output)

BCELoss损失函数的计算结果为 tensor(0.7849, grad_fn=)

3.5.2 交叉熵损失函数

In [36]:

torch.nn.CrossEntropyLoss(weight=None, size_average=None, ignore_index=-100, reduce=None, reduction='mean')

Out[36]:

CrossEntropyLoss()

功能:计算交叉熵函数 主要参数: weight:每个类别的loss设置权值。 size_average:数据为bool,为True时,返回的loss为平均值;为False时,返回的各样本的loss之和。 ignore_index:忽略某个类的损失函数。 reduce:数据类型为bool,为True时,loss的返回是标量。

In [37]:

loss = nn.CrossEntropyLoss() input = torch.randn(3, 5, requires_grad=True) target = torch.empty(3, dtype=torch.long).random_(5) output = loss(input, target) output.backward()

In [38]:

print(output)

tensor(1.9884, grad_fn=)

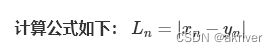

3.5.3 L1损失函数

In [39]:

torch.nn.L1Loss(size_average=None, reduce=None, reduction='mean')

Out[39]:

L1Loss()

功能: 计算输出y和真实标签target之间的差值的绝对值。

我们需要知道的是,reduction参数决定了计算模式。有三种计算模式可选:none:逐个元素计算。 sum:所有元素求和,返回标量。 mean:加权平均,返回标量。 如果选择none,那么返回的结果是和输入元素相同尺寸的。默认计算方式是求平均。

In [40]:

loss = nn.L1Loss() input = torch.randn(3, 5, requires_grad=True) target = torch.randn(3, 5) output = loss(input, target) output.backward()

In [41]:

print('L1损失函数的计算结果为',output)

L1损失函数的计算结果为 tensor(1.2040, grad_fn=)

3.5.4 MSE损失函数

In [ ]:

torch.nn.MSELoss(size_average=None, reduce=None, reduction='mean')

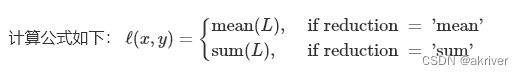

功能: 计算输出y和真实标签target之差的平方。 和L1Loss一样,MSELoss损失函数中,reduction参数决定了计算模式。有三种计算模式可选:none:逐个元素计算。 sum:所有元素求和,返回标量。默认计算方式是求平均。 计算公式如下:

In [42]:

loss = nn.MSELoss() input = torch.randn(3, 5, requires_grad=True) target = torch.randn(3, 5) output = loss(input, target) output.backward()

In [43]:

print('MSE损失函数的计算结果为',output)

MSE损失函数的计算结果为 tensor(1.8216, grad_fn=)

3.5.5 平滑L1 (Smooth L1)损失函数

torch.nn.SmoothL1Loss(size_average=None, reduce=None, reduction='mean', beta=1.0)

功能: L1的平滑输出,其功能是减轻离群点带来的影响 reduction参数决定了计算模式。有三种计算模式可选:none:逐个元素计算。 sum:所有元素求和,返回标量。默认计算方式是求平均。 提醒: 之后的损失函数中,关于reduction 这个参数依旧会存在。所以,之后就不再单独说明。

In [44]:

loss = nn.SmoothL1Loss() input = torch.randn(3, 5, requires_grad=True) target = torch.randn(3, 5) output = loss(input, target) output.backward()

In [45]:

print('SmoothL1Loss损失函数的计算结果为',output)

SmoothL1Loss损失函数的计算结果为 tensor(0.4989, grad_fn=)

平滑L1与L1的对比

这里我们通过可视化两种损失函数曲线来对比平滑L1和L1两种损失函数的区别。

In [54]:

inputs = torch.linspace(-10, 10, steps=5000)

target = torch.zeros_like(inputs)

loss_f_smooth = nn.SmoothL1Loss(reduction='none')

loss_smooth = loss_f_smooth(inputs, target)

loss_f_l1 = nn.L1Loss(reduction='none')

loss_l1 = loss_f_l1(inputs,target)

plt.plot(inputs.numpy(), loss_smooth.numpy(), label='Smooth L1 Loss')

plt.plot(inputs.numpy(), loss_l1, label='L1 loss')

plt.xlabel('x_i - y_i')

plt.ylabel('loss value')

plt.legend()

plt.grid()

plt.show()

3.5.6 目标泊松分布的负对数似然损失

In [55]:

torch.nn.PoissonNLLLoss(log_input=True, full=False, size_average=None, eps=1e-08, reduce=None, reduction='mean')

Out[55]:

PoissonNLLLoss()

功能: 泊松分布的负对数似然损失函数 主要参数: log_input:输入是否为对数形式,决定计算公式。 full:计算所有 loss,默认为 False。 eps:修正项,避免 input 为 0 时,log(input) 为 nan 的情况。 数学公式:

In [56]:

loss = nn.PoissonNLLLoss() log_input = torch.randn(5, 2, requires_grad=True) target = torch.randn(5, 2) output = loss(log_input, target) output.backward()

In [57]:

print('PoissonNLLLoss损失函数的计算结果为',output)

PoissonNLLLoss损失函数的计算结果为 tensor(2.0626, grad_fn=)

3.5.7 KL散度

In [58]:

torch.nn.KLDivLoss(size_average=None, reduce=None, reduction='mean', log_target=False)

Out[58]:

KLDivLoss()

功能: 计算KL散度,也就是计算相对熵。用于连续分布的距离度量,并且对离散采用的连续输出空间分布进行回归通常很有用。

主要参数:

reduction:计算模式,可为 none/sum/mean/batchmean。

none:逐个元素计算。

sum:所有元素求和,返回标量。

mean:加权平均,返回标量。

batchmean:batchsize 维度求平均值

In [59]:

inputs = torch.tensor([[0.5, 0.3, 0.2], [0.2, 0.3, 0.5]])

target = torch.tensor([[0.9, 0.05, 0.05], [0.1, 0.7, 0.2]], dtype=torch.float)

loss = nn.KLDivLoss()

output = loss(inputs,target)

print('KLDivLoss损失函数的计算结果为',output)

KLDivLoss损失函数的计算结果为 tensor(-0.3335)

G:\Anaconda\envs\env_name\lib\site-packages\torch\nn\functional.py:2887: UserWarning: reduction: 'mean' divides the total loss by both the batch size and the support size.'batchmean' divides only by the batch size, and aligns with the KL div math definition.'mean' will be changed to behave the same as 'batchmean' in the next major release. "reduction: 'mean' divides the total loss by both the batch size and the support size."

3.5.8 MarginRankingLoss

torch.nn.MarginRankingLoss(margin=0.0, size_average=None, reduce=None, reduction='mean')

功能: 计算两个向量之间的相似度,用于排序任务。该方法用于计算两组数据之间的差异。 主要参数: margin:边界值,x1与x2之间的差异值。 reduction:计算模式,可为 none/sum/mean。

loss = nn.MarginRankingLoss()

input1 = torch.randn(3, requires_grad=True)

input2 = torch.randn(3, requires_grad=True)

target = torch.randn(3).sign()

output = loss(input1, input2, target)

output.backward()

print('MarginRankingLoss损失函数的计算结果为',output)

MarginRankingLoss损失函数的计算结果为 tensor(0., grad_fn=)

3.5.9 多标签边界损失函数

torch.nn.MultiLabelMarginLoss(size_average=None, reduce=None, reduction='mean')功能: 对于多标签分类问题计算损失函数。 主要参数: reduction:计算模式,可为 none/sum/mean。

In [61]:

loss = nn.MultiLabelMarginLoss()

x = torch.FloatTensor([[0.9, 0.2, 0.4, 0.8]])

# for target y, only consider labels 3 and 0, not after label -1

y = torch.LongTensor([[3, 0, -1, 1]])# 真实的分类是,第3类和第0类

output = loss(x, y)

print('MultiLabelMarginLoss损失函数的计算结果为',output)

MultiLabelMarginLoss损失函数的计算结果为 tensor(0.4500)

3.5.10 二分类损失函数

In [ ]:

torch.nn.SoftMarginLoss(size_average=None, reduce=None, reduction='mean')torch.nn.(size_average=None, reduce=None, reduction='mean')

In [62]:

inputs = torch.tensor([[0.3, 0.7], [0.5, 0.5]]) # 两个样本,两个神经元

target = torch.tensor([[-1, 1], [1, -1]], dtype=torch.float) # 该 loss 为逐个神经元计算,需要为每个神经元单独设置标签

loss_f = nn.SoftMarginLoss()

output = loss_f(inputs, target)

print('SoftMarginLoss损失函数的计算结果为',output)

SoftMarginLoss损失函数的计算结果为 tensor(0.6764)

3.5.11 多分类的折页损失

In [ ]:

torch.nn.MultiMarginLoss(p=1, margin=1.0, weight=None, size_average=None, reduce=None, reduction='mean')

In [63]:

inputs = torch.tensor([[0.3, 0.7], [0.5, 0.5]])

target = torch.tensor([0, 1], dtype=torch.long)

loss_f = nn.MultiMarginLoss()

output = loss_f(inputs, target)

print('MultiMarginLoss损失函数的计算结果为',output)

MultiMarginLoss损失函数的计算结果为 tensor(0.6000)

3.5.12 三元组损失

In [ ]:

torch.nn.TripletMarginLoss(margin=1.0, p=2.0, eps=1e-06, swap=False, size_average=None, reduce=None, reduction='mean')

功能: 计算三元组损失。

三元组: 这是一种数据的存储或者使用格式。<实体1,关系,实体2>。在项目中,也可以表示为< anchor, positive examples , negative examples>

在这个损失函数中,我们希望去anchor的距离更接近positive examples,而远离negative examples

主要参数:

reduction:计算模式,可为 none/sum/mean。

p:可选 1 或 2。

margin:边界值

triplet_loss = nn.TripletMarginLoss(margin=1.0, p=2)

anchor = torch.randn(100, 128, requires_grad=True)

positive = torch.randn(100, 128, requires_grad=True)

negative = torch.randn(100, 128, requires_grad=True)

output = triplet_loss(anchor, positive, negative)

output.backward()

print('TripletMarginLoss损失函数的计算结果为',output)

3.5.13 HingEmbeddingLoss

In [ ]:

torch.nn.HingeEmbeddingLoss(margin=1.0, size_average=None, reduce=None, reduction='mean')

In [ ]:

功能: 对输出的embedding结果做Hing损失计算 主要参数: reduction:计算模式,可为 none/sum/mean。 margin:边界值 可以这样理解,让个输出的是正例yn=1,那么loss就是x,如果输出的是负例y=-1,那么输出的loss就是要做一个比较。

In [64]:

loss_f = nn.HingeEmbeddingLoss()

inputs = torch.tensor([[1., 0.8, 0.5]])

target = torch.tensor([[1, 1, -1]])

output = loss_f(inputs,target)

print('HingEmbeddingLoss损失函数的计算结果为',output)

HingEmbeddingLoss损失函数的计算结果为 tensor(0.7667)

3.5.14 余弦相似度

In [ ]:

torch.nn.CosineEmbeddingLoss(margin=0.0, size_average=None, reduce=None, reduction='mean')

功能: 对两个向量做余弦相似度

主要参数:

reduction:计算模式,可为 none/sum/mean。

margin:可取值[-1,1] ,推荐为[0,0.5] 。

这个损失函数应该是最广为人知的。对于两个向量,做余弦相似度。将余弦相似度作为一个距离的计算方式,如果两个向量的距离近,则损失函数值小,反之亦然。

In [65]:

loss_f = nn.CosineEmbeddingLoss()

inputs_1 = torch.tensor([[0.3, 0.5, 0.7], [0.3, 0.5, 0.7]])

inputs_2 = torch.tensor([[0.1, 0.3, 0.5], [0.1, 0.3, 0.5]])

target = torch.tensor([[1, -1]], dtype=torch.float)

output = loss_f(inputs_1,inputs_2,target)

print('CosineEmbeddingLoss损失函数的计算结果为',output)

--------------------------------------------------------------------------- RuntimeError Traceback (most recent call last)in 3 inputs_2 = torch.tensor([[0.1, 0.3, 0.5], [0.1, 0.3, 0.5]]) 4 target = torch.tensor([[1, -1]], dtype=torch.float) ----> 5 output = loss_f(inputs_1,inputs_2,target) 6 7 print('CosineEmbeddingLoss损失函数的计算结果为',output) G:\Anaconda\envs\env_name\lib\site-packages\torch\nn\modules\module.py in _call_impl(self, *input, **kwargs) 1108 if not (self._backward_hooks or self._forward_hooks or self._forward_pre_hooks or _global_backward_hooks 1109 or _global_forward_hooks or _global_forward_pre_hooks): -> 1110 return forward_call(*input, **kwargs) 1111 # Do not call functions when jit is used 1112 full_backward_hooks, non_full_backward_hooks = [], [] G:\Anaconda\envs\env_name\lib\site-packages\torch\nn\modules\loss.py in forward(self, input1, input2, target) 1263 1264 def forward(self, input1: Tensor, input2: Tensor, target: Tensor) -> Tensor: -> 1265 return F.cosine_embedding_loss(input1, input2, target, margin=self.margin, reduction=self.reduction) 1266 1267 G:\Anaconda\envs\env_name\lib\site-packages\torch\nn\functional.py in cosine_embedding_loss(input1, input2, target, margin, size_average, reduce, reduction) 3458 else: 3459 reduction_enum = _Reduction.get_enum(reduction) -> 3460 return torch.cosine_embedding_loss(input1, input2, target, margin, reduction_enum) 3461 3462 RuntimeError: 0D or 1D target tensor expected, multi-target not supported

3.5.15 CTC损失函数

In [ ]:

torch.nn.CTCLoss(blank=0, reduction='mean', zero_infinity=False)

功能: 用于解决时序类数据的分类

计算连续时间序列和目标序列之间的损失。CTCLoss对输入和目标的可能排列的概率进行求和,产生一个损失值,这个损失值对每个输入节点来说是可分的。输入与目标的对齐方式被假定为 "多对一",这就限制了目标序列的长度,使其必须是≤输入长度。

主要参数:

reduction:计算模式,可为 none/sum/mean。

blank:blank label。

zero_infinity:无穷大的值或梯度值为

In [66]:

# Target are to be padded

T = 50 # Input sequence length

C = 20 # Number of classes (including blank)

N = 16 # Batch size

S = 30 # Target sequence length of longest target in batch (padding length)

S_min = 10 # Minimum target length, for demonstration purposes

# Initialize random batch of input vectors, for *size = (T,N,C)

input = torch.randn(T, N, C).log_softmax(2).detach().requires_grad_()

# Initialize random batch of targets (0 = blank, 1:C = classes)

target = torch.randint(low=1, high=C, size=(N, S), dtype=torch.long)

input_lengths = torch.full(size=(N,), fill_value=T, dtype=torch.long)

target_lengths = torch.randint(low=S_min, high=S, size=(N,), dtype=torch.long)

ctc_loss = nn.CTCLoss()

loss = ctc_loss(input, target, input_lengths, target_lengths)

loss.backward()

# Target are to be un-padded

T = 50 # Input sequence length

C = 20 # Number of classes (including blank)

N = 16 # Batch size

# Initialize random batch of input vectors, for *size = (T,N,C)

input = torch.randn(T, N, C).log_softmax(2).detach().requires_grad_()

input_lengths = torch.full(size=(N,), fill_value=T, dtype=torch.long)

# Initialize random batch of targets (0 = blank, 1:C = classes)

target_lengths = torch.randint(low=1, high=T, size=(N,), dtype=torch.long)

target = torch.randint(low=1, high=C, size=(sum(target_lengths),), dtype=torch.long)

ctc_loss = nn.CTCLoss()

loss = ctc_loss(input, target, input_lengths, target_lengths)

loss.backward()

print('CTCLoss损失函数的计算结果为',loss)

CTCLoss损失函数的计算结果为 tensor(7.9300, grad_fn=)

3.7 训练和评估

完成了上述设定后就可以加载数据开始训练模型了。首先应该设置模型的状态:如果是训练状态,那么模型的参数应该支持反向传播的修改;如果是验证/测试状态,则不应该修改模型参数。在PyTorch中,模型的状态设置非常简便,如下的两个操作二选一即可:

In [67]:

model.train() # 训练状态 model.eval() # 验证/测试状态

--------------------------------------------------------------------------- NameError Traceback (most recent call last)in ----> 1 model.train() # 训练状态 2 model.eval() # 验证/测试状态 NameError: name 'model' is not defined

我们前面在DataLoader构建完成后介绍了如何从中读取数据,在训练过程中使用类似的操作即可,区别在于此时要用for循环读取DataLoader中的全部数据。

In [ ]:

for data, label in train_loader:

之后将数据放到GPU上用于后续计算,此处以.cuda()为例

In [ ]:

data, label = data.cuda(), label.cuda()

开始用当前批次数据做训练时,应当先将优化器的梯度置零:

In [ ]:

optimizer.zero_grad()

之后将data送入模型中训练:

In [ ]:

output = model(data)

根据预先定义的criterion计算损失函数:

In [ ]:

loss = criterion(output, label)

将loss反向传播回网络:

In [ ]:

loss.backward()

使用优化器更新模型参数:

In [ ]:

optimizer.step()

这样一个训练过程就完成了,后续还可以计算模型准确率等指标,这部分会在下一节的图像分类实战中加以介绍。

验证/测试的流程基本与训练过程一致,不同点在于:

需要预先设置torch.no_grad,以及将model调至eval模式 不需要将优化器的梯度置零 不需要将loss反向回传到网络 不需要更新optimizer

一个完整的图像分类的训练过程如下所示:

In [70]:

def train(epoch):

model.train()

train_loss = 0

for data, label in train_loader:

data, label = data.cuda(), label.cuda()

optimizer.zero_grad()

output = model(data)

loss = criterion(label, output)

loss.backward()

optimizer.step()

train_loss += loss.item()*data.size(0)

train_loss = train_loss/len(train_loader.dataset)

print('Epoch: {} \tTraining Loss: {:.6f}'.format(epoch, train_loss))

--------------------------------------------------------------------------- NameError Traceback (most recent call last)in 11 train_loss += loss.item()*data.size(0) 12 train_loss = train_loss/len(train_loader.dataset) ---> 13 print('Epoch: {} \tTraining Loss: {:.6f}'.format(epoch, train_loss)) NameError: name 'epoch' is not defined

对应的,一个完整图像分类的验证过程如下所示:

In [71]:

def val(epoch):

model.eval()

val_loss = 0

with torch.no_grad():

for data, label in val_loader:

data, label = data.cuda(), label.cuda()

output = model(data)

preds = torch.argmax(output, 1)

loss = criterion(output, label)

val_loss += loss.item()*data.size(0)

running_accu += torch.sum(preds == label.data)

val_loss = val_loss/len(val_loader.dataset)

print('Epoch: {} \tTraining Loss: {:.6f}'.format(epoch, val_loss))

3.9 Pytorch优化器

3.9.1 什么是优化器

深度学习的目标是通过不断改变网络参数,使得参数能够对输入做各种非线性变换拟合输出,本质上就是一个函数去寻找最优解,只不过这个最优解是一个矩阵,而如何快速求得这个最优解是深度学习研究的一个重点,以经典的resnet-50为例,它大约有2000万个系数需要进行计算,那么我们如何计算出这么多系数,有以下两种方法:

第一种是直接暴力穷举一遍参数,这种方法实施可能性基本为0,堪比愚公移山plus的难度。

为了使求解参数过程更快,人们提出了第二种办法,即BP+优化器逼近求解。

因此,优化器是根据网络反向传播的梯度信息来更新网络的参数,以起到降低loss函数计算值,使得模型输出更加接近真实标签。

3.9.2 Pytorch提供的优化器

In [ ]:

Pytorch很人性化的给我们提供了一个优化器的库torch.optim,在这里面提供了十种优化器。 torch.optim.ASGD torch.optim.Adadelta torch.optim.Adagrad torch.optim.Adam torch.optim.AdamW torch.optim.Adamax torch.optim.LBFGS torch.optim.RMSprop torch.optim.Rprop torch.optim.SGD torch.optim.SparseAdam 而以上这些优化算法均继承于Optimizer,下面我们先来看下所有优化器的基类Optimizer。定义如下:

In [72]:

class Optimizer(object):

def __init__(self, params, defaults):

self.defaults = defaults

self.state = defaultdict(dict)

self.param_groups = []

Optimizer有三个属性:

defaults:存储的是优化器的超参数,例子如下:

In [ ]:

{'lr': 0.1, 'momentum': 0.9, 'dampening': 0, 'weight_decay': 0, 'nesterov': False}

state:参数的缓存,例子如下:

In [73]:

defaultdict(, {tensor([[ 0.3864, -0.0131], [-0.1911, -0.4511]], requires_grad=True): {'momentum_buffer': tensor([[0.0052, 0.0052], [0.0052, 0.0052]])}}) File "", line 1 defaultdict( , {tensor([[ 0.3864, -0.0131], ^ SyntaxError: invalid syntax

param_groups:管理的参数组,是一个list,其中每个元素是一个字典,顺序是params,lr,momentum,dampening,weight_decay,nesterov,例子如下:

In [75]:

[{'params': [tensor([[-0.1022, -1.6890],[-1.5116, -1.7846]], requires_grad=True)], 'lr': 1, 'momentum': 0, 'dampening': 0, 'weight_decay': 0, 'nesterov': False}]

--------------------------------------------------------------------------- NameError Traceback (most recent call last)in ----> 1 [{'params': [tensor([[-0.1022, -1.6890],[-1.5116, -1.7846]], requires_grad=True)], 'lr': 1, 'momentum': 0, 'dampening': 0, 'weight_decay': 0, 'nesterov': False}] NameError: name 'tensor' is not defined

Optimizer还有以下的方法:

zero_grad():清空所管理参数的梯度,PyTorch的特性是张量的梯度不自动清零,因此每次反向传播后都需要清空梯度。

In [76]:

def zero_grad(self, set_to_none: bool = False):

for group in self.param_groups:

for p in group['params']:

if p.grad is not None: #梯度不为空

if set_to_none:

p.grad = None

else:

if p.grad.grad_fn is not None:

p.grad.detach_()

else:

p.grad.requires_grad_(False)

p.grad.zero_()# 梯度设置为0

step():执行一步梯度更新,参数更新

In [77]:

def step(self, closure):

raise NotImplementedError

add_param_group():添加参数组

In [78]:

def add_param_group(self, param_group): assert isinstance(param_group, dict), "param group must be a dict" # 检查类型是否为tensor params = param_group['params'] if isinstance(params, torch.Tensor): param_group['params'] = [params] elif isinstance(params, set): raise TypeError('optimizer parameters need to be organized in ordered collections, but ' 'the ordering of tensors in sets will change between runs. Please use a list instead.') else: param_group['params'] = list(params) for param in param_group['params']: if not isinstance(param, torch.Tensor): raise TypeError("optimizer can only optimize Tensors, " "but one of the params is " + torch.typename(param)) if not param.is_leaf: raise ValueError("can't optimize a non-leaf Tensor") for name, default in self.defaults.items(): if default is required and name not in param_group: raise ValueError("parameter group didn't specify a value of required optimization parameter " + name) else: param_group.setdefault(name, default) params = param_group['params'] if len(params) != len(set(params)): warnings.warn("optimizer contains a parameter group with duplicate parameters; " "in future, this will cause an error; " "see github.com/pytorch/pytorch/issues/40967 for more information", stacklevel=3) # 上面好像都在进行一些类的检测,报Warning和Error param_set = set() for group in self.param_groups: param_set.update(set(group['params'])) if not param_set.isdisjoint(set(param_group['params'])): raise ValueError("some parameters appear in more than one parameter group") # 添加参数 self.param_groups.append(param_group)load_state_dict() :加载状态参数字典,可以用来进行模型的断点续训练,继续上次的参数进行训练

In [79]:

def load_state_dict(self, state_dict): r"""Loads the optimizer state. Arguments: state_dict (dict): optimizer state. Should be an object returned from a call to :meth:`state_dict`. """ # deepcopy, to be consistent with module API state_dict = deepcopy(state_dict) # Validate the state_dict groups = self.param_groups saved_groups = state_dict['param_groups'] if len(groups) != len(saved_groups): raise ValueError("loaded state dict has a different number of " "parameter groups") param_lens = (len(g['params']) for g in groups) saved_lens = (len(g['params']) for g in saved_groups) if any(p_len != s_len for p_len, s_len in zip(param_lens, saved_lens)): raise ValueError("loaded state dict contains a parameter group " "that doesn't match the size of optimizer's group") # Update the state id_map = {old_id: p for old_id, p in zip(chain.from_iterable((g['params'] for g in saved_groups)), chain.from_iterable((g['params'] for g in groups)))} def cast(param, value): r"""Make a deep copy of value, casting all tensors to device of param.""" ..... # Copy state assigned to params (and cast tensors to appropriate types). # State that is not assigned to params is copied as is (needed for # backward compatibility). state = defaultdict(dict) for k, v in state_dict['state'].items(): if k in id_map: param = id_map[k] state[param] = cast(param, v) else: state[k] = v # Update parameter groups, setting their 'params' value def update_group(group, new_group): ... param_groups = [ update_group(g, ng) for g, ng in zip(groups, saved_groups)] self.__setstate__({'state': state, 'param_groups': param_groups})File "", line 30 ..... ^ TabError: inconsistent use of tabs and spaces in indentation

state_dict():获取优化器当前状态信息字典

In [80]:

def state_dict(self): r"""Returns the state of the optimizer as a :class:`dict`. It contains two entries: * state - a dict holding current optimization state. Its content differs between optimizer classes. * param_groups - a dict containing all parameter groups """ # Save order indices instead of Tensors param_mappings = {} start_index = 0 def pack_group(group): ...... param_groups = [pack_group(g) for g in self.param_groups] # Remap state to use order indices as keys packed_state = {(param_mappings[id(k)] if isinstance(k, torch.Tensor) else k): v for k, v in self.state.items()} return { 'state': packed_state, 'param_groups': param_groups, }File "", line 15 ...... ^ TabError: inconsistent use of tabs and spaces in indentation

3.9.3 实际操作

In [82]:

import os import torch # 设置权重,服从正态分布 --> 2 x 2 weight = torch.randn((2, 2), requires_grad=True) # 设置梯度为全1矩阵 --> 2 x 2 weight.grad = torch.ones((2, 2)) # 输出现有的weight和data print("The data of weight before step:\n{}".format(weight.data)) print("The grad of weight before step:\n{}".format(weight.grad)) # 实例化优化器 optimizer = torch.optim.SGD([weight], lr=0.1, momentum=0.9) # 进行一步操作 optimizer.step() # 查看进行一步后的值,梯度 print("The data of weight after step:\n{}".format(weight.data)) print("The grad of weight after step:\n{}".format(weight.grad)) # 权重清零 optimizer.zero_grad() # 检验权重是否为0 print("The grad of weight after optimizer.zero_grad():\n{}".format(weight.grad)) # 输出参数 print("optimizer.params_group is \n{}".format(optimizer.param_groups)) # 查看参数位置,optimizer和weight的位置一样,我觉得这里可以参考Python是基于值管理 print("weight in optimizer:{}\nweight in weight:{}\n".format(id(optimizer.param_groups[0]['params'][0]), id(weight))) # 添加参数:weight2 weight2 = torch.randn((3, 3), requires_grad=True) optimizer.add_param_group({"params": weight2, 'lr': 0.0001, 'nesterov': True}) # 查看现有的参数 print("optimizer.param_groups is\n{}".format(optimizer.param_groups)) # 查看当前状态信息 opt_state_dict = optimizer.state_dict() print("state_dict before step:\n", opt_state_dict) # 进行5次step操作 for _ in range(50): optimizer.step() # 输出现有状态信息 print("state_dict after step:\n", optimizer.state_dict()) # 保存参数信息 torch.save(optimizer.state_dict(),os.path.join(r"G:\pythonProject\Attention_Unet", "optimizer_state_dict.pkl")) print("----------done-----------") # 加载参数信息 state_dict = torch.load(r"G:\pythonProject\Attention_Unet\optimizer_state_dict.pkl") # 需要修改为你自己的路径 optimizer.load_state_dict(state_dict) print("load state_dict successfully\n{}".format(state_dict)) # 输出最后属性信息 print("\n{}".format(optimizer.defaults)) print("\n{}".format(optimizer.state)) print("\n{}".format(optimizer.param_groups))The data of weight before step: tensor([[ 1.9347, -0.0059], [ 2.1897, -0.0895]]) The grad of weight before step: tensor([[1., 1.], [1., 1.]]) The data of weight after step: tensor([[ 1.8347, -0.1059], [ 2.0897, -0.1895]]) The grad of weight after step: tensor([[1., 1.], [1., 1.]]) The grad of weight after optimizer.zero_grad(): tensor([[0., 0.], [0., 0.]]) optimizer.params_group is [{'params': [tensor([[ 1.8347, -0.1059], [ 2.0897, -0.1895]], requires_grad=True)], 'lr': 0.1, 'momentum': 0.9, 'dampening': 0, 'weight_decay': 0, 'nesterov': False, 'maximize': False}] weight in optimizer:2183297274408 weight in weight:2183297274408 optimizer.param_groups is [{'params': [tensor([[ 1.8347, -0.1059], [ 2.0897, -0.1895]], requires_grad=True)], 'lr': 0.1, 'momentum': 0.9, 'dampening': 0, 'weight_decay': 0, 'nesterov': False, 'maximize': False}, {'params': [tensor([[ 0.4069, -2.2681, -1.2533], [ 2.8215, -0.6699, 1.1245], [ 1.9582, 2.2112, 0.9747]], requires_grad=True)], 'lr': 0.0001, 'nesterov': True, 'momentum': 0.9, 'dampening': 0, 'weight_decay': 0, 'maximize': False}] state_dict before step: {'state': {0: {'momentum_buffer': tensor([[1., 1.], [1., 1.]])}}, 'param_groups': [{'lr': 0.1, 'momentum': 0.9, 'dampening': 0, 'weight_decay': 0, 'nesterov': False, 'maximize': False, 'params': [0]}, {'lr': 0.0001, 'nesterov': True, 'momentum': 0.9, 'dampening': 0, 'weight_decay': 0, 'maximize': False, 'params': [1]}]} state_dict after step: {'state': {0: {'momentum_buffer': tensor([[0.0052, 0.0052], [0.0052, 0.0052]])}}, 'param_groups': [{'lr': 0.1, 'momentum': 0.9, 'dampening': 0, 'weight_decay': 0, 'nesterov': False, 'maximize': False, 'params': [0]}, {'lr': 0.0001, 'nesterov': True, 'momentum': 0.9, 'dampening': 0, 'weight_decay': 0, 'maximize': False, 'params': [1]}]}

--------------------------------------------------------------------------- FileNotFoundError Traceback (most recent call last)in 38 print("state_dict after step:\n", optimizer.state_dict()) 39 # 保存参数信息 ---> 40 torch.save(optimizer.state_dict(),os.path.join(r"G:\pythonProject\Attention_Unet", "optimizer_state_dict.pkl")) 41 print("----------done-----------") 42 # 加载参数信息 G:\Anaconda\envs\env_name\lib\site-packages\torch\serialization.py in save(obj, f, pickle_module, pickle_protocol, _use_new_zipfile_serialization) 375 _check_dill_version(pickle_module) 376 --> 377 with _open_file_like(f, 'wb') as opened_file: 378 if _use_new_zipfile_serialization: 379 with _open_zipfile_writer(opened_file) as opened_zipfile: G:\Anaconda\envs\env_name\lib\site-packages\torch\serialization.py in _open_file_like(name_or_buffer, mode) 229 def _open_file_like(name_or_buffer, mode): 230 if _is_path(name_or_buffer): --> 231 return _open_file(name_or_buffer, mode) 232 else: 233 if 'w' in mode: G:\Anaconda\envs\env_name\lib\site-packages\torch\serialization.py in __init__(self, name, mode) 210 class _open_file(_opener): 211 def __init__(self, name, mode): --> 212 super(_open_file, self).__init__(open(name, mode)) 213 214 def __exit__(self, *args): FileNotFoundError: [Errno 2] No such file or directory: 'G:\\pythonProject\\Attention_Unet\\optimizer_state_dict.pkl'

注意:

每个优化器都是一个类,我们一定要进行实例化才能使用,比如下方实现

In [ ]:

class Net(nn.Moddule):

···

net = Net()

optim = torch.optim.SGD(net.parameters(),lr=lr)

optim.step()

optimizer在一个神经网络的epoch中需要实现下面两个步骤:

梯度置零 梯度更新

In [ ]:

optimizer = torch.optim.SGD(net.parameters(), lr=1e-5) for epoch in range(EPOCH): ... optimizer.zero_grad() #梯度置零 loss = ... #计算loss loss.backward() #BP反向传播 optimizer.step() #梯度更新

给网络不同的层赋予不同的优化器参数。

In [83]:

from torch import optim

from torchvision.models import resnet18

net = resnet18()

optimizer = optim.SGD([

{'params':net.fc.parameters()},#fc的lr使用默认的1e-5

{'params':net.layer4[0].conv1.parameters(),'lr':1e-2}],lr=1e-5)

# 可以使用param_groups查看属性

3.9.5 实验

为了更好的帮大家了解优化器,我们对PyTorch中的优化器进行了一个小测试

数据生成:

In [84]:

a = torch.linspace(-1, 1, 1000) # 升维操作 x = torch.unsqueeze(a, dim=1) y = x.pow(2) + 0.1 * torch.normal(torch.zeros(x.size()))

网络结构

In [85]:

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.hidden = nn.Linear(1, 20)

self.predict = nn.Linear(20, 1)

def forward(self, x):

x = self.hidden(x)

x = F.relu(x)

x = self.predict(x)

return x