计算机视觉项目实战-图像特征检测harris、sift、特征匹配

欢迎来到本博客

本次博客内容将继续讲解关于OpenCV的相关知识

作者简介:⭐️⭐️⭐️目前计算机研究生在读。主要研究方向是人工智能和群智能算法方向。目前熟悉python网页爬虫、机器学习、计算机视觉(OpenCV)、群智能算法。然后正在学习深度学习的相关内容。以后可能会涉及到网络安全相关领域,毕竟这是每一个学习计算机的梦想嘛!

目前更新:目前已经更新了关于网络爬虫的相关知识、机器学习的相关知识、目前正在更新计算机视觉-OpenCV的相关内容。本文摘要

本次博客我们介绍一下关于图像特征检测的全部过程

文章目录

- ⭐️项目前言

- ⭐️图像特征检测Harris原理

- ⭐️图像特征检测SIFT原理

- ⭐️图像特征匹配实战

⭐️项目前言

对于图像特征检测的应用场景有很多,比如目标检测、物体识别、三维重建、图像配准、图像理解。我们可以识别出来一些特定的关键点来让计算机认识图像的某些特征,该应用也应用于目前较为火热的人脸识别技术当中。后续我们我介绍一下有关于人脸识别的项目实战。这节课先跟着我,做一下这个图像特征如何检测的,它是基于什么原理。

⭐️图像特征检测Harris原理

- 角点:在图像的角度来看,无论是沿着水平方向还是竖直方向进行移动时候,灰度级会发生变化,而且这个变化是非常迅速的,我们称这个图像就是一个角点。

- 边界:在图像的角度上来看,指把图像按照水平或者垂直方向移动的时候,只有一个一个方向变化的比较明显,另一个方向变化就比较微弱,这样的我们就称之为边界。

- 平面:平面就是说无论向垂直方向还是水平方向移动,图像的灰度值都不会发生迅速的变化,这个就是平面。

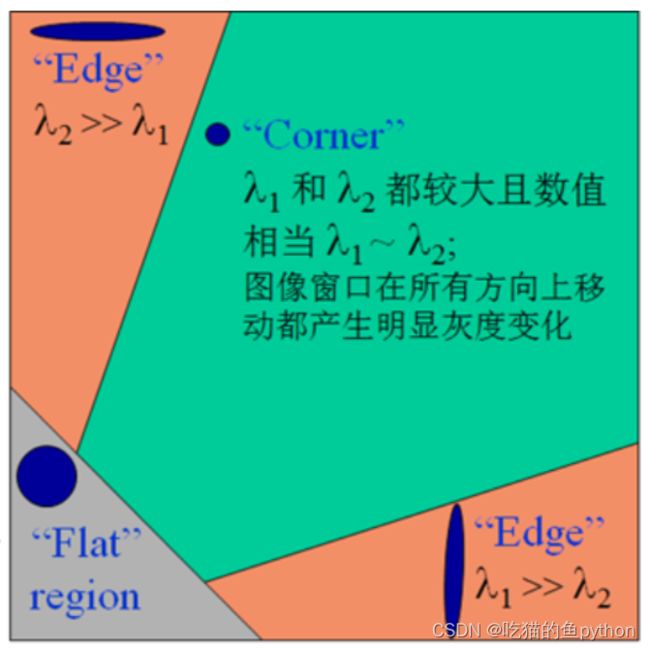

原理图,这里第一个图表示的就是平面灰度值没有明显变化,第二个图就是要给边界灰度值水平方向变化明显垂直方向灰度值变化并不明显,第三个图表示的就是一个角点,无论水平还是垂直方向都很明显。主要看灰度级的变化结果:

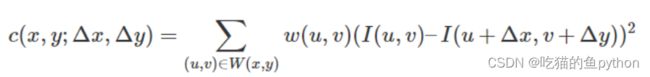

对于图像l(x,y),当在点(x,y)处平移(▲x,▲y)后的图像灰度级的相似性是:

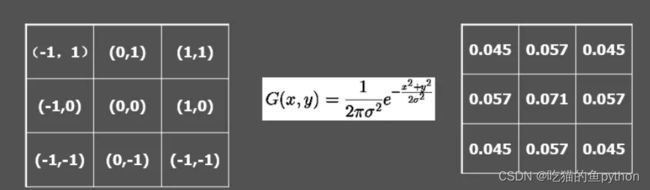

这里就是w(u,v)表示权重矩阵,而I就表示图像的灰度级后面表示图像灰度值的差值,变化程度。假设图像l(x,y)为3*3,那么就有9个像素点x1-x9,当移动之后,那么我们就得到了一个新的像素点集合z1-z9,我们要对其进行一个像素值的减法操作。其中W(u,v)表示权重矩阵项,他是一个以(x,y)为中心的一个窗口,可以是常数也可以是高斯加权函数。

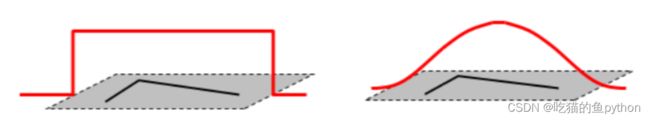

第一个图就是使用常数的一个窗口,没有什么变化,对于3*3的九个点都平等对待。但是对于高斯加权函数来说,他是一个越靠近中心点的权重就越大的一个函数。就类似于这样。

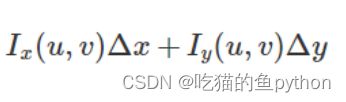

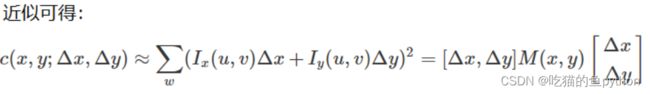

而我们一般都使用高斯加权函数。当▲x,▲y变化的都相对较小的时候,我们将图像平移由(x,y)移动(▲x,▲y)后进行一个一阶近似,泰勒展开公式:

![]()

这里我们使用泰勒公式展开之后呢?就把(▲x,▲y)的变化认为很小很小,就给直接省略了。其中Ix和Iy就是对于x,y的偏导数。

这里我们主要看这里,因为前面是一个不变的数值,所以我们将这里做一个平方,防止像素值相减后负值对结果的影响。

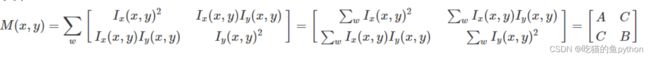

这里M(x,y)就是,当我们求出来这个M矩阵,那么对于他是怎么变化的是不是就清楚了:

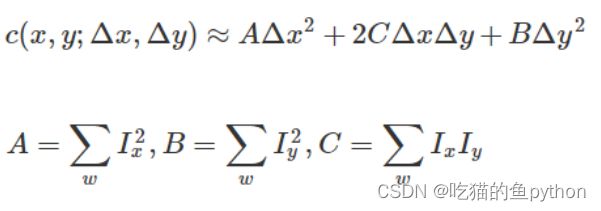

化简一下代回原式子就是:

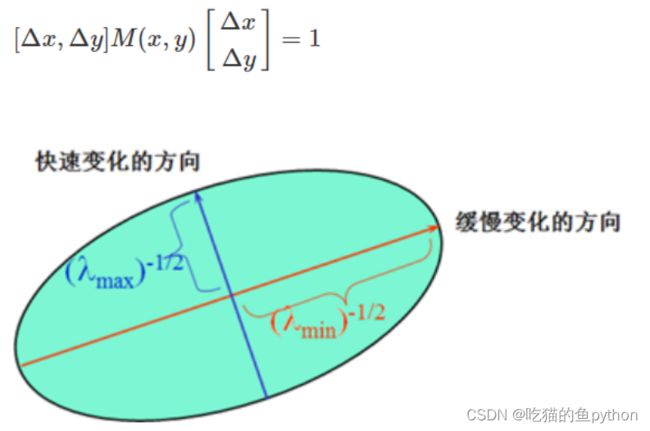

这里我们根据自己学习过的线性代数知识,对其进行对角化,可以得到lamda1=1/a2,lamda2=1/b2:肯定会得到两个特征值,特征向量。

这里我们就可以把角点表示成这样,就是lamda的两个值变化的都快,那么他就是角点。一个变化较快一个比较慢,那么就是边界,如果都比较缓慢,那么就是一个平面。

边界:一个特征值大,一个特征值小,自相关函数在某一个方向上大,在其他方向上小。

平面:两个特征都小,且近似相等。

角点:两个特征都大,且近似相等,自相关函数在所有方向都大。

在OpenCV当中我们使用,cv2.cornerHarris()来进行角点检测。

其中参数都有:

- img: 数据类型为 float32 的入图像

- blockSize: 角点检测中指定区域的大小

- ksize: Sobel求导中使用的窗口大小

- k: 取值参数为 [0,04,0.06]

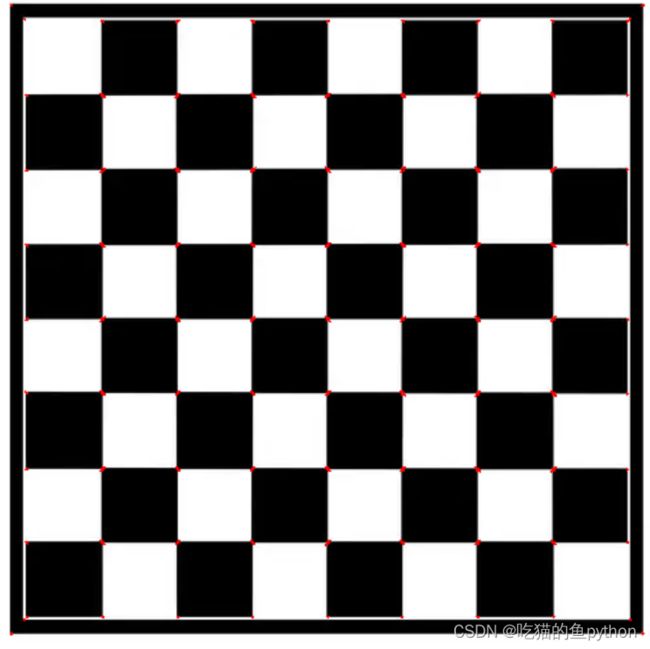

我们使用几个小图像去做一下角点检测:

import cv2

import numpy as np

img = cv2.imread('white-black.webp')

print ('img.shape:',img.shape)

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

# gray = np.float32(gray)

dst = cv2.cornerHarris(gray, 2, 3, 0.04)

print ('dst.shape:',dst.shape)

img[dst>0.01*dst.max()]=[0,0,255]

cv2.imshow('dst',img)

cv2.waitKey(0)

cv2.destroyAllWindows()

这里有一些点检测的不是特别好,然后我们用黑白棋盘来看一下。

这个效果堪称完美!!!

⭐️图像特征检测SIFT原理

SIFT是指尺度空间:是指在一定的范围内,无论物体是大是小,人眼都可以进行一个识别,然后计算机要去识别却很难,所以要让计算机能够对物体进行一个在不同尺度下都存在一个统一的认知,就要考虑图像在不同的尺度在都存在的特点,尺度空间的获取一般使用高斯模糊来实现-高斯滤波。

我们再说说SIFT有什么优点:

1、具有较好的稳定性和不变性,能够适应旋转、尺度缩放、亮度的变化,能在一定程度上不受视角变化、仿射变换、噪声的干扰。

2、区分性好,能够在海量特征数据库中进行快速准确的区分信息进行匹配

3、多量性,就算只有单个物体,也能产生大量特征向量

4、高速性,能够快速的进行特征向量匹配

5、可扩展性,能够与其它形式的特征向量进行联合

我们都知道如果图片经过高斯滤波操作之后呢,他会变模糊,那么为什么要这么做呢?因为当我们从很近的看一个人的时候,他是清晰的,那么从很远看的时候他就是模糊的。所以我们为了模拟这个过程,就用高斯滤波来进行相同了一个模拟。

不同σ的高斯函数决定了对图像的平滑程度,越大的σ值对应的图像越模糊。

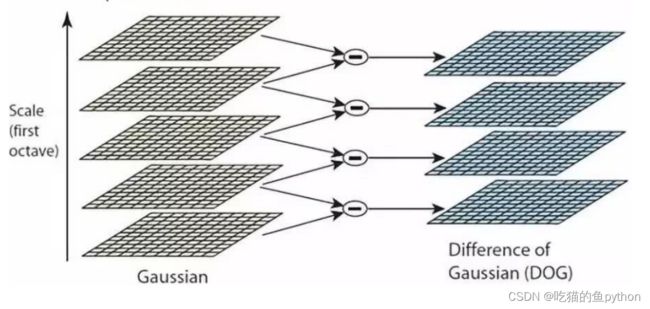

因此我们要介绍一个金字塔,高斯差分金字塔。

我们需要做一个多分辨率的金字塔,对于金字塔的每一层都要做高斯滤波。

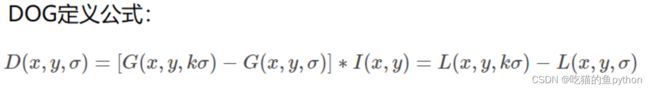

根据意思就是5个输入的高斯图像,相邻的进行像素值相减,得到4张差分后的结果。那么我们想要找什么呢?找SIFT,就是特征点,那么什么样的点被认为是特征点呢?通常关键点数值较大、差分结果较大的、极值里面较大的。是不是有点像之前讲的图像金字塔。

为了寻找尺度空间的极值点,每个像素点要和其图像域(同一尺度空间)和尺度域(相邻的尺度空间)的所有相邻点进行比较,当其大于(或者小于)所有相邻点时,该点就是极值点。如下图所示,中间的检测点要和其所在图像的3×3邻域8个像素点,以及其相邻的上下两层的3×3领域18个像素点,共26个像素点进行比较。因为这个极值点需要上下都有图片板子,所以最上面的和最下面的无法生成DOG。

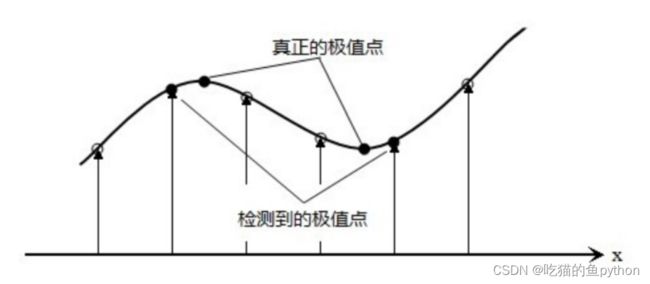

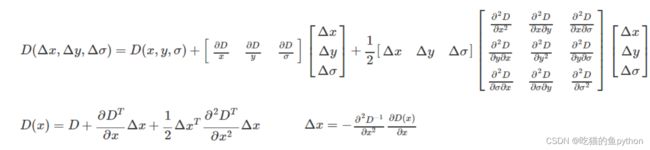

这些候选关键点是DOG空间的局部极值点,而且这些极值点均为离散的点,精确定位极值点的一种方法是,对尺度空间DoG函数进行曲线拟合,计算其极值点,从而实现关键点的精确定位。

然后我们对其进行曲线拟合。对于二维空间来说拟合公式就是这样

那么如果上升到三维空间来说,就是这样的公式;

这里我们就可以求到真正的极值点。

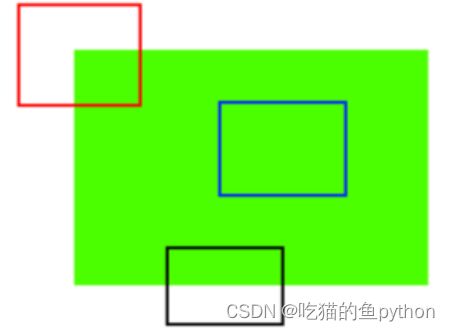

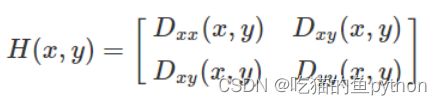

对于一些特征点,我们还要进行一个过滤,比如说我们要消除边界响应。

Hessian矩阵:

我们在讲harris的时候,已经介绍过了得到的检测角点,边界的矩阵就差不多是这个。

然后我们对其进行了对角化,a=lmax表示最大的特征值,b=lmin为最小的特征值。

如果有a/b>10,我们就认定为这个点很接近边界了。此时我们要将对于主曲率比值大于10的特征点进行删除。

进行了如上的操作之后,我们就得到了最后想要的关键点。我们还要找一个特征点的方向,因为我们当验证两个图象是否相似的时候,不仅仅要从数值上下手,还要从方向上才会更加准确。

每个特征点可以得到三个信息(x,y,σ,θ),即位置、尺度和方向。具有多个方向的关键点可以被复制成多份,然后将方向值分别赋给复制后的特征点,一个特征点就产生了多个坐标、尺度相等,但是方向不同的特征点。

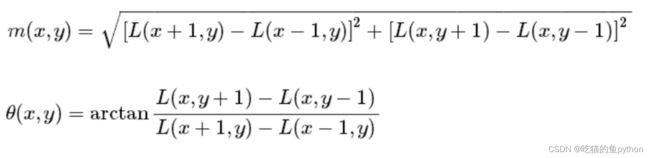

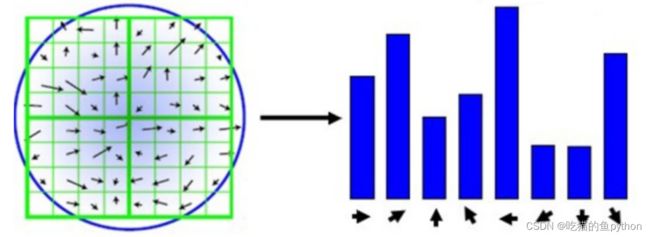

在完成关键点的梯度计算后,使用直方图统计邻域内像素的梯度和方向。

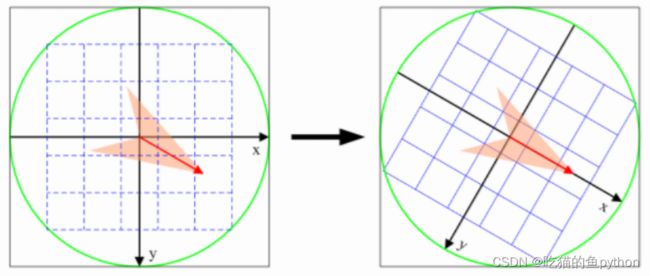

为了保证特征矢量的旋转不变性,要以特征点为中心,在附近邻域内将坐标轴旋转θ角度,即将坐标轴旋转为特征点的主方向。

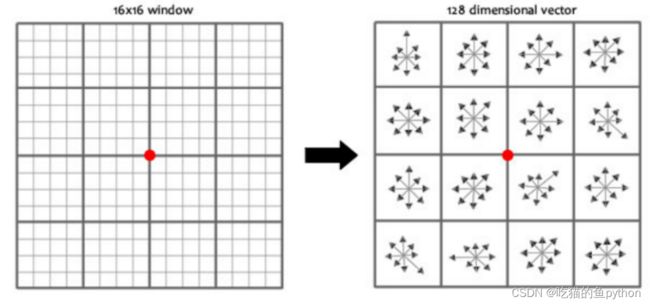

旋转之后的主方向为中心取8x8的窗口,求每个像素的梯度幅值和方向,箭头方向代表梯度方向,长度代表梯度幅值,然后利用高斯窗口对其进行加权运算,最后在每个4x4的小块上绘制8个方向的梯度直方图,计算每个梯度方向的累加值,即可形成一个种子点,即每个特征的由4个种子点组成,每个种子点有8个方向的向量信息。

论文中建议对每个关键点使用4x4共16个种子点来描述,这样一个关键点就会产生128维的SIFT特征向量。

import cv2

import numpy as np

img = cv2.imread('test_1.jpg')

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

cv2.__version__

sift = cv2.SIFT_create()

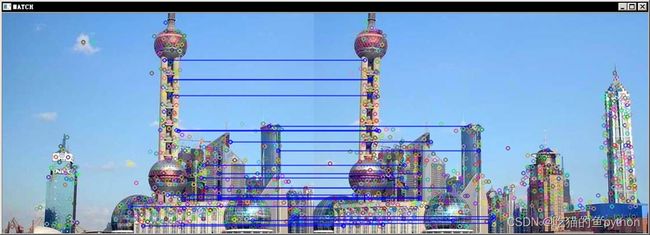

kp = sift.detect(gray, None)

img = cv2.drawKeypoints(gray, kp, img)

cv2.imshow('drawKeypoints', img)

cv2.waitKey(0)

cv2.destroyAllWindows()

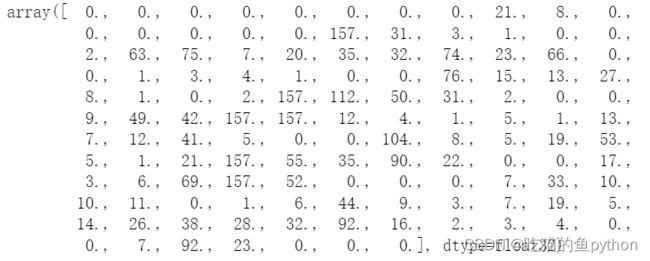

kp, des = sift.compute(gray, kp)

print (np.array(kp).shape)

des.shape

des[0]

导入图像,然后进行颜色空间转换。并看一下cv2的版本。然后求了一下sift,最后展示了一下特征第一个。

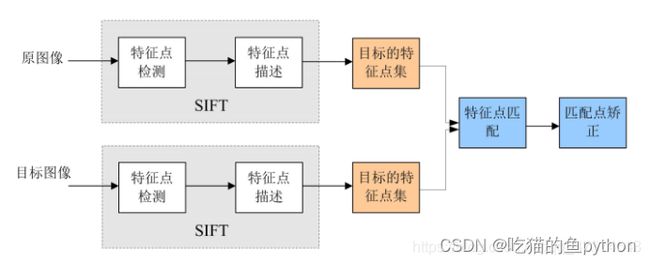

⭐️图像特征匹配实战

import cv2

import numpy as np

import matplotlib.pyplot as plt

%matplotlib inline

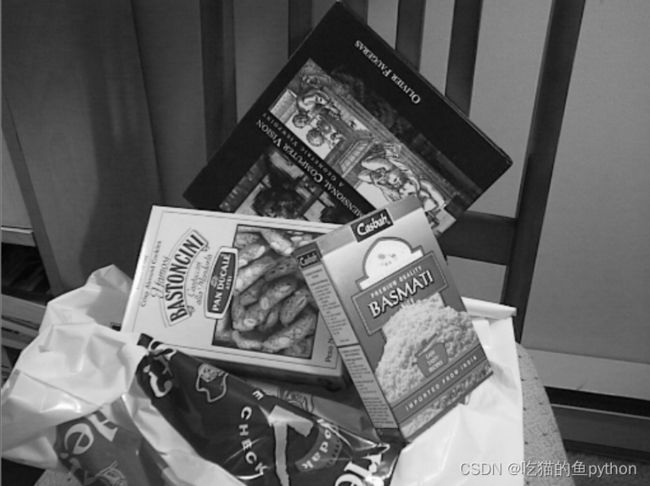

img1 = cv2.imread('box.png', 0)

img2 = cv2.imread('box_in_scene.png', 0)

def cv_show(name,img):

cv2.imshow(name, img)

cv2.waitKey(0)

cv2.destroyAllWindows()

cv_show('img1',img1)

cv_show('img2',img2)

sift = cv2.SIFT_create()

kp1, des1 = sift.detectAndCompute(img1, None)

kp2, des2 = sift.detectAndCompute(img2, None)

bf = cv2.BFMatcher(crossCheck=True)

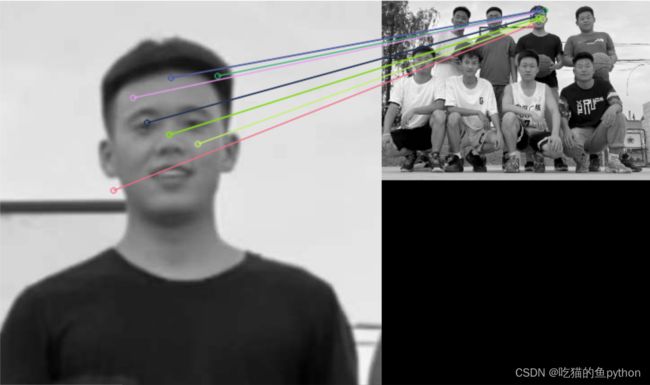

首先我们导入一个具体图像和一个整体图像,用于做特征匹配。原理就是使用sift分别识别处关键点,然后对关键点进行一个匹配。我们具体看一下实战结果。kp1, des1 = sift.detectAndCompute(img1, None)这里我们得到关键点和向量信息,得到特征向量。然后使用特征向量进行匹配。bf = cv2.BFMatcher(crossCheck=True)crossCheck表示两个特征点要互相匹,例如A中的第i个特征点与B中的第j个特征点最近的,并且B中的第j个特征点到A中的第i个特征点也是

NORM_L2: 归一化数组的(欧几里德距离),如果其他特征计算方法需要考虑不同的匹配计算方式。

matches = bf.match(des1, des2)

matches = sorted(matches, key=lambda x: x.distance)

对关键点进行一一匹配。一对一匹配。

img3 = cv2.drawMatches(img1, kp1, img2, kp2, matches[:10], None,flags=2)

cv_show('img3',img3)

然后一对多进行匹配。

bf = cv2.BFMatcher()

matches = bf.knnMatch(des1, des2, k=2)

good = []

for m, n in matches:

if m.distance < 0.75 * n.distance:

good.append([m])

img3 = cv2.drawMatchesKnn(img1,kp1,img2,kp2,good,None,flags=2)

cv_show('img3',img3)

一个点对应最近的两个点。

然后我们又做了一个图像的特征匹配。一对一的。

然后我们做了我的特征匹配。

最终的结果是:

多匹配的结果是

检测的非常完美!!!这里我们就把这个图像特征匹配讲解完了。让计算机去识别物体,人脸,所有的图像!!!

支持:如果觉得博主的文章还不错或者您用得到的话,可以免费的关注一下博主,如果三连收藏支持就更好啦!这就是给予我最大的支持!