CVPR2020/UDA/图像翻译-Cross-domain Correspondence Learning for Exemplar-based Image Translation基于范例的跨域对应

Cross-domain Correspondence Learning for Exemplar-based Image Translation基于范例的跨域对应学习的图像翻译

- 0.摘要

- 1.概述

- 2.相关工作

-

- 2.1.图像到图像的翻译

- 2.2.基于范例的图像合成

- 2.3.语义关联性

- 3.方法

-

- 3.1. 跨域通信网络

-

- 3.1.1.领域对齐

- 3.1.2.共享域内的对应

- 3.2.翻译网络

- 3.3.基于范例的翻译的损失

-

- 3.3.1.伪范例对的损失

- 3.3.2.领域对齐损失

- 3.3.3.翻译范例损失

- 3.3.4.对应正则化

- 3.3.5.对抗损失

- 3.3.6.总损失

- 4.实验

- 6.结论

- 参考文献

论文地址

代码地址

0.摘要

我们提出了一个基于范例的图像翻译的通用框架,该框架从给定范例图像的不同域(例如,语义分割掩码、边缘映射或姿势关键点)中的输入合成照片真实感图像。输出的样式(例如颜色、纹理)与示例中语义上对应的对象一致。我们建议共同学习跨域对应和图像翻译,这两项任务相互促进,因此可以在较弱的监督下学习。来自不同区域的图像首先与中间区域对齐,在中间区域建立密集的对应关系。然后,网络根据样本中语义对应的补丁的出现来合成图像。我们在几个图像翻译任务中展示了我们的方法的有效性。我们的方法在图像质量方面明显优于最先进的方法,图像风格忠实于样本,语义一致。此外,我们还展示了我们的方法在几个应用中的实用性

1.概述

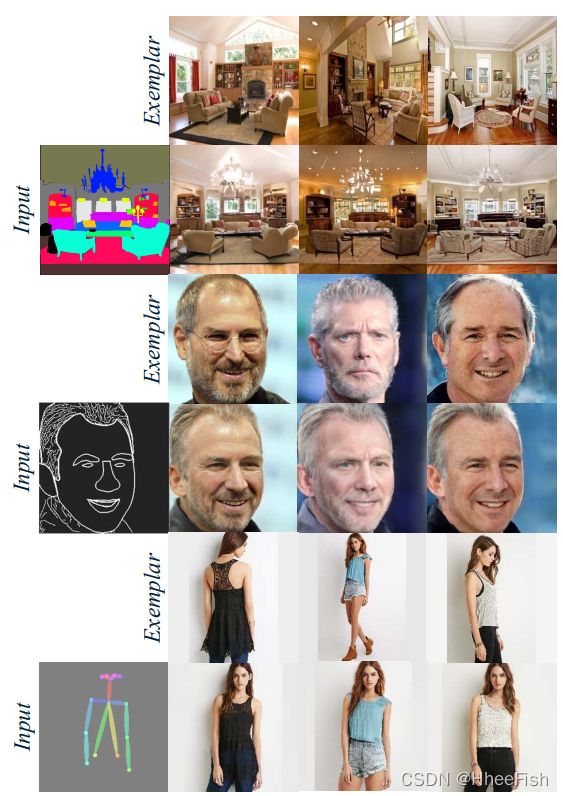

条件图像合成的目的是根据一定的输入数据生成逼真的图像[18,45,52,6]。我们感兴趣的是一种特定形式的条件图像合成,它将语义分割蒙版、边缘映射和关键点转换为真实感图像,给出一个示例图像,如图1所示。我们将这种形式称为基于范例的图像平移。它允许根据用户给出的范例对多模态生成进行更灵活的控制。

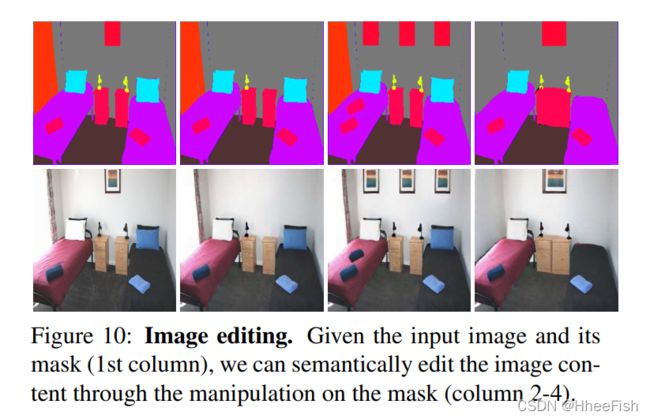

图1:基于范例的图像合成。给定样本图像(第一行),我们的网络以分割蒙版、边缘和姿态的形式将输入转换为逼真的图像(第二行)。更多结果请参考补充材料。

最近的方法使用神经网络直接学习从语义分割蒙版到范例图像的映射[17,38,34,44]。这些方法中的大多数都将范例的样式编码成一个潜在的样式向量,网络从中合成具有与范例相似的所需样式的图像。然而,样式代码只描述了范例的全局样式,而忽略了空间性相关的信息。因此,它导致了一些局部风格在最终的图像中被“洗去”。

为了解决这个问题,必须在图像转换之前建立输入和范例之间的跨域对应关系。作为图像类比[14]的扩展,深度类比[27]试图在图像对之间找到密集的语义对应关系。它利用在真实图像分类任务中预先训练的VGG的深层特征进行匹配。我们认为,这种表示可能无法处理从掩模(或边缘、关键点)到照片的更具挑战性的映射,因为预先训练的网络无法识别这些图像。为了在训练中考虑蒙版(或边缘),一些方法[10,46,5]明确地将范例图像分割为语义区域,并学习分别合成不同的部分。通过这种方式,它成功地产生了高质量的结果。然而,这些方法都是任务特定的,不适合一般翻译。

如何为基于范例的图像平移找到一个更普遍的解决方案是不平凡的。我们的目标是学习跨域图像(如mask-to-image、edge-to-image、key - point -to-image等)的密集语义对应,然后利用它来指导图像的翻译。这是一种弱监督学习,因为我们既没有对应的注解,也没有随机范例给出的综合基础真理。

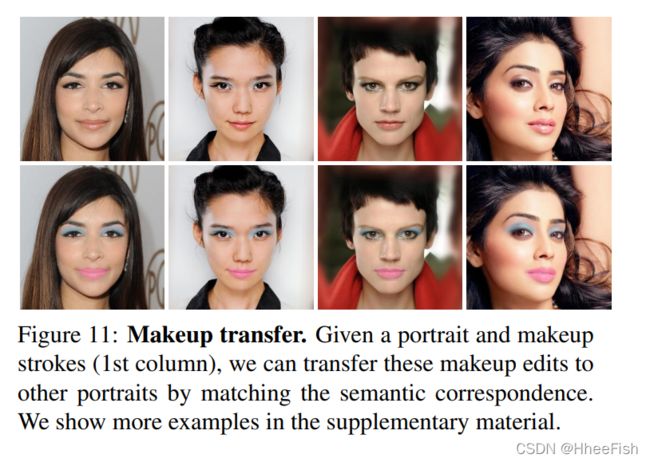

在本文中,我们提出了一个跨域通信网络(CoCosNet),它可以同时学习跨域通信和图像翻译。该网络结构包括两个子网络:1)跨域对应网络将不同域的输入转换为中间特征域,从而建立可靠的密集对应;2)翻译网络,使用一组空间变异的去规范化块[38]逐步合成输出,使用来自一个扭曲的范例的样式细节,根据估计的对应关系语义上对齐到蒙版(或边缘,关键点地图)。两个子网络相互促进,用新颖的损耗函数端到端学习。我们的方法在图像质量方面比以前的方法有很大的优势,实例级外观忠实于范例。此外,隐式学习的跨域通信可以实现一些有趣的应用,如图像编辑和化妆转移。我们的贡献可以总结如下:

- 我们解决了图像平移弱监督联合学习的密集跨域对应问题。

- 通过跨域对应,我们提出了一个基于范例的图像平移的通用解决方案,该方案首次在实例级输出与范例的精细结构相似的图像。

- 我们的方法在图像质量方面优于最先进的方法,在各种应用任务中有很大的优势。

2.相关工作

2.1.图像到图像的翻译

图像平移的目标是学习不同图像域之间的映射关系。当代最著名的方法是通过条件生成对抗网络[36]来解决这个问题,该网络利用成对数据[18,45,38]或非成对数据[52,47,22,29,42]。由于从一个图像域到另一个图像域的映射本质上是多模态的,接下来的工作通过从潜在空间进行随机采样来提高合成的多样性[53,17,24]。然而,这些方法都不允许对输出进行精细的控制,因为潜在的表示相当复杂,并且与图像风格没有明确的对应关系。相比之下,我们的方法支持根据用户给出的范例定制结果,这允许更灵活地控制多模态生成。

2.2.基于范例的图像合成

近年来,一些作品[39,44,34,40,2]提出了在范例的指导下,从语义布局合成真实感图像。非参数或半参数方法[39,2]通过合成从大型数据库中检索到的图像片段来合成图像。然而,主流作品将这个问题表述为图像到图像的翻译。Huang et al. [17] and Ma et al.[34]提出采用自适应实例归一化(AdaIN)[16]将样式代码从范例转移到源图像中。Park等人的[38]学习了一种编码器,将范例图像映射为一个向量,图像将由此进一步合成。在[44]中提出了风格一致性鉴别器来检测图像对是否表现出相似的风格。但该方法需要从视频片段中构建风格一致的图像对,不适合一般的图像平移。与上面所有只传递全局样式的方法不同,我们的方法从语义上对应的范例区域传递精细样式。我们的工作受到了最近基于范例的图像着色的启发[48,13],但我们解决了一个更普遍的问题:在不同的域之间转换图像。

2.3.语义关联性

早期关于语义对应的研究[33,8,43]主要关注手工特征的匹配。随着卷积神经网络的出现,深度特征被证明是表达高级语义的有力工具。Long et al.[32]首先提出通过匹配从预先训练的分类模型中提取的深度特征来建立语义对应。接下来的研究通过加入额外的标注[51,7,11,12,21,25],采用由粗到细的策略[27]或保留可靠的稀疏匹配[1],进一步提高了对应质量。然而,这些方法都只能处理自然图像之间的对应关系,而不能处理跨域图像,如边缘图像和真实感图像。我们探索这个新的场景,并在弱监督的情况下隐式学习任务。

3.方法

我们的目标是学习翻译从源域A到目标域B给定一个输入图像xA∈A范例图像和yB∈B .生成的输出需要符合xA的语义内容,而类似的风格内容与yB相似。为此,首先建立xA和yB之间的对应关系,它们位于不同的领域,并相应地对示例图像进行扭曲,使其语义与xA一致(章节3.1)。然后,根据扭曲的范例(第3.2节)合成一幅图像。整个网络结构如图2所示,以掩码进行图像合成为例。

图2:CoCosNet架构的图示。给定输入xA∈ A和范例yB∈ B、 对应子模块将它们调整到同一个域中,在该域中可以建立密集的对应关系。然后,翻译网络根据扭曲的样本生成最终输出→x,产生基于范例的翻译输出

3.1. 跨域通信网络

通常,语义对应是通过将特征域中的补丁[27,25]与预先训练的分类模型进行匹配来发现的。然而,预先训练的模型通常针对特定类型的图像(例如自然图像)进行训练,因此提取的特征不能概括为描述另一个领域的语义。因此,以前的工作无法建立异质图像之间的对应关系,例如边缘图像和照片真实感图像。为了解决这个问题,我们提出了一种新的跨域通信网络,将输入域映射到共享域,在共享域中,表示能够表示两个输入域的语义。因此,可以在域S中找到可靠的语义对应。

3.1.1.领域对齐

如图2所示,我们首先将输入图像和示例适配到共享域S。具体而言,xA和yB被送入特征金字塔网络,该网络通过利用局部和全局图像上下文来提取多尺度深度特征[41,28]。提取的特征映射进一步转换为S中的表示,用xS表示∈ RHW×C和yS∈ RHW×C(H,W为特征空间尺寸;C为通道方向尺寸)。FA→S和FB→S分别是两个输入域的域变换,因此自适应表示可以表示为,:

其中θ表示可学习参数。xS和yS包含区分性特征,这些特征描述了输入的语义。在实践中,域对齐对于对应来说至关重要,因为只有当xS和yS位于同一个域中时,它们才能进一步匹配某种相似性度量。

3.1.2.共享域内的对应

我们建议将xS和yS的特征与[48]中提出的对应层相匹配。具体来说,我们计算一个相关矩阵M∈ RHW×HW,其中每个元素都是成对的特征相关性,

这里是x∧S(u)和y∧S(v)∈ RC表示在位置u和v处的xS和yS的信道集中特性,即x∧S(u)=xS(u)− 平均值(xS(u))和y∧S(v)=yS(v)− 平均值(yS(v))。M(u,v)表示xS(u)和yS(v)之间有更高的语义相似性 .

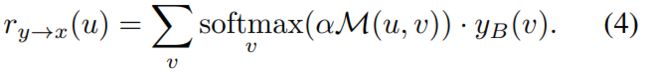

现在的挑战是如何在没有直接监督的情况下学习对应。我们的想法是与图像翻译共同训练。翻译网络可能会发现,仅通过引用样本中正确的对应区域,更容易生成高质量的输出,这隐含地推动网络学习准确的对应。有鉴于此,我们根据M对yB进行了扭曲,得到了扭曲的例子ry→x∈ RHW。具体来说,我们通过选择yB中最相关的像素并计算其加权平均值获得了ry→x

这里,α是控制softmax清晰度的系数,我们将其默认值设置为100。在接下来的过程中,图像将以ry→x为条件进行合成,对应网络在间接监督下学习其任务。

3.2.翻译网络

在ry→x的指导下,翻译网络G将常量代码z转换为所需的输出x∧B∈ B。为了保持ry→x变化的结构信息,我们使用空间自适应非规范化(SPADE)块[38]将空间变化的样本样式投射到不同的激活位置。如图2所示,翻译网络有L层,范例样式逐步注入。相对于[38]为批量归一化(BN)计算分层统计量,我们经验地发现,计算每个空间位置统计信息的标准化,即位置标准化(PN)[26],能更好地保留先前各层中合成的结构信息。因此,我们建议结合位置规范化和空间变异非规范化,从样本中进行高保真纹理传输 。

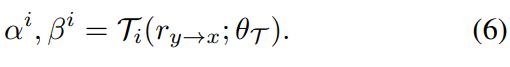

形式上,给定激活Fi∈RCi×Hi×Wi在第i个规范化层之前,我们通过下式注入范例风格:

其中统计值µih,w和σih,w只在通道方向上计算,与BN相比。反正态化参数αi和βi表征了由θT参数化的投影T从ry→x映射到样本的样式。

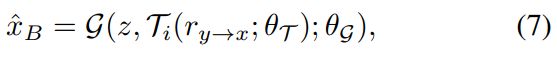

我们使用两个普通卷积层来实现T,因此α和β具有与ry→x相同的空间大小。通过每个归一化层的样式调制,整体图像转换可以表示为:

其中θG为可学参数。

3.3.基于范例的翻译的损失

我们用以下的损失函数联合训练跨域对应和图像合成,希望这两个任务能互相受益。

3.3.1.伪范例对的损失

我们利用成对的数据{xA, xB}构建范例训练对,这些数据在语义上是一致的,但在域上是不同的。具体来说,我们对xB应用随机几何畸变,得到畸变图像xˋB = h(xB),其中h表示图像扭曲或随机翻转等增广操作。当xˋB被视为范例时,xA的翻译应该是对应的xB。通过这种方法,我们得到了伪范例对。我们建议通过最小化特征匹配损失来惩罚翻译输出和地面真值xB之间的差异[19,18,6]

式中,φl代表预训练VGG-19模型中l层的激活,λl平衡各项。

3.3.2.领域对齐损失

我们需要确保转换后的嵌入xS和yS位于同一个域中。为了实现这一点,我们再次利用图像对{xA,xB},其特征嵌入应在域转换后精确对齐:

请注意,我们将通道规格化作为FA→S的最后一层和FB→S因此,最小化这个域差异不会导致一个微不足道的解决方案(即,小幅度的激活)。

3.3.3.翻译范例损失

当样本的语义布局与源图像有显著差异时,使用成对或伪样本对进行学习很难推广到一般情况下。为了解决这个问题,我们提出以下损失。

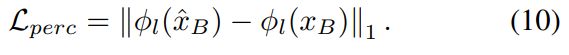

首先,最终输出应该与输入xA或对应的xB的语义一致。因此,我们惩罚知觉损失,以最小化语义差异:.

这里我们选择φl作为VGG-19网络中relu4 2层后的激活,因为这一层主要包含高级语义。

另一方面,我们需要一个损失函数来鼓励x∧B采用来自yB的语义对应补丁的外观。为此,我们使用[35]中提出的上下文损失来匹配x∧B和yB之间的统计数据,即

其中,i和j索引的是包含nl特征的第φl层的特征图,ωl控制不同层的相对重要性。尽管如此,我们还是依赖于经过预训练的VGG特性。与主要利用高级特征的Lperc相反,上下文丢失使用relu2.2到relu5.2层,因为低级特征捕获更丰富的样式信息(例如颜色或纹理),这些信息对于传递示例外观非常有用。

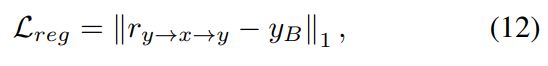

3.3.4.对应正则化

此外,学习到的对应应该是循环一致的,即图像在前后扭曲后应该匹配自身:

其中ry→x→y(v) = ∑u softmaxu(αM(u, v))·ry→x(u)是前后扭曲的图像。事实上,这个目标函数是至关重要的,因为施加在网络末端的剩余损失函数是弱监督,不能保证网络学习有意义的对应。从图9可以看出,如果没有Lreg,网络虽然可以生成似是而非的翻译结果,但却不能正确学习跨域对应关系。正则化Lreg通过约束反向扭曲的图像ry→x,使其保持在域B中,这隐含地鼓励对应如所期望的那样有意义。

3.3.5.对抗损失

我们训练一个鉴别器[9]来鉴别域b的平移输出和真实样本。同时交替训练鉴别器D和平移网络G,直到合成的图像看起来与真实图像不可区分。D和G的对抗目标分别定义为:

其中h(t) = min(0 ,−1 + t)是用于正则化鉴别器的铰链函数[49,3]

3.3.6.总损失

4.实验

6.结论

在本文中,我们提出了CocosNet,它依靠跨域对应来翻译图像。我们的方法在定量和定性上都比领先的方法取得了更好的性能。此外,我们的方法学习了跨域图像的密集对应,为一些有趣的应用铺平了道路。我们的方法是计算密集型的,我们把高分辨率的合成留给未来的工作。

参考文献

[1] K. Aberman, J. Liao, M. Shi, D. Lischinski, B. Chen, and D. Cohen-Or, “Neural best-buddies: Sparse cross-domain correspondence,” ACM Transactions on Graphics (TOG), vol. 37, no. 4, p. 69, 2018. 2

[2] A. Bansal, Y . Sheikh, and D. Ramanan, “Shapes and context: In-the-wild image synthesis & manipulation,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 2317–2326. 2

[3] A. Brock, J. Donahue, and K. Simonyan, “Large scale GAN training for high fidelity natural image synthesis,” arXiv preprint arXiv:1809.11096, 2018. 5, 7

[4] Z. Cao, G. Hidalgo, T. Simon, S.-E. Wei, and Y . Sheikh, “Openpose: realtime multi-person 2d pose estimation using part affinity fields,” arXiv preprint arXiv:1812.08008, 2018. 5

[5] H. Chang, J. Lu, F. Y u, and A. Finkelstein, “Pairedcyclegan: Asymmetric style transfer for applying and removing makeup,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018, pp. 40–48. 2

[6] Q. Chen and V . Koltun, “Photographic image synthesis with cascaded refinement networks,” in Proceedings of the IEEE International Conference on Computer Vision, 2017, pp. 1511–1520. 1, 4

[7] C. B. Choy, J. Gwak, S. Savarese, and M. Chandraker, “Universal correspondence network,” in Advances in Neural Information Processing Systems, 2016, pp. 2414–2422. 2

[8] N. Dalal and B. Triggs, “Histograms of oriented gradients for human detection,” 2005. 2

[9] I. Goodfellow, J. Pouget-Abadie, M. Mirza, B. Xu, D. Warde-Farley, S. Ozair, A. Courville, and Y . Bengio, “Generative adversarial nets,” in Advances in neural information processing systems, 2014, pp. 2672–2680. 5

[10] S. Gu, J. Bao, H. Y ang, D. Chen, F. Wen, and L. Y uan, “Mask-guided portrait editing with conditional gans,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 3436–3445. 2

[11] B. Ham, M. Cho, C. Schmid, and J. Ponce, “Proposal flow: Semantic correspondences from object proposals,” IEEE transactions on pattern analysis and machine intelligence, vol. 40, no. 7, pp. 1711–1725, 2017. 2

[12] K. Han, R. S. Rezende, B. Ham, K.-Y . K. Wong, M. Cho, C. Schmid, and J. Ponce, “Scnet: Learning semantic correspondence,” in Proceedings of the IEEE International Conference on Computer Vision, 2017, pp. 1831–1840. 2

[13] M. He, D. Chen, J. Liao, P . V . Sander, and L. Y uan, “Deep exemplar-based colorization,” ACM Transactions on Graphics (TOG), vol. 37, no. 4, p. 47, 2018. 2

[14] A. Hertzmann, C. E. Jacobs, N. Oliver, B. Curless, and D. H. Salesin, “Image analogies,” in Proceedings of the 28th annual conference on Computer graphics and interactive techniques. ACM, 2001, pp. 327–340. 1

[15] M. Heusel, H. Ramsauer, T. Unterthiner, B. Nessler, and S. Hochreiter, “Gans trained by a two time-scale update rule converge to a local nash equilibrium,” in Advances in Neural Information Processing Systems, 2017, pp. 6626–6637. 5, 6

[16] X. Huang and S. Belongie, “Arbitrary style transfer in realtime with adaptive instance normalization,” in Proceedings of the IEEE International Conference on Computer Vision, 2017, pp. 1501–1510. 2

[17] X. Huang, M.-Y . Liu, S. Belongie, and J. Kautz, “Multimodal unsupervised image-to-image translation,” in Proceedings of the European Conference on Computer Vision (ECCV), 2018, pp. 172–189. 1, 2, 6

[18] P . Isola, J.-Y . Zhu, T. Zhou, and A. A. Efros, “Image-toimage translation with conditional adversarial networks,” in Proceedings of the IEEE conference on computer vision and pattern recognition, 2017, pp. 1125–1134. 1, 2, 4

[19] J. Johnson, A. Alahi, and L. Fei-Fei, “Perceptual losses for real-time style transfer and super-resolution,” in European conference on computer vision. Springer, 2016, pp. 694– 711. 4

[20] T. Karras, T. Aila, S. Laine, and J. Lehtinen, “Progressive growing of GANs for improved quality, stability, and variation,” arXiv preprint arXiv:1710.10196, 2017. 6

[21] S. Kim, D. Min, B. Ham, S. Jeon, S. Lin, and K. Sohn, “Fcss: Fully convolutional self-similarity for dense semantic correspondence,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017, pp. 6560–6569. 2

[22] T. Kim, M. Cha, H. Kim, J. K. Lee, and J. Kim, “Learning to discover cross-domain relations with generative adversarial networks,” in Proceedings of the 34th International Conference on Machine Learning-V olume 70. JMLR. org, 2017, pp. 1857–1865. 2

[23] D. P . Kingma and J. Ba, “Adam: A method for stochastic optimization,” arXiv preprint arXiv:1412.6980, 2014. 5

[24] H.-Y . Lee, H.-Y . Tseng, J.-B. Huang, M. Singh, and M.-H. Y ang, “Diverse image-to-image translation via disentangled representations,” in Proceedings of the European Conference on Computer Vision (ECCV), 2018, pp. 35–51. 2

[25] J. Lee, D. Kim, J. Ponce, and B. Ham, “Sfnet: Learning object-aware semantic correspondence,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 2278–2287. 2, 3

[26] B. Li, F. Wu, K. Q. Weinberger, and S. Belongie, “Positional Normalization,” arXiv e-prints, p. arXiv:1907.04312, Jul. 2019. 4

[27] J. Liao, Y . Y ao, L. Y uan, G. Hua, and S. B. Kang, “Visual attribute transfer through deep image analogy,” arXiv preprint arXiv:1705.01088, 2017. 1, 2, 3

[28] T.-Y . Lin, P . Dollár, R. Girshick, K. He, B. Hariharan, and S. Belongie, “Feature pyramid networks for object detection,” in Proceedings of the IEEE conference on computer vision and pattern recognition, 2017, pp. 2117–2125. 3

[29] M.-Y . Liu, T. Breuel, and J. Kautz, “Unsupervised image-toimage translation networks,” in Advances in neural information processing systems, 2017, pp. 700–708. 2

[30] Z. Liu, P . Luo, X. Wang, and X. Tang, “Deep learning face attributes in the wild,” in Proceedings of International Conference on Computer Vision (ICCV), Dec. 2015. 5

[31] Z. Liu, P . Luo, S. Qiu, X. Wang, and X. Tang, “Deepfashion: Powering robust clothes recognition and retrieval with rich annotations,” in Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Jun. 2016. 5

[32] J. L. Long, N. Zhang, and T. Darrell, “Do convnets learn correspondence?” in Advances in Neural Information Processing Systems, 2014, pp. 1601–1609. 2

[33] D. G. Lowe, “Distinctive image features from scale-invariant keypoints,” International journal of computer vision, vol. 60, no. 2, pp. 91–110, 2004. 2

[34] L. Ma, X. Jia, S. Georgoulis, T. Tuytelaars, and L. V an Gool, “Exemplar guided unsupervised image-to-image translation with semantic consistency,” ICLR, 2019. 1, 2, 6

[35] R. Mechrez, I. Talmi, and L. Zelnik-Manor, “The contextual loss for image transformation with non-aligned data,” in Proceedings of the European Conference on Computer Vision (ECCV), 2018, pp. 768–783. 4

[36] M. Mirza and S. Osindero, “Conditional generative adversarial nets,” arXiv preprint arXiv:1411.1784, 2014. 2

[37] T. Miyato, T. Kataoka, M. Koyama, and Y . Y oshida, “Spectral normalization for generative adversarial networks,” arXiv preprint arXiv:1802.05957, 2018. 5

[38] T. Park, M.-Y . Liu, T.-C. Wang, and J.-Y . Zhu, “Semantic image synthesis with spatially-adaptive normalization,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 2337–2346. 1, 2, 4, 6

[39] X. Qi, Q. Chen, J. Jia, and V . Koltun, “Semi-parametric image synthesis,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018, pp. 8808– 8816. 2, 5, 6

[40] M. Riviere, O. Teytaud, J. Rapin, Y . LeCun, and C. Couprie, “Inspirational adversarial image generation,” arXiv preprint arXiv:1906.11661, 2019. 2

[41] O. Ronneberger, P . Fischer, and T. Brox, “U-net: Convolutional networks for biomedical image segmentation,” in International Conference on Medical image computing and computer-assisted intervention. Springer, 2015, pp. 234– 241. 3

[42] A. Royer, K. Bousmalis, S. Gouws, F. Bertsch, I. Mosseri, F. Cole, and K. Murphy, “Xgan: Unsupervised imageto-image translation for many-to-many mappings,” arXiv preprint arXiv:1711.05139, 2017. 2

[43] E. Tola, V . Lepetit, and P . Fua, “Daisy: An efficient dense descriptor applied to wide-baseline stereo,” IEEE transactions on pattern analysis and machine intelligence, vol. 32, no. 5, pp. 815–830, 2009. 2

[44] M. Wang, G.-Y . Y ang, R. Li, R.-Z. Liang, S.-H. Zhang, P . Hall, S.-M. Hu et al., “Example-guided style consistent image synthesis from semantic labeling,” arXiv preprint arXiv:1906.01314, 2019. 1, 2

[45] T.-C. Wang, M.-Y . Liu, J.-Y . Zhu, A. Tao, J. Kautz, and B. Catanzaro, “High-resolution image synthesis and semantic manipulation with conditional GANs,” in Proceedings of the IEEE conference on computer vision and pattern recognition, 2018, pp. 8798–8807. 1, 2, 6

[46] R. Yi, Y .-J. Liu, Y .-K. Lai, and P . L. Rosin, “Apdrawinggan: Generating artistic portrait drawings from face photos with hierarchical gans,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 10 743–10 752. 2

[47] Z. Yi, H. Zhang, P . Tan, and M. Gong, “Dualgan: Unsupervised dual learning for image-to-image translation,” in Proceedings of the IEEE international conference on computer vision, 2017, pp. 2849–2857. 2

[48] B. Zhang, M. He, J. Liao, P . V . Sander, L. Y uan, A. Bermak, and D. Chen, “Deep exemplar-based video colorization,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2019, pp. 8052–8061. 2, 3

[49] H. Zhang, I. Goodfellow, D. Metaxas, and A. Odena, “Selfattention generative adversarial networks,” arXiv preprint arXiv:1805.08318, 2018. 5

[50] B. Zhou, H. Zhao, X. Puig, S. Fidler, A. Barriuso, and A. Torralba, “Scene parsing through ade20k dataset,” in Proceedings of the IEEE conference on computer vision and pattern recognition, 2017, pp. 633–641. 5

[51] T. Zhou, P . Krahenbuhl, M. Aubry, Q. Huang, and A. A. Efros, “Learning dense correspondence via 3d-guided cycle consistency,” in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016, pp. 117– 126. 2

[52] J.-Y . Zhu, T. Park, P . Isola, and A. A. Efros, “Unpaired image-to-image translation using cycle-consistent adversarial networks,” in Proceedings of the IEEE international conference on computer vision, 2017, pp. 2223–2232. 1, 2

[53] J.-Y . Zhu, R. Zhang, D. Pathak, T. Darrell, A. A. Efros, O. Wang, and E. Shechtman, “Toward multimodal image-to image translation,” in Advances in Neural Information Processing Systems, 2017, pp. 465–476. 2