导语

“ 随着移动设备的普及和短视频行业的兴起,大量视频被存储到云端并经由互联网进行大规模地传播。以COS上的视频内容生产流程为例,从被生产出来到被消费者观看,视频大多在数据万象经历了摄取、压缩、处理、传输和恢复等诸多环节,不可避免地对视频产生各种画面失真与降质。例如,视频编码技术虽然能够帮助我们节约存储与传输所消耗的带宽,但却会对视频带来不可逆的画质损失;传输过程中的网络问题,同样会导致视频画面的缺失与播放卡顿。对于视频生产服务而言,能够量化并监控这些质量下降显得尤为重要,有助于维持并提升整个平台的服务质量。”

在COS大量的视频内容生产过程中视频质量评价承担了什么角色?

相信现在习惯了高清视频的用户再看座机画质视频那绝对是一种酷刑,对于众多流媒体提供商来说,糟糕的视频质量就是劝退用户的关键问题之一 。出现包浆视频的原因可能因为:一、视频历史久远;二、视频压缩处理;三、视频编辑操作等等,COS上的视频来源众多,大小质量参差不齐,涉及到的视频处理环节穿成像、编辑、处理、编/转/解码、渲染、显示,这时候不出现渣画面那肯定是hard模式了。

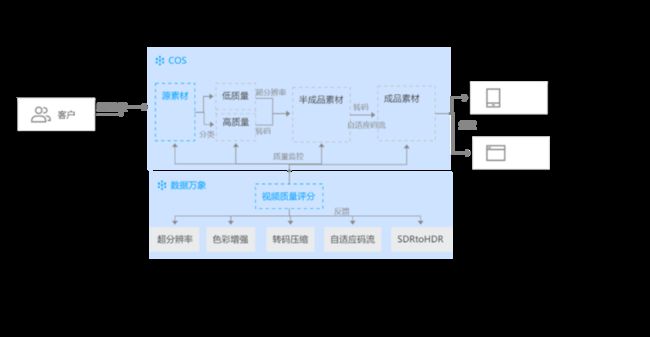

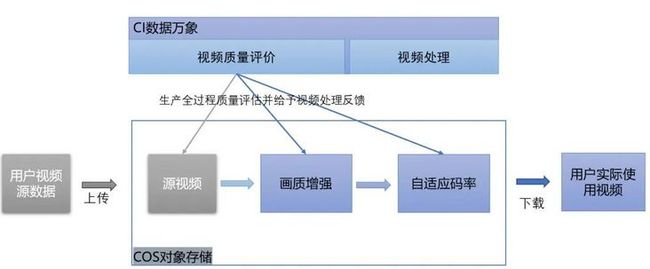

为了使用户的视频不因为质量问题而错失关注与商机,数据万象在整个生产过程中需要帮助用户进行源视频的质量分析,判别是否要进行增强操作以及通过视频视频评价确定视频美化的效果是否合格,在分发到不同平台时根据用户侧的反馈结合视频质量评分调整视频参数,视频质量评价的重要性不言而喻。

典型的COS视频质量自动化保障流程:

Step1、用户将视频上传到COS后即可开始使用视频质量评分,通过质量评分将素材进行质量分级。Step2、为每个质量分级的素材进行其质量级别适配的处理方式。

Step3、为处理后的半成品素材进行处理以适配不同的分发渠道,使用质量评分为各素材确定出最适合的转码参数。

Step4、检查即将分发到不同渠道的成品素材的质量情况。同时我们在保障过程中以提升用户体验为目标,不断反向推进视频处理的效果优化。

数据万象视频质量评分接口请参考:https://cloud.tencent.com/doc...

整个质量保障过程均为自动化流程,无需人工介入,以提升用户体验为目标,在保证性能的情况下,不断反向推进视频处理的效果优化,确保用户成品视频的质量。为了使COS视频质量评分能够为用户真正带来收益,我们在数据集构建,模型设计方面都有诸多真实业务的因素考量,下面就为大家带来详细解读。

什么是视频质量评价

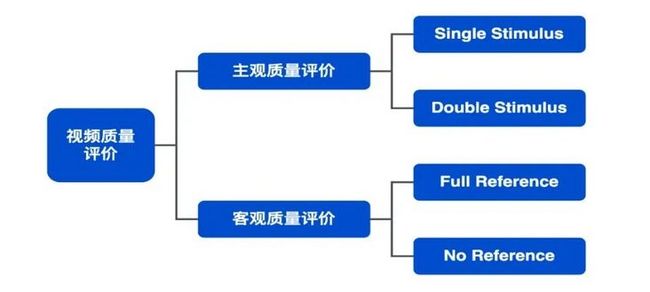

主观评价 & 客观评价

大部分情况下视频服务的最终接收者都是人,因此“主观评价”这一画质评价方法得到了广泛运用,也是迄今为止最可靠的评价方式。主观评价指通过人类观测小组对画面的质量或损害进行的判断,需要依靠大量的人力,制定详细的统一的评价标准,导致了其测试效率低且成本高昂。为了解决上述问题,“客观评价”应运而生。客观评价指利用数学模型对视频的画质进行自动化的评估与量化,同时保证评价结果无限接近于主观评价结果。

全参考 & 无参考

在视频质量评价过程中,根据原始视频信号是否可获得,可以将其划分为全参考评价和无参考评价,并分别映射出不同的视频质量定义。“全参考评价”中认为原始视频是可以获取且拥有“完美”画质,并将原始&待测视频的差异映射为质量分数。与之相对,“无参考评价”指原始视频不可获取,评价者/器依照其对完美画质的统计先验、背景知识对被测视频进行分析得到质量评分。因此,无参考评价能够被运用到原视频无法获取、视频画质提升等应用场景中。

我们做视频质量评价的意义在于提供高效低成本的客观评价方法,效果无限趋近于主观评价。统一视频质量评价的标准,避免主观评价中的个体差异问题,在视频处理的各环节起到积极作用。客观评价方法经过数十年的发展已经越来越贴近人眼主观的感觉,但仍存在许多问题。

腾讯自研的质量评价是如何实现的

设计目标我们的质量评价模型需要贴合市场需求,无限接近于主观评测的标准,且标准易于泛化,兼容多样化的视频场景,同时又具有低成本高性能的特性。我们的数据集建立、评价模型设计都为了这样的目标而服务。结合目前业界痛点,在质量评价算法设计之初我们拟定了以下设计目标:

易部署。方便嵌入到生产链路中的任意环节

低开销。模型计算量低,可运行在低算力机器上

贴合主观感受。预测分数与主观感受相符合,分数波动小

针对手机观看场景。贴近当下热门的使用场景,得到更准确地观感预测

防恶意攻击。能一定程度阻止恶意提高分数的行为

自研数据集的构建

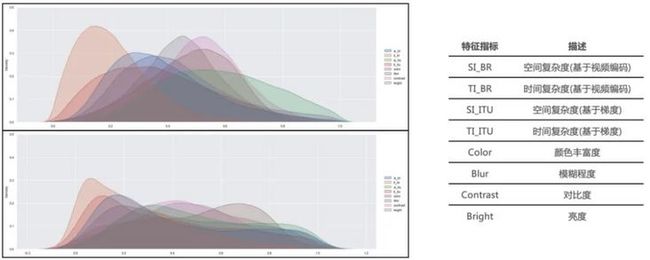

海量视频筛选保证样本多样性和所有基于统计的机器学习任务一样,质量评价数据集的采样分布均匀程度、与业务实际数据的贴合程度会直接影响最终产出模型的性能与泛化能力。这里,我们根据空间复杂度、时间复杂度、色彩、模糊程度、亮度、对比度等人眼敏感的画面特征对视频进行样本均衡。确保筛选后的标注视频各特征维度分布均匀、画面多样性高;我们的视频筛选过程基于足够大的原始样本池,数据量达百万级别,能够支撑高均衡度的筛选结果。

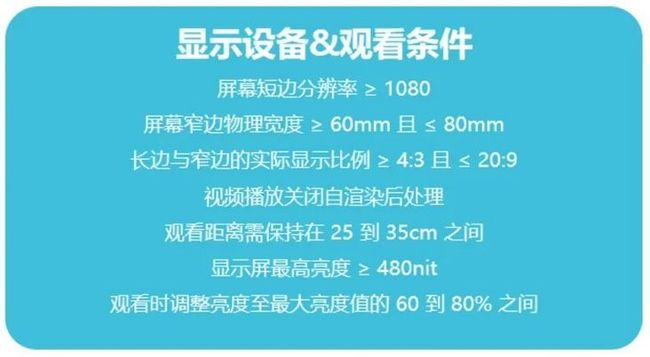

筛选前后各特征维度分布对比 制定针对手机观看场景的标注标准为了贴合覆盖率越来越广的手机观看场景,弥补业界在该场景下大规模视频质量评价数据集的空白,我们制作了专门针对手机场景的自研数据集。该数据集的观看、打分全程在手机上进行,保证标注人员的打分完全反应实际手机使用过程中的观看体验。

我们参考 ITU-R BT.500、ITU-T P.913 等传统画质评测行业标准,对手机标注标准进行设计,并获得了内部多个业务部门认可。评测方式采用无参考、五分制打分;使用手机作为视频播放、评测、打分工具;对手机屏幕分辨率、长宽比、亮度、观看距离严格控制。下面列出了标准中的部分细则:

执行严格的视频标注&验收流程

在标注过程中,我们聘请了内部上百人的专业打分团队进行质量标注,并在标注全流程的各个环节预埋了打分可靠性保障机制,确保最终获得的标注分数可靠性高、波动性小。最终,我们获得了~50W次高质量人工标注。

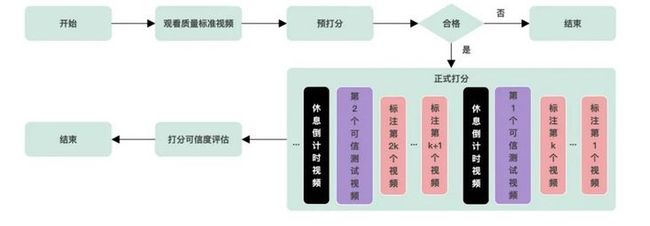

标注流程示意图

标注前:标注员需经过预打分测试,测试合格才能开始正式打分任务;

标注中:正式打分任务中随机预埋测试视频,对标注员打分质量进行实时监控;

标注后:利用先进的打分可信度评估方法对人工打分进行可靠性分析、加权融 自研评价模型

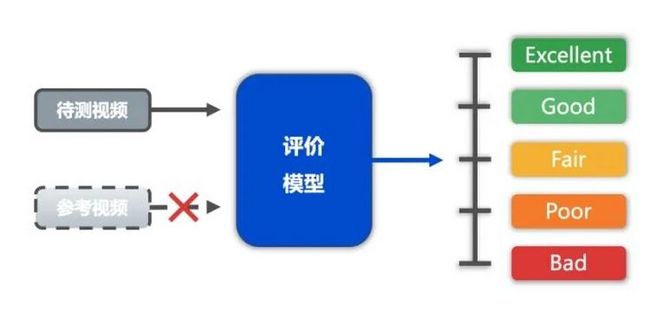

采用无参考评价模式视频从生产出来到被消费中间经历的拍摄、处理、转码、分发、渲染等众多环节,整个 pipeline 十分复杂,涉及到的硬件设备种类众多,我们希望质量评价工具能像探针一样插入到其中的任意环节,监控各个环节的画质变化,因此我们采用无参考质量评价模式,适用于线上复杂的视频处理流水线,对于无法获取参考视频的节点也能顺利部署。

* 无参考评价模型 *

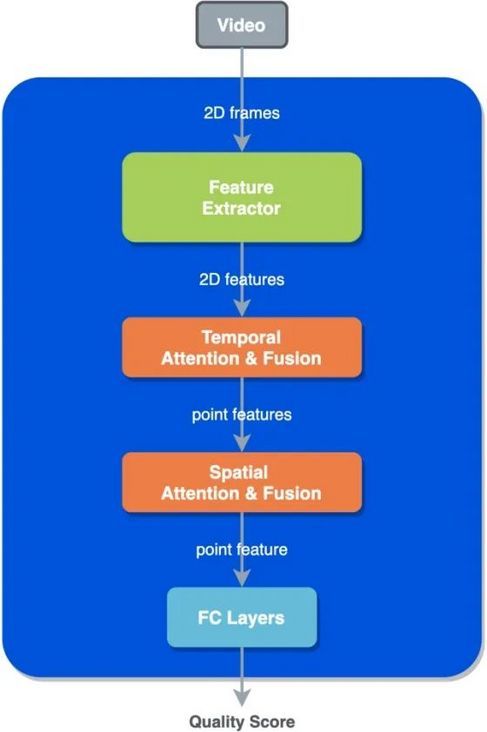

模型设计

我们的质量评价能力基于深度学习进行建模,自研高性能特征提取模块与时空域注意力模块,提升模型整体表征能力;利用模型轻量化技术对模型进行裁剪,在维持模型预测精度的同时降低计算复杂度;在此基础上引入了模型对抗攻击的设计,能一定程度阻止恶意提高分数的行为。

性能指标

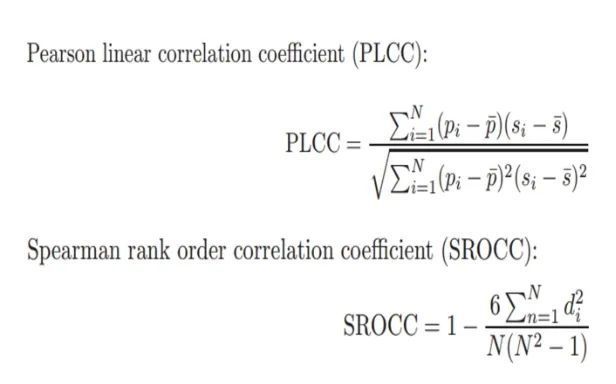

质量评价领域通常采用预测值序列与标注值序列之间的 PLCC、SROCC 等相关性系数作为模型性能的衡量指标。PLCC、SROCC,值域范围均为[-1, 1],值越接近1则相关性越高。计算公式如下所示:

模型性能

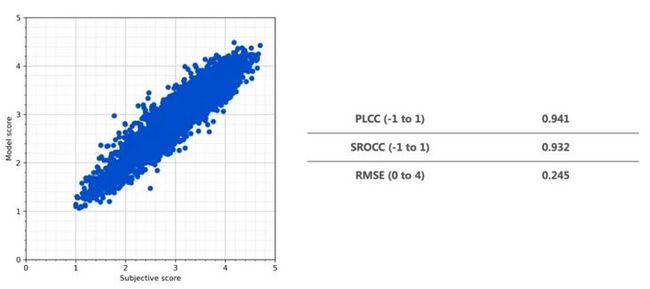

得益于高质量的数据标注与优异的模型设计,在测试集上模型预测与标注分数达到了很高的PLCC 和 SROCC。左图中,横轴代表标注分数,纵轴代表模型预测得分,可以看到两者的分布呈现出较好的相关性。

质量评价能力的应用

应用一:视频全链路质量监控

无参考工具可以对视频链路上的各个环节进行质量监控,适用于编码、处理等各种场景,找出质量的瓶颈点。

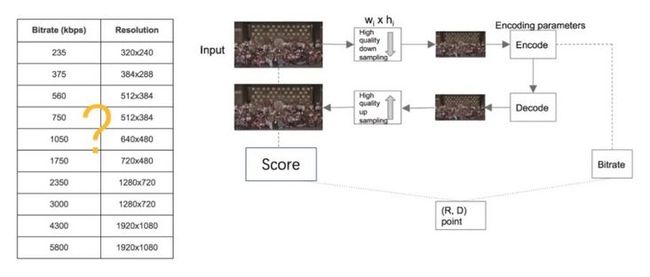

应用二:视频关键参数决策

线上视频的分辨率/码率阶梯对体验影响非常大,但缺乏科学的决策机制,依赖业务数据来反馈调节,使用质量评估能力能帮助工程师方便地进行决策。甚至更进一步,根据每个视频的具体得分情况来选择不同的分辨率和码率,保证每个视频的体验。

应用三:视频技术方案选型

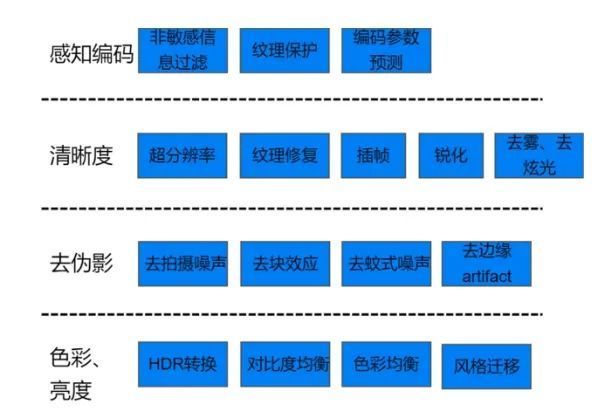

视频处理技术的蓬勃发展为视频产品带来了丰富的技术选项用于改进视频体验,因此如何选择合适的技术,如何评估不同的技术方案对体验的影响成为了关键问题,质量评估能力能为技术方案的选型提供参考。

经典案例:腾讯某自有产品视频质量提升

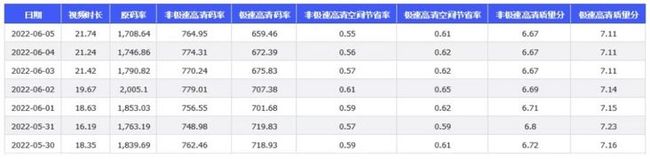

腾讯某自有业务使用质量评估能力来对业务链路进行监控,找到质量瓶颈点,并针对问题设计了视频质量改进方案。实施后码率有所下降,质量数据改善明显,业务质量得到提升。

画质改进前后对比如果您想了解视频质量评分的更多信息,请点击[https://cloud.tencent.com/doc...],查阅官网文档。