【云原生--Kubernetes】ingress详解

文章目录

- 一. Ingress简介

-

- 1.1 service暴露方式

- 1.2 ingress组件

-

- 1.2.1 ingress

- 1.2.2 ingress-controller

- 1.3 Ingress 工作原理

- 二. ingress 暴露服务的方式

-

- 2.1 Deployment+LoadBalancer

- 2.2 DaemonSet+HostNetwork+nodeSelector

- 2.3 Deployment+NodePort

- 三. ingress-nginx

-

- 3.1 Nginx Ingress Controller工作流程

- 3.2 部署 nginx-ingress-controller

- 3.3 DaemonSet+HostNetwork+nodeselector

- 3.3 部署Deployment+NodePort

- 四. ingress-nginx 反向代理

-

- 4.1 ingress http代理访问虚拟主机

- 4.2 ingress HTTPS 代理访问

- 4.3 Nginx 重写跳转

- 五. 总结

一. Ingress简介

1.1 service暴露方式

service的作用体现在两个方面,对集群内部,它不断跟踪pod的变化,更新endpoint中对应pod的对象,提供了ip不断变化的pod的服务发现机制;对集群外部,他类似负载均衡器,可以在集群内外部对pod进行访问。

在Kubernetes中,Pod的IP地址和service的ClusterIP仅可以在集群网络内部使用,对于集群外的应用是不可见的。为了使外部的应用能够访问集群内的服务,Kubernetes目前提供了以下几种方案:

-

NodePort:将service暴露在节点网络上,NodePort背后就是Kube-Proxy,Kube-Proxy是沟通service网络、Pod网络和节点网络的桥梁。

测试环境使用还行,当有几十上百的服务在集群中运行时,NodePort的端口管理就是个灾难。因为每个端口只能是一种服务,端口范围只能是 30000-32767。 -

LoadBalancer:通过设置LoadBalancer映射到云服务商提供的LoadBalancer地址。这种用法仅用于在公有云服务提供商的云平台上设置 Service 的场景。受限于云平台,且通常在云平台部署LoadBalancer还需要额外的费用。

在service提交后,Kubernetes就会调用CloudProvider在公有云上为你创建一个负载均衡服务,并且把被代理的Pod的IP地址配置给负载均衡服务做后端。 -

externalIPs:service允许为其分配外部IP,如果外部IP路由到集群中一个或多个Node上,Service会被暴露给这些externalIPs。通过外部IP进入到集群的流量,将会被路由到Service的Endpoint上。

-

Ingress:只需一个或者少量的公网IP和LB,即可同时将多个HTTP服务暴露到外网,七层反向代理。

可以简单理解为service的service,它其实就是一组基于域名和URL路径,把用户的请求转发到一个或多个service的规则。

1.2 ingress组件

1.2.1 ingress

ingress是一个API对象,通过yaml文件来配置,ingress对象的作用是定义请求如何转发到service的规则,可以理解为配置模板。

ingress通过http或https暴露集群内部service,给service提供外部URL、负载均衡、SSL/TLS能力以及基于域名的反向代理。ingress要依靠 ingress-controller 来具体实现以上功能。

1.2.2 ingress-controller

ingress-controller是具体实现反向代理及负载均衡的程序,对ingress定义的规则进行解析,根据配置的规则来实现请求转发。

ingress-controller并不是k8s自带的组件,实际上ingress-controller只是一个统称,用户可以选择不同的ingress-controller实现,目前,由k8s维护的ingress-controller只有google云的GCE与ingress-nginx两个,其他还有很多第三方维护的ingress-controller,具体可以参考官方文档。但是不管哪一种ingress-controller,实现的机制都大同小异,只是在具体配置上有差异。

一般来说**,ingress-controller的形式都是一个pod**,里面跑着daemon程序和反向代理程序。daemon负责不断监控集群的变化,根据 ingress对象生成配置并应用新配置到反向代理,比如ingress-nginx就是动态生成nginx配置,动态更新upstream,并在需要的时候reload程序应用新配置。为了方便,后面的例子都以k8s官方维护的ingress-nginx为例。

Ingress-Nginx github 地址:https://github.com/kubernetes/ingress-nginx

Ingress-Nginx 官方网站:https://kubernetes.github.io/ingress-nginx/

小结:ingress-controller才是负责具体转发的组件,通过各种方式将它暴露在集群入口,外部对集群的请求流量会先到 ingress-controller, 而ingress对象是用来告诉ingress-controller该如何转发请求,比如哪些域名、哪些URL要转发到哪些service等等。

1.3 Ingress 工作原理

- ingress-controller通过和 kubernetes APIServer 交互,动态的去感知集群中ingress规则变化,

- 然后读取它,按照自定义的规则,规则就是写明了哪个域名对应哪个service,生成一段nginx配置,

- 再写到nginx-ingress-controller的pod里,这个ingress-controller的pod里运行着一个Nginx服务,控制器会把生成的 nginx配置写入 /etc/nginx.conf文件中,

- 然后reload一下使配置生效。以此达到域名区分配置和动态更新的作用。

二. ingress 暴露服务的方式

2.1 Deployment+LoadBalancer

如果要把ingress部署在公有云,那用这种方式比较合适。用Deployment部署ingress-controller,创建一个 type为 LoadBalancer 的 service 关联这组 pod。大部分公有云,都会为 LoadBalancer 的 service 自动创建一个负载均衡器,通常还绑定了公网地址。 只要把域名解析指向该地址,就实现了集群服务的对外暴露

缺点:不适用于高并发、大集群

2.2 DaemonSet+HostNetwork+nodeSelector

用DaemonSet结合nodeselector来部署ingress-controller到特定的node上,然后使用HostNetwork直接把该pod与宿主机node的网络打通,直接使用宿主机的80/433端口就能访问服务。这时,ingress-controller所在的node机器就很类似传统架构的边缘节点,比如机房入口的nginx服务器。该方式整个请求链路最简单,性能相对NodePort模式更好。缺点是由于直接利用宿主机节点的网络和端口,一个node只能部署一个ingress-controller pod。 比较适合大并发的生产环境使用。

2.3 Deployment+NodePort

同样用deployment模式部署ingress-controller,并创建对应的service,但是type为NodePort。这样,ingress就会暴露在集群节点ip的特定端口上。由于nodeport暴露的端口是随机端口,一般会在前面再搭建一套负载均衡器来转发请求。该方式一般用于宿主机是相对固定的环境ip地址不变的场景。

NodePort方式暴露ingress虽然简单方便,但是NodePort多了一层NAT,在请求量级很大时可能对性能会有一定影响。

缺点:对后期维护难度加大,对流量转发压力也会变大,且对于高并发支持不是很友好

三. ingress-nginx

3.1 Nginx Ingress Controller工作流程

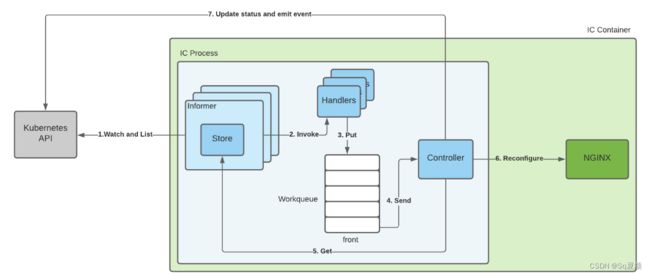

Nginx Ingress Controller容器中运行主要了Ingress Controller(下面简称IC)和Nginx两个程序,官方文档中非常详细地介绍了其工作原理:How NGINX Ingress Controller Works。下面截取了其中一张图:

1、IC会为每种其感兴趣的资源类型(如Ingress、VirtualServer、VirtualServerRoute及其关联资源)创建一个Informer,每个Informer包括一个存储该类型资源的store。Informer会通过Kubernetes API监视其对应资源类型的变化情况,来使store中内容保持最新。

2、IC会为每个Informer注册一个处理程序Handler。当用户创建或者更新了资源时(如创建了一个Ingress资源),Informer会更新其store并调用其它对应的Handler。

3、Handler会在工作队列Workqueue中为发生改变的资源创建一个条目,工作队列的元素包括资源的类型及其命名空间和名称,如(Ingress,default,cafe)。

4、Workqueue总是会试图清空队列中的元素,如果队列前面有一个元素,Workqueue将移除该元素并通过调用回调函数将其发送给控制器Controller。

5、Controller是IC中的主要组件,代表控制回路。Controller在接收到Workqueue发送的信息后(即变更的资源),将从store中获取相关资源的最新版本。

6、Controller根据获取的资源,生成相应的nginx配置文件,写入容器的文件系统,然后reload nginx,并通过Kubernetes API将reload结果更新到资源的status和event。

3.2 部署 nginx-ingress-controller

- 部署ingress-controller pod及相关资源

mkdir /opt/ingress

cd /opt/ingress

官方下载:

wget https://gitee.com/mirrors/ingress-nginx/raw/nginx-0.30.0/deploy/static/mandatory.yaml

mandatory.yaml文件中包含了很多资源的创建,包括namespace、ConfigMap、role,ServiceAccount等等所有部署ingress-controller需要的资源。

apiVersion: rbac.authorization.k8s.io/v1beta1

RBAC相关资源从1.17版本开始改用rbac.authorization.k8s.io/v1

这儿使用v1beta1的版本可能会报错,将所有的v1beta1改为v1

3.3 DaemonSet+HostNetwork+nodeselector

- 指定nginx-ingress-controller运行在node02节点

kubectl label node k8s-node2 ingress=true

kubectl get nodes --show-labels

- 修改Deployment为Daemonset,指定节点运行,并开启 hostNetwork

vim mandatory.yaml

apiversion: apps/vl

kind: Daemonset #修改kind

replicas: 1 # 删除Replicas

hostNetwork: true #使用主机网络

nodeSelector:

ingress: "true" #选择节点运行

- 启动nginx-ingress-controller

kubectl apply -f mandatory.yaml

kubectl get pod -n ingress-nginx -o wide

netstat -natp | grep nginx

由于配置了 hostnetwork,nginx 已经在 node 主机本地监听 80/443/8181 端口。其中 8181 是 nginx-controller 默认配置的一个 default backend(Ingress 资源没有匹配的 rule 对象时,流量就会被导向这个 default backend)。

这样,只要访问 node 主机有公网 IP,就可以直接映射域名来对外网暴露服务了。如果要 nginx 高可用的话,可以在多个 node

上部署,并在前面再搭建一套 LVS+keepalived 做负载均衡。

- 创建 ingress 规则

vim service-nginx.yaml

创建一个deploy和svc

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-app

spec:

replicas: 2

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx

imagePullPolicy: IfNotPresent

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:

name: nginx-app-svc

spec:

type: ClusterIP

ports:

- protocol: TCP

port: 80

targetPort: 80

selector:

app: nginx

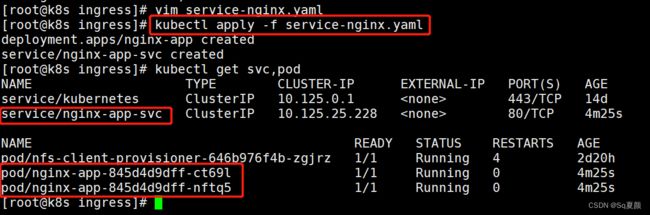

kubectl apply -f service-nginx.yaml

kubectl get svc,pod

- 创建 ingress

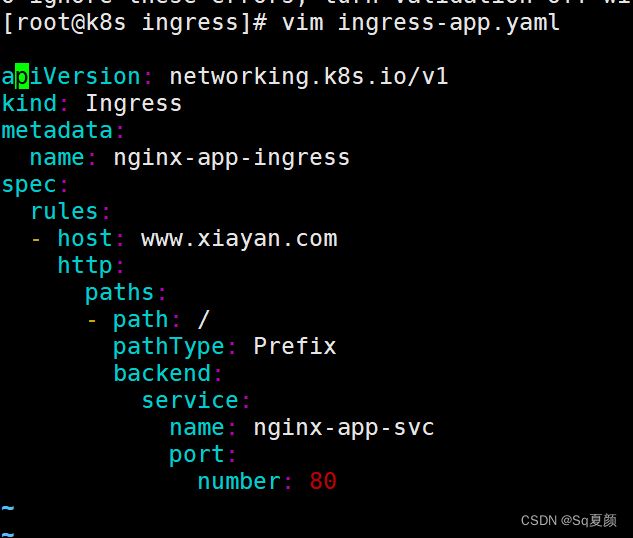

vim ingress-app.yaml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: nginx-app-ingress

spec:

rules:

- host: www.xiayan.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: nginx-app-svc

port:

number: 80

kubectl apply -f ingress-app.yaml

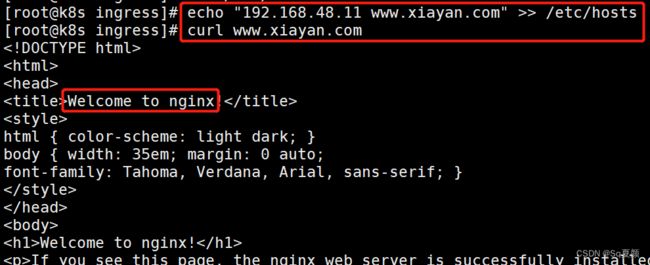

添加本地域名映射,用于测试

#注意此处使用的IP地址为node2节点的IP地址

echo "192.168.48.11 www.xiayan.com" >> /etc/hosts

- 查看nginx-ingress-controller

kubectl get pod -n ingress-nginx -o wide

kubectl exec -it nginx-ingress-controller-pplxc -n ingress-nginx bash

more /etc/nginx/nginx.conf

3.3 部署Deployment+NodePort

在做此部署时,先将上面部署的DaemonSet+HostNetwork+nodeselector删除

部署Deployment+NodePort

- 下载nginx-ingress-controller和ingress-nginx暴露端口配置文件

在主节点

mkdir /opt/ingress-nodeport

cd /opt/ingress-nodeport

官方下载地址:

wget https://raw.githubusercontent.com/kubernetes/ingress-nginx/nginx-0.30.0/deploy/static/mandatory.yaml

wget https://raw.githubusercontent.com/kubernetes/ingress-nginx/nginx-0.30.0/deploy/static/provider/baremetal/service-nodeport.yaml

国内 gitee 资源地址:

wget https://gitee.com/mirrors/ingress-nginx/raw/nginx-0.30.0/deploy/static/mandatory.yaml

wget https://gitee.com/mirrors/ingress-nginx/raw/nginx-0.30.0/deploy/static/provider/baremetal/service-nodeport.yaml

- 启动nginx-ingress-controller

kubectl apply -f mandatory.yaml

kubectl apply -f service-nodeport.yaml

kubectl get pod,svc -n ingress-nginx

- 创建deployment、service和ingress的yaml资源

vim ingress-nginx.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-app

spec:

replicas: 2

selector:

matchLabels:

name: nginx

template:

metadata:

labels:

name: nginx

spec:

containers:

- name: nginx

image: nginx

imagePullPolicy: IfNotPresent

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:

name: nginx-svc

spec:

ports:

- port: 80

targetPort: 80

protocol: TCP

selector:

name: nginx

---

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: nginx-test

spec:

rules:

- host: www.xiayan.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: nginx-svc

port:

number: 80

发布

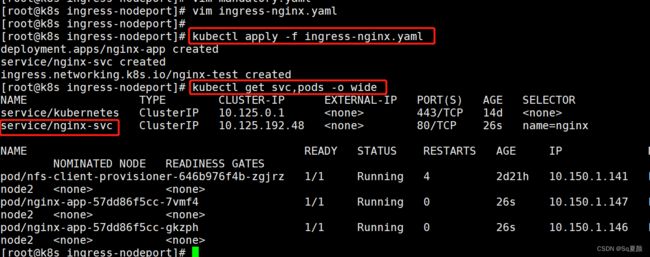

kubectl apply -f ingress-nginx.yaml

kubectl get svc,pods -o wide

#在两个pod中的nginx添加测试文件

kubectl exec -it pod/nginx-app-57dd86f5cc-7vmf4 bash

echo 'this is web1' >> /usr/share/nginx/html/index.html

echo "192.168.48.14 www.xiayan.com" >> /etc/hosts

在虚拟机的web浏览器打开www.xiayan.com:31018,使用curl访问也一样

四. ingress-nginx 反向代理

4.1 ingress http代理访问虚拟主机

mkdir /opt/vhost

cd /opt/vhost

创建虚拟主机2资源

vim deployment1.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: deployment1

spec:

replicas: 2

selector:

matchLabels:

name: nginx1

template:

metadata:

labels:

name: nginx1

spec:

containers:

- name: nginx1

image: nginx

imagePullPolicy: IfNotPresent

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:

name: svc-1

spec:

ports:

- port: 80

targetPort: 80

protocol: TCP

selector:

name: nginx1

创建虚拟主机2资源

vim deployment2.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: deployment2

spec:

replicas: 2

selector:

matchLabels:

name: nginx2

template:

metadata:

labels:

name: nginx2

spec:

containers:

- name: nginx2

image: nginx

imagePullPolicy: IfNotPresent

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:

name: svc-2

spec:

ports:

- port: 80

targetPort: 80

protocol: TCP

selector:

name: nginx2

发布资源

kubectl apply -f deployment1.yaml

kubectl apply -f deployment2.yaml

创建ingress资源

vim ingress-nginx.yaml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: ingress1

spec:

rules:

- host: www.xy.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: svc-1

port:

number: 80

---

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: ingress2

spec:

rules:

- host: www.xiayan.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: svc-2

port:

number: 80

发布:

kubectl apply -f ingress-nginx.yaml

kubectl get ingress

注意:这儿要把上个试验所做的ingress删除,只留如图所示的ingress,否则待会测试可能出问题

编写nginx的访问界面,用于测试

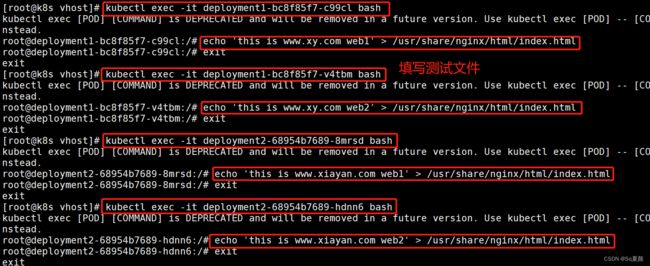

kubectl exec -it deployment1-bc8f85f7-c99cl bash

kubectl exec -it deployment1-bc8f85f7-v4tbm bash

kubectl exec -it deployment2-68954b7689-8mrsd bash

kubectl exec -it deployment2-68954b7689-hdnn6 bash

echo 'this is www.xiayan.com web2' > /usr/share/nginx/html/index.html

添加域名映射

echo "192.168.48.14 www.xiayan.com" >> /etc/hosts

echo "192.168.48.14 www.xy.com" >> /etc/hosts

4.2 ingress HTTPS 代理访问

mkdir /opt/https

cd /opt/https

- 创建SSL证书

openssl req -x509 -sha256 -nodes -days 365 -newkey rsa:2048 -keyout tls.key -out tls.crt -subj "/CN=nginxsvc/O=nginxsvc"

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-app

spec:

replicas: 2

selector:

matchLabels:

name: nginx

template:

metadata:

labels:

name: nginx

spec:

containers:

- name: nginx

image: nginx

imagePullPolicy: IfNotPresent

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:

name: nginx-svc

spec:

ports:

- port: 80

targetPort: 80

protocol: TCP

selector:

name: nginx

---

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: nginx-https

spec:

tls:

- hosts:

- www.xy.com

secretName: tls-secret

rules:

- host: www.xy.com

http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: nginx-svc

port:

number: 80

4.3 Nginx 重写跳转

- nginx.ingress.kubernetes.io/rewrite-target:<字符串>#必须重定向流量的目标URI

- nginx.ingress . kubernetes.io/ssl-redirect:<布尔值>指示位置部分是否仅可访问sSL(当Ingress包含证书时,默认为true)

- nginx.ingress . kubernetes.io/force-ssl-redirect:<布尔值>#即使Ingress未启用rLS,也强制重定向到HTTPS

- nginx.ingress .kubernetes.io/app-root:<字符串>#定义controller必须重定向的应用程序根,如果它在’/'上下文中

- nginx.ingress.kubernetes.io/use-regex:<布尔值>#指示Ingress.上定义的路径是否使用正则表达式

编写yaml文件

vim ingress-rewrite.yaml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: nginx-rewrite

annotations:

nginx.ingress.kubernetes.io/rewrite-target: https://www.xy.com:31222

spec:

rules:

- host: rewrite.xy.com

http:

paths:

- path: /

pathType: Prefix

backend:

#由于rewrite.xy.com只是用于跳转不需要真实站点存在,因此svc资源名称可随意定义

service:

name: nginx-svc

port:

number: 80

echo "192.168.48.14 rewrite.xy.com" >> /etc/hosts

五. 总结

ingress是k8s集群的请求入口,可以理解为对多个service的再次抽象

通常说的ingress一般包括ingress资源对象及ingress-controller两部分组成

ingress-controller有多种实现,社区原生的是ingress-nginx,根据具体需求选择

ingress自身的暴露有多种方式,需要根据基础环境及业务类型选择合适的方式