ECCV-2020- Ocean: Object-aware Anchor-free Tracking 阅读笔记

论文地址:

https://arxiv.org/pdf/2006.10721.pdf

代码地址:

https://github.com/researchmm/TracKit

目录

- 一、 动机

- 二、 主要贡献

- 三、 主要内容

-

- 算法整体架构:

- 特征提取

- 特征融合

- 回归任务

- 分类任务

- 目标定位

- 在线更新分支

- 损失

- 四、 实验结果

一、 动机

基于锚框的孪生网络跟踪方法在精度上取得了显著的进步,但更鲁棒的改进却收到了限制,其中的原因在于基于锚的方法中的回归网络只训练在正锚盒上(即IoU≥0.6)。这种机制使细化与目标对象重叠很小的锚变得困难。于是作者提出了一个新的对象感知的无锚网络来解决这个问题。

二、 主要贡献

① 基于锚点方法难以细化与目标对象重叠较小的锚点,提出了一种无锚点目标网络。该算法不仅可以纠正不精确的边界盒预测,而且可以学习对象感知特征,提高匹配精度。

② 将所提出的无锚网络与一个高效的特征组合模块相结合,设计了一种新的跟踪框架。提出的跟踪模型在5个基准上实现了最先进的性能,同时以实时速度运行。

三、 主要内容

算法整体架构:

特征提取

采用ResNet50的前四个阶段作为主干。前三个阶段的结构与最初的ResNet-50相同。第四阶段,将降采样单元的卷积步长由2修改为1,以增加feature map的空间大小,同时将所有3 × 3卷积都改为步长为2的扩张卷积,以增加感受野。

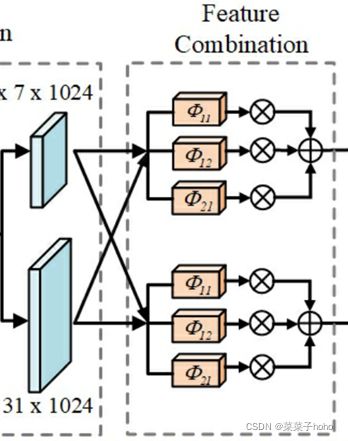

特征融合

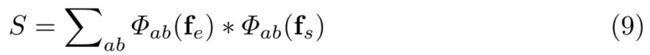

通过三个平行扩张卷积层传递,然后通过点求和融合相关特征。

fe:目标图片特征 fs:搜索图片特征

Φab为单个卷积核大小为3*3、通道数为256的扩张卷积层,沿x轴a,沿Y轴b,∗表示互相关操作

通过增加扩张的多样性可以提高特征的可表征性,因此选择了三个不同的扩张,其步长设置为(a, b)∈{(1,1),(1,2),(2,1)}。不同膨胀倍数的卷积可以捕获不同尺度区域的特征,提高最终组合特征的尺度不变性。

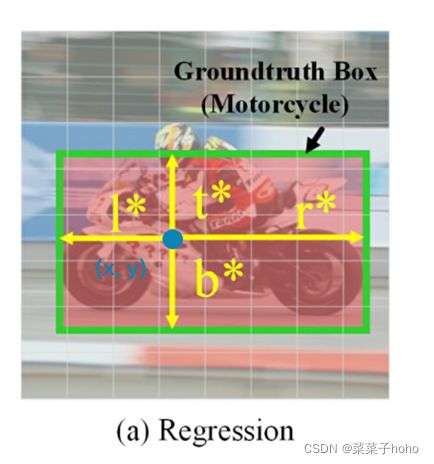

回归任务

为了解决回归依赖于分类任务且只关注 IoU >=0.6 的anchor , 忽略了目标很小的问题。

提出了一个anchor-free,直接回归gt中的每一个像素点位置的方案,这样在推理阶段即使只有很小的overlap,依然可以纠正那些不精确的预测结果。

回归网络的学习是通过四个信道数为256的3×3卷积层,然后是一个信道数为4的3×3层,用于预测距离。

如果一个像素的坐标(x, y)落入groundtruth B= (x0, y0, x1, y1)∈R4,那么它被认为是回归样本。因此,训练样本的标签T∗= (l∗,t∗,r∗,b∗)被计算为

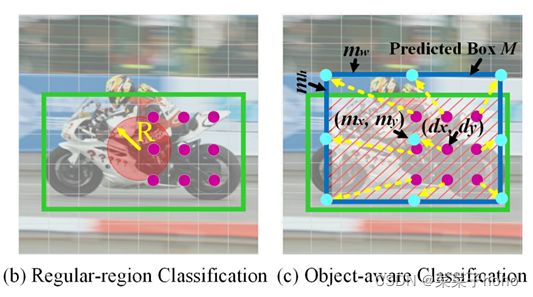

分类任务

在先前的Siam跟踪方法中,分类置信度是通过从特征图中的固定规则区域(例如图2(b)中的紫色点)采样的特征来估计的。这种采样特征描述的是图像的一个固定的局部区域,不能根据对象尺度的变化进行缩放。因此,分类置信度在区分复杂背景和目标目标时是不可靠的。

为了解决这个问题,提出了一个特征对齐模块来学习一个对象感知的特征来进行分类。具体来说,对分类任务中每个位置(dx,dy) 都有一个对应的由回归任务预测得到的对象边界框M=(mx,my,mw,mh)。我们的目标是估计每个位置的分类一致性(dx,dy)通过从相应的有效区域m采样特征。核大小为k×k的标准二维卷积样本特征使用固定的网格

![]()

因此,我们提出在规则采样网格G上加一个空间变换T(图2C中的黄色箭头),将固定区域的采样位置转换为预测区域M。

根据新的采样位置,由特征对齐模块提取对象感知特征:

这样提取的目标感知特征对目标尺度的变化便具有了鲁棒性,有利于跟踪过程中的特征匹配。

分类任务中,利用目标感知特征和规则区域特征来预测区域是否属于目标对象或图像背景。分类网络的“OA.Conv ”块是卷积核大小为3×3 的标准卷积,用来预测基于对象感知特征的分类置信度po。分类网络的“Conv”块用来预测基于规则区域特征的分类置信度pr ,由4个信道数为256 的3 × 3标准卷积层和一个通道数为1的标准3 × 3卷积层组成,计算置信度p的总和,得到的分类得分。

目标定位

分类得分图需要加惩罚来抑制物体大小和宽高比的大变化:

其中r 和 r ′ 分别指的是上一帧和当前帧预测包围盒的长宽比,s和s ′ 分别指的是上一帧和当前帧的包围盒尺度。

同时,为了保持预测的边界框的形状平滑变化,还需要使用线性权函数来计算最终的尺度。

在线更新分支

引入了一个在线分支来捕获跟踪过程中目标物体的外观变化,在线分支继承了骨干网前三个阶段的结构和参数,只是将第四个阶段的步长改为了1,该阶段的初始参数都是通过训练得到的,最终将在线分支的结果与上面得到的分类得分图相加得到最终的分类得分图:

损失

回归损失由IoU loss 和binary cross-entropy (BCE) loss定义为:

分类损失:

规则区域分类损失

对象感知分类损失

![]()

其中p 0 ∗ 和 p r ∗ p_0*和p_r*p 0∗ 和p r∗ 分别指的是两个分类的标签,前者是一个概率标签即计算真实框和预测框的IOU得到,而后者是一个二值标签,通过以下公式求得:

总损失:

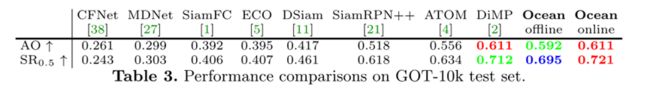

四、 实验结果

训练数据集:

Youtube-BB, ImageNet VID, ImageNet DET, GOT-10k ,COCO

评测数据集:

VOT-2018, VOT-2019, OTB-100, GOT-10k ,LaSOT