Shell脚本详解

一、Shell基础

1、Shell 简介

Shell 是一个 C 语言编写的脚本语言,它是用户与 Linux 的桥梁,用户输入命令交给 Shell 处理,

Shell 将相应的操作传递给内核(Kernel),内核把处理的结果输出给用户。

下面是流程示意图:

Shell 既然是工作在 Linux 内核之上,那我们也有必要了解下 Linux 相关知识。

Linux 是一套免费试用和自由传播的类 Unix 操作系统,是一个基于 POSIX 和 UNIX 的多用户、多任务、支持多线程和多 CPU 的操作系统。

1983 年 9 月 27 日,Richard Stallman(理查德-马修-斯托曼)发起 GNU 计划,它的目标是创建一套完全自由的操作系统。为保证 GNU 软件可以自由的使用、复制、修改和发布,所有的 GNU 软件都有一份在禁止其他人添加任何限制的情况下授权所有权利给任何人的协议条款,GNU 通用公共许可证(GNU General Plubic License,GPL),说白了就是不能做商业用途。

GNU 是"GNU is Not Unix"的递归缩写。UNIX 是一种广泛使用的商业操作系统的名称。

1985 年,Richard Stallman 又创立了自由软件基金会(Free Software Foundation,FSF)来为

GNU 计划提供技术、法律以及财政支持。

1990 年,GNU 计划开发主要项目有 Emacs(文本编辑器)、GCC(GNU Compiler Collection,GNU 编译器集合)、Bash 等,GCC 是一套 GNU 开发的编程语言编译器。还有开发一些 UNIX 系统的程序库和工具。

1991 年,Linuxs Torvalds(林纳斯- 托瓦兹)开发出了与 UNIX 兼容的 Linux 操作系统内核并在

GPL 条款下发布。

1992 年,Linux 与其他 GUN 软件结合,完全自由的 GUN/Linux 操作系统正式诞生,简称 Linux。

1995 年 1 月,Bob Young 创办 ACC 公司,以 GNU/Linux 为核心,开发出了 RedHat Linux 商业版。

Linux 基本思想有两点:第一,一切都是文件;第二,每个软件都有确定的用途。与 Unix 思想十分相近。

2、Shell 基本分两大类

1)图形界面 Shell(GUI Shell)

GUI 为 Unix 或者类 Unix 操作系统构造一个功能完善、操作简单以及界面友好的桌面环境。主流桌面环境有 KDE,Gnome 等。

2)命令行界面 Shell(CLI Shell)

CLI 是在用户提示符下键入可执行指令的界面,用户通过键盘输入指令,完成一系列操作。

在 Linux 系统上主流的 CLI 实现是 Bash,是许多 Linux 发行版默认的 Shell。还有许多 Unix 上

Shell,例如 tcsh、csh、ash、bsh、ksh 等。

3、第一个Shell脚本

主要讲解在大多Linux发行版下默认Bash Shell。Linux系统是RedHat下的CentOS 操作系统,完全免费。与其商业版RHEL(Red Hat Enterprise Linux)出自同样的源代码,不同的是CentOS并不包含封闭源代码软件和售后支持。

用vi打开test.sh,编写:

# vi test.sh

#!/bin/bash

echo "Hello world!"# bash test.sh

Hello world!# ll test.sh

-rw-r--r--. 1 root root 32 Aug 18 01:07 test.sh

# chmod +x test.sh

# ./test.sh

-bash: ./test.sh: Permission denied

# chmod +x test.sh

# ./test.sh # ./在当前目录

Hello world!# source test.sh

Hello world!4、Shell 变量

1)系统变量

在命令行提示符直接执行 env、set 查看系统或环境变量。env 显示用户环境变量,set 显示 Shell 预先定义好的变量以及用户变量。可以通过 export 导出成用户变量。

2)普通变量与临时环境变量

普通变量定义:

VAR=value 临时环境变量定义:

export VAR=value变量引用:

$VAR下面看下他们之间区别:

ps axjf 输出的第一列是 PPID(父进程 ID),第二列是 PID(子进程 ID)。

当 SSH 连接 Shell 时,当前终端 PPID(-bash)是 sshd 守护程序的 PID(root@pts/0),因此在

当 前终端下的所有进程的 PPID 都是-bash 的 PID,比如执行命令、运行脚本。

所以当在-bash 下设置的变量,只在-bash 进程下有效,而-bash 下的子进程 bash 是无效的,当

export 后才有效。

进一步说明:再重新连接 SSH,去除上面定义的变量测试下:

所以在当前 shell 定义的变量一定要 export,否则在写脚本时,会引用不到。

还需要注意的是退出终端后,所有用户定义的变量都会清除。 在/etc/profile 下定义的变量就是这个原理,后面会讲解 Linux 常用变量文件。

位置变量指的是函数或脚本后跟的第 n 个参数。

$1-$n,需要注意的是从第 10 个开始要用花括号调用,例如${10}。

shift 可对位置变量控制,例如:

#!/bin/bash

echo "1: $1"

shift

echo "2: $2"

shift

echo "3: $3"

# bash test.sh a b c

1: a

2: c

3:每执行一次 shift 命令,位置变量个数就会减一,而变量值则提前一位。shift n,可设置向前移动

n 位。

4)特殊变量

5) 变量引用

① 自定义变量与引用

# VAR=123

# echo $VAR

123

# VAR+=456

# echo $VAR

123456Shell 中所有变量引用使用$符,后跟变量名。

有时个别特殊字符会影响正常引用,那么需要使用${VAR},例如:

# VAR=123

# echo $VAR

123

# echo $VAR_ # Shell 允许 VAR_为变量名,所以此引用认为这是一个有效的变量名,故此返回

空# echo ${VAR}

123还有时候变量名与其他字符串紧碍着,也会误认为是整个变量:

# echo $VAR456

# echo ${VAR}456

123456② 将命令结果作为变量值

# VAR=`echo 123`

# echo $VAR

123

# VAR=$(echo 123)

# echo $VAR

1235、双引号和单引号

# VAR=1 2 3 -bash: 2: command not found

# VAR="1 2 3"

# echo $VAR

1 2 3 # VAR='1 2 3'

# echo $VAR

1 2 3看不出什么区别,再举个说明:

# N=3

# VAR="1 2 $N"

# echo $VAR

1 2 3

# VAR='1 2 $N'

# echo $VAR

1 2 $N6、注释

二、Shell字符串处理

1、获取字符串长度

# VAR='hello world!'

# echo $VAR

hello world!

# echo ${#VAR}

122、字符串切片

格式:

${parameter:offset}

${parameter:offset:length}截取从 offset 个字符开始,向后 length 个字符。

截取 hello 字符串:

# VAR='hello world!'

# echo ${VAR:0:5}

hello

截取 wo 字符:

# echo ${VAR:6:2}

wo

截取 world!字符串:

# echo ${VAR:5}

world!

截取最后一个字符:

# echo ${VAR:(-1)}

!

截取最后二个字符:

# echo ${VAR:(-2)}

d!

截取从倒数第 3 个字符后的 2 个字符:

# echo ${VAR:(-3):2}

ld3、替换字符串

格式:

${parameter/pattern/string}# VAR='hello world world!'

将第一个 world 字符串替换为 WORLD: # echo ${VAR/world/WORLD}

hello WORLD world!

将全部 world 字符串替换为 WORLD: # echo ${VAR//world/WORLD}

hello WORLD WORLD!

替换正则匹配为空: # VAR=123abc

# echo ${VAR//[^0-9]/}

123

# echo ${VAR//[0-9]/}

abc4、字符串截取

格式:

${parameter#word} # 删除匹配前缀

${parameter##word}

${parameter%word} # 删除匹配后缀

${parameter%%word}# URL="http://www.baidu.com/baike/user.html"

以//为分隔符截取右边字符串:

# echo ${URL#*//}

www.baidu.com/baike/user.html

以/为分隔符截取右边字符串:

# echo ${URL##*/}

user.html

以//为分隔符截取左边字符串:

# echo ${URL%%//*}

http:

以/为分隔符截取左边字符串:

# echo ${URL%/*}

http://www.baidu.com/baike

以.为分隔符截取左边:

# echo ${URL%.*}

http://www.baidu.com/baike/user

以.为分隔符截取右边:

# echo ${URL##*.}

html5、变量状态赋值

如果变量为空就返回 hello world!: # VAR=

# echo ${VAR:-'hello world!'}

hello world!

如果变量不为空就返回 hello world!: # VAR="hello"

# echo ${VAR:+'hello world!'}

hello world!

如果变量为空就重新赋值:

# VAR=

# echo ${VAR:=hello}

hello

# echo $VAR

hello

如果变量为空就将信息输出 stderr: # VAR=

# echo ${VAR:?value is null}

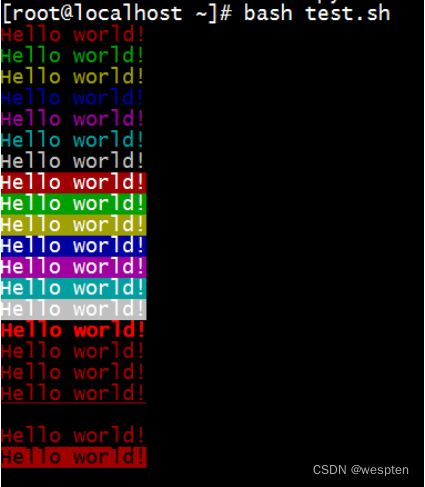

-bash: VAR: value is null6、字符串颜色

格式:

\033[1;31;40m # 1 是显示方式,可选。31 是字体颜色。40m 是字体背景颜色。

\033[0m # 恢复终端默认颜色,即取消颜色设置。示例:

#!/bin/bash

# 字体颜色

for i in {31..37}; do

echo -e "\033[$i;40mHello world!\033[0m"

done

# 背景颜色

for i in {41..47}; do

echo -e "\033[47;${i}mHello world!\033[0m"

done

# 显示方式

for i in {1..8}; do

echo -e "\033[$i;31;40mHello world!\033[0m"

done三、Shell表达式与运算符

1、条件表达式

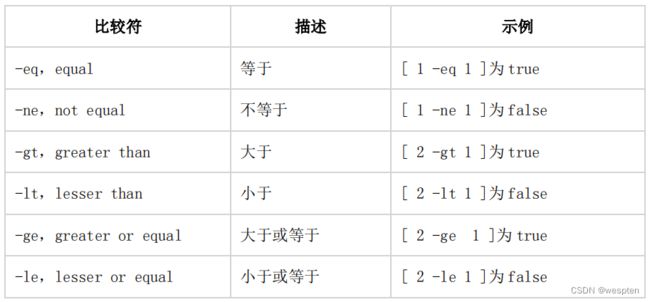

2、整数比较符

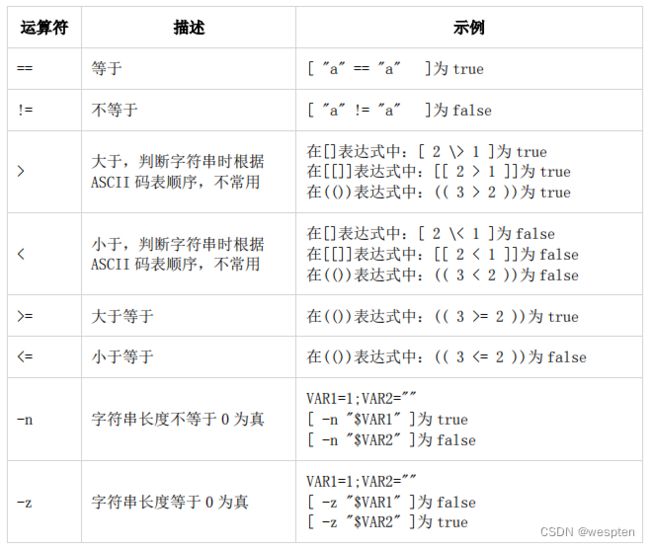

3、字符串比较符

需要注意的是,使用-z 或-n 判断字符串长度时,变量要加双引号。

举例说明:

# [ -z $a ] && echo yes || echo no

yes

# [ -n $a ] && echo yes || echo no

yes

# 加了双引号才能正常判断是否为空

# [ -z "$a" ] && echo yes || echo no

yes

# [ -n "$a" ] && echo yes || echo no

no

# 使用了双中括号就不用了双引号

# [[ -n $a ]] && echo yes || echo no

no

# [[ -z $a ]] && echo yes || echo no

yes4、文件测试

5、布尔运算符

![]()

6、逻辑判断符

7、整数运算

上面两个都不支持浮点运算。

$(())表达式还有一个用途,三目运算:

# 如果条件为真返回 1,否则返回 0 # echo $((1<0))

0# echo $((1>0))

1

指定输出数字:

# echo $((1>0?1:2))

1# echo $((1<0?1:2))

2

注意:返回值不支持字符串8、其他运算工具(let/expr/bc)

除了 Shell 本身的算数运算表达式,还有几个命令支持复杂的算数运算:

由于 Shell 不支持浮点数比较,可以借助 bc 来完成需求:

# echo "1.2 < 2" |bc

1# echo "1.2 > 2" |bc

0# echo "1.2 == 2.2" |bc

0# echo "1.2 != 2.2" |bc

1

看出规律了嘛?运算如果为真返回 1,否则返回 0,写一个例子:

# [ $(echo "2.2 > 2" |bc) -eq 1 ] && echo yes || echo no

yes

# [ $(echo "2.2 < 2" |bc) -eq 1 ] && echo yes || echo no

noexpr 还可以对字符串操作,获取字符串长度:

# expr length "string"

6

截取字符串:

# expr substr "string" 4 6

ing

获取字符在字符串中出现的位置:

# expr index "string" str

1# expr index "string" i 4

获取字符串开始字符出现的长度:

# expr match "string" s.*

6# expr match "string" str

39、Shell 括号用途总结

看到这里,想一想里面所讲的小括号、中括号的用途,是不是有点懵逼了。那我们总结一下!

四、Shell流程控制

流程控制是改变程序运行顺序的指令。

1、if 语句

格式:

if list; then list; [ elif list; then list; ] ... [ else list; ] fi1)单分支

if 条件表达式; then

命令

fi#!/bin/bash

N=10

if [ $N -gt 5 ]; then

echo yes

fi

# bash test.sh

yes2)双分支

if 条件表达式; then

命令

else

命令

fi#!/bin/bash

N=10

if [ $N -lt 5 ]; then

echo yes

else

echo no

fi

# bash test.sh

no#!/bin/bash

NAME=crond

NUM=$(ps -ef |grep $NAME |grep -vc grep)

if [ $NUM -eq 1 ]; then

echo "$NAME running."

else

echo "$NAME is not running!"

fi#!/bin/bash

if ping -c 1 192.168.1.1 >/dev/null; then

echo "OK."

else

echo "NO!"

fiif 语句可以直接对命令状态进行判断,就省去了获取$?这一步!

3)多分支

if 条件表达式; then

命令

elif 条件表达式; then

命令

else

命令

fi#!/bin/bash

N=$1

if [ $N -eq 3 ]; then

echo "eq 3"

elif [ $N -eq 5 ]; then

echo "eq 5"

elif [ $N -eq 8 ]; then

echo "eq 8"

else

echo "no"

fi如果第一个条件符合就不再向下匹配。

示例 2:根据 Linux 不同发行版使用不同的命令安装软件

#!/bin/bash

if [ -e /etc/redhat-release ]; then

yum install wget -y

elif [ $(cat /etc/issue |cut -d' ' -f1) == "Ubuntu" ]; then

apt-get install wget -y

else

Operating system does not support.

exit

fi2、for 语句

格式:

for name [ [ in [ word ... ] ] ; ] do list ; donefor 变量名 in 取值列表; do

命令

done示例:

#!/bin/bash

for i in {1..3}; do

echo $i

done

# bash test.sh

1

2

3for 的语法也可以这么写:

#!/bin/bash

for i in "$@"; { # $@是将位置参数作为单个来处理

echo $i

}# bash test.sh 1 2 3

1

2

3#!/bin/bash

for i in 12 34; do

echo $i

done

# bash test.sh

12

34如果想指定分隔符,可以重新赋值$IFS 变量:

#!/bin/bash

OLD_IFS=$IFS

IFS=":"

for i in $(head -1 /etc/passwd); do

echo $i

done

IFS=$OLD_IFS # 恢复默认值

# bash test.sh

root

x

00

root

/root

/bin/bashfor (( expr1 ; expr2 ; expr3 )) ; do list ; done#!/bin/bash

for ((i=1;i<=5;i++)); do # 也可以 i--

echo $i

done#!/bin/bash

for ip in 192.168.1.{1..254}; do

if ping -c 1 $ip >/dev/null; then

echo "$ip OK."

else

echo "$ip NO!"

fi

done#!/bin/bash

URL="www.baidu.com www.sina.com www.jd.com"

for url in $URL; do

HTTP_CODE=$(curl -o /dev/null -s -w %{http_code} http://$url)

if [ $HTTP_CODE -eq 200 -o $HTTP_CODE -eq 301 ]; then

echo "$url OK."

else

echo "$url NO!"

fi

done3、while 语句

格式:

while list; do list; donewhile 条件表达式; do

命令

done#!/bin/bash

N=0

while [ $N -lt 5 ]; do

let N++

echo $N

done

# bash test.sh

1

2

3

4

5#!/bin/bash

while [ 1 -eq 1 ]; do

echo "yes"

done也可以条件表达式直接用 true:

#!/bin/bash

while true; do

echo "yes"

done还可以条件表达式用冒号,冒号在 Shell 中的意思是不做任何操作。但状态是 0,因此为 true:

#!/bin/bash

while :; do

echo "yes"

done# cat a.txt

a b c

1 2 3

x y z#!/bin/bash

cat ./a.txt | while read LINE; do

echo $LINE

done#!/bin/bash

while read LINE; do

echo $LINE

done < ./a.txt#!/bin/bash

exec < ./a.txt # 读取文件作为标准输出

while read LINE; do

echo $LINE

done4、break 和 continue 语句

break 是终止循环。

#!/bin/bash

N=0

while true; do

let N++

if [ $N -eq 5 ]; then

break

fi

echo $N

done

# bash test.sh

1

2

3

4#!/bin/bash

N=0

while [ $N -lt 5 ]; do

let N++

if [ $N -eq 3 ]; then

continue

fi

echo $N

done

# bash test.sh

1

2

4

5当变量 N 等于 3 时,continue 跳过了当前循环,没有执行下面的 echo。

注意:continue 与 break 语句只能循环语句中使用。

5、case 语句

格式:

case word in [ [(] pattern [ | pattern ] ... ) list ;; ] ... esac

case 模式名 in

模式 1)

命令

;;

模式 2)

命令

;;

*)

不符合以上模式执行的命令

esac#!/bin/bash

case $1 in

start)

echo "start."

;;

stop)

echo "stop."

;;

restart)

echo "restart."

;;

*)

echo "Usage: $0 {start|stop|restart}"

esac

# bash test.sh

Usage: test.sh {start|stop|restart}

# bash test.sh start

start.

# bash test.sh stop

stop.

# bash test.sh restart

restart.#!/bin/bash

case $1 in

[0-9])

echo "match number."

;;

[a-z])

echo "match letter."

;;

'-h'|'--help')

echo "help"

;;

*)

echo "Input error!"

exit

esac

# bash test.sh 1

match number.

# bash test.sh a

match letter.

# bash test.sh -h

help

# bash test.sh --help

help6、select 语句

格式:

select name [ in word ] ; do list ; doneselect 变量 in 选项 1 选项 2; do

break

done#!/bin/bash

select mysql_version in 5.1 5.6; do

echo $mysql_version

done

# bash test.sh

1) 5.1

2) 5.6

#? 1

5.1

#? 2

5.6#!/bin/bash

while true; do

select mysql_version in 5.1 5.6; do

echo $mysql_version

break

done

done

# bash test.sh

1) 5.1

2) 5.6

#? 1

5.1

1) 5.1

2) 5.6

#? 2

5.6

1) 5.1

2) 5.6句就简单多了。

#!/bin/bash

PS3="Select a number: "

while true; do

select mysql_version in 5.1 5.6 quit; do

case $mysql_version in

5.1)

echo "mysql 5.1"

break

;;

5.6)

echo "mysql 5.6"

break

;;

quit)

exit

;;

*)

echo "Input error, Please enter again!"

break

esac

done

done

# bash test.sh

1) 5.1

2) 5.6

3) quit

Select a number: 1

mysql 5.1

1) 5.1

2) 5.6

3) quit

Select a number: 2

mysql 5.6

1) 5.1

2) 5.6

3) quit

Select a number: 3五、Shell函数与数组

1、函数

格式:

func() {

command

}#!/bin/bash

func() {

echo "This is a function."

}

func

# bash test.sh

This is a function.Shell 函数很简单,函数名后跟双括号,再跟双大括号。通过函数名直接调用,不加小括号。

示例 2:函数返回值

#!/bin/bash

func() {

VAR=$((1+1))

return $VAR

echo "This is a function."

}

func

echo $?

# bash test.sh

2#!/bin/bash

func() {

echo "Hello $1"

}

func world

# bash test.sh

Hello world通过 Shell 位置参数给函数传参。

函数也支持递归调用,也就是自己调用自己。

例如:

#!/bin/bash

test() {

echo $1

sleep 1

test hello

}

test执行会一直在调用本身打印 hello,这就形成了闭环。

像经典的 fork 炸弹就是函数递归调用:

:(){ :|:& };: 或 .(){.|.&};.这样看起来不好理解,我们更改下格式:

:() {

:|:&

};

:bomb() {

bomb|bomb&

};

bomb分析下:

:(){ } 定义一个函数,函数名是冒号。

: 调用自身函数

| 管道符

: 再一次递归调用自身函数

:|: 表示每次调用函数":"的时候就会生成两份拷贝。

& 放到后台

; 分号是继续执行下一个命令,可以理解为换行。

: 最后一个冒号是调用函数。

因此不断生成新进程,直到系统资源崩溃。

一般递归函数用的也少,了解下即可!

2、数组

格式:

array=(元素 1 元素 2 元素 3 ...)用小括号初始化数组,元素之间用空格分隔。

array=(a b c)定义方法 2:新建数组并添加元素

array[下标]=元素定义方法 3:将命令输出作为数组元素

array=($(command))数组操作:

获取所有元素: # echo ${array[*]} # *和@ 都是代表所有元素

a b c

获取元素下标: # echo ${!a[@]}

0 1 2

获取数组长度: # echo ${#array[*]}

3

获取第一个元素: # echo ${array[0]}

a

获取第二个元素: # echo ${array[1]}

b

获取第三个元素: # echo ${array[2]}

c

添加元素: # array[3]=d

# echo ${array[*]}

a b c d

添加多个元素: # array+=(e f g)

# echo ${array[*]}

a b c d e f g

删除第一个元素: # unset array[0] # 删除会保留元素下标

# echo ${array[*]}

b c d e f g

删除数组: # unset array#!/bin/bash

for i in $(seq 1 10); do

array[a]=$i

let a++

done

echo ${array[*]}

# bash test.sh

1 2 3 4 5 6 7 8 9 10方法 1:

#!/bin/bash

IP=(192.168.1.1 192.168.1.2 192.168.1.3)

for ((i=0;i<${#IP[*]};i++)); do

echo ${IP[$i]}

done

# bash test.sh

192.168.1.1

192.168.1.2

192.168.1.3方法 2:

#!/bin/bash

IP=(192.168.1.1 192.168.1.2 192.168.1.3)

for IP in ${IP[*]}; do

echo $IP

done六、Shell正则表达式

正则表达式在每种语言中都会有,功能就是匹配符合你预期要求的字符串。

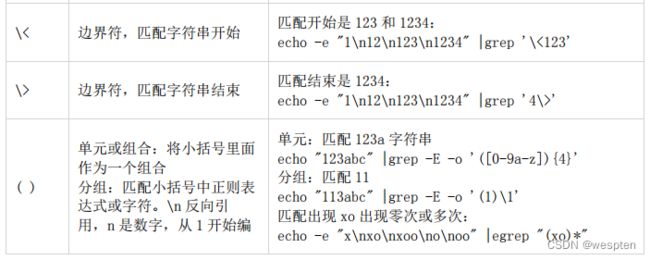

Shell 正则表达式分为两种:

基础正则表达式:BRE(basic regular express)

扩展正则表达式:ERE(extend regular express),扩展的表达式有+、?、|和()

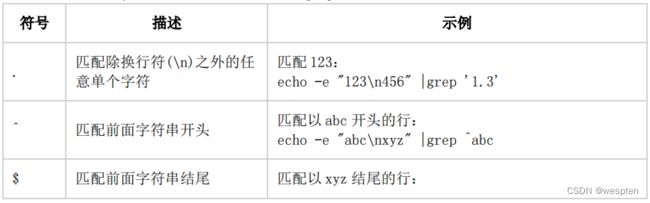

下面是一些常用的正则表达式符号,我们先拿 grep 工具举例说明。

示例:

echo -e "1\n12\n123\n1234a" |grep '[[:digit:]]'在 Shell 下使用这些正则表达式处理文本最多的命令有下面几个工具:

![]()

七、Shell文本处理三剑客

1、grep

过滤来自一个文件或标准输入匹配模式内容。

除了 grep 外,还有 egrep、fgrep。egrep 是 grep 的扩展,相当于 grep -E。fgrep 相当于 grep - f,用的少。

Usage: grep [OPTION]... PATTERN [FILE]...示例:

1)输出 b 文件中在 a 文件相同的行

# grep -f a b# grep -v -f a b# echo "a bc de" |xargs -n1 |grep -e 'a' -e 'bc'

a

bc# grep -E -v "^$|^#" /etc/httpd/conf/httpd.conf# echo "A a b c" |xargs -n1 |grep -i a

或

# echo "A a b c" |xargs -n1 |grep '[Aa]'

A

a6)只显示匹配的字符串

# echo "this is a test" |grep -o 'is'

is

is7)输出匹配的前五个结果

# seq 1 20 |grep -m 5 -E '[0-9]{2}'

10

11

12

13

148)统计匹配多少行

# seq 1 20 |grep -c -E '[0-9]{2}'

11# echo "a bc de" |xargs -n1 |grep '^b'

bc# echo "a ab abc abcd abcde" |xargs -n1 |grep -n 'de$'

5:abcde11) 递归搜索/etc 目录下包含 ip 的 conf 后缀文件

# grep -r '192.167.1.1' /etc --include *.conf12) 排除搜索 bak 后缀的文件

# grep -r '192.167.1.1' /opt --exclude *.bak13) 排除来自 file 中的文件

# grep -r '192.167.1.1' /opt --exclude-from file# seq 41 45 |grep -E '4[12]'

41

4215) 匹配至少 2 个字符

# seq 13 |grep -E '[0-9]{2}'

10

11

12

1316) 匹配至少 2 个字符的单词,最多 3 个字符的单词

# echo "a ab abc abcd abcde" |xargs -n1 |grep -E -w -o '[a-z]{2,3}'

ab

abc# ifconfig |grep -E -o "[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}\.[0-9]{1,3}"18) 打印匹配结果及后 3 行

# seq 1 10 |grep 5 -A 3

5

6

7

8

19) 打印匹配结果及前 3 行

# seq 1 10 |grep 5 -B 3

2

3

4

520) 打印匹配结果及前后 3 行

# seq 1 10 |grep 5 -C 3

2

3

4

5

6

7

821) 不显示输出

不显示错误输出:

# grep 'a' abc

grep: abc: No such file or directory

# grep -s 'a' abc

# echo $?

2

不显示正常输出:

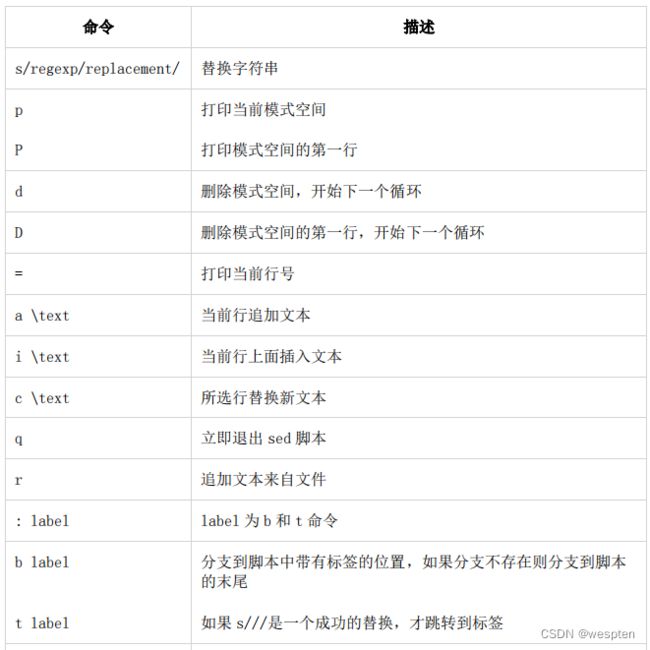

# grep -q 'a' a.txt2、sed

间。然后再将下一行读入模式空间进行处理输出,以此类推,直到最后一行。还有一个空间叫保持空间,又称暂存空间,可以暂时存放一些处理的数据,但不能直接输出,只能放到模式空间输出。

# tail /etc/services

nimgtw 48003/udp # Nimbus Gateway

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service Protocol

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject① 匹配打印(p)

1)打印匹配 blp5 开头的行

# tail /etc/services |sed -n '/^blp5/p'

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator2)打印第一行

# tail /etc/services |sed -n '1p'

nimgtw 48003/udp # Nimbus Gateway3)打印第一行至第三行

# tail /etc/services |sed -n '1,3p'

nimgtw 48003/udp # Nimbus Gateway

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service Protocol

isnetserv 48128/tcp # Image Systems Network Services4)打印奇数行

# seq 10 |sed -n '1~2p'

1

3

5

7

95)打印匹配行及后一行

# tail /etc/services |sed -n '/blp5/,+1p'

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator6)打印最后一行

# tail /etc/services |sed -n '$p'

iqobject 48619/udp # iqobject7)不打印最后一行

# tail /etc/services |sed -n '$!p'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

Protocol

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject感叹号也就是对后面的命令取反。

8)匹配范围

# tail /etc/services |sed -n '/^blp5/,/^com/p'

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw# tail /etc/services |sed -n '/blp5/,$p'

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject以逗号分开两个样式选择某个范围。

9)引用系统变量,用引号

# a=1

# tail /etc/services |sed -n ''$a',3p'

或

# tail /etc/services |sed -n "$a,3p"sed 命令用单引号时,里面变量用单引号引起来,或者 sed 命令用双引号,因为双引号解释特殊符

号原有意义。

② 匹配删除(d)

# tail /etc/services |sed '/blp5/d'

nimgtw 48003/udp # Nimbus Gateway

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

# tail /etc/services |sed '1d'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

Protocol

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

# tail /etc/services |sed '1~2d'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/udp # iqobject

# tail /etc/services |sed '1,3d'

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject去除空格 http.conf 文件空行或开头#号的行:

# sed '/^#/d;/^$/d' /etc/httpd/conf/httpd.conf③ 替换(s///)

# tail /etc/services |sed 's/blp5/test/'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

test 48129/tcp # Bloomberg locator

test 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker

全局替换加 g: # tail /etc/services |sed 's/blp5/test/g'# tail /etc/services |sed -n 's/^blp5/test/p'

test 48129/tcp # Bloomberg locator

test 48129/udp # Bloomberg locator# tail /etc/services |sed 's/48049/&.0/'

3gpp-cbsp 48049.0/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari BrokerIP 加单引号:

# echo '10.10.10.1 10.10.10.2 10.10.10.3' |sed -r 's/[^ ]+/"&"/g'

"10.10.10.1" "10.10.10.2" "10.10.10.3"# tail /etc/services | sed '1,4s/blp5/test/'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

test 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker5)对匹配行进行替换

# tail /etc/services | sed '/48129\/tcp/s/blp5/test/'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

test 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker# tail /etc/services |sed 's/blp5/test/;s/3g/4g/'

4gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

test 48129/tcp # Bloomberg locator

test 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker# tail /etc/services |sed -r 's/(.*) (.*)(#.*)/\1\2test \3/'

3gpp-cbsp 48049/tcp test # 3GPP Cell Broadcast Service

isnetserv 48128/tcp test # Image Systems Network Services

isnetserv 48128/udp test # Image Systems Network Services

blp5 48129/tcp test # Bloomberg locator

blp5 48129/udp test # Bloomberg locator

com-bardac-dw 48556/tcp test # com-bardac-dw

com-bardac-dw 48556/udp test # com-bardac-dw

iqobject 48619/tcp test # iqobject

iqobject 48619/udp test # iqobject

matahari 49000/tcp test # Matahari Broker第一列是第一个小括号匹配,第二列第二个小括号匹配,第三列一样。将不变的字符串匹配分组,

再通过\数字按分组顺序反向引用。

8)将协议与端口号位置调换

# tail /etc/services |sed -r 's/(.*)(\<[0-9]+\>)\/(tcp|udp)(.*)/\1\3\/\2\4/'

3gpp-cbsp tcp/48049 # 3GPP Cell Broadcast Service

isnetserv tcp/48128 # Image Systems Network Services

isnetserv udp/48128 # Image Systems Network Services

blp5 tcp/48129 # Bloomberg locator

blp5 udp/48129 # Bloomberg locator

com-bardac-dw tcp/48556 # com-bardac-dw

com-bardac-dw udp/48556 # com-bardac-dw

iqobject tcp/48619 # iqobject

iqobject udp/48619 # iqobject

matahari tcp/49000 # Matahari Broker9)位置调换

替换 x 字符为大写: # echo "abc cde xyz" |sed -r 's/(.*)x/\1X/'

abc cde Xyz

456 与 cde 调换: # echo "abc:cde;123:456" |sed -r 's/([^:]+)(;.*:)([^:]+$)/\3\2\1/'

abc:456;123:cde10)注释匹配行后的多少行

# seq 10 |sed '/5/,+3s/^/#/'

1

2

3

4

#5

#6

#7

#8

9

1011)注释指定多行

# seq 5 |sed -r 's/^3|^4/&#/'

1

2

3#

4#

5# seq 5 |sed -r '/^3|^4/s/^/#/'

1

2

#3

#4

5# seq 5 |sed -r 's/^3|^4/#\0/'

1

2

#3

#4

512)去除开头和结尾空格或制表符

# echo " 1 2 3 " |sed 's/^[ \t]*//;s/[ \t]*$//'

1 2 3④ 多重编辑(-e)

# tail /etc/services |sed -e '1,2d' -e 's/blp5/test/'

isnetserv 48128/udp # Image Systems Network Services

test 48129/tcp # Bloomberg locator

test 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker也可以使用分号分隔:

# tail /etc/services |sed '1,2d;s/blp5/test/'⑤ 添加新内容(a、i 和 c)

# tail /etc/services |sed '/blp5/i \test'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

test

blp5 48129/tcp # Bloomberg locator

test

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker# tail /etc/services |sed '/blp5/a \test'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

test

blp5 48129/udp # Bloomberg locator

test

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker# tail /etc/services |sed '/blp5/c \test'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

test

test

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker4)在指定行下一行添加一行

# tail /etc/services |sed '2a \test'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

test

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker5)在指定行前面和后面添加一行

# seq 5 |sed '3s/.*/txt\n&/'

1

2

txt

3

4

5

# seq 5 |sed '3s/.*/&\ntxt/'

1

2

3

txt

4

5⑥ 读取文件并追加到匹配行后(r)

# cat a.txt

123

456

# tail /etc/services |sed '/blp5/r a.txt'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

123

456

blp5 48129/udp # Bloomberg locator

123

456

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker⑦ 将匹配行写到文件(w)

# tail /etc/services |sed '/blp5/w b.txt'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker

# cat b.txt

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator⑧ 读取下一行(n 和 N)

# seq 5 |sed -n '/3/{n;p}'

4# seq 6 |sed -n 'n;p'

2

4

6sed 先读取第一行 1,执行 n 命令,获取下一行 2,此时模式空间是 2,执行 p 命令,打印模式空

间。 现在模式空间是 2,sed 再读取 3,执行 n 命令,获取下一行 4,此时模式空间为 4,执行 p 命令,以此类推。

3)打印奇数

# seq 6 |sed 'n;d'

1

3

5sed 先读取第一行 1,此时模式空间是 1,并打印模式空间 1,执行 n 命令,获取下一行 2,执行 d命令,删除模式空间的 2,sed 再读取 3,此时模式空间是 3,并打印模式空间,再执行 n 命令,获取下一行 4,执行 d 命令,删除模式空间的 3,以此类推。

# seq 6 |sed -n 'p;n'

1

3

5# seq 6 |sed 'n;n;p'

1

2

3

3

4

5

6

6sed 先读取第一行 1,并打印模式空间 1,执行 n 命令,获取下一行 2,并打印模式空间 2,再执行 n命令,获取下一行 3,执行 p 命令,打印模式空间 3。sed 读取下一行 3,并打印模式空间 3,以此类推。

5)每三行替换一次

方法 1:

# seq 6 |sed 'n;n;s/^/=/;s/$/=/'

1

2

=3=

4

5

=6=我们只是把 p 命令改成了替换命令。

方法 2:

这次用到了地址匹配,来实现上面的效果:

# seq 6 |sed '3~3{s/^/=/;s/$/=/}'

1

2

=3=

4

5

=6=# seq 6 |sed 'N;q'

1

2

将两行合并一行:

# seq 6 |sed 'N;s/\n//'

12

34

56# seq 5 |sed -n 'N;p'

1

2

3

4

# seq 6 |sed -n 'N;p'

1

2

3

4

5

6为什么第一个不打印 5 呢?

因为 N 命令是读取下一行追加到 sed 读取的当前行,当 N 读取下一行没有内容时,则退出,也不会执行 p 命令打印当前行。

当行数为偶数时,N 始终就能读到下一行,所以也会执行 p 命令。

7)打印奇数行数时的最后一行

# seq 5 |sed -n '$!N;p'

1

2

3

4

5

⑨ 打印和删除模式空间第一行(P 和 D)

# seq 6 |sed -n 'N;P'

1

3

52)保留最后一行

# seq 6 |sed 'N;D'

6⑩ 保持空间操作(h 与 H、g 与 G 和 x)

# seq 6 |sed -e '/3/{h;d}' -e '/5/g'

1

2

4

3

6# seq 6 |sed -e '/3/{h;d}' -e '$G'

1

2

4

5

6

33)交换模式空间和保持空间

# seq 6 |sed -e '/3/{h;d}' -e '/5/x' -e '$G'

1

2

4

3

6

5# seq 5 |sed '1!G;h;$!d'

5

4

3

2

1分析下:

1!G 第一行不执行把保持空间内容追加到模式空间,因为现在保持空间还没有数据。

h 将模式空间放到保持空间暂存。

$!d 最后一行不执行删除模式空间的内容。

读取第一行 1 时,跳过 G 命令,执行 h 命令将模式空间 1 复制到保持空间,执行 d 命令删除模式空间的 1。

读取第二行 2 时,模式空间是 2,执行 G 命令,将保持空间 1 追加到模式空间,此时模式空间是

2\n1,执行 h 命令将 2\n1 覆盖到保持空间,d 删除模式空间。

读取第三行 3 时,模式空间是 3,执行 G 命令,将保持空间 2\n1 追加到模式空间,此时模式空间是3\n2\n1,执行 h 命令将模式空间内容复制到保持空间,d 删除模式空间。

以此类推,读到第 5 行时,模式空间是 5,执行 G 命令,将保持空间的 4\n3\n2\n1 追加模式空间,然后复制到模式空间,5\n4\n3\n2\n1,不执行 d,模式空间保留,输出。

由此可见,每次读取的行先放到模式空间,再复制到保持空间,d 命令删除模式空间内容,防止输

出,再追加到模式空间,因为追加到模式空间,会追加到新读取的一行的后面,循环这样操作, 就把所有行一行行追加到新读取行的后面,就形成了倒叙。

5)每行后面添加新空行

# seq 10 |sed G

1

2

3

4

56)打印匹配行的上一行内容

# seq 5 |sed -n '/3/{x;p};h'

2读取第一行 1,没有匹配到 3,不执行{x;p},执行 h 命令将模式空间内容 1 覆盖到保持空间。

读取第二行 2,没有匹配到 3,不执行{x;p},执行 h 命令将模式空间内容 2 覆盖到保持空间。

读取第三行 3,匹配到 3,执行 x 命令把模式空间 3 与保持空间 2 交换,再执行 p 打印模式空间 2

以此类推。

7)打印匹配行到最后一行或下一行到最后一行

# seq 5 |sed -n '/3/,$p'

3

4

5

# seq 5 |sed -n '/3/,${h;x;p}'

3

4

5

# seq 5 |sed -n '/3/{:a;N;$!ba;p}'

3

4

5

# seq 5 |sed -n '/3/{n;:a;N;$!ba;p}'

4

5匹配到 3 时,n 读取下一行 4,此时模式空间是 4,执行 N 命令读取下一行并追加到模式空间,此时模式空间是 4\n5,标签循环完成后打印模式空间 4\n5。

⑪ 标签(:、b 和 t)

标签可以控制流,实现分支判断。

: lable name 定义标签

b lable 跳转到指定标签,如果没有标签则到脚本末尾

t lable 跳转到指定标签,前提是 s///命令执行成功

1)将换行符替换成逗号

方法 1:

# seq 6 |sed 'N;s/\n/,/'

1,2

3,4

5,6这种方式并不能满足我们的需求,每次 sed 读取到模式空间再打印是新行,替换\n 也只能对 N 命令追加后的 1\n2 这样替换。

这时就可以用到标签了:

# seq 6 |sed ':a;N;s/\n/,/;b a'

1,2,3,4,5,6看看这里的标签使用,:a 是定义的标签名,b a 是跳转到 a 位置。

sed 读取第一行 1,N 命令读取下一行 2,此时模式空间是 1\n2$,执行替换,此时模式空间是

1,2$,执行 b 命令再跳转到标签 a 位置继续执行 N 命令,读取下一行 3 追加到模式空间,此时模式空间是 1,2\n3$,再替换,以此类推,不断追加替换,直到最后一行 N 读不到下一行内容退出。

方法 2:

# seq 6 |sed ':a;N;$!b a;s/\n/,/g'

1,2,3,4,5,6# seq 6 |sed ':a;N;b a;s/\n/,/g'

1

2

3

4

5

6# echo "123456789" |sed -r 's/([0-9]+)([0-9]+{3})/\1,\2/'

123456,789

# echo "123456789" |sed -r ':a;s/([0-9]+)([0-9]+{3})/\1,\2/;t a'

123,456,789

# echo "123456789" |sed -r ':a;s/([0-9]+)([0-9]+{2})/\1,\2/;t a'

1,23,45,67,89执行第一次时,替换最后一个,跳转后,再对 123456 匹配替换,直到匹配替换不成功,不执行 t 命令。

⑫ 忽略大小写匹配(I)

# echo -e "a\nA\nb\nc" |sed 's/a/1/Ig'

1

1

b

c⑬ 获取总行数(#)

# seq 10 |sed -n '$='3、awk

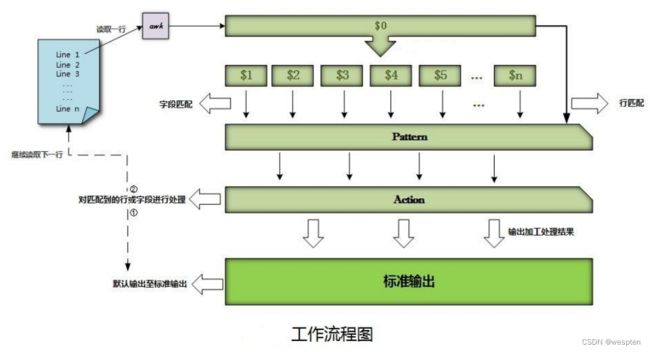

awk 是一个处理文本的编程语言工具,能用简短的程序处理标准输入或文件、数据排序、计算以及

生成报表等等。

在 Linux 系统下默认 awk 是 gawk,它是 awk 的 GNU 版本。可以通过命令查看应用的版本:

ls -l /bin/awk基本的命令语法:

awk option 'pattern {action}' file其中 pattern 表示 AWK 在数据中查找的内容,而 action 是在找到匹配内容时所执行的一系列命令,花括号用于根据特定的模式对一系列指令进行分组。

awk 处理的工作方式与数据库类似,支持对记录和字段处理,这也是 grep 和 sed 不能实现的。

在 awk 中,缺省的情况下将文本文件中的一行视为一个记录,逐行放到内存中处理,而将一行中的某一部分作为记录中的一个字段。用 1,2,3...数字的方式顺序的表示行(记录)中的不同字段。用$后跟数字,引用对应的字段,以逗号分隔,0 表示整个行。

① 选项

② 模式

常用模式有:

而动作呢,就是下面所讲的 print、流程控制、I/O 语句等。

示例:

1)从文件读取 awk 程序处理文件

# vi test.awk

{print $2}

# tail -n3 /etc/services |awk -f test.awk

48049/tcp

48128/tcp

49000/tcp打印第二字段,默认以空格分隔:

# tail -n3 /etc/services |awk '{print $2}'

48049/tcp

48128/tcp

48128/udp

指定冒号为分隔符打印第一字段:

# awk -F ':' '{print $1}' /etc/passwd

root

bin

daemon

adm

lp

sync

......还可以指定多个分隔符,作为同一个分隔符处理:

# tail -n3 /etc/services |awk -F'[/#]' '{print $3}'

iqobject

iqobject

Matahari Broker

# tail -n3 /etc/services |awk -F'[/#]' '{print $1}'

iqobject 48619

iqobject 48619

matahari 49000

# tail -n3 /etc/services |awk -F'[/#]' '{print $2}'

tcp

udp

tcp

# tail -n3 /etc/services |awk -F'[/#]' '{print $3}'

iqobject

iqobject

Matahari Broker

# tail -n3 /etc/services |awk -F'[ /]+' '{print $2}'

48619

48619

49000[]元字符的意思是符号其中任意一个字符,也就是说每遇到一个/或#时就分隔一个字段,当用多个

分隔符时,就能更方面处理字段了。

3)变量赋值

# awk -v a=123 'BEGIN{print a}'

123

系统变量作为 awk 变量的值:

# a=123

# awk -v a=$a 'BEGIN{print a}'

123

或使用单引号

# awk 'BEGIN{print '$a'}'

123# seq 5 |awk --dump-variables '{print $0}'

1

2

3

4

5

# cat awkvars.out

ARGC: number (1)

ARGIND: number (0)

ARGV: array, 1 elements

BINMODE: number (0)

CONVFMT: string ("%.6g")

ERRNO: number (0)

FIELDWIDTHS: string ("")

FILENAME: string ("-")

FNR: number (5)

FS: string (" ")

IGNORECASE: number (0)

LINT: number (0)

NF: number (1)

NR: number (5)

OFMT: string ("%.6g")

OFS: string (" ")

ORS: string ("\n")

RLENGTH: number (0)

RS: string ("\n")

RSTART: number (0)

RT: string ("\n")

SUBSEP: string ("\034")

TEXTDOMAIN: string ("messages")# tail /etc/services |awk 'BEGIN{print "Service\t\tPort\t\t\tDescription\n==="}{print

$0}'

Service Port Description

===

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari BrokerEND 模式是在程序处理完才会执行。

例如:打印页尾

# tail /etc/services |awk '{print $0}END{print "===\nEND......"}'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker

===

END......6)格式化输出 awk 命令到文件

# tail /etc/services |awk --profile 'BEGIN{print

"Service\t\tPort\t\t\tDescription\n==="}{print $0}END{print "===\nEND......"}'

Service Port Description

===

nimgtw 48003/udp # Nimbus Gateway

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service Protocol

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

===

END......

# cat awkprof.out

# gawk profile, created Sat Jan 7 19:45:22 2017

# BEGIN block(s)

BEGIN {

print "Service\t\tPort\t\t\tDescription\n==="

}

# Rule(s)

{

print $0

}

# END block(s)

END {

print "===\nEND......"

}匹配包含 tcp 的行:

# tail /etc/services |awk '/tcp/{print $0}'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

iqobject 48619/tcp # iqobject

matahari 49000/tcp # Matahari Broker

匹配开头是 blp5 的行:

# tail /etc/services |awk '/^blp5/{print $0}'

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

匹配第一个字段是 8 个字符的行:

# tail /etc/services |awk '/^[a-z0-9]{8} /{print $0}'

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker

如果没有匹配到,请查看你的 awk 版本(awk --version)是不是 3,因为 4 才支持{}8)逻辑 and、or 和 not

匹配记录中包含 blp5 和 tcp 的行:

# tail /etc/services |awk '/blp5/ && /tcp/{print $0}'

blp5 48129/tcp # Bloomberg locator

匹配记录中包含 blp5 或 tcp 的行:

# tail /etc/services |awk '/blp5/ || /tcp/{print $0}'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

iqobject 48619/tcp # iqobject

matahari 49000/tcp # Matahari Broker

不匹配开头是#和空行:

# awk '! /^#/ && ! /^$/{print $0}' /etc/httpd/conf/httpd.conf

或

# awk '! /^#|^$/' /etc/httpd/conf/httpd.conf

或

# awk '/^[^#]|"^$"/' /etc/httpd/conf/httpd.conf9)匹配范围

# tail /etc/services |awk '/^blp5/,/^com/'

blp5 48129/tcp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw# seq 5 |awk '/3/,/^$/{printf /3/?"":$0"\n"}'

4

5

另一种判断真假的方式实现:

# seq 5 |awk '/3/{t=1;next}t'

4

5

1 和 2 都不匹配 3,不执行后面{},执行 t,t 变量还没赋值,为空,空在 awk 中就为假,就不打印

当前行。匹配到 3,执行 t=1,next 跳出,不执行 t。4 也不匹配 3,执行 t,t 的值上次赋值的 1, 为真,打印当前行,以此类推。(非 0 的数字都为真,所以 t 可以写任意非 0 数字)

如果想打印匹配行都最后一行,就可以这样了:

# seq 5 |awk '/3/{t=1}t'

3

4

5③ 内置变量

示例:

1)FS 和 OFS

在程序开始前重新赋值 FS 变量,改变默认分隔符为冒号,与-F一样。

# awk 'BEGIN{FS=":"}{print $1,$2}' /etc/passwd |head -n5

root x

bin x

daemon x

adm x

lp x

也可以使用-v 来重新赋值这个变量:

# awk -vFS=':' '{print $1,$2}' /etc/passwd |head -n5 # 中间逗号被换成了 OFS 的默

认值

root x

bin x

daemon x

adm x

lp x

由于 OFS 默认以空格分隔,反向引用多个字段分隔的也是空格,如果想指定输出分隔符这样:

# awk 'BEGIN{FS=":";OFS=":"}{print $1,$2}' /etc/passwd |head -n5

root:x

bin:x

daemon:x

adm:x

lp:x

也可以通过字符串拼接实现分隔:

# awk 'BEGIN{FS=":"}{print $1"#"$2}' /etc/passwd |head -n5

root#x

bin#x

daemon#x

adm#x

lp#x2)RS 和 ORS

RS 默认是\n 分隔每行,如果想指定以某个字符作为分隔符来处理记录:

# echo "www.baidu.com/user/test.html" |awk 'BEGIN{RS="/"}{print $0}'

www.baidu.com

user

test.html

RS 也支持正则,简单演示下:

# seq -f "str%02g" 10 |sed 'n;n;a\-----' |awk 'BEGIN{RS="-+"}{print $1}'

str01

str04

str07

str10

将输出的换行符替换为+号:

# seq 10 |awk 'BEGIN{ORS="+"}{print $0}'

1+2+3+4+5+6+7+8+9+10+

替换某个字符:

# tail -n2 /etc/services |awk 'BEGIN{RS="/";ORS="#"}{print $0}'

iqobject 48619#udp # iqobject

matahari 49000#tcp # Matahari Broker# echo "a b c d e f" |awk '{print NF}'

6

打印最后一个字段:

# echo "a b c d e f" |awk '{print $NF}'

f

打印倒数第二个字段:

# echo "a b c d e f" |awk '{print $(NF-1)}'

e

排除最后两个字段:

# echo "a b c d e f" |awk '{$NF="";$(NF-1)="";print $0}'

a b c d

排除第一个字段:

# echo "a b c d e f" |awk '{$1="";print $0}'

b c d e f4)NR 和 FNR

NR 统计记录编号,每处理一行记录,编号就会+1,FNR 不同的是在统计第二个文件时会重新计数。

打印行数:

# tail -n5 /etc/services |awk '{print NR,$0}'

1 com-bardac-dw 48556/tcp # com-bardac-dw

2 com-bardac-dw 48556/udp # com-bardac-dw

3 iqobject 48619/tcp # iqobject

4 iqobject 48619/udp # iqobject

5 matahari 49000/tcp # Matahari Broker

打印总行数:

# tail -n5 /etc/services |awk 'END{print NR}'

5

打印第三行:

# tail -n5 /etc/services |awk 'NR==3'

iqobject 48619/tcp # iqobject

打印第三行第二个字段:

# tail -n5 /etc/services |awk 'NR==3{print $2}'

48619/tcp

打印前三行:

# tail -n5 /etc/services |awk 'NR<=3{print NR,$0}'

1 com-bardac-dw 48556/tcp # com-bardac-dw

2 com-bardac-dw 48556/udp # com-bardac-dw

3 iqobject 48619/tcp # iqobject# cat a

a

b

c

# cat b

c

d

e

# awk '{print NR,FNR,$0}' a b

1 1 a

2 2 b

3 3 c

4 1 c

5 2 d

6 3 e可以看出 NR 每处理一行就会+1,而 FNR 在处理第二个文件时,编号重新计数。同时也知道 awk 处理两个文件时,是合并到一起处理。

# awk 'FNR==NR{print $0"1"}FNR!=NR{print $0"2"}' a b

a1

b1

c1

c2

d2

e2当 FNR==NR 时,说明在处理第一个文件内容,不等于时说明在处理第二个文件内容。

一般 FNR 在处理多个文件时会用到,下面会讲解。

5)ARGC 和 ARGV

ARGC 是命令行参数数量

ARGV 是将命令行参数存到数组,元素由 ARGC 指定,数组下标从 0 开始

# awk 'BEGIN{print ARGC}' 1 2 3

4

# awk 'BEGIN{print ARGV[0]}'

awk

# awk 'BEGIN{print ARGV[1]}' 1 2

1

# awk 'BEGIN{print ARGV[2]}' 1 2

26)ARGIND

ARGIND 是当前正在处理的文件索引值,第一个文件是 1,第二个文件是 2,以此类推,从而可以通过这种方式判断正在处理哪个文件。

# awk '{print ARGIND,$0}' a b

1 a

1 b

1 c

2 c

2 d

2 e

# awk 'ARGIND==1{print "a->"$0}ARGIND==2{print "b->"$0}' a b

a->a

a->b

a->c

b->c

b->d

b->e7)ENVIRON

ENVIRON 调用系统变量。

# awk 'BEGIN{print ENVIRON["HOME"]}'

/root

如果是设置的环境变量,还需要用 export 导入到系统变量才可以调用:

# awk 'BEGIN{print ENVIRON["a"]}'

# export a

# awk 'BEGIN{print ENVIRON["a"]}'

1238)FILENAME

FILENAME 是当前处理文件的文件名。

# awk 'FNR==NR{print FILENAME"->"$0}FNR!=NR{print FILENAME"->"$0}' a b a->a

a->b

a->c

b->c

b->d

b->e

9)忽略大小写

# echo "A a b c" |xargs -n1 |awk 'BEGIN{IGNORECASE=1}/a/'

Aa④ 操作符

须知: 在 awk 中,有 3 种情况表达式为假:数字是 0,空字符串和未定义的值。

数值运算,未定义变量初始值为 0。字符运算,未定义变量初始值为空。

举例测试:

# awk 'BEGIN{n=0;if(n)print "true";else print "false"}'

false

# awk 'BEGIN{s="";if(s)print "true";else print "false"}'

false

# awk 'BEGIN{if(s)print "true";else print "false"}'

false示例:

1)截取整数

# echo "123abc abc123 123abc123" |xargs -n1 | awk '{print +$0}'

123

0

123

# echo "123abc abc123 123abc123" |xargs -n1 | awk '{print -$0}'

-123

0-1232)感叹号

打印奇数行: # seq 6 |awk 'i=!i'

1

3

5

打印偶数行: # seq 6 |awk '!(i=!i)'

2

4

6读取第一行:i 是未定义变量,也就是 i=!0,!取反意思。感叹号右边是个布尔值,0 或空字符串为

假,非 0 或非空字符串为真,!0 就是真,因此 i=1,条件为真打印当前记录。

没有 print 为什么会打印呢?因为模式后面没有动作,默认会打印整条记录。

读取第二行:因为上次 i 的值由 0 变成了 1,此时就是 i=!1,条件为假不打印。

读取第三行:上次条件又为假,i 恢复初始值 0,取反,继续打印。以此类推...

可以看出,运算时并没有判断行内容,而是利用布尔值真假判断输出当前行。

3)不匹配某行

# tail /etc/services |awk '!/blp5/{print $0}'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

isnetserv 48128/udp # Image Systems Network Services

com-bardac-dw 48556/tcp # com-bardac-dw

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/tcp # iqobject

iqobject 48619/udp # iqobject

matahari 49000/tcp # Matahari Broker4)乘法和除法

# seq 5 |awk '{print $0*2}'

2

4

6

8

10

# seq 5 |awk '{print $0%2}'

1

0

1

0

1

打印偶数行: # seq 5 |awk '$0%2==0{print $0}'

2

4

打印奇数行: # seq 5 |awk '$0%2!=0{print $0}'

1

3

55)管道符使用

# seq 5 |shuf |awk '{print $0|"sort"}'

1

2

3

4

56)正则表达式匹配

# seq 5 |awk '$0~3{print $0}'

3

# seq 5 |awk '$0!~3{print $0}'

1

2

4

5

# seq 5 |awk '$0~/[34]/{print $0}'

3

4

# seq 5 |awk '$0!~/[34]/{print $0}'

1

2

5

# seq 5 |awk '$0~/[^34]/{print $0}'

1

2

57)判断数组成员

# awk 'BEGIN{a["a"]=123}END{if("a" in a)print "yes"}' # awk 'BEGIN{print 1==1?"yes":"no"}' # 三目运算作为一个表达式,里面不允许写 print

yes

# seq 3 |awk '{print $0==2?"yes":"no"}'

no

yes

no

替换换行符为逗号:

# seq 5 |awk '{print n=(n?n","$0:$0)}'

1

1,2

1,2,3

1,2,3,4

1,2,3,4,5

# seq 5 |awk '{n=(n?n","$0:$0)}END{print n}'

1,2,3,4,5

说明:读取第一行时,n 没有变量,为假输出$0 也就是 1,并赋值变量 n,读取第二行时,n 是 1 为

真,输出 1,2 以此类推,后面会一直为真。

每三行后面添加新一行:

# seq 10 |awk '{print NR%3?$0:$0 "\ntxt"}'

1

2

3

txt

4

5

6

txt

7

8

9

txt

10

在

两行合并一行:

# seq 6 |awk '{printf NR%2!=0?$0" ":$0" \n"}'

1 2

3 4

5 6

# seq 6 |awk 'ORS=NR%2?" ":"\n"'

1 2

3 4

5 6

# seq 6 |awk '{if(NR%2)ORS=" ";else ORS="\n";print}'9)变量赋值

字段求和:

# seq 5 |awk '{sum+=1}END{print sum}'

5

# seq 5 |awk '{sum+=$0}END{print sum}'

15⑤ 流程控制

1)if 语句

格式:

if (condition) statement [ else statement ]单分支:

# seq 5 |awk '{if($0==3)print $0}'

3

也支持正则匹配判断,一般在写复杂语句时使用:

# echo "123abc#456cde 789aaa#aaabbb " |xargs -n1 |awk -F# '{if($2~/[0-9]/)print $2}'

456cde

# echo "123abc#456cde 789aaa#aaabbb " |xargs -n1 |awk -F# '{if($2!~/[0-9]/)print $2}'

aaabbb

或

# echo "123abc#456cde 789aaa#aaabbb" |xargs -n1 |awk -F# '$2!~/[0-9]/{print $2}'

aaabbb

双分支:

# seq 5 |awk '{if($0==3)print $0;else print "no"}'

no

no

3

no

no

多分支:

# cat file

1 2 3

4 5 6

7 8 9

# awk '{if($1==4){print "1"} else if($2==5){print "2"} else if($3==6){print "3"} else

{print "no"}}' file

no

1

no

2)while 语句

格式:

while (condition) statement遍历打印所有字段:

# awk '{i=1;while(i<=NF){print $i;i++}}' file

1

2

3

4

5

6

7

8

9awk 是按行处理的,每次读取一行,并遍历打印每个字段。

3)for 语句 C 语言风格

格式:

for (expr1; expr2; expr3) statement遍历打印所有字段:

# cat file

1 2 3

4 5 6

7 8 9

# awk '{for(i=1;i<=NF;i++)print $i}' file

1

2

3

4

5

6

7

8

9

倒叙打印文本:

# awk '{for(i=NF;i>=1;i--)print $i}' file

3

2

1

6

5

4

9

8

7

都换行了,这并不是我们要的结果。怎么改进呢?

# awk '{for(i=NF;i>=1;i--){printf $i" "};print ""}' file # print 本身就会新打印一行

3 2 1

6 5 4

9 8 7

或

# awk '{for(i=NF;i>=1;i--)if(i==1)printf $i"\n";else printf $i" "}' file

3 2 1

6 5 4

9 8 7

在这种情况下,是不是就排除第一行和倒数第一行呢?我们正序打印看下

排除第一行:

# awk '{for(i=2;i<=NF;i++){printf $i" "};print ""}' file

2 3

5 6

8 9

排除第二行:

# awk '{for(i=1;i<=NF-1;i++){printf $i" "};print ""}' file

1 2

4 5

7 8

IP 加单引号:

# echo '10.10.10.1 10.10.10.2 10.10.10.3' |awk '{for(i=1;i<=NF;i++)printf

"\047"$i"\047"}

'10.10.10.1' '10.10.10.2' '10.10.10.3'

\047 是 ASCII 码,可以通过 showkey -a 命令查看。4)for 语句遍历数组

格式:

for (var in array) statement# seq -f "str%.g" 5 |awk '{a[NR]=$0}END{for(v in a)print v,a[v]}'

4 str4

5 str5

1 str1

2 str2

3 str35)break 和 continue 语句

break 跳过所有循环,continue 跳过当前循环。

# awk 'BEGIN{for(i=1;i<=5;i++){if(i==3){break};print i}}'

1

2

# awk 'BEGIN{for(i=1;i<=5;i++){if(i==3){continue};print i}}'

1

2

4

56)删除数组和元素

格式:

delete array[index] 删除数组元素

delete array 删除数组# seq -f "str%.g" 5 |awk '{a[NR]=$0}END{delete a;for(v in a)print v,a[v]}'

空的…

# seq -f "str%.g" 5 |awk '{a[NR]=$0}END{delete a[3];for(v in a)print v,a[v]}'

4 str4

5 str5

1 str1

2 str27)exit 语句

格式:

exit [ expression ]exit 退出程序,与 shell 的 exit 一样。[ expr ]是 0-255 之间的数字。

# seq 5 |awk '{if($0~/3/)exit (123)}'

# echo $?

123⑥ 数组

数组:存储一系列相同类型的元素,键/值方式存储,通过下标(键)来访问值。

awk 中数组称为关联数组,不仅可以使用数字作为下标,还可以使用字符串作为下标。

数组元素的键和值存储在 awk 程序内部的一个表中,该表采用散列算法,因此数组元素是随机排

序。

数组格式:

array[index]=value1)自定义数组

# awk 'BEGIN{a[0]="test";print a[0]}'

test2)通过 NR 设置记录下标,下标从 1 开始

# tail -n3 /etc/passwd |awk -F: '{a[NR]=$1}END{print a[1]}'

systemd-network

# tail -n3 /etc/passwd |awk -F: '{a[NR]=$1}END{print a[2]}'

zabbix

# tail -n3 /etc/passwd |awk -F: '{a[NR]=$1}END{print a[3]}'

user# tail -n5 /etc/passwd |awk -F: '{a[NR]=$1}END{for(v in a)print a[v],v}'

zabbix 4

user 5

admin 1

systemd-bus-proxy 2

systemd-network 3

# tail -n5 /etc/passwd |awk -F: '{a[NR]=$1}END{for(i=1;i<=NR;i++)print a[i],i}'

admin 1

systemd-bus-proxy 2

systemd-network 3

zabbix 4

user 5上面打印的 i 是数组的下标。

第一种 for 循环的结果是乱序的,刚说过,数组是无序存储。

第二种 for 循环通过下标获取的情况是排序正常。

所以当下标是数字序列时,还是用 for(expr1;expr2;expr3)循环表达式比较好,保持顺序不变。

4)通过++方式作为下标

# tail -n5 /etc/passwd |awk -F: '{a[x++]=$1}END{for(i=0;i<=x-1;i++)print a[i],i}'

admin 0

systemd-bus-proxy 1

systemd-network 2

zabbix 3

user 4x 被 awk 初始化值是 0,没循环一次+1

5)使用字段作为下标

# tail -n5 /etc/passwd |awk -F: '{a[$1]=$7}END{for(v in a)print a[v],v}'

/sbin/nologin admin

/bin/bash user

/sbin/nologin systemd-network

/sbin/nologin systemd-bus-proxy

/sbin/nologin zabbix6)统计相同字段出现次数

# tail /etc/services |awk '{a[$1]++}END{for(v in a)print a[v],v}'

2 com-bardac-dw

1 3gpp-cbsp

2 iqobject

1 matahari

2 isnetserv

2 blp5

# tail /etc/services |awk '{a[$1]+=1}END{for(v in a)print a[v],v}'

2 com-bardac-dw

1 3gpp-cbsp

2 iqobject

1 matahari

2 isnetserv

2 blp5

# tail /etc/services |awk '/blp5/{a[$1]++}END{for(v in a)print a[v],v}'

2 blp5第一个字段作为下标,值被++初始化是 0,每次遇到下标(第一个字段)一样时,对应的值就会被

+1,因此实现了统计出现次数。

想要实现去重的的话就简单了,只要打印下标即可。

7)统计 TCP 连接状态

# netstat -antp |awk '/^tcp/{a[$6]++}END{for(v in a)print a[v],v}'

9 LISTEN

6 ESTABLISHED

6 TIME_WAIT8)只打印出现次数大于等于 2 的

# tail /etc/services |awk '{a[$1]++}END{for(v in a) if(a[v]>=2){print a[v],v}}'

2 com-bardac-dw

2 iqobject

2 isnetserv

2 blp59)去重

只打印重复的行:

# tail /etc/services |awk 'a[$1]++'

isnetserv 48128/udp # Image Systems Network Services

blp5 48129/udp # Bloomberg locator

com-bardac-dw 48556/udp # com-bardac-dw

iqobject 48619/udp # iqobject

不打印重复的行:

# tail /etc/services |awk '!a[$1]++'

3gpp-cbsp 48049/tcp # 3GPP Cell Broadcast Service

isnetserv 48128/tcp # Image Systems Network Services

blp5 48129/tcp # Bloomberg locator

com-bardac-dw 48556/tcp # com-bardac-dw

iqobject 48619/tcp # iqobject

matahari 49000/tcp # Matahari Broker先明白一个情况,当值是 0 是为假,非 0 整数为真,知道这点就不难理解了。

只打印重复的行说明:当处理第一条记录时,执行了++,初始值是 0 为假,就不打印,如果再遇到相同的记录,值就会+1,不为 0,则打印。

不打印重复的行说明:当处理第一条记录时,执行了++,初始值是 0 为假,感叹号取反为真,打

印,如果再遇到相同的记录,值就会+1,不为 0 为真,取反为假就不打印。

# tail /etc/services |awk '{if(a[$1]++)print $1}'

isnetserv

blp5

com-bardac-dw

iqobject

使用三目运算:

# tail /etc/services |awk '{print a[$1]++?$1:"no"}'

no

no

isnetserv

no

blp5

no

com-bardac-dw

no

iqobject

no

# tail /etc/services |awk '{if(!a[$1]++)print $1}'

3gpp-cbsp

isnetserv

blp5

com-bardac-dw

iqobject

matahari10)统计每个相同字段的某字段总数:

# tail /etc/services |awk -F'[ /]+' '{a[$1]+=$2}END{for(v in a)print v, a[v]}'

com-bardac-dw 97112

3gpp-cbsp 48049

iqobject 97238

matahari 49000

isnetserv 96256

blp5 9625811)多维数组

awk 的多维数组,实际上 awk 并不支持多维数组,而是逻辑上模拟二维数组的访问方式,比如

a[a,b]=1,使用 SUBSEP(默认\034)作为分隔下标字段,存储后是这样 a\034b。

示例:

# awk 'BEGIN{a["x","y"]=123;for(v in a) print v,a[v]}'

xy 123

我们可以重新复制 SUBSEP 变量,改变下标默认分隔符:

# awk 'BEGIN{SUBSEP=":";a["x","y"]=123;for(v in a) print v,a[v]}'

x:y 123

根据指定的字段统计出现次数:

# cat file

A 192.168.1.1 HTTP

B 192.168.1.2 HTTP

B 192.168.1.2 MYSQL

C 192.168.1.1 MYSQL

C 192.168.1.1 MQ

D 192.168.1.4 NGINX

# awk 'BEGIN{SUBSEP="-"}{a[$1,$2]++}END{for(v in a)print a[v],v}' file

1 D-192.168.1.4

1 A-192.168.1.1

2 C-192.168.1.1

2 B-192.168.1.2⑦ 内置函数

示例:

1)int()

截断为整数: # echo -e "123abc\nabc123\n123abc123" | awk '{print int($0)}'

123

0

123

# awk 'BEGIN{print int(10/3)}'

32)sqrt()

获取 9 的平方根:

# awk 'BEGIN{print sqrt(9)}'

33)rand()和 srand()

rand()并不是每次运行就是一个随机数,会一直保持一个不变:

# awk 'BEGIN{print rand()}'

0.237788

当执行 srand()函数后,rand()才会发生变化,所以一般在 awk 着两个函数结合生成随机数,但是

也有很大几率生成一样:

# awk 'BEGIN{srand();print rand()}'

0.31687

如果想生成 1-10 的随机数可以这样:

# awk 'BEGIN{srand();print int(rand()*10)}'

4如果想更完美生成随机数,还得做相应的处理!

4)asort()和 asorti()

排序数组:

# seq -f "str%.g" 5 |awk '{a[x++]=$0}END{s=asort(a,b);for(i=1;i<=s;i++)print

b[i],i}'

str1 1

str2 2

str3 3

str4 4

str5 5

# seq -f "str%.g" 5 |awk '{a[x++]=$0}END{s=asorti(a,b);for(i=1;i<=s;i++)print

b[i],i}'

0 1

1 2

2 3

3 4

4 5asort 将 a 数组的值放到数组 b,a 下标丢弃,并将数组 b 的总行号赋值给 s,新数组 b 下标从 1 开始,然后遍历。

5)sub()和 gsub()

替换正则匹配的字符串:

# tail /etc/services |awk '/blp5/{sub(/tcp/,"icmp");print $0}'

blp5 48129/icmp # Bloomberg locator

blp5 48129/udp # Bloomberg locator

# tail /etc/services |awk '/blp5/{gsub(/c/,"9");print $0}'

blp5 48129/t9p # Bloomberg lo9ator

blp5 48129/udp # Bloomberg lo9ator

# echo "1 2 2 3 4 5" |awk 'gsub(2,7,$2){print $0}'

1 7 2 3 4 5

# echo "1 2 3 a b c" |awk 'gsub(/[0-9]/, '0'){print $0}'

0 0 0 a b c在指定行前后加一行:

# seq 5 | awk 'NR==2{sub('/.*/',"txt\n&")}{print}'

1

txt

2

3

4

5

# seq 5 | awk 'NR==2{sub('/.*/',"&\ntxt")}{print}'

1

2

txt

3

4

56)index()

获取字段索引起始位置:

# tail -n 5 /etc/services |awk '{print index($2,"tcp")}'

7

0

7

0

77)length()

统计字段长度:

# tail -n 5 /etc/services |awk '{print length($2)}'

9

9

9

9

9

统计数组的长度:

# tail -n 5 /etc/services |awk '{a[$1]=$2}END{print length(a)}'

38)match

# echo "123abc#456cde 789aaa#234bbb 999aaa#aaabbb" |xargs -n1 |awk '{print

match($0,234)}'

0

8

0

如果记录匹配字符串 234,则返回索引位置,否则返回 0。

那么,我们只想打印包含这个字符串的记录就可以这样:

# echo "123abc#456cde 789aaa#234bbb 999aaa#aaabbb" |xargs -n1 |awk

'{if(match($0,234)!=0)print $0}'

789aaa#234bbb9)split()

切分记录为数组 a: # echo -e "123#456#789\nabc#cde#fgh" |awk '{split($0,a);for(v in a)print a[v],v}'

123#456#789 1

abc#cde#fgh 1

以#号切分记录为数据 a:

# echo -e "123#456#789\nabc#cde#fgh" |awk '{split($0,a,"#");for(v in a)print a[v],v}'

123 1

456 2

789 3

abc 1

cde 2

fgh 310)substr()

截取字符串索引 4 到最后:

# echo -e "123#456#789\nabc#cde#fgh" |awk '{print

substr($0,4)}'

#456#789

#cde#fgh

截取字符串索引 4 到长度 5:

# echo -e "123#456#789\nabc#cde#fgh" |awk '{print substr($0,4,5)}'

#456#

#cde#11)tolower()和 toupper()

转换小写:

# echo -e "123#456#789\nABC#cde#fgh" |awk '{print tolower($0)}'

123#456#789

abc#cde#fgh

转换大写:

# echo -e "123#456#789\nabc#cde#fgh" |awk '{print toupper($0)}'

123#456#789

ABC#CDE#FGH12)时间处理

返回当前时间戳:

# awk 'BEGIN{print systime()}'

1483297766

将时间戳转为日期和时间

# echo "1483297766" |awk '{print strftime("%Y-%m-%d %H:%M:%S",$0)}'

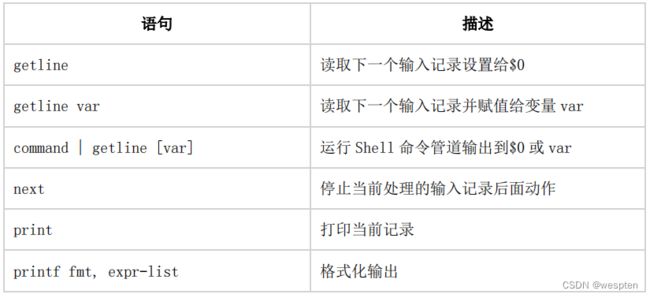

2017-01-01 14:09:26⑧ I/O 语句

示例:

1)getline

获取匹配的下一行:

# seq 5 |awk '/3/{getline;print}'

4

# seq 5 |awk '/3/{print;getline;print}'

3

4

在匹配的下一行加个星号:

# seq 5 |awk '/3/{getline;sub(".*","&*");print}'

4*

# seq 5 |awk '/3/{print;getline;sub(".*","&*")}{print}'

1

2

3

4*

52)getline var

把 a 文件的行追加到 b 文件的行尾:

# cat a

a

b

c

# cat b

1 one

2 two

3 three

# awk '{getline line<"a";print $0,line}' b

1 one a

2 two b

3 three c

把 a 文件的行替换 b 文件的指定字段:

# awk '{getline line<"a";gsub($2,line,$2);print}' b

1 a

2 b

3 c

把 a 文件的行替换 b 文件的对应字段:

# awk '{getline line<"a";gsub("two",line,$2);print}' b

1 one

2 b

3 three3)command | getline [var]

获取执行 shell 命令后结果的第一行:

# awk 'BEGIN{"seq 5"|getline var;print var}'

1

循环输出执行 shell 命令后的结果:

# awk 'BEGIN{while("seq 5"|getline)print}'

1

2

3

4

54)next

不打印匹配行:

# seq 5 |awk '{if($0==3){next}else{print}}'

1

2

4

5

删除指定行:

# seq 5 |awk 'NR==1{next}{print $0}'

2

3

4

5

如果前面动作成功,就遇到 next,后面的动作不再执行,跳过。

或者:

# seq 5 |awk 'NR!=1{print}'

2

3

4

5

把第一行内容放到每行的前面:

# cat a

hello

1 a

2 b

3 c

# awk 'NR==1{s=$0;next}{print s,$0}' a

hello 1 a

hello 2 b

hello 3 c

# awk 'NR==1{s=$0}NF!=1{print s,$0}' a

hello 1 a

hello 2 b

hello 3 c5)system()

执行 shell 命令判断返回值:

# awk 'BEGIN{if(system("grep root /etc/passwd &>/dev/null")==0)print "yes";else print

"no"}'

yes6)打印结果写到文件

# tail -n5 /etc/services |awk '{print $2 > "a.txt"}'

# cat a.txt

48049/tcp

48128/tcp

48128/udp

48129/tcp

48129/udp7)管道连接 shell 命令

将结果通过 grep 命令过滤:

# tail -n5 /etc/services |awk '{print $2|"grep tcp"}'

48556/tcp

48619/tcp

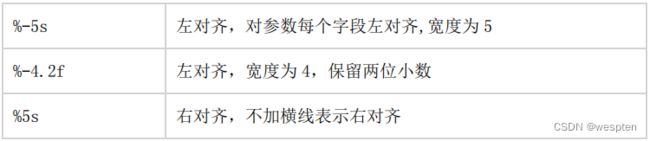

49000/tcp⑨ printf 语句

格式化输出,默认打印字符串不换行。

格式:

printf [format] arguments示例:

将换行符换成逗号:

# seq 5 |awk '{if($0!=5)printf "%s,",$0;else print $0}'

1,2,3,4,5

小括号中的 5 是最后一个数字。

输出一个字符:

# awk 'BEGIN{printf "%.1s\n","abc"}'

a

保留一个小数点:

# awk 'BEGIN{printf "%.2f\n",10/3}'

3.33

格式化输出:

# awk 'BEGIN{printf "user:%s\tpass:%d\n","abc",123}'

user:abc pass:123

左对齐宽度 10:

# awk 'BEGIN{printf "%-10s %-10s %-10s\n","ID","Name","Passwd"}'

ID Name Passwd

右对齐宽度 10:

# awk 'BEGIN{printf "%10s %10s %10s\n","ID","Name","Passwd"}'

ID Name Passwd

打印表格:

# vi test.awk

BEGIN{

print "+--------------------+--------------------+";

printf "|%-20s|%-20s|\n","Name","Number";

print "+--------------------+--------------------+";

}

# awk -f test.awk

+--------------------+--------------------+

|Name |Number |

+--------------------+--------------------+

格式化输出:

# awk -F: 'BEGIN{printf "UserName\t\tShell\n-----------------------------\n"}{printf

"%-20s %-20s\n",$1,$7}END{print "END...\n"}' /etc/passwd

打印十六进制:

# awk 'BEGIN{printf "%x %X",123,123}'

7b 7B⑩ 自定义函数

格式:

function name(parameter list) { statements }示例:

# awk 'function myfunc(a,b){return a+b}BEGIN{print myfunc(1,2)}'

3⑪ 需求案例

1)分析 Nginx 日志

日志格式:

'$remote_addr - $remote_user [$time_local] "$request" $status $body_bytes_sent "

$http_referer" "$http_user_agent" "$http_x_forwarded_for"'统计访问 IP 次数:

# awk '{a[$1]++}END{for(v in a)print v,a[v]}' access.log

统计访问访问大于 100 次的 IP:

# awk '{a[$1]++}END{for(v in a){if(a[v]>100)print v,a[v]}}' access.log

统计访问 IP 次数并排序取前 10:

# awk '{a[$1]++}END{for(v in a)print v,a[v] |"sort -k2 -nr |head -10"}' access.log

统计时间段访问最多的 IP:

# awk '$4>="[02/Jan/2017:00:02:00" && $4<="[02/Jan/2017:00:03:00"{a[$1]++}END{for(v in

a)print v,a[v]}' access.log

统计上一分钟访问量:

# date=$(date -d '-1 minute' +%d/%d/%Y:%H:%M)

# awk -vdate=$date '$4~date{c++}END{print c}' access.log

统计访问最多的 10 个页面:

# awk '{a[$7]++}END{for(v in a)print v,a[v] |"sort -k1 -nr|head -

n10"}' access.log

统计每个 URL 数量和返回内容总大小:

# awk '{a[$7]++;size[$7]+=$10}END{for(v in a)print a[v],v,size[v]}' access.log

统计每个 IP 访问状态码数量:

# awk '{a[$1" "$9]++}END{for(v in a)print v,a[v]}' access.log

统计访问 IP 是 404 状态次数:

# awk '{if($9~/404/)a[$1" "$9]++}END{for(i in a)print v,a[v]}' access.log2)两个文件对比

找出 b 文件在 a 文件相同记录:

# seq 1 5 > a

# seq 3 7 > b

方法 1:

# awk 'FNR==NR{a[$0];next}{if($0 in a)print $0}' a b

3

4

5

# awk 'FNR==NR{a[$0];next}{if($0 in a)print FILENAME,$0}' a b

b 3

b 4

b 5

# awk 'FNR==NR{a[$0]}NR>FNR{if($0 in a)print $0}' a b

3

4

5

# awk 'FNR==NR{a[$0]=1;next}(a[$0]==1)' a b # a[$0]是通过 b 文件每行获取值,如果是 1

说明有

# awk 'FNR==NR{a[$0]=1;next}{if(a[$0]==1)print}' a b

3

4

5

方法 2: # awk 'FILENAME=="a"{a[$0]}FILENAME=="b"{if($0 in a)print $0}' a b

3

4

5

方法 3: # awk 'ARGIND==1{a[$0]=1}ARGIND==2 && a[$0]==1' a b

3

4

5找出 b 文件在 a 文件不同记录:

方法 1:

# awk 'FNR==NR{a[$0];next}!($0 in a)' a b

6

7

# awk 'FNR==NR{a[$0]=1;next}(a[$0]!=1)' a b

# awk 'FNR==NR{a[$0]=1;next}{if(a[$0]!=1)print}' a b

6

7

方法 2: # awk 'FILENAME=="a"{a[$0]=1}FILENAME=="b" && a[$0]!=1' a b

方法 3: # awk 'ARGIND==1{a[$0]=1}ARGIND==2 && a[$0]!=1' a b3)合并两个文件

将 a 文件合并到 b 文件:

# cat a

zhangsan 20

lisi 23

wangwu 29

# cat b

zhangsan man

lisi woman

wangwu man

# awk 'FNR==NR{a[$1]=$0;next}{print a[$1],$2}' a b

zhangsan 20 man

lisi 23 woman

wangwu 29 man

# awk 'FNR==NR{a[$1]=$0}NR>FNR{print a[$1],$2}' a b

zhangsan 20 man

lisi 23 woman

wangwu 29 man将 a 文件相同 IP 的服务名合并:

# cat a

192.168.1.1: httpd

192.168.1.1: tomcat

192.168.1.2: httpd

192.168.1.2: postfix

192.168.1.3: mysqld

192.168.1.4: httpd

# awk 'BEGIN{FS=":";OFS=":"}{a[$1]=a[$1] $2}END{for(v in a)print v,a[v]}' a

192.168.1.4: httpd

192.168.1.1: httpd tomcat

192.168.1.2: httpd postfix

192.168.1.3: mysqld说明:数组 a 存储是$1=a[$1] $2,第一个 a[$1]是以第一个字段为下标,值是 a[$1] $2,也就是

$1=a[$1] $2,值的 a[$1]是用第一个字段为下标获取对应的值,但第一次数组 a 还没有元素,那么

a[$1]是空值,此时数组存储是 192.168.1.1=httpd,再遇到 192.168.1.1 时,a[$1]通过第一字段

下标获得上次数组的 httpd,把当前处理的行第二个字段放到上一次同下标的值后面,作为下标

192.168.1.1 的新值。此时数组存储是 192.168.1.1=httpd tomcat。每次遇到相同的下标(第一个

字段)就会获取上次这个下标对应的值与当前字段并作为此下标的新值。

4)将第一列合并到一行

# cat file

1 2 3

4 5 6

7 8 9

# awk '{for(i=1;i<=NF;i++)a[i]=a[i]$i" "}END{for(v in a)print a[v]}' file

1 4 7

2 5 8

3 6 9说明:

for 循环是遍历每行的字段,NF 等于 3,循环 3 次。

读取第一行时:

第一个字段:a[1]=a[1]1" " 值 a[1]还未定义数组,下标也获取不到对应的值,所以为空,因此a[1]=1 。

第二个字段:a[2]=a[2]2" " 值 a[2]数组 a 已经定义,但没有 2 这个下标,也获取不到对应的

值,为空,因此 a[2]=2 。

第三个字段:a[3]=a[3]3" " 值 a[2]与上面一样,为空,a[3]=3 。

读取第二行时:

第一个字段:a[1]=a[1]4" " 值 a[2]获取数组 a 的 2 为下标对应的值,上面已经有这个下标了,

对应的值是 1,因此 a[1]=1 4

第二个字段:a[2]=a[2]5" " 同上,a[2]=2 5

第三个字段:a[3]=a[3]6" " 同上,a[2]=3 6

读取第三行时处理方式同上,数组最后还是三个下标,分别是 1=1 4 7,2=2 5 8,3=3 6 9。最后

for 循环输出所有下标值。

5)字符串拆分,统计出现的次数

字符串拆分:

方法 1: # echo "hello world" |awk -F '' '{print $1}'

h

# echo "hello" |awk -F '' '{for(i=1;i<=NF;i++)print $i}'

h

e

l

l

o

方法 2:

# echo "hello" |awk '{split($0,a,"''");for(v in a)print a[v]}'

l

o

h

e

l统计字符串中每个字母出现的次数:

# echo "a.b.c,c.d.e" |awk -F '[.,]' '{for(i=1;i<=NF;i++)a[$i]++}END{for(v in a)print

v,a[v]}'

a 1

b 1

c 2

d 1

e 16)统计平均成绩

# cat file

job 80

dave 84

tom 75

dave 73

job 72

tom 83

dave 88

# awk '{a[$1]+=$2;b[$1]++}END{for(i in a)print i,a[i]/b[i]}' file

job 76

dave 81.6667

tom 797)费用统计

# cat file

zhangsan 8000 1

zhangsan 5000 1

lisi 1000 1

lisi 2000 1

wangwu 1500 1

zhaoliu 6000 1

zhaoliu 2000 1

zhaoliu 3000 1

# awk '{name[$1]++;cost[$1]+=$2;number[$1]+=$3}END{for(v in name)print

v,cost[v],number[v]}' file

zhangsan 5000 1

lisi 3000 2

wangwu 1500 1

zhaoliu 11000 3# cat file

a b 1

c d 2

e f 3

g h 3

i j 2

获取第三字段最大值:

# awk 'BEGIN{max=0}{if($3>max)max=$3}END{print max}' file

3

打印第三字段最大行:

# awk 'BEGIN{max=0}{a[$0]=$3;if($3>max)max=$3}END{for(v in a)print v,a[v],max}' a

g h 3 3 3

e f 3 3 3

c d 2 2 3

a b 1 1 3

i j 2 2 3

# awk 'BEGIN{max=0}{a[$0]=$3;if($3>max)max=$3}END{for(v in a)if(a[v]==max)print v}' a

g h 3

e f 39)去除第一行和最后一行

# seq 5 |awk 'NR>2{print s}{s=$0}'

2

3

4读取第一行,NR=1,不执行 print s,s=1

读取第二行,NR=2,不执行 print s,s=2 (大于为真)

读取第三行,NR=3,执行 print s,此时 s 是上一次 p 赋值内容 2,s=3

最后一行,执行 print s,打印倒数第二行,s=最后一行

获取 Nginx 负载均衡配置端 IP 和端口:

# cat nginx.conf

upstream example-servers1 {

server 127.0.0.1:80 weight=1 max_fails=2 fail_timeout=30s;

}

upstream example-servers2 {

server 127.0.0.1:80 weight=1 max_fails=2 fail_timeout=30s;

server 127.0.0.1:82 backup;

}

# awk '/example-servers1/,/}/{if(NR>2){print s}{s=$2}}' nginx.conf

127.0.0.1:80

# awk '/example-servers1/,/}/{if(i>1)print s;s=$2;i++}' nginx.conf

# awk '/example-servers1/,/}/{if(i>1){print s}{s=$2;i++}}' nginx.conf

127.0.0.1:80读取第一行,i 初始值为 0,0>1 为假,不执行 print s,x=example-servers1,i=1

读取第二行,i=1,1>1 为假,不执行 print s,s=127.0.0.1:80,i=2

读取第三行,i=2,2>1 为真,执行 print s,此时 s 是上一次 s 赋值内容 127.0.0.1:80,i=3

最后一行,执行 print s,打印倒数第二行,s=最后一行。

这种方式与上面一样,只是用 i++作为计数器。

10)知道上述方式,就可以实现这种需求了,打印匹配行的上一行

# seq 5 |awk '/3/{print s}{s=$0}'

2详情,请参考:The GNU Awk User’s Guide

八、Shell标准输入与输出重定向

文件描述符(fd):文件描述符是一个非负整数,在打开现存文件或新建文件时,内核会返回一个

文件描述符,读写文件也需要使用文件描述符来访问文件。

内核为每个进程维护该进程打开的文件记录表。文件描述符只适于 Unix、Linux 操作系统。

① 标准输入、输出和错误

② 重定向符号

输入和输出可以被重定向符号解释到 shell。

shell 命令是从左到右依次执行命令。

下面 n 字母是文件描述符。

③ 重定向输出

一般格式:

[n]>word如果 n 没有指定,默认是 1

打印结果写到文件:

# echo "test" > a.txt

当没有安装 bc 计算器时,错误输出结果写到文件:

# echo "1 + 1" |bc 2 > error.log2)追加重定向输出

一般格式:

[n]>>word如果 n 没有指定,默认是 1。

示例:

打印结果追加到文件:

# echo "test" >> a.txt

当没有安装 bc 计算器时,错误输出结果追加文件:

# echo "1 + 1" |bc 2 > error.log④ 重定向输入

一般格式:

[n]如果 n 没有指定,默认是 0

示例:

a.txt 内容作为 grep 输入:

# grep "test" --color < a.txt⑤ 重定向标准输出和标准错误

当不确定执行对错时都覆盖到文件:

# echo "1 + 1" |bc &> error.log

当不确定执行对错时都覆盖到文件:

# echo "1 + 1" |bc > error.log 2>&12)追加重定向标准输出和标准错误

&>>word 等价于>>word 2>&1

示例:

当不确定执行对错时都追加文件:

# echo "1 + 1" |bc &>> error.log<< delimiter

here-document

delimiter从当前 shell 读取输入源,直到遇到一行只包含 delimiter 终止,内容作为标准输入。

将 eof 标准输入作为 cat 标准输出再写到 a.txt:

# cat << eof

123

abc

eof

123

abc

# cat > a.txt << eof

> 123

> abc

> eof⑥ 重定向到空设备

/dev/null 是一个空设备,向它写入的数组都会丢弃,但返回状态是成功的。与其对应的还有一个

/dev/zero 设备,提供无限的 0 数据流。

在写 Shell 脚本时我们经常会用到/dev/null 设备,将 stdout、stderr 输出给它,也就是我们不想

要这些输出的数据。

通过重定向到/dev/null 忽略输出,比如我们没有安装 bc 计算器,正常会抛出没有发现命令:

# echo "1 + 1" |bc >/dev/null 2>&1这就让标准和错误输出到了空设备。

忽略标准输出:

# echo "test" >/dev/null忽略错误输出:

# echo "1 + 1" |bc 2>/dev/null⑦ read 命令

read 命令从标准输入读取,并把输入的内容复制给变量。

命令格式:

read [-ers] [-a array] [-d delim] [-i text] [-n nchars] [-N nchars] [-p

prompt] [-t timeout] [-u fd] [name ...]![]()

示例:

获取用户输入保存到变量:

# read -p "Please input your name: " VAR

Please input your name: lizhenliang

# echo $VAR

lizhenliang

用户输入保存为数组:

# read -p "Please input your name: " -a ARRAY

Please input your name: a b c # echo ${ARRAY[*]}

a b c

遇到 e 字符返回:

# read -d e VAR

123

456

e# echo $VAR

123 456

从文件作为 read 标准输入:

# cat a.txt

adfasfd

# read VAR < a.txt

# echo $VAR

adfasfd

while 循环读取每一行作为 read 的标准输入:

# cat a.txt |while read LINE; do echo $LINE; done

123

abc

分别变量赋值:

# read a b c 1 2 3 # echo $a

1

# echo $b

2

# echo $c

3# echo 1 2 3 | while read a b c;do echo "$a $b $c"; done

1 2 3九、Shell信号发送与捕捉

1、Linux 信号类型

信号(Signal):信号是在软件层次上对中断机制的一种模拟,通过给一个进程发送信号,执行相

应的处理函数。

进程可以通过三种方式来响应一个信号:

1)忽略信号,即对信号不做任何处理,其中有两个信号不能忽略:SIGKILL 及 SIGSTOP。

2)捕捉信号。

3)执行缺省操作,Linux 对每种信号都规定了默认操作。

Linux 究竟采用上述三种方式的哪一个来响应信号呢?取决于传递给响应的 API 函数。

Linux 支持的信号有:

CoreDump(核心转储):当程序运行过程中异常退出时,内核把当前程序在内存状况存储在一个

core 文件中,以便调试。执行命令 ulimit -c 如果是 0 则没有开启,也不会生成 core dump 文件,

可通过 ulimit -c unlimited 命令临时开启 core dump 功能,只对当前终端环境有效,如果想永久

生效,可修改/etc/security/limites.conf 文件,添加一行 "* soft core unlimited"

默认生成的 core 文件保存在可执行文件所在的目录下,文件名为 core。

如果想修改 core 文件保存路径,可通过修改内核参数:echo "/tmp/corefile-%e-%p-%t" > /proc/sys/kernel/core_pattern,则文件名格式为 core-命名名-pid-时间戳。

Linux 支持两种信号:

一种是标准信号,编号 1-31,称为非可靠信号(非实时),不支持队列,信号可能会丢失,比如发送多次相同的信号,进程只能收到一次,如果第一个信号没有处理完,第二个信号将会丢弃。

另一种是扩展信号,编号 32-64,称为可靠信号(实时),支持队列,发多少次进程就可以收到多

少次。

信号类型比较多,我们只要了解下,记住几个常用信号就行了,红色标记的我觉得需要记下。

发送信号一般有两种情况:

一种是内核检测到系统事件,比如键盘输入 CTRL+C 会发送 SIGINT 信号。另一种是通过系统调用 kill 命令来向一个进程发送信号。

2、kill 命令

kill 命令发送信号给进程。

命令格式:

kill [-s sigspec | -n signum | -sigspec] pid | jobspec ... kill -l [sigspec]

-s # 信号名称

-n # 信号编号

-l # 打印编号 1-31 信号名称示例:

给一个进程发送终止信号:

kill -s SIGTERM pid

或

kill -n 15 pid

或

kill -15 pid

或

kill -TREM pid3、trap 命令

trap 命令定义 shell 脚本在运行时根据接收的信号做相应的处理。

命令格式:

trap [-lp] [[arg] signal_spec ...]

-l # 打印编号 1-64 编号信号名称

arg # 捕获信号后执行的命令或者函数

signal_spec # 信号名或编号一般捕捉信号后,做以下几个动作:

1)清除临时文件

2)忽略该信号

3)询问用户是否终止脚本执行

示例 1:按 CTRL+C 不退出循环

#!/bin/bash

trap "" 2 # 不指定 arg 就不做任何操作,后面也可以写多个信号,以空格分隔

for i in {1..10}; do

echo $i

sleep 1

done

# bash a.sh

1

2

3

^C4

56

^C7

8

9

10#!/bin/bash

trap "echo 'exit...';exit" 2

for i in {1..10}; do

echo $i

sleep 1

done

# bash test.sh

1

2

3

^Cexit...示例 3:让用户选择是否终止循环

#!/bin/bash

trap "func" 2

func() {

read -p "Terminate the process? (Y/N): " input

if [ $input == "Y" ]; then

exit

fi

}

for i in {1..10}; do

echo $i

sleep 1

done

# bash a.sh

1

2

3

^CTerminate the process? (Y/N): Y

# bash a.sh

1

2

3

^CTerminate the process? (Y/N): N

4

5

6

...十、Shell编程时常用的系统文件

1、Linux 系统目录结构

2、环境变量文件

① 系统级

系统级变量文件对所有用户生效。

/etc/profile # 系统范围内的环境变量和启动文件。不建议把要做的事情写在这里面,最好创建

一个自定义的,放在/etc/profile.d 下。

/etc/bashrc # 系统范围内的函数和别名。

② 用户级

用户级变量文件对自己生效,都在自己家目录下:

~/.bashrc # 用户指定别名和函数

~/.bash_logout # 用户退出执行

~/.bash_profile # 用户指定变量和启动程序

~/.bash_history # 用户执行命令历史文件

开启启动脚本顺序:/etc/profile -> /etc/profile.d/*.sh -> ~/.bash_profile -> ~/.bashrc ->

/etc/bashrc

因此,我们可以把写的脚本放到以上文件里执行。

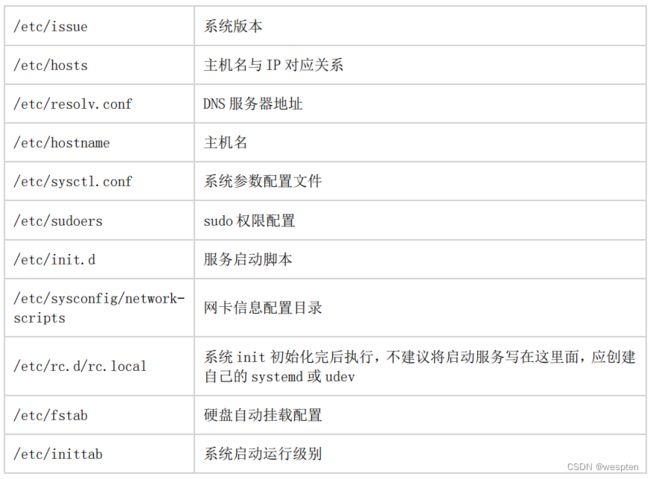

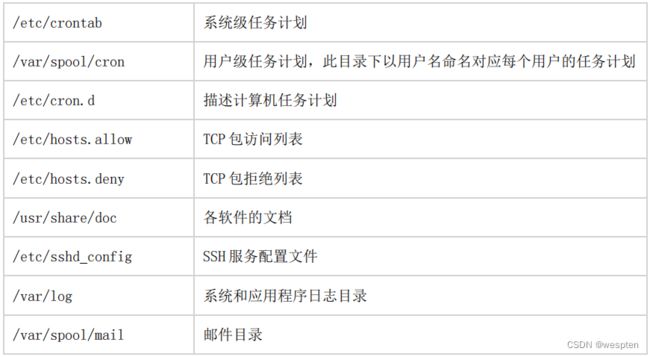

3、系统配置文件

crontab 任务计划说明:

# Example of job definition:

# .---------------- minute (0 - 59)

# | .------------- hour (0 - 23)

# | | .---------- day of month (1 - 31)

# | | | .------- month (1 - 12) OR jan,feb,mar,apr ...

# | | | | .---- day of week (0 - 6) (Sunday=0 or 7) OR

sun,mon,tue,wed,thu,fri,sat

# | | | | | # * * * * * user-name command to be executed4、/dev 目录

5、/proc 目录

1)/proc

2)/proc/net

/proc/net 目录存放的是一些网络协议信息。

3)/proc/sys

这个目录下的文件可被读写,存了大多数内核参数,可以修改改变内核行为。所以修改这些文件要特别小心,修改错误可能导致内核不稳定。

有四个主要的目录:

fs # 文件系统各方面信息,包括配额、文件句柄、inode 和目录项。

kernel # 内核行为的信息

net # 网络配置信息,包括以太网、ipx、ipv4 和 ipv6。

vm # Linux 内核的虚拟内存子系统,通常称为交换空间。详情参考:E.3.9. /proc/sys/ Red Hat Enterprise Linux 6 | Red Hat Customer Portal

十一、Shell常用命令与工具

本节学习一些在编写 Shell 时的常用命令或工具及使用技巧。有人说 Shell 脚本是命令堆积的一

个文件,按顺序去执行。还有人说想学好 Shell 脚本,要把 Linux 上各种常见的命令或工具掌握

了,这些说法都没错。由于 Shell 语言本身在语法结构上比较简单,是面向过程编程,想实现复杂

的功能有点强人所难!

而且 Shell 本身又工作在 Linux 内核之上,在用户态调用 Linux 命令会很方面,所以大多数情况下我们都是依靠这些命令来完成脚本中的某些功能,比如文本处理、获取系统状态等等,然后通过 Shell 语法结构组织代码逻辑。不管是学 Linux 系统好还是写 Shell 脚本也好,有些命令都是必须要会的,以下是根据个人经验总结的一些常用的命令。

怎么更好的学习命令呢?

当然查看官方帮助文档了,可以通过 man cmd、cmd --help、help cmd、info cmd 等方式查看命令的使用。

1、ls

功能:列出目录内容。

常用选项:

-a 显示所有文件,包括隐藏的

-l 长格式列出信息

-i 显示文件 inode 号 -t 按修改时间排序

-r 按修改时间倒序排序

-h 打印易读大小单位示例:

按修改时间排序:

# ls -t

按修改时间倒序排序:

# ls -rt

长格式列出:

# ls -lh

查看文件 inode:

# ls -i file2、echo

功能:打印一行

常用选项:

-n 不加换行符

-e 解释转义符示例:

解释换行符。

# echo -e "1\n2\n3"

1

2

33、printf

功能:格式化打印数据。默认打印字符串不换行。

格式:

printf format [arguments]一些常用的空白符:

\n 换行

\r 回车

\t 水平制表符示例:

输出一个字符:

# printf "%.1s" abc

a

保留一个小数点:

# printf "%.1f" 1.333

1.3

输出换行:

# printf "%.1f\n" 1.333

1.3

格式化输出:

# printf "user: %s\tpass: %d\n" abc 123

user: abc pass: 1

左对齐宽度 10: # printf "%-10s %-10s %-10s\n" ID Name Number

ID Name Number

右对齐宽度 10: # printf "%10s %10s %10s\n" ID Name Number

ID Name Number