Hadoop环境搭建三(完全分布式)

Hadoop完全分布式模式

. 理论讲解

一.集群配置

二.集群分发

三.分布式集群格式化

四.集群单点启动

五.ssh免密登录

六.启动停止集群

. 理论讲解

1.节点的作用

(1)我们启动了4个节点:namenode、datanode、resourcemanager、nodemanager

Namenode存储文件

(2) yarn的作用

2.MapReduce将计算过程分为两个阶段:Map和Reduce

.Map阶段并行处理输入数据

.Reduce阶段对Map结果进行汇总

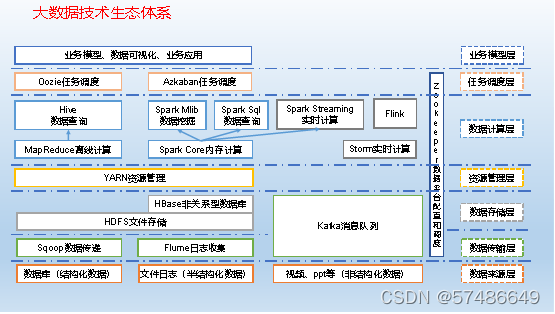

(1)Sqoop:Sqoop是一款开源的工具,主要用于在Hadoop、Hive与传统的数据库(MySql)间进行数据的传递,可以将一个关系型数据库(例如 :MySQL,Oracle 等)中的数据导进到Hadoop的HDFS中,也可以将HDFS的数据导进到关系型数据库中。

(2)Flume:Flume是一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据;

(3)Kafka:Kafka是一种高吞吐量的分布式发布订阅消息系统;

(4)Storm:Storm用于“连续计算”,对数据流做连续查询,在计算时就将结果以流的形式输出给用户。

5)Spark:Spark是当前最流行的开源大数据内存计算框架。可以基于Hadoop上存储的大数据进行计算。

(6)Flink:Flink是当前最流行的开源大数据内存计算框架。用于实时计算的场景较多。

(7)Oozie:Oozie是一个管理Hdoop作业(job)的工作流程调度管理系统。

(8)Hbase:HBase是一个分布式的、面向列的开源数据库。HBase不同于一般的关系数据库,它是一个适合于非结构化数据存储的数据库。

(9)Hive:Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供简单的SQL查询功能,可以将SQL语句转换为MapReduce任务进行运行。 其优点是学习成本低,可以通过类SQL语句快速实现简单的MapReduce统计,不必开发专门的MapReduce应用,十分适合数据仓库的统计分析。

(10)ZooKeeper:它是一个针对大型分布式系统的可靠协调系统,提供的功能包括:配置维护、名字服务、分布式同步、组服务等。

一.集群配置

注意:NameNode和SecondaryNameNode不要安装在同一台服务器

(2NN备份元数据的,如果放在一台机器上,机器宕机元数据就拿不到)

注意:ResourceManager也很消耗内存,不要和NameNode、SecondaryNameNode配置在同一台机器上。

| hadoop100 |

hadoop101 |

hadoop102 |

|

| HDFS |

NameNode DataNode |

DataNode |

SecondaryNameNode DataNode |

| YARN |

NodeManager |

ResourceManager NodeManager |

NodeManager |

- 核心配置文件

配置:hadoop-env.sh(在/opt/module/hadoop-3.1.3/etc/hadoop目录下)

Linux系统中获取JDK的安装路径:

[soft863@ hadoop100 ~]#

echo $JAVA_HOME/opt/module/jdk1.8.0_212在hadoop-env.sh文件中修改JAVA_HOME 路径:

(在第54行修改)

export JAVA_HOME=/opt/module/jdk1.8.0_212(1 ) 配置 core-site.xml

cd $HADOOP_HOME/etc/hadoopvi core-site.xml文件内容如下:

fs.defaultFS

hdfs://hadoop100:9820

hadoop.data.dir

/opt/module/hadoop-3.1.3/data

(2)HDFS配置文件

配置 hdfs-site.xml

vi hdfs-site.xml文件内容如下:

dfs.namenode.name.dir

file://${hadoop.data.dir}/name

dfs.datanode.data.dir

file://${hadoop.data.dir}/data

dfs.namenode.checkpoint.dir

file://${hadoop.data.dir}/namesecondary

dfs.client.datanode-restart.timeout

30

dfs.namenode.http-address

hadoop1000:9870

dfs.namenode.secondary.http-address

hadoop1002:9868

注意主机名称 在倒数第三行

(3)YARN配置文件

配置yarn-site.xml

命令:

vim yarn-site.xml文件内容如下:

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.resourcemanager.hostname

hadoop1001

yarn.nodemanager.env-whitelist

JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME

(4)MapReduce配置文件

配置mapred-site.xml

命令:

vim mapred-site.xml文件内容如下:

mapreduce.framework.name

yarn

二.集群分发

把module目录拷贝到hadoop1000:

[root@hadoop1002 opt]# cd /opt

[root@hadoop1002 opt]# scp -r module/ hadoop1000:/opt/

把module目录拷贝到hadoop1001:

[root@hadoop102 opt]# rsync -av module hadoop1001:/opt/

把 /etc/profile拷贝到hadoop1000 hadoop1001

[root@hadoop102 opt]# rsync -av /etc/profile hadoop101:/etc

[root@hadoop102 opt]# rsync -av /etc/profile hadoop100:/etc

在hadoop100和hadoop101上分别要进行source /etc/profile

[root@hadoop100 opt]# source /etc/profile

[root@hadoop101 opt]# source /etc/profile

注意:主机名不同的改成自己主机名

rm -rf data三.分布式集群格式化

分布式集群第一次启动之前要格式化

格式化之前,要把三个服务器上的hadoop安装目录下的 data目录和logs目录都删掉

[root@hadoop101 opt]# cd /opt/module/hadoop-3.1.3

cd /opt/module/hadoop-3.1.3[root@hadoop101 opt]# rm -rf data

rm -rf data[root@hadoop101 opt]#

rm -rf logs在指定namenode运行的服务器上执行格式化:

(namenode指定在hadoop100上运行的)

[root@hadoop100 hadoop-3.1.3]#hdfs namenode -format

hdfs namenode -format四.集群单点启动

在每个节点上分别启动下边表格的进程:

| hadoop100 |

hadoop101 |

hadoop102 |

|

| HDFS |

NameNode DataNode |

DataNode |

SecondaryNameNode DataNode |

| YARN |

NodeManager |

ResourceManager NodeManager |

NodeManager |

Hadoop100:

hdfs --daemon start namenodehdfs --daemon start datanodeyarn --daemon start nodemanagerhadoop101:

yarn --daemon start resourcemanagerhdfs --daemon start datanodeyarn --daemon start nodemanagerhadoop102:

hdfs --daemon start secondarynamenodehdfs --daemon start datanodeyarn --daemon start nodemanager(1)启动hdfs相关

hdfs --daemon start namenodehdfs --daemon start datanode(2)启动yarn相关

yarn --daemon start resourcemanageryarn --daemon start nodemanager五.ssh免密登录

1、在每个节点生成公钥和私钥,并拷贝

Hadoop100:

生成公钥和私钥:

[root@hadoop100] ssh-keygen -t rsa

然后敲(三个回车)

将公钥拷贝到要免密登录的目标机器上

[root@hadoop100]ssh-copy-id hadoop1000

[root@hadoop100] ssh-copy-id hadoop1001

[root@hadoop100] ssh-copy-id hadoop1002

Hadoop101:

生成公钥和私钥:

[root@hadoop101] ssh-keygen -t rsa

ssh-keygen -t rsa然后敲(三个回车)

将公钥拷贝到要免密登录的目标机器上

[root@hadoop101] ssh-copy-id hadoop100

[root@hadoop101] ssh-copy-id hadoop101

[root@hadoop101] ssh-copy-id hadoop102

Hadoop102:

生成公钥和私钥

[root@hadoop102] ssh-keygen -t rsa

ssh-keygen -t rsa然后敲(三个回车)

将公钥拷贝到要免密登录的目标机器上

[root@hadoop102] ssh-copy-id hadoop100

[root@hadoop102] ssh-copy-id hadoop101

[root@hadoop102] ssh-copy-id hadoop102

2、修改hadoop配置文件

在hadoop100上的start-dfs.sh 和stop-dfs.sh 文件最上边添加几行数据

[root@hadoop100] cd /opt/module/hadoop-3.1.3/sbin

cd /opt/module/hadoop-3.1.3/sbin[root@hadoop100] vi start-dfs.sh

vi start-dfs.sh底部添加:

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root[root@hadoop100] vi stop-dfs.sh

vi stop-dfs.shHDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root在 start-yarn.sh 和 stop-yarn.sh文件最上方添加几行数据

[root@hadoop100]vi start-yarn.sh

vi start-yarn.shYARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root[root@hadoop100] vi stop-yarn.sh

vi stop-yarn.shYARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root在hadoop100上修改workers:

[root@hadoop100] cd /opt/module/hadoop-3.1.3/etc/hadoop

cd /opt/module/hadoop-3.1.3/etc/hadoop[root@hadoop100] vi workers

vi workershadoop100

hadoop101

hadoop102

把上面的修改同步到hadoop101、hadoop102上:

[root@hadoop100] rsync -av /opt/module/hadoop-3.1.3/sbin/

rsync -av /opt/module/hadoop-3.1.3/sbin/hadoop101:/opt/module/hadoop-3.1.3/sbin/

/opt/module/hadoop-3.1.3/sbin/[root@hadoop100] rsync -av /opt/module/hadoop-3.1.3/sbin/

rsync -av /opt/module/hadoop-3.1.3/sbin/hadoop102:/opt/module/hadoop-3.1.3/sbin/

/opt/module/hadoop-3.1.3/sbin/[root@hadoop100] rsync -av /opt/module/hadoop-3.1.3/etc/hadoop/

rsync -av /opt/module/hadoop-3.1.3/etc/hadoop/hadoop101:/opt/module/hadoop-3.1.3/etc/hadoop/

/opt/module/hadoop-3.1.3/etc/hadoop/[root@hadoop100] rsync -av /opt/module/hadoop-3.1.3/etc/hadoop/

rsync -av /opt/module/hadoop-3.1.3/etc/hadoop/hadoop102:/opt/module/hadoop-3.1.3/etc/hadoop/

/opt/module/hadoop-3.1.3/etc/hadoop/六.启动停止集群

启动集群:

如果集群上已经启动hadoop相关程序,可以先执行停止。

在hadoop100上执行以下脚本,用来启动hdfs:

[root@hadoop100] start-dfs.sh

在hadoop101上执行以下脚本,用来启动yarn:

[root@hadoop101] start-yarn.sh

停止集群:

在hadoop100上执行以下脚本,用来停止hdfs:

[root@hadoop100] stop-dfs.sh

在hadoop101上执行以下脚本,用来停止yarn:

[root@hadoop101] stop-yarn.sh