论文笔记-Applications of Deep Learning in Fundus Images: A Review(1)

文章目录

-

目录

摘要

1.引言

2.损伤检测

2.1 出血HEs(对应label:渗透)

2.2 微血管瘤

2.3渗出物(对应label:无灌注区)

2.4.多种病变

3.疾病诊断/分级

3.1糖尿病性视网膜病变

3.1.1 结合病变检测的方法

3.1.2 其他方法

3.2糖尿病性黄斑水肿

摘要

利用眼底图像进行眼病的早期筛查具有重要的临床意义。由于其强大的性能,深度学习在病变分割、生物标记分割、疾病诊断和图像合成等相关应用中越来越流行。因此,需要综述总结眼底图像深度学习的最新进展。

在这篇综述中,我们介绍了143篇具有精心设计的层次结构的应用程序论文。此外,还提供了33个公开的数据集。我们为每个任务提供了总结和分析。最后,揭示了所有任务共同的限制性,并给出了可能的解决方案。我们还将在https://github.com/nkicsl/Fundus评论上发布并定期更新最新的结果和最新发布的数据集,以适应这一领域的快速发展。

1.引言

根据世界卫生组织2019年10月发布的世界宣明会报告1,全球有超过4.18亿人患有青光眼、糖尿病性视网膜病变(DR)、年龄相关性黄斑变性(AMD)或其他可能导致失明的眼病。眼病患者往往没有意识到无症状情况的恶化,因此早期筛查和治疗眼病尤为重要。

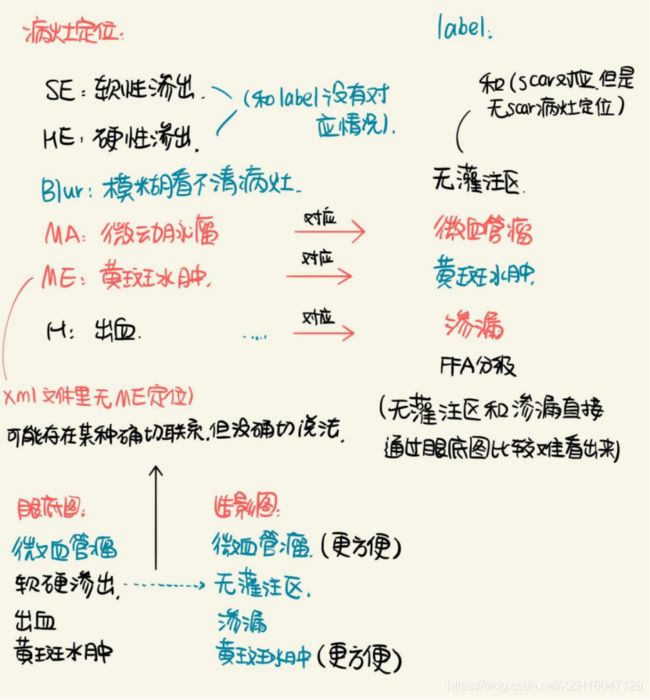

在眼底图像中可以看到许多重要的生物标记,如视盘(OD)、视杯(OC)、黄斑、胎儿、血管和一些DR相关的病变,如微动脉瘤(MAs)、出血(HEs)、硬性渗出物(EXs)和软性渗出物(SEs)。真菌图像可用于诊断多种眼病,包括青光眼、DR、AMD、白内障、早产儿视网膜病变(ROP)和糖尿病性黄斑水肿(DME)。

深度学习在眼底图像中的大多数应用可以粗略地分为分类、分割和合成任务。为了简洁起见,我们只列出了在眼底图像应用中广泛使用的骨干结构。眼科疾病的诊断和分级是分类任务的两个例子:VGG-Net、ResNet和DenseNet等是使用最广泛的分类主干网络。在分割任务方面,识别病变和生物标记物对疾病的诊断具有重要意义。

在分割方面,其他广泛用于眼底图像分割的网络包括FCN、SegNet、U-Net、MaskRCNN和DeeplabV3+。最后,在眼底图像合成领域,生成对抗网络(GANs)是主导架构。

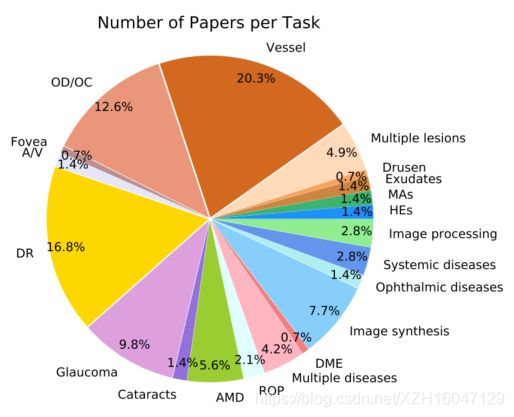

在这篇综述中,我们着重于2016年1月至2020年8月,深度学习方法在眼底图像中的成功应用。会议来源包括CVPR、AAAI、MICCAI、ISBI、ICMLA和ICIP,《期刊》来源包括IEEETIP、IEEETMI、MIA每个任务的论文分布如图所示。

2.损伤检测

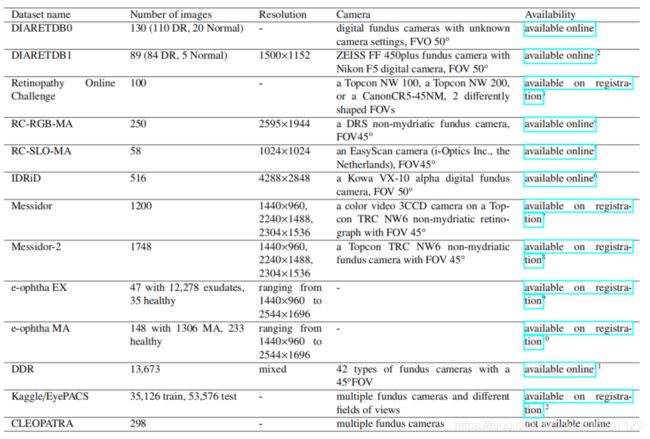

在本节中,我们将回顾深度学习方法是如何应用于病变检测/分割。此任务的广泛使用的数据集显示在选项卡中。以下是一些有利用价值的数据集

- RC-RGB-MA数据集包含250张图像。MAs由两位专家在边界框级进行了注释。

- RC-SLO-MA-dataset激光检眼镜数据集采用扫描激光检眼镜(SLO)拍摄。该数据集包含58张带有MA标签的图像。

- 视网膜疗法在线挑战(ROC)数据集由100张图像组成,它们被分为训练集和测试集,都包含50张图像。MAs的中心位置由专家标记。

- E-opththa MA数据集包括148张带有MAs或小HEs的图像和233张健康图像。

- Kaggle和EyePACS(加州加利福尼亚医疗保健基金会,2015年)指的是EyePACS提供的相同数据集,用于“糖尿病视网膜病变检测——识别眼睛图像中糖尿病视网膜病变的迹象”的数据集。Kaggle数据集由35126张训练分级为5个DR阶段的图像和53576个未公开阶段的测试图像组成。Kaggle数据集中的图像是使用多个具有不同视野的眼底摄像机获得的。

- IDRiD数据集(Porwal等人,2018)用于2018年ISBI举办的“糖尿病视网膜病变:分割和分级挑战”。它由分割、疾病分级和定位三个任务组成,并提供了官方培训和测试集。分割任务包括81张图像,其中包括病变(MA、HEs、EXs、SES)和OD区域。疾病分级任务包括516张DR和DME的图像。定位任务还包括516张图像,以及OD和中心中心定位的注释。请注意,IDRiD中的图像的分辨率相对较高。DDR数据集(Li等人,2019b)包含来自147家医院的13673家图像,覆盖中国23个省。为所有图像提供了具有五类DR严重级别的图像级注释。此外,757张图像还提供了针对病变(MAs、EXs、SEs和HEs)的像素级和边界框级注释

-

1 https: // www.it.lut.fifi / project / imageret /2 https: // www.it.lut.fifi / project / imageret /3 http: // webeye.ophth.uiowa.edu / ROC /4 http: // www.retinacheck.org / datasets5 http: // www.retinacheck.org / datasets6 https: // ieee-dataport.org / open-access / indian-diabetic-retinopathy-image-dataset-idrid7 http: // www.adcis.net / en / third-party / messidor /8 http: // www.adcis.net / en / third-party / messidor2 /9 http: // www.adcis.net / en / third-party / e-ophtha /10 http: // www.adcis.net / en / third-party / e-ophtha /11 https: // github.com / nkicsl / DDR-dataset12 https: // www.kaggle.com / c / diabetic-retinopathy-detection / data

2.1 出血HEs(对应label:渗透)

出血(HEs)是一种明显的病理症状之一。准确地检测或分割HEs对DR诊断很重要。在病变检测/分割任务中,由于数据集的图像数量有限,而且需要降低计算成本,基于补丁的方法非常流行。基于补丁的方法可以生成只有数十张图像的数十个补丁,这可以帮助提高性能和缓解过度拟合的问题。然而,HEs(以及其他病变)通常的大小相对较小,它们的像素只占整个图像的一小部分。这将导致只有少数斑块包含病变,而大量斑块对病变的检测/分割任务没有太大贡献。不平衡在本节的其他病变检测/分割任务中也很常见。改进出血检测/分割有两个主要方向;即选择性抽样和在粗注释的数据集上进行分割。

选择性抽样:范·格林斯文等人。(2016)提出了一种称为选择性抽样的方法,以减少冗余数据的使用,加速CNN训练。他们邀请了三名专家来恢复Messidor数据集和Kaggle的一个子集。在训练过程中,根据当前迭代的分类结果动态调整样本的权重,使信息样本更有可能包含在下次训练迭代中。受VGG的启发,他们设计了一个九层的CNN作为分类器。在Messidor数据集和Kaggle数据集上,实验结果表明,没有选择性抽样的CNN(SeS)优于CNN(NSeS),SeS将训练时间从170个减少到60个。

在粗注释的数据集上的分割:Huang等人提出了一种边界框精炼网络(BBRNet),它可以为粗注释的数据生成更准确的边界框注释。然后,他们使用视网膜网来检测出血。他们没有使用具有精细注释的IDRiD数据集,而是在一个具有注释粗糙的边界框的私人数据集上进行了出血检测。他们首先建立了一个包含图像对的数据集。对于每对,一张图像从IDRiD中拍摄,另一张图像通过模拟粗注释的边界框获得。BBR-Net以粗注释补丁作为输入,以精细注释补丁作为目标。经过训练后,作者介绍了他们的私有数据,以获得更准确的边界框注释,然后将结果发送到视网膜网进行出血检测。

讨论:选择性抽样方法缓解了数据不平衡的问题。选择性抽样也用于其他应用,这将在以下章节中介绍。Huang等人的探索也提供了一个很有前途的方向。生成更准确的边界框注释可以看作是图像合成,这将在第5节中更详细地讨论。然而,在目前的HEs检测应用程序中仍然有一些限制。首先,对不平衡问题需要进行进一步的研究。其次,与其他病变相比,对HEs的研究重点较少。需要更加关注这一领域在博士诊断中的重要性。第三,需要进行像素级的分割和检测。更多为HEs提供像素级标签的数据集,比如DDR,仍然需要被探索。

2.2 微血管瘤

MAs是DR最早的临床迹象,因此获得了更多的研究兴趣。有一些影响MAs分割的障碍,包括存在其他颜色相似、对比度极低的病变;以及图像照明、清晰度和背景纹理的变化。两阶段多尺度架构和临床报告指导是检测的一些成功策略。

两阶段的多尺度网络:Sarhan等人提出了一种两阶段的深度学习方法,嵌入了三态损失到微血管瘤分割当中。第一阶段被称为假设生成网络(HGN),其中使用多尺度的FCNs来生成一个感兴趣的区域(ROI)。第二阶段被称为补丁式细化网络(PRN),其中从ROI周围提取的补丁被传递到修改后的ResNet-50进行分类。作者将三态损失引入到PRN中,以提取判别特征。此外,利用上述反射采样方法降低计算成本,解决数据不平衡问题。

临床报告指导中枢神经网络Dai等人提出了一份指导多筛分卷积神经网络(MS-CNN)检测MAs的临床报告。他们首先从临床报告和眼底图像中训练了一个弱图像到文本的模型,以产生对微动脉瘤的粗略分割。然后利用提出的MS-CNN以粗糙分割为指导生成最终的高质量分割。为了解决数据不平衡问题,MS-CNN采用了一种类似于增强的方法。具体来说,MS-CNN由多个CNN组成,其中前一个CNN的假阳性被输入以下CNN作为阴性的例子。

讨论:在MA分割中采用了几种有效的方法,包括多尺度网络、临床报告的指导和三态损失的利用。在MSCNN中采用的ROI和级联架构的提取缓解了不平衡问题。然而,MS-CNN的双级架构和级联架构缺乏效率。它们使用了多个基础网络,这导致了大量的参数需要进行训练。因此,MA分割的一个很有前途的方向是在保持高性能的同时降低网络的复杂性。

2.3渗出物(对应label:无灌注区)

软渗出物和硬渗出物通常是诊断DR的基础。因此,准确检测SEs和EXs对及时治疗至关重要。与其他病变检测/分割任务一样,也有几个挑战。这些障碍包括:对比度低、大小不同和与其他病变的相似性。有几种渗出物检测方法,其中大部分可以分为CNN的圆霍夫转换和损失函数的修改

CNN与圆形的霍夫转换:Adem引入了一种三层CNN结构,用于渗出物和无渗出物眼底图像的二元分类。在预处理过程中,采用自适应直方图均衡、缝隙边缘检测和圆霍夫转换等几种方法去除了OD区域。

修改损失函数:Guo提出了一个top-k loss和bin loss,以提高渗出物分割的性能。类平衡交叉熵(CBCE)损失(Xie和Tu,2015)在一定程度上解决了类不平衡问题。然而,这就引入了新的损失不平衡问题,其中类似于渗出物的背景往往被错误地分类。主要原因是,由于背景像素和前景像素的权重不同,背景像素的损失比硬渗出像素的损失要小得多。为了解决这种损失不平衡问题,提出了top-k损失,它考虑了所有的硬渗出像素,但只考虑了损失更大的top-k背景像素。考虑到效率,他们还提出了一种快速版本的topk损失,称为bin损失。

讨论:在渗出物检测中,一些工作主要集中在改变损失函数上。top k损失和bin损失解决了使用CBCE造成的损失不平衡问题。然而,错误分类的问题仍然存在。此外,只测试了baseline模型,也没有提出任何创新的架构。Adem(2018)的作品是基于CNN改编的。一些最近的模型,如编码器-解码器网络,需要用于渗出物检测。

2.4.多种病变

大多数以前只分割/检测一种类型的病变或治疗所有病变作为一组(通常是红色病变或明亮的病变)。然而,同时分割多个病变更具有实用价值。因此,越来越多的研究人员专注于多病变的分割/检测。在个别病变检测/分割任务中发现的挑战,包括不平衡、对比度、照明等,仍然存在。此外,不同病变的类间相似性,如HEs和MAs变得更加突出。所有这些因素都使多病变分割成为一项具有挑战性的任务。

3.疾病诊断/分级

3.1糖尿病性视网膜病变

糖尿病性视网膜病变(DR)是一种影响眼睛正常血管的血管疾病,是全球可预防失明的主要原因。DR分级有一个统一的标准,即国际临床糖尿病视网膜病变量表(ICDRS)。根据本标准,DR的严重程度可分为五类,即0(无明显DR)、1(轻度DR)、2(中度DR)、3(严重DR)、4(政治性DR)。最常用的数据集显示在Tab1中。所有这些都在第二节中介绍。实验结果显示在Tab2中。

3.1.1 结合病变检测的方法

考虑到DR的诊断和出血、渗出物和其他病变的检测之间的内部相关性,许多工作在执行DR诊断分级时也会生成病变的热图。这些方法包括:生成病变热图、病变分割、Attention方法和两种基准工作。

生成病变热力图:杨等人提出了一种两阶段的DCNN,可以同时描述病变,并进行DR严重程度分级。第一阶段是一个本地网络,提取病变的局部特征。第二阶段是一个进行DR分级的全局网络,从局部网络和原始眼底图像中得到了一个加权病变图。引入了一种不平衡的加权方案,以在进行DR分级时更加关注病变斑块。

Gondal等人采用无监督学习进行病变分级,仅使用图像级标签生成病变热图。他们的主要网络使用了oO解决方案,用全局平均池(GAP)层取代了最后一层密集层。他们生成热图的方式主要是受到周等人的启发。Quellec等人提出了一种解决方案来生成一个热图,以显示图像中的像素在图像级预测中所扮演的角色。它们可以检测到图像级的可参考的DR和像素级的生物标记。他们的网络baseline也是oO方法,提出了一种前后传播优化方法。

同时进行病变分割:Foo等人使用编码器-解码器网络进行DR分级和病变分割。他们用有五组转换层的VGG-16取代了U-Net的编码器。相应地,解码器被修改为编码器的镜像。这种体系结构可以自然地进行病变分割。然后,对于DR分级,他们将网络的鞍层附加一个间隙层进行分类。他们进一步提出了一种半监督的方法来增加训练图像的数量。

Attention方法:Attenion机制也常用于DR的诊断和分级。王等人提出了一种Zoom in Net,它可以同时执行玻璃纤维DR分级,并生成突出病变的关注图。Zoom in Net由三个部分组成,即使用初始Resnet作为主干的主网Backbone(M-Net),旨在提取特征并输出诊断结果;只使用图像监督生成注意力图;以及一个C-Net,在临床医生检查图像时模拟zoomin操作。Lin等人提出了一种基于抗噪声检测和基于注意力的融合的框架,可以进行五级DR分级。他们首先使用CNN提取这些特征,然后将它们输入一个设计的中心样本检测器,以生成病变图。将损伤图和原始图像发送到所提出的注意力融合网络(AFN),该网络可以学习原始图像和损伤图的权值,以减少不必要信息的影响。

Bechmark Works:虽然根据先验知识,检测相关病变有助于诊断DR分级,但病变检测实际上是一项复杂而困难的任务,病变检测和DR分级之间存在权衡。

Li等人构建了一个名为DDR的数据集。DDR是唯一一个同时考虑DR和病变检测的数据集;它是最大的病变检测数据集,也是DR分级的第二大数据集。作者在这个数据集上评估了10个最先进的深度学习模型,包括5个分类模型、两个分割模型和三个检测模型。虽然这些方法在DR分级中达到了最大a值0.8284,但它们在病变分割和检测方面的表现特别差,这表明病变的检测或分割是一项非常具有挑战性的任务。艾哈迈德等人在Messidor-2数据集上进行了bechmark工作。他们评估了8个最先进的深度学习分类模型,并同时生成了病变的类激活图(CAMs)。结果表明,分类和定位之间存在权衡。随着网络深度和参数的增加,它们在分类方面表现更好,而在定位分割检测方面表现更差。

3.1.2 其他方法

还有其他几种进行DR分级的方法,包括双线性策略、混合方法和IDRiD挑战。

具有注意机制的双线性策略:赵等人提出使用BiRA-Net来进行DR分级。在引入的RA-Net中,从ResNet中提取的特征被输入到一个提议的关注网,以更多地关注分级的决定性领域。采用双线性策略训练两个RA网进行更细粒度的分类。

IDRiD挑战:Porwal等人描述了IDRiD数据集,并概述了在2018年ISBI举行的“糖尿病视网膜病变分割和分级”挑战的设置。他们还讨论了在比赛中表现出色的各种深度学习模型,以及从分析提交的资料中获得的经验教训。

3.2糖尿病性黄斑水肿

糖尿病性黄斑水肿(DME)是糖尿病患者最常见的并发症,可能导致严重的视力丧失(Ciulla等人,2003)。两种解决这一任务的方法分别使用两阶段架构和多尺度方法。

两阶段的架构:Mo等人提出了用于DME诊断的级联深度残余网络。所使用的数据集包括电子物理回声学家和汉密尔顿眼睛研究所黄斑水肿数据集(HEI-MED)。HEI-MED数据集12包含169张图像,其中115个是健康的,54个含有渗出物。他们的框架包括两个阶段。

第一阶段是采用深度完全卷积残余网络(FCRN)的渗出物分割网络。然后裁剪一个固定大小的区域,其中中心像素具有最大的概率值。裁剪区域被送入第二阶段,这是一个执行二元分类的深度剩余网络。

多尺度的网络:他等人。提出了一种基于多尺度DME分类方法的DMENet。他们使用IDRiD和MESSIDOR作为他们的数据集。他们首先通过u型网传递眼底图像,生成胎儿和硬的渗出区域掩模。然后设计了一个以VGG-16为主干的多尺度特征提取模块,其中对每个阶段的特征映射应用了GAP操作。然后将这些特征连接起来,获得了多尺度的特征。他们通过了原始的眼底图像,获得的胎儿和硬渗出区域掩模,以及分别通过提出的多尺度特征提取模块从眼底图像中提取的黄斑区域。将这些特征融合在一起,输入XGBoost分类器输出最终结果。