linux深度学习环境配置随笔

零、使用华为云服务器安装深度学习环境

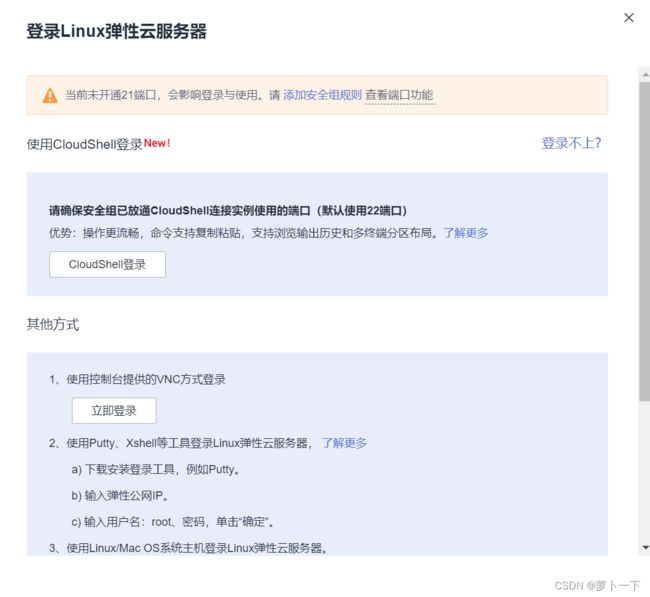

购买云服务器后进入控制中心

远程登录服务器

这里有几种登录方法,本文使用xshell进行登录。

一、cuda、cudnn安装

参考:Linux下安装cuda和对应版本的cudnn

cuda版本11.0.3 cudnn版本8.0.4.30

1.首先在安装cuda与cudnn之前,系统需要成功安装Nvidia驱动,安装教程请参照以下教程:

nvidia驱动安装教程

华为云服务器默认已经安装好了nvidia驱动

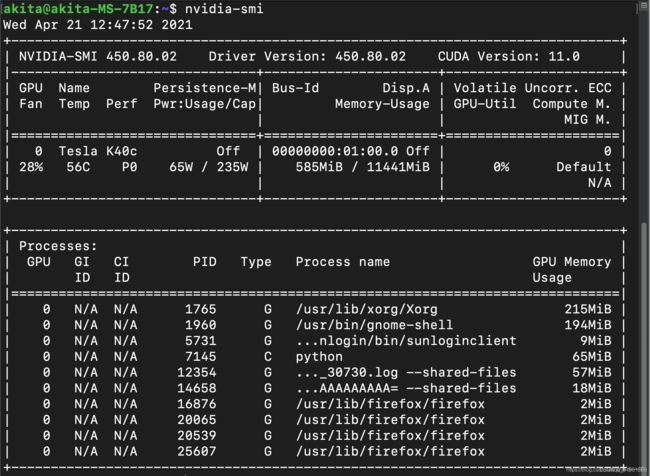

验证是否安装驱动方法:

nvidia-smi

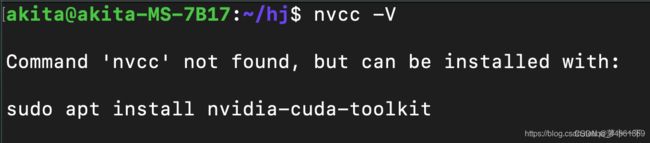

验证系统内部是否已经安装了cuda:

nvcc -V

2.进行cuda安装包与cudnn的下载

cuda的下载链接:cuda下载链接

选择cuda版本11.0.3。cudnn版本8.0.4,具体自己试着查找。查看对应版本

cudnn的下载链接:cudnn下载链接

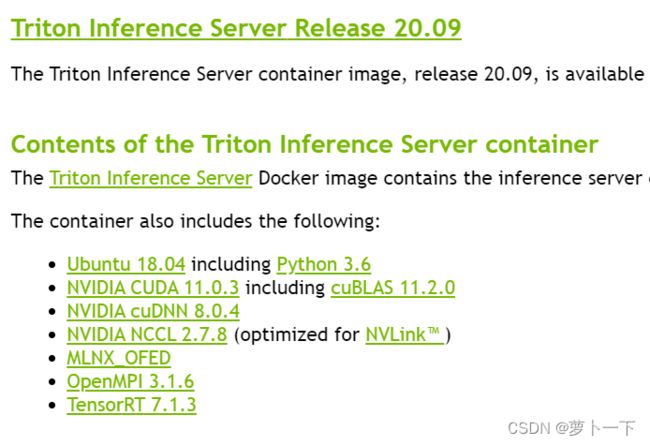

triton镜像版本22.04,试了20.09,发现没有后端库,就换成了22.04

在下载这两个文件的时候,需要注意cudnn的版本需要与cuda的版本相匹配。

3.进行cuda的安装

在进行cuda安装之前,我们需要先安装cuda的相关依赖库,防止cuda安装出现错误。命令行输入以下命令,进行相关依赖库的安装:

sudo apt-get install freeglut3-dev build-essential libx11-dev libxmu-dev libxi-dev libgl1-mesa-glx libglu1-mesa libglu1-mesa-dev

随后输入以下命令进行cuda的安装:

sudo sh cuda_11.0.3_450.51.06_linux.run //其中cuda_11.0.3_450.51.06_linux.run是我们下载的cuda安装文件

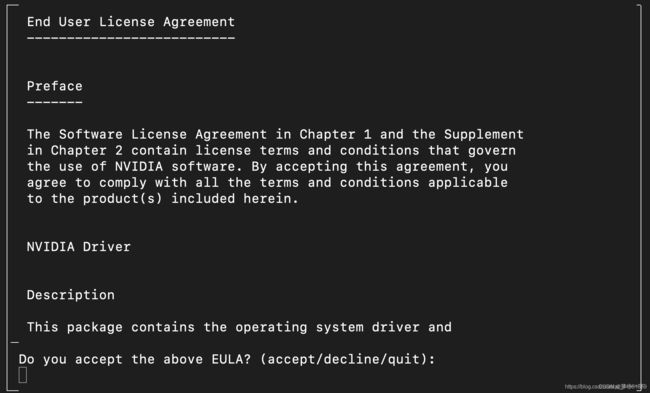

输入上述命令后,稍有卡顿,随后出现以下界面:

输入accept进行后续操作,随即出现以下界面:

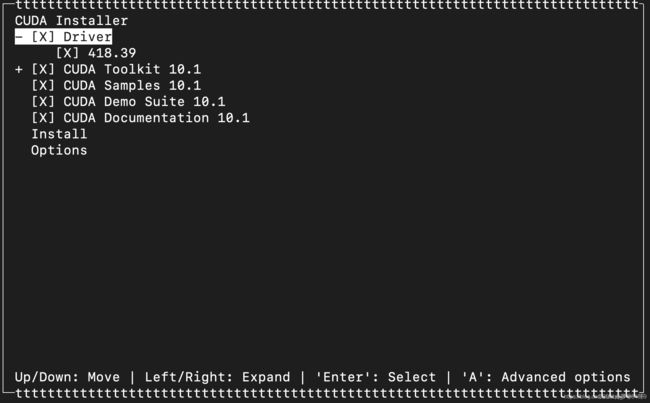

因为我们在安装cuda之前已经安装了Nvidia的驱动,因此这里的第一项我们必须取消勾选,选择不安装驱动,随后选择Install进行后续操作。

后续出现的一系列选项,我们都可以选择yes,最终出现以下界面:

Linux下安装cuda和对应版本的cudnn

二、anaconda安装

参考:如何在Linux服务器上安装Anaconda(超详细)

1、anaconda官方下载链接,找到指定版本,将下载好的anaconda***.sh文件通过xshell上传到服务器。

2、清华源下载anaconda,速度更快。

选择的是Anaconda3-5.2.0-Linux-x86_64.sh, 对应的python版本为3.6.5, 右键复制链接地址

在服务器上使用wget + 链接来下载,如下:

wget https://mirrors.tuna.tsinghua.edu.cn/anaconda/archive/Anaconda3-5.2.0-Linux-x86_64.sh

sh Anaconda3-5.2.0-Linux-x86_64.sh

或者./Anaconda3-5.2.0-Linux-x86_64.sh

安装过程和环境变量配置如下:

Linux下安装Anaconda3详细教程

Linux服务器安装Anaconda3环境

Linux系统安装Anaconda3保姆级教程

bash激活conda命令 zsh

conda init bash zsh

Anaconda更换国内下载源

三、pytorch安装

参考:如何在Linux服务器上安装Anaconda(超详细)

深度学习环境配置8——(30系显卡)windows下的torch==1.7.1环境配置

进入pytorch官网,根据官方推荐下载对应版本pytorch

# CUDA 11.0

conda install pytorch==1.7.1 torchvision==0.8.2 torchaudio==0.7.2 cudatoolkit=11.0 -c pytorch

这时官方给的下载版本,我们下载对应的cuda版本

0、建立虚拟环境

conda create –n pytorch python=3.7

激活环境

conda activate pytorch

1、

# CUDA 11.0

pip install torch==1.7.1+cu110 torchvision==0.8.2+cu110 torchaudio==0.7.2 -f https://download.pytorch.org/whl/torch_stable.html

2、

conda install cudatoolkit=11.0 -c pytorch

3、新建requirements.txt文件,输入以下内容

scipy==1.7.1

numpy==1.21.2

matplotlib==3.4.3

opencv_python==4.5.3.56

torch==1.7.1

torchvision==0.8.2

tqdm==4.62.2

Pillow==8.3.2

h5py==2.10.0

PyYAML>=5.3.1

tensorboard>=2.4.1

seaborn>=0.11.0

pandas

pycocotools>=2.0

coremltools>=4.1

onnx>=1.8.1

scikit-learn==0.19.2 # for coreml quantization

4、

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

等待安装完成,即可运行yolov5官方代码

四、docker安装

1.安装docker-nvidia

2.Linux下更换Docker镜像源

3.修改dockers镜像存储位置

Linux下修改Docker默认存储位置

已解决!docker警告WARING:No swap limit support

通过软连接方法将docker的默认路径链接到/data/docker路径下,其中data是挂载硬盘的路径。

(1) 首先停止 docker 服务:

systemctl stop docker

(2) 然后移动整个 /var/lib/docker 目录到目的路径(/data/docker):

mv /var/lib/docker /data/docker

(3) 创建软链接

ln -s /data/docker /var/lib/docker

Note:命令的意思是 /var/lib/docker 是链接文件名,其作用是当进入/var/lib/docker目录时,实际上是链接进入了 /data/docker 目录

(4) 重启 docker

systemctl start docker

参考:如何在ubuntu上安装使用Docker

1、介绍

Docker 最初是 dotCloud 公司创始人 Solomon Hykes 在法国期间发起的一个公司内部项目,它是基于 dotCloud 公司多年云服务技术的一次革新,并于 2013 年 3 月以 Apache 2.0 授权协议开源,主要项目代码在 GitHub 上进行维护。Docker 项目后来还加入了 Linux 基金会,并成立推动 开放容器联盟(OCI)。 容器允许您在资源隔离的进程中运行应用程序。它们与虚拟机类似,但容器更便携,更有利于资源,并且更依赖于主机操作系统。

在本教程中,您将安装Docker,并学会使用容器和镜像,将镜像推送到Docker存储库。

2、准备

要学习本教程,您需要具备以下条件:

一个按照Ubuntu初始服务器,我们建议您使用腾讯云免费的开发者实验室进行试验,或点击这里购买服务器。

如果您希望创建自己的镜像并将其推送到Docker Hub,则需要创建Docker Hub上的帐户。

第1步-安装Docker

官方Ubuntu存储库中提供的Docker安装包,但是可能不是最新的版本。为了确保我们获得最新版本,我们将从官方Docker存储库安装Docker。为此,我们将添加一个新的资源包,从Docker添加GPG密钥以确保下载有效,然后安装该包。

首先,更新现有的包列表:

sudo apt update

接下来,使用apt安装一些允许通过HTTPS才能使用的软件包:

sudo apt install apt-transport-https ca-certificates curl software-properties-common

然后将官方Docker存储库的GPG密钥添加到您的系统:

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo apt-key add -

将Docker存储库添加到APT源:

sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu bionic stable"

接下来,使用新添加的repo源中的Docker包更新包数据库:

sudo apt update

确保您要从Docker repo安装而不是默认的Ubuntu repo:

apt-cache policy docker-ce

虽然Docker的版本号可能不同,但您还是会看到这样的输出:

docker-ce:

Installed: (none)

Candidate: 18.03.1~ce~3-0~ubuntu

Version table:

18.03.1~ce~3-0~ubuntu 500

500 https://download.docker.com/linux/ubuntu bionic/stable amd64 Packages

现在docker-ce还没有安装,用上面这个命令我们能看到安装源来自的Docker官方存储库。

最后,安装Docker:

sudo apt install docker-ce

现在应该安装好Docker了,检查它是否正在运行:

sudo systemctl status docker

输出应类似于以下内容,表明该服务处于工作状态:

● docker.service - Docker Application Container Engine

Loaded: loaded (/lib/systemd/system/docker.service; enabled; vendor preset: enabled)

Active: active (running) since Thu 2018-07-05 15:08:39 UTC; 2min 55s ago

Docs: https://docs.docker.com

Main PID: 10096 (dockerd)

Tasks: 16

CGroup: /system.slice/docker.service

├─10096 /usr/bin/dockerd -H fd://

└─10113 docker-containerd --config /var/run/docker/containerd/containerd.toml

Docker不仅可以为您提供Docker服务,还可以为您提供docker命令行工具或Docker客户端。我们将在本教程后面探讨如何使用docker命令。

Triton Inference Server 镜像与cuda版本对应关系

Release Notes :: NVIDIA Deep Learning Triton Inference Server Documentation

ubuntu下如何检查nvidia显卡驱动是否安装OK?

答:使用sudo lshw -c video即可,笔者的输出如下:

jello~$ sudo lshw -c video*-display

description: VGA compatible controller

product: GP106 [GeForce GTX 2080 80GB]

vendor: NVIDIA Corporation

physical id: 0

bus info: pci@0000:02:00.0

version: a1

width: 64 bits

clock: 33MHz

capabilities: pm msi pciexpress vga_controller bus_master cap_list rom

configuration: driver=nvidia latency=0

resources: irq:34 memory:fa000000-faffffff memory:e0000000-efffffff memory:f0000000-f1ffffff ioport:e000(size=128) memory:c0000-dffff

如果在configuration这一行中有driver=nvidia的字符串,那么就说明nvidia的驱动安装ok

转载于:https://www.cnblogs.com/dakewei/p/10903021.html

环境搭建01——Ubuntu如何查看显卡信息及安装NVDIA显卡驱动