学习自:深度学习跨模态图文检索研究综述-西安邮电 doi: 10.3778/j.issn.1673-9418.2107076

概述(多模态->跨模态检索->跨模态图文检索):

多模态学习处理理解 来自感官的多源信息。

多模态发展历程:

- 1976年 MCGURK H, MACDONALD H. Hearing lips and seeingvoices[J]. Nature, 1976, 264(5588): 746-748.提出视觉对言语感知的影响,后被用于视听语音识别(AVSR)称为多模态概念雏形。

- 2010年:融合方法和融合水平为线索,对已有多模态融合研究方法进行分类

- 2015年:提出多模态隐条件随机场,提升多模态数据分类效果;提出基于正交正则化约束的深度多模态哈希方法,减少多模态表示的信息冗余。

- 2019年:划分多模态学习研究方向:多模态表示、多模态翻译、多模态对齐、多模态融合、多模态协同感知等

目前多模态学习成功用于 人脸识别、人体姿态估计、多模态检索、跨模态检索、语义场景理解与情感识别等

跨模态学习是多模态学习的分支,充分利用多模态学习中的模态间表示、翻译和对齐等策略。二者相似之处在与两者数据都来自所有模态,但前者的数据只在某一模态可用后者的数据则用于所有模态。

跨模态检索又称跨媒体检索,特点:训练师所有模态的数据都存在,但在测试过程中只有一个模态可用。旨在实现模态间的信息系交互,目的在于挖掘不同模态样本之间的关系,通过一种模态样本检索具有近似语义的另一种模态样本。

跨模态图文检索,关键字到图像的检索因为其本质是查询关键字与图像的标注之间的匹配,因此被称为伪"跨模态"问题。以视觉数据和自然语言描述为基础,更关注图像和文本两种模态的交互,其目的是在不借助任何辅助信息的情况下,通过文本(图像)查询来检索图像(文本)。

跨模态图文检索分为以图搜文和以文搜图两种形式。图像和文本间的语义关系可以定义为三个维度下的八种类别,包含不相关关系、互补关系、相互依赖关系、锚定关系、插图关系、对比关系、插图不良关系和锚定不良关系。

一方面,相比于传统方法,深度网络因其高度非线性结构,更适合对模态内特征和模态间语义关系进行挖掘;另一方面,鉴于小批量训练策略的优势,深度网络能够支持对海量数据的处理

跨模态检索发展历程:

- 2014年:将跨模态建模策略分为直接建模和间接建模,前者指通过建立共享层来直接度量不同模态数据间的相关性,后者指通过构建公共表示空间来建立不同场景不同模态间的语义关联。

- 2015年:多模态数据间建立关联的策略分为基于共享层与基于公共表示空间的两种关联方法

- 2016年:已有的跨模态检索方法归纳为实值表示学习和二进制表示学习两大类

- 2018年:针对模态间内容相似性度量的技术难点,将跨模态检索 分 为 公 共 空 间 学 习 方 法 和 跨 模 态 相 似 性 度 量 方法;将跨模态检索方法分为基于子空间的方法、基于深度学习的方法、基于哈希变换的方法和基于主题模型的方法,指出当前跨模态检索面临的主要问题是缺乏对模态内局部数据结构和模态间语义结构关联的研究;从信息抽取与表示、跨模态系统建模两个维度评述了基于表示学习的跨模态 检 索 模 型;探索了联合图正则化的跨模态检索方法;

- 2019年:介绍了近年来跨模态特征检索及优化的研究进展,并对跨模态数据联合分析方法及跨模态特征检索面临的问题与挑战进行了概述;对跨模态检索方法的具体分支进行了梳理,为相关领域的探索提供了新思路。

当前跨模态图文检索相关技术已被成功应用于网络舆情事件预警、多媒体事件检测、医学数据分类等领域。

跨模态图文检索近年来相关成果:

- 2017年:将跨模态图文检索的研究内容分为多模态数据特征表示和模态间关联机制两方面

- 2019年:根据构建模态间关联方式的区别,将跨模态图文检索分为基于典型关联分析、基于深度学习和基于深度哈希的方法,并就各种跨模态关联方式的缺陷探索了具体的解决思路。

- 2021年:本文除涵盖了实值表示和二进制表示的方法外,对基于深度学习的跨模态图文检索现有的研究成果进行了总结。

1 跨模态图文检索相关工作介绍

介绍算法涉及的重要概念及常见网络结构

1.1 相关概念

重要概念:

(1)跨模态重构在 给 定 跨 模 态 数 据 的 情 况 下 联 结 输 入 特 征 表示,然后相互重构各模态数据且保留重构信息,最后比较重构信息与原始信息相似性的过程。

(2)细粒度数据指信息非常详细具体的数据。数据粒度指数据的详细程度,粒度越小,数据的信息越具体,越容易在机器学习中把握数据的规律与本质。

(3)无监督学习指事先没有任何训练数据样本而需要直接对数据建模的学习方法。无监督学习仅使用共现信息来学习跨模态数据的公共表示。共现信息指在多模态文档中所共存的不同形式的数据具有相同的语义。

(4)监督学习指通过有标记的训练数据来推断或建立一个最优模型的学习方法。监督学习利用标签信息来学习公共表示,强制不同类别样本的学习表示距离尽可能远,而相同类别样本的学习表示尽可能接近。

(5)端到端学习,也称端到端训练,指在学习过程中缩减人工预处理和后续处理,使模型从原始输入直接到最终输出。其训练数据为"输入-输出"对的形式,无需提供其他额外信息。端到端学习为模型提供了更多根据数据自动调节的空间,增加了模型的整体契合度。

1.2 相关网络结构

跨模态图文检索在DL领域涉及其中网络结构:

- 深度自编码器模型(deep autoencoder,DAE)[25]由一个编码器和一个生成重构的解码器组成。深度自编码器可以产生对输入进行刻画的编码,其通常用于跨模态重构,从而发现跨模态相关性。

- 深度信念网络(deep belief nets,DBN),该网络既可以被视为自编码器进行非监督学习,也可以被视为分类器进行监督学习。

- 受限玻尔兹曼机模型(restricted Boltzmann machine,RBM)可用于跨模态重建。2012年,Srivastava等人提了一种由多种模态输入组成的深度玻尔兹曼机,该模型可实现模态融合与统一表示,也可应用于分类识别和信息检索任务。

- 注意力机制模型,目前大多数注意力模型在跨模态图文检索中用于对模态局部特征的表示,以及对不同模态片段的对齐,有助于挖掘模态间细粒度的对应关系,并在一定程度上能够弥补模态数据缺失的问题。

- 生 成 对 抗 网 络(generative adversarial networks,GAN)能 够 通 过 两 个 模 块 的 互 相 博 弈 得 到 良 好的输出。在跨模态图文检索任务中,生成对抗网络一般通过图片和文本相互对抗,使数据间的潜在关系及语义结构被更好地保留,同时生成过程可以学习强大的跨模态特征表示,从而增强跨模态语义一致性。

- 卷 积 神 经 网 络(convolutional neural networks,CNN)广泛应用于跨模态图文检索中。其优点在于对高维数据的处理能力强、特征分类效果良好,具有强大的特征表示能力;缺点是依赖于大规模标记样本和复杂的调参过程。跨模态图文检索中常用的卷积神经网络模型有 ResNet、AlexNet 等。

- 长短期记忆网络(long short-term memory,LSTM)可以有效地将短时记忆与长时记忆相结合,借此联合学习数据的上下文信息。在跨模态图文检索任务中,需首先确定从单元状态中被遗忘的信息,进而确定能够被存放到单元状态中的信息,最后通过 tanh 的单元状态乘以输出门,用于确定输出的部分。(是否可被代替?)

- 其余:,双向递归神经网络(bidirectional recurrentneural network,BRNN)、基于字嵌入(矢量)的卷积神经网络(word embedding (vector) based convolutionalneural network,WCNN)、循环神经网络、递归神经网络(recursive neural network,RNN)、区域卷积神经网络(region convolutional neural network,RCNN)等也 被 应 用 于 特 征 提 取 任务中。

2 跨模态图文检索算法研究

- 确保检索准确性,解决模态间底层数据特征异构导致的语义鸿沟

- 检索效率提升

基于准确性和效率,主流算法分为:实值表示学习 和 二进制表示学习

(方法特点+该方法近期优秀工作+方法面临挑战)

实值:高准确率,注重语义匹配,学习一个实值公共表示空间,该空间中不同模态数据通用表示是实值

二进制:又称跨模态哈希,加速检索,不同模态数据映射到共同汉明空间,二值化过程会导致检索精度下降

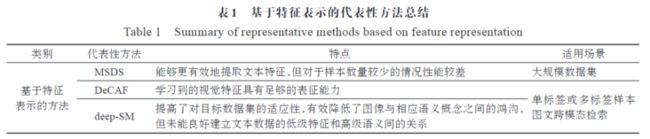

2.1 实值表示学习方法

旨在为不同形式的数据学习稠密特征表示。目前流行的基于深度学习的实值表示跨模态图文检索方法可分为两类 :基于特征表示的方法和基于图文匹配的方法。

- 基于特征表示的方法:聚焦于对不同模态间特征进行建模,以良好的特征提取来有效解决不同模态数据特征的异构问题,从而保障检索准确度

- 基于图文匹配的方法:关注图像和文本模态间的语义对应关系,旨在通过减小语义鸿沟以提高图文匹配的准确性,从而提高检索的准确度

2.1.1 基于特征表示的方法

基于特征表示的方法将基于深度学习的单模态特征提取算法应用在跨模态图文检索中,以便对不同模态间特征进行建模。

具体工作:

- 模态针对型深层结构模型(modality-specific deep structure,MSDS):使用 CNN 和WCNN 分别提取图像和文本表示,通过使用标准反向传播技术来更新 CNN 与 WCNN 的参数。WCNN可以处理不同长度的序列并获取具有相同维度的结果特征向量,能够有效提取文本特征。

- 基 于 深 度 双 向 表 示 学 习 模 型(deep and bidirectionalrepresentation learning model,DBRLM)的方法,利用文 本 描 述 中 的 序 列 和 结 构 信 息 对 特 征 进 行 增 强 ,利 用 双 向 结 构 探 索 匹 配 与 不 匹 配 图 像 文 本 对 的 关系,增加了匹配对的相似性。

对比发现,双向表示模型比只考虑单向模态不匹配对的情况有更好的效果,且该方法在匹配数据中能够学习丰富的鉴别信息。

针 对 单 标 签 或 多 标 签 样 本 跨 模 态 图 文 检 索 问题,为了更好地弥合图像和相应语义概念间的差距:

- 深 度 卷 积 激 活 特 征 描 述 子(deepconvolutional activation feature,DeCAF),将 CNN 实现产生的 1 000 维度预测得分作为 ImageNet 的输入视觉特征,,DeCAF 可以使学习到的视觉特征具有足够的表征能力

- 深度语义匹配方法(deep semanticmatching,deep-SM),对预训练的 CNN 模型进行微调,对不同的目标数据集采用不同的损失函数,使用微调的 CNN 和训练的全连接神经网络将图像和文本投影到高抽象级别的同构语义空间中

微调的方法可以提高其对目标数据集的适应性,有效降低图像与相应语义之间的鸿沟。通过微调深度 CNN 模型对图像生成视觉嵌入,有效避免了部分语义信息的丢失。

基于特征表示的方法一般通过两种方式来获取更好的跨模态输入特征:

- 针对不同应用场景,采用特殊的网络结构或提取特定的特征来获得图像文本表示;

- 对经典的 CNN 模型进行微调改进

目前研究者在该类方法中更倾向于对视觉特征的探索,文本数据在跨模态语义特征提取过程中并没有得到很好的研究。因此,探索更合适的神经网络以建立文本数据由低级特征到高级语义之间的映射是该类方法所面临的挑战。

2.1.2 基于图文匹配的方法

关注于不同模态间的结构关联,此类方法通过研究图像和文本模态间的语义对应关系来增强模态间特征表示的一致性。

目前主流的基于图文匹配的方法按照模态间语义结构关联的不同可分为三类:

(1)图像-文本对齐的方法:

学习同一实例不同模态特征之间的关系来推断句子片段与图像区域之间的潜在对齐。

对图像内容及自然语言领域的表示同时进行推理:

- 多模态双向递归神经网络结构,其核心观点是将句子视为丰富的标签空间,使连续的单词片段对应于图像中某个特定但未知的位置,该模型能够实现对小区域或相对罕见对象的视觉语义对应关系的解释,在图像-句子排序实验中有良好的性能表现。

- Neural-Image-QA 模型,回答关于图像的自然语言问题,将问题意图推理、视觉场景理解与单词序列预测任务结合起来,其中问题与视觉表征一起被输入 LSTM 进行联合训练,其语言输出取决于视觉和自然语言输入,通过单词和像素的端到端训练,获取了良好的匹配结果,实验表明该方法在"单字"变体情况下能实现最佳性能

- 图 像 -文 本 对 齐 的 方 法 更 关 注 局 部 精 细 的信息,也常用于细粒度的跨模态图文检索任务:

针对服装领域提出了 FashionBERT 模型,相比于 感 兴 趣 区 域(region of interest,RoI)模 型 ,时 尚 文本倾向于描述更精细的信息。FashionBERT 在提取图像表示时将每个图像分割成相同像素的补丁,作为 BERT 模型的序列输入 ,在 匹 配 时 将 文 本 标 记 和 图 像 补 丁 序 列 进 行 连接。实验表明该方法可以在一定程度上掩盖图像中不相关的信息,减小了检测到无用和重复区域的可能性。 - 堆叠交叉注意力模型(stacked cross attention network,SCAN):该 模 型对图像 RoI(感 兴 趣 区 域 region of interest,RoI)模型和文本标记执行跨模态匹配,利用注意力机制将每个片段与来自另一模态的所有片段对齐,以区分单词及图像区域的被关注度,有助于捕捉视觉和语言间的细粒度相互作用。该方法可以灵活地发现细粒度对应关系,在多个基准数据集上都获得了最佳性能。

- 然而,基于注意力机制的方法大多忽略了全局上下文中出现的多种语义情况:

语 境 感 知 注 意 力 网 络(context- aware attentionnetwork,CAAN),根据全局上下文有选择地关注信息量最大的局部片段,综合了模态间和模态内注意过程,同时执行图像辅助的文本注意和文本辅助的视觉注意,很好地聚合了上下文信息,捕捉了潜在的模态内相关性。 - 针对语义模型的复杂性:

基于循环注意 记 忆 的 迭 代 匹 配(iterative matching with recurrentattention memory,IMRAM)方法,该方法通过迭代匹配方案逐步更新跨模态注意力核心,挖掘图文间细粒度的对应关系。首先通过跨模态注意单元估计 V 和 T 两组特征点之间的相似度;然后通过记忆提取单元细化注意力结果,深化潜在对应关系,以便为下一次比对提供更多信息。在 K 个匹配步骤之后,该方法通过对匹配分数求和得出图文之间的相似度。

图像-文本对齐的方法更加关注图像和 文 本 的 局 部 区 域 片 段 信 息 。

优势:在于通过注意力机制等方式,能够获得更好的细粒度语义区分能力,有效解决多语义、图像问答、图像描述和细粒度交互等问题,进而提高了图文匹配的准确度

缺点:由于更多聚焦于局部信息,对数据集的规模和质量以及模型的精细度会有更高的要求,且大多并不适用于全局信息的匹配。

(2)跨模态重构的方法:

跨 模 态 重 构 的 方 法 更 关 注 全 局 信 息 ,此 类 方 法通常利用一种模态信息来重构对应模态,同时保留重建信息,能够增强跨模态特征一致性及语义区分能力。

- 不 同 模 态 数 据 共 享 权 重 的 双 模 深 度 自 编 码 器 模型:跨模态相关性是高度非线性的,而 RBM 很难直接对这种相关性进行学习。基于此,考虑在每个模态的预训练层上训练 RBM 的方法,在仅给定视频数据的情况下进行跨模态重建,从而发现跨模态的相关性。

- 提出了一种图像字幕生成的方法,引入了结构-内容神经 语 言(structure- content neural language model,SC-NLM)模型,SC-NLM 通过编码器学习图像句子联合嵌入,并根据编码器产生的分布式表示,将句子的结构与内容分离,再通过解码器生成新的字幕。该模型有效地统一了联合图像-文本嵌入模型和多模态神经语言模型,实现了对图像和字幕的排序及新字幕的生成。该模型有效地统一了联合图像-文本嵌入模型和多模态神经语言模型

- 此外,由于源集和目标集实例在不可扩展,跨模态检索任务中通常被假定共享相同范围的类,当二者 实 例 具 有 不 相 交 的 类 时 ,难 以 取 得 理 想 的 检 索结果:

模态对抗语义学习 网 络(modal-adversarial semantic learning network,MASLN),其中,跨模态重构子网络通过条件自编码器相互重建各模态数据,实现从源集到目标集的知识转移,使跨模态分布差异最小化;模态对抗语义学习子网络通过对抗性学习机制产生语义表征,使学习到的公共表示对语义有区别而对模态无区别。该方法在可扩展和不可扩展的检索任务中结果都优于其他方法,有效缩小了不同模态之间的异质性差距。

MASLN 模型框架 - 为了克服对嵌入空间的需求:

循环一致图文检索网络(cycle-consistent text and imageretrieval network,CyTIR-Net),将图文检索问题表述为文本和视觉转换的问题。该方法利用文本项和视觉特征的相互翻译建立重构约束,txt2img和 img2txt 模型分别实现了图像和文本域之间的前向和后向转换,确保重构的文本或图像与原始文本或图像向量相似,并包含足够的重构信息。该方法对中小型数据集表现更好,良好地展示了循环一致性约束的正则化能力和网络的泛化能力,以及增强模型在跨模态检索中的场景辨别能力。

跨模态重构的方法利用深度自编码器等方式,有效缩小了模态间的异构性差异。此类方法对数据集的训练及其规模要求并不高,注释成本低,更适用于中小型数据集,具有可扩展性,多用于图像字幕生成等任务。然而,此类方法在模型训练过程中容易忽略细节信息,对目标数据集成对相关性的表现度不足。因此,如何在缩小模态间统计差距的前提下,共同学习局部文本与图像信息的对齐,并据此来动态地调节模态间的生成过程,是目前此类方法所面临的挑战。

(3)图文联合嵌入的方法

相比于图像-文本对齐的方法和跨模态重构的方法,图文联合嵌入的方法一般结合了全局和局部信息作为语义特征的嵌入,因此能够学习到更好的特征判别性。此类方法一般通过图像和文本模态数据的联合训练及语义特征的嵌入来学习图像文本的相关性,进而实现图文匹配。

- 使用弱对齐的数据来学习具有强对齐的跨模态表示,在共享层使用多层感知器将文本信息映射到与视觉模态相同维度的表示空间中。该模型同时用到了微调和统计正则化的方法,可以在训练数据没有明确对齐的情况下跨模态检测相同的概念

- 为了寻找公共表示空间来直接比较不同模态的样本:

深度监督 跨 模 态 检 索(deep supervised cross-modal retrieval,DSCMR)方法,通过最小化样本在标签空间和公共表示空间中的判别损失来监督模型学习判别特征,以保持不同类别语义样本间的区分度,并使用权重共享策略来消除多媒体数据在公共表示空间中的跨模态差异.相比以往的方法,DSCMR 的学习策略可充分利用成对标签信息和分类信息,有效学习异构数据的公共表示。注意:已考虑到不同模态到公共空间的特征映射,但这种映射函数仅关注于学习模态内或模态间的区分特征,而未能在跨模态学习方法中充分利用语义信息。 - 基于正则化跨模态语义映射的深度神经网络(regularized deep neural network,RE-DNN),通过施加模态内正则化,进而获得一个联合模型来捕捉不同输入之间的高度非线性关系。该模型在语义层同时捕获模态内和模态间的关系,且所学习的深层架构能够通过停用部分网络来解决模态缺失问题,具有良好处理不成对数据的能力。该算法仅需要很少的模型训练先验知识,且对大规模数据集可扩展。

- 为了减小低级视觉特征和高级用户概念之间的"认知鸿沟":

多感官融合网络(multi-sensory fusion network,MSFN)联合模型,将同维 CNN 视觉嵌入和 LSTM 描述嵌入看作人类的两种感官,从人类感知角度将视觉和描述性感官相结合。在测试集中的所有图像和文本映射到公共语义空间后,跨模态检索被转化为用传统相似性度量评估的同构检索问题,该方法通过最小化类别损失函数挖掘了跨模态丰富的语义相关性。 - 图文联合嵌入方法通常会学习内嵌式嵌入 函 数(injective embedding functions),对 于 具 有 歧义的实例,内嵌函数寻找单个点会严重限制其在现实世界中的应用:

多义实例嵌入 网 络(polysemous instance embedding networks,PIENets),通过结合输入的全局和局部信息来提取每个实例的 K 个嵌入,同时使用局部 Transformer模 块 关 注 输 入 实 例 的 不 同 部 分 ,获 得 局 部 引 导 特征 表示,并利用残差学习将局部和全局表示结合起来,进而提升特征的判别性。 - 针对内嵌函数学习某一 模态只能表示对应模态的部分信息,进而导致被忽略 信 息 在 映 射 点 丢 失 的 问 题:

多 义视觉语义嵌入方法(polysemous visual-semanticembedding,PVSE),在多实例学习框架中对图像和文本 PIE 网络进行联合优化,且该方法通过最大平均差异(maximum mean discrepancy,MMD)来最小化两个嵌入分布之间的差异。实验表明了残差学习和多实例学习对于实例语义模糊数据检索的重要性。 - 为解决多义实例问题:

生成式 跨 模 态 学 习 网 络(generative cross- modal featurelearning,GXN),将基础表示和抽象表示相结合。除了全局语义层的跨模态特征嵌入外,GXN 还引入了图像到文本和文本到图像两种生成模型的局部跨模态特征嵌入,通过生成过程来学习全局抽象特征及局 部 基 础 特 征 。有 效 处 理 多 义 实 例 问题,并能够检索具有局部相似性的图像或具有词级相似性的句子。 - 通过引入 GAN 网络的对抗 思 想:

对 抗 式 跨 模 态 检 索 方 法(adversarial cross-modal retrieval,ACMR),该模型在对抗机制下执行语义学习,其中,特征投影器从公共子空间中的不同模态生成模态不变表示,模态分类器根据生成的表示来区分不同的模态,并以这种方式引导特征投影器的学习。通过对特征投影器施加三元组约束,将具有相同语义标签的跨模态表示差异最小化,同时最大化具有不同语义的图像文本之间的距离。该方法在跨模态数据被投影到公共子空间中时,数据的潜在语义结构被更好地保留。

图文联合嵌入的方法更关注对高级语义信息的探索。此类方法一般利用生成对抗等思想,通过最小化判别损失函数和模态不变性损失等方式挖掘丰富的语义相关性,能够很大程度上消除跨模态异构差异,减小"语义鸿沟"及"认知鸿沟",有效解决多义实例、模态缺失等问题,并能良好地捕获成对信息相关性。

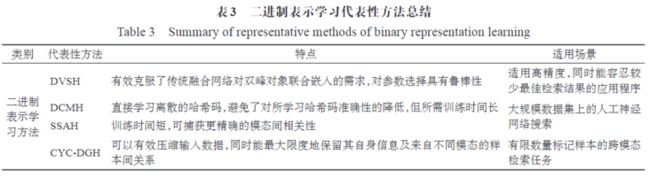

2.2 二进制表示学习方法

对于一些对检索效率要求高的任务场景,实值表示学习并不适用。二进制表示学习方法在检索效率上具有优势,其在保证准确率波动幅度可控的前提下,可显著提升检索速度。

二进制表示学习方法将跨模态数据投影到一个公共汉明空间,目的在于给相似的跨模态内容赋予相似的哈希码(快速检索?)。

近十年基于二进制表示学习的方法突破性进展与成果:

- 深 度 哈 希 算 法

- 卷积神经网络哈希(convolutional neural network Hashing,CNNH)模型,使基于 CNN 的深度哈希算法开始受到关注。

- 二进制哈希码的深度学习(deep learning of binary Hash codes,DLBHC)方法,利用深度 CNN 的增量学习特性,以点的方式进行编码和图像表示,同时学习特定图像表征和类似哈希的函数,实现了快速图像检索并使其适用于大规模数据集。

- 深度语义哈希排序(deep semantic ranking Hashing,DSRH)方法:进一步探索多标签关联图像的复杂多级语义结构,利用深度 CNN 与列表排序监督哈希,共同学习特征表示和从它们到哈希码的映射,避免了传统方法特征语义表示能力不足的限制。

- 为确保哈希码和不同信息源所设计哈希函数的一 致 性:

多 源 信 息 复 合 哈 希 算 法(composite Hashing with multiple information sources,CHMIS),通 过 调 整 权 重 的 信 息 集 成 方 法(CHMISwith adjusted weights,CHMIS-AW)调 整 每 个 单 独 源的权重,将来自不同源的信息集成到二进制哈希码中,进而最大化编码性能,保留了训练示例之间的语义相似性。 - 在基于深度哈希的跨模态图文检索算法中,一些研究者使用了端到端的方法。针对不同模态的异构性:

深度视觉语义哈希(deep visualsemantic Hashing,DVSH)模型,该模型是首个跨模态哈希的端到端学习方法,设计了学习图文联合嵌入的视觉语义融合网络,以桥接不同模态及两个模态特定的哈希网络,其生成的紧凑哈希码能够捕捉视觉数据和自然语言之间的内在对应关系,进而获取判别性特征,且该模型有效克服了传统融合网络对双峰对象联合嵌入的需求,更适用于高精度的应用程序。 - 针对跨模态哈希(cross-modal Hashing,CMH)手工制作特性与哈希码学习不能良好兼容的问题:

跨 模 态 深 度 哈 希 算 法(deep cross-modal Hashing,DCMH),将 特 征 学 习 和 哈 希 码 学 习集成到同一端到端学习框架,通过同时对不同类型样本对施加约束使相似样本间相互靠近,从而保证模态间的对齐,且 DCMH 直接学习离散的哈希码,避免了检索准确性的降低,提高了检索性能。 - 弥补模态差异以进一步提高检索准确度:

自 我 监 督 的 对 抗 式 哈 希 方 法(self-supervised adversarial Hashing,SSAH),将 对 抗 式 学习以自监督方式结合到跨模态哈希中,由自监督语义 生 成 网 络(LabNet)和 图 像 文 本 对 抗 网 络(ImgNet和 TexNet)组成。自监督语义生成网络用来监督两个模态的语义空间以及对抗性学习。两个对抗网络用来共同学习不同模态的高维特征及其对应的哈希码。实验表明,SSAH 比 DCMH 减少了 90%的训练时间,且 SSAH 学习了更充分的监督信息,可以捕获不同模态间更精确的相关性。 - 针对跨模态哈希在有限数量标记样本上容易过拟合以及高维输入转换成二进制代码导致的信息丢失问题:

循环一致的深层生成哈希算法(cycle-consistent deep generative Hashing,CYC-DGH),通过循环一致的对抗学习在没有成对对应的情况下学习耦合的生成哈希函数。该算法通过深度生成模型从哈希码中重新生成输入,使学习到的哈希码最大限度地关联每个输入-输出对应关系,且哈希嵌入过程中的信息损失被最小化,有效压缩了输入数据,同时能够最大限度地保留自身信息及不同模态样本间的关系,对减小哈希函数间的模态差异有良好表现。

二进制表示学习方法更侧重解决模态特征异构引起的模态差异问题(???和实值表示学习不一样吗),运用端到端、生成对抗等思想,致力于最大化特征分布的一致性。此类方法还有效解决了过拟合等问题。然而由于此类方法在二值化过程中会导致信息的丢失以及原有结构被破坏。

考虑模态内数据结构和模态间结构匹配的关联,优化计算等是目前需要研究的方向。

从类别、代表性方法、特点和适用场景四方面对一些具有重要作用的跨模态检索算法进行了对比分析:

博客写作心得:模块化抽取实现自我学习理解及后续快速查询。