NNDL 第三章课后作业

电子版

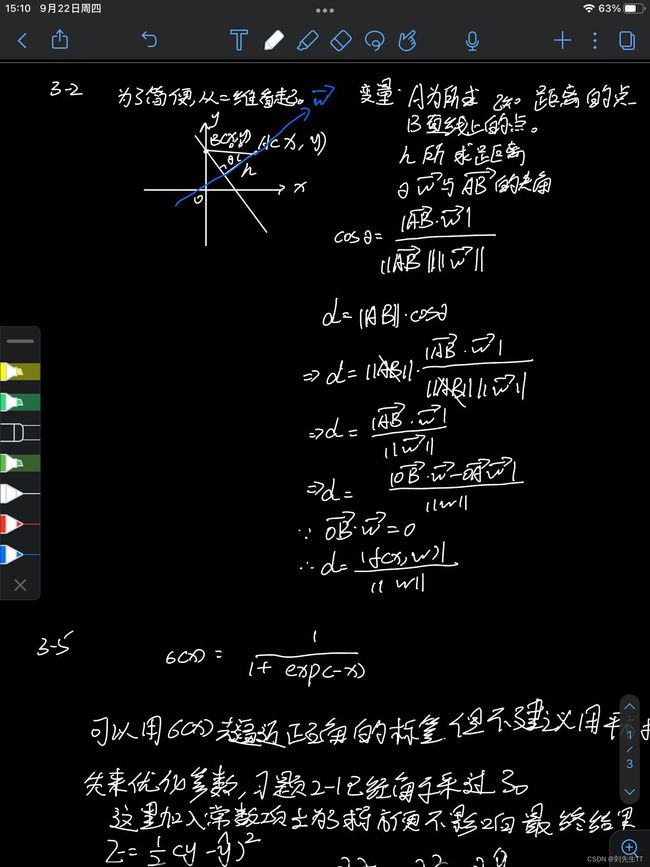

3-2在线性空间中,证明一个点 x x x到平面 f ( x ; w ) = w x + b = 0 f(x;w)=w^x+b=0 f(x;w)=wx+b=0的距离为 ∣ f ( x , w ) ∣ / ∣ ∣ w ∣ ∣ |f(x,w)|/||w|| ∣f(x,w)∣/∣∣w∣∣|

公式推导

cos θ = ∣ A B ⃗ − w ⃗ ∣ ∣ ∣ A B ⃗ ∣ ∣ ∣ ∣ w ⃗ ∣ ∣ \cos \theta =\frac{|\vec{AB}-\vec{w}|}{||\vec{AB}||||\vec{w} ||} cosθ=∣∣AB∣∣∣∣w∣∣∣AB−w∣

d = ∣ ∣ A B ∣ ∣ c o s θ d=||AB||cos\theta d=∣∣AB∣∣cosθ

= > d = A B ⃗ . w ⃗ ∣ ∣ w ⃗ ∣ ∣ =>d=\frac{\vec{AB}.\vec{w}}{||\vec{w}||} =>d=∣∣w∣∣AB.w

= > d = O B ⃗ . w ⃗ − O A ⃗ . w ⃗ ∣ ∣ w ⃗ ∣ ∣ =>d=\frac{\vec{OB}.\vec{w}-\vec{OA}.\vec{w}}{||\vec{w}||} =>d=∣∣w∣∣OB.w−OA.w

因为 O B ⃗ w ⃗ = 0 \vec{OB}\vec{w}=0 OBw=0

d = O A ⃗ . w ⃗ ∣ ∣ w ⃗ ∣ ∣ d=\frac{\vec{OA}.\vec{w}}{||\vec{w}||} d=∣∣w∣∣OA.w

d = ∣ f ( x , w ) ∣ ∣ ∣ w ⃗ ∣ ∣ d=\frac{|f(x,w)|}{||\vec{w}||} d=∣∣w∣∣∣f(x,w)∣

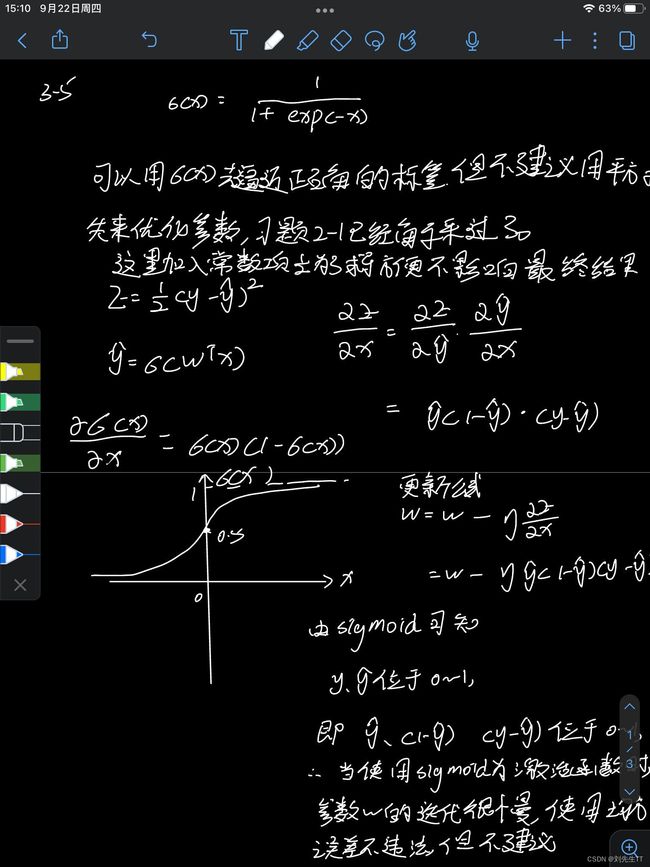

3-5 在Logistic回归中,是否可以用 y ^ = σ ( w T x ) \hat{y}=\sigma(w^Tx) y^=σ(wTx)去逼近正确的标签y,并用平方损失 ( y − y ^ ) 2 (y-\hat{y})^2 (y−y^)2最小化来优化参数 w w w?

σ ( x ) = 1 1 + e x p ( − x ) \sigma(x)=\frac{1}{1+exp(-x)} σ(x)=1+exp(−x)1

可以用 s i g m o i d sigmoid sigmoid函数去逼近正确的标签,但是并不建议用均方误差来优化函数,习题2-1中已经说过了。

E = 1 2 ( y − y ^ ) 2 E=\frac{1}{2}(y-\hat{y})^2 E=21(y−y^)2

这里均方误差加入常数项是为了求导方便,并不影响最终的结果。

下面开始公式推导

y ^ = σ ( w T x ) \hat{y}=\sigma(w^Tx) y^=σ(wTx)

∂ E ∂ x = ∂ E ∂ y ^ ∂ y ^ ∂ x = y ^ ( 1 − y ^ ) ( y − y ^ ) \frac{\partial E}{\partial x}=\frac{\partial E}{\partial \hat{y}}\frac{\partial \hat{y}}{\partial{x}} =\hat{y}(1-\hat{y})(y-\hat{y}) ∂x∂E=∂y^∂E∂x∂y^=y^(1−y^)(y−y^)

更新公式为

w = w − μ ∂ E ∂ X = w − y ^ ( 1 − y ^ ) ( y − y ^ ) w=w-\mu\frac{\partial E}{\partial X}=w-\hat{y}(1-\hat{y})(y-\hat{y}) w=w−μ∂X∂E=w−y^(1−y^)(y−y^)

由 s i g m o i d sigmoid sigmoid函数可以知道,值域位于 [ 0 , 1 ] [0,1] [0,1]之内。所以最后所得出来 y ^ − ( 1 − y ^ ) ( y − y ^ ) \hat{y}-(1-\hat{y})(y-\hat{y}) y^−(1−y^)(y−y^)函数值极小。更新速率贼慢,不适用。虽然龟兔赛跑最后乌龟赢了,但是那是在兔子睡着的情况下,如果能当兔子还是当兔子。

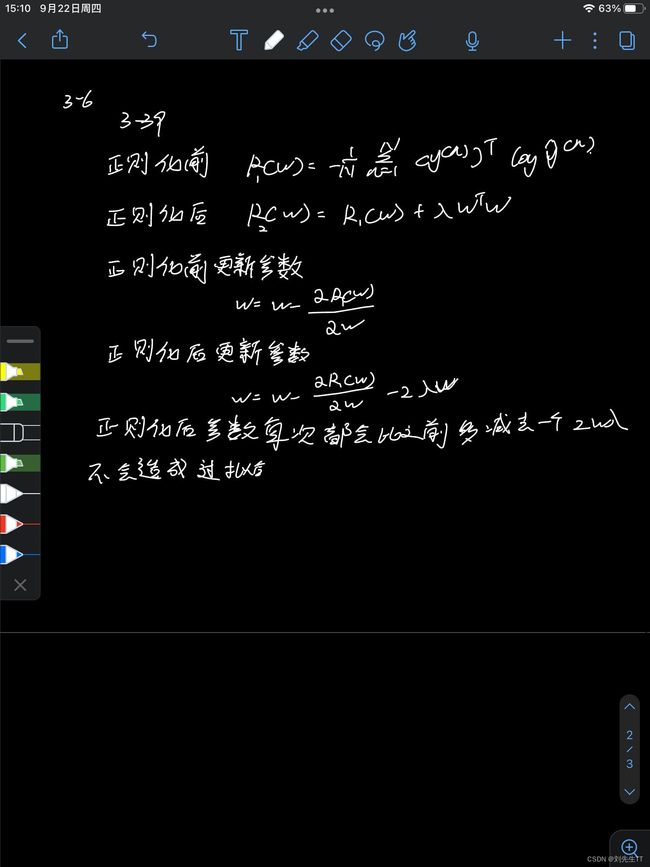

习题3-6 在Softmax回归的风险函数中,如果加上正则化会有什么影响?

风险回归函数为,同时也是正则化前的函数 R 1 ( w ) = 1 N ∑ n = 1 N ( y ( n ) ) T l o g y ^ ( n ) R_{1}(w)=\frac{1}{N} \sum_{n=1}^{N}(y^{(n)})^{T}log\hat{y}^{(n)} R1(w)=N1∑n=1N(y(n))Tlogy^(n)

正则化后函数 R 2 ( w ) = 1 N ∑ n = 1 N ( y ( n ) ) T l o g y ^ ( n ) R_{2}(w)=\frac{1}{N} \sum_{n=1}^{N}(y^{(n)})^{T}log\hat{y}^{(n)} R2(w)=N1∑n=1N(y(n))Tlogy^(n)

正则化前更新参数 w = w − ∂ R 1 ( w ) ∂ w w=w-\frac{\partial{R1(w)}}{\partial{w}} w=w−∂w∂R1(w)

正则化后更新参数 w = w − ∂ R 2 ( w ) ∂ w − 2 λ w w=w-\frac{\partial{R2(w)}}{\partial{w}}-2\lambda w w=w−∂w∂R2(w)−2λw

通过观察前后的式子可知,正则化后每次都多减去 2 λ w 2\lambda w 2λw

最终求出来的参数 w w w比正则化之前的小,所以最后的参数比较小,不会造成过拟合。