FFA 2021 专场解读 - 开源解决方案 / 流批一体

公众号更名公告

「Flink 中文社区」更名为「Apache Flink」

感谢你们的关注

Flink Forward Asia 2021 重磅开启,全球 40+ 多行业一线厂商,80+ 干货议题,带来专属于开发者的技术盛宴。

其中,开源解决方案专场,来自 Pravega、Pulsar、TiDB、Zeppelin、Atlas 等社区的技术专家围绕 Flink 的生态融合,探讨当下大数据的发展趋势与未来动向,并展现相关技术在一线生产场景的最佳实践;

流批一体专场,字节跳动、美团、京东、小米的技术专家也将分享流批一体的生产实践,另有来自阿里巴巴的技术专家手把手教你如何构建流批一体数仓。

▼ 扫码了解完整大会议程 ▼

(大会官网)

开源解决方案

HTAP 趋势下,大数据的未来

黄东旭|PingCAP 联合创始人兼 CTO,资深基础软件工程师,架构师

近年来行业数字化场景爆发式增长,数据呈现出海量、实时、在线等趋势。随着企业对数据实时性和可靠性的要求越来越高,传统通过数据库、中间件、等暴露出上线难、维护成本极高等问题,严重阻碍企业数字化进程。HTAP (Hybrid Transactional/Analytical Processing,即混合事务 / 分析处理)数据库能够在一份数据源上同时支撑在线事务处理(OLTP)和在线分析处理(OLAP)场景,避免了传统架构中在线与离线数据库之间大量的数据交互。

权威调研机构 Gartner 认为,HTAP 数据库将成为数据库领域的重要发展趋势。同样的在大数据领域也呈现出了强烈的实时和在线化趋势,实时计算正在成为不可缺少的大数据能力。TiDB 和 Flink 是 HTAP 和实时计算领域的领先者。TiDB 为海量数据带来了高性能在线查询能力和实时更新能力,能够为 Flink 实时数据打宽和实时计算结果存储提供完善的支撑。Flink 除了为 TiDB 的交易数据提供端到端实时处理能力之外,还为 TiDB 提供了外部异构数据的联邦处理能力。两大生态创新整合形成的一体化的数据平台,能够帮助企业更快应对行业变化、不确定性和机遇。

通过本次分享,听众将了解在线交易同大数据应用在 HTAP 数据库重新结合的趋势以及 Flink 与 TiDB 的联合能为企业带来哪些新的可能。

Pravega Flink connector Table API

进阶功能揭秘

周煜敏|戴尔科技集团高级软件工程师,Apache Flink Contributor

介绍 Pravega Flink connector 在进阶 Table API 的支持工作,在 FLIP-95 的 Table API 的基础上,进一步添加了包括端到端的 debezium 格式的 CDC 支持以及 catalog API 的支持。

演讲内容会围绕这两部分的功能和实现进行展开,介绍 Pravega 项目本身 debezium sink 以及 schema registry 等相关技术,以及 connector 在此基础上集成这些功能上遇到的困难以及代码演进的历程。希望我们的经验可以帮助到社区的其他项目。

打造批流融合:

Pulsar - Flink Connector

的设计、开发和使用

盛宇帆|StreamNative 工程师

对于 Flink 而言 Pulsar 是一个新鲜而又熟悉的老朋友,早在 19 年,我们就有计划给 Flink 社区提交 Pulsar Connector 的代码。随着 Pulsar 社区的壮大,对于流批一体化的实际,这一贡献进度翻开了全新的篇章。

Pulsar 的小伙伴将基于全新的 Flink Source 和 Sink API 重新设计并开发了 Pulsar Connector,并且已将 Sink API 合并到 Flink 的代码仓库进行维护。

本次演讲,我们将介绍 Flink 1.14.0 新版本的一个特性 Pulsar - Flink Connector,以及当前的 Pulsar Connector 如何打通 Flink 和 Pulsar 之前的壁垒、如何使用全新的 Pulsar Connector 开发 Flink 应用来使用 Pulsar。

大数据三剑合一:

Flink + Zeppelin + Airflow

章剑锋|阿里巴巴高级技术专家,Apache Member,PMC of Zeppelin、Tez、Livy

Flink + Zeppelin 发展多年,已经成为了一个比较成熟的 Flink 开发平台。随着 Flink 的批流引擎的统一,对 Flink 的生产调度也变得非常迫切。Airflow 是目前开源届最流行的调度系统,今年我们把 Zeppelin 和 Airflow 做了一个整合。这样的话,用户可以在 Zeppelin 里做 Flink 作业的交互式开发,然后在 Airflow 里通过调用 Zeppelin 来调度 Flink 作业,这样把 Flink 作业的开发和生产做了一个完美无缝的整合。

本次演讲我们将为大家讲述我们是如何整合这大数据三剑客的,这个整合又能如何提高你的开发以及运维效率。

Mars on Flink:

实时数据流上的 Pandas

付典|阿里巴巴高级技术专家,Apache Flink PMC

Mars on Flink 解决的问题:结合 Flink 引擎的实时数据处理能力以及 Mars 引擎的分布式 Pandas 计算能力,用户基于 Pandas API 开发的单机实验作业,可以不经过修改或者只需要少量修改,就可以部署到生产环境中进行分布式实时处理;

Mars on Flink 的架构;

Mars on Flink 的使用案例;

Mars on Flink 下一步的发展规划。

使用 Apache Atlas 追踪

Apache Flink 的实时数据仓库血缘

刘岩|Cloudera 解决方案工程师,Apache Hive/Apache Flink Contributor

Apache Flink 已经成为了实时数据处理的事实标准,Apache Atlas 也已经成为了开源的数据治理方案。本专题首先介绍如何使用 Apache Flink 对现有数据仓库的主要加工算法进行实时化改造,并引申出在使用 Apache Flink 构建实时数据仓库时,如何通过 Apache Atlas 来追踪其数据血缘,并交互式分析上下游血缘影响。

基于 Apache Flink + RocketMQ + Hudi

构建 Lakehouse

蒋晓峰|阿里巴巴技术专家,Apache RocketMQ & Apache ShardingSphere & SOFAJRaft Committer,Apache Flink Contributor

Lakehouse 是低成本,直接访问云存储并且提供传统 DBMS 管系统性能和 ACID 事务、版本、审计、索引、缓存、查询优化的数据管理系统,Lakehouse 结合数据湖和数据仓库的优点:包括数据湖的低成本存储和开放数据格式访问,数据仓库强大的管理和优化能力。

本次演讲将介绍使用 Apache Flink + RocketMQ + Hudi 构建新一代 Lakehouse 解决方案与最佳实践,其中 RocketMQ 提供面向流式存储支持、流批一体的数据访问能力等,让其成为一个可以统一批和事件流消息平台。RocketMQ Hudi Connector 通过几行简单的配置可以轻松实现数据自动流入 Hudi,自定义负载均衡可以自动伸缩数据流管道宽度,支持 Hudi 所有参数配置和特性,如 Copy-On-Write/Merge-On-Read 表类型、Schema Evolution等。

蚂蚁实时计算 Flink on OceanBase

梅庆|蚂蚁集团高级技术专家,OceanBase 解决方案架构师,OceanBase 开源生态负责人

陶然|阿里巴巴高级开发工程师,Apache Spark/Apache Flink Contributor

蚂蚁的实时计算业务主要运行于云化环境,云上混部环境中我们遇到了很多问题与挑战,如稳定性问题,多输入输出组件和复用及冲突问题,结果存储性能问题,云盘性能问题,易用性问题,资源使用效率等问题,对此我们也采取了相应的解决方案。

本次为大家带来我们生产实践中解决 Flink 相关问题的经验和分享,以及 OceanBase 的特性和选 OceanBase 的原因。

双剑合璧:Flink + StarRocks

构建实时数仓解决方案

谢寅|StarRocks 解决方案架构师

极速的实时数据处理能力和极速的查询分析能力,只有把这两种能力结合起来,才能整体提升数仓业务端到端的实时性。Apache Flink 作为分布式计算引擎已经成为实时 ETL 处理方面的事实标准,而配合极速分析型 MPP 数据库 StarRocks,会让实时数仓的构建如虎添翼。

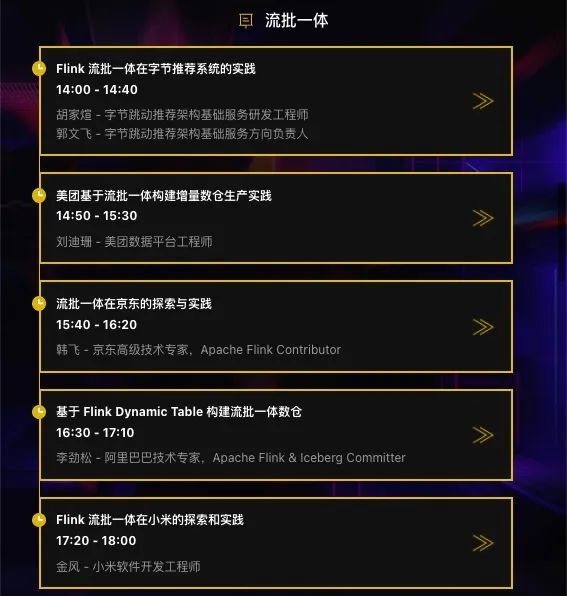

流批一体

Flink 流批一体在字节推荐系统的实践

胡家煊|字节跳动推荐架构基础服务研发工程师

郭文飞|字节跳动推荐架构基础服务方向负责人

特征生产是推荐系统数据流转中非常重要的环节,从上游的埋点数据经过清洗、过滤、聚合计算等步骤形成最终供线上取用的各种特征,是推荐系统的基石;

目前字节推荐系统中的特征生产流程,经历了从早期的 Hadoop、Spark 批式处理程序,到现在实时性更强、流批一体的 Flink 应用,从时效性、稳定性、架构完整性方面都取得了一些收益;本次分享主要介绍支持流批一体的 Flink 框架是如何在字节推荐系统中玩转的;

业务背景

内部特征服务调研;

特征生产面临的挑战;

新一代基于 Flink 的推荐特征平台。

整体架构设计

有状态特征计算;

ETL 类型特征计算;

批式特征计算。

特征入湖

线上问题和挑战

数据回溯;

窗口特征计算精度 tradeoff;

性能优化。

未来规划

美团基于流批一体

构建增量数仓生产实践

刘迪珊|美团数据平台工程师

介绍美团数据生产场景:在离线数仓和实时数仓之外,基于 Flink 的流批一体和数据湖存储技术,构建增量数仓生产的架构以及实践。主要包括增量生产场景、Flink runtime 的优化、语义优化、存储能力优化等。

流批一体在京东的探索与实践

韩飞|京东高级技术专家,Apache Flink Contributor

本次分享包含京东对流批一体的整体思考、技术方案以及目前的实践应用情况。

大纲:

整体思考(痛点、核心理念、技术挑战);

技术方案(基于 FlinkSQL + Iceberg 的架构、流批模型问题、资源混部、流批一体相关的 Flink 优化);

流批一体业务落地案例介绍;

社区贡献及未来规划。

基于 Flink Dynamic Table

构建流批一体数仓

李劲松|阿里巴巴技术专家,Apache Flink & Iceberg Committer

在实时数仓中,消息队列用于数仓 Pipeline 的数据源和中间阶段,但是实时数仓的中间表是不可查询的,融合离线数仓必然需要提供可查询的中间表。

因此,可以将中间数据双写到 Hive 或湖存储中,以便查询中间表。但是,这样的 Pipeline 存在以下问题:

对于用户来说,Append 模式和 Upsert 模式需要对应特定的存储。没有主键的情况更为复杂;

增加了架构复杂性,增加了操作和运维复杂性;

更为关键的是,流和批的体验是割裂的两套。

在 Flink SQL 上,我们引入了内置的 Dynamic Table 存储,这是一种真正统一的 changelog & table 表示,它提供易用的流计算,同时提供高性能的批查询,还可以解决流存储数据过期难以回刷的困难。

Flink 流批一体在小米的探索和实践

金风|小米软件开发工程师

小米从 2019 年开始接入使用 Flink,至今 Flink 在小米内部的应用飞速发展,已成为小米内部实时计算的标准。期间我们不断完善作业管理平台,支持管理 Flink / FlinkSQL 作业,帮助业务更好地使用 Flink。同时基于 metacat + ranger,我们做了统一的元数据管理和权限管理,并应用于 Flink、Presto、Spark 等计算引擎。我们的作业管理平台支持了公司内部众多大数据组件,包括 Iceberg,Talos (小米内部消息队列),Kudu,Hive,Doris,TiDB。

2020 年,基于 FlinkSQL + Talos,我们落地了小米实时数仓方案, 构建了小米销售服务的实时数仓。2021 年初,我们开始探索使用数据湖,基于 Flink + Iceberg 我们初步实现了流批一体的技术方案,在小米内部的一些场景也得到了应用。后续我们会不断完善小米的流批一体方案,期待 Flink + Iceberg 能够提升业务效率,应用于更多的使用场景。

以上为 Flink Forward Asia 2021 开源解决方案以及流批一体专场内容节选,了解更多大会详情可扫描下方二维码。

Flink Forward Asia 2021 赞助与合作

首届 Flink Forward Asia Hackathon 正式启动,10W 奖金等你来!

欢迎进入赛事官网了解详情:

https://www.aliyun.com/page-source//tianchi/promotion/FlinkForwardAsiaHackathon

更多 Flink 相关技术问题,可扫码加入社区钉钉交流群~