KVM虚拟化技术核心功能详解

一、云计算概述

云计算自从提出,一直没有一个明确而统一的定义。维基百科对云计算做了如下的描述:云计算是一种通过因特网以服务的方式提供动态可伸缩的虚拟化的资源的计算模式。美国国家标准与技术研究院(NIST)定义:云计算是一种按使用量付费的模式,这种模式提供可用的、便捷的、按需的网络访问,进入可配置的计算资源共享池(资源包括网络、服务器、存储、应用软件和服务),这些资源能够被快速提供,只需投入很少的管理工作,或与服务供应商进行很少的交互。

也有人基于云端计算的实现方式,认为云计算是分布式计算技术的一种,其最基本的概念是,透过网络将庞大的计算处理程序自动分拆成无数个较小的子程序,再交给由多部服务器所组成的庞大系统经搜寻、计算分析之后将处理结果回传给用户。透过这项技术,网络服务提供者可以在数秒之内,处理数以千万计甚至亿计字节的信息,实现和“超级计算机”同样强大效能的网络服务。提供资源的网络被称为“云”。“云”中的资源在使用者看来是可以无限扩展的,并且可以随时获取,按需使用。

总之,云计算是一种基于互联网的计算方式, 通过这种方式, 共享的软硬件资源和信息可以按需求提供给计算机各种终端和其他设备 。

以前要完成信息处理, 是需要在一个客观存在的计算机上完成的, 它看得见摸得到。后来随着计算机硬件、网络技术、存储技术的飞速发展, 计算机硬件性能过剩, 因为足够高的性能在大部分时间是被浪费掉的, 并没有参与客观运算。

那如果将资源集中起来, 计算任务去共享、复用集中起来的资源, 将是对资源的极大节省和效率的极大提升; 这就是云计算产生的背景, 它就是将庞大的计算资源集中在某个地方或是某些地方, 而不再是放在身边的计算机了, 用户的每一次计算, 都发生在那个被称为“**☁️云**”的地方。

云计算的服务模型

云计算的模型是以服务为导向的,根据提供的服务层次不同,可分为:IaaS(Infrastructure as a Service, 基础架构即服务)、PaaS(Platform as a Service, 平台即服务)、SaaS(Software as a Service, 软件即服务)。它们提供的服务越来越抽象,用户实际控制的范围也越来越小。

SaaS:提供商将应用软件统一部署在自己的服务器上,用户根据需求通过互联网向厂商订购应用软件服务,服务提供商根据客户所定软件的数量、时间的长短等因素收费,并且通过浏览器向客户提供软件的模式。云服务提供商提供给客户直接使用软件服务, 如Google Docs、Microsoft CRM、Salesforce.com等。用户不必自己维护软件本身, 只管使用软件提供的服务。用户只需拥有能够接入互联网的终端,即可随时随地使用软件,并为该软件提供的服务付费。

在这种模式下,客户不再像传统模式那样花费大量资金在硬件、软件、维护人员上,只需要支出一定的租赁服务费用,通过互联网就可以享受到相应的硬件、软件和维护服务,这是网络应用最具效益的营运模式。对于小型企业来说,SaaS是采用先进技术的最好途径。

PaaS:PaaS把开发环境作为一种服务来提供。这是一种分布式平台服务,厂商提供开发环境、服务器平台、硬件资源等服务给客户,用户在其平台基础上定制开发自己的应用程序并通过其服务器和互联网传递给其他客户。PaaS能够为企业或个人提供研发的中间件平台,提供应用程序开发、数据库、应用服务器、试验、托管及应用服务。

用户负责维护自己的应用程序, 但并不掌控操作系统、硬件以及运作的网络基础架构。如aliyun的RDS-MySQL、RDS-Redis等。平台是指应用程序运行环境(图中的Runtime)。通常, 这类用户在云环境中运维的应用程序会再提供软件服务给他的下级客户。用户为自己的程序的运行环境付费。

IaaS:用户有更大的自主权, 能控制自己的操作系统、网络连接(虚拟的)、硬件(虚拟的)环境等。云服务提供商提供的是一个虚拟的主机环境,该虚拟主机环境由多台服务器组成的“云端”基础设施,作为计量服务提供给客户。它将内存、I/O设备、存储和计算能力整合成一个虚拟的资源池为整个业界提供所需要的存储资源和虚拟化服务器等服务。这是一种托管型硬件方式,用户付费使用厂商的硬件设施。例如aliyun的ECS、腾讯的CMS等,用户为一个主机环境付费。

IaaS的优点是用户只需低成本获得所需的硬件资源,按需租用相应计算能力、存储容量、网络带宽,而且省去了硬件运维方面的成本,大大降低了用户在硬件上的开销。

云计算技术

云计算的兴起,改变了现有的以本地计算为主的应用模型。用户不再需要付费购买软件并将其安装到本地的计算机中执行。取而代之,大量的计算任务,由客户端通过网络发起,在云计算提供商的数据中心的服务器集群上进行计算,其结果经由网络返回,在客户端进行呈现。新的计算模型的提出,必然伴随着新的问题需要解决。在云计算的环境下,不同厂商对如何有效地管理云端的资源,为用户提供快捷的计算进行了大量研究,提出和总结了一些行之有效的云计算技术。

1. Map/Reduce

Map/Reduce是Google开发的编程模型,它是一种简化的分布式编程模型和高效的任务调度模型,用于大规模数据集(大于1TB)的并行运算。严格的编程模型使云计算环境下的编程十分简单。MapReduce模式的思想是将要执行的问题分解成Map(映射)和Reduce(化简)的方式,先通过Map程序将数据切割成不相关的区块,分配(调度)给大量计算机处理,达到分布式运算的效果,再通过Reduce程序将结果汇总输出。

Map/Reduce编程模型适用于很多应用,例如,分布式搜索、分布式排序、机器学习、基于统计的机器翻译等。在Google公司,互联网网页的搜索索引也是用Map/Reduce技术计算生成的。

Map/Reduce目前已经有基于各种不同计算机编程语言的库实现,其中相当流行的是有Apache基金会的用Java语言开发的开源的Hadoop。

2. 资源管理平台

云计算资源规模庞大,服务器数量众多并分布在不同的地点,同时运行着数百种应用,如何有效地管理这些服务器,保证整个系统提供不间断的服务是巨大的挑战。

云计算系统的平台管理技术能够使大量的服务器协同工作,方便进行业务部署和开通,快速发现和恢复系统故障,通过自动化、智能化的手段实现大规模系统的可靠运营。

当前比较流行的云计算平台,主要有思杰的CloudStack,开源的Eucalyptus,VMware公司的vCloud Director和开源的OpenStack等。除了VMware公司的vCloud Director没有免费版本和只支持VMware自由的虚拟化产品以外,其余几个都提供免费版本,而且支持多个虚拟化产品。Eucalyptus和OpenStack还对亚马逊的API保持兼容,基于亚马逊API的所有的脚本和软件产品都可以轻松地进行私有云部署。

现在,CloudStack和OpenStack正处在激烈的竞争中,两者都希望自己能够成为开源社区云计算平台的事实标准。CloudStack在成熟度上面明显优于OpenStack,在培育客户方面也占了先机,但是背后的推手主要是思杰。OpenStack虽然是后起之秀,但是得到了诸如IBM、思科、英特尔、惠普和戴尔等大牌厂商的支持。究竟谁是未来的开源云平台老大,鹿死谁手,还未可知。

3. 虚拟化

虚拟化是构建云基础架构不可或缺的关键技术之一。云计算的云端系统,其实质上就是一个大型的分布式系统。虚拟化通过在一个物理平台上虚拟出更多的虚拟平台,而其中的每一个虚拟平台则可以作为独立的终端加入云端的分布式系统。比起直接使用物理平台,虚拟化在资源的有效利用、动态调配和高可靠性方面有着巨大的优势。利用虚拟化,企业不必抛弃现有的基础架构即可构建全新的信息基础架构,从而更加充分地利用原有的IT投资。

可以说,虚拟化是云端系统部署必不可少的基础。

二、虚拟化技术

近几年,云计算大潮风起云涌,Amazon的AWS是公共云计算平台的先驱和领导者,Google的GAE、GCE也取得了一定的成绩,国内大型互联网公司也分别推出自己的云计算服务,如阿里云、腾讯云、盛大云、新浪SAE、百度BAE等。云计算已成为IT技术领域最热门的词汇之一,现在很多互联网服务都声称自己是“云”服务。在云计算发展的大背景下,支撑着云计算服务的最底层、最基础的虚拟化技术也得到了快速发展,成为技术研究和应用的热点之一。

虚拟化在计算机领域, 虚拟化指创建某事物的虚拟版本, 包括虚拟的计算机硬件平台、存储设备以及计算机网络资源。

人们往往出于对稳定性和兼容性的追求,并不情愿频繁地对已经存在的计算元件做大幅度的变更。虚拟化技术则是另辟蹊径,通过引入一个新的虚拟化层,对下管理真实的物理资源,对上提供虚拟的系统资源,从而实现了在扩大硬件容量的同时,简化软件的重新配置过程。

虚拟化是一种资源管理技术, 它将计算机的各种实体资源予以抽象和转化, 并提供分割、重新组合, 以达到最大化利用物理资源的目的。广义上来说, 我们一直以来对物理硬盘所做的逻辑分区、以及后来的LVM, 都可以纳入虚拟化的范畴; 在没有虚拟化之前, 一个物理主机上面只能运行一个操作系统及其之上的一系列运行环境和应用程序, 有了虚拟化技术, 一个物理主机可以被抽象、分割成多个虚拟的逻辑意义上的主机, 向上支撑多个操作系统及其之上的运行环境和应用程序, 则其资源就可以被最大化的利用。

![]()

如上图所示的Virtual Machine Monitor(VMM, 虚拟机监控器, 也称为Hypervisor)层, 就是为了达到虚拟化而引入的一个软件层,虚拟机监控器运行的环境,也就是运行的实际物理环境,称之为宿主机,其上虚拟出来的逻辑主机, 称为客户机(Guest Machine)。它向下掌控实际的物理资源(相当于原本的操作系统); 向上呈现给虚拟机N份逻辑的资源。为了做到这一点, 就需要将虚拟机对物理资源的访问“偷梁换柱”——截取并重定向, 让虚拟机误以为自己是在独享物理资源。

1、软件虚拟化和硬件虚拟化

实现虚拟化的重要一步就在于,虚拟化层必须能够截获计算元件对物理资源的直接访问,并将其重新定向到虚拟资源池中。根据虚拟化层是通过纯软件的方法,还是利用物理资源提供的机制来实现这种“截获并重定向”,我们可以把虚拟化划分成为软件虚拟化和硬件虚拟化两种。

如下图所示:

软件虚拟化

纯软件虚拟化,顾名思义,就是用纯软件的方法在现有的物理平台上(往往并不支持硬件虚拟化)实现对物理平台访问的截获和模拟。

常见的软件虚拟机例如QEMU,它是通过纯软件来仿真X86平台处理器的取指、解码和执行,客户机的指令并不在物理平台上直接执行。由于所有的指令都是软件模拟的,因此性能往往比较差,但是可以在同一平台上模拟不同架构平台的虚拟机。

VMWare的软件虚拟化则使用了动态二进制翻译的技术。虚拟机监控机在可控制的范围内,允许客户机的指令在物理平台上直接运行。但是,客户机指令在运行前会被虚拟机监控机扫描,其中突破虚拟机监控机限制的指令会被动态替换为可以在物理平台上直接运行的安全指令,或者替换为对虚拟机监控器的软件调用。这样做的好处是比纯软件模拟性能有大幅的提升,但是也同时失去了跨平台虚拟化的能力。

在纯软件虚拟化解决方案中,VMM在软件套件中的位置是传统意义上操作系统所处的位置,而操作系统的位置是传统意义上应用程序所处的位置,这种转换必然会增加系统的复杂性。软件堆栈的复杂性增加意味着,这些环境难于管理,因而会加大确保系统可靠性和安全性的困难。

硬件虚拟化

硬件虚拟化,简而言之,就是物理平台本身提供了对特殊指令的截获和重定向的硬件支持。甚至,新的硬件会提供额外的资源来帮助软件实现对关键硬件资源的虚拟化,从而提升性能。

以X86平台的虚拟化为例,支持虚拟技术的X86 CPU带有特别优化过的指令集来控制虚拟过程,通过这些指令集,VMM会很容易将客户机置于一种受限制的模式下运行,一旦客户机试图访问物理资源,硬件会暂停客户机的运行,将控制权交回给VMM处理。VMM还可以利用硬件的虚拟化增强机制,将客户机在受限模式下对一些特定资源的访问,完全由硬件重定向到VMM指定的虚拟资源,整个过程不需要暂停客户机的运行和VMM软件的参与。

由于虚拟化硬件可提供全新的架构,支持操作系统直接在上面运行,无需进行二进制转换,减少了相关的性能开销,极大简化了VMM设计,进而使VMM能够按通用标准进行编写,性能更加强大。

需要说明的是,硬件虚拟化技术是一套解决方案。完整的情况需要CPU、主板芯片组、BIOS和软件的支持,例如VMM软件或者某些操作系统本身。即使只是CPU支持虚拟化技术,在配合VMM软件的情况下,也会比完全不支持虚拟化技术的系统有更好的性能。

鉴于虚拟化的巨大需求和硬件虚拟化产品的广阔前景,Intel一直都在努力完善和加强自己的硬件虚拟化产品线。自2005年末,Intel便开始在其处理器产品线中推广应用Intel Virtualization Technology(IntelVT)虚拟化技术,发布了具有IntelVT虚拟化技术的一系列处理器产品,包括桌面的Pentium和Core系列,还有服务器的Xeon至强和Itanium安腾。Intel一直保持在每一代新的处理器架构中优化硬件虚拟化的性能和增加新的虚拟化技术。现在市面上,从桌面的Core i3/5/7,到服务器端的E3/5/7/9,几乎全部都支持Intel VT技术。可以说,在不远的将来,Intel VT很可能会成为所有Intel处理器的标准配置。

2、虚拟化和全虚拟化

最理想的虚拟化的两个目标如下:

- 客户机完全不知道自己运行在虚拟化环境中, 还以为自己运行在原生环境里。

- 完全不需要VMM介入客户机的运行过程。

纯软件的虚拟化可以做到第一个目标, 但性能不是很好, 而且软件设计的复杂度大大增加。

半虚拟化

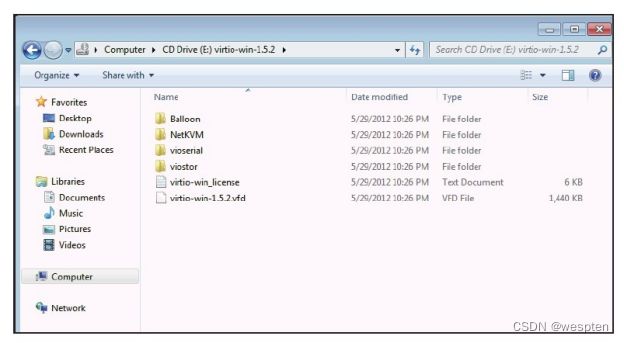

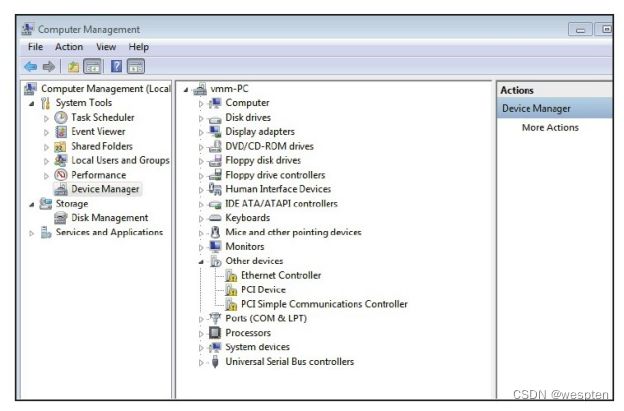

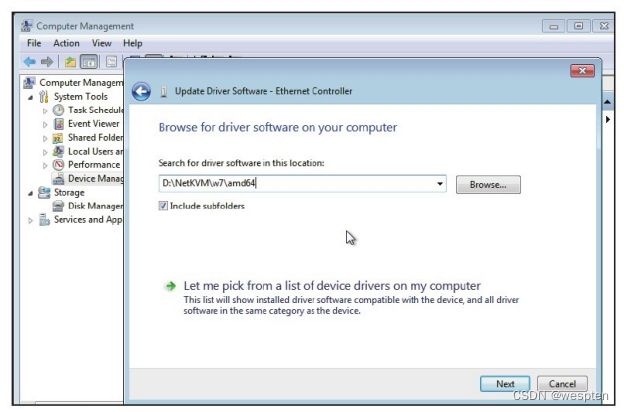

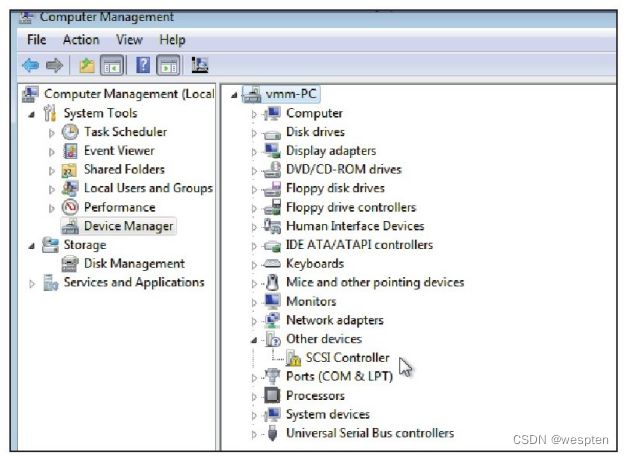

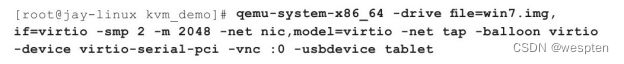

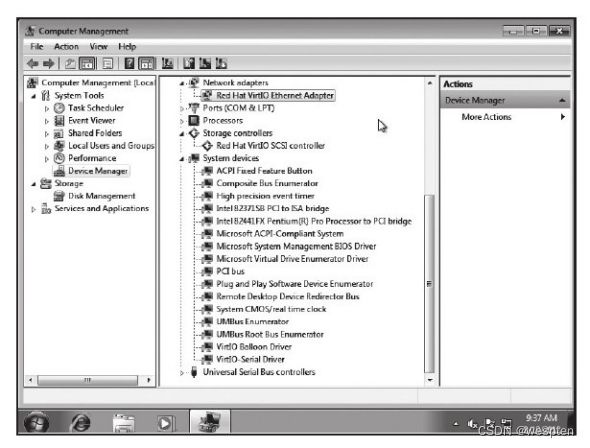

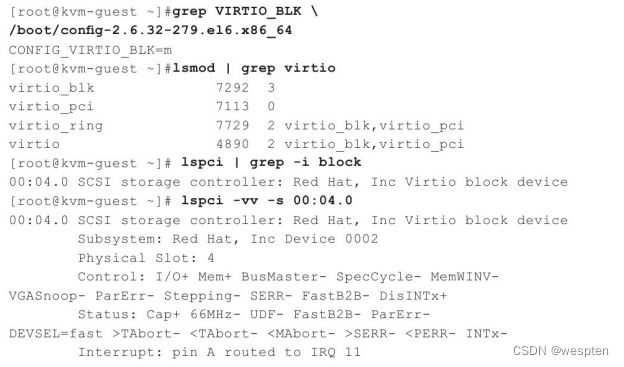

那么如果放弃第一个目标呢?让客户机意识到自己是运行在虚拟化环境里, 并做相应修改以配合VMM, 这就是半虚拟化(Para-Virtualization)。一方面, 可以提升性能和简化VMM软件复杂度;另一方面, 也不需要太依赖硬件虚拟化的支持, 从而使得其软件设计(至少是VMM这一侧)可以跨平台且是优雅的。“本质上, 准虚拟化弱化了对虚拟机特殊指令的被动截获要求, 将其转化成客户机操作系统的主动通知。但是, 准虚拟化需要修改客户机操作系统的源代码来实现主动通知。”典型的半虚拟化技术就是virtio, 使用virtio需要在宿主机/VMM和客户机里都相应地装上驱动。

全虚拟化

与半虚拟化相反的, 全虚拟化(Full Virtualization)坚持第一个理想化目标:客户机的操作系统完全不需要改动。敏感指令在操作系统和硬件之间被VMM捕捉处理, 客户操作系统无须修改, 所有软件都能在虚拟机中运行。因此, 全虚拟化需要模拟出完整的、和物理平台一模一样的平台给客户机, 这在达到了第一个目标的同时也增加了虚拟化层(VMM)的复杂度。

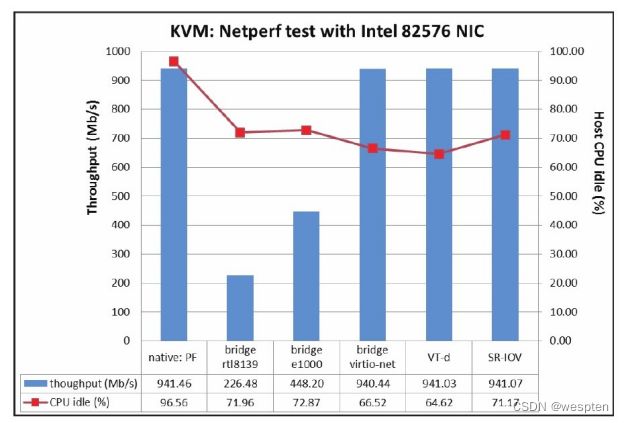

性能上, 2005年硬件虚拟化兴起之前, 软件实现的全虚拟化完败于VMM和客户机操作系统协同运作的半虚拟化, 这种情况一直延续到2006年。之后以Intel VT-x、VT-d为代表的硬件虚拟化技术的兴起, 让由硬件虚拟化辅助的全虚拟化全面超过了半虚拟化。但是, 以virtio为代表的半虚拟化技术也一直在演进发展, 性能上只是略逊于全虚拟化, 加之其较少的平台依赖性, 依然受到广泛的欢迎。

三、虚拟化解决方案

在虚拟化领域也有很多的技术和产品种类,包括传统的老牌虚拟化软件VMware、Microsoft的Hyper-V、Citrix的XenServer/XenClient、Oracle的VirtualBox等,还有在Linux平台上比较流行的开源虚拟化技术KVM、Xen等,甚至包括Linux上的轻量级虚拟化技术LXC。

1、KVM虚拟化

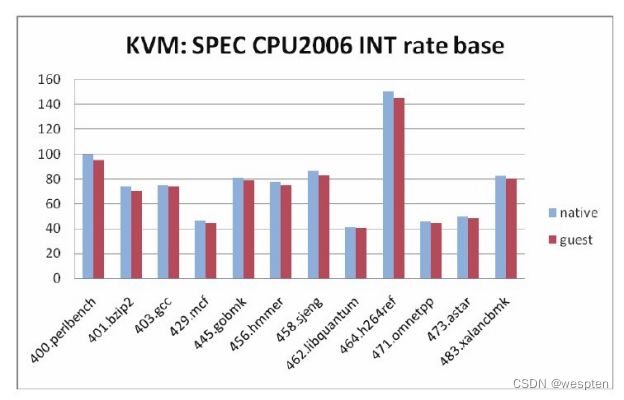

。随着Linux服务器广泛地应用在互联网等热门行业,KVM作为Linux内核原生的虚拟化技术受到了开发者和用户广泛的关注,并且已经得到了较大规模的应用,如Google的公有云计算引擎GCE就是在底层完全使用KVM作为虚拟化技术来实现的。

KVM虚拟机最初是由以色列一家创业公司Qumranet员工Avi Kivity等人开发,于2006年8月完全开源并推向Linux内核社区,当年10月被Linux社区接受。2007年2月发布的Linux 2.6.20 是第一个带有KVM模块的Linux内核正式发布版本。Red Hat公司于2008年9月正式将Qumranet公司收购,接着投入了较多的资源到KVM虚拟化的开发中。在2010年11月,Red Hat公司发布的RHEL 6中完全用KVM替换了RHEL 5中默认支持的Xen,让KVM成为RHEL操作系统默认的虚拟化方案。

KVM必须依赖CPU提供的硬件虚拟化技术,以Intel、AMD为代表的x86硬件平台在最近几年也推出了很多与虚拟化相关的硬件特性,包括最初基本的CPU的VT支持和EPT、VPID,以及I/O设备的VT-d、SR-IOV,还包括最新的APIC-v、Shadow VMCS等特性。随着x86硬件对虚拟化技术的支持越来越成熟,KVM在最新的硬件平台上的虚拟化效率也得到很大的提高。

除了硬件方面的虚拟化技术逐渐成熟之外,KVM作为Linux内核虚拟机,受到许许多多Linux软件开发者的青睐。Red Hat公司无疑是KVM开发中最大的一股力量,很多Red Hat工程师在KVM、QEMU、libvirt等开源社区中成为核心开发成员。除了Red Hat之外,还有许多知名公司都有不少软件开发者为KVM贡献自己的代码,如IBM、 Intel、 Novell、AMD、Siemens、华为等。除了这些大公司的开发者之外,还有许多小公司和个人独立开发者活跃在KVM开源社区,为KVM开发代码或者做测试工作。

在硬件方面的虚拟化支持和软件方面的功能开发、性能优化的共同作用下,目前KVM虚拟化技术已经拥有非常丰富的功能和非常优秀的性能。而且,随着libvirt、virt-manager等工具和OpenStack等云计算平台的逐渐完善,KVM管理工具在易用性方面的劣势已经逐渐被克服。另外,KVM仍然可以改进虚拟网络的支持、虚拟存储支持、增强的安全性、高可用性、容错性、电源管理、HPC/实时支持、虚拟CPU可伸缩性、跨供应商兼容性、科技可移植性等方面,不过,现在KVM开发者社区比较活跃,也有不少大公司的工程师参与开发,我们有理由相信很多功能都会在不远的将来得到完善。

2、Xen虚拟化

Xen的历史

早在20世纪90年代,伦敦剑桥大学的Ian Pratt和Keir Fraser在一个叫做Xenoserver的研究项目中,开发了Xen虚拟机。作为Xenoserver的核心,Xen虚拟机负责管理和分配系统资源,并提供必要的统计功能。在那个年代,X86的处理器还不具备对虚拟化技术的硬件支持,所以Xen从一开始是作为一个准虚拟化的解决方案出现的。因此,为了支持多个虚拟机,内核必须针对Xen做出特殊的修改才可以运行。为了吸引更多开发人员参与,2002年Xen正式被开源。在先后推出了1.0和2.0版本之后,Xen开始被诸如Redhat、Novell和Sun的Linux发行版集成,作为其中的虚拟化解决方案。2004年,Intel的工程师开始为Xen添加硬件虚拟化的支持,从而为即将上市的新款处理器做必需的软件准备。在他们的努力下,2005年发布的Xen 3.0,开始正式支持Intel的VT技术和IA64架构,从而Xen虚拟机可以运行完全没有修改的操作系统。2007年10月,思杰公司出资5亿美金收购了XenSource,变成了Xen虚拟机项目的东家。

与Xen在功能开发上的快速进展形成对比的是,Xen在将它对内核的修改集成进入内核社区方面进展不大。有部分重要的内核开发人员不喜欢Xen的架构和实现,多位内核维护人员公开声明不欢迎Xen。这样的形势一直持续到2010年,在基于内核的PVOPS对Xen做了大量重写之后,内核社区才勉强接纳了Xen。当然,目前从Linux 3.0版本开始的内核主干对Xen的支持还是越来越好了。

Xen功能概览

Xen是一个直接在系统硬件上运行的虚拟机管理程序。Xen在系统硬件与虚拟机之间插入一个虚拟化层,将系统硬件转换为一个逻辑计算资源池,Xen可将其中的资源动态地分配给任何操作系统或应用程序。在虚拟机中运行的操作系统能够与虚拟资源交互,就好像它们是物理资源一样。

Xen架构:

Xen被设计成为微内核的实现,其本身只是负责管理处理器和内存资源。Xen上面运行的所有虚拟机中,0号虚拟机是特殊的,其中运行的是经过修改的支持准虚拟化的Linux操作系统,大部分的输入输出设备都交由这个虚拟机直接控制,而Xen本身并不直接控制它们。这样做可以使基于Xen的系统可以最大程度地复用Linux内核的驱动程序。更广泛地说,Xen虚拟化方案在Xen Hypervisor和0号虚拟机的功能上做了聪明的划分,既能够重用大部分Linux内核的成熟代码,又可以控制系统之间的隔离型和针对虚拟机更加有效的管理和调度。通常,0号虚拟机也被视为是Xen虚拟化方案的一部分。

Xen上面运行的虚拟机,既支持准虚拟化,也支持全虚拟化,可以运行几乎所有可以在X86物理平台上运行的操作系统。此外,最新的Xen还支持ARM平台的虚拟化。

下面简单介绍一下Xen的功能特性:

1. Xen服务器(即思杰公司的Xen Server产品)构建于开源的Xen虚拟机管理程序之上,结合使用半虚拟化和硬件协助的虚拟化。操作系统与虚拟化平台之间的这种协作支持开发一个较简单的虚拟机管理程序来提供高度优化的性能。

2. Xen提供了复杂的工作负载平衡功能,可捕获CPU、内存、磁盘I/O和网络I/O数据,它提供了两种优化模式:一种针对性能,另一种针对密度。

3. Xen服务器利用一种名为Citrix Storage Link的独特的存储集成功能。使用Citrix Storage Link,系统管理员可直接利用来自HP、Dell Equal Logic、NetApp、EMC等公司的存储产品。

4. Xen服务器包含多核处理器支持、实时迁移、物理服务器到虚拟机转换(P2V)和虚拟到虚拟转换(V2V)工具、集中化的多服务器管理、实时性能监控,以及对Windows和Linux客户机的良好性能。

Xen的前景

Xen作为一个开发最早的虚拟化方案,对各种虚拟化功能的支持相对完善。Xen虚拟机监控程序,是一个专门为虚拟机开发的微内核,所以其资源管理和调度策略完全是针对虚拟机的特性而开发的。作为一个独立维护的微内核,Xen的功能明确,开发社区构成比较简单,所以更容易接纳专门针对虚拟化所做的功能和优化。

Xen比较难于配置和使用,部署会占用相对较大的空间,而且非常依赖于0号虚拟机中的Linux操作系统。Xen微内核直接运行于真实物理硬件之上,开发和调试都比基于操作系统的虚拟化困难。Xen最大的困难在于Linux内核社区的抵制,导致Xen相关的内核改动一直不能顺利进入内核源代码,从而无法及时得到内核最新开发成果的支持,这与KVM形成了鲜明的对比。

3、其他虚拟化

把虚拟机作为商品出售给终端用户,就需要一些商业化的虚拟机解决方案。下面简单介绍常见的一些商业化的虚拟机。

VMware

VMware公司创办于1998年,从公司的名字就可以看出,这是一家专注于提供虚拟化解决方案的公司。VMware公司很早就预见到了虚拟化在未来数据中心中的核心地位,有针对性地开发虚拟化软件,从而抓住了21世纪初虚拟化兴起的大潮,成为了虚拟化业界的标杆。VMware公司从创建至今,一直占据着虚拟化软件市场的最大份额,是毫无争议的龙头老大。Vmware公司作为最成熟的商业虚拟化软件提供商,其产品线是业界覆盖范围最广的,下面会对VMware的主要产品进行简单的介绍。

(1)VMware Workstation

VMware Workstation是VMware公司销售的运行于台式机和工作站上的虚拟化软件,也是VMware公司第一个面市的产品(1999年5月)。该产品最早采用了VMware在业界知名的二进制翻译技术,在x86 CPU硬件虚拟化技术还未出现之前,为客户提供了纯粹的基于软件的全虚拟化解决方案。作为最初的拳头产品,VMware公司投入了大量的资源对二进制翻译进行优化,其二进制翻译技术带来的虚拟化性能甚至超过第一代的CPU硬件虚拟化产品。该产品如同KVM,是“类型二”虚拟机[6],需要在宿主操作系统之上运行。

(2)VMware ESX Server

ESX服务器(一种能直接在硬件上运行的企业级的虚拟平台),虚拟的SMP,它能让一个虚拟机同时使用四个物理处理器,和VMFS一样,它能使多个ESX服务器分享块存储器。该公司还提供一个虚拟中心来控制和管理虚拟化的IT环境:VMotion让用户可以移动虚拟机器;DRS从物理处理器创造资源工具;HA提供从硬件故障自动恢复功能;综合备份可使LAN-free自动备份虚拟机器;VMotion存储器可允许虚拟机磁盘自由移动;更新管理器自动更新修补程序和更新管理;能力规划能使VMware的服务供应商执行能力评估;转换器把本地和远程物理机器转换到虚拟机器;实验室管理可自动化安装、捕捉、存储和共享多机软件配置;ACE允许桌面系统管理员对虚拟机应用统一的企业级IT安全策略,以防止不可控台式电脑带来的风险。虚拟桌面基础设施可主导个人台式电脑在虚拟机运行的中央管理器;虚拟桌面管理,它是联系用户到数据库中的虚拟电脑的桌面管理服务器;WMware生命管理周期可通过虚拟环境提供控制权。

VirtualBox

Oracle VirtualBox是由德国InnoTek软件公司出品的虚拟机器软件,现在由甲骨文公司进行开发,是甲骨文公司xVM虚拟化平台技术的一部份。它提供使用者在32位或64位的Windows、Solaris及Linux操作系统上虚拟其他X86的操作系统。使用者可以在VirtualBox上安装并执行Solaris、Windows、DOS、Linux、OS/2 Warp、OpenBSD及FreeBSD等系统作为客户端操作系统。最新的VirtualBox还支持运行Android4.0系统。

与同性质的VMware及Virtual PC比较下,VirtualBox独到之处包括远端桌面协定(RDP)、iSCSI及USB的支援,VirtualBox在客户机操作系统上已可以支援USB 2.0的硬件装置。此外,VirtualBox还支持在32位宿主操作系统上运行64位的客户机操作系统。

VirtualBox既支持纯软件虚拟化,也支持Intel VT-x与AMD AMD-V硬件虚拟化技术。为了方便其他虚拟机用户向VirtualBox的迁移,VirtualBox可以读写VMware VMDK格式与VirtualPC VHD格式的虚拟磁盘文件。

Hyper-V

Hyper-V是微软提出的一种系统管理程序虚拟化技术。Hyper-V设计的目的是为广泛的用户提供更为熟悉及成本效益更高的虚拟化基础设施软件,这样可以降低运作成本、提高硬件利用率、优化基础设施并提高服务器的可用性。

Hyper-V的设计借鉴了Xen,采用微内核的架构,兼顾了安全性和性能的要求。Hyper-V底层的Hypervisor运行在最高的特权级别下,微软将其称为ring-1(而Intel也将其称为root mode),而虚拟机的操作系统内核和驱动运行在ring 0,应用程序运行在ring 3。

Hyper-V采用基于VMbus的高速内存总线架构,来自虚拟机的硬件请求(显卡、鼠标、磁盘、网络),可以直接经过VSC,通过VMbus总线发送到根分区的VSP,VSP调用对应的设备驱动,直接访问硬件,中间不需要Hypervisor的帮助。

从架构上讲,Hyper-V只有“硬件-Hyper-V-虚拟机”三层,本身非常小巧,代码简单,且不包含任何第三方驱动,所以安全可靠、执行效率高,能充分利用硬件资源,使虚拟机系统性能更接近真实系统性能。

Intel虚拟化技术

Intel虚拟化技术其实是一系列硬件技术的集合,虚拟机监控机软件通过选择利用各项技术,从而提高虚拟化软件的性能或者实现各种不同的功能。

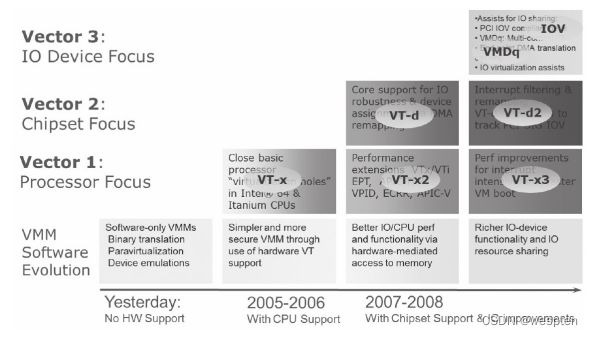

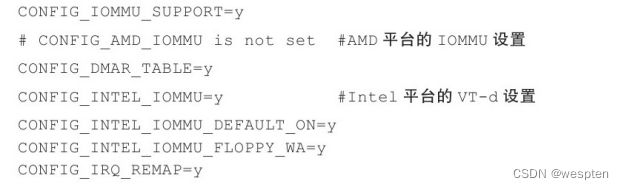

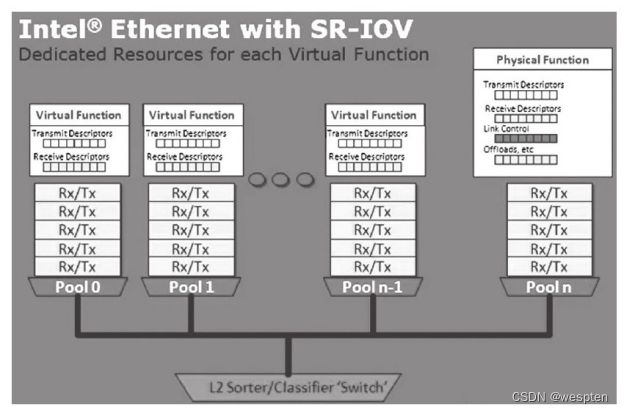

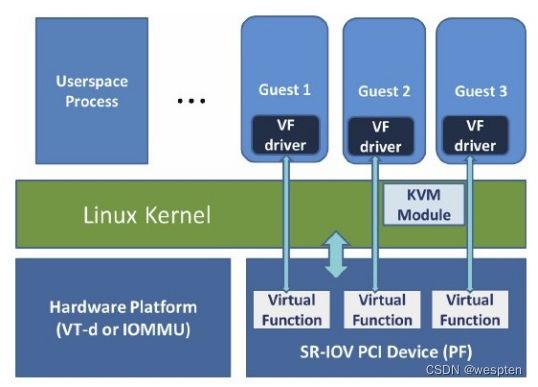

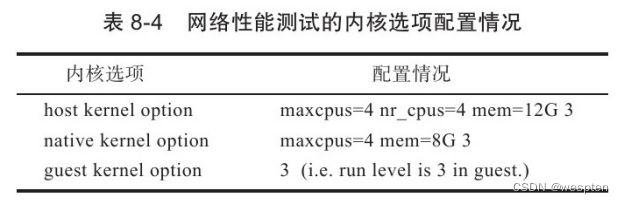

如图2-3所示,Intel虚拟化技术其实可以大致分为三类:第一类是处理器相关的,称为VT-x,是实现处理器虚拟化的硬件扩展,这也是硬件虚拟化的基础;第二类是芯片组相关的,成为VT-d,是从芯片组的层面为虚拟化提供必要支持,通过它,可以实现诸如直接分配物理设备给客户机的功能;第三类是输入输出设备相关的,主要目的是通过定义新的输入输出协议,使新一代的输入输出设备可以更好地支持虚拟化环境下的工作,比如Intel网卡自有的VMDq技术和PCI组织定义的单根设备虚拟化协议(SR-IOV)。

Intel虚拟化技术进化蓝图:

从图中可以看出,硬件虚拟化技术发展到今天,已经从最初的处理器虚拟化扩展变成了各种先进技术的集合。而且,Intel公司还在继续为这个集合添加新的成员。同时Intel公司的软件开发工程师也一直活跃在开源虚拟机社区,为KVM即时添加最新的硬件支持。可以自己去下载KVM和QEMU的源代码,从而进行更深入的理解和应用。

四、KVM管理工具

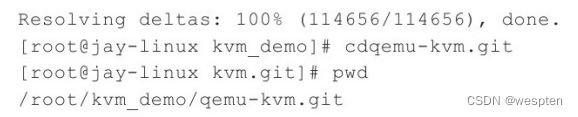

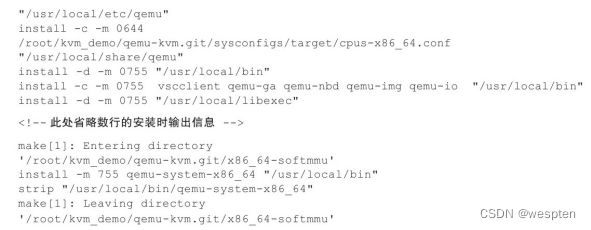

1、QEMU

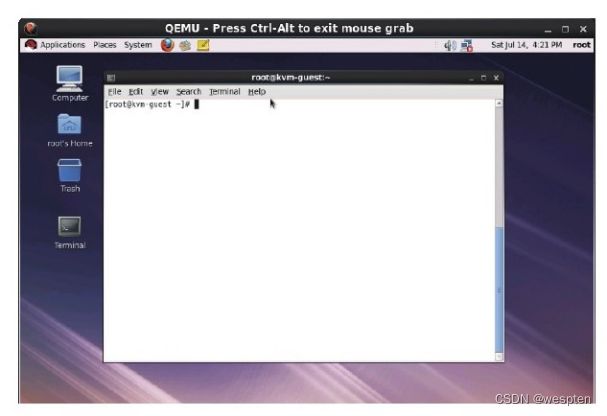

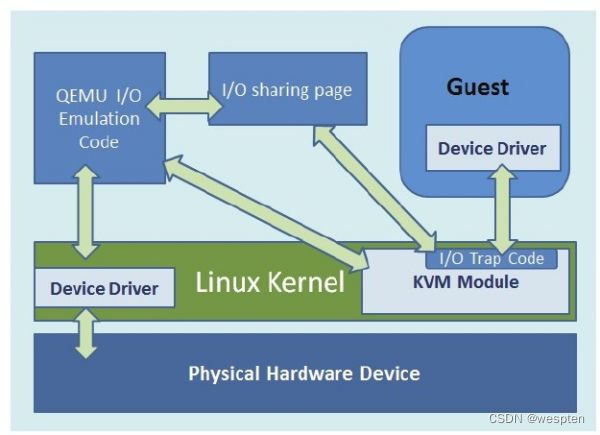

QEMU本身并不是KVM的一部分,其自身就是一个著名的开源虚拟机软件。与KVM不同,QEMU虚拟机是一个纯软件的实现,所以性能低下。但是,其优点是在支持QEMU本身编译运行的平台上就可以实现虚拟机的功能,甚至虚拟机可以与宿主机并不是同一个架构。作为一个存在已久的虚拟机,QEMU的代码中有整套的虚拟机实现,包括处理器虚拟化、内存虚拟化,以及KVM使用到的虚拟设备模拟(比如网卡、显卡、存储控制器和硬盘等)。

为了简化开发和代码重用,KVM在QEMU的基础上进行了修改。虚拟机运行期间,QEMU会通过KVM模块提供的系统调用进入内核,由KVM模块负责将虚拟机置于处理器的特殊模式运行。遇到虚拟机进行输入输出操作,KVM模块会从上次的系统调用出口处返回QEMU,由QEMU来负责解析和模拟这些设备。

从QEMU角度来看,也可以说QEMU使用了KVM模块的虚拟化功能,为自己的虚拟机提供硬件虚拟化的加速,从而极大地提高了虚拟机的性能。除此之外,虚拟机的配置和创建,虚拟机运行依赖的虚拟设备,虚拟机运行时的用户操作环境和交互,以及一些针对虚拟机的特殊技术(诸如动态迁移),都是由QEMU自己实现的。

从QEMU和KVM模块之间的关系可以看出,这是典型的开源社区在代码共用和开发项目共用上面的合作。诚然,QEMU可以选择其他的虚拟机或技术来加速,比如Xen或者KQEMU;KVM也可以选择其他的用户空间程序作为虚拟机实现,只要它按照KVM提供的API来设计。但是在现实中,QEMU与KVM两者的结合是最成熟的选择,这对一个新开发和后起的项目(KVM)来说,无疑多了一份未来成功的保障。

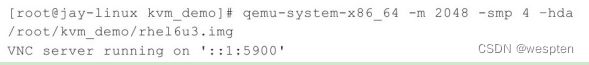

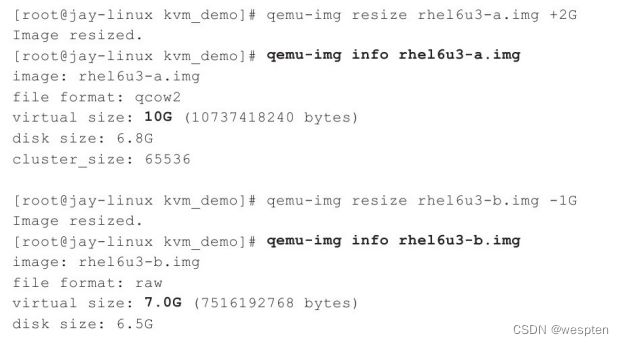

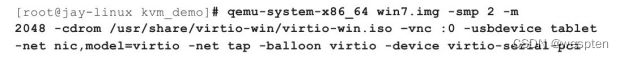

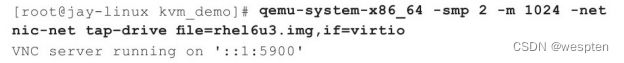

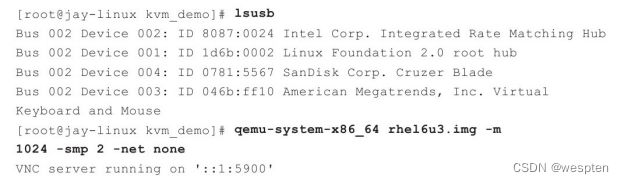

1)qemu-kvm 命令行参数

用户使用QEMU/KVM之时,一般有两个途径与客户机进行交互和配置,其中一个途径是通过QEMU monitor,另一个就是通过qemu-kvm命令行。用户通过qemu-kvm命令行启动个客户机,并通过qemu-kvm命令行的各种参数来配置客户机。在介绍KVM的某个功能时一般都会提及qemu-kvm命令行启动时使用什么参数来达到效果。将会简单总结一下之前用过的qemu-kvm命令行参数,然后介绍另外一些未曾介绍的重要参数的用法和功能。

1. qemu-kvm命令基本格式

一般来说x86_64平台上的qemu-kvm工具的命令行格式如下:

其中,options是各种选项、参数,disk_image是客户机的磁盘镜像文件(默认被挂载为第一个IDE磁盘设备)。而关于disk_image的写法也是多种多样的,如可以通过"-hda"参数使用IDE磁盘,也可以用"-driver"参数来提供磁盘镜像,在少数情况下也可以没有磁盘镜像参数。

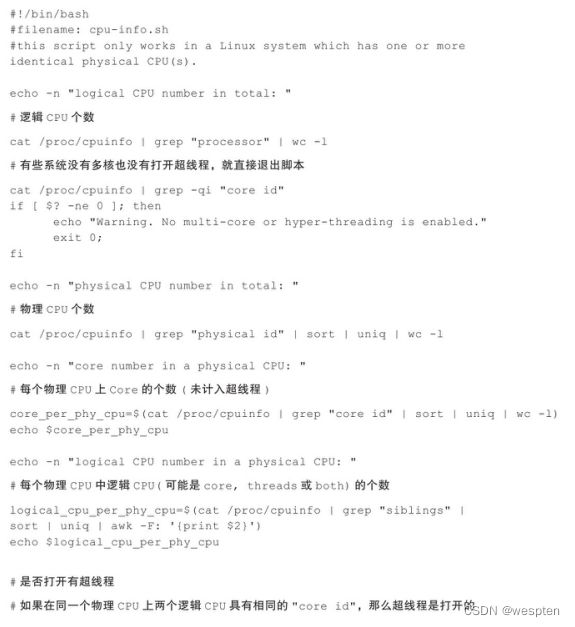

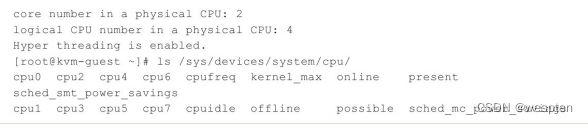

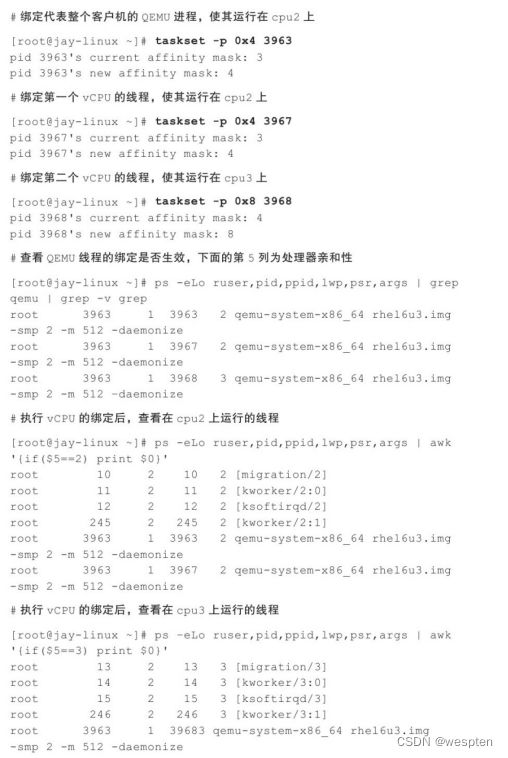

2. CPU相关的参数

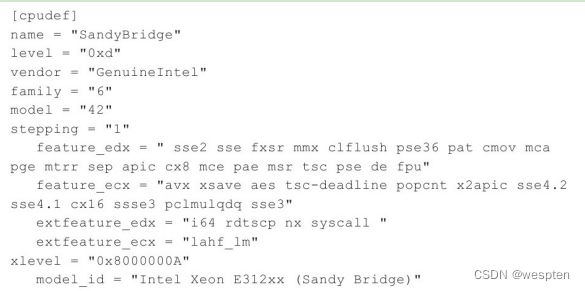

(1)-cpu参数

指定CPU模型,如"-cpu SandyBridge"参数指定给客户机模拟Intel的代号为SandyBridge的CPU。默认的CPU模型为qemu64,"-cpu?"可以查询当前qemu-kvm支持哪些CPU模型。

可以用一个CPU模型作为基础,然后用“+”号将部分的CPU特性添加到基础模型中去,如"-cpu qemu64,+avx"将在qemu64模型中添加对AVX支持的特性,"-cpu qemu64,+vmx"将在qemu64模型中添加Intel VMX特性。

如果想尽可能多地将宿主机的CPU特性暴露给客户机使用,则可以使用"-cpu host"参数。当然,使用"-cpu host"参数会带来动态迁移的限制,不让客户机在不同的CPU硬件上迁移。

(2)-smp参数

设置客户机总共有n个逻辑CPU,并设置了其中CPU socket的数量、每个Socket上核心(core)的数量、每个核心上的线程(thread)数量。其中:n=sockets×cores×threads。

3. 内存相关的参数

(1)-m megs参数

设置客户机内存大小为megs MB。默认单位为MB,如"-m 1024"就表示1024MB内存,也可以使用G来表示GB为单位的内存大小,如"-m 4G"表示4GB内存大小。

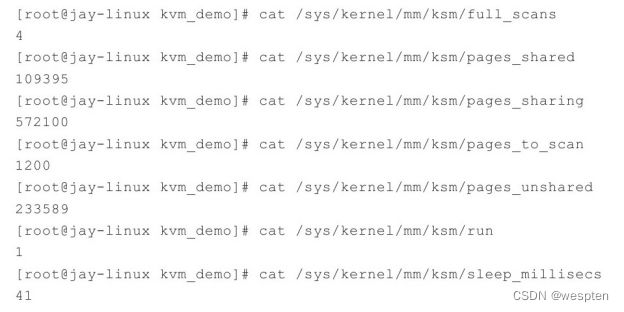

(2)-mem-path path参数

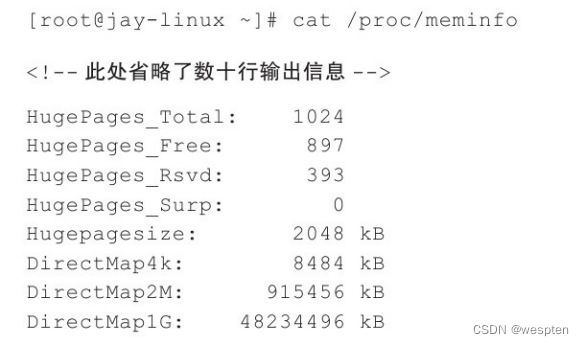

从path路径表示的临时文件中为客户机分配内存,主要是分配大页内存(如2 MB大页),如"-mem-path/dev/hugepages",“内存配置”。

(3)-mem-prealloc参数

启动时即分配全部的内存,而不是根据客户机请求而动态分配,必须与"-mem-path"参数一起使用。

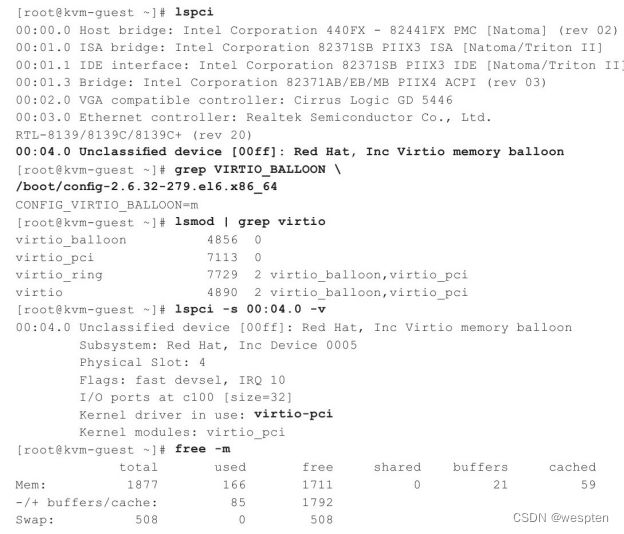

(4)-balloon开启内存气球的设置

"-balloon virtio"为客户机提供virtio_balloon设备,从而通过内存气球balloon,可以在QEMU monitor中用"balloon"命令来调节客户机占用内存的大小(在qemu-kvm命令行启动时的"-m"参数设置的内存范围内)。

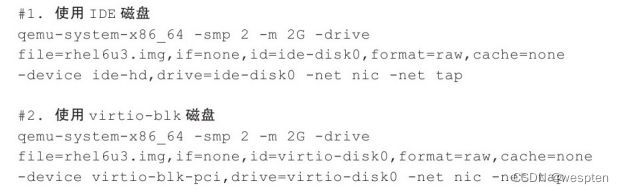

4. 磁盘相关的参数

(1)-hda、-hdb和-cdrom等参数

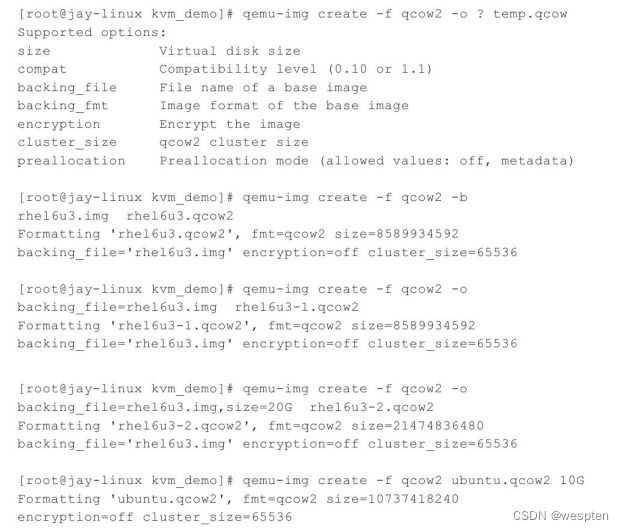

设置客户机的IDE磁盘和光盘设备。如"-hda rhel6u3.img"将rhel6u3.img镜像文件作为客户机的第一个IDE磁盘。

(2)-drive参数

详细地配置一个驱动器,如:在介绍半虚拟化驱动时,用到过"-drive file=rhel6u3.img,if=virtio"的参数配置使用virtio-block驱动来支持该磁盘文件。

(3)-boot参数

设置客户机启动时的各种选项(包括启动顺序等),如:在介绍客户机系统的安装时,使用到"-boot order=dc-hda rhel6u3.img-cdrom rhel6u3.iso"参数,让rhel6u3.img(未安装系统)文件作为IDE磁盘,安装光盘rhel6u3.iso作为IDE光驱,并且从光盘启动客户机,从而让客户机进入到系统安装的流程中。

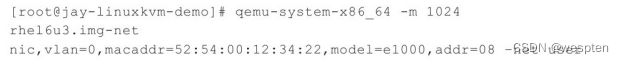

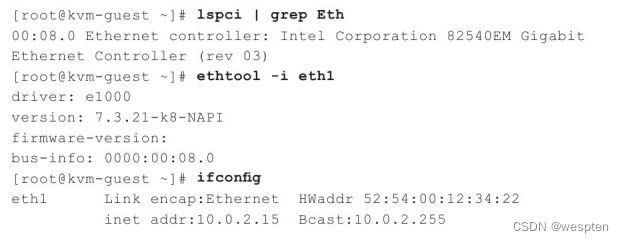

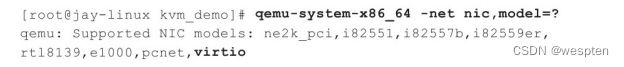

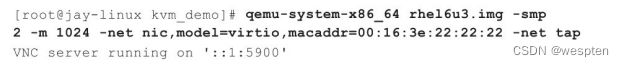

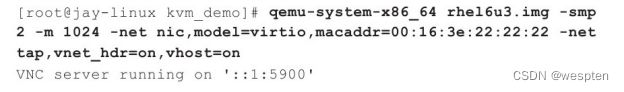

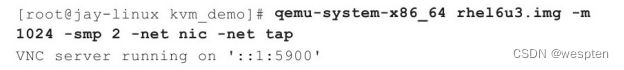

5. 网络相关的参数

(1)-net nic参数

为客户机创建一个网卡(NIC),凡是使用qemu-kvm模拟的网卡作为客户机网络设备的情况都应该使用该参数。当然,如果用VT-d方式将宿主机网卡直接分配给客户机使用,是不需要"-net nic"参数的。

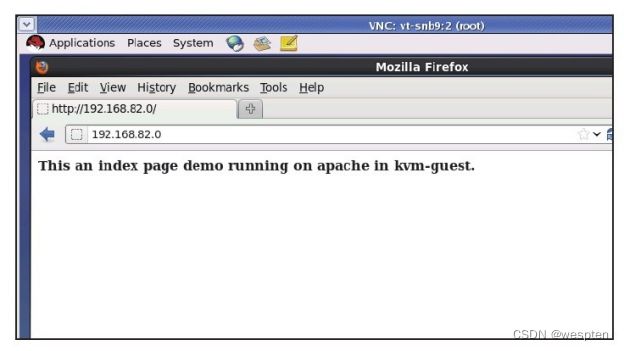

(2)-net user参数

让客户机使用不需要管理员权限的用户模式网络(user mode network),如"-net nic-net user"。

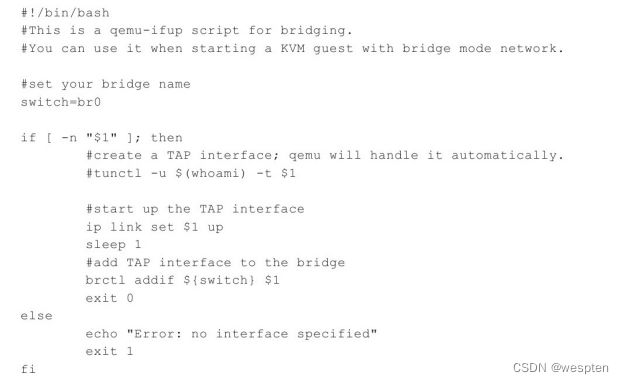

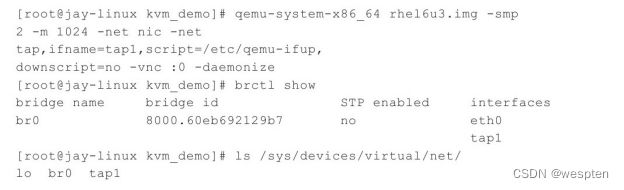

(3)-net tap参数

使用宿主机的TAP网络接口来帮助客户机建立网络。使用网桥连接和NAT模式网络的客户机都会使用到"-net tap"参数。如"-net nic-net tap,ifname=tap1,script=/etc/qemu-ifup,downscript=no"参数就是使用网桥模式网络的命令行参数。

(4)-net dump参数

转存(dump)出网络中的数据流量,之后可以用tcpdump或Wireshark工具来分析。

(5)-net none参数

当不需要配置任何网络设备时,需要使用"-net none"参数,因为如果不添加"-net"参数,则会被默认设置为"-net nic-net user"参数。

6. 图形显示相关的参数

(1)-sdl参数

使用SDL方式显示客户机。如果在qemu-kvm编译时已经将SDL的支持编译进去了,则qemu-kvm命令行在默认情况下(不加"-sdl")也会使用SDL方式来显示客户机。

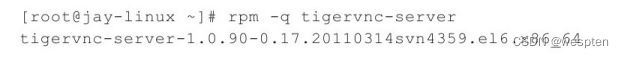

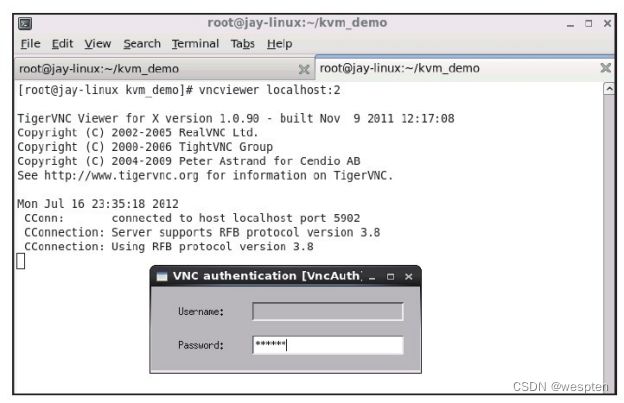

(2)-vnc参数

使用VNC方式显示客户机。只有在进行qemu-kvm编译时没有添加SDL支持,但是编译了VNC相关的支持,才会默认开启VNC方式。在有SDL支持的qemu-kvm工具中,需要使用"-vnc"参数来让客户机显示在VNC中,如"-vnc localhost:2"就将客户机的显示放到本机的2号VNC窗口中,然后在宿主机上可以通过"vncviewer localhost:2"来连接到客户机。

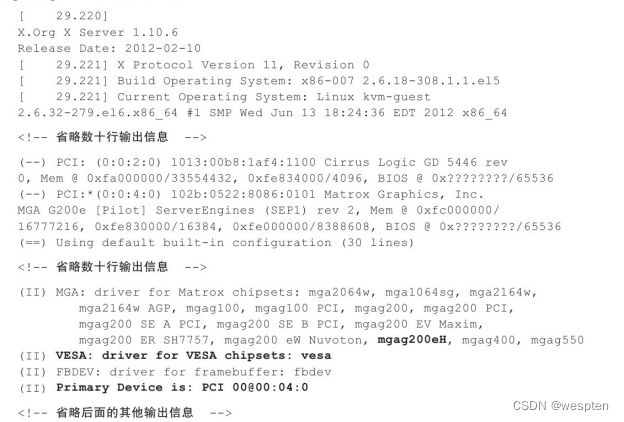

(3)-vga参数

设置客户机中的VGA显卡类型,默认值为"-vga cirrus",默认会为客户机模拟出"Cirrus Logic GD5446"显卡。可以使用"-vga std"参数来模拟带有Bochs VBE扩展的标准VGA显卡,而"-vga none"参数是不为客户机分配VGA卡,会让VNC或SDL中都没有任何显示。

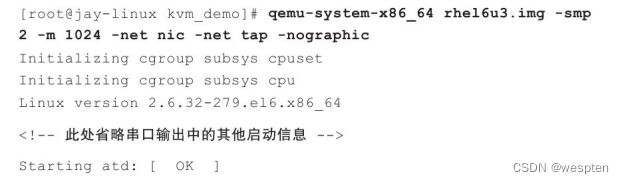

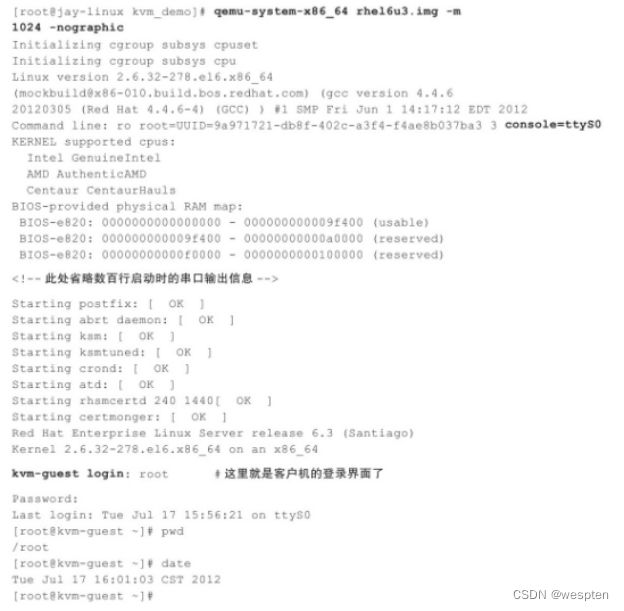

(4)-nographic参数

完全关闭QEMU的图形界面输出,从而让QEMU在该模式下完全成为简单的命令行工具。而QEMU中模拟产生的串口被重定向到了当前的控制台(console)中,所以如果在客户机中对其内核进行配置从而让内核的控制台输出重定向到串口后,就依然可以在非图形模式下管理客户机系统。

在"-nograhpic"非图形模式下,使用"Ctrl+a h"组合键(按Ctrl+a之后,再按h键)可以获得终端命令的帮助,如下所示:

帮助手册中打印出了多个快捷键,上面演示了"Ctrl+a t"来控制是否显示控制台的时间戳,以及"Ctrl+a c"在控制台(串口也重定向到控制台)与QEMU monitor之间的切换。

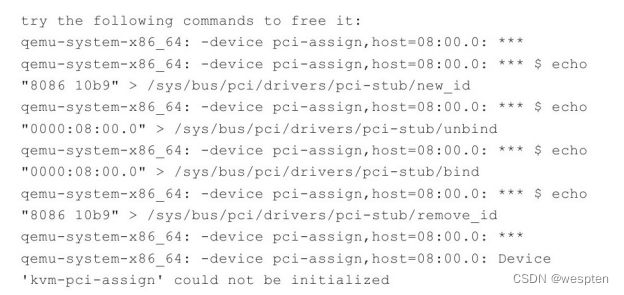

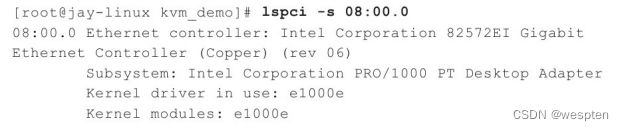

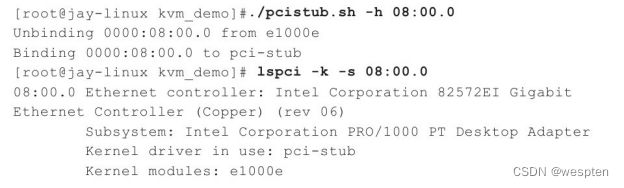

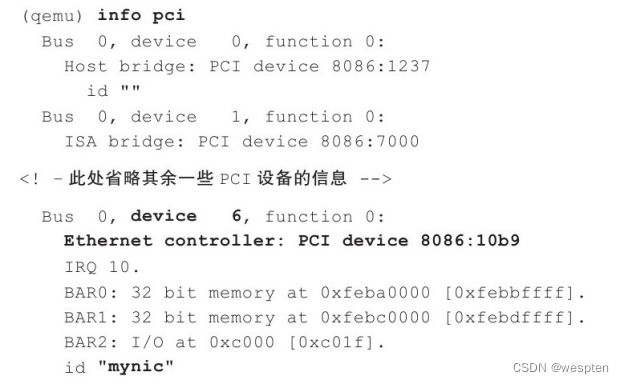

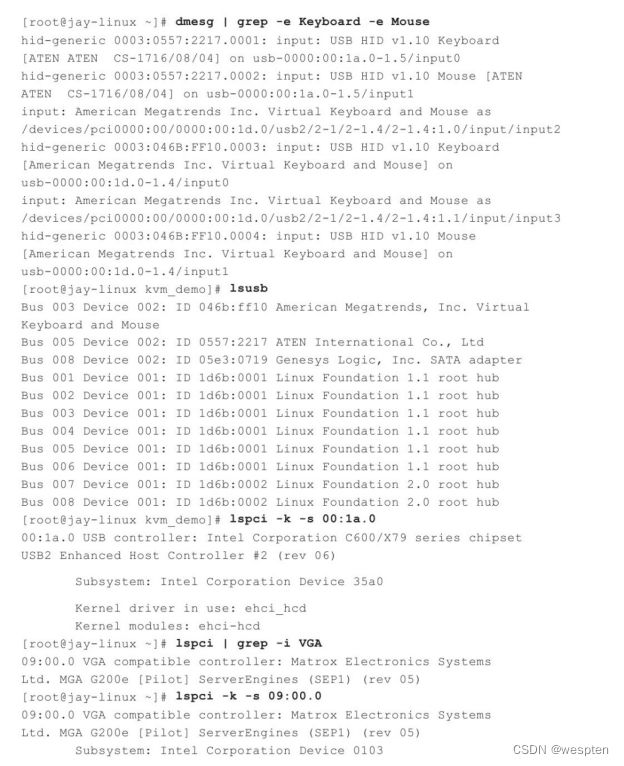

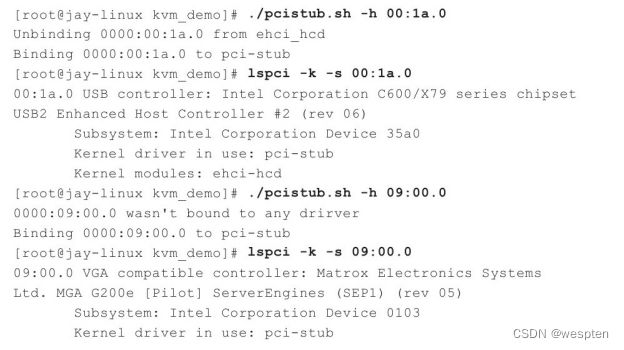

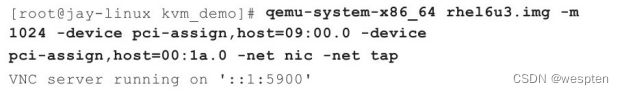

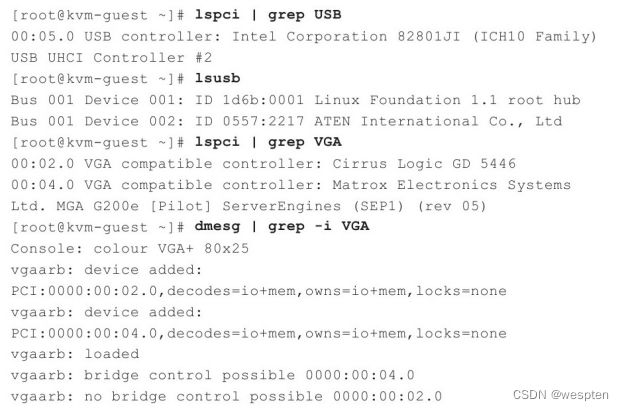

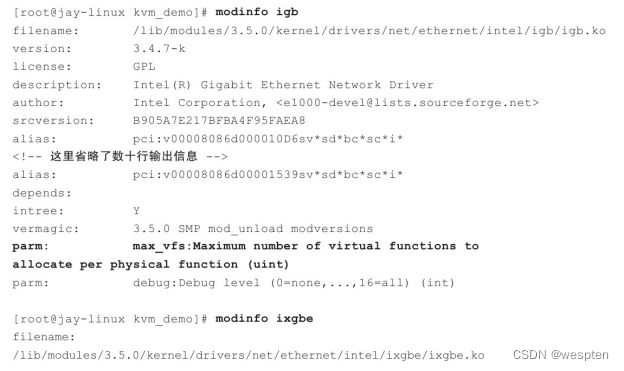

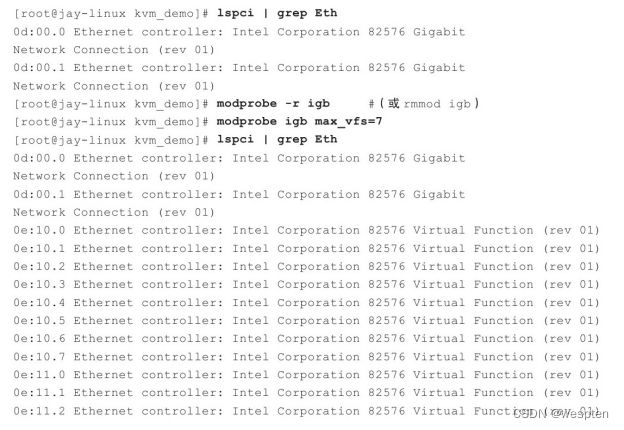

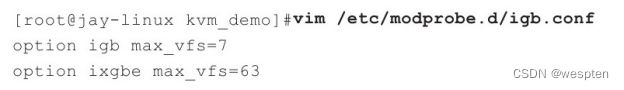

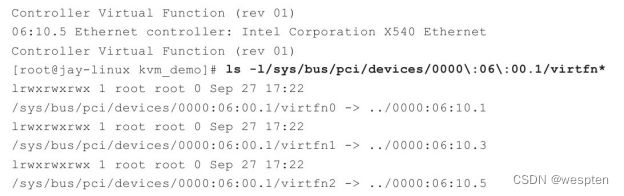

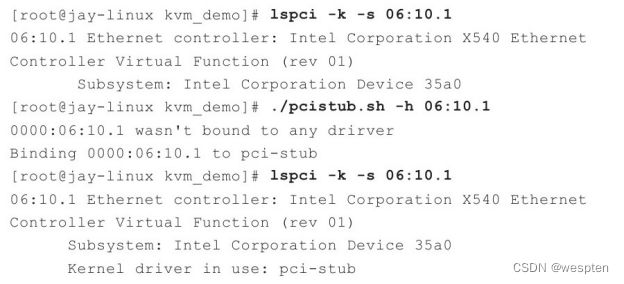

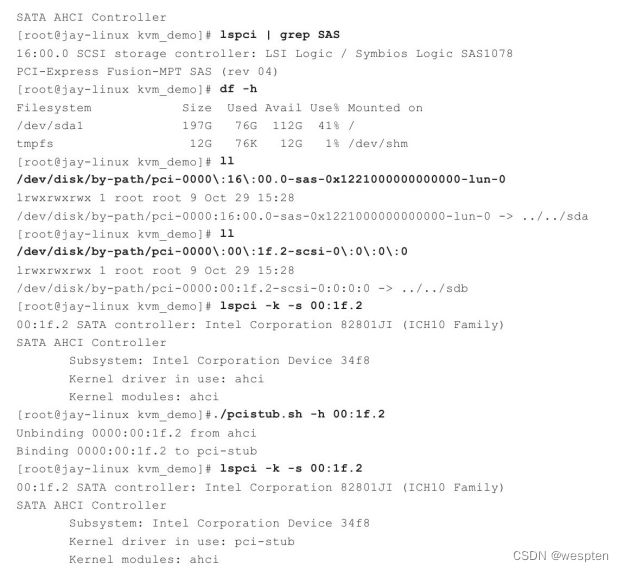

7. VT-d和SR-IOV相关的参数

添加一个设备驱动器(driver),其中prop=value是设置驱动器的各项属性。可以用"-device?"参数查看到有哪些可用的驱动器,可以用"-device driver,?"查看到某个驱动器(driver)支持的所有属性。不管是KVM的VT-d还是SR-IOV特性,都是使用"device"参数将宿主机中的设备完全分配给客户机使用,如"-device pci-assign,host=08:00.0,id=mydev0,addr=0x6"参数就将宿主机的BDF号是08:00.0的设备分配给客户机使用。VT-d和SR-IOV在使用时的区别在于,VT-d中分配的设备是一个物理PCI/PCI-e设备,而SR-IOV使用的是虚拟设备(VF,Virtual Function)。

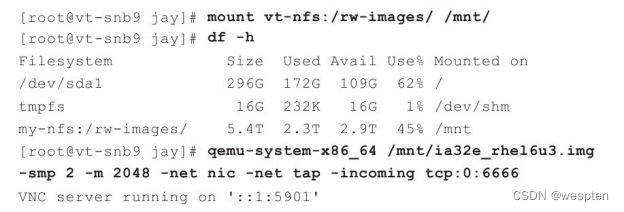

8. 动态迁移的参数

-incoming port参数让qemu-kvm进程进入到迁移监听(migration-listen)模式,而不是真正以命令行中的镜像文件运行客户机。如启动客户机的qemu-kvm命令行中添加了"-incoming tcp:0:6666"参数,表示在6666端口建立一个TCP Socket连接用于接收来自源主机的动态迁移的内容,其中“0”表示允许来自任何主机的连接。

9. 已使用过的其他参数

(1)-daemonize参数

在启动时让qemu-kvm作为守护进程在后台运行。如果没有该参数,默认qemu-kvm在启动客户机后就会占用标准输入输出,直到客户机退出。"-daemonize"参数的使用,可以让一个qemu-kvm进程在后台运行,接着在当前位置进行其他的操作(如启动另一个客户机)。

(2)-usb参数

开启客户机中的USB总线,如"-usb-usbdevice tablet"就是在客户机中模拟USB而不是PS/2的键盘和鼠标,而且使用tablet这种类型的设备实现鼠标的定位。

(3)-enable-kvm参数

打开KVM虚拟化的支持,在qemu-kvm中,"-enable-kvm"默认就是打开的,默认支持KVM虚拟化,而在纯QEMU中,默认没有打开KVM的支持,需要"-enable-kvm"参数来配置。

10. 其他常用参数

-h显示帮助手册:

显示了当前qemu-kvm工具中支持的所有命令行参数。

-version显示qemu-kvm的版本信息:

显示了当前QEMU模拟器是qemu-kvm开发分支的1.1.0版本。

-k设置键盘布局的语言:

默认值为en-us(美式英语键盘),一般不需要设置这个参数,除非客户机中键盘布局、按键不准确才需要设置,如"-k fr"表示客户机使用法语(French)的键盘布局。它所支持的键盘布局的语言一般在"/usr/local/share/qemu/keymaps/"目录中。

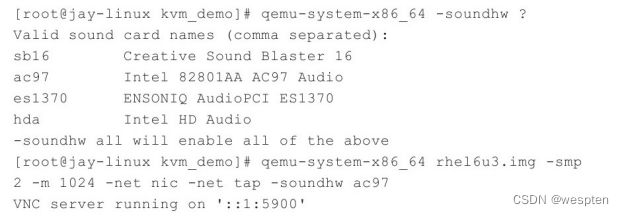

-soundhw开启声卡硬件的支持:

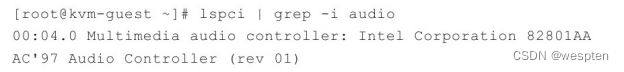

可以通过"-soundhw?"查看有效的声卡的种类,在qemu-kvm命令行中添加"-soundhw ac97"参数即可在客户机中使用到Intel 82801AAAC97声卡。在宿主机中查看支持的声卡种类,然后选择使用"ac97"声卡类型启动一个客户机。

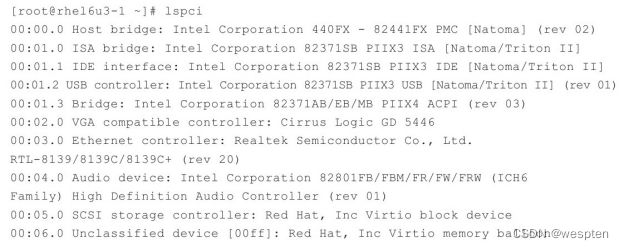

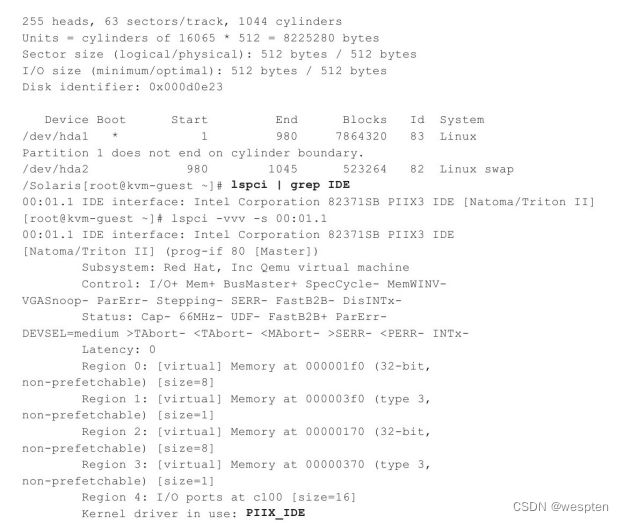

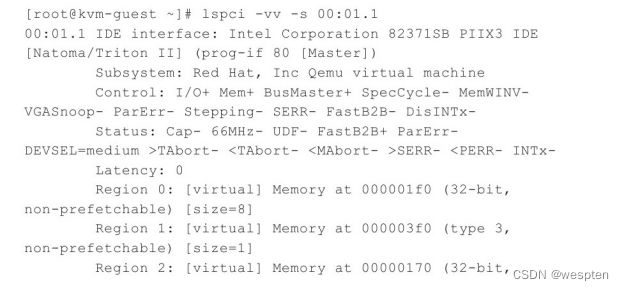

在客户机中通过"lspci"命令查看到的声卡如下:

-display设置显示方式:

选择客户机使用的显示方式,它是为了取代前面提及过的较旧的"-sdl"、"-curses"、"-vnc"等参数。如"-display sdl"表示通过SDL方式显示客户机图像输出,"-display curses"表示使用curses/ncurses方式来显示图像,"-display none"表示不显示任何的图像输出(它与"-nographic"参数的区别在于,"-nographic"会显示客户机的串口和并口的输出),"-display vnc=localhost:2"表示将客户机图像输出显示到本地的2号VNC显示端口中(与"-vnc localhost:2"的意义相同)。

-name设置客户机名称:

设置客户机名称可用于在某宿主机上唯一标识该客户机,如"-name myname"参数就表示设置客户机的名称为"myname",设置的名字将会在SDL窗口边框的标题中显示,或者在VNC窗口的标题栏中显示。

-uuid设置系统的UUID:

客户机的UUID标识符,与名称类似,不过一般来说UUID是一个较大系统中唯一的标识符。在libvirt等虚拟机管理工具中就根据UUID来管理所有客户机的唯一标识。在通过qemu-kvm命令行启动客户时添加"-uuid 12345678-1234-1234-1234-123456789abc"参数(UUID是按照8-4-4-4-12个数分布的32个十六进制数字),就配置了客户机的UUID,然后在QEMU monitor中也可以用"info uuid"命令来查询到该客户机的UUID值。

-rtc设置RTC开始时间和时钟类型:

![]()

其中"base"选项设置客户机的实时时钟(RTC,real-time clock)开始的时间,默认值为"utc"。而当微软的DOS和Windows系统作为客户机时,应该将"base"选项设置为"base=localtime",否则时钟非常不准确。也可以选择某个具体的时间作为"base"基础时间,如"2012-11-06T22:22:22"或“2012-11-06”这样的格式。

"clock"选项用于设置客户机实时时钟的类型。默认情况下是"clock=host",表示由宿主机的系统时间来驱动,一般会让客户机使用的RTC时钟比较准确。特别是当宿主机的时间通过与外部时钟进行同步(如NTP方式)而保持准确的时候,默认"clock=host"会提供非常准确的时间。如果设置"clock=rt",则表示将客户机和宿主机的时间进行隔离,而不进行校对。如果设置"clock=vm",则当客户机暂停的时候,客户机时间将不会继续向前计时。

"driftfix"选项用于设置是否进行时间漂移的修复。默认值是"driftfix=none",表示不进行客户机时间偏移的修复。而"driftfix=slew"则表示当客户机中可能出现时间漂移的时能够自动修复,某些Windows作为客户机时可能会出现时间不太准确(时间漂移)的情况,这时qemu-kvm先计算出Windows客户机中缺少了多少个时间中断,然后重新将缺少的时间中断注入到客户机中。

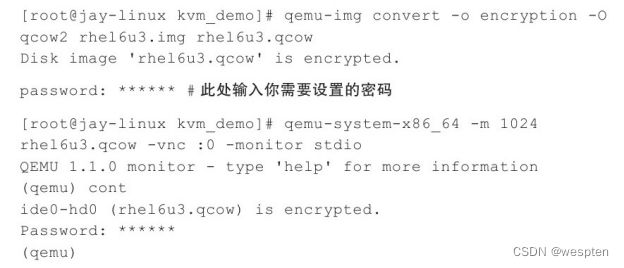

2)QEMU监控器

QEMU监控器(monitor)是QEMU与实现用户交互的一种控制台,一般用于为QEMU模拟器提供较为复杂的功能,包括为客户机添加和移除一些媒体镜像(如CD-ROM、磁盘镜像等),暂停和继续客户机的运行,快照的建立和删除,从磁盘文件中保存和恢复客户机状态,客户机动态迁移,查询客户机当前各种状态参数……。根据实际应用的具体场景已经多次提及一部分QEMU monitor中的命令了。

① QEMU monitor的切换和配置

要使用QEMU monitor,首先需要切换到monitor窗口中,然后才能使用命令来操作。

在默认情况下,在显示客户机的QEMU窗口中,"Ctrl+Alt+2"组合键可以切换到QEMU monitor中,从monitor窗口中按"Ctrl+Alt+1"组合键可以回到客户机标准显示窗口。

当然,并非在所有情况下都使用"Ctrl+Alt+2"快捷键切换到monitor窗口,如果使用SDL显示,且在使用qemu-kvm命令行启动客户机时添加了"-alt-grab"或"-ctrl-grab"参数,则会使该组合键被对应修改为"Ctrl+Alt+Shift+2"或“右Ctrl+2”组合键。

如果所有的情况都一定要到图形窗口(SDL或VNC)才能操作QEMU monitor,那么在某些完全不能使用图形界面的情况下将会受到一些限制。其实,QEMU提供了如下的参数来灵活地控制monitor的重定向。

该参数的作用是将monitor重定向到宿主机的dev设备上。关于dev设备这个选项的写法有很多种,下面简单介绍其中的几种。

1)vc

即虚拟控制台(Virtual Console),不加"-monitor"参数就会使用"-monitor vc"作为默认参数。而且,还可以用于指定monitor虚拟控制台的宽度和长度,如"vc:800x600"表示宽度、长度分别为800像素、600像素,"vc:80Cx24C"则表示宽度、长度分别为80个字符宽和24个字符长,这里的C代表字符(character)。注意,只有选择这个"vc"为"-monitor"的选项时,利用前面介绍的"Ctrl+Alt+2"组合键才能切换到monitor窗口,其他情况下不能用这个组合键。

2)/dev/XXX

使用宿主机的终端(tty),如"-monitor/dev/ttyS0"是将monitor重定向到宿主机的ttyS0串口上去,而且QEMU会根据QEMU模拟器的配置来自动设置该串口的一些参数。

3)null

空设备,表示不将monitor重定向到任何设备上,无论怎样也不能连接上monitor。

4)stdio

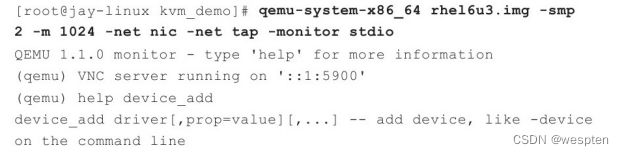

标准输入输出,不需要图形界面的支持。"-monitor stdio"将monitor重定向到当前命令行所在标准输入输出上,可以在运行QEMU命令后直接就默认连接到monitor中,操作起来非常方便。当需要使用较多QEMU monitor的命令时(这是经常使用的方式),命令行示例如下:

上面的命令行中演示了通过qemu-kvm命令行启动客户机后,标准输入输出中显示了QEMU monitor,然后在monitor中运行了"help device_add"命令来查看"device_add"命令的帮助手册。

② 监控器常用命令总结

1. help显示帮助信息

help命令可以显示其他命令的帮助信息,其命令格式为:

![]()

"help"与“?”命令是同一个命令,都是显示命令的帮助信息。它后面不加cmd命令作为参数时,help命令(单独的"help"或“?”)将显示该QEMU中支持的所有命令及其简要的帮助手册。当有cmd参数时,"help cmd"将显示cmd命令的帮助信息,如果cmd不存在,则帮助信息输出为空。

在monitor中使用help命令的几个示例,命令行操作如下:

2. info显示系统状态

info命令显示当前系统状态的各种信息,也是monitor中一个很常用的命令,其命令格式如下:

显示subcommand中描述的系统状态。如果subcommand为空,则显示当前可用的所有的各种info命令组合及其介绍,这与"help info"命令显示的内容相同。

已经多次用到info命令来查看客户机系统的状态了,下面单独介绍一些常用的info命令的基本功能。

(1)info version

查看QEMU的版本信息。

(2)info kvm

查看当前QEMU是否有KVM的支持。

(3)info name

显示当前客户机的名称。

(4)info status

显示当前客户机的运行状态,可能为运行中(running)和暂停(paused)状态。

(5)info uuid

查看当前客户机的UUID[19]标识。

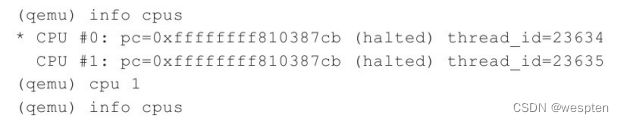

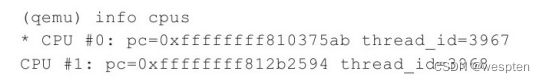

(6)info cpus

查看客户机各个vCPU的信息。

(7)info registers

查看客户机的寄存器状态信息。

(8)info tlb

查看TLB信息,显示了客户机虚拟地址到客户机物理地址的映射。

(9)info mem

查看正在活动中的虚拟内存页。

(10)info numa

查看客户机中看到的NUMA结构。

(11)info mtree

以树状结构展示内存的信息。

(12)info balloon

查看ballooning的使用情况。

(13)info pci

查看PCI设备的状态信息。

(14)info qtree

以树状结构显示客户机中的所有设备。

(15)info block

查看块设备的信息,如硬盘、软盘、光盘驱动器等。

(16)info chardev

查看字符设备的信息,如串口、并口和这里的monitor设备等。

(17)info network

查看客户的网络配置信息,包括VLAN及其关联的网络设备。

(18)info usb

查看客户机中虚拟USB hub上的USB设备。

(19)info usbhost

查看宿主机中的USB设备的信息。

(20)info snapshots

显示当前系统中已保存的客户机快照的信息。

(21)info migrate

查看当前客户机迁移的状态。

(22)info roms

显示客户机使用的BIOS等ROM文件的信息。

(23)info vnc

显示当前客户机的VNC状态。

(24)info history

查看当前的QEMU monitor中命令行执行的历史记录。

在QEMUmonitor中实际执行其中的几个命令,命令行如下:

3. 已使用过的命令

(1)info

已经详细介绍过info命令了,info命令包括:info kvm、info cpus、info block、info network、info pci、info balloon、info migrate等。

(2)commit

提交修改部分的变化到磁盘镜像中(在使用了"-snapshot"启动参数),或提交变化部分到使用后端镜像文件。

(3)cont或c

恢复QEMU模拟器继续工作。另外,"stop"是暂停QEMU模拟器的命令。

(4)change

改变一个设备的配置,如"change vnc localhost:2"改变VNC的配置,"change vnc password"更改VNC连接的密码,"change ide1-cd0/path/to/some.iso"改变客户机中光驱加载的光盘。

(5)balloon

改变分配给客户机的内存大小,如"balloon 512"表示改变分配给客户机的内存大小为512 MB。

(6)device_add和device_del

动态添加或移除设备,如"device_add pci-assign,host=02:00.0,id=mydev"将宿主机中的BDF编号为02:00.0的PCI设备分配给客户机,而"device_del mydev"移除刚才添加的设备。

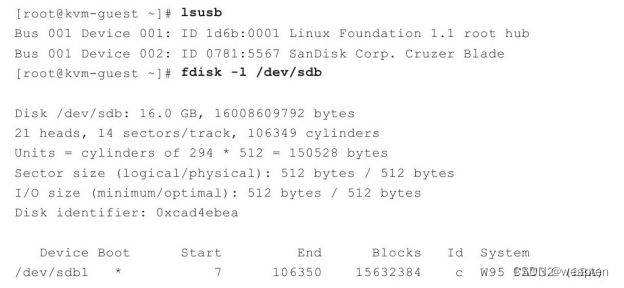

(7)usb_add和usb_del

添加或移除一个USB设备,如"usb_add host:002.004"表示添加宿主机的002号USB总线中的004设备到客户机中,"usb_del 0.2"表示删除客户机中的某个USB设备。

(8)savevm、loadvm和delvm

创建、加载和删除客户机的快照,如"savevm mytag"表示根据当前客户机状态创建标志为"mytag"的快照,"loadvm mytag"表示加载客户机标志为"mytag"快照时的状态,而"delvm mytag"表示删除"mytag"标志的客户机快照。

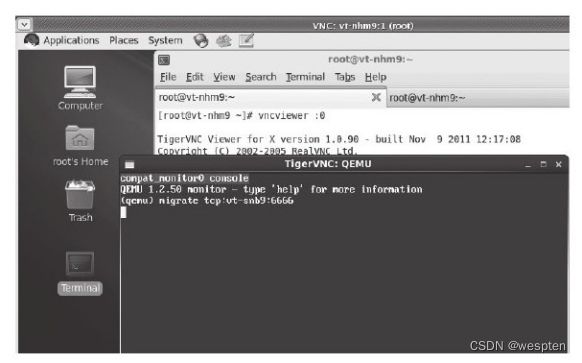

(9)migrate和migrate_cancel

动态迁移和取消动态迁移,如"migrate tcp:des_ip:6666"表示动态迁移当前客户机到IP地址为"des_ip"的宿主机的TCP 6666端口上去,而"migrate_cancel"则表示取消当前进行中的动态迁移过程。

4. QEMU monitor 其他常见命令

QEMU monitor中还有很多非常有用的命令,选取其中一些常用的进行简单介绍。

(1)cpu index

设置默认的CPU为index数字指定的,在info cpus命令的输出中,星号(*)标识的CPU就是系统默认的CPU,几乎所有的中断请求都会优先发到默认CPU上去。如下命令行演示了"cpu index"命令的作用。

在"cpu 1"命令后,系统的默认CPU变为CPU#1了。另外,利用"cpu_set num online|offline"命令可以添加或移除num数量的CPU已经提及过目前这个命令不生效,有bug存在。

(2)log和logfile

"log item1[,...]"将制定的item1项目的log保存到/tmp/qemu.log中;而"logfile filename"命令设置log文件输出到filename文件中而不是默认的/temp/qemu.log文件。

(3)sendkey keys

向客户机发送keys按键(或组合键),就如同非虚拟环境中那样的按键效果。如果同时发送的是多个按键的组合,则按键之间用“-”来连接。如"sendkey ctrl-alt-f2"命令向客户机发送"ctrl-alt-f2"键,将会切换客户机的显示输出到tty2终端;"sendkey ctrl-alt-delete"命令则会发送"ctrl-alt-delete"键,在文本模式的客户机Linux系统中该组合键会重启系统。

用"sendkey ctrl-alt-f1"、"sendkey ctrl-alt-f2"、"sendkey ctrl-alt-f5"切换到客户机的tty1、tty2、tty5等终端登录系统,然后ssh连接到系统中查看当前系统已登录用户的状态如下。

(4)system_powerdown、system_reset和system_wakeup

❑system_powerdown向客户机发送关闭电源的事件通知,一般会让客户机执行关机操作。

❑system_reset让客户机系统重置,相当于直接拔掉电源,然后插上电源,按开机键开机。

❑system_wakeup将客户机从暂停(suspend)中唤醒。

使用这几个命令要小心,特别是system_reset命令是很“暴力”的,可能会损坏客户机系统中的文件系统。

(5)x和xp

❑x/fmtaddr转存(dump)出从addr开始的虚拟内存地址。

❑xp/fmtaddr转存出从addr开始的物理内存地址。

在上面两个命令中,fmt指定如何格式化输出转存出来的内存信息。fmt格式的语法是:/{count}{format}{size}。其中,count表示被转存出来条目的数量,format可以是x(hex,十六进制)、d(有符号的十进制)、u(无符号的十进制)、o(八进制)、c(字符)、i(asm汇编指令),size可以是b(8位)、h(16位)、w(32位)、g(64位)。另外,在x86架构体系下,format中的i可以根据实际指令长度自动设置size为h(16位)或w(32位)。x和xp这两个命令可以用于对客户机或者QEMU开发过程中的调试。使用x和xp转存出一些内存信息,如下:

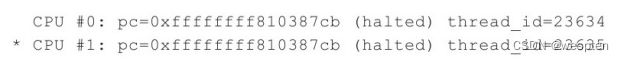

(6)p或print fmt expr

按照fmt格式打印expr表达式的值,可以使用$reg来访问CPU寄存器。如"print 1+2"就是计算“1+2”表达式的值,而"p$cs"就是打印CS寄存器的值。使用p或print命令的示例如下:

(7)q或quit

执行q或quit命令,直接退出QEMU模拟器,QEMU进程会被杀掉。

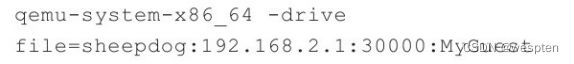

3) 存储设备URL的语法参数

QEMU/KVM除了可以使用本地的raw、qcow2等格式的镜像之外,还可以使用远程的如NFS上镜像文件,也可以使用iSCSI、NBD、Sheepdog等网络存储设备上面的存储。对于NFS,挂载后就和使用本地文件没有任何区别,而iSCSI等则在启动时需要使用一些特殊的URL语法以便标识存储的位置。并不详细讲解其语法,而是举例简要介绍其基本用法。

(1)iSCSI的URL语法

iSCSI支持qemu-kvm直接访问iSCSI资源和直接使用其镜像文件作为客户机存储,支持磁盘镜像和光盘镜像。qemu-kvm使用iSCSI LUNs的语法为:

而iSCSI会话建立的参数为:

一个使用iSCSI的示例如下:

不过需要注意的是,在qemu-kvm配置、编译时需要有libiscsi的支持才行(在运行./configure配置时,添加--enable-libiscsi参数),否则qemu-kvm可能不能支持iSCSI。

(2)NBD的URL语法

QEMU支持使用TCP协议的NBD(Network Block Devices)设备,也支持Unix Domain Socket的NBD设备。

使用TCP的NBD设备,在qemu-kvm中的语法为:

而使用Unix Domain Socket的NBD设备,其语法为:

在qemu-kvm命令中的示例为:

(3)Sheepdog的URL语法

Sheepdog可以让QEMU使用分布式存储系统。qemu-kvm支持本地和远程网络的Sheepdog设备。Sheepdog在使用时的语法,可以有如下几种形式:

![]()

qemu-kvm命令行中的示例为:

关于Sheepdog更详细的使用,可以参考:http://www.osrg.net/sheepdog/。

-chardev配置字符型设备:

![]()

配置一个字符型设备,其中"backend"可以是"null、socket、udp、msmouse、vc、file、pipe、console、serial、pty、stdio、braille、tty、parport、spicevmc"之一。后端(backend)将会决定后面可用的选项。"id=id"选项设置了该设备的唯一标识,ID可以是包含最多127个字符的字符串。每个设备必须有一个唯一的ID,它可用于其他命令行参数识别该设备。"mux=on|off"选项表示该设备是否多路复用。当该字符型设备被用于多个前端(frontend)使用时,需要启用"mux=on"这个模式。

-bios指定客户机的BIOS文件:

设置BIOS的文件名称。一般来说,qemu-kvm会到"/usr/local/share/qemu/"目录下去找BIOS文件。但也可以使用"-L path"参数来改变qemu-kvm查找BIOS、VGA BIOS、keymaps等文件的目录。

-no-reboot和-no-shutdown参数:

"-no-reboot"参数,让客户机在执行重启(reboot)操作时,在系统关闭后就退出qemu-kvm进程,而不会再启动客户机。

"-no-shutdown"参数,让客户机执行关机(shutdown)操作时,在系统关闭后,不退出qemu-kvm进程(在正常情况下,系统关闭后就退出qemu-kvm进程),而是保持这个进程存在,它的QEMU monitor依然可以使用。在需要的情况下,这就允许在关机后切换到monitor中将磁盘镜像的改变提交到真正的镜像文件中。

-loadvm加载快照状态:

"-loadvm mysnapshot"在qemu-kvm启动客户机时即加载系统的某个快照,这与QEMU monitor中的"loadvm"命令的功能类似。

-pidfile保存进程ID到文件中:

"-pidfile qemu-pidfile"保存qemu-kvm进程的PID文件到qemu-pidfile中,这对在某些脚本中对该进程继续做处理提供了便利(如设置该进程的CPU亲和性,监控该进程的运行状态)。

-nodefaults不创建默认的设备:

在默认情况下,qemu-kvm会为客户机配置一些默认的设备,如串口、并口、虚拟控制台、monitor设备、VGA显卡等。使用了"-nodefaults"参数可以完全禁止默认创建的设置,而仅仅使用命令行中显式指定的设备。

-readconfig和-writeconfig参数:

"-readconfig guest-confg"参数从文件中读取客户机设备的配置(注意仅仅是设备的配置信息,不包含CPU、内存之类的信息)。当qemu-kvm命令行参数的长度超过系统允许的最长参数的个数时,qemu-kvm将会遇到错误信息"arg list too long",这时如果将需要的配置写到文件中,使用"-readconfig"参数来读取配置,就可以避免参数过长的问题。在Linux系统中,可以用"getconf ARG_MAX"命令查看系统能支持的命令行参数的字符个数。

"-writeconfig guest-confg"参数表示将客户机中设备的配置写到文件中;"-writeconfig"参数则会将设备的配置打印在标准输出中。保存好的配置文件,可以用于刚才介绍的"-readconfig"参数。

设备配置文件如下:

-nodefconfig和-no-user-config参数:

"-nodefconfig"参数使qemu-kvm不加载默认的配置文件。在默认情况下,qemu-kvm会加载/usr/local/share/qemu/目录下的配置文件(当然不同系统中可能目录不一致的),如cpus-x86_64.conf文件等。

"-no-user-config"参数使qemu-kvm不加载用户自定义的配置文件(其目录是在编译QEMU时指定的,默认还是为"/usr/local/share/qemu/"),但是依然会加载qemu-kvm原本提供的配置文件(如cpus-x86_64.conf)。

4) Linux或多重启动相关的参数

qemu-kvm提供了一些参数,可以让用户不用安装系统到磁盘上即可启动Linux或多重启动的内核,这个功能可以用于进行早期调试或测试各种不同的内核。

(1)"-kernel bzImage"参数

使用"bzImage"作为客户机内核镜像。这个内核可以是一个普通Linux内核或多重启动的格式中的内核镜像。

(2)"-append cmdline"参数

使用"cmdline"作为内核附加的命令选项

(3)"-initrd file"参数

使用"file"作为初始化启动是的内存盘(ram disk)。

(4)"-initrd" file1 arg=foo,file2""参数

仅用于多重启动中,使用file1和file2作为模块,并将"arg=foo"作为参数传递给第一个模块(file1)。

(5)"-dtb file"参数

使用file文件作为设备树二进制(dtb,device tree binary)镜像,在启动时将其传递给客户机内核。

5)-serial串口重定向

"-serial dev"参数将客户机的串口重定向到宿主机的字符型设备dev上。可以重复多次使用"-serial"参数,以便为客户机模拟多个串口,最多可以达到4个串口(ttyS0~ttyS3)。

在默认情况下,如果客户机工作在图形模式,则串口被重定向到虚拟控制台(vc,virtual console),"Ctrl+Alt+3"组合键可以切换到该串口;如果客户机工作在非图形模式下(使用了"-nographics"参数),串口默认被重定向到标准输入输出(stdio)。还可以将串口重定向到一个文件中,如"-serial file:myserial.log"参数就将串口输出重定向到当前目录的myserial.log文件中,如果将客户机的内核输出也重定向到串口,那么这样就可以将内核打印的信息都保存到myserial.log文件中了,特别是当客户机系统崩溃时,这样保存的串口输出日志文件可以辅助我们分析系统崩溃时的具体状态。

对于串口重定向,可以选择很多种设备(dev)作为重定向的输出,下面简单介绍其中的几种。

(1)vc

虚拟控制台(virtual console),这是默认的选择,与"-monitor"重定向监控器输出类似,还可以指定串口重定向的虚拟控制台的宽度和长度,如"vc:800x600"表示宽度、长度分别为800像素、600像素。

(2)pty

重定向到虚拟终端(pty),系统默认自动创建一个新的虚拟终端。

(3)none

不重定向到任何设备。

(4)null

重定向到空的设备。

(5)/dev/XXX

使用宿主机系统更多终端设备(如/dev/ttyS0)。

(6)file:filename

重定向到filename这个文件中,只能保存串口输出,不能输入字符进行交互。

(7)stdio

重定向到当前的标准输入输出。

(8)pipe:filename

重定向到filename名字的管道。

(9)其他

还可以将串口重定向到TCP或UDP建立的网络控制台中,还可以重定向到Unix Domain Socket。

6)调试相关的参数

qemu-kvm中也有很多和调试相关的参数,下面简单介绍其中的几个参数。

(1)-singlestep

以单步执行的模式运行QEMU模拟器。

(2)-S

在启动时并不启动CPU,需要在monitor中运行"c"(或"cont")命令才能继续运行。它可以配合"-gdb"参数一起使用,启动后,让gdb远程连接到qemu-kvm上,然后再继续运行。

(3)-gdb dev

运行GDB服务端(gdbserver),等待GDB连接到dev设备上。典型的连接可能是基于TCP协议的,当然也可能是基于UDP协议、虚拟终端(pty),甚至是标准输入输出(stdio)的。"-gdb"参数配置可以让内核开发者很方便地使用qemu-kvm运行内核,然后用GDB工具连接上去进行调试(debug)。

在qemu-kvm命令行中使用TCP方式的"-gdb"参数,示例如下:

在本机的GDB中可以运行如下命令连接到qemu-kvm运行的内核上去,当然如果是远程调试就需要添加一些网络IP地址的参数:

而在使用标准输入输出(stdio)时,允许在GDB中执行qemu-kvm,然后通过管道连接到qemu-kvm的客户机中,例如可以用如下的方式来使用:

(4)-s

"-s"参数是"-gdb tcp::1234"的简写表达方式,即在TCP 1234端口打开一个GDB服务器。

(5)-d

将QEMU的日志保存在/tmp/qemu.log中,以便调试时查看日志。

(6)-D logfile

将QEMU的日志保存到logfile文件中(而不是"-d"参数指定的/tmp/qemu.log)中。

(7)-watchdog model

创建一个虚拟的硬件看门狗(watchdog)设备,对于一个客户机而言,只能够启用一个看门狗。在客户机中必须要有看门狗的驱动程序,周期性地轮询这个看门狗,否则客户机将会被重启。"model"选项是QEMU模拟产生的硬件看门狗的模型,一般有两个可选"ib700"(iBASE 700)和"i6300esb"(Intel 6300ESB I/O controller hub)。使用"-watchdog?"可以查看到所有可用的硬件看门狗模型的列表,命令行演示如下:

查看客户机中内核是否支持这些看门狗,在客户机中命令行如下:

(8)-watchdog-action action

"action"选项控制qemu-kvm在看门狗定时器到期时的动作。默认动作是"reset",它表示“暴力”重置客户机(让客户机掉电然后重启)。一些可选的动作包括:"shutdown"表示正常关闭客户机系统,"poweroff"表示正常关闭系统后再关闭电源,"pause"表示暂停客户机,"debug"表示打印出调试信息然后继续运行,"none"表示什么也不做。看门狗相关的一个示例参数如下:

(9)-trace-unassigned

跟踪未分配的内存访问或未分配的I/O访问,并记录到标准错误输出(stderr)。

(10)-trace[events=file][,file=lofile]

指定一些跟踪的选项。其中"event=file"中的file文件的格式必须是每行包含一个事件(event)的名称,其中所有的事件名称都已在qemu-kvm源代码中的"trace-events"文件中列出来了。"event=file"这个选项只有在qemu-kvm编译时指定的跟踪后端(tracing backend)为"simple"或"stderr"时才可用,编译qemu-kvm的配置命令演示如下:

"file=logfile"选项是将跟踪的日志输出到logfile文件中。该选项只有在qemu-kvm编译时选择了"simple"作为跟踪后端时才可用。

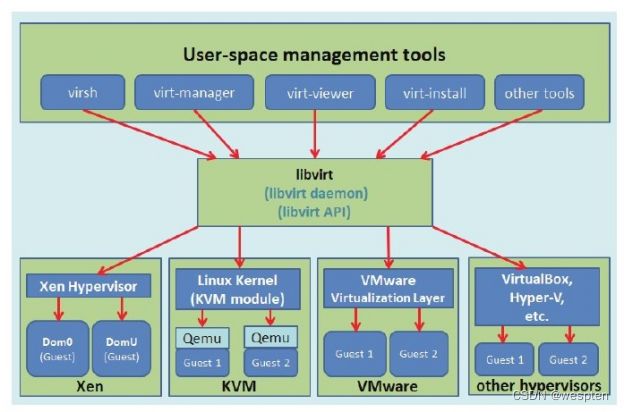

2、libvirt

提到KVM的管理工具,首先不得不介绍的就是大名鼎鼎的libvirt,因为libvirt是目前使用最为广泛的对KVM虚拟机进行管理的工具和应用程序接口,而且一些常用的虚拟机管理工具(如virsh、virt-install、virt-manager等)和云计算框架平台(如OpenStack、OpenNebula、Eucalyptus等)都在底层使用libvirt的应用程序接口。

libvirt是为了更方便地管理平台虚拟化技术而设计的开放源代码的应用程序接口、守护进程和管理工具,它不仅提供了对虚拟化客户机的管理,也提供了对虚拟化网络和存储的管理。尽管libvirt项目最初是为Xen设计的一套API,但是目前对KVM等其他Hypervisor的支持也非常的好。libvirt支持多种虚拟化方案,既支持包括KVM、QEMU、Xen、VMware、VirtualBox等在内的平台虚拟化方案,又支持OpenVZ、LXC等Linux容器虚拟化系统,还支持用户态Linux(UML)的虚拟化。libvirt是一个免费的开源的软件,使用的许可证是LGPL[1](GNU宽松的通用公共许可证),使用libvirt库进行链接的软件程序不一定要选择开源和遵守GPL许可证。和KVM、Xen等开源项目类似,libvirt也有自己的开发者社区,而且随着虚拟化、云计算等成为近年来的技术热点,libvirt项目的社区也比较活跃。目前,libvirt的开发主要由Redhat公司作为强大的支持,由于Redhat公司在虚拟化方面逐渐偏向于支持KVM(而不是Xen),故libvirt对QEMU/KVM的支持是非常成熟和稳定的。当然,IBM、Novell等公司以及众多的个人开发者,对libvirt项目的代码贡献量也是非常大的。

libvirt本身提供了一套较为稳定的C语言应用程序接口,目前,在其他一些流行的编程语言中也提供了对libvirt的绑定,在Python、Perl、Java、Ruby、PHP、OCaml等高级编程语言中已经有libvirt的程序库可以直接使用。libvirt还提供了为基于AMQP(高级消息队列协议)的消息系统(如ApacheQpid)提供QMF代理,这可以让云计算管理系统中宿主机与客户机、客户机与客户机之间的消息通信变得更易于实现。libvirt还为安全的远程管理虚拟客户机提供了加密和认证等安全措施。正是由于libvirt拥有这些强大的功能和较为稳定的应用程序接口,而且它的许可证(license)也比较宽松,libvirt的应用程序接口已被广泛地用在基于虚拟化和云计算的解决方案中,主要作为连接底层Hypervisor和上层应用程序的一个中间适配层。

libvirt对多种不同的Hypervisor的支持是通过一种基于驱动程序的架构来实现的。libvirt对不同的Hypervisor提供了不同的驱动:对Xen有Xen的驱动,对QEMU/KVM有QEMU驱动,对VMware有VMware驱动。在libvirt源代码中,可以很容易找到qemu_driver.c、xen_driver.c、xenapi_driver.c、vmware_driver.c、vbox_driver.c这样的驱动程序源代码文件。

libvirt作为中间适配层,让底层Hypervisor对上层用户空间的管理工具可以是完全透明的,因为libvirt屏蔽了底层各种Hypervisor的细节,为上层管理工具提供了一个统一的、较稳定的接口(API)。通过libvirt,一些用户空间管理工具可以管理各种不同的Hypervisor和上面运行的客户机,它们之间基本的交互框架如下图所示。

在libvirt中涉及几个重要的概念,解释如下:

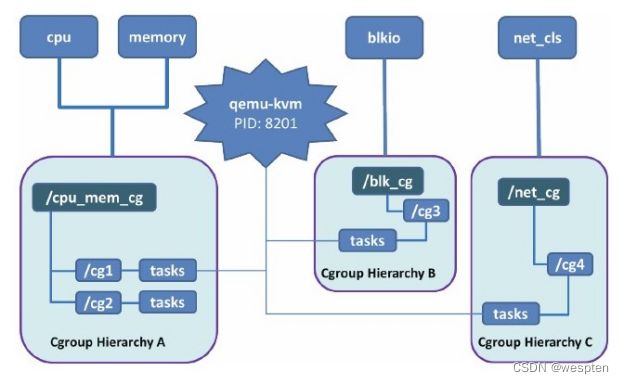

❑节点(Node)是一个物理机器,上面可能运行着多个虚拟客户机。Hypervisor和Domain都运行在节点之上。

❑Hypervisor也称虚拟机监控器(VMM),如KVM、Xen、VMware、Hyper-V等,是虚拟化中的一个底层软件层,它可以虚拟化一个节点让其运行多个虚拟客户机(不同客户机可能有不同的配置和操作系统)。

❑域(Domain)是在Hypervisor上运行的一个客户机操作系统实例。域也被称为实例(instance,如亚马逊的AWS云计算服务中的客户机就被称为实例)、客户机操作系统(guest OS)、虚拟机(virtual machine),它们都是指同一个概念。

关于节点、Hypervisor和域的关系,可以简单地用图来表示。

![]()

在了解了节点、Hypervisor和域的概念之后,用一句话概括libvirt的目标,那就是:为了安全高效地管理节点上的各个域,而提供一个公共的稳定的软件层。当然,这里的管理,既包括本地的管理,也包含远程的管理。具体地讲,libvirt的管理功能主要包含如下五个部分。

(1)域的管理。包括对节点上的域的各个生命周期的管理,如启动、停止、暂停、保存、恢复和动态迁移。也包括对多种设备类型的热插拔操作,包括磁盘、网卡、内存和CPU,当然不同的Hypervisor对这些热插拔的支持程度有所不同。

(2)远程节点的管理。只要物理节点上运行了libvirtd这个守护进程,远程的管理程序就可以连接到该节点进程管理操作,经过认证和授权之后,所有的libvirt功能都可以被访问和使用。libvirt支持多种网络远程传输类型,如SSH、TCP套接字、Unix domain socket、支持TLS的加密传输等。假设使用了最简单的SSH,不需要额外配置工作,比如,在example.com节点上运行了libvirtd,而且允许SSH访问,在远程的某台管理机器上就可以用如下的命令行来连接到example.com上,从而管理其上的域。

(3)存储的管理。任何运行了libvirtd守护进程的主机,都可以通过libvirt来管理不同类型的存储,如创建不同格式的客户机镜像(qcow2、raw、qde、vmdk等)、挂载NFS共享存储系统、查看现有的LVM卷组、创建新的LVM卷组和逻辑卷、对磁盘设备分区、挂载iSCSI共享存储,等等。当然在libvirt中,对存储的管理也是支持远程管理的。

(4)网络的管理。任何运行了libvirtd守护进程的主机,都可以通过libvirt来管理物理的和逻辑的网络接口。包括列出现有的网络接口卡,配置网络接口,创建虚拟网络接口,网络接口的桥接,VLAN管理,NAT网络设置,为客户机分配虚拟网络接口,等等。

(5)提供一个稳定、可靠、高效的应用程序接口,以便可以完成前面的4个管理功能。

libvirt主要由三个部分组成,它们分别是:应用程序编程接口库、一个守护进程(libvirtd)和一个默认命令行管理工具(virsh)。应用程序接口是为其他虚拟机管理工具(如virsh、virt-manager等)提供虚拟机管理的程序库支持。libvirtd守护进程负责执行对节点上的域的管理工作,在用各种工具对虚拟机进行管理之时,这个守护进程一定要处于运行状态中,而且这个守护进程可以分为两种:一种是root权限的libvirtd,其权限较大,可以完成所有支持的管理工作;一种是普通用户权限的libvirtd,只能完成比较受限的管理工作。

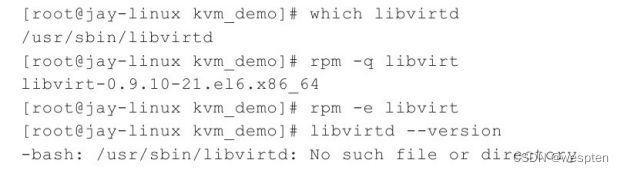

1)libvirt的编译、安装和配置

如果只是普通用户使用libvirt,一般不需要从源码编译libvirt,只需要安装对应的Linux系统上libvirt软件包即可。一些高级用户或开发者,可能希望对libvirt进行更多的了解,甚至通过修改libvirt的源代码来实现自己的功能,因此还是需要了解从源代码编译和安装libvirt的过程。

下面以在一个RHEL 6.3系统上编译libvirt 1.0.0版本为例,介绍一下libvirt的编译和安装过程。

(1)检查和清理安装的libvirt

在真正开始编译之前,需要检查和清理系统上已经安装的libvirt(如果曾经安装过),命令行操作如下:

(2)下载libvirt的源代码

可以选择从Linux系统发行版的源代码ISO中获取其libvirt的源代码安装包,也可以选择到libvirt官方网站下载libvirt源代码的tar.gz压缩包,还可以通过git工具将开发中的libvirt源码仓库克隆到本地。

libvirt官方发布源代码的网页是:http://libvirt.org/sources/。该网页上提供了最原生的libvirt各个版本的源代码的tar.gz压缩包,以及已经编译好的libvirt-devel、libvirt-python、libvirt-java、libvirt-php等RPM包。libvirt官方还提供了下载源代码的FTP站点:ftp://libvirt.org/libvirt/。下载libvirt-1.0.0.tar.gz源码包并将其解压缩的命令行如下:

libvirt处于开发中的最新的git代码仓库的地址为:git://libvirt.org/libvirt.git。还可以通过网页http://libvirt.org/git/以在线网页的方式浏览libvirt.git、libvirt-java.git、libvirt-php.git等开发中的代码仓库。另外,libvirt的python绑定的代码就存放在libvirt的源码仓库(libvirt.git)中,没有单独的libvirt-python代码仓库。下载libvirt开发代码仓库的命令行如下:

![]()

(3)配置和编译libvirt

配置和编译libvirt的方法与Linux上多数的开源项目的方法类似,都是先运行configure脚本进行编译环境配置的,然后用make命令进行编译,用make install命令进行安装。

查看有哪些配置选项可用的命令为"./configure--help",命令行操作如下:

根据上面的配置帮助信息可知,如果不用"--prefix=PREFIX"参数指定自定义的安装路径,那么libvirt相关的文件默认都会被安装到/usr/local/bin和/usr/local/lib等目录中。

配置libvirt编译环境的命令为"./configure",命令行操作如下:

在配置过程中,可能会由于缺少编译时需要依赖的软件包而导致配置失败,这时只需要按照提示安装对应的软件包,然后重新运行"./configure"命令配置即可。在默认情况下,libvirt会配置QEMU/KVM、vmware的驱动支持(如果能找到相关依赖库程序),也会配置libvirtd和virsh等,还会默认配置libvirt对python的绑定。对于Xen、Hyper-V等的支持,配置程序会自动检查当前系统是否含有与这些Hypervisor相关的程序,如果检测成功,就会编译对应的驱动。

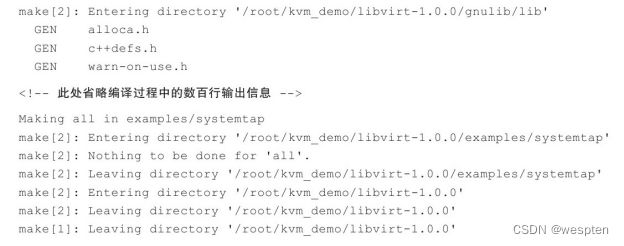

真正编译libvirt的命令为"make",命令行操作如下:

![]()

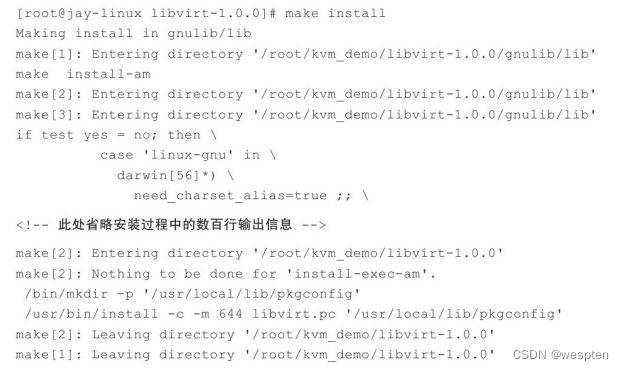

(4)安装libvirt

在配置和编译时都不需要超级用户(root)权限,但是在安装libvirt时一般都需要root用户权限。执行make install命令即可完成libvirt安装,命令行操作如下:

(5)检查已经安装的libvirt

libvirt的安装会为系统安装libvirtd、virsh等可执行程序,也会安装libvirt的API程序库,还会安装对python的绑定,检查这些安装后的文件,命令行操作如下:

如果安装后立即使用libvirt这些程序库,会遇到找不到对应库文件的错误提示,这时可能需要运行ldconfig等工具来更新刚才安装的共享库。

(6)从libvirt的git代码仓库编译libvirt

从git源代码仓库编译和安装libvirt,与从libvirt的源码tar.gz包编译和安装的过程是完全类似的。这里只介绍一些在编译前进行配置(configure)时的一些不同之处。在使用libvirt.git源码仓库配置时,先运行其自带的autogen.sh这个脚本,它会默认会先下载git://git.sv.gnu.org/gnulib.git,然后根据模板生成configure配置脚本和初始化一些Makefile文件,最后自动运行configure文件进行对编译环境的配置。

从git源码仓库安装libvirt的基本操作命令行如下(省略命令执行的输出信息):

在默认状态下,配置和编译后安装的目录与Linux操作系统发行版提供的默认目录可能不一致,例如,在RHEL 6.3中通过系统的RPM包安装的libvirtd、virsh等可执行程序被安装在/usr/sbin/目录下,libvirt.so、libvirt-qemu.so等共享库文件被安装在/usr/lib64/目录下,而从前面步骤(5)可知,在编译安装时默认会将libvirtd、virsh等安装在/usr/local/sbin目录下,而libvirt.so、libvirt-qemu.so等被安装在/usr/local/lib/目录下。如果想保持对操作系统发行版中安装的可执行程序和共享库的目录的一致性,autogen.sh脚本提供了"--system"参数,通过这个参数来配置,就会尽可能保证安装目录与原生系统的一致性,其命令行操作如下(省略了部分命令执行的输出信息):

2. 用软件包安装libvirt

很多流行的Linux发行版(如RHEL 6.x、Fedora 17、Ubuntu 12.10等)都提供了libvirt相关的软件包,按照安装普通软件包的方式安装libvirt相关的软件包即可。在当前使用的RHEL 6.3中可以使用yum或rpm工具来安装对应的RPM包。查看某系统中已经安装的libvirt相关的RPM包,命令行如下:

当然,RHEL 6.3默认采用QEMU/KVM的虚拟化方案,所以应该安装QEMU相关的软件包,查看这些软件包的命令行操作如下:

![]()

由于libvirt是跨平台的,而且还支持微软公司的Hyper-V虚拟化,所以在Windows上也可以安装libvirt,甚至可以编译libvirt。可以到libvirt官方的网页(http://libvirt.org/sources/win32_experimental/)中查看和下载能在Windows上运行的libvirt安装程序。不过,由于libvirt主要还是基于Linux开发的,而且支持它的公司(Redhat等)中的开发者和个人开发者大多数都是Linux程序员,故libvirt的Windows版本还是处于开发中的,开发进度并不如Linux上libvirt开发得快,前面提到的能下载的libvirt Windows版也是实验性的版本,而不是正式产品的发行版,其功能并不是非常完善。

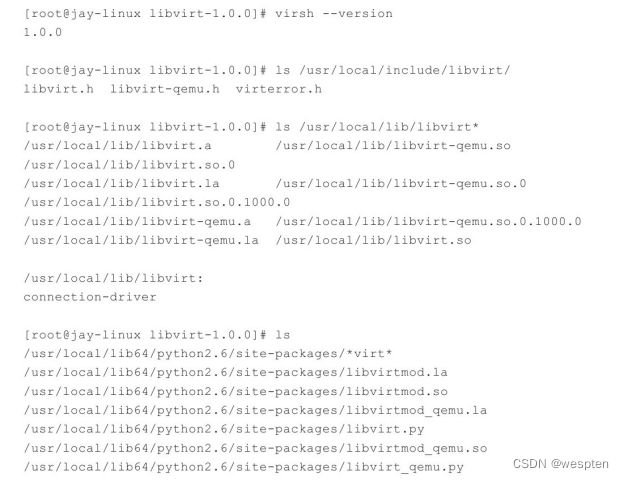

2)libvirt和libvirtd的配置

1. libvirt的配置文件

以RHEL 6.3为例,libvirt相关的配置文件都在/etc/libvirt/目录之中,如下:

下面简单介绍其中几个重要的配置文件和目录。

(1)/etc/libvirt/libvirt.conf

libvirt.conf文件用于配置一些常用libvirt连接(通常是远程连接)的别名,和Linux中的普通配置文件一样,在该配置文件中以井号(#)开头的行是注释,如下:

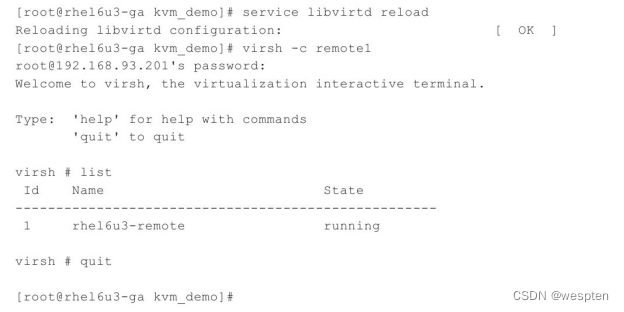

其中,配置了remote1这个别名用于指代qemu+ssh://[email protected]/system这个远程的libvirt连接,有这个别名后,就可以在用virsh等工具或自己写代码调用libvirt API时使用这个别名,而不需要写完整的、冗长的URI连接标识了。用virsh使用这个别名,连接到远程的libvirt上查询当前已经启动的客户机状态,然后退出连接,命令行操作如下:

在代码中调用libvirt API时也可以使用这个别名来建立连接,如下的python代码行就实现了使用这个别名来建立连接。

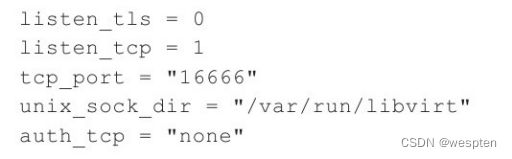

(2)/etc/libvirt/libvirtd.conf

libvirtd.conf是libvirt的守护进程libvirtd的配置文件,被修改后需要让libvirtd重新加载配置文件(或重启libvirtd)才会生效。在libvirtd.conf文件中,用井号(#)开头的行是注释内容,真正有用的配置在文件的每一行中使用“配置项=值”(如tcp_port="16509")这样配对格式来设置。在libvirtd.conf中配置了libvirtd启动时的许多设置,包括是否建立TCP、UNIX domain socket等连接方式及其最大连接数,以及这些连接的认证机制,等等。

例如,下面的几个配置项表示关闭TLS安全认证的连接(默认值是打开的)、打开TCP连接(默认是关闭TCP连接的),设置TCP监听的端口,TCP连接不使用认证授权方式,设置UNIX domain socket的保存目录等。

注意 要让TCP、TLS等连接生效,需要在启动libvirtd时加上--listen参数(简写为-l)。而默认的service libvirtd start命令在启动libvirtd服务时并没带--listen参数,所以如果要使用TCP等连接方式,可以使用libvirtd--listen-d命令来启动libvirtd。

以上配置选项实现将UNIX socket放到/var/run/libvirt目录下,启动libvirtd并检验配置是否生效,命令行操作如下:

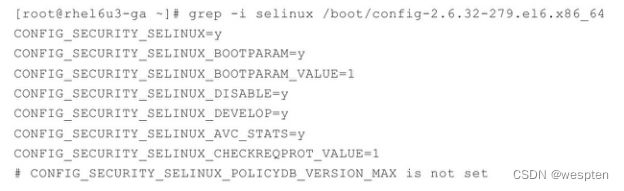

(3)/etc/libvirt/qemu.conf

qemu.conf是libvirt对QEMU的驱动的配置文件,包括VNC、SPICE等和连接它们时采用的权限认证方式的配置,也包括内存大页、SELinux、Cgroups等相关配置。

(4)/etc/libvirt/qemu/目录

在qemu目录下存放的是使用QEMU驱动的域的配置文件,查看qemu目录如下:

其中包括了两个域的XML配置文件(rhel6u3-1.xml和rhel6u3-2.xml),这就是用virt-manager工具创建的两个域,默认会将其配置文件保存到/etc/libvirt/qemu/目录下。而其中的networks目录保存了创建一个域时默认使用的网络配置。

2. libvirtd的使用

libvirtd是一个作为libvirt虚拟化管理系统中的服务器端的守护程序,要让某个节点能够利用libvirt进行管理(无论是本地还是远程管理),都需要在这个节点上运行libvirtd这个守护进程,以便让其他上层管理工具可以连接到该节点,libvirtd负责执行其他管理工具发送给它的虚拟化管理操作指令。而libvirt的客户端工具(包括virsh、virt-manager等)可以连接到本地或远程的libvirtd进程,以便管理节点上的客户机(启动、关闭、重启、迁移等)、收集节点上的宿主机和客户机的配置和资源使用状态。

在RHEL 6.3中libvirtd是作为一个服务(service)配置在系统中的,所以可以通过service命令来对其进行操作(实际是通过/etc/init.d/libvirtd服务脚本来实现的)。常用的操作方式有:"service libvirtd start"命令表示启动libvirtd,"service libvirtd restart"表示重启libvirtd,"service libvirtd reload"表示不重启服务但重新加载配置文件(即/etc/libvirt/libvirtd.conf配置文件)。对libvirtd服务进行操作的命令行如下:

在默认情况下,libvirtd在监听一个本地的UNIX domain socket,而没有监听基于网络的TCP/IP socket,需要使用“-l或--listen”的命令行参数来开启对libvirtd.conf配置文件中TCP/IP socket的配置。另外,libvirtd守护进程的启动或停止,并不会直接影响正在运行中的客户机。libvirtd在启动或重启完成时,只要客户机的XML配置文件是存在的,libvirtd会自动加载这些客户的配置,获取它们的信息;当然,如果客户机没有基于libvirt格式的XML文件来运行,libvirtd则不能发现它。

libvirtd是一个可执行程序,不仅可以使用"service"命令调用它作为服务来运行,而且可以单独地运行libvirtd命令来使用它。下面介绍以下几种libvirtd命令行的参数。

(1)-d或--daemon

表示让libvirtd作为守护进程(daemon)在后台运行。

(2)-f或--config FILE

指定libvirtd的配置文件为FILE,而不是使用默认值(通常是/etc/libvirt/libvirtd.conf)。

(3)-l或--listen

开启配置文件中配置的TCP/IP连接。

(4)-p或--pid-file FILE

将libvirtd进程的PID写入到FILE文件中,而不是使用默认值(通常是/var/run/libvirtd.pid)。

(5)-t或--timeout SECONDS

设置对libvirtd连接的超时时间为SECONDS秒。

(6)-v或--verbose

执行命令输出详细的输出信息。特别是在运行出错时,详细的输出信息便于用户查找原因。

(7)--version

显示libvirtd程序的版本信息。

关于libvirtd命令的使用,几个简单的命令行操作如下:

3) libvirt域的XML配置文件

在使用libvirt对虚拟化系统进行管理时,很多地方都是XML文件作为配置文件,包括客户机(域)的配置、宿主机网络接口配置、网络过滤、各个客户机的磁盘存储配置、磁盘加密、宿主机和客户机的CPU特性,等等。只针对客户机的XML进行较详细的介绍,因为客户机的配置是最基本的和最重要的,了解了它之后就可以使用libvirt管理客户机了。

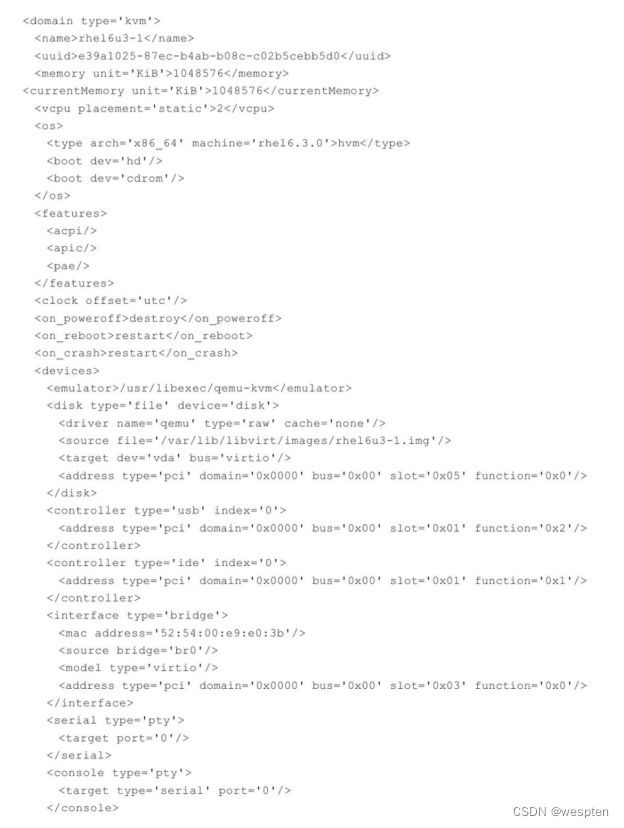

1. 客户机的XML配置文件格式的示例

在libvirt中,客户机(即域)的配置是采用XML格式来描述的。下面展示了使用virt-manager创建的一个客户机的配置文件。

由上面的配置文件示例可以看到,在该域的XML文件中所有有效配置都在<domain>和</domain>标签之间,这表明该配置文件是一个域的配置。(XML文档中注释在两个特殊的标签之间,如<!--注释-->。)

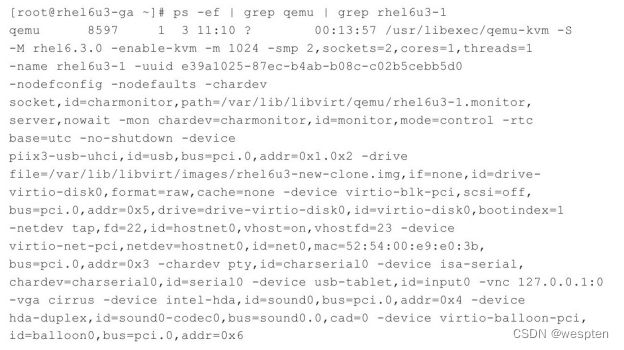

通过libvirt启动客户机,经过文件解析和命令参数的转换,最终也会调用qemu-kvm命令行工具来实际完成客户机的创建。用这个XML配置文件启动的客户机,它的qemu-kvm命令行参数是非常详细非常冗长的一行,查询qemu-kvm命令行参数的操作如下:

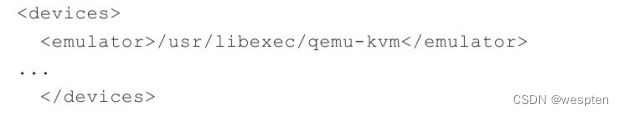

这里RHEL 6.3系统中的qemu-kvm工具为/usr/libexec/qemu-kvm,与从源代码编译和安装的qemu-system-x86_64工具是类似的,它们的参数也基本一致(当然如果两者版本差异较大,参数和功能可能有一些不同)。qemu-kvm命令的这么多的参数,针对域的XML配置文件进行介绍和分析。

2. CPU、内存、启动顺序等基本配置

(1)CPU的配置

在前面介绍的rhel6u3-1.xml配置文件中,关于CPU的配置为:

![]()

vcpu标签,表示客户机中vCPU的个数,这里为两个。features标签,表示Hypervisor为客户机打开或关闭CPU或其他硬件的特性,这里打开了ACPI、APIC、PAE等特性。当然,CPU的特性是在该客户机的CPU模型中定义的,如RHEL 6.3中的qemu-kvm默认该客户机的CPU模型是cpu64-rhel6,该CPU模型中的特性(如SSE2、LM、NX、TSC等)也是该客户机使用的。

对CPU的分配,可以有更细粒度的配置,例如:

cpuset表示允许到哪些物理CPU上执行,这里表示客户机的两个vCPU被允许调度到1、2、4、6号物理CPU上执行(^3表示排除3号),而current表示启动客户机时只给一个vCPU,最多可以增加到使用2个vCPU。

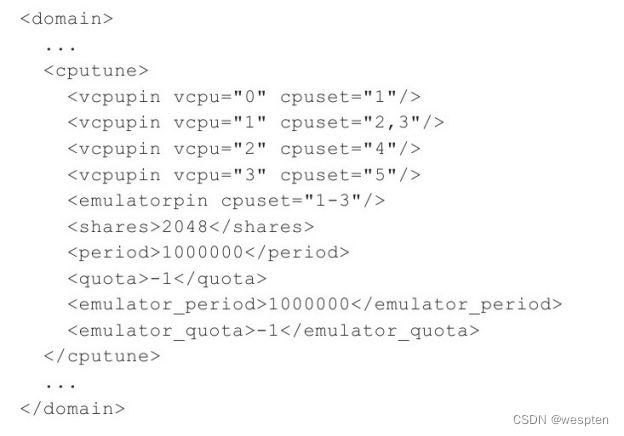

当然libvirt还提供cputune标签来对CPU分配进行更多调节,如下:

这里只简单解释其中几个配置,vcpupin标签表示将虚拟CPU绑定到某一个或多个物理CPU上,如"<vcpupin vcpu="2"cpuset="4"/>"表示客户机2号虚拟CPU被绑定到4号物理CPU上运行。"<emulatorpin cpuset="1-3"/>"表示将QEMU emulator绑定到1~3号物理CPU上。在不设置任何vcpupin和cpuset的情况下,客户机的虚拟CPU默认会被调度到任何一个物理CPU上去运行。"<shares>2048</shares>"表示客户机占用CPU时间的加权配额,一个配置为2048的域,会获得的CPU执行时间是配置为1024的域的两倍。如果不设置shares值,就会默认使用宿主机系统提供的默认值。

(2)内存的配置

在该域的XML配置文件中,内存大小的配置如下:

![]()

可知,内存大小为1048576 KB(即1GB),memory标签中的内存表示客户机最大可使用的内存,currentMemory标签中的内存表示启动时即分配给客户机使用的内存。在使用QEMU/KVM时,一般将二者设置为相同的值。

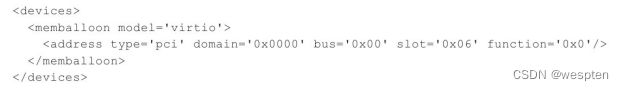

另外,内存的ballooning相关的配置包含在devices这个标签的memballoon子标签中,该标签配置了该客户机的内存气球设备,如下:

该配置将为客户机分配一个使用virtio-balloon驱动的设备,以便实现客户机内存的ballooning调节,该设备在客户机中的PCI设备编号为0000:00:06.0。

(3)客户机系统类型和启动顺序

客户机系统类型及其启动顺序,在os标签中配置,如下:

![]()

这样的配置表示客户机类型是HVM类型,HVM(硬件虚拟机,Hardware Virtual machine)原本是Xen虚拟化中的概念,它表示在硬件辅助虚拟化技术(Intel VT或AMD-V等)的支持下不需要修改客户机操作系统就可以启动客户机。因为KVM一定要依赖于硬件虚拟化技术的支持,所以在KVM中,客户机类型应该总是hvm,操作系统的架构是x86_64,机器类型是rhel6.3.0(这是RHEL 6.3系统的默认类型,也可以根据需要填写其他类型,如rhel6.2.0等)。boot选项用于设置客户机启动时的设备,这里有hd(即硬盘)和cdrom(光驱)两种,而且是按照硬盘、光驱的顺序启动的,它们在XML配置文件中的先后顺序即是启动时的先后顺序。

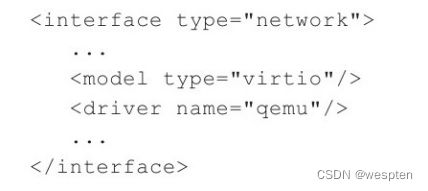

3. 网络的配置

(1)桥接方式的网络配置

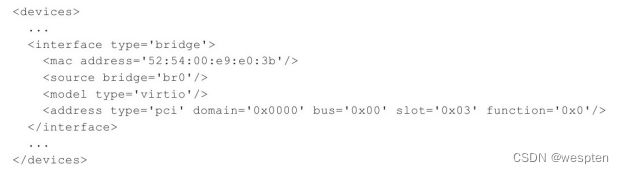

在示例的域的XML配置中,使用桥接方式的网络的相关配置如下:

type='bridge'表示使用桥接方式使客户机获得网络,address用于配置客户机中网卡的MAC地址,<source bridge='br0'/>表示使用宿主机中的br0网络接口来建立网桥,<model type='virtio'/>表示在客户机中使用virtio-net驱动的网卡设备,也配置了该网卡在客户机中的PCI设备编号为0000:00:03.0。在“4.5网络配置”中已经详细介绍过几种不同的网络配置方式,而在libvirt中都有对它们的相应支持。

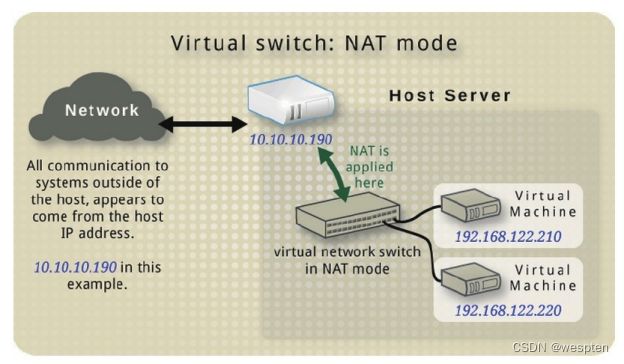

(2)NAT方式的虚拟网络配置

在域的XML配置中,NAT方式的虚拟网络的配置示例如下:

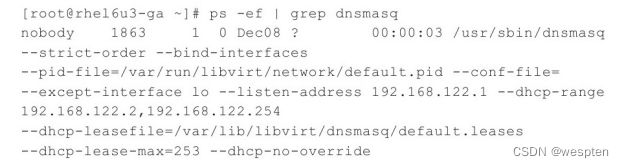

这里的设置为type='network'和<source network='default'/>表示使用NAT的方式,并使用默认的网络配置,客户机将会分配到192.168.122.0/24网段中的一个IP地址。当然,使用NAT必须保证宿主机中运行着DHCP和DNS服务器,一般默认使用的dnsmasq软件,查询DHCP和DNS服务的运行的命令行如下:

由于配置使用了默认的NAT网络配置,可以到libvirt相关的网络配置中看到一个default.xml文件(/usr/share/libvirt/networks/default.xml),它具体配置了默认的连接方式,如下:

在使用NAT时,查看宿主机中网桥的使用情况如下:

其中vnet0这个网络接口就是客户机和宿主机网络连接的纽带。

(3)用户模式网络的配置

在域的XML文件中,如下的配置即实现了使用用户模式的网络:

其中,type='user'表示该客户机的网络接口是用户模式网络,完全由qemu-kvm软件模拟的一个网络协议栈。在宿主机中,是没有一个虚拟的网络接口连接到virbr0这样的网桥的。

(4)网卡设备直接分配(VT-d)

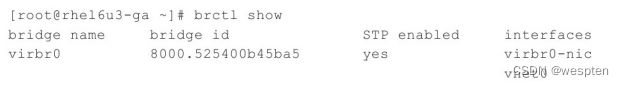

在客户机的网络配置中,还可以采用PCI/PCI-e网卡将设备直接分配给客户机使用。对于设备直接分配的配置在域的XML配置文件中有两种方式:一种是较新的方式,使用<interface type='hostdev'/>标签;另一种是较旧但支持设备很广泛的方式,直接使用<hostdev>标签。

<interface type='hostdev'/>标签是较新的配置方式,目前仅支持libvirt 0.9.11以上的版本,而且仅支持SR-IOV特性中的VF的直接配置。在<interface type='hostdev'/>标签中,用<source>标签来指示将宿主机中的哪个VF分配给宿主机使用,还可使用<mac address='52:54:00:6d:90:02'>来指定在客户机中看到的该网卡设备的MAC地址。一个示例配置如下所示,它表示将宿主机的0000:08:10.0这个VF网卡直接分配给客户机使用,并规定该网卡在客户机中的MAC地址为“52:54:00:6d:90:02”。

![]()

在<devices>标签中直接使用<hostdev>标签来指定将网卡设备直接分配给客户机使用,这是较旧的配置方式,是libvirt 0.9.11版本之前对设备直接分配的唯一使用方式,而且对设备的支持较为广泛,既支持有SR-IOV功能的高级网卡的VF的直接分配,也支持无SR-IOV功能的普通PCI或PCI-e网卡的直接分配。这种方式并不支持对直接分配的网卡在客户机中的MAC地址的设置,在客户机中网卡的MAC地址与宿主机中看到的完全相同。在域的XML配置文件中,使用<hostdev>标签配置网卡设备直接分配的示例如下,它表示将宿主机中的PCI 0000:08:00.0设备直接分配给客户机使用。

4. 存储的配置

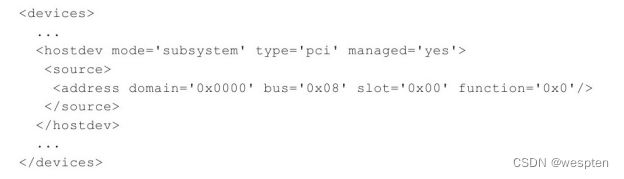

在示例的域的XML配置文件中,关于客户机磁盘的配置如下:

上面的配置表示,使用raw格式的rhel6u3-1.img镜像文件作为客户机的磁盘,磁盘的缓存是关闭的,其在客户机中使用virtio总线(使用virtio-blk驱动),设备名称为/dev/vda,其PCI地址为0000:00:05.0。

<disk>标签是客户机磁盘配置的主标签,其中包含它的属性和一些子标签。它的type属性表示磁盘使用哪种类型作为磁盘的来源,其取值为file、block、dir或network中的一个,分别表示使用文件、块设备、目录或网络来作为客户机磁盘的来源。它的device属性表示让客户机如何来使用该磁盘设备,其取值为floppy、disk、cdrom或lun中的一个,分别表示软盘、硬盘、光盘和LUN(逻辑单元号),其默认值为disk(硬盘)。

在<disk>标签中可以配置许多的子标签,这里仅简单介绍一下上面示例中出现的几个重要的子标签。<driver>子标签用于定义Hypervisor如何为该磁盘提供驱动,它的name属性用于指定宿主机中使用的后端驱动名称,QEMU/KVM仅支持name='qemu',但是它支持的类型type可以是多种,包括raw、qcow2、qed、bochs等。而这里的cache属性表示在宿主机中打开该磁盘时使用的缓存方式,可以配置为default、none、writethrough、writeback、directsync和unsafe等多种模式。已经详细地介绍过磁盘缓存的各种配置方式的区别。

<source>子标签表示磁盘的来源,当<disk>标签的type属性为file时,应该配置为<source file='/var/lib/libvirt/images/rhel6u3-1.img'/>这样的模式,而type属性为block时,应该配置为<source dev='/dev/sda'/>这样的模式。

<target>子标签表示将磁盘暴露给客户机时的总线类型和设备名称。其dev属性表示在客户机中该磁盘设备的逻辑设备名称,而bus属性表示该磁盘设备被模拟挂载的总线类型,bus属性的值可以为ide、scsi、virtio、xen、usb、sata等。如果省略了bus属性,libvirt则会根据dev属性中的名称来“推测”bus属性的值,例如,sda会被推测是scsi,而vda被推测是virtio。

<address>子标签表示该磁盘设备在客户机中的PCI地址,这个标签在前面网络配置中也是多次出现的,如果该标签不存在,libvirt会自动分配一个地址。

5. 其他配置简介

(1)域的配置

在域的整个XML配置文件中,<domain>标签是范围最大、最基本的标签,是其他所有标签的根标签。在示例的域的XML配置文件中,<domain>标签的配置如下:

在<domain>标签中可以配置两个属性:一个是type,用于表示Hypervisor的类型,可选的值为xen、kvm、qemu、lxc、kqemu、vmware等中的一个;另一个是id,其值是一个数字,用于在该宿主机的libvirt中唯一标识一个运行着的客户机,如果不设置id属性,libvirt会按顺序分配一个最小的可用ID。

(2)域的元数据配置

在域的XML文件中,有一部分是用于配置域的元数据(meta data)。元数据用于表示域的属性(用于区别其他的域)。在示例的域的XML文件中,元数据的配置如下:

![]()

其中,name用于表示该客户机的名称,uuid是唯一标识该客户机的UUID。在同一个宿主机上,各个客户机的名称和UUID都必须是唯一的。

当然,域的元数据,还有其他很多的配置,例如Xen上的一个域的元数据配置如下:

(3)QEMU模拟器的配置

在域的配置文件中,需要制定使用的设备模型的模拟器,在emulator标签中配置模拟器的绝对路径。在示例的域的XML文件中,模拟器的配置如下:

假设自己编译了一个最新的qemu-kvm,要使用自己编译的qmeu-kvm作为模拟器,只需要将这里修改为/usr/local/bin/qemu-system-x86_64即可。不过,创建客户机时可能会遇到如下的错误信息:

这是因为qemu-system-x86_64并不支持配置文件中的rhel6.3.0机器类型,做如下修改即可解决这个问题:

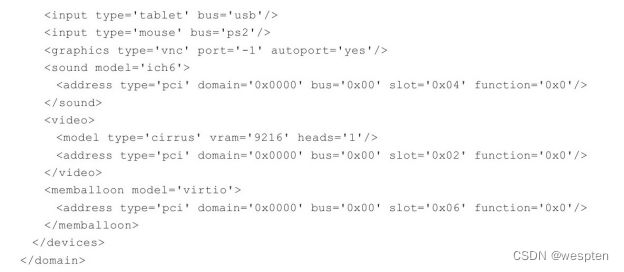

(4)图形显示方式

在示例的域的XML文件中,对连接到客户机的图形显示方式的配置如下:

这表示通过VNC的方式连接到客户机,其VNC端口为libvirt自动分配。

也可以支持其他多种类型的图形显示方式,以下就配置了SDL、VNC、RDP、SPICE等多种客户机显示方式。

(5)客户机声卡和显卡的配置

在示例的域的XML文件中,该客户机的声卡和显卡的配置如下:

![]()

<sound>标签表示的是声卡配置,其中model属性表示为客户机模拟出来的声卡的类型,其取值为es1370、sb16、ac97和ich6中的一个。

<video>标签表示的是显卡配置,其中<model>子标签表示为客户机模拟的显卡的类型,它的类型(type)属性可以为vga、cirrus、vmvga、xen、vbox、qxl等中的一个,vram属性表示虚拟显卡的显存容量(单位为KB),heads属性表示显示屏幕的序号。KVM客户机的显卡的默认配置为cirrus类型、显存为9216(即9 MB)、使用在第1号屏幕上。

(6)串口和控制台

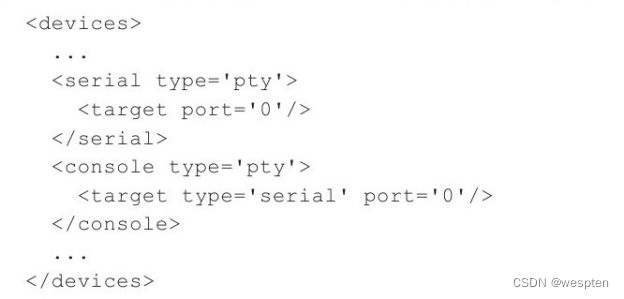

串口和控制台是非常有用的设备,特别是在调试客户机的内核或遇到客户机宕机的情况下,一般都可以在串口或控制台中查看到一些利于系统管理员分析问题的日志信息。在示例的域的XML文件中,客户机串口和控制台的配置如下:

设置了客户机的编号为0的串口(即/dev/ttyS0),使用宿主机中的伪终端(pty),由于这里没有指定使用宿主机中的哪个虚拟终端,因此libvirt会自己选择一个空闲的虚拟终端(可能为/dev/pts/下的任意一个)。当然也可以加上<source path='/dev/pts/1'/>配置来明确指定使用宿主机中的哪一个虚拟终端。在通常情况下,控制台(console)配置在客户机中的类型为'serial',此时,如果没有配置串口(serial),则会将控制台的配置复制到串口配置中,如果已经配置了串口(本例即是如此),则libvirt会将控制台的配置项忽略。

当然为了让控制台有输出信息和能够与客户机交互,也需在客户机中配置将信息输出到串口,如在Linux客户机内核的启动行中添加"console=ttyS0"这样的配置。在“5.10.2其他常用参数”中,对-serial参数的介绍中有更多和串口配置相关的介绍。

(7)输入设备

在示例的XML文件中,在客户机图形界面下进行交互的输入设备的配置如下:

这里的配置会让QEMU模拟PS2接口的鼠标,还提供了tablet这种类型的设备,让光标可以在客户机获取绝对位置定位。在“4.6.3 VNC显示中的鼠标偏移”中已经介绍过tablet设备的使用及其带来的好处。

(8)PCI控制器

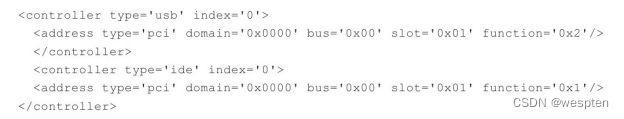

根据客户机架构的不同,libvirt默认会为客户机模拟一些必要的PCI控制器(而不需要在XML配置文件中指定),而一些PCI控制器需要显式地在XML配置文件中配置。在示例的域的XML文件中,一些PCI控制器的配置如下:

这里显式指定了一个USB控制器和一个IDE控制器。libvirt默认还会为客户机分配一些必要的PCI设备,如PCI主桥(Host bridge)、ISA桥等。使用示例的域的XML配置文件启动客户机,在客户机中查看到的PCI信息如下:

4) libvirt API简介

libvirt的核心价值和主要目标就是提供一套管理虚拟机的、稳定的、高效的应用程序接口(API)。libvirt API本身是用C语言实现的,libvirt API大致可划分为如下8个部分。

❑连接Hypervisor相关的API:以virConnect开头的一系列函数。

只有在与Hypervisor建立连接之后,才能进行虚拟机管理操作,所以连接Hypervisor的API是其他所有API使用的前提条件。与Hypervisor建立的连接是为其他API的执行提供了路径,是其他虚拟化管理功能的基础。通过调用virConnectOpen函数可以建立一个连接,其返回值是一个virConnectPtr对象,该对象就代表到Hypervisor的一个连接;如果连接出错,则返回空值(NULL)。而virConnectOpenReadOnly函数会建立一个只读的连接,在该连接上可以使用一些查询的功能,而不使用创建、修改等功能。virConnectOpenAuth函数提供了根据认证建立的连接。virConnectGetCapabilities函数返回对Hypervisor和驱动的功能的描述的XML格式的字符串。virConnectListDomains函数返回一列域标识符,它们代表该Hypervisor上的活动域。

❑域管理的API:以virDomain开头的一系列函数。

虚拟机最基本的管理职能就是对各个节点上的域的管理,故在libvirt API中实现了很多针对域管理的函数。要管理域,首先要获取virDomainPtr这个域对象,然后才能对域进行操作。有很多种方式来获取域对象,如virDomainPtrvirDomainLookupByID(virCo nnectPtr conn,int id)函数是根据域的id值到conn这个连接上去查找相应的域。类似地,virDomainLookupByName、virDomainLookupByUUID等函数分别是根据域的名称和UUID去查找相应的域。在得到某个域的对象后,就可以进行很多的操作,可以查询域的信息(如virDomainGetHostname、virDomainGetInfo、virDomainGetVcpus、virDomainGetVcpusFlags、virDomainGetCPUStats,等等),也可以控制域的生命周期(如virDomainCreate、virDomainSuspend、virDomainResume、virDomainDestroy、virDomainMigrate,等等)。

❑节点管理的API:以virNode开头的一系列函数。

域运行在物理节点之上,libvirt也提供了对节点进行信息查询和控制的功能。节点管理的多数函数都需要使用一个连接Hypervisor的对象作为其中的一个传入参数,以便可以查询或修改到该连接上的节点的信息。virNodeGetInfo函数是获取节点的物理硬件信息,virNodeGetCPUStats函数可以获取节点上各个CPU的使用统计信息,virNodeGetMemoryStats函数可以获取节点上的内存的使用统计信息,virNodeGetFreeMemory函数可以获取节点上可用的空闲内存大小。也有一些设置或者控制节点的函数,如virNodeSetMemoryParameters函数可以设置节点上的内存调度的参数,virNodeSuspendForDuration函数可以让节点(宿主机)暂停运行一段时间。

❑网络管理的API:以virNetwork开头的一系列函数和部分以virInterface开头的函数。

libvirt也对虚拟化环境中的网络管理提供了丰富的API。libvirt首先需要创建virNetworkPtr对象,然后才能查询或控制虚拟网络。一些查询网络相关信息的函数,如virNetworkGetName函数可以获取网络的名称,virNetworkGetBridgeName函数可以获取该网络中网桥的名称,virNetworkGetUUID函数可以获取网络的UUID标识,virNetworkGetXMLDesc函数可以获取网络的以XML格式的描述信息,virNetworkIsActive函数可以查询网络是否正在使用中。一些控制或更改网络设置的函数,例如virNetworkCreateXML函数可以根据提供的XML格式的字符串创建一个网络(返回virNetworkPtr对象),virNetworkDestroy函数可以销毁一个网络(同时也会关闭使用该网络的域),virNetworkFree函数可以回收一个网络(但不会关闭正在运行的域),virNetworkUpdate函数可根据提供XML格式的网络配置来更新一个已存在的网络。另外,virInterfaceCreate、virInterfaceFree、virInterfaceDestroy、virInterfaceGetName、virInterfaceIsActive等函数可以用于创建、释放和销毁网络接口,以及查询网络接口的名称和激活状态。

❑存储卷管理的API:以virStorageVol开头的一系列函数。

libvirt对存储卷(volume)的管理,主要是对域的镜像文件的管理,这些镜像文件可能是raw、qcow2、vmdk、qed等各种格式。libvirt对存储卷的管理,首先需要创建virStorageVolPtr这个存储卷对象,然后才能对其进行查询或控制操作。libvirt提供了3个函数来分别通过不同的方式来获取存储卷对象,如virStorageVolLookupByKey函数可以根据全局唯一的键值来获得一个存储卷对象,virStorageVolLookupByName函数可以根据名称在一个存储资源池(storage pool)中获取一个存储卷对象,virStorageVolLookupByPath函数可以根据它在节点上的路径来获取一个存储卷对象。有一些函数用于查询存储卷的信息,如virStorageVolGetInfo函数可以查询某个存储卷的使用情况,virStorageVolGetName函数可以获取存储卷的名称,virStorageVolGetPath函数可以获取存储卷的路径,virStorageVolGetConnect函数可以查询存储卷的连接。一些函数用于创建和修改存储卷,如virStorageVolCreateXML函数可以根据提供的XML描述来创建一个存储卷,virStorageVolFree函数可以释放存储卷的句柄(但是存储卷依然存在),virStorageVolDelete函数可以删除一个存储卷,virStorageVolResize函数可以调整存储卷的大小。

❑存储池管理的API:以virStoragePool开头的一系列函数。

libvirt对存储池(pool)的管理,包括对本地的基本文件系统、普通网络共享文件系统、iSCSI共享文件系统、LVM分区等的管理。libvirt需要基于virStoragePoolPtr这个存储池对象才能进行查询和控制操作。一些函数可以通过查询获取一个存储池对象,如virStoragePoolLookupByName函数可以根据存储池的名称来获取一个存储池对象,virStoragePoolLookupByVolume可以根据一个存储卷返回其对应的存储池对象。virStoragePoolCreateXML函数可以根据XML描述来创建一个存储池(默认已激活),virStoragePoolDefineXML函数可以根据XML描述信息静态地定义个存储池(尚未激活),virStoragePoolCreate函数可以激活一个存储池。virStoragePoolGetInfo、virStoragePoolGetName、virStoragePoolGetUUID等函数可以分别获取存储池的信息、名称和UUID标识。virStoragePoolIsActive函数可以查询存储池是否处于使用中状态。virStoragePoolFree函数可以释放存储池相关的内存(但是不改变其在宿主机中的状态),virStoragePoolDestroy函数可以用于销毁一个存储池(但并没有释放virStoragePoolPtr对象,之后还可以用virStoragePoolCreate函数重新激活它),virStoragePoolDelete函数可以物理删除一个存储池资源(该操作不可恢复)。

❑事件管理的API:以virEvent开头的一系列函数。

libvirt支持事件机制,在使用该机制注册之后,可以在发生特定的事件(如域的启动、暂停、恢复、停止等)时得到自己定义的一些通知。

❑数据流管理的API:以virStream开头的一系列函数。

libvirt还提供了一系列函数用于数据流的传输。

5)建立到Hypervisor的连接

要使用libvirt API进行虚拟化管理,就必须先建立到Hypervisor的连接,因为有了连接才能管理节点、Hypervisor、域、网络等虚拟化中的要素。介绍一下建立到Hypervisor连接的一些方式。

对于一个libvirt连接,可以使用简单的客户端-服务器端(C/S)的架构模式来解释,一个服务器端运行着Hypervisor,一个客户端去连接服务器端的Hypervisor,然后进行相应的虚拟化管理。当然,如果通过libvirt API实现本地的管理,则客户端和服务器端都在同一个节点上,并不依赖于网络连接。一般来说(如基于QEMU/KVM的虚拟化方案),不管是基于libvirt API的本地管理还是远程管理,在服务器端的节点上,除了需要运行相应的Hypervisor,还需要让libvirtd这个守护进程处于运行中的状态,以便让客户端连接到libvirtd从而进行管理操作。不过,也并非所有的Hypervisor都需要运行libvirtd守护进程,比如VMware ESX/ESXi就不需要在服务器端运行libvirtd,依然可以通过libvirt客户端以另外的方式[2]连接到VMware。

由于支持多种Hypervisor,libvirt需要通过唯一的标识来指定如何才能准确地连接到本地或远程的Hypervisor。为了达到这个目的,libvirt使用了在互联网应用中广泛使用的URI[3](Uniform Resource Identifier,统一资源标识符)来标识到某个Hypervisor的连接。libvirt中连接的标识符URI,其本地URI和远程URI有一些区别,下面分别介绍一下它们的使用方式。

1. 本地URI

在libvirt的客户端使用本地的URI用于连接本系统范围内的Hypervisor,本地URI的一般格式如下:

![]()

其中,driver是连接Hypervisor的驱动名称(如qemu、xen、xbox、lxc等),transport是选择该连接所使用的传输方式(可以为空,也可以是"unix"这样的值),path是连接到服务器端上的某个路径,?extral-param是可以用于添加额外的一些参数(如Unix domain sockect的路径)。

在libvirt中KVM使用QEMU驱动。QEMU驱动是一个多实例的驱动,它提供了一个系统范围内的特权驱动(即"system"实例)和一个用户相关的非特权驱动(即"session"实例)。通过"qemu:///session"这样的URI可以连接到一个libvirtd非特权实例,但是这个实例必须是与本地客户端的当前用户和用户组相同的实例,也就说,根据客户端的当前用户和用户组去服务器端寻找对应用户下的实例。在建立session连接后,可以查询和控制的域或其他资源都仅仅是在当前用户权限范围内的,而不是整个节点上的全部域或其他资源。而使用"qemu:///system"这样的URI连接到libvirtd实例,是需要系统特权账号"root"权限的。在建立system连接后,由于它是具有最大权限的,因此以查询和控制整个节点范围内的域,还可以管理该节点上特权用户才能管理的块设备、PCI设备、USB设备、网络设备等系统资源。一般来说,为了管理的方便,在公司内网范围内建立到system实例的连接进行管理的情况比较常见,当然为了安全考虑,赋予不同用户不同的权限就可以使用建立到session实例的连接。

在libvirt中,本地连接QEMU/KVM的几个URI示例如下:

(1)qemu:///session

连接到本地的session实例,该连接仅能管理当前用户虚拟化资源。

(2)qemu+unix:///session

以Unix domain sockect的方式连接到本地的session实例,该连接仅能管理当前用户的虚拟化资源。

(3)qemu:///system

连接到本地的system实例,该连接可以管理当前节点的所有特权用户可以管理的虚拟化资源。

(4)qemu+unix:///system

以Unix domain sockect的方式连接到本地的system实例,该连接可以管理当前节点的所有特权用户可以管理的虚拟化资源。

2. 远程URI

除了本地管理,libvirt还提供了非常方便的远程的虚拟化管理功能。libvirt可以使用远程URI来建立到网络上的Hypervisor的连接。远程URI和本地URI也是类似的,只是会增加用户名、主机名(或IP地址)和连接端口来连接到远程的节点。远程URI的一般格式如下:

![]()

其中,transport表示传输方式,其取值可以是ssh、tcp、libssh2等;user表示连接远程主机使用的用户名,host表示远程主机的主机名或IP地址,port表示连接远程主机的端口。其余的参数的意义,与本地URI中介绍的完全一样。

在远程URI连接中,也存在使用system实例和session实例两种方式,这二者的区别和用途,与本地URI中介绍的内容是完全一样的。

在libvirt中,远程连接QEMU/KVM的URI示例如下:

(1)qemu+ssh://[email protected]/system

通过ssh通道连接到远程节点的system实例,具有最大的权限来管理远程节点上的虚拟化资源。建立该远程连接时,需要经过ssh的用户名和密码验证或者基于密钥的验证。

(2)qemu+ssh://[email protected]/session

通过ssh通道连接到远程节点的使用user用户的session实例,该连接仅能对user用户的虚拟化资源进行管理,建立连接时同样需要经过ssh的验证。

(3)qemu://example.com/system

通过建立加密的TLS连接与远程节点的system实例相连接,具有对该节点特权管理权限。在建立该远程连接时,一般需要经过TLS x509安全协议的证书验证。

(4)qemu+tcp://example.com/system

通过建立非加密的普通TCP连接与远程节点的system实例相连接,具有对该节点特权管理权限。在建立该远程连接时,一般需要经过SASL/Kerberos认证授权。

3. 使用URI建立到Hypervisor的连接

在某个节点启动libvirtd后,一般在客户端都可以通过ssh方式连接到该节点。而TLS和TCP等连接方式却不一定都处于开启可用状态,如RHEL 6.3系统中的libvirtd服务在启动时就默认没有打开TLS和TCP这两种连接方式。而在服务器端的libvirtd打开了TLS和TCP连接方式,也需要一些认证方面的配置,当然也可直接关闭掉认证功能(这样不安全),可以参考libvirtd.conf配置文件。

我们看到URI这个标识还是比较复杂的,特别是在管理很多远程节点时,需要使用很多的URI连接。为了简化系统管理的复杂程度,可以在客户端的libvirt配置文件中,为URI命名别名以方便记忆。

libvirt使用virConnectOpen函数来建立到Hypervisor的连接,所以virConnectOpen函数就需要一个URI作为参数。而当传递给virConnectOpen的URI为空值(NULL)时,libvirt会依次根据如下3条规则去决定使用哪一个URI。

1)试图使用LIBVIRT_DEFAULT_URI这个环境变量。

2)使用客户端的libvirt配置文件中的uri_default参数的值。

3)依次试图用每个Hypervisor的驱动去建立连接,直到能正常建立连接后即停止尝试。

当然,如果这3条规则都不能够让客户端libvirt建立到Hypervisor的连接,就会报出建立连接失败的错误信息("failed to connect to the hypervisor")。

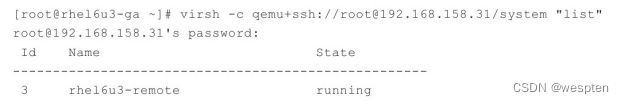

在使用virsh这个libvirt客户端工具时,可以用"-c"或"--connect"选项来指定建立到某个URI的连接。只有连接建立之后,才能够操作。使用virsh连接到本地和远程的Hypervisor的示例如下:

其实,除了针对QEMU、Xen、LXC等真实Hypervisor的驱动之外,libvirt自身还提供了一个名叫"test"的傀儡Hypervisor及其驱动程序。test Hypervisor是在libvirt中仅仅用于测试和命令学习的目的,因为在本地的和远程的Hypervisor都连接不上(或无权限连接)时,test这个Hypervisor却一直都会处于可用状态。使用virsh连接到test Hypervisor的示例操作如下:

6) libvirt API使用示例

经过前面对libvirt的配置、编译、API、建立连接等内容的介绍,相信大家对libvirt已经有了大致的了解。对API进行学习的最好方法就是通过代码来调用API实现几个小功能,主要通过两个示例来分别演示如何调用libvirt的由C语言和Python语言绑定的API。

1. libvirt的C API的使用

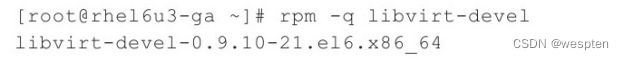

在使用libvirt API之前,必须要在远程或本地的节点上启动libvirtd守护进程。在使用libvirt的客户端前,先安装libvirt-devel软件包来自行编译和安装libvirt。本次示例中安装的是RHEL 6.3自带的libvirt-devel软件包,如下:

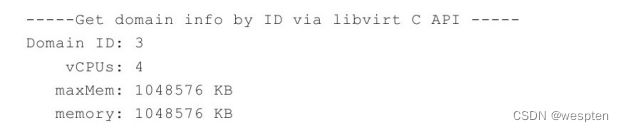

如下一个简单的C程序(文件名为dominfo.c)就是通过调用libvirt的API来查询一些关于某个域的信息。该示例程序比较简单易懂,它仅仅是使用libvirt API的一个演示程序,这里不做过多的介绍。不过,这里有三点需要注意:1)需要在示例代码的开头引入<libvirt/libvirt.h>这个头文件;2)由于只是做查询信息的功能,所以可以使用virConnectOpenReadOnly来建立只读连接;3)这里使用了空值(NULL)作为URI,是让libvirt自动根据默认规则去建立到Hypervisor的连接。这里由于本地已经运行了libvirtd守护进程,并启动了两个QEMU/KVM客户机,所以它默认会建立到QEMU/KVM的连接。

在获得dominfo.c这个示例程序之后,用virsh命令查看当前节点中的情况,再编译和运行这个示例程序去查询一些域的信息,可以将二者得到的一些信息进行对比,可以发现得到的信息是匹配的,命令行操作如下:

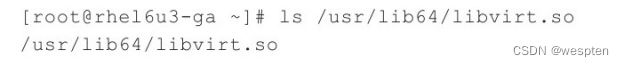

这里需要注意的是,在使用GCC编译dominfo.c这个示例程序时,加上了"-lvirt"这个参数来指定程序链接时的依赖的库文件,如果不指定libvirt相关的共享库,则会发生链接时错误。在本次示例的RHEL 6.3系统中,需要依赖的libvirt共享库文件是/usr/lib64/libvirt.so,如下:

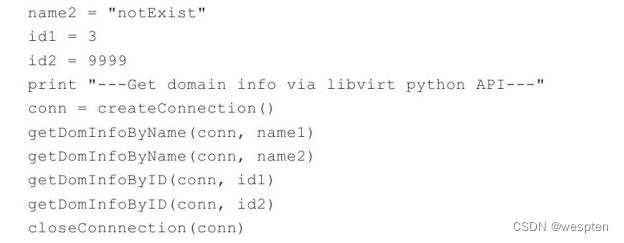

2. libvirt的Python API的使用

前面中已经介绍过,许多种编程语言都提供了libvirt的绑定。Python作为一种在Linux上比较流行的编程语言,它也提供了libvirt API的绑定。在使用Python调用libvirt之前,需要安装libvirt-python软件包来自行编译和安装libvirt及其Python API。

本次示例是基于RHEL 6.3系统自带的libvirt和libvirt-python软件包来进行的,对libvirt-python及Python中的libvirt API文件的查询,命令行如下:

如下是本次示例使用的一个Python小程序(libvirt-test.py),用于通过调用libvirt的Python API来查询域的一些信息。该Python程序示例的源代码如下:

![]()

该示例程序比较简单,只是简单地调用libvirt Python API获取一些信息,这里唯一需要注意的是"import libvirt"语句引入了libvirt.py这个API文件,然后才能够使用libvirt.openReadOnly、conn.lookupByName等libvirt中的方法。在本次示例中,必须被引入的libvirt.py这个API文件的绝对路径是/usr/lib64/python2.6/site-packages/libvirt.py,它实际调用的是/usr/lib64/python2.6/site-packages/libvirtmod.so这个共享库文件。

在获得该示例Python程序后,运行该程序(libvirt-test.py),查看其运行结果,命令行操作如下:

3、virsh

libvirt项目的源代码中就包含了virsh这个虚拟化管理工具的代码。virsh是用于管理虚拟化环境中的客户机和Hypervisor的命令行工具,与virt-manager等工具类似,它也是通过调用libvirt API来实现虚拟化的管理。virsh是完全在命令行文本模式下运行的用户态工具,它是系统管理员通过脚本程序实现虚拟化自动部署和管理的理想工具之一。

virsh是用C语言编写的一个使用libvirt API的虚拟化管理工具。virsh程序的源代码在libvirt项目源代码的tools目录下,实现virsh工具最核心的一个源代码文件是virsh.c,其路径如下:

![]()

在使用virsh命令行进行虚拟化管理操作时,可以使用两个工作模式:交互模式和非交互模式。交互模式,是连接到相应的Hypervisor上,然后输入一个命令得到一个返回结果,直到用户使用"quit"命令退出连接。非交互模式,是直接在命令行中一个建立连接的URI之后添加需要执行的一个或多个命令,执行完成后将命令的输出结果返回到当前终端上,然后自动断开连接。

使用virsh的交互模式,命令行操作示例如下:

使用virsh的非交互模式,命令行操作示例如下:

另外,在某个节点上直接使用"virsh"命令,就默认连接节到本节点的Hypervisor之上,并且进入virsh的命令交互模式。而直接使用"virsh list"命令,就是在连接本节点的Hypervisor之后,使用virsh的非交互模式中执行了"list"命令操作。

1)virsh常用命令

virsh这个命令行工具使用libvirt API实现了很多命令来管理Hypervisor、节点和域,提到过qemu-kvm命令行中的多数参数和QEMU monitor中的多数命令。这里只能说,virsh实现了对QEMU/KVM中的多数而不是全部的功能的调用,这是和开发模式及流程相关的,libvirt中实现的功能和最新的QEMU/KVM中的功能相比有一定的滞后性。一般来说,一个功能都是先在QEMU/KVM代码中实现,然后再修改libvirt的代码来实现的,最后由virsh这样的用户空间工具添加相应的命令接口去调用libvirt来实现。当然,除了QEMU/KVM、libvirt和virsh还实现了对Xen、VMware等其他Hypervisor的支持,如果考虑到这个因素,virsh等工具中有部分功能也可能是QEMU/KVM中本身就没有实现的。

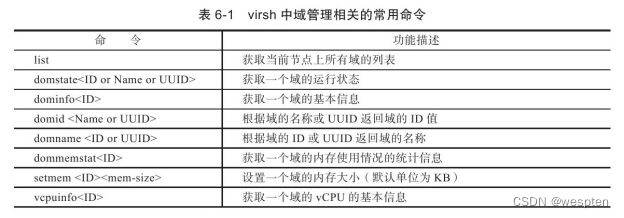

virsh工具有很多的命令和功能,仅针对virsh的一些常见命令进行简单介绍,一些更详细的参考文档可以在Linux系统中通过"man virsh"命令查看帮助文档。这里将virsh常用命令划分为五个类别来分别进行介绍,在介绍virsh命令时,使用的时是RHEL 6.3系统中的libvirt0.9.10版本,假设已经通过交互模式连接到本地或远程的一个Hypervisor的system实例上了(拥有该节点上最高的特权)以对于与域相关的管理,一般都需要使用域的ID、名称或UUID这样的唯一标识来指定是对某个特定的域进行的操作。为了简单起见,在本节中,一般使用"<ID>"来表示一个域的唯一标识(而不专门指定为"<ID or Name or UUID>"这样冗长的形式)。另外,介绍一个输入virsh命令的小技巧:在交互模式中输入命令的交互方式,与在终端中输入Shell命令进行的交互类似,可以使用<Tab>键根据已经输入的部分字符(在virsh支持的范围内)进行联想,从而找到匹配的命令。

1. 域管理的命令

virsh的最重要的功能之一就是实现对域(客户机)的管理,当然其相关的命令也是最多的,而且后面的网络管理、存储管理也都有很多是算对域的管理。

下表列出了域管理中的一小部分常用的virsh命令。

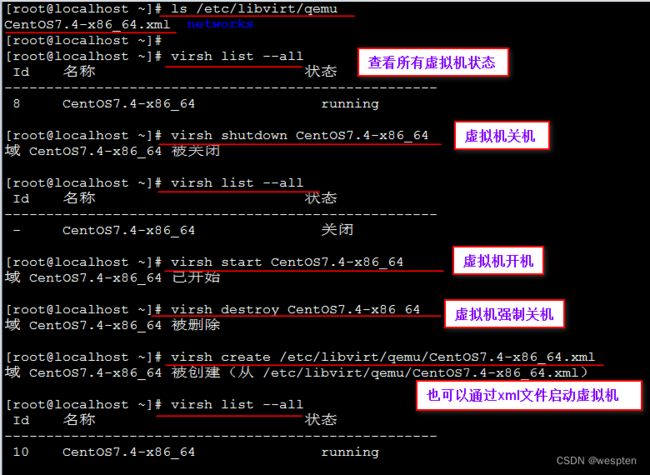

对上面表格中提及域管理的几个命令,在virsh的交互模式中进行操作的示例如下:

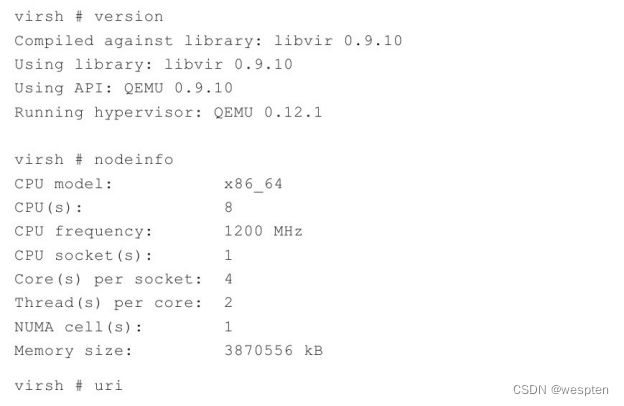

2. 宿主机和Hypervisor的管理命令

一旦建立有特权的连接,virsh也可以对宿主机和Hypervisor进行管理,主要是对宿主机和Hypervisor信息的查询。

下表列出了对宿主机和Hypervisor进行管理的部分常用的virsh命令。

对于宿主机和Hypervisor管理的命令,选择其中的几个,命令行操作示例如下:

3. 网络的管理命令

virsh可以对节点上的网络接口和分配给域的虚拟网络进行管理。

下表列出了网络管理中的一小部分常用的命令。

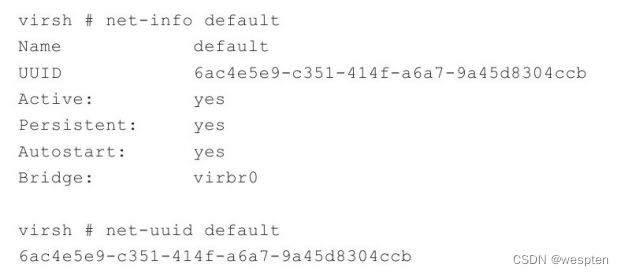

在virsh命令中关于网络管理的几个命令的命令行操作如下:

![]()

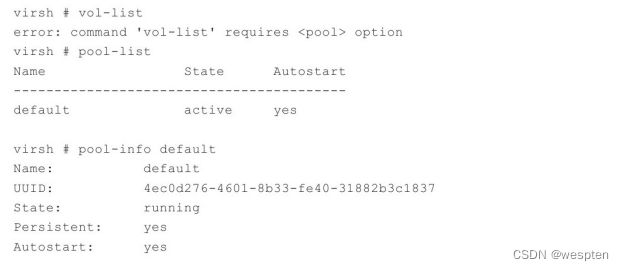

4. 存储池和存储卷的管理命令

virsh也可以对节点上的存储池和存储卷进行管理。

下表列出了对存储池和存储卷管理的部分常用命令。

在virsh中关于存储池和存储卷管理的几个常用命令的命令行操作如下:

5. 其他常用命令

除了对节点、Hypervisor、域、虚拟网络、存储池等的管理之外,virsh还有一些其他的命令。下表列出了部分其他的常用命令。

部分命令的命令行操作如下:

![]()

4、virt-manager

virt-manager是虚拟机管理器(Virtual Machine Manager)这个应用程序的缩写,也是该管理工具的软件包名称。virt-manager是用于管理虚拟机的图形化的桌面用户接口,目前仅支持在Linux或其他类Unix系统中运行。和libvirt、oVirt等类似,virt-manager是由Redhat公司发起的项目,在RHEL 6.x、Fedora、CentOS等Linux发行版中有较广泛的使用,当然在Ubuntu、Debian、OpenSuse等系统中也可以正常使用virt-manager。为了实现快速开发而不太多地降低程序运行性能的需求,virt-manager项目选择使用Python语言开发其应用程序部分,使用GNU AutoTools(包括autoconf、automake等工具)进行项目的构建。virt-manager是一个完全开源的软件,使用Linux界广泛采用的GNU GPL许可证发布。virt-manager依赖的一些程序库主要包括Python(用于应用程序逻辑部分的实现)、GTK+PyGTK(用于UI界面)和libvirt(用于底层的API)。

virt-manager工具在图形界面中实现了一些易用的和比较丰富的虚拟化管理功能,已经为用户提供的功能如下:

1)对虚拟机(即客户机)生命周期的管理,如创建、编辑、启动、暂停、恢复和停止虚拟机,还包括虚拟快照、动态迁移等功能。

2)运行中客户机的实时性能、资源利用率等的监控,统计结果的图形化展示。

3)对创建客户机的图形化的引导,对客户机的资源分配和虚拟硬件的配置和调整等功能也提供了图形化的支持。

4)内置了一个VNC客户端,可以用于连接到客户机的图形界面进行交互。

5)支持本地或远程管理KVM、Xen、QEMU、LXC等Hypervisor上的客户机。

在没有成熟的图形化的管理工具之时,由于需要记忆大量的命令行参数,QEMU/KVM的使用和学习曲线比较陡峭,常常让部分习惯于GUI界面的初学者望而却步。不过现在情况有所改观,已经出现了一些开源的、免费的、易用的图形化管理工具,可以用于KVM虚拟化管理。virt-manager作为KVM虚拟化管理工具中最易用的工具之一,其最新的版本已经提供了比较成熟的功能、易用的界面和不错的性能。对于习惯于图形界面或不需要了解KVM原理和qemu-kvm命令细节,通过virt-manager工具来使用KVM也是一个不错的选择。

1)virt-manager编译和安装

virt-manager的源代码开发仓库是用Linux世界中著名的版本管理工具Git进行管理,使用autoconf、automake等工具进行构建。如果想从源代码编译和安装virt-manager,可以到其官方网站(http://virt-manager.org/download.html)下载最新发布的virt-manager源代码。或者使用Git工具克隆其开发中的代码仓库:git://git.fedorahosted.org/git/virt-manager.git。

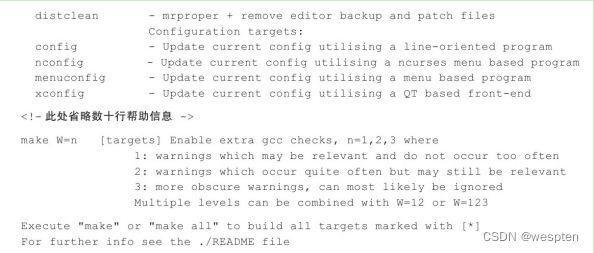

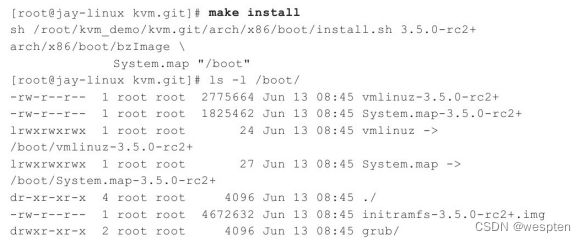

virt-manager源代码的编译,与Linux下众多的开源项目类似,主要运行"./configure"、"make"、"make install"等几个命令分别进行配置、编译和安装即可。

许多流行的Linux发行版(如RHEL、Fedora、Ubuntu等)中都提供了virt-manager软件包供用户自行安装。例如,在RHEL 6.3系统中,使用"yum install virt-manager"命令即可安装virt-manager的RPM软件包了,当然YUM工具也会检查并同时安装它所依赖的一些软件包,包括python、pygtk2、libvirt-python、libxml2-python、python-virtinst等。

2)virt-manager使用

将以RHEL 6.3(英文版)系统中的virt-manager 0.9.0版本为例来简单地介绍它的一些基本用法和技巧。

1. 在RHEL6.3中打开virt-manager

在本节的示例系统中,查看virt-manager的版本,命令行操作如下:

登录到RHEL 6.3的图形用户界面中,用鼠标选择"Applications->System Tools->Virtual Machine Manager"即可打开virt-manager的使用界面。

也可以在桌面系统的终端(terminal)中直接运行"virt-manager"命令来打开virt-manager管理界面,而且使用该命令还可以像virsh那样添加"-c URI"参数来指定启动时连接到本地或远程的Hypervisor,在没有带"-c URI"参数时,默认连接到本地的Hypervisor。对于远程连接,当然需要用户名密码的验证或使用数字证书的验证后才能建立连接,实现远程管理。在图形界面的终端中用命令行启动virt-manager并远程连接到某个Hypervisor,命令行示例如下:

![]()

在RHEL 6.3中启动virt-manager,其管理界面如图6-3所示。在此图中,virt-manager默认连接到了本地的QEMU/KVM上,可以看到有两个客户机(rhel6u3-1、rhel6u3-2),在客户机名称的右边是客户机CPU使用率统计的图形展示。

另外,还可以在本地图形界面终端上通过"ssh-X remoge-host"命令连接到远程主机并开启了ssh中的X11转发,然后可以在本机终端上直接运行"virt-manager"命令来使用远程主机上的virt-manager工具。这种使用方式的命令行操作如下:

![]()

2. 创建一个客户机

在下图所示的virt-manager界面中,选择"File"菜单下方的那个带有“创建一个新的虚拟机”的标识的按钮,即可进入到创建客户机流程的向导之中。

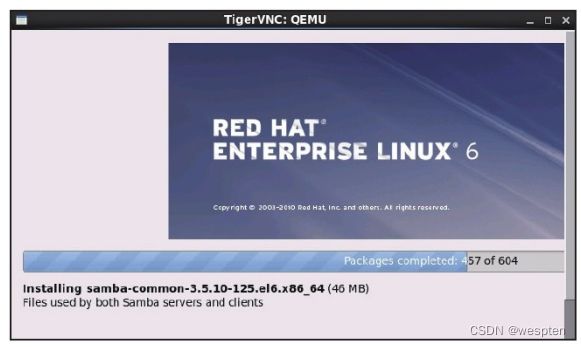

根据virt-manager中的向导指引,可以比较方便地创建一个客户机。主要需要输入或选择一些必要的设置项目,包括:客户机名称、安装介质的选择(如本地的ISO文件)、客户机类型和版本、虚拟CPU个数、内存大小、创建的磁盘镜像文件的空间大小和是否立即分配空间,虚拟网络的配置,等等。在设置了这些必要的步骤之后,最后一步是一个确认的界面,如图6-4所示,点击其中的"Finish"按钮确认即可。确认之后,virt-manager会自动连接到客户机中,客户机系统启动进入到普通的安装流程,这之后的安装过程就和在非虚拟化环境中安装操作系统的过程完全一样了。

点击"Finish"完成配置之后,libvirt和virt-manager工具会默认创建以客户机名称来命令的客户机的XML配置文件和磁盘镜像文件,查看XML配置和镜像文件的命令行如下:

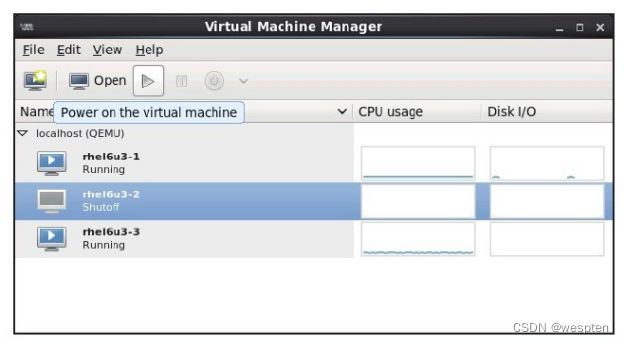

3. 启动、暂停和关闭一个客户机

在virt-manager中,处于关机状态的客户机的状态标识为"Shutoff",如图6-5所示,选中了一个处于关机状态的客户机,然后点击管理界面上方的开机按钮(即图中的三角符号按钮)即可让该客户机开机。双击已经开启的客户机,可以连接到客户机的图形界面的控制台,然后可以登录到客户机中正常使用客户机系统。

除了上面的开机方法之外,还可以双击某个客户机进入到对该客户机的管理窗口中,这里同样有开机的按钮。如果一个客户机处于正常的开机运行状态,那么virt-manager可以选择对其进行暂停和关机等操作。在某个客户机的管理窗口中,如图6-6所示,可以选择"shutdown"选项来关机,也可以选择"Reboot"来重启,选择"Force Off"来强制关机,选择"Save"来保存客户机的当前运行状态。注意,一般尽量避免使用"Force Off"来实施强制关机,因为它可能损坏客户机的磁盘镜像,一般是在客户机完全失去响应而不能正常关机时才采用强制关机的方式。

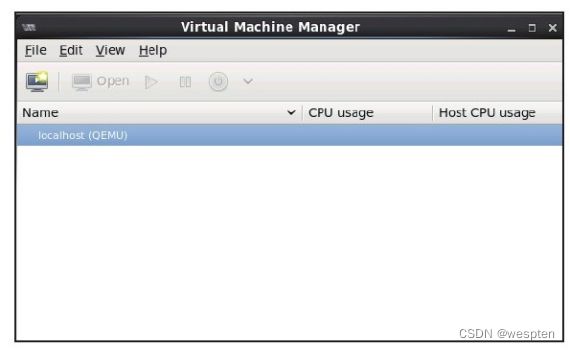

4. 连接到本地和远程的Hypervisor

在一般情况下,启动virt-manager时会默认通过libvirt API试图连接本地的Hypervisor,如果libvirtd守护进程没有在运行,则会有连接失败的错误提示。在重启libvirtd服务之后,需要在virt-manager中重新建立连接,否则连接处于未连接(Not Connected)状态。

在virt-manager系统界面中建立一个到本地或远程主机的连接,可以选择"File"-->"Add Connection"菜单即可。如图6-7所示,选择相应的Hypervisor(QEMU/KVM、Xen、LXC等),选择远程连接方式(SSH、TCP、TLS等),填写好用户名、主机名(或IP地址),然后点击"Connect"按钮,经过密码或证书验证之后,即可建立好到远程主机的连接。

建立了远程连接后,在virt-manager的主界面中可以看到远程主机和本地主机上运行着的客户机,然后可以对其进行相应的管理,如图所示。

5. 查看和修改客户机的详细配置

在virt-manager的主界面中,双击某个客户机标识,可以进入到这个客户机的详细界面,在此处点击virt-manager窗口上工具栏中的提示信息为"Show virtual hardware details"的图标,即可进入到该客户机的虚拟硬件的详细设置界面。如图6-9所示,在客户机硬件详细配置界面中,可以查看也可以修改该客户机的配置参数。

上图中的对客户机详细配置的设置,包括对客户机的名称、描述信息、处理器、内存、启动选项、磁盘、网卡、鼠标、VNC显示、声卡、显卡、串口等许多信息的配置。根据界面上的提示,设置起来还是比较方便的,这里不再详细介绍它们的配置。

需要注意的是,这里的详细设置都会在libvirt管理的该客户机的XML配置文件中表现出来,对运行中的客户机的设置,并不能立即生效,而是在重启客户机后才会生效。

6. 动态迁移

在KVM虚拟环境中,如果遇到宿主机负载过高或需要升级宿主机硬件等需求时,可以选择将部分或全部客户机动态迁移到其他的宿主机上去继续运行。virt-manager也提供了这个功能,而且可以方便使用图形界面的方式进行操作。不过,在做动态迁移之前,一般来说(如对RHEL 6.3系统中的libvirt和virt-manager来说),需要满足如下前提条件才能使动态迁移成功实施。

1)源宿主机和目的宿主机使用共享存储,如NFS、iSCSI、基于光纤通道的LUN、GFS2等,而且它们挂载共享存储到本地的挂载路径需要完全一致,被迁移的客户机就是使用该共享存储上的镜像文件。

2)硬件平台和libvirt软件的版本要尽可能的一致,如果软硬件平台差异较大,可能会增加动态迁移失败的概率。

3)源宿主机和目的宿主机的网络通畅并且打开了对应的端口。

4)源宿主机和目的宿主机必须要有相同的网络配置,否则可能出现动态迁移之后客户机的网络不能正常工作的情况。

5)如果客户机使用了和源宿主机建立桥接的方式获得网络,那么只能在同一个局域网(LAN)中进行迁移,否则客户机在迁移后,其网络将无法正常工作。

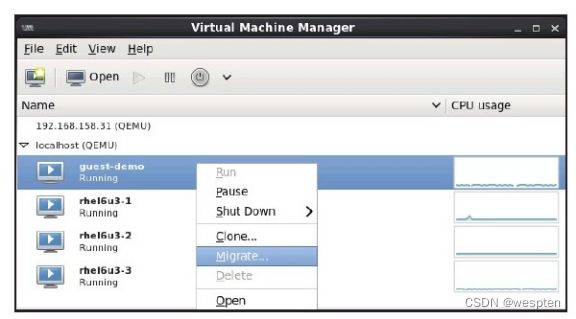

在准备配置环境且满足上面的所有前提条件后,在virt-manager中可以完成动态迁移。源宿主机IP地址为192.168.185.145,目的主机IP地址为192.168.158.31,被动态迁移的客户机名称为"guest-demo",下面介绍动态迁移过程中的关键操作步骤。

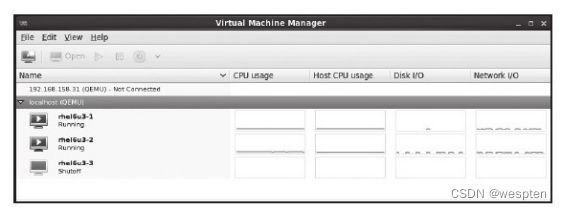

(1)在目的宿主机的virt-manager中查看当前目的宿主机上没有运行任何客户机,如图所示。

(2)在源宿主机的virt-manager管理界面中,选中名为"guest-demo"的客户机,右键单击可以看到"Migrate"选项,如图所示,该选项就实现动态迁移的功能。

选择"Migrate"选项进入到与动态迁移相关的选项设置界面,如图所示,填写目的宿主机的IP或主机名,Max downtime、Port、Bandwith等选项,可以不填写,一般使用默认值即可。

填写好动态迁移的配置信息后,点击"Migrate"按钮即进入到正式的动态迁移过程,这里可能需要输入目的宿主机的root用户的密码,密码验证成功之后,将会出现如图所示的动态迁移的进度图。

(3)待动态迁移的进度完成之后,在目的客户机的virt-manager主界面中可以看到动态迁移过来的"guest-demo"客户机系统,如图所示。如果登录到该客户机系统,该系统是可以正常使用的(包括网络配置),就说明了本示例的动态迁移是成功的。

![]()

7. 性能统计图形界面

virt-manager还提供了对宿主机和客户机的资源使用的监控,如RHEL 6.3中的virt-manager就提供了对宿主机CPU利用率、客户机CPU利用率、客户机的磁盘I/O、客户机的网络I/O等项目的图形化监控。

在virt-manager中,对资源监控频率和保存的采样数量的设置位于主界面的"Edit"→"Preferences"→"Stats"标签中,如图所示。

在"View"→"Graph"中,可以选择哪些被监控的资源是需要显示在界面上的,如图6-16所示。如果发现"Disk I/O"和"Network I/O"两个项目不可选,则需要检查是否开启了对磁盘和网络I/O的轮询。

选中了所有监控图,让其显示在virt-manager中,就可以尽可能多地通过图形化的方式了解客户机和宿主机的资源使用率,如图所示。

5、virt-viewer、virt-install和virt-top

1)virt-viewer

virt-viewer是"Virtual Machine Viewer"(虚拟机查看器)工具的软件包和命令行工具名称,它是一个用于与虚拟化客户机的图形显示的轻量级的交互接口工具。virt-viewer使用GTK-VNC作为它的显示能力,使用libvirt API去查询客户机的VNC服务器端的信息。virt-viewer经常用于去掉传统的VNC客户端查看器,因为后者通常不支持x509认证授权的SSL/TLS加密,而对virt-viewer是支持的。在virt-manager中查看客户机图形界面进行交互之时,其实已经间接地使用过virt-viewer工具了。

在RHEL 6.3系统中查看virt-viewer的RPM包信息,命令行如下:

virt-viewer的使用语法为:

![]()

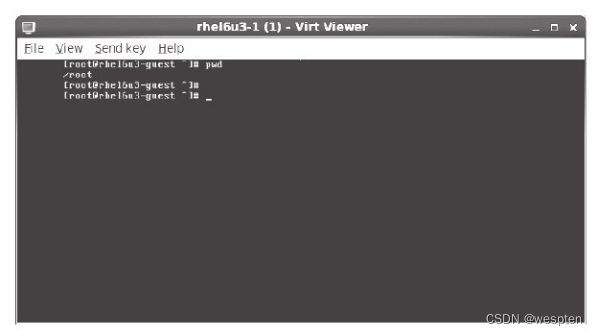

virt-viewer连接到的客户机可以通过客户机的名称、域ID、UUID等表示来唯一指定。virt-viewer还支持"-c URI"或"--connection URI"参数来指定连接到远程宿主机上的一个客户机,当然远程连接需要的一些必要的认证还是必须的。关于virt-viewer工具更多详细的参数和解释,可以通过"man virt-viewer"命令查看使用手册。

在图形界面的一个终端中,用"virt-viewer rhel6u3-1"连接到本地宿主机上名为"rhel6u3-1"的客户机,其显示效果如图所示。

在virt-viewer打开的客户机窗口中(图6-18),其工具栏的"File"菜单下有保存屏幕快照的功能,"View"菜单下有使用全屏和放大(或缩小)屏幕的功能,"Send key"菜单下可以向客户机发送一些特殊的按键(如Ctrl+Alt+Del、Ctrl+Alt+F2等)。

2)virt-install

virt-install是"Virt Install"工具的命令名称,其软件包名为virtinst(或python-virtinst)。virt-install命令行工具为虚拟客户机的安装提供了一个便捷易用的方式,它也是libvirt API来创建KVM、Xen、LXC等上面的客户机,同时,它也为virt-manager的图形界面创建客户机提供了安装系统的API。virt-install工具使用文本模式的串口控制台和VNC(或SDL)图形接口,可以支持基于文本模式和图形界面的客户机安装。virt-install中使用到的安装介质(如光盘、ISO文件)可以存放在本地系统上,也可以存放在远程的NFS、HTTP、FTP服务器上。virt-install支持本地的客户机系统,也可以通过"--connect URI"(或"-c URI")参数来支持在远程宿主机中安装客户机。使用virt-install中的一些选项(--initrd-inject、--extra-args等)和kickstart[4]文件,可以实现无人值守的自动化安装客户机系统。

在RHEL中virt-install工具存在于"python-virtinst" RPM包中,查询的命令行如下:

使用virt-install命令启动一个客户机的安装过程,命令行操作如下:

上面virt-install的命令行参数中,"--connect"用于连接到本地或远程的Hypervisor(无该参数时,默认连接本地Hypervisor);"--disk"用于配置客户机的磁盘镜像文件,其中的path属性表示路径,size属性表示磁盘大小(默认单位为GB);"--cdrom"用于指定用于安装的ISO光盘镜像文件;"--os-type=linux"表示客户机是Linux系统(virt-install会根据这个值自动优化一些安装配置);"--accelerate"表示使用KVM来加速QEMU客户机的安装(一般都添加这个参数);"--graphics vnc"表示使用VNC图形接口来连接到客户机的控制台。关于virt-install工具的更多更详细参数配置可以参考通过"man virt-install"命令查看到相应的帮助文档。

在示例中使用VNC接口连接到客户机,会默认用virt-viewer自动打开客户机的控制台,如图所示。

3) virt-top

virt-top是一个用于展示虚拟化客户机运行状态和资源使用率的工具,它和Linux系统上常用的"top"工具类似,而且它的许多快捷键和命令行参数的设置都与"top"工具的相同。virt-top也是使用libvirt API来获取客户机的运行状态和资源使用情况的,所以也是只要libvirt支持的Hypervisor,就可以用virt-top监控该Hypervisor上的客户机状态。

在RHEL 6.3系统上,virt-top命令就是在名为virt-top的RPM包中用命令行查看:

直接运行"virt-top"命令后,将会显示出当前宿主机上各个客户机的运行情况,如图6-20所示,其中包括宿主机的CPU、内存的总数,也包括各个客户机的运行状态、CPU、内存的使用率。关于virt-top工具的更多更详细参数配置可以参考通过"man virt-top"命令查看到的相应的帮助文档。

五、KVM原理与生命周期

1、虚拟机的基本架构

从虚拟机的基本架构上来区分,虚拟机一般分为两种,我们称之为类型一和类型二。

其中,“类型一”虚拟机是在系统上电之后首先加载运行虚拟机监控程序,而传统的操作系统则是运行在其创建的虚拟机中。类型一的虚拟机监控程序,从某种意义上说,可以视为一个特别为虚拟机而优化裁剪的操作系统内核。因为,虚拟机监控程序作为运行在底层的软件层,必须实现诸如系统的初始化、物理资源的管理等操作系统的职能;它对虚拟机的创建、调度和管理,与操作系统对进程的创建、调度和管理有共通之处。这一类型的虚拟机监控程序一般会提供一个具有一定特权的特殊虚拟机,由这个特殊虚拟机来运行需要提供给用户日常操作和管理使用的操作系统环境。著名的开源虚拟化软件Xen、商业软件VMware ESX/ESXi和微软的Hyper-V就是“类型一”虚拟机的代表。

与“类型一”虚拟机的方式不同,“类型二”虚拟机监控程序,在系统上电之后仍然运行一般意义上的操作系统(也就是俗称的宿主机操作系统),虚拟机监控程序作为特殊的应用程序,可以视作操作系统功能的扩展。对于“类型二”的虚拟机来说,其最大的优势在于可以充分利用现有的操作系统。因为虚拟机监控程序通常不必自己实现物理资源的管理和调度算法,所以实现起来比较简洁。但是,正所谓“成也萧何,败也萧何”,这一类型的虚拟机监控程序既然依赖操作系统来实现管理和调度,就同样也会受到宿主操作系统的一些限制。例如,通常无法仅仅为了虚拟机的优化,而对操作系统作出修改。KVM就是属于“类型二”虚拟机,另外,VMware Workstation、VirtualBox也是属于“类型二”虚拟机。

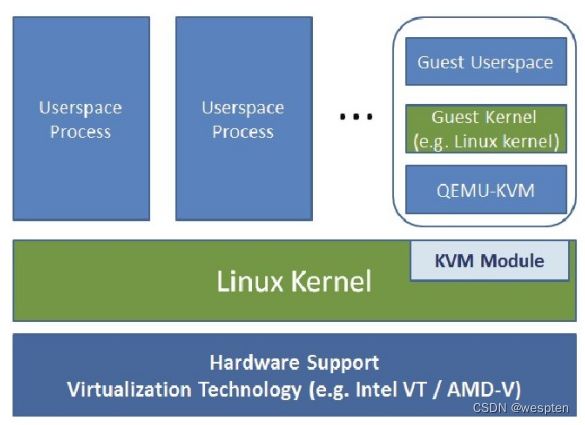

2、KVM的基本架构

KVM是一个基于宿主操作系统的类型二虚拟机。在这里,我们再一次看到了实用至上的Linux设计哲学,既然类型二的虚拟机是最简洁和容易实现的虚拟机监控程序,那么就通过内核模块的形式实现出来就好。其他的部分则尽可能充分利用Linux内核的既有实现,最大限度地重用代码。

KVM是基于虚拟化扩展(Intel VT或AMD-V)的X86硬件,是Linux完全原生的全虚拟化解决方案。部分的准虚拟化支持,主要是通过准虚拟网络驱动程序的形式用于Linux和Windows客户机系统的。KVM目前设计为通过可加载的内核模块,支持广泛的客户机操作系统,比如Linux、BSD、Solaris、Windows、Haiku、ReactOS和AROS Research Operating System。

在KVM架构中,虚拟机实现为常规的Linux进程,由标准Linux调度程序进行调度。事实上,每个虚拟CPU显示为一个常规的Linux进程。这使KVM能够享受Linux内核的所有功能。

需要注意的是,KVM本身不执行任何模拟,需要用户空间程序通过/dev/kvm接口设置一个客户机虚拟服务器的地址空间,向它提供模拟的I/O,并将它的视频显示映射回宿主的显示屏。目前这个应用程序就是大名鼎鼎的QEMU。

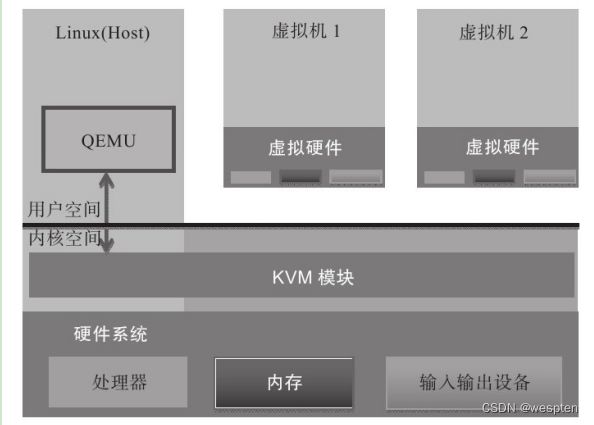

KVM的基本架构:

左侧部分是一个标准的Linux操作系统,可以是RHEL、Fedora、Ubuntu等。KVM内核模块在运行时按需加载进入内核空间运行。KVM本身不执行任何设备模拟,需要用户空间程序QEMU通过/dev/kvm接口设置一个虚拟客户机的地址空间,向它提供模拟的I/O设备,并将它的视频显示映射回宿主机的显示屏。

3、KVM模块

KVM模块是KVM虚拟机的核心部分。其主要功能是初始化CPU硬件,打开虚拟化模式,然后将虚拟客户机运行在虚拟机模式下,并对虚拟客户机的运行提供一定的支持。

为了软件的简洁和性能,KVM仅支持硬件虚拟化。自然而然,打开并初始化系统硬件以支持虚拟机的运行,是KVM模块的职责所在。以KVM在Intel公司的CPU上运行为例,在被内核加载的时候,KVM模块会先初始化内部的数据结构;做好准备之后,KVM模块检测系统当前的CPU,然后打开CPU控制寄存器CR4中的虚拟化模式开关,并通过执行VMXON指令将宿主操作系统(包括KVM模块本身)置于虚拟化模式中的根模式;最后,KVM模块创建特殊设备文件/dev/kvm并等待来自用户空间的命令。接下来虚拟机的创建和运行将是一个用户空间的应用程序(QEMU)和KVM模块相互配合的过程。

KVM模块与用户空间QEMU的通信接口主要是一系列针对特殊设备文件的IOCTL调用。

如上所述,KVM模块加载之初,只存在/dev/kvm文件,而针对该文件的最重要的IOCTL调用就是“创建虚拟机”。在这里,“创建虚拟机”可以理解成KVM为了某个特定的虚拟客户机(用户空间程序创建并初始化)创建对应的内核数据结构。同时,KVM还会返回一个文件句柄来代表所创建的虚拟机。针对该文件句柄的IOCTL调用可以对虚拟机做相应的管理,比如创建用户空间虚拟地址和客户机物理地址及真实内存物理地址的映射关系,再比如创建多个可供运行的虚拟处理器(vCPU)。同样,KVM模块会为每一个创建出来的虚拟处理器生成对应的文件句柄,对虚拟处理器相应的文件句柄进行相应的IOCTL调用,就可以对虚拟处理器进行管理。

针对虚拟处理器的最重要的IOCTL调用就是“执行虚拟处理器”。通过它,用户空间准备好的虚拟机在KVM模块的支持下,被置于虚拟化模式中的非根模式下,开始执行二进制指令。在非根模式下,所有敏感的二进制指令都会被处理器捕捉到,处理器在保存现场之后自动切换到根模式,由KVM决定如何进一步处理(要么由KVM模块直接处理,要么返回用户空间交由用户空间程序处理)。

除了处理器的虚拟化,内存虚拟化也是由KVM模块实现的。

实际上,内存虚拟化往往是一个虚拟机实现中代码量最大、实现最复杂的部分(至少,在硬件支持二维地址翻译之前是这样的)。众所周知,处理器中的内存管理单元(MMU)是通过页表的形式将程序运行的虚拟地址转换成为物理内存地址。在虚拟机模式下,内存管理单元的页表则必须在一次查询的时候完成两次地址转换。这是因为,除了要将客户机程序的虚拟地址转换成为客户机物理地址以外,还必须将客户机物理地址转换成为真实物理地址。KVM模块开始使用了影子页表的技术来解决这个问题:在客户机运行时候,处理器真正使用的页表并不是客户机操作系统维护的页表,而是KVM模块根据这个页表维护的另外一套影子页表。

影子页表实现复杂,而且有时候开销很大。为了解决这个问题,新的处理器在硬件上做了增强(Intel的EPT技术)。通过引入第二级页表来描述客户机虚拟地址和真实物理地址的转换,硬件可以自动进行两级转换生成正确的内存访问地址。KVM模块将其称为二维分页机制。

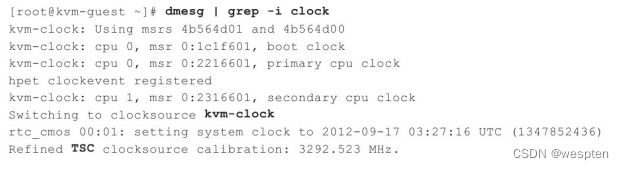

处理器对设备的访问主要是通过IO指令和MMIO,其中IO指令会被处理器直接截获,MMIO会通过配置内存虚拟化来捕捉。但是,外设的模拟一般并不由KVM模块负责。一般来说,只有对性能要求比较高的虚拟设备才会由KVM内核模块来直接负责,比如虚拟中断控制器和虚拟时钟,这样可以大量减少处理器的模式切换的开销。大部分的输入输出设备还是会交给用户态程序QEMU来负责。

4、KVM的功能特性

(1)内存管理

KVM从Linux继承了强大的内存管理功能。一个虚拟机的内存与任何其他Linux进程的内存一样进行存储,可以以大页面的形式进行交换以实现更高的性能,也可以以磁盘文件的形式进行共享。NUMA支持(非一致性内存访问,针对多处理器的内存设计)允许虚拟机有效地访问大量内存。

KVM支持最新的基于硬件的内存虚拟化功能,支持Intel的扩展页表(EPT)和AMD的嵌套页表(NPT,也叫“快速虚拟化索引-RVI”),以实现更低的CPU利用率和更高的吞吐量。

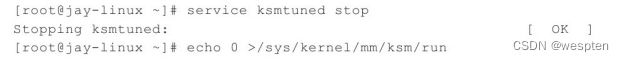

内存页面共享通过一项名为内核同页合并(Kernel Same-page Merging,KSM)的内核功能来支持。KSM扫描每个虚拟机的内存,如果虚拟机拥有相同的内存页面,KSM将这些页面合并到一个在虚拟机之间共享的页面,仅存储一个副本。如果一个客户机尝试更改这个共享页面,它将得到自己的专用副本。

(2)存储

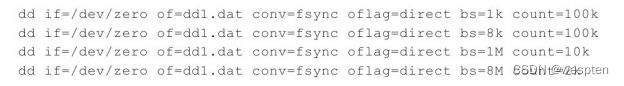

KVM能够使用Linux支持的任何存储来存储虚拟机镜像,包括具有IDE、SCSI和SATA的本地磁盘,网络附加存储(NAS)(包括NFS和SAMBA/CIFS),或者支持iSCSI和光纤通道的SAN。多路径I/O可用于改进存储吞吐量和提供冗余。由于KVM是Linux内核的一部分,它可以利用所有领先存储供应商都支持的一种成熟且可靠的存储基础架构,它的存储堆栈在生产部署方面具有良好的记录。

KVM还支持全局文件系统(GFS2)等共享文件系统上的虚拟机镜像,以允许虚拟机镜像在多个宿主之间共享或使用逻辑卷共享。磁盘镜像支持按需分配,仅在虚拟机需要时分配存储空间,而不是提前分配整个存储空间,提高存储利用率。KVM的原生磁盘格式为QCOW2,它支持快照,允许多级快照、压缩和加密。

(3)设备驱动程序

KVM支持混合虚拟化,其中准虚拟化的驱动程序安装在客户机操作系统中,允许虚拟机使用优化的I/O接口而不使用模拟的设备,从而为网络和块设备提供高性能的I/O。KVM准虚拟化的驱动程序使用IBM和Red Hat联合Linux社区开发的VirtIO标准,它是一个与虚拟机管理程序独立的、构建设备驱动程序的接口,允许为多个虚拟机管理程序使用一组相同的设备驱动程序,能够实现更出色的虚拟机交互性。

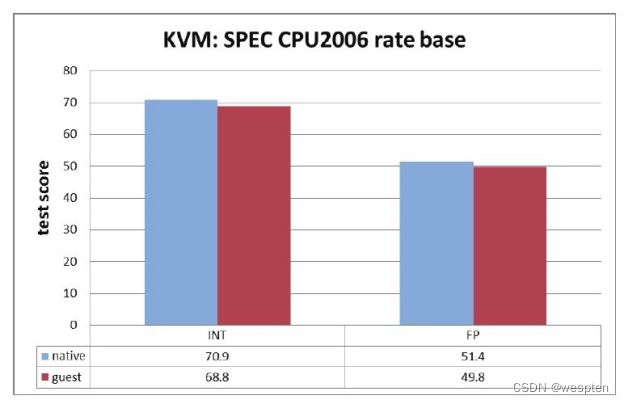

(4)性能和可伸缩性

KVM也继承了Linux的性能和可伸缩性。KVM虚拟化性能在很多方面(如计算能力、网络带宽等)已经可以达到非虚拟化原生环境的95%以上的性能。KVM的扩展性也非常良好,客户机和宿主机都可以支持非常多的CPU数量和非常大量的内存。例如,Redhat官方文档[5]就介绍过,RHEL 6.x系统中的一个KVM客户机可以支持160个虚拟CPU和多达2TB的内存,KVM宿主机支持4096个CPU核心和多达64TB的内存。

5、KVM生命周期

一个 libvirt Domain 是一个运行在虚拟机器上的操作系统的实例,它可以指一个运行着的虚拟机,或者用于启动虚拟机的配置。

还有一些生命周期术语:

| 术语 |

解释 |

| Domain (域) |

一个运行在被虚拟化的机器上的,由 hypervisor 提供的操作系统实例 |

| Hypervisor (虚机管理程序) |

一个虚拟化一个物理服务器为多个虚拟机的软件层。 |

| Node (节点) |

一个物理服务器。它可能有多种类型,比如存储节点,集群节点和数据库节点等。 |

| Storage Pool (存储池) |

一个存储介质的集合,比如物理硬盘驱动器的集合。一个存储池被细分为卷,卷会被分配给一个或者多个域。 |

| Volume (卷) |

一个从存储池中分配出来的存储空间。一个卷可能会分配给一个或者多个域使用,并且往往被用作域内的虚拟硬盘驱动器。 |

Domain的两种形式

过渡性 Guest Domain VS 持久性 Guest Domain

Libivrt 区分两种不同类型的 domain:短暂性的(transient )和持久性的(persistent)。

短暂性 domain: 只在 domain 被关机( shutdown) 或者所在的主机(host)被重启(restart)之前存在。

持久性 domain: 会一直存在,直到被删除。

无论它是什么类型,当一个 domain 被创建后,它的状态可以被保存进一个文件。之后,只要该文件存在,这个 domain 的状态就可以从无限次从该文件中被恢复( restored)。因此,即使是一个短暂性的domain,它也可以被反复地恢复。

创建短暂性的 domain 与创建持久性 domain 有一点不同。对持久性domain来说,它必须在其启动前定义(define)好, 预备了domain的部件和相关配置。而短暂性虚机可以被一次性被创建和启动。操作两种类型的domain的命令也有些区别。

Domain 有什么状态?

一个 Guest domain 可能处于的状态:

Undified (未定义的):这是起始状态。这时 libvirt 不会知道 domain 的任何信息,因为这时候 domain尚未被定义或者创建。

Defined (定义了的)/ Stopped (停止的):domain 已经被定义,但是不在运行(running)。只有持久性 domains 才能处于该状态。当一个短暂性 domain 被停止或者关机时,它就不存在了。

Running (运行中的):domain 被创建而且启动了,无论是短暂性domain还是持久性domain。任何处于该状态的 domain 都已经在主机的 hypervisor 中被执行了。

Paused (中止了的):Hypervisor 上对该 domain 的运行被挂起(suspended)了。它的状态被临时保存(比如到内存中),直到它被继续(resumed)。domain 本身不知道它处于是否被中止状态。

Saved (保存了的):类似中止(Paused) 状态,除了domain 的状态被保存在持久性存储比如硬盘上。处于该状态上的 domain 可以被恢复 (restored)。

下图描述了 domain 的状态机:

方框表示状态,箭头表示使得状态变更的命令。

从改图中可以看出,对持久性 domain,shtudown 命令可以将其从运行(running) 状态变为定义(defined)状态;对短暂性 domain 而言,它会从运行(running) 状态变为变为未定义(undefined) 状态。

中还有一些被隐藏的状态:

Idle:等待 I/O,或是因为没有工作需要进行休眠中

Crashed:可能因为 QEMU process 被强制删除 or core dump 所造成了VM损坏

in shutdown: 顾名思义就是在shutdown过程中

Dying:在shutdown的过程中失败所产生的状态

Pmsuspended:透过guest OS中的电源管理功能进行suspend后进入的状态

只要是进程而言就会具备运行、重启、停止等基本生命周期, 虚拟机进程生命周期的特殊性在于还会有cpu、内存、磁盘的添加和移除以及快照、克隆等操作等。以上所提到的所有操作都需要使用libvirtd包中所包含的 `virsh` 指令:

#> 启动短暂化domain, 使用指定的XML建立VM,並启动VM

$ virsh create VMACHINE_NAME

#> 关机指令,停止一个运行中的domain

$ virsh shutdown

#> 粗野的关机(inelegant shutdown),等同于直接拔电源

$ virsh destroy

#> 开机指令,启动持久化domain

$ virsh start

#> 重启一个持久性的domain指令。注意:重启一个暂时性的domain是不可能的,因为当它被关闭 (shutdown)后它就变成了 undefined 状态。

$ virsh reboot

#> 中止(Pause)/恢复(unpause/resume)domain,使用suspend命令来中止一个domain

$ virsh suspend

#> 使用resume命令来继续一个domain:

$ virsh resume

#> 删除一个domain,使用virsh的undefine命令来删除一个domain

$ virsh undefine

#> 重置电源状态

$ virsh reset

#> 持续化保存domain状态,將VM状态存储到文档中,并关闭VM

$ virsh save

#> 从指定文档中将VM状态恢复到运行中

$ virsh restore

#> 连接指令

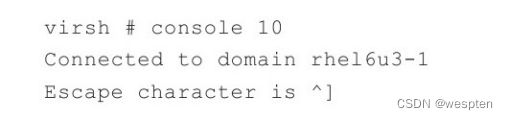

$ virsh console VMACHINE_NAME

Connected to domain VMACHINE_NAME

Escape character is ^]

CentOS Linux 7 (Core)

Kernel 3.10.0-514.el7.x86_64 on an x86_64

localhost login: root

Password:

Last login: Wed Jun 14 17:06:02 on ttyS0

[root@VMACHINE_NAME ~]#

##> [ERROR CHECK]如果console连接卡住不动, 则通过vnc进入到对应的虚拟机中在以下文件中添加内容

$ cat /etc/securetty | tail -n 1

ttyS0

$ [root@ungeolinux ~]# cat /etc/grub2.cfg | grep ttyS0

linux16 /vmlinuz-3.10.0-1160.el7.x86_64 root=/dev/mapper/centos-root ro rd.lvm.lv=centos/root rd.lvm.lv=centos/swap rhgb quiet console=ttyS0 演示:

通过备份恢复删除的虚拟机:

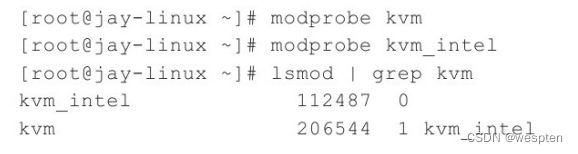

六、KVM安装与虚拟机创建

1、硬件系统的配置

我们知道,KVM从诞生伊始就是需要硬件虚拟化扩展的支持,所以这里需要特别讲解一下硬件系统的配置。

KVM最初始的开发是基于x86和x86-64处理器架构上的Linux系统进行的,目前,KVM被移植到多种不同处理器架构之上,包括:Intel和HP的IA64(安腾)架构、AIM联盟(Apple-IBM-Motorola)的PowerPC架构、IBM的S/390架构、ARM架构(2012年开始[1])。其中,在X86-64上面的功能支持最完善(主要原因是Intel/AMD的x86-64架构在桌面和服务器市场上的主导地位及其架构的开放性,以及它的开发者众多),我们也采用基于Intel x86-64架构的处理器作为基本的硬件环境。

在x86-64架构的处理器中,KVM必需的硬件虚拟化扩展分别为:Intel的虚拟化技术(Intel VT)和AMD的AMD-V技术。其中,Intel在2005年11月发布的奔腾四处理器(型号:662和672)第一次正式支持VT技术(Virtualization Technology),之后不久的2006年5月AMD也发布了支持AMD-V的处理器。现在比较流行的针对服务器和桌面的Intel处理器多数都是支持VT技术的,着重讲述英特尔的VT技术相关的硬件设置。

首先处理器(CPU)要在硬件上支持VT技术,还要在BIOS中将其功能打开,KVM才能使用到。目前,多数流行的服务器和部分桌面处理器的BIOS都默认将VT打开了。

一般在BIOS中,VT的选项通过"Advanced→Processor Configuration"来查看和设置,它的标识通常为"Intel(R)Virtualization Technology"或"Intel VT"等类似的文字说明。

除了支持必需的处理器虚拟化扩展以外,如果服务器芯片还支持VT-d,就建议在BIOS中将其打开,因为后面一些相对高级的设备的直接分配功能会需要硬件VT-d技术的支持。VT-d(Virtualization Technology for Directed I/O)是对设备I/O的虚拟化硬件支持,在BIOS中的位置可能为"Advanced→Processor Configuration"或"Advanced→System Agent(SA)Configuration",它一般在BIOS中的标志一般为"Intel(R)VTfor Directed I/O"或"Intel VT-d"等。

下面以一台Intel Romley-EP平台的服务器为例来说明在BIOS中的设置。

1)BIOS中的Advanced选项,如图所示:

2)BIOS中的VT和VT-d选项,如图所示:

对于不同平台或不同厂商的BIOS,VT和VT-d等设置的位置可能是不一样的,需要根据实际的硬件情况和BIOS中的选项来灵活设置。

设置好了VT和VT-d的相关选项,保存BIOS的设置并退出,系统重启后生效。在Linux系统中,可以通过检查/proc/cpuinfo文件中的CPU特性标志(flags)来查看CPU目前是否支持硬件虚拟化。在x86和x86-64平台中,Intel系列CPU支持虚拟化的标志为"vmx",AMD系列CPU的标志为"svm"。

可以用如下命令行查看"vmx"或者"svm"标志:

2、安装宿主机Linux系统

KVM是基于内核的虚拟化技术,要运行KVM虚拟化环境,安装一个Linux操作系统的宿主机(Host)是必需的。由于Redhat公司是目前对KVM项目投入最多的企业之一,从RHEL6开始,其系统自带的虚拟化方案就采用了KVM,而且RHEL(Red Hat Enterprise Linux)也是最流行的企业级Linux发行版之一,所以选用RHEL来讲解Linux系统的安装步骤和过程,并且后面的编译和运行都是在这个系统上进行的。

当然,KVM作为流行的开源虚拟机之一,它可以在绝大多数流行的Linux系统上编译和运行,所以依然可以选择RHEL之外的其他Linux发行版,CentOS、Fedora、Ubuntu、Debian、OpenSuse等系统都是不错的选择。

基于RHEL6.3 Server版的系统来简单介绍,普通Linux安装的基本过程这里就不再详细描述,这里主要说明安装过程中一些值得注意的地方。

在选择哪种类型的服务器时,选择"Software Development Workstation"即可(如下图所示),然后选中当前页面的"Customize now",单击"Next"按钮进入下一步去选择具体需要安装的组件并设置所需要的各个RPM包。

在选择了"Software Development Workstation"之后,在选择具体组件的界面就可以看到默认已经选择了很多的组件(如图3-4所示),这里主要需要检查一下Development这个选项中默认已经勾选了的很多的开发组件。其中,最好选中Development选项中的Development tools和Additional Development这两个组件,KVM编译过程中以及其他实验中可能会用到,其中包括一些比较重要的软件包,比如:gcc、git、make等(一般被默认选中)。另外可以单击下方的"Optional packages"按钮根据需要选择一些可选的软件包。

在下图的Virtualization选项中,我们可以先不选中其中的任何组件,因为是在自己编译KVM和qemu-kvm。发行版中的KVM时,一般会安装Virtualization组件并使用发行版中自带的KVM Virtualization功能。

Software Development Workstation默认选择的具体组件 :

然后,继续进行后面安装流程,可以安装相应的软件包,安装过程的一个快照如图:

在安装完所有软件包后,系统会提示安装完成需要重启系统,重启后即可进入到RHEL 6.3系统中。至此,Linux系统就安装完毕了,这就是在将来作为宿主机(Host)的操作系统,后面的编译和实验都是在这个宿主机上进行的。

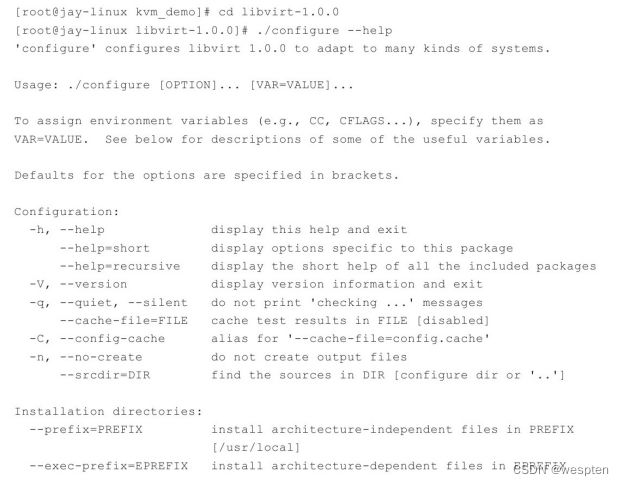

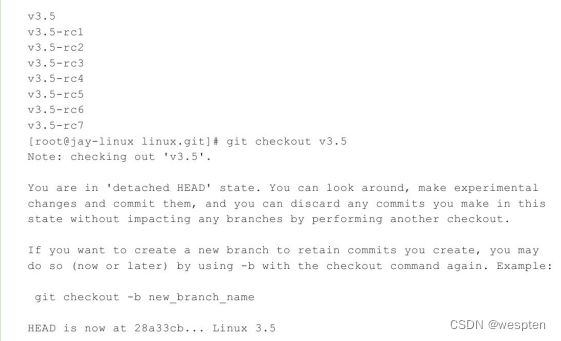

3、下载KVM源代码

KVM作为Linux kernel中的一个module而存在,是从Linux2.6.20版本开始被完全正式加入到内核的主干开发和正式发布代码中。所以,只需要下载2.6.20版本之后Linux kernel代码即可编译和使用KVM。当然,如果是学习KVM,推荐使用最新正式发布或者正在开发中的kernel版本,如果是实际部署到生产环境中,还需要自己选择适合的稳定版本进行详尽的功能和性能测试。如果你想使用最新的处于开发中的KVM代码,你需要自己下载KVM的代码仓库,以此为例来讲解的。

总的来说,下载最新KVM源代码,主要有如下三种方式:

1. 下载KVM项目开发中的代码仓库kvm.git;

2. 下载Linux内核的代码仓库linux.git;

3. 打包下载Linux内核的源代码(Tarball格式);

(1)下载kvm.git

KVM项目的代码是托管在Linux内核官方源码网站http://git.kernel.org上的,可以到上面去查看和下载。该网页上virt/kvm/kvm.git即是KVM项目的代码,它是最新的功能最丰富的KVM源代码库(尽管并非最稳定的)。目前,kvm.git的最主要维护者(maintainer)是来自Redhat公司的Gleb Natapov和PaoloBonzini。从http://git.kernel.org/?p=virt/kvm/kvm.git网页可以看到,kvm.git下载链接有如下3个URL,可用于下载最新的KVM的开发代码仓库。

![]()

从这3个URL下载的内容完全一致,根据自己实际情况选择其中任一个下载即可。Linux内核相关的项目一般都使用Git[4]作为源代码管理工具,KVM当然也是用Git管理源码的。可以使用git clone命令来下载KVM的源代码,也可以使用Git工具的其他命令对源码进行各种管理,这里不详述Git的各种命令。

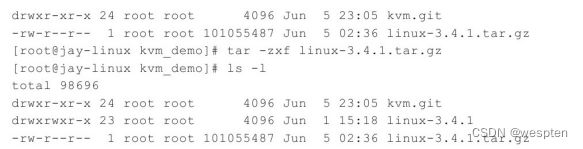

kvm.git的下载方式和过程,为如下命令行所示:

(2)下载linux.git