UDA/语义分割:Feature Re-Representation and Reliable Pseudo Label Retraining for Cross-Domain Semantic

Feature Re-Representation and Reliable Pseudo Label Retraining for Cross-Domain Semantic Segmentation 跨域语义分割的特征重表示与可靠伪标签重训练

- 0.摘要

- 1.概述

- 2.相关工作

-

- 2.1.语义分割

- 2.2.基于领域自适应的语义分割

- 3.方法

-

- 3.1.特征重表示对齐

-

- 3.1.1.特征重表示(Feature Re-Representation)

- 3.1.2.UDA中源域基下的特征重表示对齐(Feature Re-Representation Alignment Under Source Domain Bases for UDA)

- 3.2.可靠的伪标签再培训

-

- 3.2.1.伪标签再训练(Pseudo Label Retraining)

- 3.2.2.可靠的伪标签选择

- 4.实验

-

- 4.1.数据集

- 4.2.实现细节

-

- 4.2.1.架构细节

- 4.2.2.训练策略

- 4.2.3.图像翻译的策略

- 4.2.4.可靠的伪标签再训练

- 4.3.和先进方法的比较

- 4.4.消融实验

-

- 4.4.1.框架消融研究

- 4.4.2.FRA的组成部分

- 4.4.3.FRA中的bases可视化

- 4.4.4.FRA中的bases更新

- 4.4.5.bases中的#在FRA中的作用

- 4.4.6.α在FRA中的作用

- 4.4.7.β在FRA指数移动平均中的影响

- 4.4.8.与其他对抗性比对方法的比较。

- 4.4.9.RPLR与PLR

- 4.4.10.RPLR中多视图数据的性能提高

- 4.4.11.RPLR与Π-Model、Mean Teachers比较

- 4.4.12.计算效率

- 5.总结

- 参考文献

0.摘要

提出了一种新的无监督领域自适应语义分割方法。我们认为,目标域数据的良好表示应该同时保留源域的知识和目标域的特定信息。为了从源域获取知识,我们首先学习一组基来描述源域的特征分布,然后将源域和目标域的特征重新表示为源基的加权和。此外,还引入了一个鉴别器,使得两个域特征在相同基下的重表示责任无法区分。这样,源重表示和目标重表示之间的域间隙被最小化,重表示的目标域特征包含源域信息。然后,我们将特征重表示与原始的特定领域特征相结合,进行后续的像素级分类。为了进一步使重新表示的目标特征具有语义意义,提出了一种可靠的伪标签再训练(RPLR)策略,该策略利用多视点源图像训练网络的预测一致性,在未标记的目标图像上选择干净的伪标签进行重新训练。大量的实验证明了我们的方法在语义分割基准上的无监督领域自适应的竞争性能。

1.概述

卷积神经网络(CNN)[1]、[2]、[3]在语义分割方面已经取得了巨大的成功,但由于需要大量的标记数据,在新的场景中进行注释既耗时又昂贵。为了解决这个问题,提出了无监督域自适应(UDA)方法,利用源域的标记数据来训练一个能很好地推广到未标记目标域的模型。本文主要研究基于UDA的语义分割。

最近用于语义分割的UDA方法包括输入级[5]、[6](即图像翻译[7])、特征级[8]、[9]和输出级[10]、[11]的对抗对齐方法,以及包括伪标签重新训练[6]、[12]、[13]、熵最小化[14]和均值教师[15]、[16]在内的自训练方法。对抗性对齐方法过度强制网络提取领域不变的输出,但减少了特定领域的变化,这可能会扭曲原始特征分布并导致负迁移[17]。

为了使重新表示的目标特征在语义上更有意义,我们将伪标签重新训练策略集成到我们的框架中。以前的伪标签再训练方法[6]、[12]、[13]将网络对具有高softmax概率的未标记图像的预测视为地面真值标签(即伪标签)的近似值。然而,已知softmax概率的排名不可靠[23]、[24]、[25]、[26]。换句话说,较高的softmax概率不一定会带来正确的伪标签。为了使伪标签更加可靠,我们提出了可靠的伪标签再训练(RPLR)策略来选择伪标签。Cycle GAN[5]、[7]翻译的源图像在纹理、光照和外观上与目标图像相似,但由于图像翻译不理想而存在伪影,而原始源图像干净,但视觉间隙较大。因此,可以将这些图像视为同一场景的不同视图。利用不同源图像训练的两个网络的预测一致性作为可靠性,选择伪标签进行再训练。本文的贡献可以总结如下。i) 我们提出了一种新的框架,该框架利用特征重表示对齐(FRA)来借用源域的信息,并将其与目标域特定的特征结合起来进行语义分割。通过在公共源域基下的重新表示,可以最小化域间隙。提出了一种对抗性的规则化方法,对每个基元的重表示责任进行规范化,以进一步协调特征重表示。ii)在我们的框架中进一步引入了可靠的伪标签再训练(RPLR)策略,以提高基于UDA的语义切分的性能。iii)大量实验验证了我们基于UDA的语义分割方法的有效性。

2.相关工作

2.1.语义分割

近年来的语义分割网络是基于全卷积网络[1]的。语义分词的一个关键问题是接收域的限制。以前的方法通过atrous卷积[3],[27],[28],[29],金字塔池[2]和大内核[30],[31]来解决这个问题。目前流行的方法[32]、[33]、[34]、[35]利用注意机制[36]、[37]来捕获远程依赖。特别地,EMANet[35]使用期望最大化算法[38]来寻找每个图像内的特征重新表示基,作为对长距离依赖的关注。与[35]不同,我们通过EM处理UDA。[35]在推理阶段通过对多个步骤的交替更新在单个图像中查找基。我们的方法旨在保留来自整个源数据集的一组基来重新表示目标特征,因此在推断过程中不需要对单个图像中的多个步骤进行替换更新,减少了计算成本和推断时间

2.2.基于领域自适应的语义分割

近年来UDA语义分割方法主要分为对抗比对和自训练两大类。对抗性UDA语义分割方法包括三个层次的对齐:输入级对齐、特征级对齐和输出级对齐,它们在网络的不同层次上附加鉴别器以最小化域间隙。输入级比对[5],[6],[16],[39],[40],[41],[42]将源图像转换为目标图像,然后将其作为输入训练分割网络。Outputlevel对齐对网络的输出进行对齐,可以是分割预测[10],分割预测划分的patch[43],分割预测的熵图[14],[44]或以聚类像素为ground-truth的patch预测[11]。特性级对齐[8],[45],[46],[47],[48]最小化中间特性分布差距。自训练方法包括伪标签再训练[6],[12],[13],[42],[44],[48],[49],[50],熵最小化[14],[51]和mean teacher[15],[16]。伪标签再训练依赖于对未标记数据预测的softmax概率选择干净的伪标签,并使用它们进行再训练,导致目标域中类之间的分离。熵最小化是将未标记图像上的熵最小化,使目标预测类似于源图像上的低熵预测。对于未标记的图像,Mean Teacher由时间集成教师对网络进行监督。

3.方法

图1所示。Feature Re-representation Alignment (FRA)与ResNet101骨干的示意图。在FRA中,我们首先减少从网络骨干中提取的特征的通道。我们从源信道缩减特征中学习一组基,然后结合这些基重新表示源特征和目标特征。在每个碱基对重新表示所承担的责任上添加一个鉴别器,以使重新表示反向对齐。然后将重新表示的特征与原始特征一起添加,以进行最终的像素级分类。

在输入源图像IS带有语义标签YS和未标记目标图像IT没有标注的情况下,UDA的目标是通过使用IS和YS以及IT训练的模型来提高目标数据集的泛化性能。我们的UDA处理框架包括两个部分:i) Feature Re-representation对齐(FRA),获取特征Re-representation以最小化领域间隙,并将其作为来自源领域的知识与原始领域特定特征相结合。ii)可靠伪标签再训练(Reliable Pseudo Label Retraining, RPLR),选择可靠的伪标签进行再训练,使重新表示的目标特征更具有语义意义,如图2所示。

3.1.特征重表示对齐

如图1所示,我们学习了一组源base,然后在公共源base下重新表示来自两个域的特性。由于两个域的重新表示特征由一组共同的base组成,因此它们之间的差距相对于原始表示是最小的。与强制网络提取域不变输出并可能导致负传输[17]的对抗比对方法不同,FRA中的重表示避免了原始特征分布的失真;因此,保留了原始的特定于领域的特性。为了进一步对齐特征的重新表示,一个鉴别器被应用于每个基对重新表示的responsibilities作为对抗性正则化。因此,特征重新表示和原始特征的结合不仅提供了源领域的知识,而且提供了特定领域的信息。在FRA中,我们首先在分类器前对特征进行1 × 1的卷积,将信道数减少到512,以降低计算成本。然后,特征被源域基重新表示,然后通过其他1 × 1卷积来增加通道。特征重新表示最终被添加到原始特征中,作为后续像素级分类的快捷连接

3.1.1.特征重表示(Feature Re-Representation)

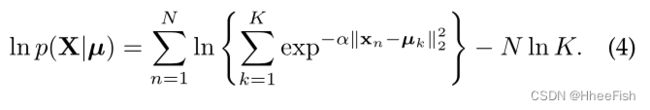

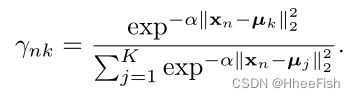

我们首先介绍一个简化的高斯混合模型[22]的特征再表示的一般形式。简化后的高斯混合模型采用期望最大化算法[38]进行优化。我们将观察到的特征表示为X,base表示为µ。在给定第k个base µk的情况下,第n个数据点xn的特征的后验概率为

α是一个预先定义的常数。因此,我们假设不同分布的混合系数相等:

我们可以很容易地得到似然函数的对数

为了使对数似然函数最大化,我们选择期望-最大化算法[38]来求解,因为lnp(X|μ)对µk的导数为零并不构成封闭解。

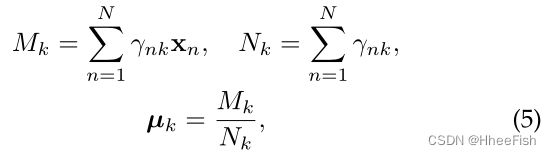

在最大化(M)步骤中,得到

其中,用于重表示的responsibility γnk在期望(E)步骤中使用当前参数评估为

式5中base -µk的更新可以看成是根据相应的responsibility γnk对xn的加权平均值。同样的,我们设lnp(X|µ)对xn的导数为零,来表示混合模型的数据,得到

它可以看作是xn的特征重表示,即根据各自的responsibility γnk将估计的bases µk 加权求和。

3.1.2.UDA中源域基下的特征重表示对齐(Feature Re-Representation Alignment Under Source Domain Bases for UDA)

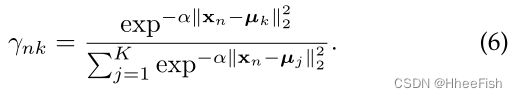

在基于UDA的语义分割中,我们表示源特征和目标特征为XS, XT∈RH×W×C,其中H, W为全卷积网络中经过多次降采样操作后的高度和权重,C为通道数。然后将特征分别重构为xS、xT,其中xS、xT∈RN×C, N = H × W。我们对FRA的说明见图1。在FRA中,基只通过源域特征学习。另外,我们用网络训练维持基地的运转。由于在一个小批量中无法观察到所有的数据,我们在实现中利用指数移动平均来更新base µ。因此,在E步骤中,源特征xSn和目标特征xTn的responsibility γSnk和γTnk分别为

bases在M步骤中更新为

其中β是0和1之间的常数,意味着在一次更新中保留了多少历史。需要注意的是,只有源特征xSn和衍生源responsibility γSnk用于更新base µ(t)k,因此µ(t)k只表征源域的特征分布。

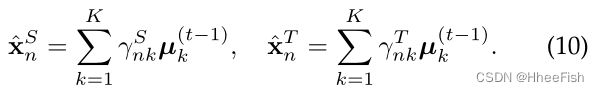

重新表示的源特性xˆSn和目标特性xˆTn被重新估计为

由于源特性xˆS和目标特性xˆT都用源域bases的加权求和重新表示,因此被表示的特征之间的差距最小。当目标特征由源域基重新表示时,源域的知识包含在目标特征重表示中。

Responsibilities再表示的对抗性正规化

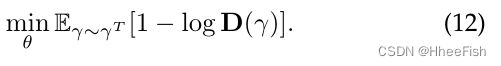

为了进一步对齐重新表示的源和目标特征,通过一个鉴别器引入一个对抗损失来正则化源特征的γS和目标特征的γT。这种规范化的目的是反向地调整责任。由于重新表示的特征是公式10中根据Responsibility γ的base µ的加权求和,一旦职责被正则化,源域和目标域特征的重新表示将进一步对齐。鉴别器D的优化目标为

对分割网络θ的Responsibilities的对抗性对齐为:

重新表示的目标特征在没有直接监督的情况下可能不适用于随后的分类。为了使目标特征重表示更具语义意义,我们将伪标签重训练集成到我们的框架中。我们首先回顾了典型的伪标签再训练配方,然后介绍了我们提出的可靠伪标签再训练(Reliable Pseudo Label Retraining,RPLR)。

3.2.可靠的伪标签再培训

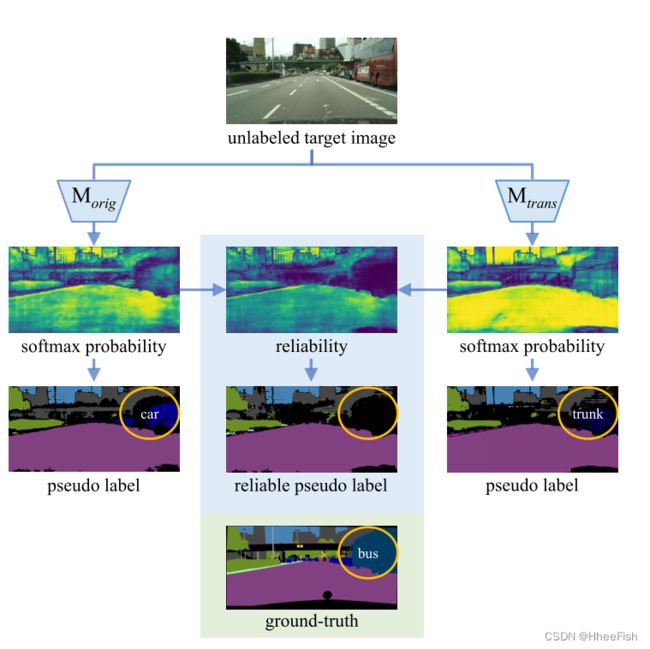

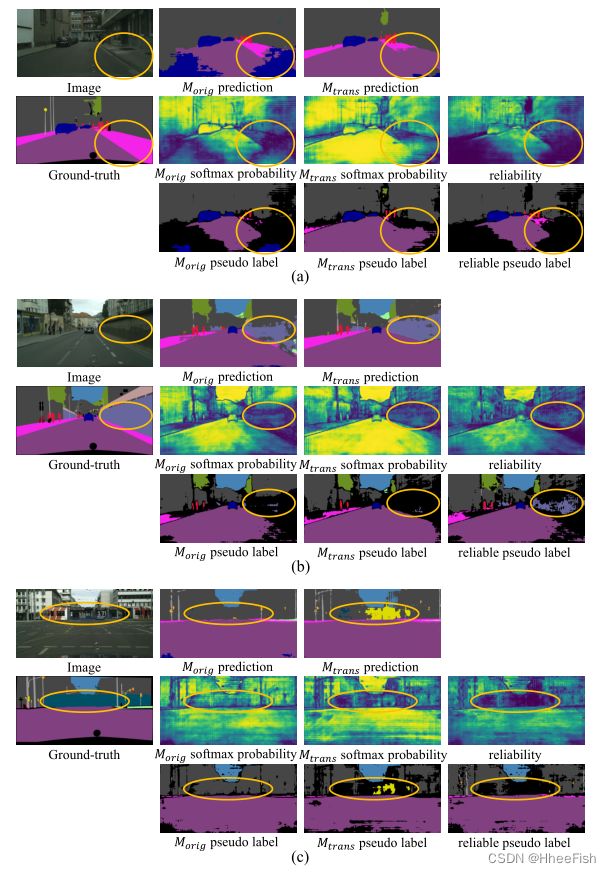

图2所示。可靠伪标签的生成说明。Morig表示用原始源图像训练的模型。Mtrans表示经过平移源图像训练的模型。对于未标记的目标图像,利用这两种模型预测的softmax概率映射生成伪标签。通过设置保持再训练目标伪标签比例相同的阈值,可以看出,通过两次预测的js-divergence计算信度忽略了橙色圆中的区域,而依赖各自的softmax概率会导致错误的伪标签,导致负迁移。

3.2.1.伪标签再训练(Pseudo Label Retraining)

伪标签再训练(PLR)是UDA中[6]、[12]、[13]、[42]的有效训练方法。现有的方法依赖于softmax概率过滤掉有噪声的伪标签:

yˆTn,©∗n是伪标签第n个像素在目标图像类c。要么是一个离散的独热0

00的向量或零向量,根据最大的概率将softmax输出pn (c |θ,)对网络参数θ超过一个固定的阈值δ。δ可以是均匀的,也可以是依赖于不同类别的。在重新培训期间,将忽略伪标签0。这背后的假设是具有高softmax概率的预测是自信的,并且在重新训练时,伪标签将导致目标域中类之间的低密度分离。

3.2.2.可靠的伪标签选择

虽然PLR是有效的,但它所依赖的软最大概率排序是不可靠的[23],[24],[25],[26]。具有高softmax概率的伪标签可能是不正确的,因此生成的伪标签是有噪声的。受共同训练[53],[54]和Tri-训练[55],[56]的启发,我们提出了RPLR,利用在多视图源数据上训练的两个网络的预测一致性来选择可靠的伪标签,如图2所示。在RPLR中,我们通过图像平移在输入层构造多视图。图像平移是UDA中最常用的一种算法,可以看作是输入级的域适应。经Cycle-GAN转换后的源图像[5]、[7]与目标图像具有相似的外观、纹理和光照模式。然而,由于不令人满意的翻译而引入了伪影,而原始图像很干净,但有很大的视觉差距。因此,可以认为它们是同一场景的不同视图,分别对它们进行训练的两个网络往往会有不同的行为。我们将在平移源图像T(IS)上训练的模型Mtrans的参数表示为θtrans,将在原始图像IS上训练的另一个模型Morig的参数表示为θtrans。可靠的伪标签生成方式如下:

其中pn(IT |θtrans)和pn(IT |θorig)分别为图像IT第n个像素上Mtrans和Morig的输出分布。利用Jensen-Shannon (JS)散度DJS来衡量两种预测的一致性。我们将1−DJS(pn(IT |θtrans)||pn(IT |θorig))作为可靠性。可靠性越接近1,预测就越一致,伪标签就越可靠。我们设置一个阈值δ来忽略带有大JS散度的噪声伪标签。再训练可以按照引导策略[6]、[12]进行多轮。

4.实验

4.1.数据集

我们在synthetic-to - real UDA环境下评估我们提出的方法,这意味着模型在一个完全标记的合成数据集上训练,并在一个未标记的真实数据集上评估。源域采用GTA5[57]和SYNTHIA (SYNTHIA- rand - Cityscapes)[58]两个合成数据集,目标域采用真实的Cityscapes数据集[59]。GTA5数据集有24,966个由游戏引擎渲染的合成帧,因此可以轻松实现相应的像素级注释。类似地,SYNTHIA数据集包含9400幅合成图像。未标记的现实城市景观数据集包含2975张训练图像和500张验证图像。在《GTA5》→cityscape中,共有19个类与33个类的cityscape数据集共同用于训练[8]网络。对于SYNTHIA→Cityscapes,我们使用16个普通课程来训练网络。在前面的工作[12]之后,我们评估了这16个类别的平均性能,并提供了13个类别的平均性能,不包括性能最差的3个类别。使用mIoU (mean-Intersection-over-Union)度量作为度量。

4.2.实现细节

4.2.1.架构细节

我们使用DeepLab-V2[3]和ResNet101[60]以及FCN-8s[1]和VGG16[61]。该鉴别器类似于[10],但我们将前三层卷积的stride改为1,以适应下采样特征映射的大小。bases是64。

4.2.2.训练策略

DeepLab由SGD优化器训练,初始学习率为2.5e-4,以[3]之后的多项式调度衰减。对抗性正则化的权重为0.01。为了用vgg16训练FCN-8s,我们使用初始学习率为1e-5的ADAM,每5万步降低0.1。对抗性正则化的权重为0.001。GTA5数据集的图片大小调整为1,280×720, SYNTHIA数据集的图片大小调整为1,280×760, cityscape数据集的图片大小调整为1,024×512。在GTA5→Cityscapes中,最大迭代次数是25万次,早期在15万步时停止,而SYNTHIA→Cityscapes的最大迭代次数是9万次。为了在GTA5中生成伪标签,我们在第一轮中训练了12万个步骤,在第二轮中训练了8万个步骤。要在SYNTHIA上生成伪标签,我们需要60,000步来训练网络。所有实验均在单个12GB NVIDIA TITAN V GPU上进行,批处理大小为1。该鉴别器采用最小二乘目标优化[62]。

4.2.3.图像翻译的策略

为了将源图像转换为类似于目标的图像,我们在[5],[7]之后使用CycleGAN。图像的宽度被调整为1024,而长宽比保持不变。400×400补丁被裁剪成20个epoch。前10个纪元的学习速率为2e-4,其余纪元的学习速率为0。

4.2.4.可靠的伪标签再训练

我们手动设置JS散度的阈值δ,以便选择数据集70%的伪标签在RPLR中重新训练网络。

4.3.和先进方法的比较

表1 GT A5→城市景观的实验结果与其他方法比较。

表2 SYNTHIA→城市景观的实验结果与其他方法进行了比较。mIoU表示13个类别的平均欠条,不包括带有的类别。

表1展示了GTA5→Cityscape与其他最先进的方法的比较。在ResNet101骨干上,我们实现了50.1%的mIoU,这比目前使用对抗训练和伪标签再训练的BDL[6]、IDA[44]和DTST[49]等方法要好。在VGG16骨干上也获得了43.1% mIoU的最新结果。同样,在SYNTHIA→Cityscapes上,如表2所示,在16个类和13个类的评估中也取得了最先进的结果。

4.4.消融实验

在这里,我们仔细研究了我们提出的方法中不同成分的影响。本小节的实验都是在带有ResNet101骨干网的DeepLabv2[3]上的GTA5→Cityscapes中进行的。

4.4.1.框架消融研究

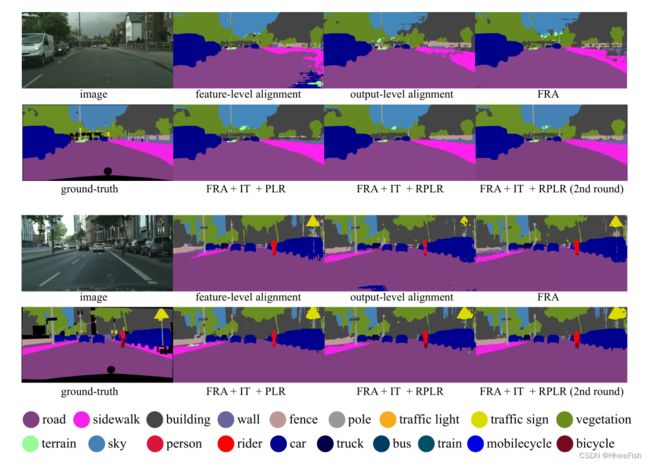

图3所示。分割结果的可视化。可以看出,定性结果从左向右逐渐改善,特别是栅栏和人行道

图4所示。应用FRA进行域适应前和域适应后特征的t-SNE可视化,perplexity = 90。我们选择了8个类别进行清晰的可视化。在域适应之前,将栅栏和交通标志的嵌入在目标域与源域混合。而在森林资源评估方面,仍有明确的区分

与仅使用源数据训练的模型相比,FRA在mIoU基础上提高了7%。结果表明,在源域基下的特征重表示实际上最小化了域间隙,将特征重表示与原始目标域信息相结合是一种良好的目标表示。为了可视化,我们使用t-SNE[63]将高维特征投影到一个二维空间中。从图4中可以看出,通过FRA,不同类别的嵌入有更清晰的分离,相同类别的嵌入在源领域和目标领域的差异减小。利用FRA对转换后的源图像进行训练,通过图像平移(image translation, IT)[5],[7]得到小的改进。对于RPLR, Morig对应FRA, Mtrans对应FRA + IT。在RPLR选择伪标签的监督下,利用FRA对翻译源图像进行再训练,mIoU提高了4.7% ~ 49.7%,表明了RPLR的有效性。经过第二轮再培训,mIoU最终达到50.1%。不同分量的分割结果可视化如图3所示。

4.4.2.FRA的组成部分

表4 FRA消融研究。我们提议的FRA的所有组成部分对于提高性能都是必不可少的。

FRA评估包括两个组成部分:特征重新表示和责任对抗性比对。如表4所示,基线模型仅针对源数据进行训练。值得注意的是,在mIoU上的特征再表征比非适应基线提高了5.5%。职责上的经常性对抗也能提升6.7%的绩效。我们的FRA与这两个模块一起进一步提高了性能,mIoU为44.8%,这表明它们是互补的。此外,将特征重新表示与原始领域特定特征相结合的快捷连接也是FRA中必不可少的组成部分。如果不结合原始的特定于领域的特性,性能会显著下降。我们声称,重新表示可以提供不同领域的公共知识,而缺乏特定领域的信息。因此,在我们提出的FRA中,原始的未失真的领域特定特征是一个补充,而快捷连接是一个必要的组成部分。

4.4.3.FRA中的bases可视化

为了揭示基学习什么,我们将与一些抽样bases对应的Responsibility可视化。在图5中,我们可以发现我们的学习bases是有语义意义的。图5(a)中的bases负责处理自行车和汽车的轮子。图5(b)中的bases负责处理汽车后部。bases在5©照料树枝和树叶。bases在5(d)照料树干。5(e)bases注意红绿灯。bases在5(f)负责建筑物。bases在5(g)照顾到路边。bases在5(h)照料极点和直瘦树。不同的bases负责场景的不同部分。有趣的是,有些bases代表了一些现有概念的组合,如图5(a)中的bases是自行车和汽车车轮的组合;同时,一些bases将注释过的类别分解为新的概念,例如图5©和图5(d)中的bases将树概念分解为树枝和叶子,将其作为数据集中的植被作为整体进行注释。图5(g)中的路边也是一个未注释的概念。值得注意的是,我们的学习bases对源图像和目标图像有相似的反应,这证实了我们的再表示在各个领域都是通用的。

4.4.4.FRA中的bases更新

表5不同碱基更新策略在FRA中的性能。EM更新的带有源代码特性的基实现了最佳性能。

在特征重新表示中,有5个选择用于更新的bases,如表5所示。如等式5所述,由源特性更新的FDA评估达到最佳性能,而由目标特性更新的FDA评估表现最差。同时使用源特征和目标特征进行更新的FDA评估也优于使用目标特征进行更新的FDA评估,与随机初始化后不进行更新的bases FDA评估相当。我们推测原因是,没有监督的目标特征可能无法进行有意义的表征,因此缺乏辨别力。将基值作为可训练参数,通过反向传播进行更新,mIoU也会下降1.0%。结果表明,在UDA中,在重表示中表征源域特征分布的bases是最有利的。

4.4.5.bases中的#在FRA中的作用

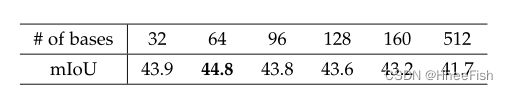

表6不同碱基数量下FRA的性能。

FRA中的bases数是一个需要调整的超参数。从表6的结果可以看出,对于feature re-representation来说,64个bases足够了,并且达到了最好的结果。当bases数增加到512时,mIoU下降到41.7,接近bases数为64时42.3%的无对抗损失性能。我们进一步可视化学习的bases,发现许多bases对源图像和目标图像的响应都是零。我们推测原因是:鉴别器无法判断输入是源还是目标,所以任务网络更倾向于生成响应为零的bases,因此容易欺骗鉴别器。当bases数量较大时,在有效bases数量较少的情况下,任务损失仍然可以最小化。因此,对抗性损失可能不能为任务网络提供有效的监督,从而降低任务网络的性能。

4.4.6.α在FRA中的作用

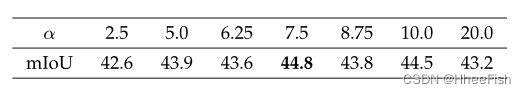

表7不同α的FRA性能。

本文的方程6中的常数α是一个待调的超参数。在预测步骤中,γ的值为:

如果α被设置为足够大,γ就变成了一个独热向量,因此只有一个bases有助于最终重表示ˆx在主论文的方程式7和特征x也只更新方程式5中的一个base。相反,如果α设置为零,γ是一个统一的矢量,这意味着最后re-representation x是bases的平均值,是同样的更新和bases的平均x。在表7中,我们可以看到,一个小α和α不带来良好的性能。设置α = 7.5会得到最好的结果,这意味着一个好的重新表示应该利用多个不同的bases。

4.4.7.β在FRA指数移动平均中的影响

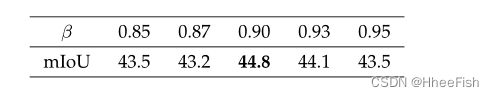

表8指数移动平均法中不同β的FRA性能。

在主要的文章中,Eq.(11)中的常数β是指数移动平均中的一个重要超参数,表示在训练过程中需要保留多少信息。表8的结果证实,β较大的base积累了大量的历史信息,导致在训练过程中优化困难。另一方面,使用较小的β进行快速更新会很快忘记历史,导致对整个数据集的统计数据估计不准确。为了实现这两种情况之间的权衡,我们最终将β设置为0.9。

4.4.8.与其他对抗性比对方法的比较。

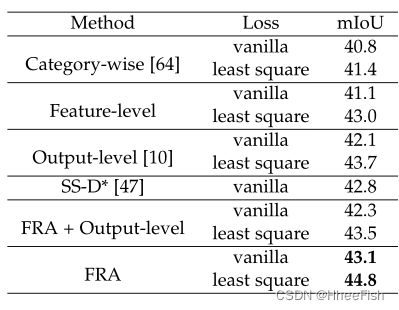

表9与其他对抗性比对方法的比较。我们提出的方法优于特征级对齐和输出级对齐,无论使用哪种损失。*表示结果改编自[47]。

FRA建议将重新分配的责任反向调整。为了与其他对抗性比对方法进行比较,我们在[10]中重新实现了输出级比对和特征级比对。值得注意的是,我们在FRA中使用了相同下采样步数的鉴别器进行特征级比对,与[10]相比性能有了很大提高。我们用不同的优化目标训练鉴别器,即香草二值交叉熵损失和最小二乘损失[10][62]。与输出级对齐和特征级对齐相比,FRA在表9中以最小二乘损失或普通二叉交叉熵损失获得最佳结果。图3显示了最小二乘损失下的比较。我们还比较了分类级对齐方法,即semantic - wise可分离鉴别器(SS-D)[47]和分类级对齐[64]。SS-D的结果改编自[47]。对于分类对齐,我们重新实现它,并在没有伪标签或弱标签监督的情况下报告性能。可以看出,我们的FRA评估的表现仍然优于其他国家。我们试图将我们的FRA评估与产出水平校准相结合。但是,性能会下降。原因可能是很难同时优化两个不同的对抗性任务

4.4.9.RPLR与PLR

图6所示。PLR、RPLR、RPLR*、RPLR的比较(w/o多视图)。IT表示图像平移。*表示在每幅图像中选择相同比例的伪标签。可以看出,我们提出的RPLR优于PLR和RPLR (w/o多视图),验证了我们的方法的有效性

图7所示。RPLR与PLR的视觉比较。我们保留整个目标训练集70%的像素来生成伪标签。在(a)的橙色圈中,Morig的伪标签虽然忽略了错误预测为汽车的大面积蓝色区域,但仍然保留了一些小部件。Mtrans的伪标签把大的错误预测为道路。在我们可靠的伪标签中,错误预测的区域会被忽略。在(b)的橙色圈中,虽然Morig和Mtrans都正确预测了wall,但由于伪标签中相对较低的softmax概率,它们仍然被忽略。在我们可靠的伪标签中,部分墙面被保留。在©中,Morig和Mtrans错误地将列车预测为具有较高软max概率的建筑和交通标志,并保留在生成的伪标签中。在我们可靠的伪标签中,大部分错误的预测都被忽略了。

在图6中,我们比较了RPLR和PLR。在训练基准模型FRA + IT后,我们对整个数据集的伪标签分别进行软最大值概率和JS散度由低到高的排序。然后手动设置阈值δ,从整个数据集中获得不同比例的自信伪标签,在翻译源图像上对模型进行再训练,分别得到再训练模型FRA + IT和FRA + IT + RPLR。在图6中,使用大量伪标签可以获得更好的结果。RPLR总是比伪标签再培训好。我们假设性能是通过忽略错误的伪标签获得的,这大约占整个伪标签的30%。当增加比例超过70%时,会引入错误的标签,降低性能。然而,在PLR中,不正确的伪标签不会被softmax概率忽略。因此,即使在再训练中选择了一小部分具有高softmax概率的伪标签,在训练中也已经包含了错误的伪标签,导致性能低于RPLR。随着引入更多低软最大概率的正确伪标签,当PLR中增加再训练的比例时,性能会提高。可视化结果如图2所示。从图7中可以看出,我们生成的可靠伪标签忽略了可靠性相对较低的不正确区域,而这些区域保留在softmax概率相对较高的伪标签中。同时,一些网络预测正确但软最大概率相对较低的区域在伪标签中被忽略。这些都保留在我们的可靠伪标签中,具有相对较高的可靠性。图3是RPLR与PLR分割结果对比的可视化结果。我们还尝试在每个图像中选择相同比例的伪标签,但与在整个数据集中选择伪标签的比例相比,性能有所下降。其原因可能是在这种选择策略中,选择了一些置信度较低的像素。

4.4.10.RPLR中多视图数据的性能提高

RPLR成功的关键是使两个网络不同,因此一致性可以作为伪标签选择的可靠性。造成RPLR网络不同的主要原因有两个:作为训练输入的多视图源数据和不同的随机初始化。我们在这里做实验,看看在RPLR中多视图数据的增益。在图6中,FRA + IT + RPLR (w/o multi-view)表示我们在已翻译的类目标源图像上训练另一个与Mtrans初始化不同的网络M’trans,以及公式14中Mtrans和M’trans而不是Morig计算的可靠性来选择伪标签。需要注意的是伪标签是由相同的Mtrans预测产生的,但是不同的策略可以忽略。RPLR和RPLR (w/o多视图)的比较表明,性能的提高主要来自于多视图数据作为源输入,这使得两种网络的性能有所不同。

4.4.11.RPLR与Π-Model、Mean Teachers比较

表11 RPLR与Π-model和mean teacher比较。IT表示图像翻译

我们的RPLR在半监督学习领域类似于Π-model[65]或mean teacher[66],[67],因为我们的RPLR利用了预测之间的一致性。不同的是,对于Π-model和在半监督学习区域的mean teacher,在未标记的目标图像上添加了颜色抖动和高斯噪声等扰动。而在我们的方法中,我们不改变未标记的目标图像,而是向网络输入不同的源图像。此外,在Π-model和mean teacher中加入的颜色抖动和高斯噪声等扰动是随机的和领域无关的。而在RPLR中,CycleGAN将源图像转换为类似于目标的图像,从而最小化域间隙。我们在提出的FRA上实现了不同扰动下的mean teacher和Πmodel。对于颜色抖动,我们随机将原图像的亮度、对比度和饱和度从80%改变到120%,色相从-5%改变到5%。对于高斯噪声,σ设为0.1,归一化后将噪声加到图像中。表11的结果表明,在mean teacher和Π-model中简单地添加一些扰动,如颜色抖动和高斯噪声,有时甚至会影响性能。这可能是由于摄动是随机的和领域无关的,这并不能最小化领域间隙,使得模型难以在未受摄动的目标图像上推广。我们的RPLR比mean teacher和Π-model具有更好的性能,因为Cycle-GAN将图像从源域转换到目标域,并且没有对目标图像进行扰动。

4.4.12.计算效率

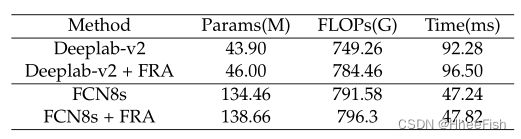

表10 FRA的计算分析。Params表示参数的数量。FLOPs表示浮点运算的数量。我们提出的森林资源评估只增加了一小部分参数和失败。

我们分析了具有FRA的网络的计算代价。输入大小为1,024×512。如表10所示,对于DeepLab-V2[3]和ResNet101[60],我们建议的FRA在参数、浮点操作和推断时间上增加小于5%。对于FCN8s[1]和VGG16 [61], FRA仅增加3%的参数,0.5%的浮点运算和1%的推断时间。这表明FDA重量轻,速度快

5.总结

在这项工作中,我们提出了一种新的无监督域适应的语义分割方法。提出特征重表示对齐方法,通过源域基的特征重表示来提供源域的知识,避免了原始特征分布的失真。然后,通过将重新表示的特征与原始的目标领域特定特征相结合,实现目标数据的良好表示。由于两个域的特征都用相同的源域基表示,因此它们之间的差距最小。进一步引入了对再表示责任的对抗性正则化来对齐再表示。为了使重新表示的特性在语义上更有意义,可靠的伪标签再培训被集成到框架中。竞争性能表明,我们的方法成功地缩小了域差距。

参考文献

[1] E. Shelhamer, J. Long, and T. Darrell, “Fully Convolutional Networks for Semantic Segmentation,” IEEE TP AMI, vol. 39, no. 4, pp. 640–651, 2017.

[2] H. Zhao, J. Shi, X. Qi, X. Wang, and J. Jia, “Pyramid scene parsing network,” CVPR, vol. 2017-Janua, pp. 6230–6239, 2017.

[3] L.-C. Chen, G. Papandreou, I. Kokkinos, K. Murphy , and A. L. Yuille, “DeepLab: Semantic Image Segmentation with Deep Convolutional Nets, Atrous Convolution, and Fully Connected CRFs.” IEEE TP AMI, vol. 40, no. 4, pp. 834–848, 2018.

[4] Y . Ganin, E. Ustinova, H. Ajakan, P . Germain, H. Larochelle, F. Laviolette, M. Marchand, and V . Lempitsky , “Domainadversarial training of neural networks,” The Journal of Machine Learning Research, vol. 17, no. 1, pp. 2096–2030, 2016.

[5] J. Hoffman, E. Tzeng, T. Park, J. Y . Zhu, P . Isola, K. Saenko, A. A. Efros, and T. Darrell, “CyCADA: Cycle-Consistent Adversarial Domain adaptation,” ICML, vol. 5, pp. 3162–3174, 2018.

[6] Y . Li, L. Yuan, and N. Vasconcelos, “Bidirectional learning for domain adaptation of semantic segmentation,” in CVPR, 2019, pp. 6936–6945.

[7] J.-Y . Zhu, T. Park, P . Isola, and A. A. Efros, “Unpaired image-toimage translation using cycle-consistent adversarial networks,” in ICCV, 2017, pp. 2223–2232.

[8] J. Hoffman, D. Wang, F. Yu, and T. Darrell, “Fcns in the wild: Pixellevel adversarial and constraint-based adaptation,” arXiv preprint arXiv:1612.02649, 2016.

[9] H. Huang, Q. Huang, and P . Krahenbuhl, “Domain transfer through deep activation matching,” in ECCV, 2018, pp. 590–605.

[10] Y .-H. Tsai, W.-C. Hung, S. Schulter, K. Sohn, M.-H. Yang, and M. Chandraker, “Learning to adapt structured output space for semantic segmentation,” in CVPR, 2018, pp. 7472–7481.

[11] Y .-H. Tsai, K. Sohn, S. Schulter, and M. Chandraker, “Domain adaptation for structured output via discriminative patch representations,” in ICCV, 2019, pp. 1456–1465.

[12] Y . Zou, Z. Yu, B. Vijaya Kumar, and J. Wang, “Unsupervised domain adaptation for semantic segmentation via class-balanced self-training,” in ECCV, 2018, pp. 289–305.

[13] Y . Zou, Z. Yu, X. Liu, B. Kumar, and J. Wang, “Confidence regularized self-training,” in ICCV, 2019, pp. 5982–5991.

[14] T.-H. Vu, H. Jain, M. Bucher, M. Cord, and P . Pérez, “Advent: Adversarial entropy minimization for domain adaptation in semantic segmentation,” in CVPR, 2019, pp. 2517–2526.

[15] Y . Xu, B. Du, L. Zhang, Q. Zhang, G. Wang, and L. Zhang, “Self-ensembling attention networks: Addressing domain shift for semantic segmentation,” in AAAI, vol. 33, 2019, pp. 5581–5588.

[16] J. Choi, T. Kim, and C. Kim, “Self-ensembling with gan-based data augmentation for domain adaptation in semantic segmentation,” in ICCV, 2019, pp. 6830–6840.

[17] H. Liu, M. Long, J. Wang, and M. Jordan, “Transferable adversarial training: A general approach to adapting deep classifiers,” in ICML, 2019, pp. 4013–4022.

[18] D. P . Kingma and M. Welling, “Auto-encoding variational bayes,” arXiv preprint arXiv:1312.6114, 2013.

[19] K. Huang and S. Aviyente, “Sparse representation for signal classification,” in NeurIPS, 2007, pp. 609–616.

[20] W. Dai and O. Milenkovic, “Subspace pursuit for compressive sensing signal reconstruction,” IEEE transactions on Information Theory, vol. 55, no. 5, pp. 2230–2249, 2009.

[21] R. Gray , “V ector quantization,” IEEE Assp Magazine, vol. 1, no. 2, pp. 4–29, 1984.

[22] S. Richardson and P . J. Green, “On bayesian analysis of mixtures with an unknown number of components (with discussion),” Journal of the Royal Statistical Society: series B (statistical methodology), vol. 59, no. 4, pp. 731–792, 1997.

[23] H. Jiang, B. Kim, M. Guan, and M. Gupta, “To trust or not to trust a classifier,” in NeurIPS, 2018, pp. 5541–5552.

[24] C. Corbière, N. Thome, A. Bar-Hen, M. Cord, and P . Pérez, “Addressing failure prediction by learning model confidence,” in NeurIPS, 2019, pp. 2898–2909.

[25] I. J. Goodfellow, J. Shlens, and C. Szegedy , “Explaining and harnessing adversarial examples,” arXiv preprint arXiv:1412.6572, 2014.

[26] A. Nguyen, J. Yosinski, and J. Clune, “Deep neural networks are easily fooled: High confidence predictions for unrecognizable images,” in CVPR, 2015, pp. 427–436.

[27] L.-C. Chen, G. Papandreou, I. Kokkinos, K. Murphy , and A. L. Yuille, “Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs,” IEEE TP AMI, vol. 40, no. 4, pp. 834–848, 2017.

[28] L.-C. Chen, G. Papandreou, F. Schroff, and H. Adam, “Rethinking Atrous Convolution for Semantic Image Segmentation,” 2017.

[Online]. Available: http://arxiv .org/abs/1706.05587

[29] L.-C. Chen, Y . Zhu, G. Papandreou, F. Schroff, and H. Adam, “Encoder-decoder with atrous separable convolution for semantic image segmentation,” in ECCV, 2018, pp. 801–818.

[30] C. Peng, X. Zhang, G. Yu, G. Luo, and J. Sun, “Large kernel matters–improve semantic segmentation by global convolutional network,” in CVPR, 2017, pp. 4353–4361.

[31] Z. Zhang, X. Zhang, C. Peng, X. Xue, and J. Sun, “Exfuse: Enhancing feature fusion for semantic segmentation,” in ECCV, 2018, pp. 269–284.

[32] H. Zhao, Y . Zhang, S. Liu, J. Shi, C. Change Loy , D. Lin, and J. Jia, “Psanet: Point-wise spatial attention network for scene parsing,” in ECCV, 2018, pp. 267–283.

[33] J. Fu, J. Liu, H. Tian, Y . Li, Y . Bao, Z. Fang, and H. Lu, “Dual attention network for scene segmentation,” in CVPR, 2019, pp. 3146–3154.

[34] Z. Huang, X. Wang, L. Huang, C. Huang, Y . Wei, and W. Liu, “Ccnet: Criss-cross attention for semantic segmentation,” in ICCV, 2019, pp. 603–612.

[35] X. Li, Z. Zhong, J. Wu, Y . Yang, Z. Lin, and H. Liu, “Expectationmaximization attention networks for semantic segmentation,” in ICCV, 2019, pp. 9167–9176.

[36] A. Vaswani, N. Shazeer, N. Parmar, J. Uszkoreit, L. Jones, A. N. Gomez, Ł. Kaiser, and I. Polosukhin, “Attention is all you need,” in NeurIPS, 2017, pp. 5998–6008.

[37] X. Wang, R. Girshick, A. Gupta, and K. He, “Non-local neural networks,” in CVPR, 2018, pp. 7794–7803.

[38] A. P . Dempster, N. M. Laird, and D. B. Rubin, “Maximum likelihood from incomplete data via the em algorithm,” Journal of the Royal Statistical Society: Series B (Methodological), vol. 39, no. 1, pp. 1–22, 1977.

[39] Z. Murez, S. Kolouri, D. Kriegman, R. Ramamoorthi, and K. Kim, “Image to image translation for domain adaptation,” in CVPR, 2018, pp. 4500–4509.

[40] R. Gong, W. Li, Y . Chen, and L. V . Gool, “Dlow: Domain flow for adaptation and generalization,” in CVPR, 2019, pp. 2477–2486.

[41] W.-L. Chang, H.-P . Wang, W.-H. Peng, and W.-C. Chiu, “All about structure: Adapting structural information across domains for boosting semantic segmentation,” in CVPR, 2019, pp. 1900–1909.

[42] Y . Yang and S. Soatto, “Fda: Fourier domain adaptation for semantic segmentation,” in CVPR, June 2020.

[43] Y . Chen, W. Li, and L. Van Gool, “Road: Reality oriented adaptation for semantic segmentation of urban scenes,” in CVPR, 2018, pp. 7892–7901.

[44] F. Pan, I. Shin, F. Rameau, S. Lee, and I. S. Kweon, “Unsupervised intra-domain adaptation for semantic segmentation through selfsupervision,” in CVPR, June 2020.

[45] J. Zhang, C. Liang, and C.-C. J. Kuo, “A fully convolutional tribranch network (fctn) for domain adaptation,” in ICASSP. IEEE, 2018, pp. 3001–3005.

[46] Z. Wu, X. Han, Y .-L. Lin, M. Gokhan Uzunbas, T. Goldstein, S. Nam Lim, and L. S. Davis, “Dcan: Dual channel-wise alignment networks for unsupervised scene adaptation,” in ECCV, 2018, pp. 518–534.

[47] L. Du, J. Tan, H. Yang, J. Feng, X. Xue, Q. Zheng, X. Ye, and X. Zhang, “Ssf-dan: Separated semantic feature based domain adaptation network for semantic segmentation,” in ICCV, 2019, pp. 982–991.

[48] J. Huang, S. Lu, D. Guan, and X. Zhang, “Contextual-relation consistent domain adaptation for semantic segmentation,” in ECCV. Springer, 2020, pp. 705–722.

[49] Z. Wang, M. Yu, Y . Wei, R. Feris, J. Xiong, W.-m. Hwu, T. S. Huang, and H. Shi, “Differential treatment for stuff and things: A simple unsupervised domain adaptation method for semantic segmentation,” in CVPR, June 2020.

[50] M. Kim and H. Byun, “Learning texture invariant representation for domain adaptation of semantic segmentation,” in CVPR, 2020, pp. 12 975–12 984.

[51] M. Chen, H. Xue, and D. Cai, “Domain adaptation for semantic segmentation with maximum squares loss,” ICCV, vol. 2019October, pp. 2090–2099, 2019.

[52] Y . Luo, L. Zheng, T. Guan, J. Yu, and Y . Yang, “Taking a closer look at domain shift: Category-level adversaries for semantics consistent domain adaptation,” in CVPR, 2019, pp. 2507–2516.

[53] A. Blum and T. Mitchell, “Combining labeled and unlabeled data with co-training,” in Proceedings of the eleventh annual conference on Computational learning theory, 1998, pp. 92–100.

[54] M. Chen, K. Q. Weinberger, and J. Blitzer, “Co-training for domain adaptation,” in NeurIPS, 2011, pp. 2456–2464.

[55] Z.-H. Zhou and M. Li, “Tri-training: Exploiting unlabeled data using three classifiers,” IEEE TKDE, vol. 17, no. 11, pp. 1529–1541, 2005.

[56] K. Saito, Y . Ushiku, and T. Harada, “Asymmetric tri-training for unsupervised domain adaptation,” in ICML, 2017, pp. 2988–2997.

[57] S. R. Richter, V . Vineet, S. Roth, and V . Koltun, “Playing for data: Ground truth from computer games,” in ECCV, 2016, pp. 102–118.

[58] G. Ros, L. Sellart, J. Materzynska, D. Vazquez, and A. M. Lopez, “The synthia dataset: A large collection of synthetic images for semantic segmentation of urban scenes,” in CVPR, 2016, pp. 3234– 3243.

[59] M. Cordts, M. Omran, S. Ramos, T. Rehfeld, M. Enzweiler, R. Benenson, U. Franke, S. Roth, and B. Schiele, “The cityscapes dataset for semantic urban scene understanding,” in CVPR, 2016, pp. 3213–3223.

[60] K. He, X. Zhang, S. Ren, and J. Sun, “Deep residual learning for image recognition,” in CVPR, 2016, pp. 770–778.

[61] K. Simonyan and A. Zisserman, “V ery deep convolutional networks for large-scale image recognition,” arXiv preprint arXiv:1409.1556, 2014.

[62] X. Mao, Q. Li, H. Xie, R. Y . Lau, Z. Wang, and S. Paul Smolley , “Least squares generative adversarial networks,” in ICCV, 2017.

[63] L. v . d. Maaten and G. Hinton, “Visualizing data using t-sne,” JMLR, vol. 9, no. Nov , pp. 2579–2605, 2008.

[64] S. Paul, Y .-H. Tsai, S. Schulter, A. K. Roy-Chowdhury , and M. Chandraker, “Domain adaptive semantic segmentation using weak labels,” in Computer Vision–ECCV 2020: 16th European Conference, Glasgow, UK, August 23–28, 2020, Proceedings, Part IX 16. Springer, 2020, pp. 571–587.

[65] S. Laine and T. Aila, “Temporal ensembling for semi-supervised learning,” arXiv preprint arXiv:1610.02242, 2016.

[66] A. Tarvainen and H. Valpola, “Mean teachers are better role models: Weight-averaged consistency targets improve semi-supervised deep learning results,” arXiv preprint arXiv:1703.01780, 2017.

[67] G. French, M. Mackiewicz, and M. Fisher, “Self-ensembling for visual domain adaptation,” 6th International Conference on Learning Representations, ICLR 2018 - Conference T rack Proceedings, pp. 1–20, 2018.