数据挖掘与建模流程

哈喽,好久不见,甚是想念,今天给大家分享一下关于数据挖掘建模的流程,这是小编在书里看到的,分享给大家,这样以后做事有头有尾,有据可循。

欢迎关注哔哩哔哩UP主:我家公子Q

目 录

定义目标

数据采集及取样

数据探索

数据预处理

建立数学模型

模型评价

1.定义目标

针对于具体的数据挖掘与建模的工作任务,首先要做的就是明确任务目标,然后将任务目标进行拆分,构建各子目标,目的是为后续工作确定一个良好的方向,避免误入歧途,陷入数据分析的漩涡。

要精准的明确数据挖掘与建模的目标,要求作业人员需要对应用领域具备较为熟悉的掌握,包括应用中的各种知识和应用目标,了解相关领域的情况,熟悉背景知识,弄清用户需求。

一般讲,数据分析与挖掘的目的可以分为三类:

-

把握趋势和模式。比如把握顾客的消费意愿、分析商品的销售模式(啤酒和尿布)等等;

-

预测或分类。比如预测股票价格变动、预测人口变化、预测环境污染等等,分类是指将群体依据多个属性分为多种类别。

-

求最优解。在多种约束条件下,要实现利益最大化或成本最小化,比如资源一定的前提下,实现利润最大化,寻找最优决策。

2.数据采集与取样

2.1 数据采集

数据采集的方式多种多样,一般来讲数据源包括如下几种:端上数据、开放数据、其他平台的数据、物理数据和主观性数据。

端上数据:如果你自己公司具有完整的数据管理系统,那么一般可以根据业务需求可以直接在自身系统里进行数据导出,然后用于后续的数据分析与建模。

开放数据:是指开放给所有人的数据,比如网页的内容数据,或者特定行业的公开数据。这类数据往往需要使用爬虫技术来采集。

其他平台的数据:比如说开发者想要拿到自己微信公众号的数据,那么直接可以调取微信的API接口,进而得到自身所需的数据。

物理数据:主要是指通过传感器、射频识别等采集到的一些数据信息,指拥护在物理世界中所产生的数据。

主观性数据:主要通过调研、访谈或调查问卷得到的数据,也是一种传统的数据采集采集方式。

分享几个有用的数据采集网站:

新榜

排名列表

以日、周、月、年为周期,按24大分类权威发布以微信为代表的中国各自媒体平台真实、有价值的运营榜单,方便用户了解新媒体整体发展情况,为用户提供有效的参考导向

清博大数据

登录 - 账号中心

大数据导航

大数据导航-大数据工具导航-199IT大数据导航-199IT大数据工具导航-Hao.199it.com

以大数据产业为主,大数据工具为辅,给用户提供一个更加快速找到大数据相关的工具平台。

国家数据中心

国家数据

镝数:数据查找与可视化平台

镝数图表 - 在线数据可视化神器,让你的数据有型有款、创意无限

中国首个数据与可视化服务平台,致力于聚合可靠的数据,提供无需编程的数据可视化工具,让不同行业从业者可以在平台上一站式完成从数据获取、数据处理到数据可视化的工作。

2.2 取样

一般进行实际的数据分析和建模之前,需要从采集的数据集中进行抽样操作,抽样常见的方式如下:

(1)随机抽样:在进行随机抽样时,数据集中的每一组观测值都有相同的被抽样的概率。

(2)等距抽样:如按照5%的比例对一个有100组观测值的数据集进行等距抽样,则有100/5=20,等距抽样则抽取第20,40,60,80和100这5组观测值。

(3)分层抽样:在分层抽样时,首先要将样本总体分为若干层,在每层中的观测值都有相同被选中的概率,但对于不同层次可以设置不同的概率。

(4)从起始位置开始抽样:这种抽样方式是从输入数据集的起始开始抽样。

(5)分类抽样:依据某种属性的取值来选择数据子集,如按照客户名称分类、按地址区域分类等。

3. 数据探索

数据探索是对采集抽样之后的数据集进行初步分析,对数据质量进行判断,一般其后紧跟数据预处理操作。

数据探索一般包括数据质量分析和数据特征分析。

数据质量分析的首要任务是检查原始数据中是否存在脏数据(一般指不符合要求以及不能直接进行相应分析的数据),脏数据主要包括:

(1)缺失值;

(2)异常值;

(3)不一致的值;

(4)重复数据及含有特殊符号(如#¥@等)的数据

可以使用简单的统计分析,得到含有缺失值属性的个数,以及每个属性的未缺失数、缺失数与缺失率。进而采取相应的处理方式(本推文暂不讲)

异常值也称离群点,可以使用如下方法进行分析:

简单统计量分析、3σ原则、箱型图分析等。

数据特征分析包括分布分析、对比分析、统计量分析、贡献度分析相关分析和周期性分析等。

4. 数据预处理

数据预处理主要包括数据清洗、数据集成、数据变换和数据规约。

4.1 数据清洗

数据清洗主要是删除原始数据集中的无关数据、重复数据,平滑噪声数据,筛选掉与挖掘主题无关的数据,处理缺失值和异常值等。

缺失值主要的处理方式为:删除记录、数据插补和不处理;

异常值的处理方式:

| 异常值处理方法 | 描述 |

| 删除记录 | 将含有异常值的记录直接删除 |

| 视为缺失值 | 将其作为缺失值,采用缺失值处理方式进行处理 |

| 平均值修正 | 采用前后两个观测值的平均值修正该异常值 |

| 不处理 | 直接在含有异常值的数据集上进行建模 |

4.2 数据集成

实际业务中,需要的数据集可能分布于不同的数据源中,数据集成就是将多个数据源合并存放在一个一致的数据存储(如数据仓库)中的过程。在进行数据集成时,来自多个数据源的现实实体的表现形式不一样,有可能不匹配,比如在这张数据表中,id代表物料号,在另一个表单中id代表库位号,在进行数据集成时要考虑实体识别问题和属性冗余问题。

实体识别:同名异义(上方id的例子)、异名同义、单位不统一;

冗余属性识别:同一属性多次出现;同一属性不同命名;

4.3 数据变换

数据变换主要是对数据进行规范化处理,将数据转换为合理形式,以适应后续挖掘任务和算法。主要包括:

(1)简单函数变换

比如平方、开方、取对数、差分运算等

(2)规范化

比如最小-最大规范化、零-均值规范化、小数定标规范化

(3)连续属性离散化

比如等宽法、等频法、基于聚类的方法

(4)属性构造

比如根据业务构造属性、暴力衍生属性等

(5)小波变换

4.4 数据规约

数据规约产生更小单保持元数据完整性的新数据集,使得后续的数据集在进行分析和建模时更有效率。包括属性规约和数值规约两个方面。

考虑

5. 建立数学模型

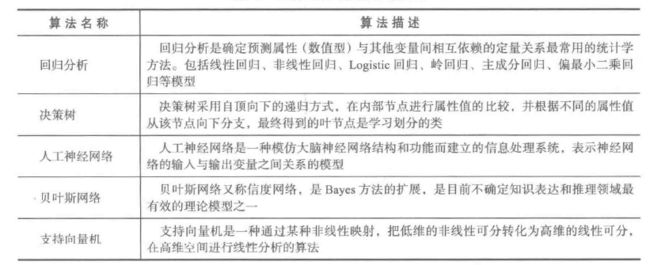

数学模型和之前描述的任务目标类型往往是一致的,常见的分类与预测算法如下表所示。

关于最优化决策问题,往往会涉及到运筹学相关知识,一般构建数学规划模型,常见的求解方式分为精确式求解方式和启发式的求解方式。

常见的精确式求解方式:单纯形法、分支定界法、列生成法、割平面法、动态规划法等;

常见的启发式方法:进化算法、粒子群算法、模拟退火算法、邻域搜索算法等;

6. 模型评价

模型评价一方面可以根据自身实际的业务评价指标进行判断,另一方面对于分类和预测模型,有一些常用的指标用来评估,当然,为说明模型的效果,一般是训练集和测试集进行分离,在没有参与模型建立的测试集上进行模型的评价。

评价指标一般包括:相对/绝对误差,平均绝对误差、均方误差、均方根误差等。

对于一些分类问题,可以通过识别准确度、识别精确率、反馈率、ROC曲线、混淆矩阵等方式进行评估。

参考书目:

Python数据分析与挖掘实战/张良均等著。—北京:机械工业出版社, 2015.12↩︎

好了,这次的内容就分享到这里!!谢谢大家支持。如有侵权,告知必删。

更多内容和源码下载, 请关注微信公众号“运筹帷幄Q"