干货!基于拓扑感知的高效神经网络架构搜索

点击蓝字

关注我们

AI TIME欢迎每一位AI爱好者的加入!

神经网络架构搜索是机器学习自动化中的重要一环。现有的神经网络架构搜索工作基于现有网络模块进行搜索,这极大限制了可探索的网络架构并约束了网络的潜在性能。

此外,由于现有搜索方法没有利用神经网络结构与模块中的拓扑信息,搜索过程非常耗时且并不能准确的找到良好和高效的架构。

为了解决这些问题并充分利用神经网络架构中的拓扑信息,我们提出了一套基于拓扑感知的神经架构搜索方法以探索新颖的神经网络模块,并将其泛化成有向无环图的形式。

我们首先提出了AutoShrink算法,用于逐步缩减巨大的有向无环图搜索空间,这让我们在短时间内搜寻高效的神经网络模块。

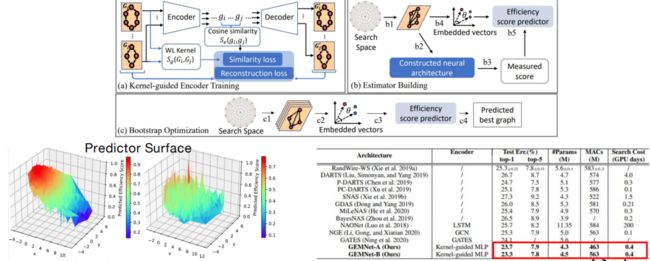

其次,我们提出NASGEM算法,利用拓扑信息为结构相似的神经网络模块赋予相似的图编码和表达,这为搜索算法提供更好的先验知识和更准确的神经网络架构性能评估。

在主流的计算机视觉任务上,我们提出的方法在获得了高精度、高效的神经网络架构的同时,极大地减少了搜索时间和开销。

本期AI TIME PhD直播间,我们邀请杜克大学电子与计算机工程系博士生——张屯厚,为我们带来报告分享《基于拓扑感知的高效神经网络架构搜索》。

张屯厚:

本科毕业于复旦大学微电子系,目前是杜克大学电子与计算机工程系二年级博士生,师从陈怡然和李海老师。他的主要研究方向自动机器学习,具体为基于拓扑感知的神经网络架构搜索。

01

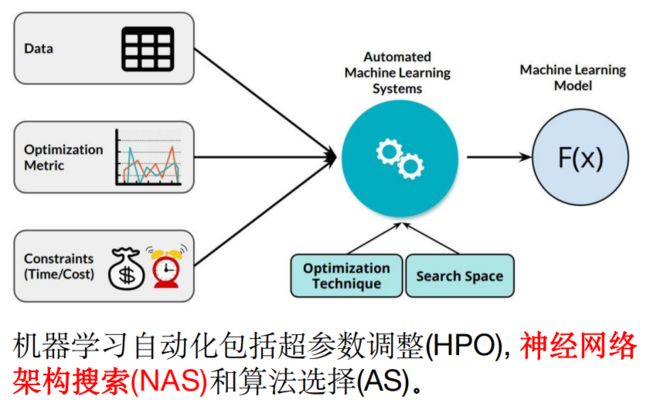

机器学习自动化

传统机器学习 (ML)

• 需求: 人类机器学习专家

• 耗时 & 容易出错

• 简单的同构神经网络设计

• 低生产效率和部署利用效能

自动机器学习 (AutoML)

• 需求: 计算资源

• 无人工成本 & 不容易出错

• 复杂的异构神经网络设计

• 高生产效率和部署效能

02

神经网络架构搜索

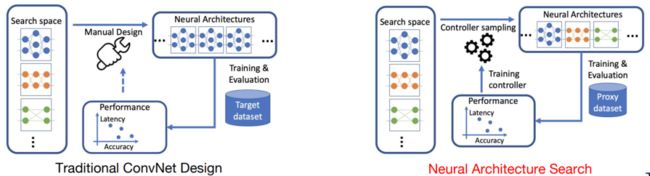

• 神经网络架构搜索(NAS)是自动机器学习(AutoML)自动化的一部分。

• 神经网络架构搜索旨在为不同的任务自动搜索高效并且高性能的神经网络模型。

• 神经网络架构搜索是系统化的自动设计,无需人工干预。

• 神经网络架构搜索非常耗时:NASNet需要40,000个GPU小时完成搜索。

• 神经网络架构搜索在很多任务上取得了卓越性能。

03

基于拓扑感知的神经网络架构搜索

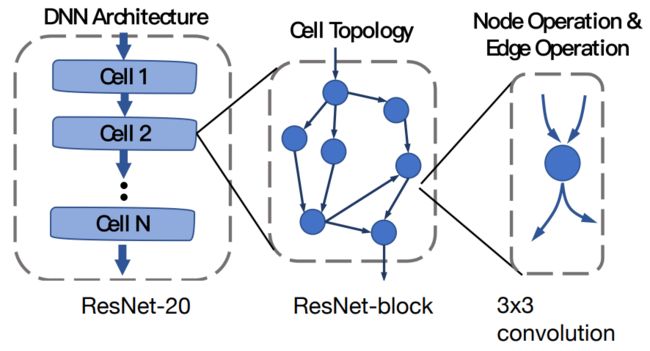

• 基于拓扑感知的神经网络架构搜索寻找构建神经网络的最佳基础单元(Cell),并使用有向无环图(DAG)构建层级化搜索空间。

• DNN architecture:我们最终的目标设计(如ResNet-20)

• Cell topology: a group of DNN (node) operations (e.g., ResNet-block which is composed of 2 3x3 convolution) that transforms input feature maps into representative output feature maps

• Node operation: a single DNN operation of our interest (e.g., 3x3 convolution

由此,我们可以将每个基础单元用一个有向无环图来表示,有向无环图的起点就是它的原点,对应着基础单元的输入节点。ResNet此时就是对应的两个有向无环图的中间节点,每个节点对应一个3x3卷积操作。

• 以前的神经网络架构搜索方法:

- 使用的方法(例如强化学习或者基于梯度下降的搜索)不考虑拓扑结构。

- 巨大的搜索资源开销,典型为上千GPU小时。

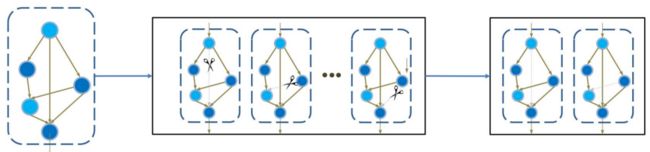

• AutoShrink通过如下方式解决了上述问题:

- 构建基于有向无环图的拓扑结构空间,适用于计算机视觉与自然语言处理 任务

- 逐渐缩减有向无环图中没有效能的边高效地搜索最好的结构,仅需1.5 GPU小时。

04

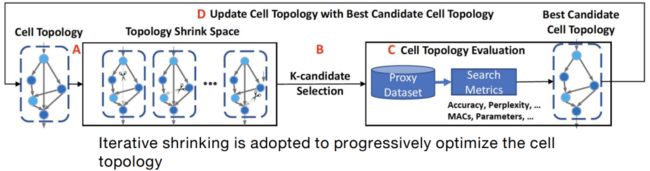

算法流程图: AutoShrink

• 我们不关心搜索空间当中的最优结构。我们只需要在逐渐缩减有效无环图的过程中,对搜索到结构的质量做出实质性的提升。

• AutoShrink的隐含视野:模型的可训练性和表达性存在权衡。

回顾之前ResNet的提出,是因为人们发现非常深的网络是无法被训练的。因为非常深的网络是存在梯度下降等问题的,其可训练性非常差。

05

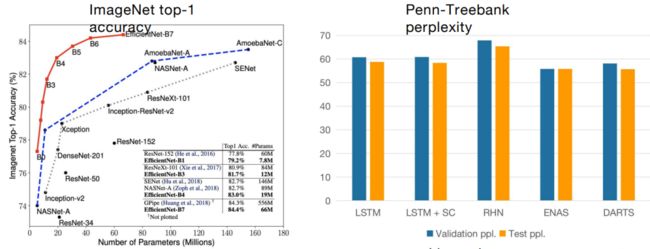

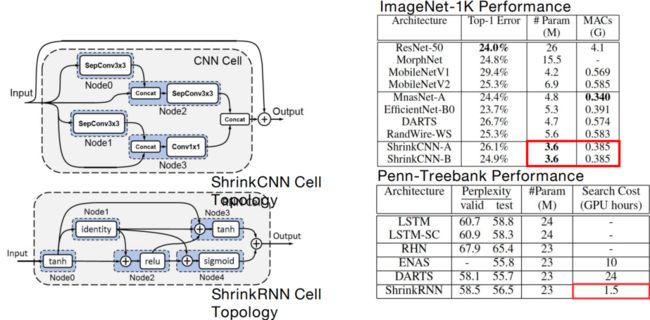

实验结果 & 找到的模块

我们的工作在计算机视觉任务和语言模型任务上都取得很好的效果。

06

基于拓扑感知的神经网络架构搜索: NASGEM

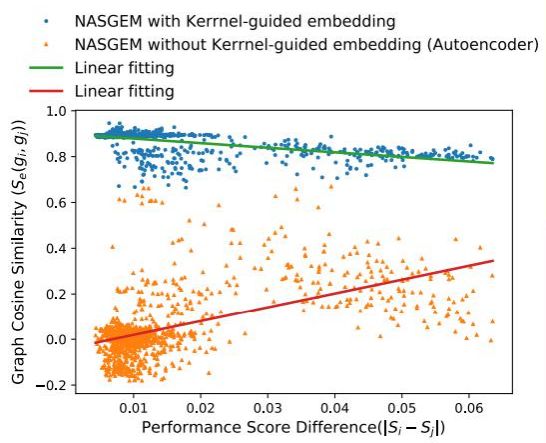

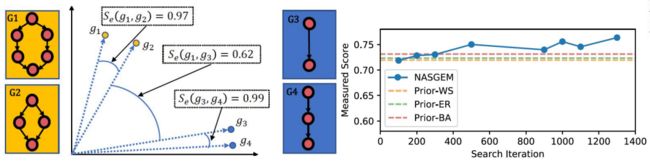

我们在下面的研究中将去探究一些相似图结构网络之间的性能关系。

• 我们的观察: 拓扑结构相似的神经网络架构一般具有相似的性能。

• 因此,我们结合了这种图学上拓扑结构的信息去提高神经网络的结构表达,为基于模型预测器的神经网络架构搜索提供更准确的先验知识和更准确的性能预测。

07

NASGEM算法流程 & 实验结果

基于这样的观察和假设,我们提出NASGEM方法,基于相似图结构有相似性能假设。我们希望相似的图能有相似的模型预测结果,然后进行模型预测主任务的训练。这样一来,上图左下角的可视化模型就更能体现我们先验知识的用处。

08

结语与展望

• 机器学习自动化,尤其是神经网络架构搜索,极大地提高了机器学习设计的效率并提升了机器学习的性能。

• 通过利用拓扑感知和结合拓扑结构信息,神经网络架构搜索能更高效地搜索高性能的网络建造模块,并更有效地发挥作用。

• 我们希望将这一类基于拓扑感知的神经网络架构搜索方式利用到更广泛的领域中去,包含但不限于机器翻译、3D点云检测、推荐系统。

• 并且,我们希望通过搜索有向无环图的结构,发现神经网络设计的内在逻辑,从而从根本上解决网络设计问题。

提

醒

论文链接:

https://arxiv.org/abs/1911.09251

https://arxiv.org/abs/2007.04452

论文题目:

AutoShrink: A Topology-aware NAS for Discovering Efficient Neural Architecture

(AAAI'20)

NASGEM: Neural Architecture Search via Graph Embedding Method (AAAI'21)

点击“阅读原文”,即可观看本场回放

整理:林 则

作者:张屯厚

往期精彩文章推荐

记得关注我们呀!每天都有新知识!

关于AI TIME

AI TIME源起于2019年,旨在发扬科学思辨精神,邀请各界人士对人工智能理论、算法和场景应用的本质问题进行探索,加强思想碰撞,链接全球AI学者、行业专家和爱好者,希望以辩论的形式,探讨人工智能和人类未来之间的矛盾,探索人工智能领域的未来。

迄今为止,AI TIME已经邀请了600多位海内外讲者,举办了逾300场活动,超170万人次观看。

我知道你

在看

哦

~

点击 阅读原文 查看回放!