论文超详细精读|五千字:ResGCN/DenseGCN

文章目录

- 前言

- 总览

- 一、 Introduction

-

- 背景

- 主要贡献

- 二、Related Work

-

- 目前主要应用场景

- 目前困难与解决

- 三、Methodology

-

- 3.1 Representation Learning on Graphs(图的表示学习)

- 3.2 Residual Learning for GCNs(GCN的残差学习)

- 3.3 Dense Connections in GCNs (GCN的密集连接)

- 3.4 Dilated Aggregation in GCNs(GCN的膨胀聚集)

- 四、Experiments

- 五、Conclusion and Future Work

前言

笔者从人工智能小白的角度,力求能够从原文中解析出最高效率的知识。

之前看了很多博客去学习AI,但发现虽然有时候会感觉很省时间,但到了复现的时候就会傻眼,因为太多实现的细节没有提及。而且博客具有很强的主观性,因此我建议还是搭配原文来看。

请下载原文《DeepGCNs: Can GCNs Go as Deep as CNNs?》搭配阅读本文,会更高效哦!

总览

首先,看完标题,摘要和结论,我了解到了以下信息:

1.提出了成功训练深度GCNs的新方法。借鉴了CNN的概念,特别是残差(residual)/密集(dense)连接和扩张(dilated)卷积,并将它们适应于GCN架构。

2.使用这些新概念构建了一个非常深的56层GCN,并展示了它如何显著提高点云语义分割任务中的性能(与最先进的技术相比增加3.7%的mIoU)。

一、 Introduction

背景

1.CNN成功的一个关键原因是它能够设计和可靠地训练非常深入的CNN模型。相比之下,如何恰当地训练深度GCN体系结构尚不清楚。

2.CNN局限性:在一个GCN中叠加更多的层会导致常见的渐变消失问题。这意味着通过这些网络的反向传播会导致超平滑,最终导致图顶点的特征收敛到相同的值。

由于这些限制,大多数最先进的GCNs不超过4层。

3.作者采用了成功训练深度CNN的概念,主要是残余连接、密集连接和扩展卷积。

作者展示了如何将这些层合并到一个图形框架中,并对这些添加对深度GCNs的准确性和稳定性的影响进行了广泛的分析。

4.为了展示这些层适应性,作者将它们应用到流行的点云语义分割任务中。

我们表明,添加残差连接和密集连接以及扩展卷积的组合,可以成功训练56层深度的GCN。这个非常深的GCN将具有挑战性的S3DIS点云数据集的最新水平提高了3.7%。

主要贡献

1.将残差(residual)/密集(dense)连接和扩张(dilated )卷积应用于GCNs。

2.作者在点云数据上进行了大量的实验,展示了这些新层对训练深度GCNs的稳定性和性能的影响。使用点云语义分割作为实验平台。

3.展示了这些新概念如何帮助构建56层GCN,这是当时 最大程度上最深的GCN架构,并在S3DIS数据集上实现了近4%的最新性能提升。

- (左)展示了有7、14、28和56层的GCNs的训练损失,有和没有残余连接。本文注意到,在没有残余连接的情况下,添加更多的层会导致更高的loss。

- (右)相比之下,训练带有残余连接的GCNs在所有深度都能获得一致的稳定性。

二、Related Work

无法系统地、可靠地处理这些非欧几里和距离数据。为了克服cnn的缺点,GCNs为非欧氏数据处理提供了非常合适的解决方案,这大大增加了人们对使用GCNs进行各种应用的兴趣。

目前主要应用场景

1.社交网络:图表表示个人之间基于共同利益/关系的联系。这些联系是非欧氏的,高度不规则。GCNs有助于更好地估计社交网络图顶点之间的边缘强度,从而导致个体之间更准确的连接。

2.计算机视觉:在场景图生成中,对象之间的语义关系是用图来建模的。该图用于检测和分割图像中的对象,也用于预测对象对之间的语义关系。

3.重建图像:场景图还有助于反向过程,在给定场景的图形表示的情况下重建图像。

4.模拟人体关节的动作识别:在视频中,图形也被用于模拟人体关节的动作识别。

5.3D点云处理:特别是点云的非结构化特性对系统研究提出了表征挑战。

目前困难与解决

主要困难:梯度消失和感受野有限。

解决:

1.梯度消失:ResNet通过增加各层输入输出之间的残差连接,可以缓解梯度消失的问题。

2.DenseNet将这个想法更进一步,还添加了跨层连接。

(dilated)扩展卷积是一种较新的方法,通过增加感受野而不损失分辨率,已经带来了显著的性能提高,特别是在像语义分割这样的图像到图像翻译任务中。

3.本文展示了如何利用为CNN引入的概念,主要是残差/密集连接和扩张卷积,来训练深的GCNs。本文将Wang等人的工作扩展到更深的GCN,从而显著提高其性能。在点云语义分割任务上的大量实验验证了这些思想在一般图场景中的有效性。

三、Methodology

3.1 Representation Learning on Graphs(图的表示学习)

1.GCN框架函数

- 聚合函数:用于编译来自顶点邻域的信息

- 更新函数:对聚合信息执行非线性转换,以计算新的顶点表示。

2.GCN具有固定的图结构,并且只在每次迭代中更新顶点特征。与具有固定图结构的GCNs相比,动态图卷积(允许图结构在每一层发生变化)可以学习更好的图表示。

例如,

- ECC(边条件卷积)[34]使用动态边条件滤波器来学习边比权矩阵。

- EdgeConv[42]在每一个EdgeConv层之后查找当前特征空间中最近的邻居来重建图。

3.当考虑更深层的GCNs时,动态改变GCNs中的邻居有助于缓解过平滑问题,并导致有效更大的感受野。

本文框架中,作者建议在每层的特征空间中通过扩展 k − N N k-NN k−NN 函数重新计算顶点之间的边缘,以进一步增加感受野。

3.2 Residual Learning for GCNs(GCN的残差学习)

扩展深层架构的困难:堆叠多层图卷积会导致反向传播的高度复杂性。因此,大多数最先进的GCN模型通常不超过3层深。

实现:在原来的图学习框架中,学习了底层映射 F F F,它将图作为输入,输出一个新的图表示。

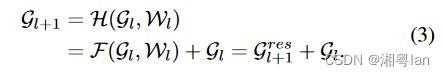

本文提出了一个图残差学习框架,通过拟合另一个映射 F F F 来学习一个底层映射 H H H 。 G l \mathcal{G}_l Gl 被 F F F 变换后,进行逐点相加得到 G l + 1 G_{l+1} Gl+1。

残差映射 F F F 学会将一个图作为输入,并在下一层输出残差图表示 G r e s l + 1 G_{res l+1} Gresl+1。

W l W_l Wl为 l l l 层的可学习参数集。此残差模型称为ResGCN。

3.3 Dense Connections in GCNs (GCN的密集连接)

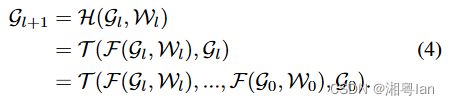

1.GCNS DenseNet中的密集连接:为了利用层之间的密集连接,从而改善了网络中的信息流,并使层之间的特征能够有效地重用。本文将类似的思想应用于GCN,以便利用来自不同GCN层的信息流。

运算符 T \mathcal{T} T 是将输入图 G 0 \mathcal{G}_0 G0与所有中间GCN层输出密集融合的逐顶点级联函数。为此, G l + 1 \mathcal{G}_{l+1} Gl+1由来自先前层的所有GCN过渡组成。此密集模型称为DenseGCN。

2.DenseGCN的增长率:等于输出图的维度 D D D (类似于CNN的DenseNet)。例如,如果 F F F 产生 D D D 维顶点特征,其中输入图 G 0 \mathcal{G}_0 G0的顶点是 D 0 D_0 D0 维的,则 G l + 1 \mathcal{G}_{l+1} Gl+1 的每个顶点特征的维度是 D 0 + D × ( l + 1 ) D_0+D×(l+1) D0+D×(l+1)。

3.4 Dilated Aggregation in GCNs(GCN的膨胀聚集)

有学者提出将膨胀卷积作为对密集预测任务(例如,语义图像分割)应用连续池化层的替代方案。实验表明,使用膨胀卷积聚集多尺度上下文信息可以显著提高语义分割任务的准确性。原因是扩张可以在不损失分辨率的情况下扩大感受野。作者认为,扩张也有助于加深GCNS的感受野。因此,作者将膨胀聚集引入GCNS。作者使用一个膨胀的 k − N N k-NN k−NN 在每一个GCN层之后寻找膨胀的邻域,并构造一个膨胀的图。特别地,对于以扩张 k − N N k-NN k−NN 和 d d d 为扩张率的输入图 G = ( V , E ) \mathcal{G}=(\mathcal{V},\mathcal{E}) G=(V,E) ,扩张 k − N N k-NN k−NN 通过跳过每 d d d 个邻域返回 k × d k×d k×d 邻域内的 k k k 个最近邻域。根据预定义的距离度量确定最近的邻居。实验中,使用当前层的特征空间中的 l 2 \mathcal{l}_2 l2 距离。

GCNS的膨胀聚集。在网格中排列的结构化图形(例如2D图像)和一般结构化图形上的膨胀卷积的可视化。(上)2D卷积,核大小为3,膨胀率为1、2、4(从左到右)。(下)扩张率为1、2、4的动态图形卷积(从左至右)。

四、Experiments

提出了ResGCN和DenseGCN来处理GCNS的消失梯度问题。为了扩大感受野,作者为GCNS定义了一种扩张的图卷积算子。为了评估框架,作者在大规模点云分割任务上进行了广泛的实验,证明了其方法显著地提高了性能。此外,作者还进行了一项全面的消融研究,以显示框架的不同部分的影响。

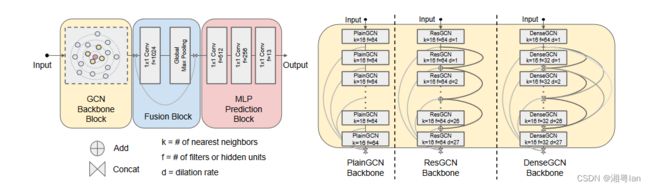

提出了点云语义分割的GCN体系结构。(左)框架由三个块组成:GCN骨干块(输入点云的特征变换)、融合块(全局特征生成和融合)和MLP预测块(点标签预测)。(右)作者研究了三种类型的GCN骨干块(PlainGCN、ResGCN和DenseGCN),并使用了两种层连接(ResGCN中使用的顶点相加或DenseGCN中使用的顶点拼接)。

五、Conclusion and Future Work

1.本文研究:如何将经过验证的有用概念(residual连接、dense连接和dilated卷积)从CNN引入GCNS,并回答了这个问题:如何使GCNS变得更深?

2.三个主要贡献:Res,Dense,Dilated。通过在GCNS中加入跳跃(residual)连接,可以缓解训练难度(梯度消失),这是阻碍GCNS深入的主要问题。此外,膨胀的图形卷积有助于在不损失分辨率的情况下获得更大的感受野。

3.具体实验:即使在最近邻较少的情况下,深度GCNS也能达到较高的点云语义分割性能。ResGCN-56在这项任务中执行得非常好,尽管它只使用8个最近邻居,而ResGCN-28使用16个最近邻居。作者还对ResGCN-151进行80个epochs的训练;该网络收敛得很好,取得了与ResGCN-28和ResGCN-56类似的结果,但只有3个最近邻。