谣言检测文献阅读三—The Future of False Information Detection on Social Media:New Perspectives and Trends

系列文章目录

- 谣言检测文献阅读一—A Review on Rumour Prediction and Veracity Assessment in Online Social Network

- 谣言检测文献阅读二—Earlier detection of rumors in online social networks using certainty‑factor‑based convolutional neural networks

- 谣言检测文献阅读三—The Future of False Information Detection on Social Media:New Perspectives and Trends

- 谣言检测文献阅读四—Reply-Aided Detection of Misinformation via Bayesian Deep Learning

- 谣言检测文献阅读五—Leveraging the Implicit Structure within Social Media for Emergent Rumor Detection

- 谣言检测文献阅读六—Tracing Fake-News Footprints: Characterizing Social Media Messages by How They Propagate

- 谣言检测文献阅读七—EANN: Event Adversarial Neural Networks for Multi-Modal Fake News Detection

- 谣言检测文献阅读八—Detecting breaking news rumors of emerging topics in social media

文章目录

- 系列文章目录

- 前言

- 1、Introduction

- 2、相关工作

-

- 2.1 基于内容的方法

- 2.2 基于社会背景的方法

- 2.4 基于深度学习的方法

- 2.5 Existing Detection Tools

- 3、虚假信息检测的新趋势

-

- 3.1 早期检测

- 4 基于人群智能的检测

-

- 4.1 虚假信息中的群体情报

- 4.2 隐式众智模型

-

- 4.3混合人机模型

- 5.未决问题和未来方向

- 6 结论

前言

文章:The Future of False Information Detection on Social Media:New Perspectives and Trends

发布期刊:ACM Computing Surveys

时间:2020年7月

1、Introduction

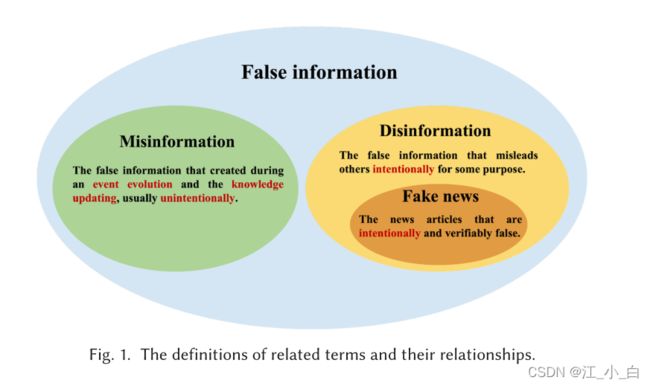

False Information :包括两种disingotmation和misinfromation

- disingotmation:指出于某种目的故意误导他人的虚假信息

- misinformation:指在事件演化或知识更新过程中产生的虚假信息,其目的不是误导

FID方法: - 基于内容的方法:基于内容的检测方法主要利用从社交帖子中提取的文本或视觉特征进行二元分类(真或假)。

- 基于社交环境的方法:通常依赖于大量用户之间的交互特征,比如评论、转发和关注。

- 基于特征融合的方法:综合利用了内容特征和社会背景特征

- 基于深度学习的方法:主要通过神经网络学习信息的潜在深度表示。

存在的问题:

- 现有的FID方法大多利用内容或传播特性,通常在虚假信息的整个生命周期中都能很好地工作,这可能会导致早期检测性能不佳。由于虚假信息可能会在几分钟内产生严重影响,因此在早期发现它们至关重要。

- 随着在社交网络上传播的多模式帖子的增加,传统的基于文本的检测方法不再可行,在更复杂的场景中利用图像或视频进行FID是有益的。

- 目前的检测方法只能给出声明是否虚假的最终结果,但缺乏做出决定的理由。对揭穿不准确信息并防止其进一步传播给出令人信服的解释具有重要意义。

文章的贡献

- 在简要回顾FID文献的基础上,我们重点介绍了FID的最新研究趋势,包括新事件的模型通用性、早期检测、基于多模式融合的检测和解释性检测

- 我们对基于人群智能的FID方法进行了研究,包括FID中人群智能的范围、基于人群智能的检测模型和混合人机融合模型

- 我们进一步讨论了FID模型的开放性问题和有前途的研究方向,如模型对新事件的适应性/通用性,新的机器学习模型的接受,以及FID模型中的对抗性攻击和防御。

2、相关工作

相关定义:

- 声明 s s s:含有n个post, P = { p 1 , p 2 , . . . , p n } P=\{p_1,p_2,...,p_n\} P={p1,p2,...,pn}和mf个相关用户 U = { u 1 , u 2 , . . . , u m } U=\{u_1,u_2,...,u_m\} U={u1,u2,...,um},其中 p i p_i pi含有一系列特征,例如文字、图片、评论数量等, u i u_i ui由一系列描述用户的属性组成,包括姓名、注册时间、职业等。

- 令 E = { e 1 , e 2 , . . . , e n } E=\{e_1, e_2, . . . , e_n\} E={e1,e2,...,en}是指 m 个用户和 n 个帖子之间的关系。每个 e i e_i ei 定义为 e i = { p i , u j , a , t } e_i = \{p_i,u_j, a, t\} ei={pi,uj,a,t},表示用户 u j u_j uj 在时间 t 通过动作 a a a(发布、转发或评论)与帖子 p i p_i pi 进行交互。

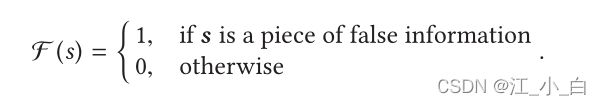

- False Information Detection:给定一条语句 s s s,其帖子集 P P P,用户集 U U U,参与集 E E E,错误信息检测任务是学习预测函数 F ( s ) → 0 , 1 F (s) → {0, 1} F(s)→0,1,满足:

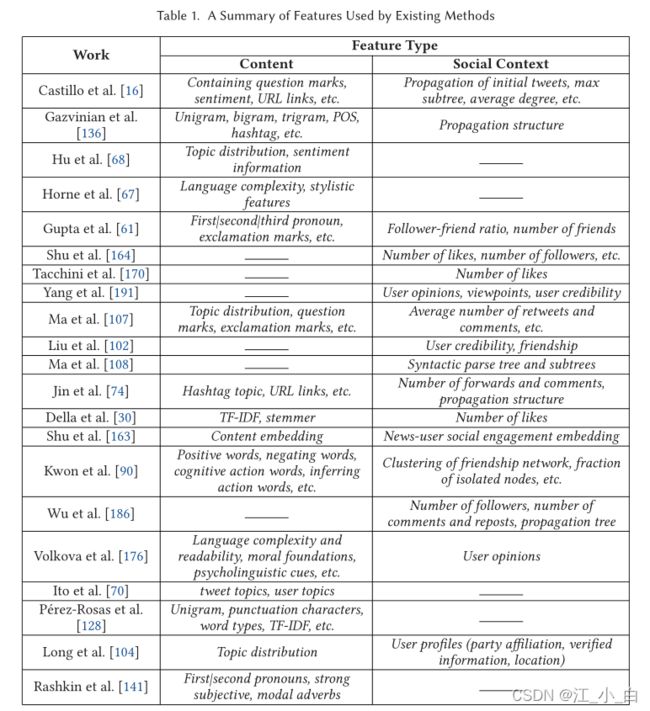

2.1 基于内容的方法

基于内容的方法主要基于虚假文章中的特定写作风格或耸人听闻的标题,例如词汇特征、句法特征和主题特征[143]。例如,卡斯蒂略等人。 [16, 17] 发现可信度高的推文有更多的 URL,文本内容长度通常比可信度低的推文长。

1、基于post的方法

基于帖子的方法主要依靠用户的帖子来表达他们对特定事件的情绪或意见。许多研究通过分析用户的可信度 [95, 118] 或立场 [63, 116] 来检测虚假信息。例如,舒等人。 [164]从用户档案中探索真正有用的特征用于FID,以减少检测过程中特征提取的负担。具体来说,他们发现外向和随和的用户不太可能受到虚假信息的影响。而保守的用户更容易相信虚假新闻、

2、基于传播的特征。

基于传播的方法从整体上评估帖子和事件的可信度[14],通常关注信息传播网络的构建和可信度传播。

一些研究通过分析其传播模式来检测虚假信息。例如,马等人。 [107] 发现社会背景的特征会随着时间的推移而逐渐变化。因此,他们提出了一种 DSTS 模型来表征 FID 的社会背景特征的时间模式,该模型将信息传播序列划分为固定长度的片段,然后从每个帖子片段中提取基于内容和基于社会背景的特征,最后用支持向量机进行分类。刘等人。 [102]基于异构用户的特定属性构建信息传播网络,用于识别虚假信息的特殊传播结构。金等人。 [79] 提出了一种贝叶斯非参数模型来表征新闻文章的传输,该模型联合利用文章主题和用户兴趣进行 FID。此外,吴等人。 [186]观察到,虚假消息通常首先由普通用户发布,然后由一些意见领袖转发,最后由大量普通用户传播。然而,真相往往是由一些意见领袖发布,然后被大量用户直接传播。基于这一观察,他们提出了一种用于 FID 的混合 SVM 分类器,该分类器对消息传播结构、主题信息、用户属性等进行联合建模。

2.2 基于社会背景的方法

传统的基于内容的方法孤立地分析单个微博或声明的可信度,忽略了不同推文和事件之间的高度相关性。此外,还有大量的人与内容交互数据(发帖、评论、转发、评分和标记等),具体来说基于社会背景的方法,分为基于post的方法和基于传播的方法

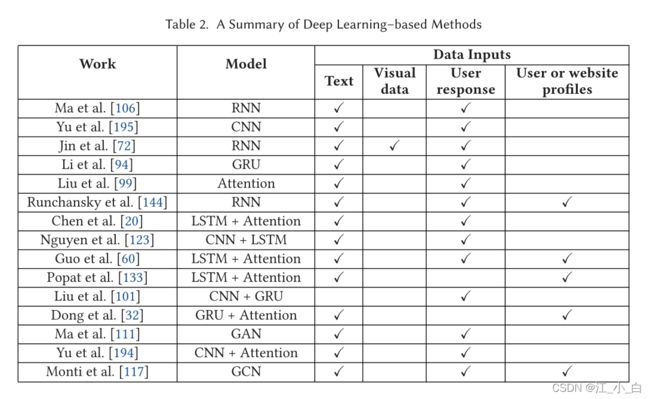

2.4 基于深度学习的方法

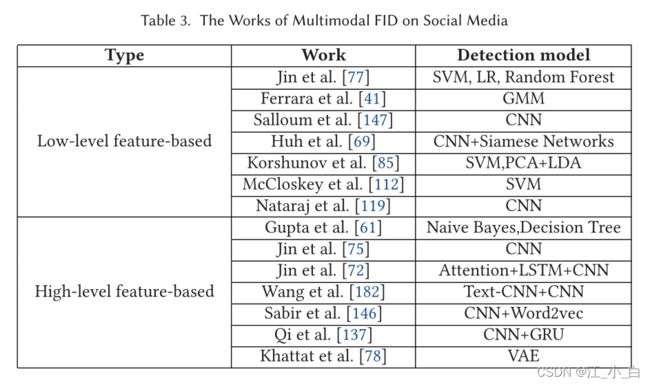

基于深度学习的方法旨在自动抽象出虚假信息数据的高级表示。目前,大多数工作主要利用循环神经网络 [106] 和卷积神经网络 [195] 进行 FID,如表 2 所示。在本文中,我们首先总结一下广泛使用的深度学习模型,主要包括:

- 卷积神经网络 (CNN)。 CNN 可以从输入中捕获局部和全局特征。FID模型可以通过调整过滤器的大小来捕捉词与词、词组与词组之间的内容特征。

- 循环神经网络(RNN),RNN 可以有效地捕捉序列数据的特征。社交网络帖子显然具有时间特征,所以FID 模型可以将帖子的交互数据分成连续的片段,并通过 RNN 捕捉它们的顺序特征。然而,Glorot 等人。 [49] 发现 RNN 可能会遭受梯度消失的影响,这使得它没有长期记忆。因此,长短期记忆(LSTM)[65]和门控循环单元(GRU)[25],一种具有门控机制的RNN,被广泛用于NLP。

- 递归神经网络 (RvNN)。 RvNN 与 RNN 类似,它在结构上展开数据,可用于分析数据的层次结构 [135],例如语法分析树。该模型由根节点、左叶节点和右叶节点组成。此外,每个节点从直接的左右子节点学习其表示,递归计算,直到遍历所有节点。

- 自编码器 (AE)。 AE 是一种无监督学习模型,包括编码和解码阶段 [64]。在编码阶段,输入数据通过多个隐藏层转化为潜在向量,在解码阶段将其重构为原始数据。通过最小化重构误差,AE 尽可能多地学习输入的表示。与 AE 相比,变分自动编码器 (VAE) 约束了编码阶段并成为生成模型 [82]。编码阶段的隐藏层通过从特定分布(例如高斯分布)中采样来学习潜在变量,然后将它们输入到解码阶段以生成真实样本。

- 生成对抗网络(GAN)。 GAN 是一种生成神经网络,由生成器和判别器组成 [51]。在反向传播的迭代过程中,判别器区分其输入来自真实数据集还是生成器生成的假样本,而生成器根据数据集的采样分布生成真实样本以混淆判别器。他们最终达到了纳什均衡,即生成器和判别器的性能无法再提高。

- 注意力机制。注意机制通常用于描述神经网络对输入序列的注意分布[7]。它计算当前输入序列和输出向量之间的匹配度,旨在捕获输入的关键信息。匹配度越高,注意力得分越高。因此,检测方法可以利用注意力机制来找到这些对 FID 贡献更大的单词或短语。

许多现有研究利用深度神经网络通过将相关帖子建模为时间序列数据来学习虚假信息的潜在文本表示。例如,马等人。 [106] 提出了一种基于 RNN 的检测模型,该模型捕获连续用户评论流的时间语言特征。李等人。 [94] 考虑到后流的前向和后向序列都传达了丰富的交互信息,因此他们提出了 FID 的双向 GRU 方法。刘等人。 [101] 认为假新闻和真新闻的传播模式存在差异,他们利用 CNN 和 GRU 对传播路径进行分类,以识别低可信度信息。于等人。 [194] 认为帖子的时间序列特征有助于准确地建模事件,他们提出了 FID 的 ACAMI 模型。该模型使用 event2vec(建议学习事件相关表示)和注意力机制来提取事件的时间和语义表示,然后使用 CNN 提取高级特征以对假微博帖子进行分类。

一些方法将文本信息和社交上下文信息(例如用户响应、用户或网站配置文件)结合为深度神经网络的数据输入。例如,郭等人。 [60] 提出了一种分层神经网络,将用户、帖子和传播网络的信息视为数据输入。此外,他们利用注意力机制来估计 FID 中特征的不同贡献。 Ruchansky 等人的工作。 [144] 提出了一种基于 RNN 的检测模型,该模型结合了新闻内容、用户响应和源用户的特征,以提升 FID 的性能。马等人。 [111] 提出了一种基于 GAN 的检测模型,旨在捕捉虚假推文的低频但有效的迹象。生成器(基于 GRU 的 seq2seq 模型)试图生成有争议的意见,使推文观点的分布更加复杂,而鉴别器(基于 RNN)试图从增强样本中识别虚假信息的稳健特征。

还有一些使用图神经网络进行 FID 的工作,例如 GCN。他们经常利用神经网络分析社交帖子的传播结构,然后为分类器提取信息传播模式的高级表示。例如,蒙蒂等人。 [117] 提出了一种基于 GCN 的 FID 模型,该模型集成了推文内容、传播结构、用户个人资料和用户社交关系(关注和被关注)。给定原始推文和所有相关推文,即评论和转发,检测模型以每条推文为节点,以推文传播路径和用户关系为边,构建事件特定图。之后,他们使用 GCN 来识别那些低可信度的推文,其中包含两个卷积层和两个全连接层。此外,董等人。 [33] 提出了一种基于GCN的检测模型,名为 GCNSI,它利用图卷积网络来检测多个错误信息源。

2.5 Existing Detection Tools

除了学术研究,研究人员还开发了几种 FID 工具。根据主要检测内容,现有的在线工具主要可分为基于图像的工具和基于文本的工具。

- 基于图像的检测工具: FotoForensics 通过分析图像压缩级别的分布来判断目标图像是否被修改。如果图像已被修改,则包含该图像的声明很可能是一条虚假信息。此外,知识搜索引擎Wolfram Alpha 还可以通过检索其知识库中的信息来验证图像的真实性,这有助于检测包含图像的虚假信息。

- 基于文本的检测工具 :。现有的 FID 工具主要侧重于文本内容的检测,一些工具也成为学者构建数据集的基本参考,例如 Politifact、 Snopes和 Factcheck。它们可以检查社交媒体上流传的可疑声明的事实。网络,并为用户提供来自值得信赖的专家或记者的分析报告。此外,研究人员还开发了多种在线 FID 工具,例如 Fake News Detector、TwitterTrails、 和 Hoaxy。

3、虚假信息检测的新趋势

3.1 早期检测

大量用户很容易在社交网络上传播虚假信息,在很短的时间内造成严重影响 [14, 46]。因此,早期发现虚假信息成为重要的研究课题。然而,大多数现有研究(基于内容和基于社会背景的方法)通过假设它们拥有所有生命周期数据来检测错误信息。它们依赖于几个聚合特征,例如内容特征和传播模式,这需要一定数量的帖子来训练鲁棒的分类器。虚假信息开始时的可用数据非常有限,以至于在早期阶段检测它具有挑战性。最近,对于早期的 FID 也有一些努力。

传统的机器学习方法往往在帖子的早期传播中分析用户交互信息,手动提取大量特征,最后使用分类器(例如,SVM、随机森林)来评估它们的可信度。例如,刘等人。 [100] 发现来源可靠性、用户多样性和证据信号,如“我看到”和“我听到”,在少量数据中对 FID 有显着影响。此外,Qazvinian 等人。 [136] 观察到用户倾向于在推文传播的早期阶段表达自己的想法(例如,支持或质疑)。因此,合理利用用户对消息的信念,对于早期发现虚假信息大有裨益。为了解决缺乏数据的问题,从相关事件中借用知识用于 FID 将是另一种有用的方法。例如,桑普森等人。 [149] 通过利用隐式链接(例如,标签链接、网络链接)来获取来自相关事件的附加信息,提出了一种用于紧急 FID 的方法。实验结果表明,当可用的文本或交互式数据较少时,此类隐式链接显着有助于正确识别出现的不真实声明。

许多检测方法利用深度学习模型来早期检测错误信息。基于深度学习的检测方法通常使用神经网络自动提取社交上下文特征,并利用注意力机制找到 FID 的关键特征。例如,Liu 等人。 [99] 观察到只有少数帖子对 FID 有很大贡献。为了选择这些关键内容,他们提出了一种基于注意力的检测模型,该模型通过注意力值来评估每个帖子的重要性。此外,实验结果表明,正确使用注意力机制有利于早期发现错误信息。同样,陈等人。 [20]发现用户在信息传播的不同时期倾向于评论不同的内容(例如,从惊讶到质疑)。基于这一观察,提出了一种基于 RNN 的深度注意力模型,用于选择性地学习用于早期 FID 的序列帖子的时间隐藏表示。于等人。 [195]利用基于CNN的模型从帖子序列中提取关键特征并学习它们之间的高级交互,这有利于识别具有相对较少交互数据的假推文。阮等人。 [123] 还利用 CNN 来学习每条推文的潜在表示,从而获得推文的可信度。然后,他们通过在事件开始时聚合相关推文的所有预测来评估目标事件是否是一条虚假信息。更重要的是,刘等人。 [101] 发现在消息传播的早期,大多数用户在没有评论的情况下转发源推文,这隐含地导致了在早期 FID 中使用用户评论的一些延迟。因此,他们提出了一种传播路径分类模型,命名为 PPC,该模型联合使用 CNN 和 GRU 来提取用户在转发路径中的局部和全局特征。

4 基于人群智能的检测

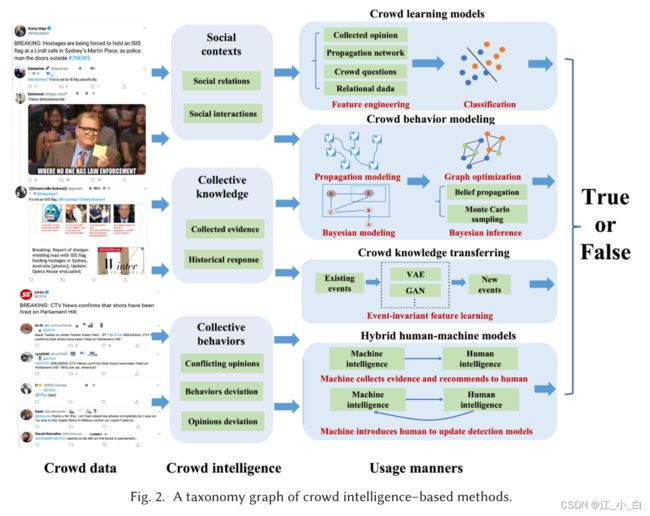

现有研究表明,帖子的内容特征仍然是 FID 的重中之重。随着社交帖子被用户生成、交互和消费,它会在帖子的编辑、评论和转发中吸收各种人类智能(例如观点、立场、提问、证据提供)。所谓的人群情报 [58, 96, 185] 也是在社交媒体帖子的传播过程中以集体方式聚合的。正如 Castillo 等人所述。 [16],一个有希望的假设是社交媒体环境中有一些内在信号有助于评估信息的可信度。马等人。110] 还发现 Twitter 支持基于汇总的用户意见、猜想和证据片段对虚假信息的“自我检测”。尽管如此,如何在 FID 中利用人群智能仍然是一个悬而未决的问题。在第 4 节中,我们尝试通过提炼和展示FID系统中人群智能的几种不同使用形式来解决这个问题,如图 2 所示。

4.1 虚假信息中的群体情报

在FID中,人群智能是指在信息生成和传播过程中,来自社交媒体用户的智慧的聚合线索或社交信号。在本小节中,我们总结了 FID 中人群智能的含义和使用方式。

我们从社会背景、集体知识和集体行为三个方面来描述群体智能。

- **社会背景:**源用户和传播者之间的社会关系和互动有助于理解信息的确定性。例如,金等人。 [80] 认为用户标记可以间接反映推文的可信度,因此他们使用 PGM 生成人与内容交互过程并推断推文的真实性。赵等人。 [199] 发现人群对评论真实性的提问或询问是低可信度信息的指示性信号,他们使用正则表达式从用户评论中提取上述信号用于 FID。此外,吴等人。 [188] 考虑到相似的主题可能会在相似的人群中传播,因此他们对传播者进行编码以捕捉他们的社交接近度以识别虚假消息。

- **集体知识:**人群提供的收集证据有助于推断信息的可信度。例如,林等人。 [97] 利用用户对目标事件在线证据的支持或反对来检测不准确的陈述。雷亚纳等人。 [142]认为用户的评分和评论是对帖子可信度的真实评价,因此他们提出了一个名为SpEagle的检测框架,该框架从集体线索和关系数据(信息传播网络)中提取特征。此外,钱等人。 [138] 提出了一种用于 FID 的人群知识转移方法,其中利用了来自历史真实/虚假声明的人群响应知识(例如,上下文特征和行为特征)。

- **集体行为:**在许多情况下,虽然个人行为不能很好地表征信息可信度,但来自一组用户的聚合行为往往会揭示更多信息。这可能是指人群互动模式、行为或意见偏离多数 [88]、观点冲突等。例如,经常参与低可信信息生产和传播的用户存在行为偏差,例如在短时间内发表若干意见,或在固定间隔后与内容互动。基于上述观察,Kumar 等人。 [88] 通过贝叶斯模型推断回复者及其评论的可信度。此外,Jin 等人。 [76] 发现同一事件下的相关推文包含支持和反对意见(通过 LDA 主题模型分析),他们利用这些相互冲突的观点为 FID 构建可信度传播网络。

在调查了现有的 FID 研究后,我们提炼出四种不同的人群智能使用方式,如下所示。 - **人群学习模型:**它主要使用特征工程和代表性学习将人群智能整合到 FID 模型中。

- **人群行为建模:**它使用图形或概率模型对人群行为和交互进行建模,以推断信息的可信度。

- **人群知识转移:**学习到的 FID 模型通常不适用于新事件。这种方式解决了如何将人群知识从现有事件转移到新事件。

- **混合人机模型:**考虑到人类智能和机器智能的互补性,这种方式专注于开发用于 FID 的混合人机模型。

前三种方式的一个共同特点是人群智能以隐含的方式使用,没有明确的人工输入。具体来说,人群智能被表示为统计人类行为模式,用作学习模型中的特征或参数。然而,最后一种方式是基于明确的人工输入,例如使用众包进行数据标记。此后,我们在第 4.2 节中描述了前三种形式的相关工作,在第 4.3 节中描述了最后一种形式。

4.2 隐式众智模型

在本节中,我们介绍了在 FID 中使用隐式人群智能的开创性研究,特别关注第 4.1 节中描述的前三种方式,如表 4 所示。

(1) 人群学习模型。

在该模型中,人群智能被表示为训练分类器以检测虚假信息的特征。这已被证明对早期 FID 很有用。例如,刘等人。 [100] 尝试使用来自 Twitter 数据的人群线索来解决实时虚假声明揭穿的问题,包括人们的意见、证人账户的统计数据、对事件的聚合信念、网络传播等。赵等人。 [199] 观察到,在决定是否相信此消息之前有些人愿意质疑或询问 Twitter 中声明的真实性。特别是,他们发现使用探究性思维有助于及早发现错误信息。

社会关系和互动也是 FID 特征学习中广泛使用的人群智能。例如,吴等人。 [188]假设相似的消息通常会导致相似的信息传播轨迹。他们提出了一种社交媒体用户嵌入方法来捕获社交接近度和社交网络结构的特征,在此之上使用 LSTM 模型对信息传播路径进行分类并识别其真实性。雷亚纳等人。 [142]应用集体意见线索和关系数据来检测虚假信息。

利用发布虚假帖子的用户行为与发布真实事实的用户行为不同的群体智能,识别虚假信息也很有帮助。Chen等人[22]提出了一种无监督学习模型,该模型将RNN和自动编码器结合起来,以区分低可信度信息与其他真实声明。此外,Xie等人[189]观察到,评论垃圾邮件攻击与其评级模式密切相关,这与正常评论人的行为模式不同。因此,他们提出了一种基于时态行为模式的评论式垃圾邮件检测方法,为基于群体学习模型的FID提供了参考

(2) 人群行为建模。

在该模型中,群体行为是群体智能的一种,它被建模为图形或概率模型来推断信息可信度。Hooi等人[66]发现欺诈账户通常在短时间内呈现其评级(评级分数满足偏态分布)。 群体智慧的特点是贝叶斯推理模型,它可以估计用户的行为与相关社区的行为之间的偏差。他们通过测量行为偏差的程度来推断用户评分的可信度。类似地,Kumar等人[88]提出了一个贝叶斯检测模型,该模型结合了聚合的群体智慧,例如用户的行为属性、评级的可靠性和产品的优点。通过惩罚异常行为,它可以推断出评级平台中的信息可信度。

一些研究利用聚集人群行为建模来促进虚假信息的早期检测。例如,马等人[110]假设回答者倾向于询问支持或否认给定事件的人,并表达他们对更多证据的渴望。因此,他们提出了两个树结构递归神经网络(RvNN),用于有效的假推特表示学习和早期检测,该网络可以对用户回复结构建模,并学习捕获聚合信号以用于FID。

(3) 群体知识转移。

现有的FID模型在新兴和时间关键事件上仍然表现不佳。换句话说,现有的FID模型通常捕捉到许多与事件相关的特征,这些特征在其他事件中并不常见。因此,有必要学习并将从现有众包数据中学习到的共享知识转移到新的活动中。Wang等人[182]的工作提出了一种检测模型,用于使用可转移特征识别新生成的假事件,称为事件对抗神经网络(EANN),该模型由三部分组成,即“特征提取器”、“事件鉴别器”和“假新闻检测器”EANN使用事件鉴别器学习与事件无关的共享特征,并在模型训练期间减少事件特定特征的影响。

群体知识转移模型也有助于早期FID。例如,钱等人[138]设计了一个生成式条件变分自动编码器,从历史用户对真假新闻文章的评论中捕捉用户的反应模式。换句话说,在虚假信息传播的早期阶段,当社交互动数据不可用时,群体智能被用来生成对新文章的响应,以提高模型的检测能力。Wu等人[187]还探讨了从历史众包数据中获得的知识是否有助于发现新出现的虚假社交媒体帖子。他们观察到,内容相似的社交帖子往往会导致类似的行为模式(例如好奇、探究)。因此,本文建立了一个稀疏表示模型来选择共享特征并训练与事件无关的分类器。

4.3混合人机模型

FID 是一个具有挑战性的问题,仅靠自动模型无法很好地适应各种上下文和事件。然而,人类智能可以通过利用他们的知识和经验来适当地解决这个问题。因此开发了混合人机模型,以利用人类智能和机器智能的互补性来进行 FID。从广义上讲,它属于“人类计算”范式,旨在开发人机系统,将人群和机器能力无缝交织,以完成两者都无法完成的任务[113, 177]。人机系统有几个有代表性的例子。例如,reCAPTCHA [178] 是一个类似于验证码的系统,用于保护计算机安全,同时它利用个人的共同努力来实现书籍的数字化。 Pandora [124] 是一种混合人机方法,可以解释基于组件的机器学习系统中的故障。

与隐含的基于人群智能的模型不同,此类模型中使用的人类智能通常基于显式的人类输入。这样的模型通常会提供足够的可解释信息来促进人机协作。在人机协作的帮助下,所提出的模型通常可以加快错误信息的检测速度。

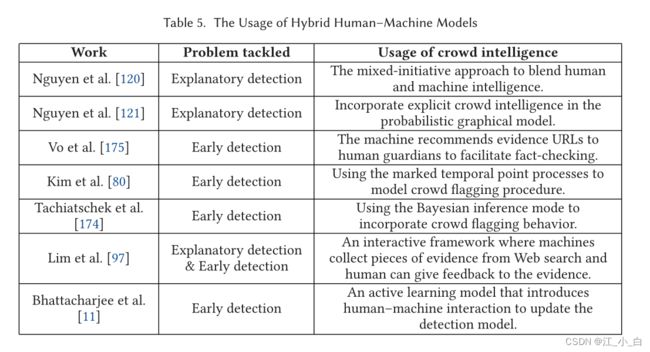

如表 5 所示,已经建立了几个人机模型用于事实验证。例如,Nguyen等人[120]认为,一个可靠的系统应该在如何获得决策结果方面对用户透明 。他们提出了一种混合主动的方法,将人类知识和经验与人工智能相结合,用于事实检查。此外,Nguyen等人[121]提出了一种基于PGMs的人机混合方法,该方法将显式人类智能(通过众包)与计算能力相结合,共同建模姿态、准确性和众包标签。这种方法能够生成FID的解释。Vo等人[175]提出了一个事实检查URL推荐模型,以阻止人们共享虚假信息。这种模式激励监护人(倾向于纠正虚假信息的用户)积极参与事实核查活动,并向社交网络传播经验证的文章。

显式人类智能也被表征并用于 FID 的概率模型。 Kim 等人的工作。 [80] 提出了 CURB,它利用标记的时间点过程来模拟低可信度文章的众包标记过程。为了通过可证明的保证显着减少虚假信息的传播,CURB 可以决定选择哪个语句进行识别以及何时检查它。 Tschiatschek 等人。 [174] 还提出了一个贝叶斯推理模型,该模型结合了人群标记来检测虚假帖子。为了评估推文中新声明的可信度,Lim 等人。 [97] 提出了一个名为 iFACT 的交互式框架。它从网络搜索结果中收集独立证据,并确定新声明和历史声明之间的依赖关系。进一步允许用户提供关于网络搜索结果是否与未经验证的信息相关(支持或反对)的明确反馈。此外,Bhattacharjee 等人。 [11]提出了一种人机协作学习系统,用于快速驳斥虚假信息。在这项工作中,他们将主动学习方法引入 FID,首先在有限的标记数据上训练一个初始分类器,然后使用交互方法逐步更新这个检测模型。

5.未决问题和未来方向

尽管研究人员已经做出了越来越大的努力来解决FID系统中的上述挑战,但如下文所述,未来仍有有待研究的问题。

(1)虚假信息的认知机制。

人们对虚假信息的认知机制的研究对于检测和驳斥虚假社交媒体帖子[87]具有很好的指导意义,尤其是基于群体智能的检测方法。有几部著作对社交媒体平台上的低可信度帖子进行了分析,以研究虚假信息能够迅速广泛传播的原因。Lewandowsky等人[92]认为,协同虚假信息需要在技术和心理学的背景下进行科学研究,因此他们提出了一种称为“技术认知”的跨学科解决方案。此外,他们还将用户在虚假信息面前的认知问题分为四类,包括影响效应、熟悉性逆反效应、过度杀戮逆反效应、世界观逆反效应,这为研究用户对虚假信息的感知奠定了基础[93]。正如Acerbi[1]得出的结论,不准确信息的快速传播在于它们包含满足用户认知偏好的特定内容。为了探索虚假信息的认知特征,他们通过将认知偏好编码为“威胁”、“厌恶”、“社交”、“名人”等部分,进一步分析了真假新闻文章中偏好的分布。未来值得研究的一点是将虚假信息和真实信息与具有认知吸引力的特征进行比较,或者评估与认知偏好相关的特征如何影响信息的真实性。

除了在数据分析层面研究认知机制,我们还可以从人脑认知功能的角度来学习机制。神经科学的进步为研究虚假信息的认知机制提供了一种有前途的方法。正如 Poldrack 等人所述。 [130],利用脑电图 (EEG)、脑磁图 (MEG)、功能磁共振成像 (fMRI) 和其他脑成像工具可以促进我们了解人类大脑如何形成社会行为。此外,Adolphs [3] 已经确定了参与社会认知调节的神经结构,例如扣带回皮层、海马体和基底前脑。阿拉帕基斯等人。 [6]利用脑电图记录来衡量用户对新闻文章的兴趣,实验结果表明,正面阿尔法不对称(FFA)可以客观地评估用户对媒体内容的偏好。为了解释信息病毒式传播的机制,Scholz 等人。 [151] 提出了一个基于 fMRI 数据的神经认知框架来评估用户在 Facebook 上分享信息的意愿。如果我们能够理解虚假信息的认知机制,那么可以将更多的精力集中在探索揭穿信息最大化方法上,以找到针对虚假信息的稳健对策。

(2) 缺乏标准数据集和基准。

尽管研究人员已经在FID上做了大量工作,但仍然缺乏像ImageNet[31]这样的用于视觉对象识别的基准数据集。数据集作为一种资源,与FID中的算法一样重要。然而,收集假消息是一个费时费力的过程,这导致缺乏权威的基准。

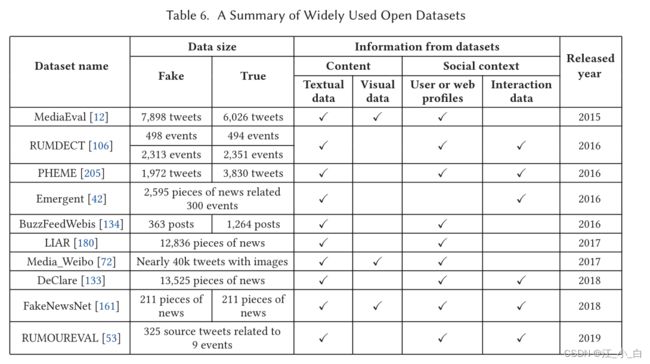

我们总结了自2015年以来使用的开放数据集,如表6所示,我们从新浪微博(如RUMDECT21和Meida_微博22)、Twitter(如MediaEval.PHEME,RumorEval),snopes.com, politifact.com(e.g.Emergent,26 BuzzFeedWebis,27 LIAR,28 Declare,29 and FakeNewsNet30)和其他事实核查网站。然而,这些数据集的注释方法、数据维度以及正确和错误陈述的比率是不同的,这对研究人员公平评估其模型性能提出了一定的挑战。Shu等人[162]总结了广泛使用的FID评估指标,现有的评估指标仍然是精度、召回率、F1分数、准确度等机器学习模型评估指标。在 FID 中,我们需要定义一些更实用的评估指标。例如,在政治选举中,我们会更关注虚假陈述是否被更充分地识别(即更关注召回而不是精确),因此使用 F1 分数来评估检测模型的性能不是很合适。在未来的研究中,需要标准的数据集和实用的评价指标来比较各种 FID 算法,促进 FID 方法的发展。

(3) 模型适应性/对新事件的普遍性。

FID方法应识别不可见的、新发生的事件,因为系统的现有数据可能与新发生事件的内容不同。然而,现有方法倾向于提取难以与新事件共享的特定于事件的特征[204]。正如托洛西等人[173]所述,基于特征工程的检测方法很难在不同领域(如政治、犯罪、自然灾害)检测到虚假信息,因为特征在不同的事件中会发生显著变化。因此,模型的通用性或自适应性对于提高FID模型的鲁棒性非常重要。Zubiaga等人[206]指出,依赖于领域的特征分布可能会限制模型的泛化能力。由于大多数特征的分布直接对应于事件,FID模型的性能将受到影响。虽然我们在第4.2节中讨论了一些群体知识转移模型[138、182、187],但还有很多需要研究。转移学习模型[59126]已成功应用于其他领域(如情感分类[50]和图像识别[103]),可用于设计领域适应性FID模型。使用基于GAN的鉴别器[182]是建立具有共享特征的广义FID模型的另一种有希望的方法。

另一个值得探索的有趣方向是我们应该从相似领域借用知识。例如,我们可以参考网络安全、病毒/垃圾邮件检测方法 [21、153、203],它们也存在早期检测和模型泛化等类似问题。

(4) 接受新的机器学习模型。

FID过程本质上是分类器的学习,以识别给定索赔的可信度。我们发现,许多研究建立了深度学习模型[20、72、101、106、123、144、195],以提高自动事实检查的性能。然而,还有更多可以探索的地方。在下文中,我们将介绍几个利用先进机器学习技术实现FID的代表性示例。

- 多任务学习。多任务学习[109]旨在通过使用相关任务中包含的领域知识来提高模型的泛化性能。现有的方法通过对任务相关性(例如特征共享、子空间共享和参数共享)建模来寻找多个任务之间的共性,作为促进每个任务学习效果的一些补充知识。例如,马等人。 [109] 认为 FID 任务与姿态分类任务高度相关,因此他们提出了一种神经多任务学习框架来更好地进行事实检查。在权重共享的机制下,他们提出了两个基于 RNN 的多任务结构来联合训练这两个任务,这可以为谣言表示提取普通以及特定于任务的特征。受这项工作的启发,我们可以研究 FID 与其他任务之间的联系和协作,并进一步设计基于多任务学习的算法来提高 FID 模型的性能。

- 少量学习。 Few-shot learning [183] 致力于通过利用少量监督信息来识别来自看不见的类别的样本来解决数据稀缺问题。现有的小样本学习方法通常将其训练过程分解为多个元任务学习过程,类似于元学习[43],它从不同任务的数据中提取可转移的知识。因此,这允许仅使用少量标记数据对新类别进行分类。据我们所知,FID 中应用的少样本学习方法较少,因此我们可以从其他相关领域学习,例如文本分类。为了改进分类器的归纳和泛化,Geng 等人。 [48] 提出了一种基于动态路由算法的分类架构,称为归纳网络,它从几个样本中学习广义的类级表示。 Induction Networks 主要包含一个编码器模块、一个归纳模块和一个关系模块。具体来说,编码器模块生成样本和查询表示,然后归纳模块利用变换矩阵将样本级表示映射到类级表示。最后,关系模块计算查询与每个类之间的匹配度。这项工作表明few-shot learning在NLP中具有巨大的潜力,我们可以继续研究基于few-shot learning的FID方法。

- 半监督模型。大多数现有的 FID 工作都集中在监督分类上,它们通常训练分类器通过大量标记数据(例如,假或非)来识别错误信息。然而,在很多情况下,我们只有少量的标记数据。半监督模型通常用于处理标签稀疏问题。例如,Guacho 等人。 [55] 提出了一种半监督 FID 方法,该方法利用基于张量分解的文本嵌入来捕获社交帖子的全局和局部特征。在构建所有帖子的K-Nearest Neighbor (K-NN)图后,他们使用置信度传播算法将已知标签传播到图中以获得事件的最终可信度。此外,图神经网络的发展也为半监督检测模型的研究提供了机会。GNN,如 DeepWalk [129]、LINE [171] 和 node2vec [54],利用不同的采样算法生成节点序列,然后通过skip-gram模型学习每个节点的表示或传播路径。他们将一阶接近度(表征两个相邻节点之间的相似性)和二阶接近度(表征两个节点之间的结构相似性)引入到他们的损失函数中,以确保神经网络能够充分提取特征图表。特别是,如第 2 节中所讨论的,GCNs [83] 通过图的拉普拉斯矩阵的非线性变换在相邻的卷积层中传输信息。每个卷积层只计算一阶接近度,因此 GCN 可以通过多个卷积层学习节点或传播路径的高级特征表示。特别是,GNN 能够通过显式图正则化方法 [184] 对图进行半监督学习来平滑标签信息。因此,FID 模型可以构建信息传播图并结合 GNN 来检测虚假信息。

- 无监督模型。如果能够直接建立可靠的无监督检测模型,那么对于快速驳斥虚假信息具有重要意义。无监督模型可以通过人与内容的交互(例如发布或转发社交媒体帖子)和人与人的交互(例如关注或提及某些用户)来评估帖子的可信度。一方面,GAN 和 VAE 的进步为无监督 FID 模型带来了新的可能性。然而,PGMs 仍然可以在 FID 中发挥重要作用。例如,陈等人。 [22] 从用户的发帖行为判断帖子的真假。这种无监督的方法利用 AE 来学习个人最近发帖及其评论的潜在表示。当其重构误差收敛时,该模型可用于评估新帖子的可信度。如果模型的重建误差超过了一定的阈值,那么这个帖子可能是假消息。杨等人。 [191]将新闻真实性和用户可信度视为潜在变量,并利用用户评论来推断他们对新闻真实性的看法。换句话说,新闻的真实性取决于用户观点的可信度,观点的可信度取决于用户的声誉。他们利用贝叶斯网络对交互过程进行建模,以在没有任何标记数据的情况下推断新闻文章的真实性。实际上,用户的观点可能会受到其他用户的影响,他们对不同主题的虚假信息的识别能力也不同。在使用 PGM 时可以进一步考虑这些条件。

- 混合学习模型。混合学习模型的发展,将线性模型和深度学习模型相结合,已经成为人工智能的一个新的研究趋势,即显性特征和潜在特征的结合使用。它利用了两种学习模型的互补性。例如,Wide & Deep [24] 是一个性能良好的推荐系统框架,其中 Wide 部分提取显式特征,Deep 部分学习非线性的潜在特征。 FID中也有初步的混合学习模型。杨等人。 [192] 提出了用于检测错误信息的 TI-CNN 模型,该模型基于显式和隐式特征空间的融合,对文本和视觉信息进行联合训练。此外,张等人。 [197] 提出了一种基于贝叶斯深度学习的 FID 模型,该模型使用 LSTM 对断言(声明)和用户评论进行编码,并利用贝叶斯模型来推断分类结果。由于混合学习模型还处于早期阶段,需要在这个方向上进一步研究,例如概率图模型和深度学习模型的融合。

(5) FID模型中的对抗性攻击和防御。

基于深度学习的 FID 模型有助于有效提高事实检查性能。然而,Szegedy 等人。 [169] 已经证明,经过训练的神经网络可能无法抵抗对抗性攻击,这意味着向输入向量添加一些小扰动可能会使模型得到错误的结果 [4]。现有的 FID 研究很少强调可以被对抗性攻击欺骗的深度模型的稳健性。

尽管对 FID 模型中的对抗性攻击和防御的研究很少,但有关其他任务的相关工作(如图像分类 [52、169]、语音识别 [15]、文本分类 [86] 和强化学习 [10])已被调查。有几项工作侧重于对抗性攻击对模型的影响。例如,戴等人。 [28] 提出了一种基于强化学习 (RL) 的图数据对抗性攻击方法,该方法通过增加或减少图中边的数量来学习最优攻击策略。为了为文本生成普遍的对抗性扰动,Behjati 等人。 [9]提出了一种基于梯度投影的攻击方法。贾等人。 [71] 通过在不会对人类理解造成困难的问题中添加句子或短语来攻击问答系统。

尽管对 FID 模型中的对抗性攻击和防御的研究很少,但有关其他任务的相关工作(如图像分类 [52、169]、语音识别 [15]、文本分类 [86] 和强化学习 [10])已被调查。有几项工作侧重于对抗性攻击对模型的影响。例如,戴等人。 [28] 提出了一种基于强化学习 (RL) 的图数据对抗性攻击方法,该方法通过增加或减少图中边的数量来学习最优攻击策略。为了为文本生成普遍的对抗性扰动,Behjati 等人。 [9]提出了一种基于梯度投影的攻击方法。贾等人。 [71] 通过在不会对人类理解造成困难的问题中添加句子或短语来攻击问答系统。

(6) 解释性检测模型。

提供决策结果的证据或解释可以增加用户对检测模型的信任。尽管关于解释性 FID 模型的工作很少,但解释的应用已经在其他相关领域进行了研究,例如推荐系统。

可解释的推荐,它解释了为什么推荐一个项目,近年来引起了越来越多的关注[198]。它可以提高用户对推荐系统的接受度、可信度和满意度,增强系统的说服力。例如,陈等人。 [23] 提出了一种基于注意力神经网络的视觉上可解释的推荐方法来模拟用户对图像的注意力。用户可以通过提供个性化和直观的视觉亮点来理解为什么推荐产品。凯瑟琳等人。 [18] 研究如何在外部知识图谱的支持下生成可解释的推荐,他们提出了一种个性化的 PageRank 程序来对项目和知识图谱实体进行排序。王等人的工作。 [181]提出了一种基于强化学习(RL)的与模型无关的解释性推荐系统,可以灵活控制解释的呈现质量。最重要的是,这种可解释的推荐系统中使用的方法可以启发我们设计更好的可解释 FID 系统。

从更高的角度来看,机器学习模型在不同的应用领域(除了推荐系统和 FID)推动了突破。尽管取得了巨大的成功,但我们仍然缺乏对其内在行为的理解,例如分类器如何得出特定的决定。这导致了可解释机器学习(IML)的研究方向激增。 IML 使机器学习模型能够以人类可理解的术语进行解释或呈现 [2, 34]。杜等人。 [35] 定义了两种类型的可解释性:模型级解释和预测级解释。模型级解释,为了增加模型本身的透明度,可以阐明机器学习模型的内部工作机制。预测级解释有助于揭示特定输入和模型输出之间的关系。对于 FID,它更关注预测级别的解释,这可以说明如何做出决定(使用来源可靠性、证据和立场等要素)。构建预测级可解释模型的代表性方案是采用注意力机制,该机制被广泛用于解释由序列模型(例如 RNN)做出的决策结果。我们还应该研究源自 IML 的其他方法,以增强 FID 系统的可解释性。

(7) 群体智慧的集合。

对于FID系统来说,如何聚集人群智慧是很重要的,因为人群贡献数据往往存在噪声。大多数用户的意见可以有效地用于识别虚假信息,但也存在真相掌握在少数人手中的情况。因此,未来仍有必要探索FID群体智慧的聚集与优化方法。

我们可以从真相发现系统中学习。随着人类智能从相互冲突的多源数据中提取可靠信息的能力,真相发现已经成为一个越来越重要的研究课题。对于FID,我们也有多篇关于一个事件的帖子,目标是确定这个事件的真相。因此,这两个研究问题之间有相似之处,我们可以借鉴真相发现系统的知识来促进FID。例如,Liu等人[98]提出了一种专家验证辅助的图像标签真相发现方法,旨在尽可能从嘈杂的众包标签中推断出正确的标签。特别是,它以人机协作的方式使用半监督学习算法,可以最大限度地发挥专家标签的影响,减少专家的工作量。Zhang等人[196]提出了一个基于概率图的真相发现模型,名为“TextTruth”,该模型通过全面学习关键因素(一组关键字)的可信度来选择问题的高度可信答案。TextTruth以无监督的方式推断答案提供者的可信度和答案因素的可信度。Yin等人[193]提出了一种以无监督方式聚集人群智慧的模型,称为标签感知自动编码器(LAA),它提取多源标签的基本特征和模式,并通过分类器和重构器推断出可信的标签。为了应对同一信息源在不同主题上具有不同可信度的挑战,Ma等人[105]提出了一种名为FaithCrowd的众包数据聚合方法。FaithCrowd通过在概率贝叶斯模型上对问题内容和出版商的答案进行建模,共同学习问题的主题分布、答案提供者基于主题的知识以及真实答案。

(8) 社交机器人的传播。

现有的 FID 研究集中于声明的内容和传播模式。但是,发布和传播帖子的“帐户”的特征没有得到很好的调查。最近,已经做出了一些努力来研究虚假信息像病毒一样迅速传播的根本原因。例如,邵等人。 [155] 对 2016 年美国总统大选期间的 1400 万条推文进行了详细分析,他们观察到“社交机器人”显然促进了虚假信息的快速传播。社交机器人通常是指为了某种目的而模仿人类交互行为(例如,制作内容、关注其他帐户、转发帖子等)的计算机算法或软件程序 [40]。这些恶意机器人帐户在虚假推文传播的早期阶段异常活跃。此外,在对社交机器人的社交互动和情感互动进行建模之后,Stella 等人。 [167] 发现它们增加了社交网络上负面和暴力内容的曝光率。

上述研究结果表明,抑制社交机器人可能是减轻虚假信息传播的一种有希望的方式。一些研究人员分析了社交机器人的行为模式并提出了一些检测方法。例如,费拉拉等人。 [40]将现有的社交机器人检测方法分为四类,包括基于图的模型、众包、基于特征的模型和混合模型。阿尔马图格等人。 [5] 设计了一种社交机器人检测方法,该方法结合了内容属性、社交互动和个人资料属性。同样,Minnich 等人。 [115] p r o p o s e BotWalk 检测方法,该方法利用多种特征将用户与机器人帐户区分开来,例如元数据、内容、时间信息和网络交互。克雷斯奇等人。 [27]对社交机器人的集体行为进行了深入分析,并介绍了一种用于垃圾邮件检测的社交指纹技术。特别是,他们利用数字 DNA 技术来描述所有账户的集体行为,然后他们提出一种受 DNA 启发的方法来识别真实帐户和垃圾邮件机器人。克雷斯奇等人。 [26] 还利用组帐户的特征来检测恶意机器人。随着社交机器人促进低可信度陈述的传播和负面内容的曝光 [155, 167],未来的工作可以将 FID 与社交机器人检测结合起来,为快速驳斥虚假信息提供新的解决方案。

(9) 虚假信息缓解。

有效的FID是防止虚假信息的一部分,也需要科学研究来减少虚假信息的影响,属于虚假信息缓解的研究范围。一些研究综述了虚假信息缓解和干预的方法。例如,Sharma等人[156]从信息扩散的角度总结了三种缓解方法,即“去污”、“竞争级联”和“多级干扰”舒等人[159]将现有的缓解策略分为“用户识别”、“网络规模估计”和“网络干预”由于每个用户在传播虚假信息时扮演着不同的角色,如意见领袖、监护人、恶意传播者和旁观者,因此有必要采取灵活的缓解措施。例如,建议意见领袖和监护人提供事实信息,以帮助传播真相[175],而应遏制恶意账户或机器人[122]。正如Ozturk等人[125]所说,在Twitter上显示带有事实核查信息的虚假消息有助于减少虚假信息的持续传播。基于这一观察,Budak等人[13]提出了多战役独立级联模型,该模型包含虚假信息战役和真实信息战役。此外,我们还可以利用多元霍克斯过程[37]来模拟外部干预影响下虚假信息的传播动力学。

在未来的研究中,FID可以与上述缓解策略相结合,探索在防止社交网络上传播虚假信息方面更具前景的工作。此外,Sundar[168]曾证实,社交帖子中来源归属的存在提高了用户对在线信息可信度和质量的感知。因此,来源归因和因果推断[158]也可用于指导社交媒体上虚假信息的检测。

6 结论

本文系统地回顾了FID的研究动态。在简要回顾了FID的文献后,我们提出了几个新的研究挑战和技术,包括早期检测、多模态数据融合检测和解释性检测。我们进一步研究了群体智能在FID中的应用,包括基于群体智能的FID模型和人机混合FID模型。虽然FID的研究已经取得了很大的进展,但它仍处于早期阶段,有许多开放的研究问题和有前途的研究方向有待研究,例如模型对新事件的适应性\通用性,采用新的机器学习模型,解释性检测模型等。