面试文档(自用)

Redis知识

Redis为什么这么快

Redis为什么这么快

答案:

- redis是纯内存操作:数据存放在内存中,内存的响应时间大约是100纳秒,这是Redis每秒万亿级别访问的重要基础。

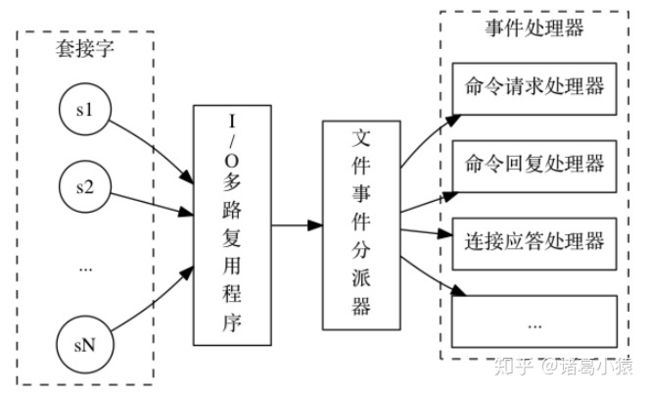

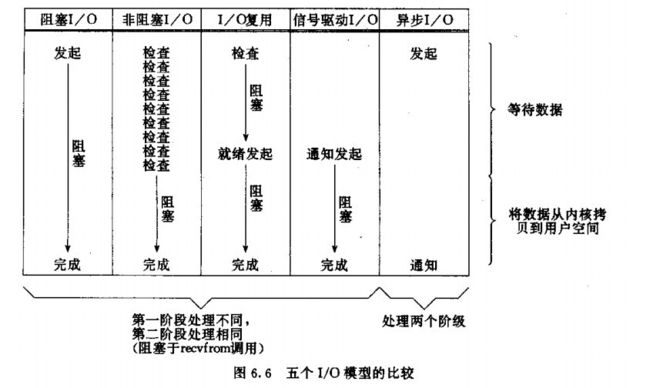

- 非阻塞I/O:Redis采用epoll做为I/O多路复用技术的实现,再加上Redis自身的事件处理模型将epoll中的连接,读写,关闭都转换为了时间,不在I/O上浪费过多的时间。

- 单线程避免了线程切换和竞态产生的消耗。

Redis采用单线程模型,每条命令执行如果占用大量时间,会造成其他线程阻塞,对于Redis这种高性能服务是致命的,所以Redis是面向高速执行的数据库

Redis的主要缺点是数据库容量受到物理内存的限制,不能作海量数据的高性能读写,因此Redis适合的场景主要局限在较小的数据量的高性能操作和运算。

Redis系列之 缓存穿透,缓存击穿,缓存雪崩

Redis系列之 缓存穿透,缓存击穿,缓存雪崩

-

缓存穿透:

是指缓存和数据库中没有数据,而用户不断发起请求,过多的请求会导致数据库压力过大而宕机。

- 解决方法:Cache null策略,布隆过滤器

-

缓存击穿

是指缓存中没有但数据库中有的数据(一般是缓存时间到期),这时由于并发用户特别多,同时读缓存没读到数据,又同时去数据库去取数据,引起数据库压力瞬间增大,造成过大压力

- 解决办法:设置热点数据不过期,分布式锁

-

缓存雪崩

是指缓存中数据大批量到过期时间,而查询数据量巨大,引起数据库压力过大甚至down机。和缓存击穿不同的是,缓存击穿指并发查同一条数据,缓存雪崩是不同数据都过期了,很多数据都查不到从而查数据库。

- 解决办法:数据预热,缓存过期时间随机,Redis集群

Redis有哪几种数据结构

Redis支持5种数据类型:String(字符串)、hash(哈希)、list(列表)、set(集合)、zset(有序集合)、 Bitmap 、HyperLogLog 、 Geospatial

-

String一个

key对应一个valueString类型是二进制安全的,因此redis的string可以包含任何数据,比如jpg图片或者序列化对象String类型的值最大能存储512MB常用命令:

get、set、decr、incr、mget等 -

hashhash是一个键值对集合:是一个String类型的field和value的映射表hash特别适合用于存储对象每个

hash可存储2^(32-1)键值对常用命令:

hget、hset、hgetall等 -

listlist是一个简单的字符串列表、按照插入顺序排序,你可以添加一个元素到列表的头部或者尾部list类型经常会被用于消息队列的服务、以完成多程序之间的消息交换列表最多可存储

2^(32-1)个元素常用命令:

lpush、rpush、lpop、rpop、lrange等 -

setset也是一个字符串列表,和列表不同的是,在插入和删除时会判断是否存在了该元素。集合的最大的优势在于可以进行交集并集差集操作。集合是通过hash表实现的,因此,添加,删除,查找的复杂度都是o(1)应用场景:

- 利用交集求共同好友。

- 利用唯一性,可统计访问网站的所有独立

IP。 - 好友推荐的时候根据

tag求交集,大于某个thresold就可以推荐

集合最多可存储

2^(32-1)个元素常用命令:

sadd、spop、smembers、sunion等 -

zset和

set一样是String类型元素的集合,且不允许重复的成员。不同的是每个元素都会关联一个double类型的分数。redis正是通过分数来为集合中的成员进行从小到大的排序。zset的成员是唯一的,但分数却可以重复。应用场景:

- 例如存储全班同学的成绩,其集合

value可以是同学的学号、而score就可以是成绩 - 排行榜应用,根据得分列出

topN的用户等。

常用命令:

zadd、zrange、zrem、zcard等 - 例如存储全班同学的成绩,其集合

-

Bitmap通过操作二进制位记录数据。

-

HyperLogLog被用于估计一个set中元素数量的概率性数据结构

-

Geospatial被用于地理空间关系计算

Redis的淘汰策略

六种淘汰策略

volatile-lru:从设置了过期时间的数据集中,选择最近最久未使用的数据释放

allkeys-lru:从数据集中(包括设置过期时间以及未设置过期时间的数据集中释放),选择最近最久未被使用的数据释放

volatile-random:从设置了过期时间的数据集中,随机选择一个数据进行释放

allkeys-random:从数据集中(包括了设置过期时间以及未设置过期时间)随机选择一个数据进行入释放

volatile-ttl:从设置了过期时间的数据集中,选择马上就要过期的数据进行释放操作;

noeviction:不删除任意数据(但redis还会根据引用计数器进行释放),这时如果内存不够时,会直接返回错误。

默认的内存策略是noeviction,在Redis中LRU算法是一个近似算法,默认情况下,Redis随机挑选5个键,并且从中选取一个最近最久未使用的key进行淘汰,在配置文件中可以通过maxmemory-samples的值来设置redis需要检查key的个数,但是检查的越多,耗费的时间也就越久,但是结构越精确(也就是Redis从内存中淘汰的对象未使用的时间也就越久~),设置多少,综合权衡。

**一般来说,推荐使用的策略是volatile-lru,并辨识Redis中保存的数据的重要性。**对于那些重要的,绝对不能丢弃的数据(如配置类数据等),应不设置有效期,这样Redis就永远不会淘汰这些数据。对于那些相对不是那么重要的,并且能够热加载的数据(比如缓存最近登录的用户信息,当在Redis中找不到时,程序会去DB中读取),可以设置上有效期,这样在内存不够时Redis就会淘汰这部分数据。

Redis的持久化

Redis的持久化策略有两种:

-

RDB:快照形式是直接把内存中的数据保存到一个dump文件中,定时保存。 -

AOF:把所有的对Redis的服务器进行修改的命令都存在一个文件里,命令的集合 -

RDB的优缺点:

-

优点:

- 对性能的影响最小,

Redis在保存RDB快照时会fork出子进程进行,几乎不影响Redis处理客服端请求的效率。 - 每次快照都会生成一个完整的数据快照文件,所以**可以辅助其他手段保存多个时间点的快照(**例如把每天0点的快照备份至其他存储媒介中)

- 作为非常可靠的灾难恢复手段。使用

RDB文件进行数据恢复要比使用AOF要快很多。

- 对性能的影响最小,

-

缺点:

- 快照是定期生成的,所以在

Redis crash时或多或少会丢失一部分数据 - 如果数据集非常大且

cpu不够强(比如单核cpu),Redis在fork子进程时可能会消耗相对较长的时间,影响Redis对外提供服务的性能。

- 快照是定期生成的,所以在

-

AOF的原理

AOF提供了三种

fsync配置,always/everysec/no,通过配置项[appendfsync]指定:appendfsync no:不进行fsync,将flush文件的时机交给OS决定,速度最快appendfsync always:每写入一条日志就进行一次fsync操作,数据安全性最高,但速度最慢appendfsync everysec:折中的做法,交由后台线程每秒fsync一次随着

AOF不断地记录写操作日志,因为所有的操作都会记录,所以必定会出现一些无用的日志。大量无用的日志会让AOF文件过大,也会让数据恢复的时间过长。不过Redis提供了AOF rewrite功能,可以重写AOF文件,只保留能够把数据恢复到最新状态的最小写操作集。AOF rewrite可以通过BGREWRITEAOF命令触发,也可以配置Redis定期自动进行:auto-aof-rewrite-percentage 100auto-aof-rewrite-min-size 64mb上面两行配置的含义是,

Redis在每次AOF rewrite时,会记录完成rewrite后的AOF日志大小,当AOF日志大小在该基础上增长了100%后,自动进行AOF rewrite。同时如果增长的大小没有达到64mb,则不会进行注意:

Rewrite原理 : AOF文件持续增长而过大时,会fork出一条新进程来将文件重写(也是先写临时文件最后再rename)。遍历新进程的内存中数据,每条记录有一条的Set语句。重写aof文件的操作,并没有读取旧的aof文件,而是将整个内存中的数据库内容用命令的方式重写了一个新的aof文件,这点和快照有点类似。

-

AOF的优缺点

-

优点:

- 最安全,在启用

appendfsync always时,任何已写入的数据都不会丢失,使用在启用appendfsync everysec也至多只会丢失1秒的数据。AOF文件在发生断电等问题时也不会损坏,即使出现了某条日志只写入了一半的情况,也可以使用redis-check-aof工具轻松修复。AOF文件易读,可修改,在进行了某些错误的数据清除操作后,只要AOF文件没有rewrite,就可以把AOF文件备份出来,把错误的命令删除,然后恢复数据。

- 最安全,在启用

-

缺点:

-

AOF文件通常比RDB文件更大性能消耗比RDB高数据恢复速度比RDB慢Redis的数据持久化工作本身就会带来延迟,需要根据数据的安全级别和性能要求制定合理的持久化策略:AOF + fsync always的设置虽然能够绝对确保数据安全,但每个操作都会触发一次fsync,会对Redis的性能有比较明显的影响AOF + fsync every second是比较好的折中方案不过大多数应用场景下,建议至少开启

RDB方式的数据持久化。Redis对于数据备份是非常友好的, 因为你可以在服务器运行的时候对RDB文件进行复制:RDB文件一旦被创建, 就不会进行任何修改。 当服务器要创建一个新的RDB文件时, 它先将文件的内容保存在一个临时文件里面, 当临时文件写入完毕时, 程序才使用rename(2)原子地用临时文件替换原来的RDB文件。

-

Redis的过期策略

1.设置过期时间

- expire key time—这是最常用的方式

- setex(String key,int seconds,String value) —字符串独有的方式

注意:

- 除了字符串自己独有设置过期时间的方法外,其他方法都需要依靠expire方法来设置时间

- 如果没有设置时间,那缓存就是永不过期

- 如果设置了过期时间,之后又想让缓存永不过期,使用persist key

2.三种过期策略

-

定时删除

- 含义:在设置key的过期时间的同时,为该key创建一个定时器,让定时器在key的过期时间来临时,对key进行删除

- 优点:保证内存被尽快释放

- 缺点:

- 若过期key很多,删除这些key会占用很多的CPU时间,在CPU时间紧张的情况下,CPU不能把所有的时间用来做要紧的事儿,还需要去花时间删除这些key

- 定时器的创建耗时,若为每一个设置过期时间的key创建一个定时器(将会有大量的定时器产生),性能影响严重

- 没人用

-

惰性删除

- 含义:key过期的时候不删除,每次从数据库获取key的时候去检查是否过期,若过期,则删除,返回null。

- 优点:删除操作只发生在从数据库取出key的时候发生,而且只删除当前key,所以对CPU时间的占用是比较少的,而且此时的删除是已经到了非做不可的地步(如果此时还不删除的话,我们就会获取到了已经过期的key了)

- 缺点:若大量的key在超出超时时间后,很久一段时间内,都没有被获取过,那么可能发生内存泄露(无用的垃圾占用了大量的内存)

-

定期删除

- 含义:每隔一段时间执行一次删除过期key操作

- 优点:

- 通过限制删除操作的时长和频率,来减少删除操作对CPU时间的占用–处理"定时删除"的缺点

- 定期删除过期key–处理"惰性删除"的缺点

- 缺点

- 在内存友好方面,不如"定时删除"

- 在CPU时间友好方面,不如"惰性删除"

- 难点

- 合理设置删除操作的执行时长(每次删除执行多长时间)和执行频率(每隔多长时间做一次删除)(这个要根据服务器运行情况来定了)

3.Redis采用的过期策略

惰性删除+定期删除

- 惰性删除流程

- 在进行get或setnx(当key不存在时设置value)等操作时,先检查key是否过期

- 若过期,删除key,然后执行相应操作

- 若没过期,则直接执行相应操作

- 定期删除流程(简而言之,就是对指定个数的数据库的每一个库随机删除小于等于指定个数的过期key)

- 遍历每个数据库(redis.conf中配置的

database数量,默认为16)- 检查当前库中的指定个数个key(默认每个库检查20个key,相当于循环下面的操作20次)

- 如果当前库中没有一个key设置了过期时间,直接执行下一个库的遍历

- 随机获取一个设置了过期时间的key,检查该key是否过期,如果过期,删除key

- 判断定期删除操作是否已经到达时长,若已经到达,直接退出定期删除。

- 检查当前库中的指定个数个key(默认每个库检查20个key,相当于循环下面的操作20次)

- 遍历每个数据库(redis.conf中配置的

- 注意:

- 对于定期删除,在程序中有一个全局变量current_db来记录下一个将要遍历的库,假设有16个库,我们这一次定期删除遍历了10个,那此时的current_db就是11,下一次定期删除就从第11个库开始遍历,假设current_db等于15了,那么之后遍历就再从0号库开始(此时current_db==0)

4.RDB对过期key的处理

过期key对RDB没有任何影响

- 从内存数据库持久化数据到RDB文件

- 持久化key之前,会检查是否过期,过期的key不进入RDB文件

- 从RDB文件恢复数据到内存数据库

- 数据载入数据库之前,会对key先进行过期检查,如果过期,不导入数据库(主库情况)

5.AOF对过期key的处理

过期key对AOF没有任何影响

- 从内存数据库持久化数据到AOF文件:

- 当key过期后,还没有被删除,此时进行执行持久化操作(该key是不会进入aof文件的,因为没有发生修改命令)

- 当key过期后,在发生删除操作时,程序会向aof文件追加一条del命令(在将来的以aof文件恢复数据的时候该过期的键就会被删掉)

- AOF重写

- 重写时,会先判断key是否过期,已过期的key不会重写到aof文件

Redis管道

Redis是基于请求/响应协议的TCP服务,在客服端向服务器发送一个查询请求时,需要监听socket的返回,该监听过程一直阻塞,直到服务器有结果返回。由于Redis集群通常部署在不同服务器上,所以每次查询都会存在一定的网络延迟,多次请求的话可能会使延迟累加,使得Redis性能大大下降,因此Redis提出了管道技术

Redis管道技术,允许在服务器未响应的时候,连续多次发送多个请求,并最终一次性读取所有服务器的响应。这样能显著提升Redis的性能。

Redis事务

Redis支持分布式环境下的事务操作,其事务可以一次执行多个命令,事务中的所有命令都会序列化地顺序执行。

Redis的事务执行流程如下:

- 事务开启:客服端执行Multi命令开启事务

- 提交请求:客服端提交命令到事务

- 任务入队列:Redis将客服端请求放入事务队列中等待执行

- 入队状态反馈:服务器返回QURUD,表示命令已被放入事务队列

- 执行命令:客服端通过Exec执行事务

- 事务执行错误:在Redis事务中如果某条命令执行错误,则其他命令会继续执行,不会回滚。可以通过watch监控事务的执行状态并处理命令执行错误的异常情况。

- 执行结果反馈:服务器向客服端返回事务执行的结果。

| 命令 | 说明 |

|---|---|

| Multi | 标记一个事务块的开始 |

| Exec | 执行所有事务块内的命令 |

| Discard | 取消事务,放弃执行事务块内的所有命令 |

| Watch | 监视一个key,在事务执行之前如果这个key被其他命令改动,那么事务将被打断 |

| UnWatch | 取消watch命令对所有key的监视 |

Redis发布 订阅

Redis发布/订阅是一种消息通信模式,发送者(pub)向频道(Channel)发送消息,订阅者(Sub)接收频道上的消息。

Redis的集群模式及工作原理

Redis有三种集群模式:主从模式、哨兵模式、和集群模式。

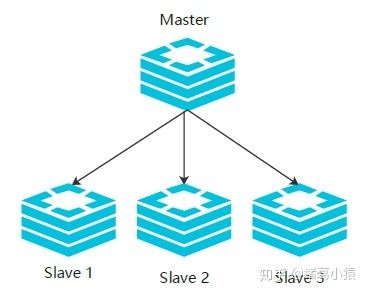

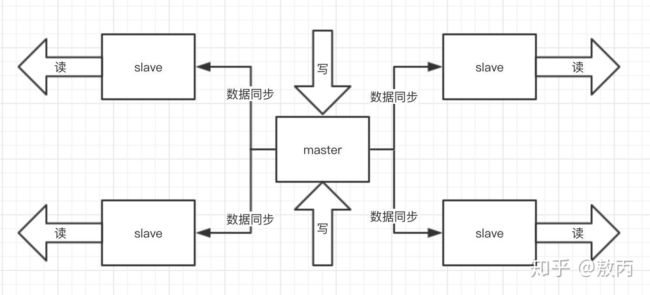

(1)主从模式:

所有的写请求都被发送到主数据库上,再由主数据库将数据同步到从数据库上,主数据库主要用于执行写操作和数据同步,从数据库主要用于执行读操作,缓解系统的压力。

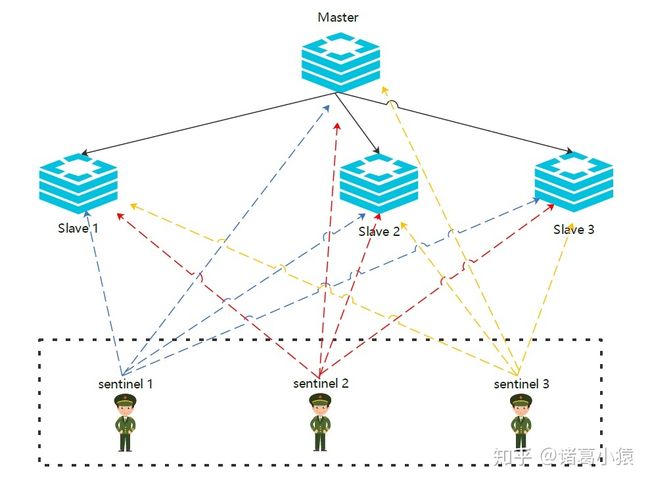

(2)哨兵模式

在主从模式上添加一个哨兵的角色来监控集群的运行状态。哨兵通过发送命令让Redis服务器返回其运行状态。哨兵是一个独立运行的进程,在监测到Master宕机时会自动将Slave切换成Master,然后通过发布/订阅模式通知其他从服务器修改其配置文件。完成主备热切。

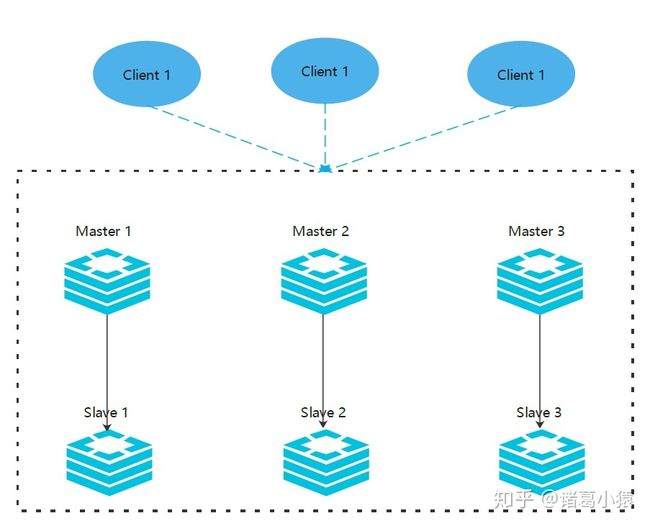

(3)集群模式

Redis集群实现了在多个Redis节点之间进行数据分片和数据复制。

基于Redis集群的数据自动分片能力,我们能够方便的对Redis集群进行横向扩展,以提高Redis集群的吞吐量。

基于Redis集群的数据复制能力,在集群中的一部分节点失效或者无法进行通信时,Redis任然可以基于副本数据对外提供服务,这提高了集群的可用性。

Redis 集群数据复制的原理

1)若启动一个Slave机器进程,则它会向Master机器发送一个“sync command”命令,请求同步连接。

2)无论是第一次连接还是重新连接,Master机器都会启动一个后台进程,将数据快照保存到数据文件中(执行rdb操作),同时Master还会记录修改数据的所有命令并缓存在数据文件中。

3)后台进程完成缓存操作之后,Maste机器就会向Slave机器发送数据文件,Slave端机器将数据文件保存到硬盘上,然后将其加载到内存中,接着Master机器就会将修改数据的所有操作一并发送给Slave端机器。若Slave出现故障导致宕机,则恢复正常后会自动重新连接。

4)Master机器收到Slave端机器的连接后,将其完整的数据文件发送给Slave端机器,如果Mater同时收到多个Slave发来的同步请求,则Master会在后台启动一个进程以保存数据文件,然后将其发送给所有的Slave端机器,确保所有的Slave端机器都正常。

如果在主从复制过程中遭遇连接断开,则重新连接之后可以从中断处继续进行复制,而不必重新同步。

断点续传的工作原理具体如下。

主服务器端为复制流维护一个内存缓冲区(in-memory backlog)。主从服务器都维护一个复制偏移量(replication offset)和master run id。当连接断开时,从服务器会重新连接上主服务器,然后请求继续复制,假如主从服务器的两个master run id相同,并且指定的偏移量在内存缓冲区中还有效,则复制就会从上次中断的点开始继续。如果其中一个条件不满足,就会进行完全重新同步(在2.8版本之前就是直接进行完全重新同步)。

Redis 集群方案

1.codis

目前使用最多的集群方案,基本和twemproxy一致的效果,但它支持在结点数量改变的情况下,旧结点数据可恢复到新hash节点。

Codis分片机制:

Codis默认所有的key划分为1024个slot,对客户端传入的key做crc32运算计算hash值,再将hash后的整数值对1024取模获取key的slot。codis会在内存中维护slot与redis实例的对应关系。根据映射关系将数据转发到对应的实例。

codis集群通过对zk与etcd的支持来保证数据的一致性,如果是依赖zk,那么codisProxy的slot关系信息会存储在zk节点上,通过zk的监听机制来共享slot信息。

如何扩容:

进行扩容,意味着集群中增加新的redis实例,这时slot与实例的映射关系需要调整,意味着一部分数据需要进行迁移。

首先第一个问题是,我们需要找到槽位对应的所有key。codis增加了slotsscan命令,可以遍历指定slot下所有的key。然后挨个将每个key迁移到新的redis节点。迁移过程中,codis收到新请求,如果是查询key,那么会强制先完成迁移工作,然后再提供对外服务。

最后一点,迁移操作是一个move操作,即迁移完成后,旧实例中就不存在key了。

自动均衡机制:

redis新增实例,手动均衡slot比较麻烦,所以codis提供了自动均衡机制。自动均衡机制会在系统空闲时观察每个实例对应的slot数量,不平衡会自动进行迁移。

Codis的劣势

1.使用codis扩容的机器,redis不再支持事务。

2.rename这种危险的命令也不支持。官方文档中提供了不支持的命令列表。

3.为了支持迁移,单个key对应的value不宜过大。过大会导致迁移卡顿,官方建议小于1M,所以不适合存放社交关系数据等等。

4.网络开销比单个实例要大,性能略微下降。可以通过增加代理数量来弥补性能不足。

5.如果依赖zk,那么会增加zk运维成本。

Codis的优势

1.设计上比官方的redis cluster方案要简单。

2.托管给zk或者etcd,省去了分布式一致性逻辑。

问题:mget查询多个key的场景,codis会将key按照映射关系分组,然后对涉及的redis执行mget,最后由codis汇总返回。

分布式缓存设计的核心问题

缓存预热

指用户在请求数据前,先将数据加载到缓存系统中,用户查询事先被预热的缓存数据,以提高系统的查询效率。

缓存更新

缓存更新是指在数据变化后及时将变化后的数据更新到缓存中。常见的缓存更新策略有以下4种:

- 定时更新:定时将底层数据库的内容更新到缓存系统中

- 过期更新:将缓存种过期的数据更新为最新数据并更新缓存的过期时间

- 写请求更新:在用户有写请求时先写数据库同时更新缓存

- 读请求更新:有读请求时,如果缓存数据不存在或者过期,将底层数据库的查询结果更新到缓存中。

缓存淘汰策略

- FIFO(先进先出):判断被存储的时间,离目前最远的数据优先被淘汰

- LRU(最近被使用):判断缓存最近被使用的时间,距离当前时间最远的数据优先被淘汰。

- LFU(最不经常使用):在一段时间内,被使用次数最少的缓存优先被淘汰。

缓存雪崩

大量的缓存同一时间失效,造成数据库的压力过大进而可能发生宕机的现象。

解决办法:

- 请求加锁

- 失效更新

- 设置不同的失效时间

缓存穿透

缓存穿透是指由于缓存系统故障或者用户频繁查询系统中不存在的数据,导致请求穿过缓存系统不断发送到数据库,造成数据库过载的现象。

解决方法:

- 布隆过滤器:会过滤掉不存在数据请求的请求

- Cache null策略:在缓存中也缓存null这个数据。

缓存降级

是指由于访问量剧增,为保证核心业务的正常运行,减少或关闭非核心业务对资源的使用,常见的策略如下:

- 写降级:写请求增大,可以先只对Cache更新,事后在异步更新到数据库中。

- 读降级:只对Cache进行读取,并将结果返回给用户,适用于对数据实时性要求不高的场景。

Redis系列之事务及乐观锁

参考知乎文章

在redis中,是有事务的。但是redis的事务是弱事务。事务没有隔离级别,事务中的多条命令也不是原子性的

redis的事物使用有三步:

- 开启事物 (multi)

- 命令入队 (需要执行的命令写入队列,先进先出,队列中是一组命令。)

- 执行事物 (exec)

事物开启后,也可以取消事物(discard):

编译时报错,是因为队列中的命令本身有问题,导致在命令入队的时候就报错;有编译错误的时候,执行exec会提示失败,所有的命令都不能执行。

运行时错误,是入栈的命令本身没有错误,但是在出队执行的时候报错,比如对String做自增操作。

运行时报错了,但是事物不会回滚,而且,出错后不会影响后续的命令执行,只会有出错的那一条命令执行失败。所以,对于队列中的命令,是不存在原子性的。

redis的事物没有隔离性,

Redis使用watch实现了一个乐观锁。

Redis系列之分布式锁

redis系列之——分布式锁

什么是分布式锁

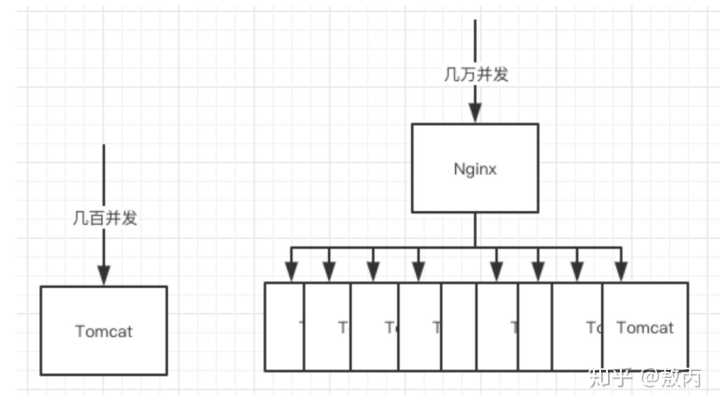

先说一个场景,消费者在购物网站上下单或收银员在POS机上下单,由于网络等问题,在连续点击了两下,后端网站如何处理,如何响应?对于这个问题,前端需要处理,后端也需要处理。这里主要说后端,后端不光要处理重复订单问题,还有处理幂等问题。幂等问题简单来说就是相同的请求,要有相同的响应结果,这里就不展开了。重复订单该如何处理?

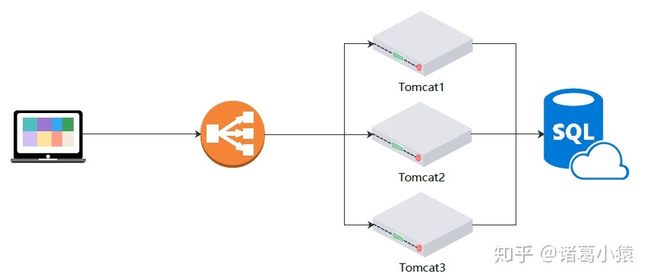

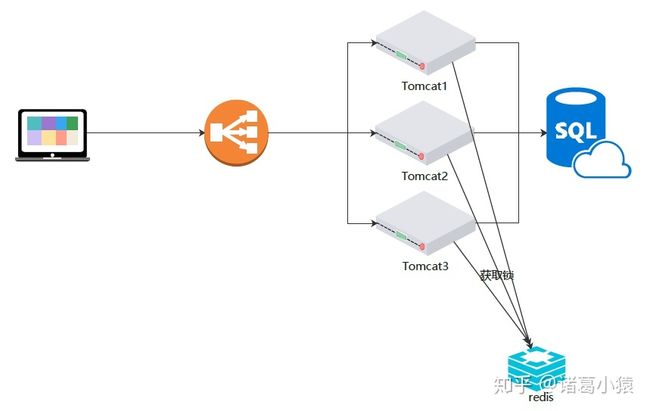

对于一个小的访问量不大的网站,部署了一个tomcat,这个问题可以简单的通过JVM提供的同步锁synchronized实现。但是当网站访问量越来越大时,需要扩展机器,synchronized就不能起作用了。相同的下单参数连续两次请求后端服务器,可能会被分发到两个tomcat上,就会出现synchronized失效问题。

幂等操作:

在编程中,一个幂等操作的特点是其任意多次执行所产生的影响均与一次执行的影响相同。幂等函数,或幂等方法,是指可以使用相同参数重复执行,并能获得相同结果的函数。这些函数不会影响系统状态,也不用担心重复执行会对系统造成改变。例如,“getUsername()和setTrue()”函数就是一个幂等函数。用通俗的话讲:就是针对一个操作,不管做多少次,产生效果或返回的结果都是一样的

分布式锁要解决的就是多机器部署时,相同请求并发访问时资源竞争问题。请求到达每个tomcat时,首先要去redis中注册锁,注册成功返回true则说明获得了锁,可以继续处理相关的业务,处理完成后释放锁。同一时刻只能有一个tomcat能获得锁,其他没获得锁的tomcat则多次尝试继续获得锁,没有获得锁不能处理业务。获得锁的tomcat释放锁后,其他的tomcat才能有一个获得锁。

解决重复订单问题:

在请求进入方法前,加锁,往后的同一个请求(requestId相同)无法获取锁,就被判定为重复请求,抛出异常,等第一个请求调用完毕后再释放锁。

这里是使用redis做外部存储介质存储锁的,使用zookeeper也是类似的。万变不离其宗,原理都一样,只是技术选型有差别。

Redis系列之数据持久化(RDB和AOF)

Redis系列之数据持久化(RDB和AOF)

Redis数据类型之bitmaps

redis系列之——数据类型bitmaps:今天你签到了吗?

什么是bitmaps

来看看官方对Bitmaps的说明:

- Bitmaps 并不是实际的数据类型,而是定义在String类型上的一个面向字节操作的集合。因为字符串是二进制安全的块,他们的最大长度是512M,最适合设置成2^32个不同字节。

- bitmaps的位操作分成两类:1.固定时间的单个位操作,比如把String的某个位设置为1或者0,或者获取某个位上的值 2.对于一组位的操作,对给定的bit范围内,统计设定值为1的数目(比如人口统计)。

- bitmaps最大的优势是在存储数据时可以极大的节省空间,比如在一个项目中采用自增长的id来标识用户,就可以仅用512M的内存来记录40亿用户的信息(比如用户是否希望收到新的通知,用1和0标识)

简单来说bitmaps就是一个长度可变的bit数组。每个位只能存储0或1。我们先来看看bitmap的具体表示,当我们使用命令 setbit key (0,2,4,6) 1后,这个bit数组的具体表示为:

bit0bit1bit2bit3bit4bit5bit6bit710101010

一天的1亿人的登录情况(登录、未登录)就可以使用一个长度为1亿的bit数组存储,数组的索引就是用户的userId(假设userId是自增的)。

使用场景

由于bit数组的每个位置只能存储0或者1这两个状态;所以对于实际生活中,处理两个状态的业务场景就可以考虑使用bitmaps。如用户登陆/未登录,签到/未签到,关注/未关注,打卡/未打卡等。同时bitmap还通过了相关的统计方法进行快速统计。

由于bit数组的每个位置只能存储0或者1这两个状态;所以对于实际生活中,处理两个状态的业务场景就可以考虑使用bitmaps。如用户登陆/未登录,签到/未签到,关注/未关注,打卡/未打卡等。同时bitmap还通过了相关的统计方法进行快速统计。

内存占用比较

假如一个平台有8亿用户,平均日活跃用户有1亿,,分别使用List和Bitmap存储平台某一天是否活跃(登陆)用户时内存占用情况(1KB=1000bit):

数据类型每个userId占用空间需要存储的用户量内存使用总量List4 * 8bit=32bit(假设userId用的是int存储)100,000,00032bit * 100,000,000= 400MBBitmaps1bit800,000,0001bit * 800,000,000=100MB

假如一个平台有8亿用户,平均日活跃用户有100万,,分别使用List和Bitmap存储平台某一天是否活跃(登陆)用户时内存占用情况(1KB=1000bit):

数据类型每个userId占用空间需要存储的用户量内存使用总量List4 * 8bit=32bit(假设userId用的是int存储)1,000,00032bit * 1,000,000= 4MBBitmaps1bit800,000,0001bit * 800,000,000=100MB

所以并不是在所有的情况下,使用bitmap都是最好的选择。平台虽然有8亿用户,但是活跃的用户很少,这是使用Bitmaps,如果只有一个用户登录(加入是userId=800,000,000-1这个用户登录),也需要分配100MB的空间。

注意

bitmaps类型(string)最大长度为512M。 setbit时的偏移量很大时,可能会有较大耗时。 bitmaps不是绝对的好,有时可能更浪费空间。

Bloot Filter该怎么做,你是不是已经知道了?

完成,收工!!

Redis系列之数据类型geospatial

如何实现定位功能

说到定位,很多人第一反应应该是,实时上报经纬度,数据库中提前存储好所有的经纬度,然后用上报的经纬度和数据库中的经纬度进行比较,计算出附近的人或共享单车。这种做法需要循环遍历,数据库中的数据量大,查询慢,效率低。

那么,这些app是如何做到既能够精确定位,又能够实时查询的呢?答案就是使用geohash。redis的"数据类型"geospatial就能计算出geohash。redis使用geohash技术将实时上报的精度和纬度,通过一定的算法转化成最长12个字符的字符串,两个位置的经纬度计算的字符串的前缀越相同,则两个位置离得越近。这样一来就可以通过数据库的like加上geohash的前几位模糊查询数据库的数据了。比如ofo共享单车,数据库中用一张表t_bike专门存储ofo的每一辆车的编号no、经度longitude 、纬度latitude、geohash等字段,当每一辆车上报自己的经纬度时,同时计算一个geohash存到表中;当用户要用车时,上报用户的实时位置的经纬度,并计算一个hash值,比如hash=efgrtv98fjng,那么可以使用:

select * from t_bike where geohash like 'efgrtv98%'

就可以找到附近有多少车了。like后面使用的hash位数越多,查找的范围越准确。

查询的前提是开启实时定位功能。

Geohash技术

geohash技术就是将经纬度转换成最长12个字符的字符串,同时两个位置越近,生成的字符串的前缀越一致。这是如何实现的呢?

例如,东方明珠的经纬度,东经121.506377,北纬31.245105。

下面就以东方明珠为例,简单说一下如何将这两个经纬度计算成一个hash字符串的。

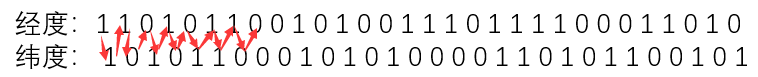

geohash的计算

1.使用二分法生成二进制

将纬度(-90,90)分成两个区间,(-90,0)和(0,90),如果目标纬度落在左边区间则记为0,否则记为1;再将目标纬度所在的那个区间在通过二分法分成两个相等的区间,如果目标纬度落在左边区间则记为0,否则记为1,以此类推。

同样的,将经度(-180,180)也通过这种方式计算。

最终,经度和纬度计算后,分别得到一个由0和1组成的二进制。

假如,东方明珠的经纬度计算后,得到两个二进制位:

经度:110101100101001110111100011010

纬度:101011000101010000110101100101

2.合并二进制

将上面的两个二进制按照“偶数位放经度,奇数位放纬度”的原则,从0位开始数起,合并成一个二进制。

可以理解成将纬度向后移动一位,然后将两行压成一行。

结果: 111001100111100000110011000110101000111110110001011010011001

3.二进制转换成十进制

把上面合并后的60位二进制,按照从左往右,每5位划分成1个组,如果最后一组如果不足5位就用0补齐到5位。分组后所示:

分组结果: 11100 11001 11100 00011 00110 00110 10100 01111 10110 00101 10100 11001

将上面的每组二进制分别转成十进制:

十进制结果: 28 25 28 3 6 6 20 15 22 5 20 25

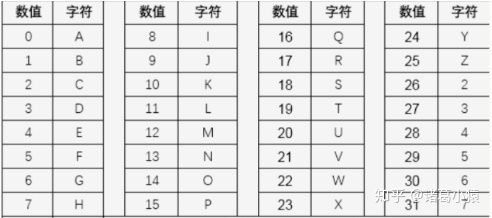

4.十进制转base32字符串

使用base32编码表,将每个十进制数替换成编码表中的字符,获得一个字符串。

base32编码表如下:

转化后的字符串:

base32字符串:4Z4CGGUPWFUZ

这就是模拟东方明珠的经纬度生产的geohash的值(不是真实值)。

geohash的精度

geohash这个字符串在地图上表示一个矩形的块。

hash的字符串长1位-12位,对应精度的级别1-12级。字符串越长,位置越精确。

上面模拟的东方明珠的hash有12位字符串,精度在37mm以内。上面可以看出,6位hash的精度在1.2km以内。所以当两个hash的前6位相同时,就可以将范围缩小到1.2km以内了。在实际的应用中,我们就可以通过调整精度级别控制搜索的范围。

geohash的区块中,同一个区块内部的点被认为是最近的。如下图,如果你在东方明珠圆圈的中心,搜索最近的便利店,你会搜索到A点,而搜索不到B点,虽然B点是最近的。这就是geohash的边界问题。这个该如何解决呢?

其实,就是将该区块上下左右以及四个对角的8个区块的hash都计算一遍,分别计算这些便利店和自己之间的距离,找到最近的一家。因为这是的数据量已经非常小了,计算周边的8个块也很快。

redis> GEOADD china:city 121.47 31.23 shanghai #添加上海的经纬度

(integer) 1

redis> GEOADD china:city 116.40 39.90 beijing #添加北京的经纬度

(integer) 1

redis> GEODIST china:city shanghai beijing km #计算上海和北京之间的直线距离

"1067.3788"

redis> GEORADIUS china:city 116 39 1500 km #找到离经纬度为116,39的位置1500km以内的地方有哪些 ,因为redis中只有两个城市,所以只能显示两个

1) "beijing"

2) "shanghai"

redis> GEOHASH china:city beijing #获得北京的geohash

1) "wx4fbxxfke0"

Redis系列之一致性hash算法

redis系列之——一致性hash算法

Redis系列之高可用(主从、哨兵、集群)

Redis系列之高可用(主从、哨兵、集群)

一,主从模式

一般,系统的高可用都是通过部署多台机器实现的。redis为了避免单点故障,也需要部署多台机器。

因为部署了多台机器,所以就会涉及到不同机器的的数据同步问题。

为此,redis提供了Redis提供了复制(replication)功能,当一台redis数据库中的数据发生了变化,这个变化会被自动的同步到其他的redis机器上去。

redis多机器部署时,这些机器节点会被分成两类,一类是主节点(master节点),一类是从节点(slave节点)。一般主节点可以进行读、写操作,而从节点只能进行读操作。同时由于主节点可以写,数据会发生变化,当主节点的数据发生变化时,会将变化的数据同步给从节点,这样从节点的数据就可以和主节点的数据保持一致了。一个主节点可以有多个从节点,但是一个从节点会只会有一个主节点,也就是所谓的一主多从结构。

二, 哨兵模式

主从模式下,当主服务器宕机后,需要手动把一台从服务器切换为主服务器,这就需要人工干预,费事费力,还会造成一段时间内服务不可用。这种方式并不推荐,实际生产中,我们优先考虑哨兵模式。这种模式下,master宕机,哨兵会自动选举master并将其他的slave指向新的master。

在主从模式下,redis同时提供了哨兵命令redis-sentinel,哨兵是一个独立的进程,作为进程,它会独立运行。其原理是哨兵进程向所有的redis机器发送命令,等待Redis服务器响应,从而监控运行的多个Redis实例。

哨兵可以有多个,一般为了便于决策选举,使用奇数个哨兵。哨兵可以和redis机器部署在一起,也可以部署在其他的机器上。多个哨兵构成一个哨兵集群,哨兵直接也会相互通信,检查哨兵是否正常运行,同时发现master宕机哨兵之间会进行决策选举新的master

哨兵模式的作用:

- 通过发送命令,让Redis服务器返回监控其运行状态,包括主服务器和从服务器;

- 当哨兵监测到master宕机,会自动将slave切换到master,然后通过发布订阅模式通过其他的从服务器,修改配置文件,让它们切换主机;

- 然而一个哨兵进程对Redis服务器进行监控,也可能会出现问题,为此,我们可以使用多个哨兵进行监控。各个哨兵之间还会进行监控,这样就形成了多哨兵模式。

哨兵很像kafka集群中的zookeeper的功能

三,集群模式

先说一个误区:Redis的集群模式本身没有使用一致性hash算法,而是使用slots插槽。这是很多人的一个误区。这里先留个坑,后面我会出一期《 redis系列之——一致性hash算法》。

Redis 的哨兵模式基本已经可以实现高可用,读写分离 ,但是在这种模式下每台 Redis 服务器都存储相同的数据,很浪费内存,所以在redis3.0上加入了 Cluster 集群模式,实现了 Redis 的分布式存储,对数据进行分片,也就是说每台 Redis 节点上存储不同的内容;

这里的6台redis两两之间并不是独立的,每个节点都会通过集群总线(cluster bus),与其他的节点进行通信。通讯时使用特殊的端口号,即对外服务端口号加10000。例如如果某个node的端口号是6379,那么它与其它nodes通信的端口号是16379。nodes之间的通信采用特殊的二进制协议。

对客户端来说,整个cluster被看做是一个整体,客户端可以连接任意一个node进行操作,就像操作单一Redis实例一样,当客户端操作的key没有分配到该node上时,Redis会返回转向指令,指向正确的node,这有点儿像浏览器页面的302 redirect跳转。

根据官方推荐,集群部署至少要 3 台以上的master节点,最好使用 3 主 3 从六个节点的模式。测试时,也可以在一台机器上部署这六个实例,通过端口区分出来。

3.4.运行机制

在 Redis 的每一个节点上,都有这么两个东西,一个是插槽(slot),它的的取值范围是:0-16383,可以从上面redis-trib.rb执行的结果看到这16383个slot在三个master上的分布。还有一个就是cluster,可以理解为是一个集群管理的插件,类似的哨兵。

当我们的存取的 Key到达的时候,Redis 会根据 crc16的算法对计算后得出一个结果,然后把结果和16384 求余数,这样每个 key 都会对应一个编号在 0-16383 之间的哈希槽,通过这个值,去找到对应的插槽所对应的节点,然后直接自动跳转到这个对应的节点上进行存取操作。

当数据写入到对应的master节点后,这个数据会同步给这个master对应的所有slave节点。

为了保证高可用,redis-cluster集群引入了主从模式,一个主节点对应一个或者多个从节点。当其它主节点ping主节点master 1时,如果半数以上的主节点与master 1通信超时,那么认为master 1宕机了,就会启用master 1的从节点slave 1,将slave 1变成主节点继续提供服务。

如果master 1和它的从节点slave 1都宕机了,整个集群就会进入fail状态,因为集群的slot映射不完整。如果集群超过半数以上的master挂掉,无论是否有slave,集群都会进入fail状态。

redis-cluster采用去中心化的思想,没有中心节点的说法,客户端与Redis节点直连,不需要中间代理层,客户端不需要连接集群所有节点,连接集群中任何一个可用节点即可。

注:

对redis集群的扩容就是向集群中添加机器,缩容就是从集群中删除机器,并重新将16383个slots分配到集群中的节点上(数据迁移)。

3.8.集群模式的优缺点

优点

采用去中心化思想,数据按照 slot 存储分布在多个节点,节点间数据共享,可动态调整数据分布;

可扩展性:可线性扩展到 1000 多个节点,节点可动态添加或删除;

高可用性:部分节点不可用时,集群仍可用。通过增加 Slave 做 standby 数据副本,能够实现故障自动 failover,节点之间通过 gossip 协议交换状态信息,用投票机制完成 Slave 到 Master 的角色提升;

降低运维成本,提高系统的扩展性和可用性。

缺点

1.Redis Cluster是无中心节点的集群架构,依靠Goss协议(谣言传播)协同自动化修复集群的状态

但 GosSIp有消息延时和消息冗余的问题,在集群节点数量过多的时候,节点之间需要不断进行 PING/PANG通讯,不必须要的流量占用了大量的网络资源。虽然Reds4.0对此进行了优化,但这个问题仍然存在。

2.数据迁移问题

Redis Cluster可以进行节点的动态扩容缩容,这一过程,在目前实现中,还处于半自动状态,需要人工介入。在扩缩容的时候,需要进行数据迁移。

而 Redis为了保证迁移的一致性,迁移所有操作都是同步操作,执行迁移时,两端的 Redis均会进入时长不等的阻塞状态,对于小Key,该时间可以忽略不计,但如果一旦Key的内存使用过大,严重的时候会接触发集群内的故障转移,造成不必要的切换。

四、总结

主从模式:master节点挂掉后,需要手动指定新的master,可用性不高,基本不用。

哨兵模式:master节点挂掉后,哨兵进程会主动选举新的master,可用性高,但是每个节点存储的数据是一样的,浪费内存空间。数据量不是很多,集群规模不是很大,需要自动容错容灾的时候使用。

集群模式:数据量比较大,QPS要求较高的时候使用。 Redis Cluster是Redis 3.0以后才正式推出,时间较晚,目前能证明在大规模生产环境下成功的案例还不是很多,需要时间检验。

Redis怎么实现的点赞(项目)

step1: 参数校验:对传入的参数进行null值判断

step2:逻辑校验:对于用户点赞,用户不能重复点赞相同的文章

对于取消点赞,用户不能取消未点赞的文章

step3:存入Redis:

存入的数据主要有所有文章的点赞数,某篇文章的点赞数,用户点赞的文章

step4:定时任务

通过定时任务(1小时执行一次),从Redis读取数据持久化到MySQL中

Redis的应用

- 缓存,速度快,提升服务器性能

- 排行榜,在使用传统的关系型数据库来做这个事情,非常的麻烦,利用Redis的SortSet(有序集合)数据结构可以简单搞定

- 计数器:利用Redis中原子性的自增操作,我们可以统计类似用户点赞数、用户访问数等,这类操作如果用MySQL,频繁的读写会带来相当大的压力

- 好友关系:利用集合的一些命令,比如求交集,并集,差集等。可以方便搞定一些共同好友,共同爱好值之类的功能。

- 简单消息队列:除了Redis自身的发布/订阅模式,我们也可以利用List来实现一个队列机制,比如:到货通知,邮件发送之类的需求。

- Session共享:以PHP为例,默认Session是保存在服务器的文件中,如果是集群服务,同一个用户过来可能落在不同机器上,这就会导致用户频繁登陆;采用Redis保存Session后,无论用户落在那台机器上都能够获取到对应的Session信息。

- 一些频繁被访问的数据,经常被访问的数据如果放在关系型数据库,每次查询的开销都会很大,而放在redis中,因为redis 是放在内存中的可以很高效的访问

Redis的String应用场景:

-

计数器

INCR article:readcount:{文章id}

GET article:readcount:{文章id}

-

web集群session共享(不同的访问请求映射到不同服务器上的问题)

spring session +redis实现session共享

-

分布式系统全局序列号

INCRBY orderid 1000

Redis的一些问题

(https://blog.csdn.net/qq_28827039/article/details/81183888)

kaflka知识

消息中间件面试题

消息中间件面试题:消息队列的优缺点,区别

消息中间件面试题:消息丢失怎么办

消息中间件面试题:消息中间件的高可用

消息中间件面试题:如何保证消息的顺序性

消息中间件面试题:如何保证消息不被重复消费

消息中间件面试题:如何解决消息队列的延时以及过期失效问题?消息队列满了以后该怎么处理?有几百万消息持续积压几小时呢?

基本概念

kafka是一个分布式消息队列。具有高性能、持久化、多副本备份、横向扩展能力。生产者往队列里写消息,消费者从队列里取消息进行业务逻辑。一般在架构设计中起到解耦、削峰、异步处理的作用。

kafka对外使用topic的概念,生产者往topic里写消息,消费者从读消息。为了做到水平扩展,一个topic实际是由多个partition组成的,遇到瓶颈时,可以通过增加partition的数量来进行横向扩容。单个parition内是保证消息有序。

每新写一条消息,kafka就是在对应的文件append写,所以性能非常高。

消息系统本质其实就是一个模拟缓存 ,且仅仅是起到了缓存的作用 而并不是真正的缓存,数据仍然是存储在磁盘上面而不是内存。

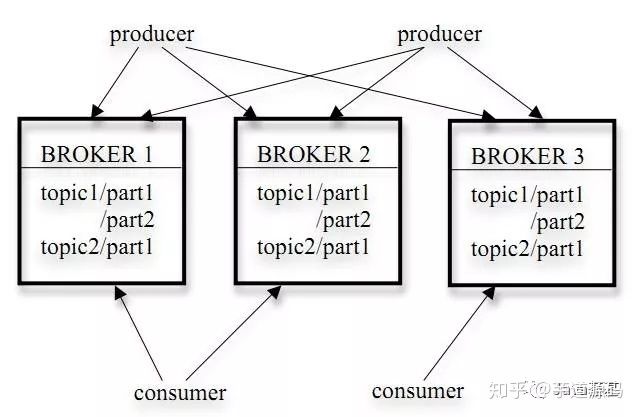

kafka架构

Kafka—>Broker----->Topic----->Partition------>Segment

kafka中有多个Broker,Broker中有多个Topic,Topic中有多个Partition,Partition中有多个Segment

它的架构包括以下组件:

-

话题(Topic):是特定类型的消息流。消息是字节的有效负载(Payload),话题是消息的分类名或种子(Feed)名。

-

Partition:

topic中的数据分割为一个或多个partition。每个topic至少有一个partition。每个partition中的数据使用多个segment文件存储。partition中的数据是有序的,不同partition间的数据丢失了数据的顺序。如果topic有多个partition,消费数据时就不能保证数据的顺序。在需要严格保证消息的消费顺序的场景下,需要将partition数目设为1。

-

生产者(Producer):是能够发布消息到话题的任何对象。

生产者即数据的发布者,该角色将消息发布到Kafka的topic中。broker接收到生产者发送的消息后,broker将该消息追加到当前用于追加数据的segment文件中。生产者发送的消息,存储到一个partition中,生产者也可以指定数据存储的partition。

-

服务代理(Broker):已发布的消息保存在一组服务器中,它们被称为代理(Broker)或Kafka集群。

Kafka 集群包含一个或多个服务器,服务器节点称为broker。

broker存储topic的数据。如果某topic有N个partition,集群有N个broker,那么每个broker存储该topic的一个partition。

如果某topic有N个partition,集群有(N+M)个broker,那么其中有N个broker存储该topic的一个partition,剩下的M个broker不存储该topic的partition数据。

如果某topic有N个partition,集群中broker数目少于N个,那么一个broker存储该topic的一个或多个partition。在实际生产环境中,尽量避免这种情况的发生,这种情况容易导致Kafka集群数据不均衡。

-

消费者(Consumer):可以订阅一个或多个话题,并从Broker拉数据,从而消费这些已发布的消息。

-

Consumer Group:

每个Consumer属于一个特定的Consumer Group(可为每个Consumer指定group name,若不指定group name则属于默认的group)。

-

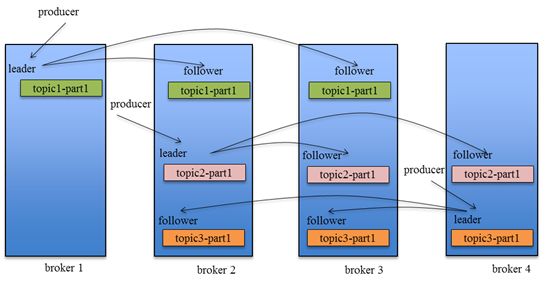

Leader:

每个partition有多个副本,其中有且仅有一个作为Leader,Leader是当前负责数据的读写的partition

-

Follower:

Follower跟随Leader,所有写请求都通过Leader路由,数据变更会广播给所有Follower,Follower与Leader保持数据同步。如果Leader失效,则从Follower中选举出一个新的Leader。当Follower与Leader挂掉、卡住或者同步太慢,leader会把这个follower从“in sync replicas”(ISR)列表中删除,重新创建一个Follower。

Topic和Partition

Topic在逻辑上可以被认为是一个queue,每条消费都必须指定它的Topic,可以简单理解为必须指明把这条消息放进哪个queue里。为了使得Kafka的吞吐率可以线性提高,物理上把Topic分成一个或多个Partition,每个Partition在物理上对应一个文件夹,该文件夹下存储这个Partition的所有消息和索引文件。创建一个topic时,同时可以指定分区数目,分区数越多,其吞吐量也越大,但是需要的资源也越多,同时也会导致更高的不可用性,kafka在接收到生产者发送的消息之后,会根据均衡策略将消息存储到不同的分区中。因为每条消息都被append到该Partition中,属于顺序写磁盘,因此效率非常高(经验证,顺序写磁盘效率比随机写内存还要高,这是Kafka高吞吐率的一个很重要的保证)。

对于传统的message queue而言,一般会删除已经被消费的消息,而Kafka集群会保留所有的消息,无论其被消费与否。当然,因为磁盘限制,不可能永久保留所有数据(实际上也没必要),因此Kafka提供两种策略删除旧数据。一是基于时间,二是基于Partition文件大小。例如可以通过配置$KAFKA_HOME/config/server.properties,让Kafka删除一周前的数据,也可在Partition文件超过1GB时删除旧数据。

因为Kafka读取特定消息的时间复杂度为O(1),即与文件大小无关,所以这里删除过期文件与提高Kafka性能无关。选择怎样的删除策略只与磁盘以及具体的需求有关。另外,Kafka会为每一个Consumer Group保留一些metadata信息——当前消费的消息的position,也即offset。这个offset由Consumer控制。正常情况下Consumer会在消费完一条消息后递增该offset。当然,Consumer也可将offset设成一个较小的值,重新消费一些消息。因为offet由Consumer控制,所以Kafka broker是无状态的,它不需要标记哪些消息被哪些消费过,也不需要通过broker去保证同一个Consumer Group只有一个Consumer能消费某一条消息,因此也就不需要锁机制,这也为Kafka的高吞吐率提供了有力保障。

kafka 交付担保(Kafka delivery guarantee)

Kafka支持三种消息投递语义

- At most once 消息可能会丢,但绝不会重复传递

- At least one 消息绝不会丢,但可能会重复传递

- Exactly once 每条消息肯定会被传输一次且仅传输一次(理想情况)

接收到消息之后先commit还是先处理消息?

consumer(消息的消费者)在从broker(消息的存储者)读取消息后,可以选择commit,该操作会在Zookeeper中存下该consumer在该partition下读取的消息的offset,该consumer下一次再读该partition时会从下一条开始读取。如未commit,下一次读取的开始位置会跟上一次commit之后的开始位置相同。

1.先commit:At most once

读完消息先commit再处理消息。这种模式下,如果consumer在commit后还没来得及处理消息就crash了,下次重新开始工作后就无法读到刚刚已提交而未处理的消息,这就对应于At most once。

2.先处理消息:At least once

读完消息先处理再commit消费状态(保存offset)。这种模式下,如果在处理完消息之后commit之前Consumer crash了,下次重新开始工作时还会处理刚刚未commit的消息,实际上该消息已经被处理过了,这就对应于At least once。

3.Exactly once:两阶段提交

如果一定要做到Exactly once,就需要协调offset和实际操作的输出。经典的做法是引入两阶段提交,但由于许多输出系统不支持两阶段提交,更为通用的方式是将offset和操作输入存在同一个地方。比如,consumer拿到数据后可能把数据放到HDFS,如果把最新的offset和数据本身一起写到HDFS,那就可以保证数据的输出和offset的更新要么都完成,要么都不完成,间接实现Exactly once。(目前就high level API而言,offset是存于Zookeeper中的,无法存于HDFS,而low level API的offset是由自己去维护的,可以将之存于HDFS中)。

Kafka默认:At least once

Kafka默认保证At least once,并且允许通过设置producer异步提交来实现At most once,而Exactly once要求与目标存储系统协作,Kafka提供的offset可以较为容易地实现这种方式。

Kafka的高可用

Leader Election

引入Replication之后,同一个Partition可能会有多个Replica,而这时需要在这些Replication之间选出一个Leader,Producer和Consumer只与这个Leader交互,其它Replica作为Follower从Leader中复制数据。

因为需要保证同一个Partition的多个Replica之间的数据一致性(其中一个宕机后其它Replica必须要能继续服务并且即不能造成数据重复也不能造成数据丢失)。如果没有一个Leader,所有Replica都可同时读/写数据,那就需要保证多个Replica之间互相(N×N条通路)同步数据,数据的一致性和有序性非常难保证,大大增加了Replication实现的复杂性,同时也增加了出现异常的几率。而引入Leader后,只有Leader负责数据读写,Follower只向Leader顺序Fetch数据(N条通路),系统更加简单且高效。

消息同步传递策略

Producer在发布消息到某个Partition时,先通过ZooKeeper找到该Partition的Leader,然后无论该Topic的Replication Factor为多少,Producer只将该消息发送到该Partition的Leader。Leader会将该消息写入其本地Log。每个Follower都从Leader pull数据。这种方式上,Follower存储的数据顺序与Leader保持一致。Follower在收到该消息并写入其Log后,向Leader发送ACK。一旦Leader收到了ISR中的所有Replica的ACK,该消息就被认为已经commit了,Leader将增加HW并且向Producer发送ACK。

为了提高性能,每个Follower在接收到数据后就立马向Leader发送ACK,而非等到数据写入Log中。因此,对于已经commit的消息,Kafka只能保证它被存于多个Replica的内存中,而不能保证它们被持久化到磁盘中,也就不能完全保证异常发生后该条消息一定能被Consumer消费。

Consumer读消息也是从Leader读取,只有被commit过的消息才会暴露给Consumer。

Kafka Replication的数据流如下图所示:

Kafka特性:

- 高吞吐量、低延迟:kafka每秒可以处理几十万条消息,它的延迟最低只有几毫秒,每个topic可以分多个partition, consumer group 对partition进行consume操作。

- 可扩展性:kafka集群支持热扩展

- 持久性、可靠性:消息被持久化到本地磁盘,并且支持数据备份防止数据丢失

- 容错性:允许集群中节点失败(若副本数量为n,则允许n-1个节点失败)

- 高并发:支持数千个客户端同时读写

kafka的优点:

- 解耦

- 冗余:有些情况下,处理数据的过程会失败。除非数据被持久化,否则将造成丢失。消息队列把数据进行持久化直到它们已经被完全处理,通过这一方式规避了数据丢失风险。许多消息队列所采用的"插入-获取-删除"范式中,在把一个消息从队列中删除之前,需要你的处理系统明确的指出该消息已经被处理完毕,从而确保你的数据被安全的保存直到你使用完毕。

- 扩展性:因为消息队列解耦了你的处理过程,所以增大消息入队和处理的频率是很容易的,只要另外增加处理过程即可。不需要改变代码、不需要调节参数。扩展就像调大电力按钮一样简单。

- 灵活性&峰值处理能力

- 可恢复性

- 顺序保证

- 缓冲

- 异步通信

常用的MQ组件:

- RabbitMQ

- Redis

- ZeroMQ

- ActiveMQ

- Kafka/Jafka

Kafka的使用场景

- 日志收集:一个公司可以用Kafka可以收集各种服务的log,通过kafka以统一接口服务的方式开放给各种consumer,例如hadoop、Hbase、Solr等。

- 消息系统:解耦生产者和消费者、缓存消息等。

-

消息系统介绍:

一个消息系统负责将数据从一个应用传递到另外一个应用,应用只需关注于数据,无需关注数据在两个或多个应用间是如何传递的。分布式消息传递基于可靠的消息队列,在客户端应用和消息系统之间异步传递消息。有两种主要的消息传递模式:点对点传递模式、发布-订阅模式。大部分的消息系统选用发布-订阅模式。Kafka就是一种发布-订阅模式。

缓冲和削峰:上游数据时有突发流量,下游可能扛不住,或者下游没有足够多的机器来保证冗余,kafka在中间可以起到一个缓冲的作用,把消息暂存在kafka中,下游服务就可以按照自己的节奏进行慢慢处理。

解耦和扩展性:项目开始的时候,并不能确定具体需求。消息队列可以作为一个接口层,解耦重要的业务流程。只需要遵守约定,针对数据编程即可获取扩展能力。

冗余:可以采用一对多的方式,一个生产者发布消息,可以被多个订阅topic的服务消费到,供多个毫无关联的业务使用。

健壮性:消息队列可以堆积请求,所以消费端业务即使短时间死掉,也不会影响主要业务的正常进行。

异步通信:很多时候,用户不想也不需要立即处理消息。消息队列提供了异步处理机制,允许用户把一个消息放入队列,但并不立即处理它。想向队列中放入多少消息就放多少,然后在需要的时候再去处理它们。

Kafka面试题

Kafka中ISR、AR又代表什么?ISR的伸缩又指什么

ISR:In-Sync Replicas 副本同步队列

AR:Assigned Replicas 所有副本

ISR是由leader维护,follower从leader同步数据有一些延迟,任意一个超过延迟阈值都会把follower剔除出ISR, 存入OSR(Outof-Sync Replicas)列表,新加入的follower也会先存放在OSR中。AR=ISR+OSR。

Kafka中的broker是干什么

broker 是消息的代理,Producers往Brokers里面的指定Topic中写消息,Consumers从Brokers里面拉取指定Topic的消息,然后进行业务处理,broker在中间起到一个代理保存消息的中转站。

kafka中的zookeeper起到什么作用,可以不用zookeeper么

zookeeper 是一个分布式的协调组件,早期版本的kafka用zk做meta信息存储,consumer的消费状态,group的管理以及 offset的值。考虑到zk本身的一些因素以及整个架构较大概率存在单点问题,新版本中逐渐弱化了zookeeper的作用。新的consumer使用了kafka内部的group coordination协议,也减少了对zookeeper的依赖,

但是broker依然依赖于ZK,zookeeper 在kafka中还用来选举controller 和 检测broker是否存活等等。

kafka follower如何与leader同步数据

Kafka的复制机制既不是完全的同步复制,也不是单纯的异步复制。完全同步复制要求All Alive Follower都复制完,这条消息才会被认为commit,这种复制方式极大的影响了吞吐率。而异步复制方式下,Follower异步的从Leader复制数据,数据只要被Leader写入log就被认为已经commit,这种情况下,如果leader挂掉,会丢失数据,kafka使用ISR的方式很好的均衡了确保数据不丢失以及吞吐率。Follower可以批量的从Leader复制数据,而且Leader充分利用磁盘顺序读以及send file(zero copy)机制,这样极大的提高复制性能,内部批量写磁盘,大幅减少了Follower与Leader的消息量差。

什么情况下一个broker会从isr中踢出去

leader会维护一个与其基本保持同步的Replica列表,该列表称为ISR(in-sync Replica),每个Partition都会有一个ISR,而且是由leader动态维护 ,如果一个follower比一个leader落后太多,或者超过一定时间未发起数据复制请求,则leader将其重ISR中移除 。

kafka为什么这么快

- Cache Filesystem Cache PageCache缓存

- 顺序写 由于现代的操作系统提供了预读和写技术,磁盘的顺序写大多数情况下比随机写内存还要快。

- Zero-copy 零拷技术减少拷贝次数

- Batching of Messages 批量量处理。合并小的请求,然后以流的方式进行交互,直顶网络上限。

- Pull 拉模式 使用拉模式进行消息的获取消费,与消费端处理能力相符。

kafka producer 如何优化打入速度

- 增加线程

- 提高 batch.size

- 增加更多 producer 实例

- 增加 partition 数

- 设置 acks=-1 时,如果延迟增大:可以增大 num.replica.fetchers(follower 同步数据的线程数)来调解;

- 跨数据中心的传输:增加 socket 缓冲区设置以及 OS tcp 缓冲区设置。

kafka producer打数据,ack为0,1,-1的时候代表啥,设置为-1的时候,什么情况下,leader会认为一条消息commit了

- 1(默认) 数据发送到Kafka后,经过leader成功接收消息的的确认,就算是发送成功了。在这种情况下,如果leader宕机了,则会丢失数据。

- 0 生产者将数据发送出去就不管了,不去等待任何返回。这种情况下数据传输效率最高,但是数据可靠性确是最低的。

- -1 producer需要等待ISR中的所有follower都确认接收到数据后才算一次发送完成,可靠性最高。当ISR中所有Replica都向Leader发送ACK时,leader才commit,这时候producer才能认为一个请求中的消息都commit了。

kafka unclean 配置代表啥,会对 spark streaming 消费有什么影响

unclean.leader.election.enable 为true的话,意味着非ISR集合的broker 也可以参与选举,这样有可能就会丢数据,spark streaming在消费过程中拿到的 end offset 会突然变小,导致 spark streaming job挂掉。如果unclean.leader.election.enable参数设置为true,就有可能发生数据丢失和数据不一致的情况,Kafka的可靠性就会降低;而如果unclean.leader.election.enable参数设置为false,Kafka的可用性就会降低。

如果leader crash时,ISR为空怎么办

kafka在Broker端提供了一个配置参数:unclean.leader.election,这个参数有两个值:

true(默认):允许不同步副本成为leader,由于不同步副本的消息较为滞后,此时成为leader,可能会出现消息不一致的情况。

false:不允许不同步副本成为leader,此时如果发生ISR列表为空,会一直等待旧leader恢复,降低了可用性。

kafka的message格式是什么样的

一个Kafka的Message由一个固定长度的header和一个变长的消息体body组成,header部分由一个字节的magic(文件格式)和四个字节的CRC32(用于判断body消息体是否正常)构成。当magic的值为1的时候,会在magic和crc32之间多一个字节的数据:attributes(保存一些相关属性,比如是否压缩、压缩格式等等);如果magic的值为0,那么不存在attributes属性,body是由N个字节构成的一个消息体,包含了具体的key/value消息。

kafka中consumer group 是什么概念

同样是逻辑上的概念,是Kafka实现单播和广播两种消息模型的手段。同一个topic的数据,会广播给不同的group;同一个group中的worker,只有一个worker能拿到这个数据。换句话说,对于同一个topic,每个group都可以拿到同样的所有数据,但是数据进入group后只能被其中的一个worker消费。group内的worker可以使用多线程或多进程来实现,也可以将进程分散在多台机器上,worker的数量通常不超过partition的数量,且二者最好保持整数倍关系,因为Kafka在设计时假定了一个partition只能被一个worker消费(同一group内)。

Kafka中的消息是否会丢失和重复消费?

要确定Kafka的消息是否丢失或重复,从两个方面分析入手:消息发送和消息消费。

1、消息发送

Kafka消息发送有两种方式:同步(sync)和异步(async),默认是同步方式,可通过producer.type属性进行配置。Kafka通过配置request.required.acks属性来确认消息的生产:

- 0—表示不进行消息接收是否成功的确认;

- 1—表示当Leader接收成功时确认;

- -1—表示Leader和Follower都接收成功时确认;

综上所述,有6种消息生产的情况,下面分情况来分析消息丢失的场景:

(1)acks=0,不和Kafka集群进行消息接收确认,则当网络异常、缓冲区满了等情况时,消息可能丢失;

(2)acks=1、同步模式下,只有Leader确认接收成功后但挂掉了,副本没有同步,数据可能丢失;

2、消息消费

Kafka消息消费有两个consumer接口,Low-level API和High-level API:

- Low-level API:消费者自己维护offset等值,可以实现对Kafka的完全控制;

- High-level API:封装了对parition和offset的管理,使用简单;

如果使用高级接口High-level API,可能存在一个问题就是当消息消费者从集群中把消息取出来、并提交了新的消息offset值后,还没来得及消费就挂掉了,那么下次再消费时之前没消费成功的消息就“诡异”的消失了;

解决办法:

针对消息丢失:同步模式下,确认机制设置为-1,即让消息写入Leader和Follower之后再确认消息发送成功;异步模式下,为防止缓冲区满,可以在配置文件设置不限制阻塞超时时间,当缓冲区满时让生产者一直处于阻塞状态;

针对消息重复:将消息的唯一标识保存到外部介质中,每次消费时判断是否处理过即可。

消息重复消费及解决参考:https://www.javazhiyin.com/22910.html

为什么Kafka不支持读写分离?

在 Kafka 中,生产者写入消息、消费者读取消息的操作都是与 leader 副本进行交互的,从 而实现的是一种主写主读的生产消费模型。

Kafka 并不支持主写从读,因为主写从读有 2 个很明 显的缺点:

- (1)数据一致性问题。数据从主节点转到从节点必然会有一个延时的时间窗口,这个时间 窗口会导致主从节点之间的数据不一致。某一时刻,在主节点和从节点中 A 数据的值都为 X, 之后将主节点中 A 的值修改为 Y,那么在这个变更通知到从节点之前,应用读取从节点中的 A 数据的值并不为最新的 Y,由此便产生了数据不一致的问题。

- (2)延时问题。类似 Redis 这种组件,数据从写入主节点到同步至从节点中的过程需要经 历网络→主节点内存→网络→从节点内存这几个阶段,整个过程会耗费一定的时间。而在 Kafka 中,主从同步会比 Redis 更加耗时,它需要经历网络→主节点内存→主节点磁盘→网络→从节点内存→从节点磁盘这几个阶段。对延时敏感的应用而言,主写从读的功能并不太适用。

Kafka中是怎么体现消息顺序性的?

kafka每个partition中的消息在写入时都是有序的,消费时,每个partition只能被每一个group中的一个消费者消费,保证了消费时也是有序的。

整个topic不保证有序。如果为了保证topic整个有序,那么将partition调整为1.

消费者提交消费位移时提交的是当前消费到的最新消息的offset还是offset+1?

offset+1

计算机网络知识

TCP的主要特点

-

TCP 是面向连接的。(就好像打电话一样,通话前需要先拨号建立连接,通话结束后要挂机释放连接);

-

每一条 TCP 连接只能有两个端点,每一条 TCP 连接只能是点对点的(一对一);

-

TCP 提供可靠交付的服务。通过 TCP 连接传送的数据,无差错、不丢失、不重复、并且按序到达;

-

TCP 提供全双工通信。TCP 允许通信双方的应用进程在任何时候都能发送数据。TCP 连接的两端都设有发送缓存和接收缓存,用来临时存放双方通信的数据;

-

面向字节流。TCP 中的“流”(Stream)指的是流入进程或从进程流出的字节序列。“面向字节流”的含义是:虽然应用程序和 TCP 的交互是一次一个数据块(大小不等),但 TCP 把应用程序交下来的数据仅仅看成是一连串的无结构的字节流。

UDP的主要特点

-

UDP 是无连接的;

-

UDP 使用尽最大努力交付,即不保证可靠交付,因此主机不需要维持复杂的链接状态(这里面有许多参数);

-

UDP 是面向报文的;

-

UDP 没有拥塞控制,因此网络出现拥塞不会使源主机的发送速率降低(对实时应用很有用,如 直播,实时视频会议等);

-

UDP 支持一对一、一对多、多对一和多对多的交互通信;

-

UDP 的首部开销小,只有 8 个字节,比 TCP 的 20 个字节的首部要短。

TCP和UDP的区别?

TCP 提供面向连接的服务。在传送数据之前必须先建立连接,数据传送结束后要释放连接。TCP 不提供广播或多播服务。由于 TCP 要提供可靠的,面向连接的运输服务(TCP 的可靠体现在 TCP 在传递数据之前,会有三次握手来建立连接,而且在数据传递时,有确认、窗口、重传、拥塞控制机制,在数据传完后,还会断开连接用来节约系统资源),这难以避免增加了许多开销,如确认,流量控制,计时器以及连接管理等。这不仅使协议数据单元的首部增大很多,还要占用许多处理机资源。

UDP 在传送数据之前不需要先建立连接,远地主机在收到 UDP 报文后,不需要给出任何确认。虽然 UDP 不提供可靠交付,但在某些情况下 UDP 确是一种最有效的工作方式(一般用于即时通信),比如:QQ 语音、 QQ 视频 、直播等等。

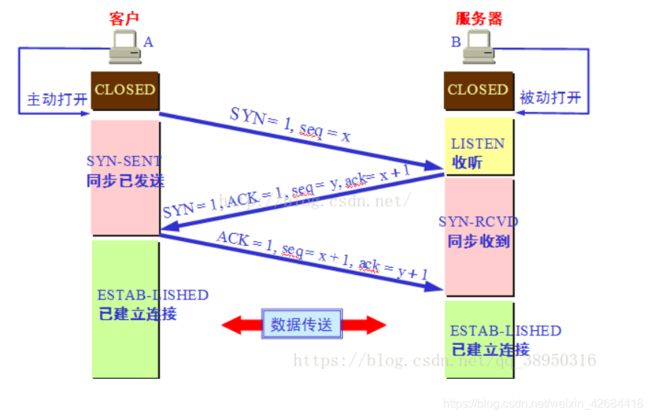

TCP三次握手

参考文章:https://blog.csdn.net/qq_38950316/article/details/81087809

第一次握手:主机A发送位码为SYN=1,随机产生seq number=1234567的数据包到服务器,主机B由SYN=1知道,A要求建立联机;

第二次握手:主机B收到请求后要确认联机信息,向A发送ack number=(主机A的seq+1),SYN=1,ACK=1,随机产生seq=7654321的包;

第三次握手:主机A收到后检查ack number是否正确,即第一次发送的seq number+1,以及位码ACK是否为1,若正确,主机A会再发送ack number=(主机B的seq+1),ACK=1,主机B收到后确认seq值与ACK=1则连接建立成功。

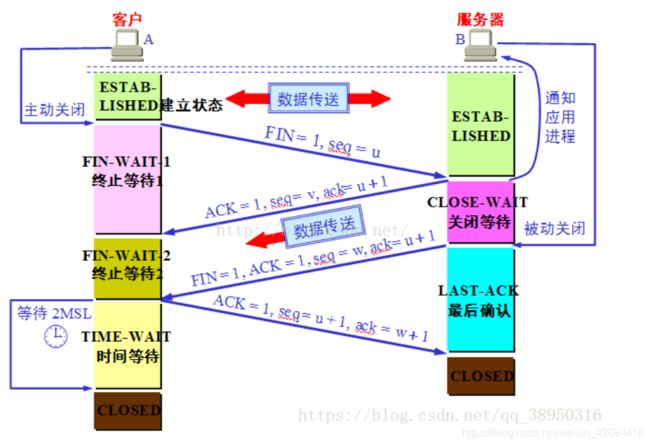

TCP四次挥手

1)客户端进程发出连接释放报文,并且停止发送数据。释放数据报文首部,FIN=1,其序列号为seq=u(等于前面已经传送过来的数据的最后一个字节的序号加1),此时,客户端进入FIN-WAIT-1(终止等待1)状态。 TCP规定,FIN报文段即使不携带数据,也要消耗一个序号。

2)服务器收到连接释放报文,发出确认报文,ACK=1,ack=u+1,并且带上自己的序列号seq=v,此时,服务端就进入了CLOSE-WAIT(关闭等待)状态。TCP服务器通知高层的应用进程,客户端向服务器的方向就释放了,这时候处于半关闭状态,即客户端已经没有数据要发送了,但是服务器若发送数据,客户端依然要接受。这个状态还要持续一段时间,也就是整个CLOSE-WAIT状态持续的时间。

3)客户端收到服务器的确认请求后,此时,客户端就进入FIN-WAIT-2(终止等待2)状态,等待服务器发送连接释放报文(在这之前还需要接受服务器发送的最后的数据)。

4)服务器将最后的数据发送完毕后,就向客户端发送连接释放报文,FIN=1,ack=u+1,由于在半关闭状态,服务器很可能又发送了一些数据,假定此时的序列号为seq=w,此时,服务器就进入了LAST-ACK(最后确认)状态,等待客户端的确认。

5)客户端收到服务器的连接释放报文后,必须发出确认,ACK=1,ack=w+1,而自己的序列号是seq=u+1,此时,客户端就进入了TIME-WAIT(时间等待)状态。注意此时TCP连接还没有释放,必须经过2∗∗MSL(最长报文段寿命)的时间后,当客户端撤销相应的TCB后,才进入CLOSED状态。

6)服务器只要收到了客户端发出的确认,立即进入CLOSED状态。同样,撤销TCB后,就结束了这次的TCP连接。可以看到,服务器结束TCP连接的时间要比客户端早一些。

为什么两次握手不可以

为了防止已经失效的连接请求报文段突然又传送到了 B,因而产生错误。比如下面这种情况:A 发出的第一个连接请求报文段并没有丢失,而是在网路结点长时间滞留了,以致于延误到连接释放以后的某个时间段才到达 B。本来这是一个早已失效的报文段。但是 B 收到此失效的链接请求报文段后,就误认为 A 又发出一次新的连接请求。于是就向 A 发出确认报文段,同意建立连接。

对于上面这种情况,如果不进行第三次握手,B 发出确认后就认为新的运输连接已经建立了,并一直等待 A 发来数据。B 的许多资源就这样白白浪费了。

如果采用了三次握手,由于 A 实际上并没有发出建立连接请求,所以不会理睬 B 的确认,也不会向 B 发送数据。B 由于收不到确认,就知道 A 并没有要求建立连接。

为什么不需要四次握手?

有人可能会说 A 发出第三次握手的信息后在没有接收到 B 的请求就已经进入了连接状态,那如果 A 的这个确认包丢失或者滞留了怎么办?

我们需要明白一点,完全可靠的通信协议是不存在的。在经过三次握手之后,客户端和服务端已经可以确认之前的通信状况,都收到了确认信息。所以即便再增加握手次数也不能保证后面的通信完全可靠,所以是没有必要的。

为什么 TIME-WAIT 状态必须等待 2MSL 的时间呢?

2MSL:maximum segment lifetime (最大分节生命周期),这是一个IP数据包在互联网上生存的最长时间,超过这个时间IP数据包将在网络中消失,MSL 在 RFC 1122上建议是2分钟,而源自berkeley的TCP实现传统上使用30秒。

-

为了保证 A 发送的最后一个 ACK 报文段能够到达 B。这个 ACK 报文段有可能丢失,因而使处在 LAST-ACK 状态的 B 收不到对已发送的 FIN + ACK 报文段的确认。B 会超时重传这个 FIN+ACK 报文段,而 A 就能在 2MSL 时间内(超时 + 1MSL 传输)收到这个重传的 FIN+ACK 报文段。接着 A 重传一次确认,重新启动 2MSL 计时器。最后,A 和 B 都正常进入到 CLOSED 状态。如果 A 在 TIME-WAIT 状态不等待一段时间,而是在发送完 ACK 报文段后立即释放连接,那么就无法收到 B 重传的 FIN + ACK 报文段,因而也不会再发送一次确认报文段,这样,B 就无法按照正常步骤进入 CLOSED 状态。

-

防止已失效的连接请求报文段出现在本连接中。A 在发送完最后一个 ACK 报文段后,再经过时间 2MSL,就可以使本连接持续的时间内所产生的所有报文段都从网络中消失。这样就可以使下一个连接中不会出现这种旧的连接请求报文段。

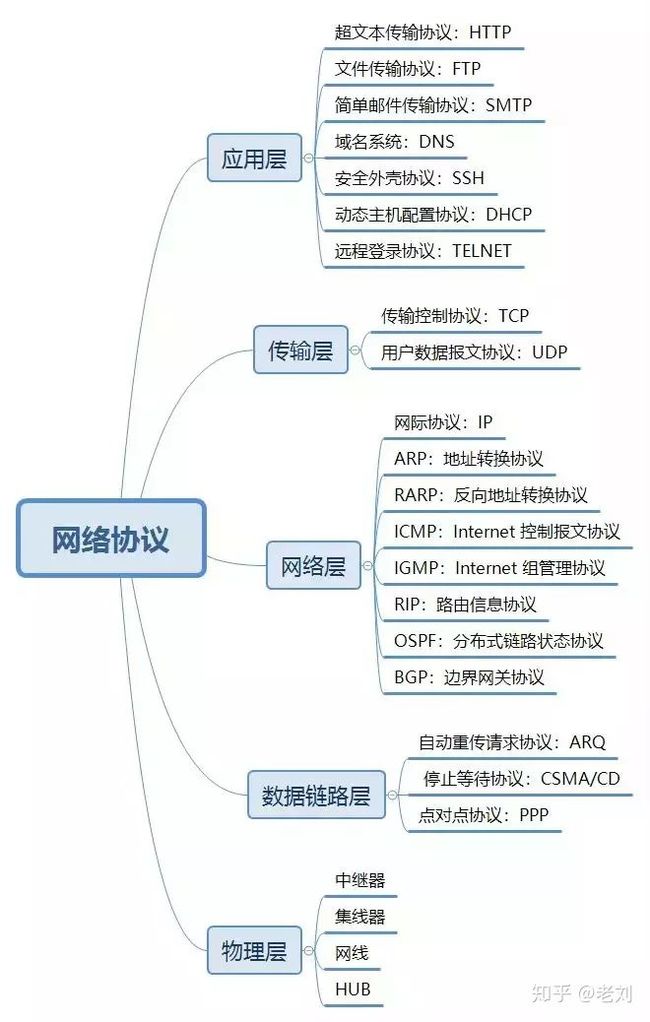

五层协议框架

计算机五层网络体系中涉及的协议非常多,下面就常用的做了列举:

物理层:实现两台计算机之间点对点的比特流透明传输

数据链路层:两台计算机之间的数据传输,总是在一段一段的链路上传输的,这就需要使用专门的链路层协议

网络层:在计算机网络中进行通信的两个计算机可能会经过很多个数据链路,也可能还要经过很多通信子网,网络层的任务就是选择合适的网间路由和交换节点,确保数据及时传送。

传输层:主要任务就是向两台主机进程之间的通信提供通用的数据传输服务。

应用层:通过应用进程间的交互来完成特定网络应用。

ARP协议的工作原理

功能:完成了IP地址与MAC地址的映射

具体实现:首先,每台主机都会在自己的 ARP 缓冲区中建立一个 ARP 列表,以表示 IP 地址和 MAC 地址的对应关系。当源主机需要将一个数据包要发送到目的主机时,会首先检查自己 ARP 列表中是否存在该 IP 地址对应的 MAC 地址:如果有,就直接将数据包发送到这个 MAC 地址;如果没有,就向本地网段发起一个 ARP 请求的广播包,查询此目的主机对应的 MAC 地址。此 ARP 请求数据包里包括源主机的 IP 地址、硬件地址、以及目的主机的 IP 地址。网络中所有的主机收到这个 ARP 请求后,会检查数据包中的目的 IP 是否和自己的 IP 地址一致。如果不相同就忽略此数据包;如果相同,该主机首先将发送端的 MAC 地址和 IP 地址添加到自己的 ARP 列表中,如果 ARP 表中已经存在该 IP 的信息,则将其覆盖,然后给源主机发送一个 ARP 响应数据包,告诉对方自己是它需要查找的 MAC 地址;源主机收到这个 ARP 响应数据包后,将得到的目的主机的 IP 地址和 MAC 地址添加到自己的 ARP 列表中,并利用此信息开始数据的传输。如果源主机一直没有收到 ARP 响应数据包,表示 ARP 查询失败。

IP地址分类

功能:为互联网上的每一个网络和每一台主机分配一个逻辑地址,以此来屏蔽物理地址的差异。IP 地址编址方案将 IP 地址空间划分为 A、B、C、D、E 五类,其中 A、B、C 是基本类,D、E 类作为多播和保留使用,为特殊地址。

每个 IP 地址包括两个标识码(ID),即网络 ID 和主机 ID。同一个物理网络上的所有主机都使用同一个网络 ID,网络上的一个主机(包括网络上工作站,服务器和路由器等)有一个主机 ID 与其对应。A~E 类地址的特点如下:

A 类地址:以 0 开头,第一个字节范围:0~127;

B 类地址:以 10 开头,第一个字节范围:128~191;

C 类地址:以 110 开头,第一个字节范围:192~223;

D 类地址:以 1110 开头,第一个字节范围为 224~239;

E 类地址:以 1111 开头,保留地址

TCP 和 UDP 分别对应的常见应用层协议有哪些?

1. TCP 对应的应用层协议

FTP:定义了文件传输协议,使用 21 端口。常说某某计算机开了 FTP 服务便是启动了文件传输服务。下载文件,上传主页,都要用到 FTP 服务。

Telnet:它是一种用于远程登陆的端口,用户可以以自己的身份远程连接到计算机上,通过这种端口可以提供一种基于 DOS 模式下的通信服务。如以前的 BBS 是-纯字符界面的,支持 BBS 的服务器将 23 端口打开,对外提供服务。

SMTP:定义了简单邮件传送协议,现在很多邮件服务器都用的是这个协议,用于发送邮件。如常见的免费邮件服务中用的就是这个邮件服务端口,所以在电子邮件设置-中常看到有这么 SMTP 端口设置这个栏,服务器开放的是 25 号端口。

POP3:它是和 SMTP 对应,POP3 用于接收邮件。通常情况下,POP3 协议所用的是 110 端口。也是说,只要你有相应的使用 POP3 协议的程序(例如 Fo-xmail 或 Outlook),就可以不以 Web 方式登陆进邮箱界面,直接用邮件程序就可以收到邮件(如是163 邮箱就没有必要先进入网易网站,再进入自己的邮-箱来收信)。

HTTP:从 Web 服务器传输超文本到本地浏览器的传送协议。

2. UDP 对应的应用层协议

DNS:用于域名解析服务,将域名地址转换为 IP 地址。DNS 用的是 53 号端口。

SNMP:简单网络管理协议,使用 161 号端口,是用来管理网络设备的。由于网络设备很多,无连接的服务就体现出其优势。

TFTP(Trival File Transfer Protocal):简单文件传输协议,该协议在熟知端口 69 上使用 UDP 服务。

UDP和TCP的数据包长度

在应用程序中我们用到的Data的长度最大是多少,直接取决于底层的限制。

我们从下到上分析一下:

1.在链路层,由以太网的物理特性决定了数据帧的长度为(46+18)-(1500+18),其中的18是数据帧的头和尾,也就是说数据帧的内容最大为1500(不包括帧头和帧尾),即MTU(Maximum Transmission Unit)为1500;

2.在网络层,因为IP包的首部要占用20字节,所以这的MTU为1500-20=1480;

3.在传输层,对于UDP包的首部要占用8字节,所以这的MTU为1480-8=1472; TCP 包的大小就应该是 1500 - IP头(20) - TCP头(20) = 1460 (Bytes)

所以,在应用层,你的Data最大长度为1472。当我们的UDP包中的数据多于MTU(1472)时,发送方的IP层需要分片fragmentation进行传输,而在接收方IP层则需要进行数据报重组,由于UDP是不可靠的传输协议,如果分片丢失导致重组失败,将导致UDP数据包被丢弃。

从上面的分析来看,在普通的局域网环境下,UDP的数据最大为1472字节最好(避免分片重组)。

但在网络编程中,Internet中的路由器可能有设置成不同的值(小于默认值),Internet上的标准MTU值为576,所以Internet的UDP编程时数据长度最好在576-20-8=548字节以内。

- MTU: Maxitum Transmission Unit 最大传输单元

- MSS: Maxitum Segment Size 最大分段大小,MSS就是TCP数据包每次能够传输的最大数据分段。

3、TCP、UDP数据包最小值的确定

在用UDP局域网通信时,经常发生“Hello World”来进行测试,但是“Hello World”并不满足最小有效数据(64-46)的要求,为什么小于18个字节,对方仍然可用收到呢?因为在链路层的MAC子层中会进行数据补齐,不足18个字节的用0补齐。但当服务器在公网,客户端在内网,发生小于18个字节的数据,就会出现接收端收不到数据的情况。

以太网EthernetII规定,以太网帧数据域部分最小为46字节,也就是以太网帧最小是6+6+2+46+4=64。除去4个字节的FCS,因此,抓包时就是60字节。当数据字段的长度小于46字节时,MAC子层就会在数据字段的后面填充以满足数据帧长不小于64字节。由于填充数据是由MAC子层负责,也就是设备驱动程序。不同的抓包程序和设备驱动程序所处的优先层次可能不同,抓包程序的优先级可能比设备驱动程序更高,也就是说,我们的抓包程序可能在设备驱动程序还没有填充不到64字节的帧的时候,抓包程序已经捕获了数据。因此不同的抓包工具抓到的数据帧的大小可能不同。下列是本人分别用wireshark和sniffer抓包的结果,对于TCP 的ACK确认帧的大小一个是54字节,一个是60字节,wireshark抓取时没有填充数据段,sniffer抓取时有填充数据段。

4、实际应用

用UDP协议发送时,用sendto函数最大能发送数据的长度为:65535- IP头(20) - UDP头(8)=65507字节。用sendto函数发送数据时,如果发送数据长度大于该值,则函数会返回错误。

用TCP协议发送时,由于TCP是数据流协议,因此不存在包大小的限制(暂不考虑缓冲区的大小),这是指在用send函数时,数据长度参数不受限制。而实际上,所指定的这段数据并不一定会一次性发送出去,如果这段数据比较长,会被分段发送,如果比较短,可能会等待和下一次数据一起发送。

保活计时器的作用?

除时间等待计时器外,TCP 还有一个保活计时器(keepalive timer)。设想这样的场景:客户已主动与服务器建立了 TCP 连接。但后来客户端的主机突然发生故障。显然,服务器以后就不能再收到客户端发来的数据。因此,应当有措施使服务器不要再白白等待下去。这就需要使用保活计时器了。

服务器每收到一次客户的数据,就重新设置保活计时器,时间的设置通常是两个小时。若两个小时都没有收到客户端的数据,服务端就发送一个探测报文段,以后则每隔 75 秒钟发送一次。若连续发送 10个 探测报文段后仍然无客户端的响应,服务端就认为客户端出了故障,接着就关闭这个连接。

TCP 协议是如何保证可靠传输的?

-

数据包校验:目的是检测数据在传输过程中的任何变化,若校验出包有错,则丢弃报文段并且不给出响应,这时 TCP 发送数据端超时后会重发数据;

-

对失序数据包重排序:既然 TCP 报文段作为 IP 数据报来传输,而 IP 数据报的到达可能会失序,因此 TCP 报文段的到达也可能会失序。TCP 将对失序数据进行重新排序,然后才交给应用层;

-

丢弃重复数据:对于重复数据,能够丢弃重复数据;

-

应答机制:当 TCP 收到发自 TCP 连接另一端的数据,它将发送一个确认。这个确认不是立即发送,通常将推迟几分之一秒;

-

超时重发:当 TCP 发出一个段后,它启动一个定时器,等待目的端确认收到这个报文段。如果不能及时收到一个确认,将重发这个报文段;

-

流量控制:TCP 连接的每一方都有固定大小的缓冲空间。TCP 的接收端只允许另一端发送接收端缓冲区所能接纳的数据,这可以防止较快主机致使较慢主机的缓冲区溢出,这就是流量控制。TCP 使用的流量控制协议是可变大小的滑动窗口协议。

TCP的四种拥塞控制算法

- 慢开始

- 拥塞避免

- 快重传

- 快恢复

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-SKyqFsYl-1661411816871)(C:\Users\jjp-god\Desktop\笔记\Java学习\picture\image-20200812161626363.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-gNYZhLvt-1661411816872)(C:\Users\jjp-god\Desktop\笔记\Java学习\picture\image-20200812162348903.png)]

TCP发送方一开始使用 慢开始 算法,让拥塞窗口cwnd的值从1开始指数增长,当拥塞窗口cwnd的值增长到初始的慢开始门限值ssthresh值时,停止使用慢开始算法,转而执行拥塞避免算法,拥塞避免算法让cwnd的值按线性增长,当发生超时重传时,就判断网络可能出现了拥塞,这是会将慢开始门限值更新到当前拥塞窗口值cwnd的一半,并将cwnd的值置为1,重新开始慢开始算法,和拥塞避免算法。

注意:慢开始是指一开始向网络中注入的报文段少,并不是指拥塞窗口cwnd增长速度慢

拥塞避免并非指完全能够避免拥塞,而是指在拥塞避免阶段将拥塞窗口控制在线性规律增长,使网络不容易出现拥塞。

有时网络中只是个别报文段会在网络中丢失,但实际上网络并未发生拥塞,这将导致发送方超时重传,并误认为网络发生了拥塞;发送发错误地启动了慢开始算法,并把拥塞窗口的cwnd值设置为1,因而降低了传输效率。为了解决这个问题,出现了快重传和快恢复算法

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-JsSnIAgs-1661411816872)(C:\Users\jjp-god\Desktop\笔记\Java学习\picture\image-20200812164507012.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-WTuLLbVF-1661411816873)(C:\Users\jjp-god\Desktop\笔记\Java学习\picture\image-20200812164701894.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-wrUnOtT8-1661411816873)(C:\Users\jjp-god\Desktop\笔记\Java学习\picture\image-20200812164902874.png)]

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Sn4YRKcH-1661411816874)(C:\Users\jjp-god\Desktop\笔记\Java学习\picture\image-20200812164932343.png)]

TCP发送方一开始使用 慢开始 算法,让拥塞窗口cwnd的值从1开始指数增长,当拥塞窗口cwnd的值增长到初始的慢开始门限值ssthresh值时,停止使用慢开始算法,转而执行拥塞避免算法,拥塞避免算法让cwnd的值按线性增长,当发生超时重传时,就判断网络可能出现了拥塞,这是会将慢开始门限值更新到当前拥塞窗口值cwnd的一半,并将cwnd的值置为1,重新开始慢开始算法,让拥塞窗口cwnd的值从1开始指数增长,当拥塞窗口cwnd的值增长到新的慢开始门限值ssthresh值时,停止使用慢开始算法,转而执行拥塞避免算法,拥塞避免算法让cwnd的值按线性增长。这时如果网络中出现了个别保文的丢失,并收到三个重复确认时,就执行快重传和快恢复算法,将慢开始门限值ssthresh值和拥塞窗口cwnd值调整为当前窗口一半,开始执行拥塞避免算法

什么是粘包

在进行 Java NIO 学习时,可能会发现:如果客户端连续不断的向服务端发送数据包时,服务端接收的数据会出现两个数据包粘在一起的情况。

-

TCP 是基于字节流的

-

TCP 的首部没有表示数据长度的字段。

一个数据包中包含了发送端发送的两个数据包的信息,这种现象即为粘包。

接收端收到了两个数据包,但是这两个数据包要么是不完整的,要么就是多出来一块,这种情况即发生了拆包和粘包。拆包和粘包的问题导致接收端在处理的时候会非常困难,因为无法区分一个完整的数据包。

TCP 黏包是怎么产生的?

- 发送方产生粘包

采用 TCP 协议传输数据的客户端与服务器经常是保持一个长连接的状态(一次连接发一次数据不存在粘包),双方在连接不断开的情况下,可以一直传输数据。但当发送的数据包过于的小时,那么 TCP 协议默认的会启用 Nagle 算法,将这些较小的数据包进行合并发送(缓冲区数据发送是一个堆压的过程);这个合并过程就是在发送缓冲区中进行的,也就是说数据发送出来它已经是粘包的状态了。

- 接收方产生粘包

接收方采用 TCP 协议接收数据时的过程是这样的:数据到接收方,从网络模型的下方传递至传输层,传输层的 TCP 协议处理是将其放置接收缓冲区,然后由应用层来主动获取(C 语言用 recv、read 等函数);这时会出现一个问题,就是我们在程序中调用的读取数据函数不能及时的把缓冲区中的数据拿出来,而下一个数据又到来并有一部分放入的缓冲区末尾,等我们读取数据时就是一个粘包。(放数据的速度 > 应用层拿数据速度)

怎么解决拆包和粘包?

分包机制一般有两个通用的解决方法:

-

特殊字符控制;

-

在包头首都添加数据包的长度。

如果使用 netty 的话,就有专门的编码器和解码器解决拆包和粘包问题了。

tips:UDP 没有粘包问题,但是有丢包和乱序。不完整的包是不会有的,收到的都是完全正确的包。传送的数据单位协议是 UDP 报文或用户数据报,发送的时候既不合并,也不拆分。

HTTP状态码

- 1XX 信息

- 100 Continue :表明到目前为止都很正常,客户端可以继续发送请求或者忽略这个响应。

- 2XX 成功

-

200 OK

-

204 No Content :请求已经成功处理,但是返回的响应报文不包含实体的主体部分。一般在只需要从客户端往服务器发送信息,而不需要返回数据时使用。

-

206 Partial Content :表示客户端进行了范围请求,响应报文包含由 Content-Range 指定范围的实体内容。

- 3XX 重定向

-

301 Moved Permanently :永久性重定向;

-

302 Found :临时性重定向;

-

303 See Other :和 302 有着相同的功能,但是 303 明确要求客户端应该采用 GET 方法获取资源。

-

304 Not Modified :如果请求报文首部包含一些条件,例如:If-Match,If-Modified-Since,If-None-Match,If-Range,If-Unmodified-Since,如果不满足条件,则服务器会返回 304 状态码。

-

307 Temporary Redirect :临时重定向,与 302 的含义类似,但是 307 要求浏览器不会把重定向请求的 POST 方法改成 GET 方法。

- 4XX 客户端错误

-

400 Bad Request :请求报文中存在语法错误。

-

401 Unauthorized :该状态码表示发送的请求需要有认证信息(BASIC 认证、DIGEST 认证)。如果之前已进行过一次请求,则表示用户认证失败。

-

403 Forbidden :请求被拒绝。

-

404 Not Found

- 5XX 服务器错误

-

500 Internal Server Error :服务器正在执行请求时发生错误;

-

503 Service Unavailable :服务器暂时处于超负载或正在进行停机维护,现在无法处理请求。

HTTP 状态码 301 和 302 代表的是什么?有什么区别?

301,302 都是 HTTP 状态的编码,都代表着某个 URL 发生了转移。

- 区别:

301 redirect: 301 代表永久性转移(Permanently Moved)

302 redirect: 302 代表暂时性转移(Temporarily Moved)

forward 和 redirect 的区别?

Forward 和 Redirect 代表了两种请求转发方式:直接转发和间接转发。

直接转发方式(Forward):客户端和浏览器只发出一次请求,Servlet、HTML、JSP 或其它信息资源,由第二个信息资源响应该请求,在请求对象 request 中,保存的对象对于每个信息资源是共享的。

间接转发方式(Redirect):实际是两次 HTTP 请求,服务器端在响应第一次请求的时候,让浏览器再向另外一个 URL 发出请求,从而达到转发的目的。

- 举个通俗的例子:

直接转发就相当于:“A 找 B 借钱,B 说没有,B 去找 C 借,借到借不到都会把消息传递给 A”;

间接转发就相当于:“A 找 B 借钱,B 说没有,让 A 去找 C 借”。

HTTP 方法有哪些?

客户端发送的 请求报文 第一行为请求行,包含了方法字段。

- GET:获取资源,当前网络中绝大部分使用的都是 GET;

- HEAD:获取报文首部,和 GET 方法类似,但是不返回报文实体主体部分;

- POST:传输实体主体

- PUT:上传文件,由于自身不带验证机制,任何人都可以上传文件,因此存在安全性问题,一般不使用该方法。

- PATCH:对资源进行部分修改。PUT 也可以用于修改资源,但是只能完全替代原始资源,PATCH 允许部分修改。

- OPTIONS:查询指定的 URL 支持的方法;

- CONNECT:要求在与代理服务器通信时建立隧道。使用 SSL(Secure Sockets Layer,安全套接层)和 TLS(Transport Layer Security,传输层安全)协议把通信内容加密后经网络隧道传输。

- TRACE:追踪路径。服务器会将通信路径返回给客户端。发送请求时,在 Max-Forwards 首部字段中填入数值,每经过一个服务器就会减 1,当数值为 0 时就停止传输。通常不会使用 TRACE,并且它容易受到 XST 攻击(Cross-Site Tracing,跨站追踪)。

HTTP报文格式

请求报文

-

请求行:请求方法 url 版本号

-

请求头:

Host:接收请求的服务器地址,可以是ip也可以是端口号

User-Agent:发送请求的应用程序名称

Connection:指定与连接相关的属性,Connection:Keep-Alive

Accept-Charset:指定可接收的编码格式

Accept-Encoding:指定可接收的数据压缩格式

Accept-Language:指定可以接收的语言

-

空行:表示请求头结束

-

请求正文:可选,get就没有请求正文

响应报文

-

响应行:协议版、状态码,状态描述

-

响应头:

Content-Type:相应正文的类型(是图片还是二进制)

Content-Length:相应正文的长度

Content-Charset:相应正文的使用编码

Content-Encoding:相应正文使用的数据压缩格式

Content-Language:相应正文使用的语言

-

空行:表示响应头结束

-

响应正文:

![]()

![]()

说下 GET 和 POST 的区别?

GET 和 POST 本质都是 HTTP 请求,只不过对它们的作用做了界定和适配,并且让他们适应各自的场景。

本质区别:GET 只是一次 HTTP请求,POST 先发请求头再发请求体,实际上是两次请求。

-

从功能上讲,GET 一般用来从服务器上获取资源,POST 一般用来更新服务器上的资源;

-

从 REST 服务角度上说,GET 是幂等的,即读取同一个资源,总是得到相同的数据,而 POST 不是幂等的,因为每次请求对资源的改变并不是相同的;进一步地,GET 不会改变服务器上的资源,而 POST 会对服务器资源进行改变;

-

从请求参数形式上看,GET 请求的数据会附在 URL 之后,即将请求数据放置在 HTTP 报文的 请求头 中,以 ? 分割 URL 和传输数据,参数之间以 & 相连。特别地,如果数据是英文字母/数字,原样发送;否则,会将其编码为 application/x-www-form-urlencoded MIME 字符串(如果是空格,转换为+,如果是中文/其他字符,则直接把字符串用 BASE64 加密,得出如:%E4%BD%A0%E5%A5%BD,其中 %XX 中的 XX 为该符号以 16 进制表示的 ASCII);而 POST 请求会把提交的数据则放置在是 HTTP 请求报文的 请求体 中;

-

就安全性而言,POST 的安全性要比 GET 的安全性高,因为 GET 请求提交的数据将明文出现在 URL 上,而且 POST 请求参数则被包装到请求体中,相对更安全;

-

从请求的大小看,GET 请求的长度受限于浏览器或服务器对 URL 长度的限制,允许发送的数据量比较小,而 POST 请求则是没有大小限制的。

在浏览器中输入URL地址到显示主页的过程:

DNS解析------->TCP链接--------->发送HTTP请求---------->服务器处理请求并返回HTTP报文------->浏览器解析报文并渲染页面--------->连接结束

1.根据域名到DNS中找到IP

2.根据IP建立TCP连接(三次握手)

3.连接建立成功发起http请求

4.服务器响应http请求

5.浏览器解析HTML代码并请求html中的静态资源(js,css)

6.关闭TCP连接(四次挥手)

7.浏览器渲染页面

过程中使用到的协议:UDP协议,TCP协议,IP协议,ARP协议,SOFP协议

DNS解析的过程

以一个例子来说明:

假设域名m.xyz.com的主机想知道另一个主机y.abc.com的IP地址.那么DNS解析过程如下:

1.首先主机先向本地域名服务器发起查询

2.若本地域名服务器没有缓存该域名对应的IP地址,则向根域名服务器查询

3.根域名服务器告诉本地服务器,应该向哪一个顶级域名服务器去查询

4.然后本地域名服务器向顶级域名服务器发起查询

5.顶级域名服务器告诉本地域名服务器,下一步应该查询的权限服务器的IP地址

6.本地域名服务器向权限域名服务器发起查询

7.权限域名服务器告诉本地域名服务器所查询网址的IP地址

8.本地域名服务器将该IP发送给主机。

HTTP 长连接和短连接

Connection:keep-alive

操作系统

操作系统 内存分配与回收

操作系统 内存分配与回收

操作系统内存管理

内存管理方法

内存管理主要包括虚地址、地址变换、内存分配和回收、内存扩充、内存共享和保护等功能

连续分配存储管理方式

-

单一连续存储管理

在这种管理方式中,内存被分为两个区域:系统区和用户区。应用程序装入到用户区,可使用用户区全部空间。其特点是,最简单,适用于单用户、单任务的操作系统。CP/M和 DOS 2.0以下就是采用此种方式。这种方式的最大优点就是易于管理。但也存在着一些问题和不足之处,例如对要求内存空间少的程序,造成内存浪费;程序全部装入,使得很少使用的程序部分也占用—定数量的内存。

-

分区式存储管理

- 固定分区

- 动态分区

- 伙伴系统

简单Java基础

接口和抽象类的区别

最大的区别在于:

接口是对象功能的抽象,抽象类是对象本质的抽象。这个是最大区别

StringBuilder和StringBuffer

主要有线程安全、缓冲区、性能三方面的区别

-

线程安全方面

StringBuffer:线程安全的。StringBuilder:线程不安全。因为StringBuffer的所有公开方法都是synchronized修饰的,而StringBuilder并没有sychronized修饰。

-

缓冲区方面

StringBuffer每次获取toString都会直接使用缓存区的toStringCache值来构造一个字符串。StringBuilder则每次都需要复制一次字符数组,再构造一次字符串所以、

StringBuffer对缓冲区进行了优化。 -

性能方面

由于

StringBuilder没有加锁,所以性能要优于StringBuffer -

总结:

StringBuffer适用于多线程操作同一个StringBuffer的场景,StringBuilder在单线程场景下更为合适

Java创建对象的几种方式

- 通过new关键字来创建

- 通过反射来创建

- 通过clone()方法来创建

- 通过序列化机制来创建

为什么要重写equals方法

因为Object对象中equals方法(源码)中是比较两个对象是否相同,必须两个引用指向统一地址的才会返回true,而一般我们用equals方法来比较对象的内容是否相同,所以一般我们需要重写equals方法。

public class Object {

......

public boolean equals(Object obj) {

return (this == obj);

}

......

}

解决Hash冲突的方法

-

开放定址法:

就是一旦发生了冲突,就去寻找下一个空的散列地址,只要散列表足够大,空的散列地址总能找到,并将记录存入

-

拉链法

每个哈希表节点都有一个next指针,多个哈希表节点可以用next指针构成一个单向链表,被分配到同一个索引上的多个节点可以用这个单向链表连接起来

-

再哈希法

再哈希法又叫双哈希法,有多个不同的Hash函数,当发生冲突时,使用第二个,第三个,….,等哈希函数

-

建立公共溢出区法

将哈希表分为基本表和溢出表两部分,凡是和基本表发生冲突的元素,一律填入溢出表

深拷贝和浅拷贝

参考链接:(91条消息) 深拷贝和浅拷贝的区别_crystal_hhj的博客-CSDN博客_深拷贝和浅拷贝的区别

- 浅拷贝:被复制对象的所有变量都含有与原来的对象相同的值,而所有的对其他对象的引用仍然指向原来的对象.换言之,浅拷贝仅仅复制所考虑的对象,而不复制它所引用的对象.

- 深拷贝:被复制对象的所有变量都含有与原来的对象相同的值.而那些引用其他对象的变量将指向被复制过的新对象.而不再是原有的那些被引用的对象.换言之.深拷贝把要复制的对象所引用的对象都复制了一遍.

final有哪些用法

- final修饰的类不可以被继承,例如String类

- final修饰的方法不可以被重写

- final修饰的成员变量不可以被改写,如果修饰应用,那么表示引用的指向不可变,指向的内容可变

Java中的异常

Error:

是程序中无法处理的错误,表示运行应用程序中出现了严重的错误。此类错误一般表示代码运行时JVM出现问题。通常有Virtual MachineError(虚拟机运行错误)、NoClassDefFoundError(类定义错误)等。比如说当jvm耗完可用内存时,将出现OutOfMemoryError。此类错误发生时,JVM将终止线程。非代码性错误。因此,当此类错误发生时,应用不应该去处理此类错误。

Exception:

程序本身可以捕获并且可以处理的异常。

-

运行时异常(不受捡异常):

RuntimeException类极其子类表示JVM在运行期间可能出现的错误。编译器不会检查此类异常,并且不要求处理异常,比如用空值对象的引用(NullPointerException)、数组下标越界(ArrayIndexOutBoundException)。此类异常属于不可查异常,一般是由程序逻辑错误引起的,在程序中可以选择捕获处理,也可以不处理。

-

非运行异常(受检异常):

Exception中除RuntimeException极其子类之外的异常。编译器会检查此类异常,如果程序中出现此类异常,比如说IOException,必须对该异常进行处理,要么使用try-catch捕获,要么使用throws语句抛出,否则编译不通过。

ThreadLocal特性

ThreadLocal和Synchronized都是为了解决多线程中相同变量的访问冲突问题,不同的点是

- Synchronized是通过线程等待,牺牲时间来解决访问冲突

- ThreadLocal是通过每个线程单独一份存储空间,牺牲空间来解决冲突,并且相比于Synchronized,ThreadLocal具有线程隔离的效果,只有在线程内才能获取到对应的值,线程外则不能访问到想要的值。

正因为ThreadLocal的线程隔离特性,使他的应用场景相对来说更为特殊一些。在android中Looper、ActivityThread以及AMS中都用到了ThreadLocal。当某些数据是以线程为作用域并且不同线程具有不同的数据副本的时候,就可以考虑采用ThreadLocal。

Java assert关键字

Java assert关键字

CAS原理

CAS原理

AQS原理

什么是CAS、什么是AQS - 知乎 (zhihu.com)

AQS:AbstractQuenedSynchronizer抽象的队列式同步器。是除了java自带的synchronized关键字之外的锁机制。

AQS的全称为(AbstractQueuedSynchronizer),这个类在java.util.concurrent.locks包

AQS的核心思想:,如果被请求的共享资源空闲,则将当前请求资源的线程设置为有效的工作线程,并将共享资源设置为锁定状态,如果被请求的共享资源被占用,那么就需要一套线程阻塞等待以及被唤醒时锁分配的机制,这个机制AQS是用CLH队列锁实现的,即将暂时获取不到锁的线程加入到队列中。CLH(Craig,Landin,and Hagersten)队列是一个虚拟的双向队列,虚拟的双向队列即不存在队列实例,仅存在节点之间的关联关系。

AQS是将每一条请求共享资源的线程封装成一个CLH锁队列的一个结点(Node),来实现锁的分配。

用大白话来说,AQS就是基于CLH队列,用volatile修饰共享变量state,线程通过CAS去改变状态符,成功则获取锁成功,失败则进入等待队列,等待被唤醒。

**注意:AQS是自旋锁:**在等待唤醒的时候,经常会使用自旋(while(!cas()))的方式,不停地尝试获取锁,直到被其他线程获取成功

实现了AQS的锁有:自旋锁、互斥锁、读锁写锁、条件产量、信号量、栅栏都是AQS的衍生物、

![]()

如图示,AQS维护了一个volatile int state和一个FIFO线程等待队列,多线程争用资源被阻塞的时候就会进入这个队列。state就是共享资源,其访问方式有如下三种:

getState();setState();compareAndSetState();

AQS 定义了两种资源共享方式:

1.Exclusive:独占,只有一个线程能执行,如ReentrantLock

2.Share:共享,多个线程可以同时执行,如Semaphore、CountDownLatch、ReadWriteLock,CyclicBarrier

不同的自定义的同步器争用共享资源的方式也不同。

AQS底层使用了模板方法模式

同步器的设计是基于模板方法模式的,如果需要自定义同步器一般的方式是这样(模板方法模式很经典的一个应用):

- 使用者继承AbstractQueuedSynchronizer并重写指定的方法。(这些重写方法很简单,无非是对于共享资源state的获取和释放)

- 将AQS组合在自定义同步组件的实现中,并调用其模板方法,而这些模板方法会调用使用者重写的方法。

这和我们以往通过实现接口的方式有很大区别,这是模板方法模式很经典的一个运用。

自定义同步器在实现的时候只需要实现共享资源state的获取和释放方式即可,至于具体线程等待队列的维护,AQS已经在顶层实现好了。自定义同步器实现的时候主要实现下面几种方法:

isHeldExclusively():该线程是否正在独占资源。只有用到condition才需要去实现它。

tryAcquire(int):独占方式。尝试获取资源,成功则返回true,失败则返回false。

tryRelease(int):独占方式。尝试释放资源,成功则返回true,失败则返回false。

tryAcquireShared(int):共享方式。尝试获取资源。负数表示失败;0表示成功,但没有剩余可用资源;正数表示成功,且有剩余资源。

tryReleaseShared(int):共享方式。尝试释放资源,如果释放后允许唤醒后续等待结点返回true,否则返回false。

ReentrantLock为例,(可重入独占式锁):state初始化为0,表示未锁定状态,A线程lock()时,会调用tryAcquire()独占锁并将state+1.之后其他线程再想tryAcquire的时候就会失败,直到A线程unlock()到state=0为止,其他线程才有机会获取该锁。A释放锁之前,自己也是可以重复获取此锁(state累加),这就是可重入的概念。

注意:获取多少次锁就要释放多少次锁,保证state是能回到零态的。

以CountDownLatch为例,任务分N个子线程去执行,state就初始化 为N,N个线程并行执行,每个线程执行完之后countDown()一次,state就会CAS减一。当N子线程全部执行完毕,state=0,会unpark()主调用线程,主调用线程就会从await()函数返回,继续之后的动作。

一般来说,自定义同步器要么是独占方法,要么是共享方式,他们也只需实现tryAcquire-tryRelease、tryAcquireShared-tryReleaseShared中的一种即可。但AQS也支持自定义同步器同时实现独占和共享两种方式,如ReentrantReadWriteLock。

在acquire() acquireShared()两种方式下,线程在等待队列中都是忽略中断的,acquireInterruptibly()/acquireSharedInterruptibly()是支持响应中断的。

反射:

反射就是把Java类中的各个成分映射成一个个的Java对象。即在运行状态中,对于任意一个类,都能够知道这个类的所以属性和方法;对于任意一个对象,都能调用它的任意一个方法和属性。这种动态获取信息及动态调用对象方法的功能叫Java的反射机制。

1. 反射机制的功能

Java反射机制主要提供了以下功能:

- 在运行时判断任意一个对象所属的类。

- 在运行时构造任意一个类的对象。

- 在运行时判断任意一个类所具有的成员变量和方法。

- 在运行时调用任意一个对象的方法。

- 生成动态代理。

2. 实现反射机制的类

Java中主要由以下的类来实现Java反射机制(这些类都位于java.lang.reflect包中):

-

Class类:代表一个类。 Field类:代表类的成员变量(成员变量也称为类的属性)。

-

Method类:代表类的方法。

-

Constructor类:代表类的构造方法。

-

Array类:提供了动态创建数组,以及访问数组的元素的静态方法。

注解

Java基础

深入理解new String()

(91条消息) 深入了解new String()_小胖java攻城狮的博客-CSDN博客_new string

HashMap

数据结构:

HashMap内部使用链表+数组+红黑树的结构。

插入元素的流程

- 判断数组是否为空,为空进行初始化;

- 不为空,计算 k 的 hash 值,通过

(n - 1) & hash计算应当存放在数组中的下标 index; - 查看 table[index] 是否存在数据,没有数据就构造一个Node节点存放在 table[index] 中;

- 存在数据,说明发生了hash冲突(存在二个节点key的hash值一样), 继续判断key是否相等,相等,用新的value替换原数据(onlyIfAbsent为false);

- 如果不相等,判断当前节点类型是不是树型节点,如果是树型节点,创造树型节点插入红黑树中;(如果当前节点是树型节点证明当前已经是红黑树了)

- 如果不是树型节点,创建普通Node加入链表中;判断链表长度是否大于 8并且数组长度大于64, 大于的话链表转换为红黑树;

- 插入完成之后判断当前节点数是否大于阈值,如果大于开始扩容为原数组的二倍。

HashMap怎么设定初始容量大小:

默认大小是16,负载因子是0.75, 如果自己传入初始大小k,初始化大小为 大于k的 2的整数次方,例如如果传10,大小为16

hash函数如何设计

hash函数是先拿到 key 的hashcode,是一个32位的int值,然后让hashcode的高16位和低16位进行异或操作。

为什么这么设计:

因为key.hashCode()函数调用的是key键值类型自带的哈希函数,返回int型散列值。int值范围为**-2147483648~2147483647**,前后加起来大概40亿的映射空间。只要哈希函数映射得比较均匀松散,一般应用是很难出现碰撞的。但问题是一个40亿长度的数组,内存是放不下的。你想,如果HashMap数组的初始大小才16,用之前需要对数组的长度取模运算,得到的余数才能用来访问数组下标。

源码中模运算就是把散列值和数组长度-1做一个"与"操作,位运算比取余%运算要快。

bucketIndex = indexFor(hash, table.length);

static int indexFor(int h, int length) {

return h & (length-1);

}

顺便说一下,这也正好解释了为什么HashMap的数组长度要取2的整数幂。因为这样(数组长度-1)正好相当于一个“低位掩码”。“与”操作的结果就是散列值的高位全部归零,只保留低位值,用来做数组下标访问。以初始长度16为例,16-1=15。2进制表示是00000000 00000000 00001111。和某散列值做“与”操作如下,结果就是截取了最低的四位值。

但这时候问题就来了,这样就算我的散列值分布再松散,要是只取最后几位的话,碰撞也会很严重。更要命的是如果散列本身做得不好,分布上成等差数列的漏洞,如果正好让最后几个低位呈现规律性重复,就无比蛋疼。

右移16位,正好是32bit的一半,自己的高半区和低半区做异或,就是为了混合原始哈希码的高位和低位,以此来加大低位的随机性。而且混合后的低位掺杂了高位的部分特征,这样高位的信息也被变相保留下来。

为什么这么设计:

- 一定要尽可能降低hash碰撞,越分散越好;

- 算法一定要尽可能高效,因为这是高频操作, 因此采用位运算;

Java1.8对HashMap做了什么改进

- 数组+链表改成了数组+链表或红黑树;

- 链表的插入方式从头插法改成了尾插法,简单说就是插入时,如果数组位置上已经有元素,1.7将新元素放到数组中,原始节点作为新节点的后继节点,1.8遍历链表,将元素放置到链表的最后;

- 扩容的时候1.7需要对原数组中的元素进行重新hash定位在新数组的位置,1.8采用更简单的判断逻辑,位置不变或索引+旧容量大小;

- 在插入时,1.7先判断是否需要扩容,再插入,1.8先进行插入,插入完成再判断是否需要扩容;

为什么要改进

-

防止发生hash冲突,链表长度过长,将时间复杂度由

O(n)降为O(logn); -

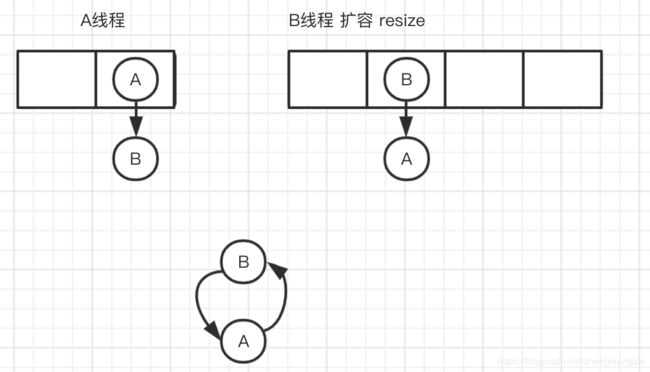

因为1.7头插法扩容时,头插法会使链表发生反转,多线程环境下会产生环;

A线程在插入节点B,B线程也在插入,遇到容量不够开始扩容,重新hash,放置元素,采用头插法,后遍历到的B节点放入了头部,这样形成了环,如下图所示:

扩容的时候为什么1.8 不用重新hash就可以直接定位原节点在新数据的位置呢?

这是由于扩容是扩大为原数组大小的2倍,用于计算数组位置的掩码仅仅只是高位多了一个1,怎么理解呢?

扩容前长度为16,用于计算(n-1) & hash 的二进制n-1为0000 1111,扩容为32后的二进制就高位多了1,为0001 1111。

因为是& 运算,1和任何数 & 都是它本身,那就分二种情况,如下图:原数据hashcode高位第4位为0和高位为1的情况;

第四位高位为0,重新hash数值不变,第四位为1,重新hash数值比原来大16(旧数组的容量)

那1.8后HashMap是线程安全的吗?

安琪拉: 不是,在多线程环境下,1.7 会产生死循环、数据丢失、数据覆盖的问题,1.8 中会有数据覆盖的问题,以1.8为例,当A线程判断index位置为空后正好挂起,B线程开始往index位置的写入节点数据,这时A线程恢复现场,执行赋值操作,就把A线程的数据给覆盖了;还有++size这个地方也会造成多线程同时扩容等问题。

LinkedList和ArrayList的区别

ArrayList底层是基于数组实现的,查询效率较高,增删改查的效率较低。

LinkedList底层是基于链表实现的,查询效率较低,增删速度较快

两者都不是线程安全的。

concurrentHashMap

ConcurrentHashMap成员变量使用volatile 修饰,免除了指令重排序,同时保证内存可见性,另外使用CAS操作和synchronized结合实现赋值操作,多线程操作只会锁住当前操作索引的节点。

因为在多线程环境下,使用HashMap进行put操作可能会引起死循环,导致cpu利用率接近100%,所以在并发情况下不能使用HashMap

因此针对这一问题:出现了Hashtable 和concurrentHashMap

-

hashtable

Hashtable使用synchronized来保证线程安全,但在线程竞争激烈的情况下,hashtable的效率非常低下。因为在同一时刻只能有一个线程占有资源,其他线程都处于等待状态。

-

concurrentHashMap

concurrentHashMap采用分段锁的思想,将数据分成一段一段存储,然后给每一段数据配上一把锁,当一个线程占用锁访问其中一段数据时,其他线程也可以访问别的段数据。

-

总结

Hashtable的任何操作都会把整个表锁住,是阻塞的。好处是总能获取最实时的更新,比如说线程A调用putAll写入大量数据,期间线程B调用get,线程B就会被阻塞,直到线程A完成putAll,因此线程B肯定能获取到线程A写入的完整数据。坏处是所有调用都要排队,效率较低。

ConcurrentHashMap 是设计为非阻塞的。在更新时会局部锁住某部分数据,但不会把整个表都锁住。同步读取操作则是完全非阻塞的。好处是在保证合理的同步前提下,效率很高。坏处是严格来说读取操作不能保证反映最近的更新。例如线程A调用putAll写入大量数据,期间线程B调用get,则只能get到目前为止已经顺利插入的部分数据。

应该根据具体的应用场景选择合适的HashMap。

sychronized和ReentrantLock

Synchronized

Java的关键字

为对象,代码块,方法提供线程安全的操作

属于独占式的悲观锁,同时属于可重入锁。

Java中每个对象都有一个monitor对象,加锁就是在竞争monitor对象。对代码块进行加锁是通过在前后分别加上monitorenter和monitorexit来实现的

Synchronized的作用范围

synchronized作用于成员变量和静态方法时,锁住的是对象的实例,即this对象synchronized作用于静态方法时,锁住的是class实例,因为静态方法属于类synchronized作用于一个代码块时,锁住的是所有代码块中配置的对象

ReentrantLock

Lock接口的实现类,是一个可重入的独占锁

可重入锁指的是允许一个线程对同一资源执行多次加锁操作。

ReentrantLock支持公平锁和非公平锁的实现

ReentrantLock不仅提供了synchronized对锁的操作功能,**还提供了可响应中断锁,可轮询锁请求,定时锁等避免多线程死锁的方法。

sychronized关键字原理

在synchronized内部包括ContentionList、EntryList、WaitSet、OnDeck、Owner、!Owner这6个区域,每个区域都代表锁的不同状态。

-

ContentionList:锁竞争队列,所有请求锁的线程都被放在竞争队列中

-

EntryList竞争候选列表,在

ContentionList中有资格成为候选者来竞争锁资源的线程被移动到了EntryList中 -

WaitSet等待集合,调用

wait方法后被阻塞的线程将被放在WaitSet中 -

OnDeck竞争候选者,在同一时刻最多只有一个线程在竞争锁资源,该线程的状态被称为

OnDeck -

Owner竞争到锁资源的线程被称为

Owner状态线程 -

!Owner在

Owner线程释放后,会从Owner的状态变成!Owner。

synchronized在收到新的锁请求时首先自旋,如果通过自旋也没有获取锁资源,则将被放入锁竞争队列ContentionList中,Owner

会在释放锁资源的时候,将ContentionList中的部分线程移动到EntryList中,然后将EntryList中的某个线程(一般遵循先进先出规则)设为OnDeck线程。

值得注意的是,Owner并没有将锁资源直接交给OnDeck线程,而是把锁竞争的权利交给OnDeck线程,让OnDeck线程重新竞争锁,该操作牺牲了公平性,但提高了性能。

获取到锁资源的OnDeck线程会变成Owner线程,而未获取到锁资源的线程仍然停留在EntryList中。

Owner线程在被wait方法阻塞后,会被移动到WaitSet队列,直到notify方法或者notifyAll方法通知后被唤醒,从而进入到EntryList,重新竞争锁资源。

ReentrantLock实现原理

ReentrantLock是一个可重入的锁,内部采用AQS来实现

首先看一下AQS中比较重要的属性

exclusiveOwnerThread:独占锁线程,指向了当前获取到锁的线程

state:AQS的核心,AQS就是用这个字段来实现锁的获取和重入,在没有线程获取到锁的时候,锁的状态为0,获取的时候,通过cas对其进行+1,并且每重入一次再 +1,释放一次 -1,具体的后面代码展示

head,tail:AQS维护了一个内部类Node的双向队列,由未获取到锁的线程包装成的Node节点组成,也就是获取锁失败加入队列尾部。

AQS的获取锁过程分析

线程通过CAS将state从0设置为1,如果设置成功,说明获取锁成功,并且将exclusiveOwnerThread指向自己;

当调用lock方法时,公平锁和非公平锁的实现有区别

非公平锁的实现:线程会直接进行CAS操作去设置state,如果成功就获取到锁,如果失败,继续调用NonFairSync的acquire(1)方法

公平锁的实现:线程会直接调用FairSync的accquire(1)方法,这两个方法都调用了AQS的方法

公平锁与非公平锁的区别:

- //差别就在这里,多了一个hasQueuedPredecessors方法,这是跟非公平锁唯一的区别

- //也就是为什么叫公平锁体现在这里。

- //这里判断有没有别的线程比他更早来,如果返回true说明有,肯定就直接获取失败了

- //如果没有别他更早来的线程,那么自己就可以去尝试获取锁了

总结一下,AQS中维护了一堆wait线程组成的等待队列,凡是进入了这个队列的线程,之后就会按顺序一个一个获取到锁,执行逻辑,也就是将他们串行化了,那么公平和非公平体现在什么地方呢?

就是tryAcquire这里,公平锁是说新线程进来对于队列中的线程是公平的,如果队列中有等待线程,它就直接往后排,而非公平锁是,新线程对于队列中的等待线程是不公平的,可能存在队列中的头节点释放掉锁之后唤醒下一个线程,结果有一个新的线程进来同时获取锁,这个时候他们机会是平等的,因此说这是非公平锁。

具体的链接:https://blog.csdn.net/yanyan19880509/article/details/52345422

sychronized和lock共同点和区别

sychronized和ReentrantLock的共同点如下:

-

都用于控制多线程对共享对象的访问

-

都是可重用锁

-

都保证了可见性和互斥性

区别:

-

底层实现:sychronized是Java中的关键字,是由JVM来维护的,是JVM层面的锁 lock是一个类,是java代码层面的锁底层实现的

-

使用方式不同:sychronized在使用时候,获取锁和释放锁,都是由系统维护的。而使用lock的需要手动获取锁,手动释放锁。

-

异常的处理方式:sync在线程发生异常时会自动释放锁,不会发生异常死锁,Lock异常时不会自动释放锁,所以需要在finally中实现释放锁。

-

等待是否可中断:sychronized是不可中断的,除非抛出异常或者正常运行完成,Lock是可以中断的,中断方式有:

- 调用设置超时方法

tryLock(long timeout,timeUnit unit) - 调用

lockInterruptibly()放到代码块中,然后调用interrupt()方法可以中断

- 调用设置超时方法

-

加锁的时候是否可以公平:sync是非公平锁,lock既可以公平也可以不公平

-

锁可以绑定多个条件:

sync:要么随机唤醒一个线程,要么是唤醒所有等待的线程

lock:用来实现分组唤醒所需要唤醒的线程,可以精确的唤醒线程。

-

从锁的实现机制来看:

sync采用的是独占锁,也就是悲观锁的机制

lock采用的是乐观锁,所谓乐观锁就是每次不加锁而是假设没有冲突而去完成某项操作,如果因为冲突失败就重试,直到成功为止。

volatile关键字

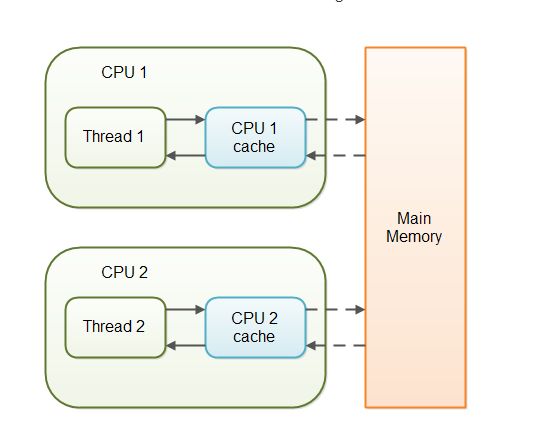

volatile,用来将变量的更新操作通知到其他线程,当把变量声明为volatile类型后,编译器与运行时都会注意到这个变量是共享的,因此不会将改变量上的操作与其他内存操作一起重排序。volatile变量不会被缓存在寄存器或者对其他处理器不可见的地方,因此在读取volatile类型的变量时总会返回最新写入的值。

当对非 volatile 变量进行读写的时候,每个线程先从内存拷贝变量到CPU缓存中。如果计算机有多个CPU,每个线程可能在不同的CPU上被处理,这意味着每个线程可以拷贝到不同的 CPU cache 中。

而声明变量是 volatile 的,JVM 保证了每次读变量都从内存中读,跳过 CPU cache 这一步。

当一个变量定义为volatile之后,将具备两种特性:

1.保证此变量对所有的线程的可见性,这里的“可见性”,如本文开头所述,当一个线程修改了这个变量的值,volatile 保证了新值能立即同步到主内存,以及每次使用前立即从主内存刷新。但普通变量做不到这点,

2.禁止指令重排序优化。有volatile修饰的变量,赋值后多执行了一个“load addl $0x0, (%esp)”操作,这个操作相当于一个内存屏障(指令重排序时不能把后面的指令重排序到内存屏障之前的位置),只有一个CPU访问内存时,并不需要内存屏障;(什么是指令重排序:是指CPU采用了允许将多条指令不按程序规定的顺序分开发送给各相应电路单元处理)。

volatile 性能:

volatile 的读性能消耗与普通变量几乎相同,但是写操作稍慢,因为它需要在本地代码中插入许多内存屏障指令来保证处理器不发生乱序执行。

线程池

线程池的结构:

- 线程池管理器

- 工作线程

- 任务接口

- 任务队列

线程池刚被创建时,只是向系统申请一个用于执行线程队列和管理线程池的线程资源,在调用execute()添加一个任务时,线程池会按照以下流程执行任务:

(1): 如果正在运行的线程数量小于corePoolSize(核心线程数量),线程池就会立刻创建线程并执行该线程任务

(2):如果正在运行的线程数量大于等于corePoolSize,该任务就将被放入阻塞队列中。

(3):在阻塞队列已满且正在运行的线程数量少于maximumPoolSize时,线程池会创建非核心线程立刻执行该线程任务

(4):在阻塞队列已满且正在运行的线程数量大于等于maximumPoolSize时,线程池将拒绝执行该线程任务并抛出RejectExecutionException异常

(5):在线程执行任务完毕后,该任务将被从线程池队列中移除,线程池将从队列中取下一个线程任务继续执行。

(6):在线程处于空闲状态的时间超过keepAliveTime时间时,正在运行的线程数量超过corePoolSize,该线程将会被认定为空闲线程并停止。因此在线程池中所有线程任务都执行完毕后,线程池会收缩到corePoolSize大小。

线程池的拒绝策略:

- AbortPolicy:直接抛出异常,阻止线程正常运行

- CallerRunsPolicy:如果被丢弃的线程未关闭,则执行该线程任务

- DiscardOldestPolicy: 移除线程队列中最早的一个线程任务,并尝试执行当前任务

- DiscardPolicy:丢弃当前任务而不做任何处理

- 自定义拒绝策略:继承RejectedExecutionHandler接口

五种常用的线程池:

- newCachedThreadPool:可缓存的线程池

- newFixedThreadPool:固定大小的线程池

- newScheduledThreadPool: 可做任务调度的线程池

- newSingleThreadExecutor: 单个线程的线程池

- newWorkStealingPool: 足够大小的线程池

Java线程的创建方式

-

继承Thread类

-

实现Runnable接口

-

通过ExecutorService和Callable实现有返回值的线程

Java中线程调度

两种线程的调度模式:

抢占式调度:

抢占式调度指的是每条线程执行的时间、线程的切换都由系统控制,系统控制指的是在系统某种运行机制下,可能每条线程都分同样的执行时间片,也可能是某些线程执行的时间片较长,甚至某些线程得不到执行的时间片。在这种机制下,一个线程的堵塞不会导致整个进程堵塞。

协同式调度:

协同式调度指某一线程执行完后主动通知系统切换到另一线程上执行,这种模式就像接力赛一样,一个人跑完自己的路程就把接力棒交接给下一个人,下个人继续往下跑。线程的执行时间由线程本身控制,线程切换可以预知,不存在多线程同步问题,但它有一个致命弱点:如果一个线程编写有问题,运行到一半就一直堵塞,那么可能导致整个系统崩溃。

JVM的实现:

JVM规范中规定每个线程都有优先级,且优先级越高越优先执行,但优先级高并不代表能独自占用执行时间片,可能是优先级高得到越多的执行时间片,反之,优先级低的分到的执行时间少但不会分配不到执行时间。

java使用的线程调度式抢占式调度

Java中线程会按优先级分配CPU时间片运行

线程让出cpu的情况:

-

当前运行线程主动放弃CPU,JVM暂时放弃CPU操作(基于时间片轮转调度的JVM操作系统不会让线程永久放弃CPU,或者说放弃本次时间片的执行权),例如调用yield()方法。

-

当前运行线程因为某些原因进入阻塞状态,例如阻塞在I/O上。

-

当前运行线程结束,即运行完run()方法里面的任务。

进程调度算法

- 优先调度算法

- 先来先服务调度算法

- 短作业(进程)优先调度算法

- 高优先权优先调度算法

- 抢占式优先调度算法

- 非抢占式优先调度算法

- 高响应比优先调度算法

- 时间片的轮转调度算法

- 时间片轮转法

- 多级反馈队列调度算法

JVM内存结构介绍

- 虚拟机栈:线程私有的内存区域,每创建一个线程都会对应创建一个Java栈,这个栈中又会对应多个栈帧,栈帧是用来存储方法数据和部分过程结果的数据结构,每调用一个方法就会往栈中创建并压入一个栈帧,每一个方法从调用到最终返回结果的过程,就对应一个栈帧从入栈到出栈的过程。

- 程序计数器:保存着当前线程执行的虚拟机字节码指令的内存地址。每个线程都会设立一个程序计数器,程序计数器是线程私有的内存区域

- 本地方法栈:和虚拟机栈的作用相似,不过虚拟机栈是为Java方法服务的,而本地方法栈是为Native方法服务的。

- 方法区:方法区(Method Area)是用于存储类结构信息的地方,包括常量池、静态变量、构造函数等类型信息,类型信息是由类加载器在类加载时从类文件中提取出来的。方法区同样存在垃圾收集,因为用户通过自定义加载器加载的一些类同样会成为垃圾,JVM会回收一个未被引用类所占的空间,以使方法区的空间达到最小。方法区中还存在着常量池,常量池包含着一些常量和符号引用(加载类的连接阶段中的解析过程会将符号引用转换为直接引用)。方法区是线程共享的。

- 堆:堆(heap)是存储java实例或者对象的地方,是GC的主要区域,同样是线程共享的内存区域。

总结:

-

所有线程共享的内存数据区:方法区,堆。而虚拟机栈,本地方法栈和程序计数器都是线程私有的。

-

存放于栈中的东西如下:

- 每个线程包含一个栈区,栈中只保存基础数据类型的对象和自定义对象的引用(不是对象)。对象都存放在堆区中。

- 每个栈中的数据(基础数据类型和对象引用)都是私有的,其他栈不能访问。

- 方法的形式参数,方法调用完后从栈空间回收

- 引用对象的地址,引用完后,栈空间地址立即被回收,堆空间等待GC

-

存放于堆中的东西如下:

- 存储的全部是对象,每个对象包含一个与之对应的class信息

- Jvm只有一个堆区(heap)被所有线程共享,堆区中不存放基本类型和对象引用,只存放对象本身

-

存放于方法区中的东西如下:

- 存放线程所执行的字节码指令

- 跟堆一样.被所有线程共享.方法区包含:所有的class和static变量

- 常量池位于方法区中

垃圾回收算法

新生代的垃圾回收算法:

- Serial:单线程复制算法

- ParNew:多线程复制算法:默认开启与CPu同等数量的线程进行垃圾回收

- Parallel Scavenge:多线程复制算法:提供了三个参数用于调节、控制垃圾回收的停顿时间及吞吐量,分别是控制最大垃圾收集停顿时间、控制吞吐量的大小、控制自适应调节策略开启与否的参数。

老年代的垃圾回收算法:

- CMS:多线程标记清除算法

- Serial Old:单线程标记整理算法

- Parallel Old:多线程标记整理算法:在设计上优先考虑吞吐量,其次考虑停顿时间等因素

全区收集算法:

- G1:多线程标记整理算法

CMS垃圾收集器介绍:

CMS主要目的是达到最短的垃圾回收停顿时间,基于线程的标记清除算法实现。

四个阶段:

- 初始标记:只标记和GC Roots直接关联的对象,速度很快,需要暂停所有工作线程

- 并发标记:标记GC Root间接关联的对象,不需要暂停工作线程

- 重新标记:在并发标记过程中用户线程继续执行使得部分对象的状态发生了变化,需要重新标记,需要暂停所有工作线程

- 并发清除:清除GC Roots 不可达的对象。

引用计数和可达性分析

引用计数法:在为对象添加一个引用时,引用计数加1,在为对象删除一个引用时,引用计数减1,如果引用计数为0,说明此刻该对象没有被引用,可以被回收。引用计数法容易产生循环引用的问题,使得对象不能被回收。

可达性分析:首先定义一些GC Roots对象,然后以这些GC Roots对象作为起点向下搜索,如果在GC Roots和一个对象之间没有可达路径,则称该对象是不可达的,不可达的对象至少经过两次标记才能判断其是否可以被回收,如果在两次标记后,该对象任然不可达的,则将被垃圾回收器回收。

Java内存溢出(OOM)异常排查

OOM:java heap space

**原因1:**当应用程序试图向堆空间添加更多的数据,但堆却没有足够的空间来容纳这些数据时,将会触发OOM: Java heap space异常。需要注意的是:即使有足够的物理内存可用,只要达到堆空间设置的大小限制,此异常仍然会被触发。可以使用参数-Xmx和-XX:MaxPermSize设置堆空间的大小

**原因2:**流量/数据量峰值:应用程序在设计之初均有用户量和数据量的限制,某一时刻,当用户数量或数据量突然达到一个峰值,并且这个峰值已经超过了设计之初预期的阈值,那么以前正常的功能将会停止,并触发OOM: Java heap space异常。

**原因3:**内存泄漏:特定的编程错误会导致你的应用程序不停的消耗更多的内存,每次使用有内存泄漏风险的功能就会留下一些不能被回收的对象到堆空间中,随着时间的推移,泄漏的对象会消耗所有的堆空间,最终触发OOM: Java heap space错误。

OOM:GC overhead limit exceeded

**原因:**当应用程序花费超过98%的实践用来做GC并且回收了不到2%的堆内存时,会抛出OOM:GC overhead limit exceeded错误,具体表现就是你的应用几乎耗尽所有可用内存,并且GC多次均未能清理干净。

OOM:Permgen space

Java1.7中会出现这个错误,Java1.8已经采用元空间(MetaSpace)来取代,不会出现这种错误。

Java中堆空间是JVM管理的最大一块内存空间,可以在JVM启动时指定堆空间的大小,其中堆被划分成两个不同的区域:新生代(Young)和老年代(Tenured),新生代又被划分为3个区域:Eden、From Survivor、To Survivor

java.lang.OutOfMemoryError: PermGen space错误就表明持久代所在区域的内存已被耗尽。

**原因:首先需要理解Permanent Generation Space的用处是什么。持久代主要存储的是每个类的信息,比如:类加载器引用、运行时常量池(所有常量、字段引用、方法引用、属性)、字段(Field)数据、方法(Method)数据、方法代码、**方法字节码等等。我们可以推断出,PermGen的大小取决于被加载类的数量以及类的大小。因此,我们可以得出出现java.lang.OutOfMemoryError: PermGen space错误的原因是:太多的类或者太大的类被加载到permanent generation(持久代)。

解决方案:

-

1.解决初始化时的OOM

当在应用程序启动期间触发由于

PermGen耗尽引起的OutOfMemoryError时,解决方案很简单。 应用程序需要更多的空间来加载所有的类到PermGen区域,所以我们只需要增加它的大小。 为此,请更改应用程序启动配置,并添加(或增加,如果存在)-XX:MaxPermSize参数,类似于以下示例:java -XX:MaxPermSize=512m com.yourcompany.YourClass -

2.解决Redeploy时的OOM

分析dump文件:首先,找出引用在哪里被持有;其次,给你的web应用程序添加一个关闭的hook,或者在应用程序卸载后移除引用。你可以使用如下命令导出dump文件:

jmap -dump:format=b,file=dump.hprof如果是你自己代码的问题请及时修改,如果是第三方库,请试着搜索一下是否存在"关闭"接口,如果没有给开发者提交一个bug或者issue吧。

-

3.解决运行时OOM

首先你需要检查是否允许GC从

PermGen卸载类,JVM的标准配置相当保守,只要类一创建,即使已经没有实例引用它们,其仍将保留在内存中,特别是当应用程序需要动态创建大量的类但其生命周期并不长时,允许JVM卸载类对应用大有助益,你可以通过在启动脚本中添加以下配置参数来实现:-XX:+CMSClassUnloadingEnabled默认情况下,这个配置是未启用的,如果你启用它,GC将扫描

PermGen区并清理已经不再使用的类。但请注意,这个配置只在UseConcMarkSweepGC的情况下生效,如果你使用其他GC算法,比如:ParallelGC或者Serial GC时,这个配置无效。所以使用以上配置时,请配合:-XX:+UseConcMarkSweepGC如果你已经确保JVM可以卸载类,但是仍然出现内存溢出问题,那么你应该继续分析dump文件,使用以下命令生成dump文件:

jmap -dump:file=dump.hprof,format=b当你拿到生成的堆转储文件,并利用像Eclipse Memory Analyzer Toolkit这样的工具来寻找应该卸载却没被卸载的类加载器,然后对该类加载器加载的类进行排查,找到可疑对象,分析使用或者生成这些类的代码,查找产生问题的根源并解决它。

OOM:Metaspace

**原因:**太多的类或太大的类加载到元空间。

**解决方法:**扩大MetaSpace的空间

OOM:Unable to create new native thread

JVM中的线程完成自己的工作也是需要一些空间的,当有足够多的线程却没有那么多的空间时就会像这样:

OOM:Out of swap space

Java应用程序在启动时会指定所需要的内存大小,可以通过-Xmx和其他类似的启动参数来指定。在JVM请求的总内存大于可用物理内存的情况下,操作系统会将内存中的数据交换到磁盘上去。Out of swap space?表示交换空间也将耗尽,并且由于缺少物理内存和交换空间,再次尝试分配内存也将失败。

OOM:Requested array size exceeds VM limit

Java对应用程序可以分配的最大数组大小有限制。不同平台限制有所不同,但通常在1到21亿个元素之间。

OOM:Out of memory:Kill process or sacrifice child

为了理解这个错误,我们需要补充一点操作系统的基础知识。操作系统是建立在进程的概念之上,这些进程在内核中作业,其中有一个非常特殊的进程,名叫“内存杀手(Out of memory killer)”。当内核检测到系统内存不足时,OOM killer被激活,然后选择一个进程杀掉。

OOM:kill process or sacrifice child

为了理解这个错误,我们需要补充一点操作系统的基础知识。操作系统是建立在进程的概念之上,这些进程在内核中作业,其中有一个非常特殊的进程,名叫“内存杀手(Out of memory killer)”。当内核检测到系统内存不足时,OOM killer被激活,然后选择一个进程杀掉。哪一个进程这么倒霉呢?选择的算法和想法都很朴实:谁占用内存最多,谁就被干掉。

怎么排查线程问题

1. 通过top命令查看当前系统CPU使用情况,定位CPU使用率超过100%的进程ID;

2. 通过ps aux | grep PID命令进一步确定具体的线程信息;

3. 通过ps -mp pid -o THREAD,tid,time命令显示线程信息列表,然后找到耗时的线程ID;

4. 将需要的线程ID转换为16进制格式:printf "%x\n" tid

5. 最后找到线程堆栈信息:jstack pid |grep tid ,其中tid是上面转换后的16进制的线程ID

虚拟机性能监控和故障处理工具

虚拟机进程状况工具 (jps)

jps :JVM Process Status Tool

功能: 列出正在运行的虚拟机进程,并显示虚拟机执行主类名称以及这些进程的本地虚拟机唯一ID

虚拟机统计信息监视工具(jstat)

jstat : JVM Statistics Monitoring Tool

功能:用于监视虚拟机各种运行状态信息的命令行工具。它可以显示本地或者远程虚拟机进程的类装载、内存、垃圾回收、JIT编译等运行数据。

例子:假如需要每250毫秒查询一次进程2764的垃圾收集状况,一共查询20次,那么命令应该是

jstat -gc 2764 250 20

jinfo: Java配置信息工具

功能:实时查看和调整虚拟机各项参数。

jmap: Java内存映像工具

功能:用于生成堆转储快照。如果不想使用jmap命令,要想获得堆转储快照,还有其他方法:

- 用 -XX:+HeapDumpOnOutOfMemoryError参数,可以让虚拟机在OOM异常出现之后自动生成dump文件

- 用 -XX:+HeapDumpOnCtrlBreak参数,可以使用[ctrl]+[break]键让虚拟机生成dump文件。

- 又或者在Linux系统下通过 Kill -3 命令发送进程退出信号“吓唬”一下虚拟机,也能拿到dump文件。

jmap的作用并不仅仅是为了获取dump文件,还可以查询finalize执行队列、Java堆和永久代的详细信息、如空间使用率、当前使用的时哪种收集器等。

jhat: 虚拟机堆转储快照分析工具

功能:配合jmap使用,分析dump文件,但一般不用,因为有比其更优秀的分析工具。

jstack:Java堆栈跟踪工具

jstack命令用于生成虚拟机当前时刻的线程快照(一般称为threaddump或者javacore文件)。线程快照就是当前虚拟机内每一条线程正在执行的方法堆栈的集合。生成快照的主要目的是定位线程出现长时间停顿的原因,如线程间死锁,死循环、请求外部资源导致的长时间等待等都是导致线程长时间停顿的常见原因。

死锁出现的原因

什么是死锁、产生死锁的原因、解决死锁的基本办法、避免死锁、预防死锁、死锁检测、解除死锁

所谓死锁,是指多个进程在运行过程中因争夺资源而造成的一种僵局,当进程处于这种僵持状态时,若无外力作用,它们都将无法再向前推进。 因此我们举个例子来描述,如果此时有一个线程A,按照先锁a再获得锁b的的顺序获得锁,而在此同时又有另外一个线程B,按照先锁b再锁a的顺序获得锁。如下图所示:

![]()

可以归结为两点:

-

竞争资源

-

可剥夺资源,是指某进程在获得这类资源后,该资源可以再被其他进程或系统剥夺,CPU和主存均属于可剥夺性资源;

-

另一类资源是不可剥夺资源,当系统把这类资源分配给某进程后,再不能强行收回,只能在进程用完后自行释放,如磁带机、打印机等。

-

产生死锁中的竞争资源之一指的是竞争不可剥夺资源(例如:系统中只有一台打印机,可供进程P1使用,假定P1已占用了打印机,若P2继续要求打印机打印将阻塞)

-

产生死锁中的竞争资源另外一种资源指的是竞争临时资源(临时资源包括硬件中断、信号、消息、缓冲区内的消息等),通常消息通信顺序进行不当,则会产生死锁

-

-

进程间顺序推进法

- 若P1保持了资源R1,P2保持了资源R2,系统处于不安全状态,因为这两个进程再向前推进,便可能发生死锁

- 例如,当P1运行到P1:Request(R2)时,将因R2已被P2占用而阻塞;当P2运行到P2:Request(R1)时,也将因R1已被P1占用而阻塞,于是发生进程死锁

死锁的必要条件

产生死锁的必要条件:

- 1.互斥条件:进程要求对所分配的资源进行排它性控制,即在一段时间内某资源仅为一进程所占用。

- 2.请求和保持条件:当进程因请求资源而阻塞时,对已获得的资源保持不放。

- 3.不剥夺条件:进程已获得的资源在未使用完之前,不能剥夺,只能在使用完时由自己释放。

- 4.环路等待条件:在发生死锁时,必然存在一个进程–资源的环形链。

死锁的避免

预防死锁的四点解决办法:

- 1.资源一次性分配:一次性分配所有资源,这样就不会再有请求了:(破坏请求条件)

- 2.只要有一个资源的不到分配,也不给这个进程分配其他的资源:(破坏请求保持条件)

- 3.可剥夺资源:即当某进程获得了部分资源,但得不到其他资源,则释放已占有的资源(破坏不可剥夺条件)

- 4.资源有序分配法:系统给每类资源赋予一个编号,每一个进程按编号递增的顺序请求资源,释放则相反(破坏环路等待条件)

避免死锁:

- 预防死锁的几种策略,会严重地损害系统性能。因此在避免死锁时,要施加较弱的限制,从而获得 较满意的系统性能。由于在避免死锁的策略中,允许进程动态地申请资源。因而,系统在进行资源分配之前预先计算资源分配的安全性。若此次分配不会导致系统进入不安全的状态,则将资源分配给进程;否则,进程等待。其中最具有代表性的避免死锁算法是银行家算法。

- 银行家算法:首先需要定义状态和安全状态的概念。系统的状态是当前给进程分配的资源情况。因此,状态包含两个向量Resource(系统中每种资源的总量)和Available(未分配给进程的每种资源的总量)及两个矩阵Claim(表示进程对资源的需求)和Allocation(表示当前分配给进程的资源)。安全状态是指至少有一个资源分配序列不会导致死锁。当进程请求一组资源时,假设同意该请求,从而改变了系统的状态,然后确定其结果是否还处于安全状态。如果是,同意这个请求;如果不是,阻塞该进程知道同意该请求后系统状态仍然是安全的。

JVM类加载机制

java文件通过编译器变成了.class文件,接下来类加载器又将这些.class文件加载到JVM中。其中类装载器的作用其实就是类的加载,类的加载指的是将类的.class文件中的二进制数据读入到内存中,将其放在运行时数据区的方法区内,然后在堆区创建一个 java.lang.Class对象,用来封装类在方法区内的数据结构。

在什么时候才会启动类加载器?

其实,类加载器并不需要等到某个类被“首次主动使用”时再加载它,JVM规范允许类加载器在预料某个类将要被使用时就预先加载它,如果在预先加载的过程中遇到了.class文件缺失或存在错误,类加载器必须在程序首次主动使用该类时才报告错误(LinkageError错误)如果这个类一直没有被程序主动使用,那么类加载器就不会报告错误。

从哪个地方去加载.class文件

在这里进行一个简单的分类。例举了5个来源

(1)本地磁盘

(2)网上加载.class文件(Applet)

(3)从数据库中

(4)压缩文件中(ZAR,jar等)

(5)从其他文件生成的(JSP应用)

JVM的类的生命周期

类加载的过程包括了加载、验证、准备、解析、初始化五个阶段。在这五个阶段中,加载、验证、准备和初始化这四个阶段发生的顺序是确定的,而解析阶段则不一定,它在某些情况下可以在初始化阶段之后开始。另外注意这里的几个阶段是按顺序开始,而不是按顺序进行或完成,因为这些阶段通常都是互相交叉地混合进行的,通常在一个阶段执行的过程中调用或激活另一个阶段。

-

加载:

JVM读取class文件,并且根据class文件描述创建java.lang.Class对象的过程

-

验证:

用于确保Class文件符合当前虚拟机的要求,保障JVM自身的安全

-

准备:

主要工作是在方法区中为类变量分配内存空间并设置类中变量的初始值,非final类型的变量会设置为不同数据类型的默认值,在初始化阶段的时候再赋予真实值,final类型的变量会根据实际值在准备阶段就赋予了真实值。

-

解析:

会将常量池中的符号引用替换为直接引用

-

初始化:

这是类加载机制的最后一步,在这个阶段,java程序代码才开始真正执行。我们知道,在准备阶段已经为类变量赋过一次值。在初始化阶端,程序员可以根据自己的需求来赋值了。一句话描述这个阶段就是执行类构造器< client>()方法的过程。

在初始化阶段,主要为类的静态变量赋予正确的初始值,JVM负责对类进行初始化,主要对类变量进行初始化。在Java中对类变量进行初始值设定有两种方式:

①声明类变量是指定初始值

②使用静态代码块为类变量指定初始值

JVM初始化步骤

1、假如这个类还没有被加载和连接,则程序先加载并连接该类

2、假如该类的直接父类还没有被初始化,则先初始化其直接父类

3、假如类中有初始化语句,则系统依次执行这些初始化语句

类初始化时机:只有当对类的主动使用的时候才会导致类的初始化,类的主动使用包括以下六种:

- 创建类的实例,也就是new的方式

- 访问某个类或接口的静态变量,或者对该静态变量赋值

- 调用类的静态方法

- 反射(如 Class.forName(“com.shengsiyuan.Test”))

- 初始化某个类的子类,则其父类也会被初始化

-

使用

-

卸载

类加载器

-

Bootstrap ClassLoader:

最顶层的加载类,主要加载核心类库,也就是我们环境变量下面%JRE_HOME%\lib下的rt.jar、resources.jar、charsets.jar和class等

-

Extention ClassLoader:

扩展的类加载器,加载目录%JRE_HOME%\lib\ext目录下的jar包和class文件

-

AppClassLoader:

也称为SystemAppClass。 加载当前应用的classpath的所有类。

-

自定义类加载器

类加载的三种方式。

(1)通过命令行启动应用时由JVM初始化加载含有main()方法的主类。

(2)通过Class.forName()方法动态加载,会默认执行初始化块(static{}),但是Class.forName(name,initialize,loader)中的initialze可指定是否要执行初始化块。

(3)通过ClassLoader.loadClass()方法动态加载,不会执行初始化块。

双亲委派原则

当一个类加载器收到类加载任务,会先交给其父类加载器去完成,因此最终加载任务都会传递到顶层的启动类加载器,只有当父类加载器无法完成加载任务时,才会尝试执行加载任务。

采用双亲委派的好处:

- 是比如加载位于rt.jar包中的类java.lang.Object,不管是哪个加载器加载这个类,最终都是委托给顶层的启动类加载器进行加载,这样就保证了使用不同的类加载器最终得到的都是同样一个Object对象。

- 双亲委派原则归纳一下就是:可以避免重复加载,父类已经加载了,子类就不需要再次加载更加安全,很好的解决了各个类加载器的基础类的统一问题,如果不使用该种方式,那么用户可以随意定义类加载器来加载核心api,会带来相关隐患。

BIO NIO AIO

BIO 阻塞IO

同步阻塞I/O模式,数据的读取写入必须阻塞在一个线程内等待完成。

采用 BIO 通信模型 的服务端,通常由一个独立的 Acceptor 线程负责监听客户端的连接。我们一般通过在 while(true) 循环中服务端会调用 accept() 方法等待接收客户端的连接的方式监听请求,请求一旦接收到一个连接请求,通过多线程来支持多个客户端的连接。

当线程数量过多,就会使cpu负载过重,占用大量的资源,不过可以通过 线程池机制 改善,线程池还可以让线程的创建和回收成本相对较低。使用FixedThreadPool 可以有效的控制了线程的最大数量,保证了系统有限的资源的控制,实现了N(客户端请求数量):M(处理客户端请求的线程数量)的伪异步I/O模型(N 可以远远大于 M)

NIO 阻塞IO

NIO使用了多路复用器机制,以socket使用来说,多路复用器(Selector)通过不断轮询各个连接的状态,只有在socket有流可读或者可写时,应用程序才需要去处理它,在线程的使用上,就不需要一个连接就必须使用一个处理线程了,而是只是有效请求时(确实需要进行I/O处理时),才会使用一个线程去处理,这样就避免了BIO模型下大量线程处于阻塞等待状态的情景。

相对于BIO的流,NIO抽象出了新的通道(Channel)作为输入输出的通道,并且提供了缓存(Buffer)的支持,在进行读操作时,需要使用Buffer分配空间,然后将数据从Channel中读入Buffer中,对于Channel的写操作,也需要现将数据写入Buffer,然后将Buffer写入Channel中。

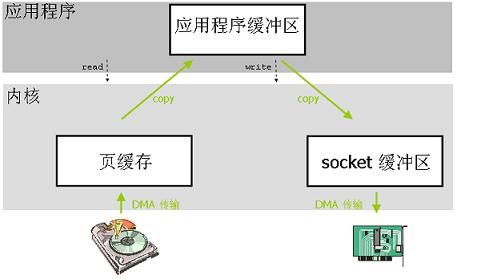

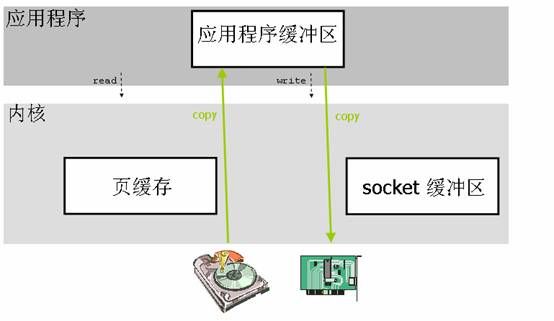

![]()

NIO 包含下面几个核心的组件:

- Channel(通道)

- Buffer(缓冲区)

- Selector(选择器)

整个NIO体系包含的类远远不止这三个,只能说这三个是NIO体系的“核心API”。我们上面已经对这三个概念进行了基本的阐述,这里就不多做解释了。

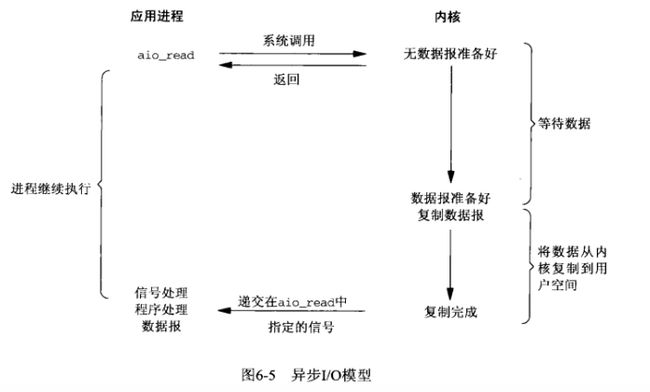

AIO 异步IO

Linux操作系统中的五种操作模型

-

阻塞IO模型

阻塞 I/O 是最简单的 I/O 模型,一般表现为进程或线程等待某个条件,如果条件不满足,则一直等下去。条件满足,则进行下一步操作。

举个例子:我们什么也不做,双手一直把着鱼竿,就静静的等着鱼儿咬钩。一旦手上感受到鱼的力道,就把鱼钓起来放入鱼篓中。然后再钓下一条鱼。

-

非阻塞IO模型

应用进程与内核交互,目的未达到之前,不再一味的等着,而是直接返回。然后通过轮询的方式,不停的去问内核数据准备有没有准备好。如果某一次轮询发现数据已经准备好了,那就把数据拷贝到用户空间中。

我们钓鱼的时候,在等待鱼儿咬钩的过程中,我们可以做点别的事情,比如玩一把王者荣耀、看一集《延禧攻略》等等。但是,我们要时不时的去看一下鱼竿,一旦发现有鱼儿上钩了,就把鱼钓上来。

-

IO复用模型

多个进程的IO可以注册到同一个管道上,这个管道会统一和内核进行交互。当管道中的某一个请求需要的数据准备好之后,进程再把对应的数据拷贝到用户空间中。

我们钓鱼的时候,为了保证可以最短的时间钓到最多的鱼,我们同一时间摆放多个鱼竿,同时钓鱼。然后哪个鱼竿有鱼儿咬钩了,我们就把哪个鱼竿上面的鱼钓起来。

-

信号驱动IO模型

应用进程在读取文件时通知内核,如果某个 socket 的某个事件发生时,请向我发一个信号。在收到信号后,信号对应的处理函数会进行后续处理。

我们钓鱼的时候,为了避免自己一遍一遍的去查看鱼竿,我们可以给鱼竿安装一个报警器。当有鱼儿咬钩的时候立刻报警。然后我们再收到报警后,去把鱼钓起来。

-

异步IO模型

应用进程把IO请求传给内核后,完全由内核去操作文件拷贝。内核完成相关操作后,会发信号告诉应用进程本次IO已经完成。

我们钓鱼的时候,采用一种高科技钓鱼竿,即全自动钓鱼竿。可以自动感应鱼上钩,自动收竿,更厉害的可以自动把鱼放进鱼篓里。然后,通知我们鱼已经钓到了,他就继续去钓下一条鱼去了。

Java中的代理模式

1、什么是代理模式

代理模式:就是为其他对象提供一种代理以控制对这个对象的访问。

代理可以在不改动目标对象的基础上,增加其他额外的功能(扩展功能)。

2 静态代理

静态代理在使用时,需要定义接口或者父类,被代理对象(目标对象)与代理对象(Proxy)一起实现相同的接口或者是继承相同父类。

静态代理总结:

可以实现在不修改目标对象的基础上,对目标对象的功能进行扩展。

但是由于代理对象需要与目标对象实现一样的接口,所以会有很多代理类,类太多.同时,一旦接口增加方法,目标对象与代理对象都要维护.

可以使用动态代理方式来解决。

动态代理

1.代理对象,不需要实现接口

2.代理对象的生成,是利用JDK的API,动态的在内存中创建代理对象(需要我们指定创建代理对象/目标对象实现的接口的类型)

3.动态代理也叫做:JDK代理,接口代理

Cglib代理

JDK的动态代理机制只能代理实现了接口的类,而不能实现接口的类就不能实现JDK的动态代理,cglib是针对类来实现代理的,他的原理是对指定的目标类生成一个子类,并覆盖其中方法实现增强,但因为采用的是继承,所以不能对final修饰的类进行代理。

Cglib代理,也叫作子类代理,它是在内存中构建一个子类对象从而实现对目标对象功能的扩展

Cglib子类代理实现方法:

1.需要引入cglib的jar文件,但是Spring的核心包中已经包括了Cglib功能,所以直接引入Spring-core.jar即可.

2.引入功能包后,就可以在内存中动态构建子类

3.代理的类不能为final,否则报错

4.目标对象的方法如果为final/static,那么就不会被拦截,即不会执行目标对象额外的业务方法.

countDownLatch CyclicBarrier 信号量

countDownLatch

- countDownLatch这个类使一个线程等待其他线程各自执行完毕后再执行。

- 是通过一个计数器来实现的,计数器的初始值是线程的数量。每当一个线程执行完毕后,计数器的值就-1,当计数器的值为0时,表示所有线程都执行完毕,然后在闭锁上等待的线程就可以恢复工作了。

CountDownLatch和CyclicBarrier区别:

- countDownLatch是一个计数器,线程完成一个记录一个,计数器递减,只能只用一次

- CyclicBarrier的计数器更像一个阀门,需要所有线程都到达,然后继续执行,计数器递增,提供reset功能,可以多次使用

信号量

你可以认为信号量是一个可以递增或递减的计数器。你可以初始化一个信号量的值为5,此时这个信号量可最大连续减少5次,直到计数器为0。当计数器为0时,你可以让其递增5次,使得计数器值为5。在我们的例子中,信号量的计数器始终限制在[0~5]之间。

显然,信号量并不仅仅是计数器。当计数器值为0时,它们可以使线程等待,即它们是具有计数器功能的锁。

就多线程而言,当一个线程要访问共享资源(由信号量保护)时,首先,它必须获得信号量。如果信号量的内部计数器大于0时,信号量递减计数器,并允许访问共享资源。否则,如果信号量的计数器为0,则信号量将线程置于休眠状态,直到计数器大于0。计数器中的值为0意味着所有共享资源都被其他线程使用,因此希望使用共享资源的线程必须等到有线程空闲(释放信号量)。

java开发设计—七大原则

-

开闭原则

当应用需求改变时,在不修改软件实体的源代码或者二进制代码的前提下可以扩展模块的功能,使其满足新的需求。

-

里氏替换原则

子类可以扩展父类的功能,但不能改变父类原有的功能。也就是说:子类继承父类时,除添加新的方法完成新增功能外,尽量不要重写父类的方法。

-

依赖倒置原则

要面向接口编程,不要面向具体的实现编程。

-

单一职责原则

一个类应该有且仅有一个引起它变化的原因,否则类应该被拆分。

-

接口隔离原则

要为各个类建立它们所需要的专用接口,而不要试图建立一个很庞大的接口供所有依赖它的类去调用。

-

迪米特原则