5.1 Apache Hive DML语句与函数使用

Apache Hive DML语句与函数使用

- 一、Hive SQL DML语法之加载数据

-

- 1、Hive SQL-DML-Load加载数据

-

- Load语法功能

- Load语法规则

- 语法规则之filepath

- 语法规则之LOCAL

- LOCAL本地是哪里?

- 练习:Load Data From Local FS or HDFS

- 2、Hive SQL-DML-Insert插入数据

-

- Insert语法功能

- insert+select

- 二、Hive SQL DML语法之查询数据

-

- 1、Hive SQL select语法介绍

-

- Select语法树

- 练习

- 2、 select_expr、ALL DISTINCT 结果返回与去重

-

- ( 1)select_expr

- (2)ALL 、DISTINCT

- 3、WHERE 过滤

- 3、聚合操作

- 5、GROUP BY 分组

- 6、HAVING 分组后过滤

- 7、ORDER BY 排序

- 8、LIMIT 返回条数限制

- 三、Hive SQL Join关联查询

-

- 1、Hive Join语法规则

-

- inner join 内连接

- left join 左连接

- 四、Hive SQL中的函数使用

-

- 1、 Hive 函数概述及分类标准

-

- 概述

- 分类标准

- 用户定义函数UDF分类标准

- UDF分类标准扩大化

- 2、 Hive 常用的内置函数

-

- 概述

- (1)String Functions 字符串函数

- (2)Date Functions 日期函数

- (3)Mathematical Functions 数学函数

- (4)Conditional Functions 条件函数

一、Hive SQL DML语法之加载数据

1、Hive SQL-DML-Load加载数据

回顾

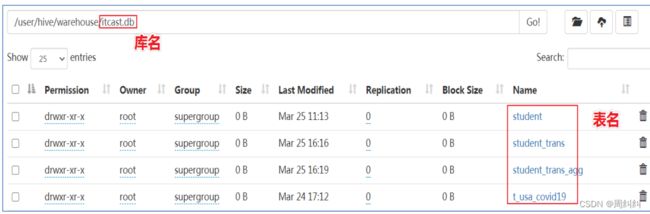

- 在Hive中建表成功之后,就会在HDFS上创建一个与之对应的文件夹,且文件夹名字就是表名;

- 文件夹父路径是由参数hive.metastore.warehouse.dir控制,默认值是/user/hive/warehouse;

- 不管路径在哪里,只有把数据文件移动到对应的表文件夹下面,Hive才能映射解析成功;

- 最原始暴力的方式就是使用

hadoop fs –put|-mv等方式直接将数据移动到表文件夹下; - 但是,Hive官方推荐使用Load命令将数据加载到表中

Load语法功能

- Load英文单词的含义为:加载、装载;

- 所谓加载是指:将数据文件移动到与Hive表对应的位置,移动时是纯复制、移动操作。

- 纯复制、移动指在数据load加载到表中时,Hive不会对表中的数据内容进行任何转换,任何操作

Load语法规则

LOAD DATA [LOCAL] INPATH 'filepath' [OVERWRITE] INTO TABLE tablename;

语法规则之filepath

- filepath表示待移动数据的路径。可以指向文件(在这种情况下,Hive将文件移动到表中),也可以指向目录(在这种情况下,Hive将把该目录中的所有文件移动到表中)。

- filepath文件路径支持下面三种形式,要结合LOCAL关键字一起考虑:

- 相对路径,例如:project/data1

- 绝对路径,例如:/user/hive/project/data1

- 具有schema的完整URI,例如:hdfs://namenode:9000/user/hive/project/data1

语法规则之LOCAL

- 指定LOCAL, 将在本地文件系统中查找文件路径。

若指定相对路径,将相对于用户的当前工作目录进行解释;

用户也可以为本地文件指定完整的URI-例如:file:///user/hive/project/data1。 - 没有指定LOCAL关键字。

如果filepath指向的是一个完整的URI,会直接使用这个URI;

如果没有指定schema,Hive会使用在hadoop配置文件中参数fs.default.name指定的(不出意外,都是HDFS)

LOCAL本地是哪里?

练习:Load Data From Local FS or HDFS

Step1:建表

--step1:建表

--建表student_local 用于演示从本地加载数据

create table student_local(num int,name string,sex string,age int,dept string) row format delimited fields terminated by ',';

--建表student_HDFS 用于演示从HDFS加载数据

create external table student_HDFS(num int,name string,sex string,age int,dept string) row format delimited fields terminated by ',';

Step2:load加载数据

--建议使用beeline客户端 可以显示出加载过程日志信息

--step2:加载数据

-- 从本地加载数据 数据位于HS2(node1)本地文件系统 本质是hadoop fs -put上传操作

LOAD DATA LOCAL INPATH '/root/hivedata/students.txt' INTO TABLE student_local;

--从HDFS加载数据 数据位于HDFS文件系统根目录下 本质是hadoop fs -mv 移动操作

--先把数据上传到HDFS上 hadoop fs -put /root/hivedata/students.txt /

LOAD DATA INPATH '/students.txt' INTO TABLE student_HDFS;

2、Hive SQL-DML-Insert插入数据

Insert语法功能

- Hive官方推荐加载数据的方式:

清洗数据成为结构化文件,再使用Load语法加载数据到表中。这样的效率更高。 - 也可以使用insert语法把数据插入到指定的表中,最常用的配合是把查询返回的结果插入到另一张表中。

insert+select

- insert+select表示:将后面查询返回的结果作为内容插入到指定表中。

- 需要保证查询结果列的数目和需要插入数据表格的列数目一致。

- 如果查询出来的数据类型和插入表格对应的列数据类型不一致,将会进行转换,但是不能保证转换一定成功,转换失败的数据将会为NULL。

INSERT INTO TABLE tablename select_statement1 FROM from_statement;

--step1:创建一张源表student

drop table if exists student;

create table student(num int,name string,sex string,age int,dept string)

row format delimited

fields terminated by ',';

--加载数据

load data local inpath '/root/hivedata/students.txt' into table student;

--step2:创建一张目标表 只有两个字段

create table student_from_insert(sno int,sname string);

--使用insert+select插入数据到新表中

insert into table student_from_insert select num,name from student;

select *

from student_insert1;

二、Hive SQL DML语法之查询数据

1、Hive SQL select语法介绍

Select语法树

- 从哪里查询取决于FROM关键字后面的table_reference,这是我们写查询SQL的首先要确定的事即你查询谁?

- 表名和列名不区分大小写。

SELECT [ALL | DISTINCT] select_expr, select_expr, ...

FROM table_reference

[WHERE where_condition]

[GROUP BY col_list]

[ORDER BY col_list]

[LIMIT [offset,] rows];

练习

美国Covid-19新冠数据之select查询:准备一下select语法测试环境,在附件资料中有一份数据文件《us-covid19-counties.dat》,里面记录了2021-01-28美国各个县累计新冠确诊病例数和累计死亡病例数。

数据环境准备

创建表t_usa_covid19

drop table if exists t_usa_covid19;

CREATE TABLE t_usa_covid19(

count_date string,

county string,

state string,

fips int,

cases int,

deaths int)

row format delimited fields terminated by ",";

--将源数据load加载到t_usa_covid19表对应的路径下

load data local inpath '/root/hivedata/us-covid19-counties.dat' into table t_usa_covid19;

2、 select_expr、ALL DISTINCT 结果返回与去重

( 1)select_expr

select_expr表示检索查询返回的列,必须至少有一个select_expr。

--1、select_expr

--查询所有字段或者指定字段

select * from t_usa_covid19;

select county, cases, deaths from t_usa_covid19;

--查询当前数据库

select current_database(); --省去from关键字

(2)ALL 、DISTINCT

- 用于指定查询返回结果中重复的行如何处理。

- 如果没有给出这些选项,则默认值为ALL(返回所有匹配的行)。

- DISTINCT指定从结果集中删除重复的行。

--2、ALL DISTINCT

--返回所有匹配的行

select state from t_usa_covid19;

--相当于

select all state from t_usa_covid19;

--返回所有匹配的行 去除重复的结果

select distinct state from t_usa_covid19;

--多个字段distinct 整体去重

select distinct county,state from t_usa_covid19;

3、WHERE 过滤

- WHERE后面是一个布尔表达式(结果要么为true,要么为false),用于查询过滤,当布尔表达式为true时,返回select后面expr表达式的结果,否则返回空。

- 在WHERE表达式中,可以使用Hive支持的任何函数和运算符,但聚合函数除外。

--3、WHERE CAUSE

select * from t_usa_covid19 where 1 > 2; -- 1 > 2 返回false

select * from t_usa_covid19 where 1 = 1; -- 1 = 1 返回true

--找出来自于California州的疫情数据

select * from t_usa_covid19 where state = "California";

--where条件中使用函数 找出州名字母长度超过10位的有哪些

select * from t_usa_covid19 where length(state) >10 ;

--注意:where条件中不能使用聚合函数

-- --报错 SemanticException:Not yet supported place for UDAF ‘sum'

--聚合函数要使用它的前提是结果集已经确定。

--而where子句还处于“确定”结果集的过程中,因而不能使用聚合函数。

select state,sum(deaths) from t_usa_covid19 where sum(deaths) >100 group by state;

--可以使用Having实现

select state,sum(deaths) from t_usa_covid19 group by state having sum(deaths) > 100;

比较运算、逻辑运算

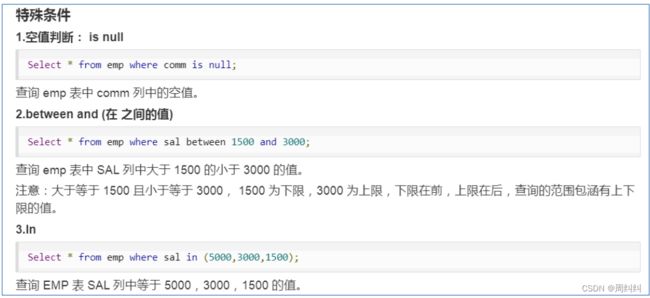

特殊条件(空值判断、between、in)

3、聚合操作

- SQL中拥有很多可用于计数和计算的内建函数,其使用的语法是:

SELECT function(列) FROM 表。 - 这里我们要介绍的叫做聚合(Aggregate)操作函数,如:Count、Sum、Max、Min、Avg等函数。

- 聚合函数的最大特点是不管原始数据有多少行记录,经过聚合操作只返回一条数据,这一条数据就是聚合的结果。

常见的聚合操作函数

--4、聚合操作

--统计美国总共有多少个县county

select count(county) from t_usa_covid19;

--统计美国加州有多少个县

select count(county) from t_usa_covid19 where state = "California";

--统计德州总死亡病例数

select sum(deaths) from t_usa_covid19 where state = "Texas";

--统计出美国最高确诊病例数是哪个县

select max(cases) from t_usa_covid19;

5、GROUP BY 分组

- GROUP BY语句用于结合聚合函数,根据一个或多个列对结果集进行分组;

- 如果没有group by语法,则表中的所有行数据当成一组。

SELECT [ALL | DISTINCT] select_expr, select_expr, ...

FROM table_reference

[WHERE where_condition]

[GROUP BY col_list]

[ORDER BY col_list]

[LIMIT [offset,] rows];

--5、GROUP BY

--根据state州进行分组 统计每个州有多少个县county

select count(county) from t_usa_covid19 where count_date = "2021-01-28" group by state;

--想看一下统计的结果是属于哪一个州的

select state,count(county) from t_usa_covid19 where count_date = "2021-01-28" group by state;

--再想看一下每个县的死亡病例数,我们猜想很简单呀 把deaths字段加上返回 真实情况如何呢?

select state,count(county),deaths from t_usa_covid19 where count_date = "2021-01-28" group by state;

--很尴尬 sql报错了org.apache.hadoop.hive.ql.parse.SemanticException:Line 1:27 Expression not in GROUP BY key 'deaths'

--为什么会报错??group by的语法限制

--结论:出现在GROUP BY中select_expr的字段:要么是GROUP BY分组的字段;要么是被聚合函数应用的字段。

--deaths不是分组字段 报错

--state是分组字段 可以直接出现在select_expr中

--被聚合函数应用

select state,count(county),sum(deaths) from t_usa_covid19 where count_date = "2021-01-28" group by state;

GROUP BY语法限制

- 出现在GROUP BY中select_expr的字段:要么是GROUP BY分组的字段;要么是被聚合函数应用的字段。

- 原因:避免出现一个字段多个值的歧义。

- 分组字段出现select_expr中,一定没有歧义,因为就是基于该字段分组的,同一组中必相同;

- 被聚合函数应用的字段,也没歧义,因为聚合函数的本质就是多进一出,最终返回一个结果。

6、HAVING 分组后过滤

- 在SQL中增加HAVING子句原因是,WHERE关键字无法与聚合函数一起使用。

- HAVING子句可以让我们筛选分组后的各组数据,并且可以在Having中使用聚合函数,因为此时where,group by已经执行结束,结果集已经确定。

--6、having

--统计2021-01-28死亡病例数大于10000的州

select state,sum(deaths) from t_usa_covid19 where count_date = "2021-01-28" and sum(deaths) >10000 group by state;

--where语句中不能使用聚合函数 语法报错

--先where分组前过滤,再进行group by分组, 分组后每个分组结果集确定 再使用having过滤

select state,sum(deaths) from t_usa_covid19 where count_date = "2021-01-28" group by state having sum(deaths) > 10000;

--这样写更好 即在group by的时候聚合函数已经作用得出结果 having直接引用结果过滤 不需要再单独计算一次了

select state,sum(deaths) as cnts from t_usa_covid19 where count_date = "2021-01-28" group by state having cnts> 10000;

HAVING与WHERE区别

- having是在分组后对数据进行过滤

- where是在分组前对数据进行过滤

- having后面可以使用聚合函数

- where后面不可以使用聚合函数

7、ORDER BY 排序

- ORDER BY 语句用于根据指定的列对结果集进行排序。

- ORDER BY 语句默认按照升序(ASC)对记录进行排序。如果您希望按照降序对记录进行排序,可以使用DESC关键字

--7、order by

--根据确诊病例数升序排序 查询返回结果

select * from t_usa_covid19 order by cases;

--不写排序规则 默认就是asc升序

select * from t_usa_covid19 order by cases asc;

--根据死亡病例数倒序排序 查询返回加州每个县的结果

select * from t_usa_covid19 where state = "California" order by cases desc;

8、LIMIT 返回条数限制

- LIMIT用于限制SELECT语句返回的行数。

- LIMIT接受一个或两个数字参数,这两个参数都必须是非负整数常量。

- 第一个参数指定要返回的第一行的偏移量(从 Hive 2.0.0开始),第二个参数指定要返回的最大行数。当给出单个参数时,它代表最大行数,并且偏移量默认为0。

--8、limit

--没有限制返回2021.1.28 加州的所有记录

select * from t_usa_covid19 where count_date = "2021-01-28" and state ="California";

--返回结果集的前5条

select * from t_usa_covid19 where count_date = "2021-01-28" and state ="California" limit 5;

--返回结果集从第1行开始 共3行

select * from t_usa_covid19 where count_date = "2021-01-28" and state ="California" limit 2,3;

--注意 第一个参数偏移量是从0开始的

执行顺序

- 在查询过程中执行顺序:from > where > group(含聚合)> having >order > select;

- 聚合语句(sum,min,max,avg,count)要比having子句优先执行

- where子句在查询过程中执行优先级别优先于聚合语句(sum,min,max,avg,count)

- 结合下面SQL感受:

--执行顺序

select state,sum(deaths) as cnts from t_usa_covid19

where count_date = "2021-01-28"

group by state

having cnts> 10000

limit 2;

三、Hive SQL Join关联查询

1、Hive Join语法规则

背景

- 根据数据库的三范式设计要求和日常工作习惯来说,我们通常不会设计一张大表把所有类型的数据都放在一起,而是不同类型的数据设计不同的表存储。

- 比如在设计一个订单数据表的时候,可以将客户编号作为一个外键和订单表建立相应的关系。而不可以在订单表中添加关于客户其它信息(比如姓名、所属公司等)的字段。

- 在这种情况下,有时需要基于多张表查询才能得到最终完整的结果;

- join语法的出现是用于根据两个或多个表中的列之间的关系,从这些表中共同组合查询数据。

在Hive中,使用最多,最重要的两种join分别是:

inner join(内连接)、left join(左连接)

- table_reference:是join查询中使用的表名。

- table_factor:与table_reference相同,是联接查询中使用的表名。

- join_condition:join查询关联的条件,如果在两个以上的表上需要连接,则使用AND关键字。

join_table:

table_reference [INNER] JOIN table_factor [join_condition]

| table_reference {LEFT} [OUTER] JOIN table_reference join_condition

join_condition:

ON expression

join查询数据环境准备

--加载数据到表中

load data local inpath '/root/hivedata/employee.txt' into table employee;

load data local inpath '/root/hivedata/employee_address.txt' into table employee_address;

load data local inpath '/root/hivedata/employee_connection.txt' into table employee_connection;

inner join 内连接

- 内连接是最常见的一种连接,它也被称为普通连接,其中inner可以省略:

inner join == join; - 只有进行连接的两个表中都存在与连接条件相匹配的数据才会被留下来。

--1、inner join

select e.id,e.name,e_a.city,e_a.street

from employee e inner join employee_address e_a

on e.id =e_a.id;

--等价于 inner join=join

select e.id,e.name,e_a.city,e_a.street

from employee e join employee_address e_a

on e.id =e_a.id;

--等价于 隐式连接表示法

select e.id,e.name,e_a.city,e_a.street

from employee e , employee_address e_a

where e.id =e_a.id;

left join 左连接

- left join中文叫做是左外连接(Left Outer Join)或者左连接,其中outer可以省略,left outer join是早期的写法。

- left join的核心就在于left左。左指的是join关键字左边的表,简称左表。

- 通俗解释:join时以左表的全部数据为准,右边与之关联;左表数据全部返回,右表关联上的显示返回,关联不上的显示null返回。

--2、left join

select e.id,e.name,e_conn.phno,e_conn.email

from employee e left join employee_connection e_conn

on e.id =e_conn.id;

--等价于 left outer join

select e.id,e.name,e_conn.phno,e_conn.email

from employee e left outer join employee_connection e_conn

on e.id =e_conn.id;

四、Hive SQL中的函数使用

1、 Hive 函数概述及分类标准

概述

Hive内建了不少函数,用于满足用户不同使用需求,提高SQL编写效率:

分类标准

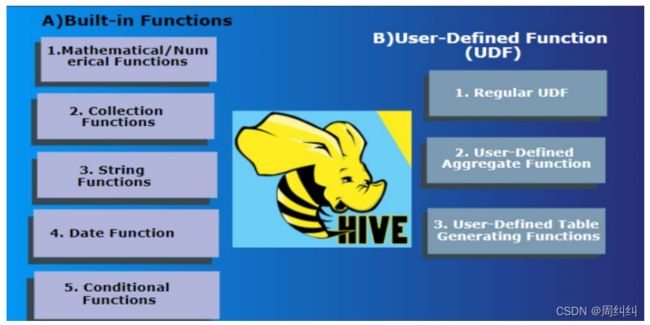

- Hive的函数分为两大类:内置函数(Built-in Functions)、用户定义函数UDF(User-Defined Functions):

- 内置函数可分为:数值类型函数、日期类型函数、字符串类型函数、集合函数、条件函数等;

- 用户定义函数根据输入输出的行数可分为3类:UDF、UDAF、UDTF。

用户定义函数UDF分类标准

- 根据函数输入输出的行数:

UDF(User-Defined-Function)普通函数,一进一出

UDAF(User-Defined Aggregation Function)聚合函数,多进一出

UDTF(User-Defined Table-Generating Functions)表生成函数,一进多出

UDF分类标准扩大化

- UDF分类标准本来针对的是用户自己编写开发实现的函数。UDF分类标准可以扩大到Hive的所有函数中:包括内置函数和用户自定义函数。

因为不管是什么类型的函数,一定满足于输入输出的要求,那么从输入几行和输出几行上来划分没有任何问题。

千万不要被UD(User-Defined)这两个字母所迷惑,照成视野的狭隘。 - 比如Hive官方文档中,针对聚合函数的标准就是内置的UDAF类型。

2、 Hive 常用的内置函数

概述

- 内置函数(build-in)指的是Hive开发实现好,直接可以使用的函数,也叫做内建函数。

- 官方文档地址:https://cwiki.apache.org/confluence/display/Hive/LanguageManual+UDF

- 内置函数根据应用归类整体可以分为8大种类型,我们将对其中重要的,使用频率高的函数使用进行详细讲解。

(1)String Functions 字符串函数

•字符串长度函数:length

•字符串反转函数:reverse

•字符串连接函数:concat

•带分隔符字符串连接函数:concat_ws

•字符串截取函数:substr,substring

------------String Functions 字符串函数------------

select length("itcast");

select reverse("itcast");

select concat("angela","baby");

--带分隔符字符串连接函数:concat_ws(separator, [string | array(string)]+)

select concat_ws('.', 'www', array('itcast', 'cn'));

--字符串截取函数:substr(str, pos[, len]) 或者 substring(str, pos[, len])

select substr("angelababy",-2); --pos是从1开始的索引,如果为负数则倒着数

select substr("angelababy",2,2);

--分割字符串函数: split(str, regex)

select split('apache hive', ' ');

(2)Date Functions 日期函数

----------- Date Functions 日期函数 -----------------

--获取当前日期: current_date

select current_date();

--获取当前UNIX时间戳函数: unix_timestamp

select unix_timestamp();

--日期转UNIX时间戳函数: unix_timestamp

select unix_timestamp("2011-12-07 13:01:03");

--指定格式日期转UNIX时间戳函数: unix_timestamp

select unix_timestamp('20111207 13:01:03','yyyyMMdd HH:mm:ss');

--UNIX时间戳转日期函数: from_unixtime

select from_unixtime(1618238391);

select from_unixtime(0, 'yyyy-MM-dd HH:mm:ss');

--日期比较函数: datediff 日期格式要求'yyyy-MM-dd HH:mm:ss' or 'yyyy-MM-dd'

select datediff('2012-12-08','2012-05-09');

--日期增加函数: date_add

select date_add('2012-02-28',10);

--日期减少函数: date_sub

select date_sub('2012-01-1',10);

(3)Mathematical Functions 数学函数

----Mathematical Functions 数学函数-------------

--取整函数: round 返回double类型的整数值部分 (遵循四舍五入)

select round(3.1415926);

--指定精度取整函数: round(double a, int d) 返回指定精度d的double类型

select round(3.1415926,4);

--取随机数函数: rand 每次执行都不一样 返回一个0到1范围内的随机数

select rand();

--指定种子取随机数函数: rand(int seed) 得到一个稳定的随机数序列

select rand(3);

(4)Conditional Functions 条件函数

主要用于条件判断、逻辑判断转换这样的场合

-----Conditional Functions 条件函数------------------

--使用之前课程创建好的student表数据

select * from student limit 3;

--if条件判断: if(boolean testCondition, T valueTrue, T valueFalseOrNull)

select if(1=2,100,200);

select if(sex ='男','M','W') from student limit 3;

--空值转换函数: nvl(T value, T default_value)

select nvl("allen","itcast");

select nvl(null,"itcast");

--条件转换函数: CASE a WHEN b THEN c [WHEN d THEN e]* [ELSE f] END

select case 100 when 50 then 'tom' when 100 then 'mary' else 'tim' end;

select case sex when '男' then 'male' else 'female' end from student limit 3;