- AI原生应用中的用户画像构建:从理论到实践全解析

AI原生应用中的用户画像构建:从理论到实践全解析关键词:用户画像、AI原生应用、特征工程、机器学习、个性化推荐、数据隐私、模型优化摘要:本文全面解析AI原生应用中用户画像构建的全过程,从基础概念到核心技术,再到实际应用和未来趋势。我们将用通俗易懂的方式讲解用户画像如何像"数字身份证"一样工作,深入探讨特征提取、模型构建等关键技术,并通过实际案例展示用户画像在推荐系统、精准营销等场景中的应用。文章还

- 推荐项目: Few-Shot-Adversarial-Learning-for-face-swap

邱晋力

推荐项目:Few-Shot-Adversarial-Learning-for-face-swap去发现同类优质开源项目:https://gitcode.com/1、项目介绍Few-Shot-Adversarial-Learning-for-face-swap是一个基于PyTorch的开源实现,重演了三星AI实验室的一项前沿研究——“Few-ShotAdversarialLearningofReal

- Python爬虫【四十五章】爬虫攻防战:异步并发+AI反爬识别的技术解密

程序员_CLUB

Python入门到进阶python爬虫人工智能

目录引言:当爬虫工程师遇上AI反爬官一、异步并发基础设施层1.1混合调度框架设计1.2智能连接池管理二、机器学习反爬识别层2.1特征工程体系2.2轻量级在线推理三、智能决策系统3.1动态策略引擎3.2实时对抗案例四、性能优化实战4.1全链路压测数据4.2典型故障处理案例五、总结:构建智能化的爬虫生态系统Python爬虫相关文章(推荐)引言:当爬虫工程师遇上AI反爬官在大数据采集领域,我们正经历着技

- 万字长文,解读大模型技术原理(非常详细)零基础入门到精通,收藏这一篇就够了

大模型是指具有大规模参数和复杂计算结构的机器学习模型。本文从大模型的发展历程出发,对大模型领域的各个技术细节进行详细解读,供大家在了解大模型基本知识的过程中起到一定参考作用。一、大模型的定义大语言模型作为一个被验证可行的方向,其“大”体现在训练数据集广,模型参数和层数大,计算量大,其价值体现在通用性上,并且有更好的泛化能力。这些模型通常由深度神经网络构建而成,拥有数十亿甚至数千亿个参数。大模型的设

- TensorFlow为AI人工智能航空航天领域带来变革

AI原生应用开发

人工智能tensorflowpythonai

TensorFlow为AI人工智能航空航天领域带来变革关键词:TensorFlow、人工智能、航空航天、机器学习、深度学习、神经网络、自主系统摘要:本文探讨了TensorFlow这一强大的机器学习框架如何推动航空航天领域的创新。我们将从基础概念入手,逐步深入分析TensorFlow在航天器导航、卫星图像处理、飞行器自主决策等关键应用场景中的实现原理。通过实际代码示例和架构图解,展示TensorFl

- 多语言文本分类在AI应用中的实践

AI原生应用开发

人工智能分类数据挖掘ai

多语言文本分类在AI应用中的实践关键词:多语言文本分类、自然语言处理、机器学习、深度学习、BERT、迁移学习、跨语言模型摘要:本文深入探讨多语言文本分类在AI领域的应用实践。我们将从基础概念出发,逐步讲解其核心原理、技术架构和实现方法,并通过实际案例展示如何构建一个高效的多语言文本分类系统。文章将涵盖从传统机器学习方法到最先进的深度学习技术,特别关注跨语言迁移学习在实际业务场景中的应用。背景介绍目

- 从零开始构建AI原生应用的认知架构

AI原生应用开发

AI-native架构ai

从零开始构建AI原生应用的认知架构关键词:AI原生应用、认知架构、机器学习、知识图谱、神经网络、智能决策、系统设计摘要:本文深入探讨如何从零开始构建AI原生应用的认知架构。我们将从基本概念出发,逐步解析认知架构的核心组件,包括知识表示、推理机制和学习能力等。通过生动的比喻和实际代码示例,帮助读者理解如何设计一个能够模拟人类认知过程的AI系统。文章还将介绍当前最先进的认知架构模型,并展望未来发展趋势

- Real-World Blur Dataset for Learning and Benchmarking Deblurring Algorithms

钟屿

深度学习

用于学习和评估去模糊算法的真实世界模糊数据集摘要近年来,针对相机抖动和物体运动模糊的单幅图像去模糊提出了许多基于学习的方法。为了将这些方法推广到真实世界的模糊场景,包含大量真实模糊图像及其对应的清晰真实图像(groundtruth)的数据集至关重要。然而,目前尚不存在这样的数据集,因此所有现有方法都依赖于合成数据集,这导致它们无法有效去除真实世界图像的模糊。在本工作中,我们提出了一个用于学习和评估

- Deep Multi-scale Convolutional Neural Network for Dynamic Scene Deblurring 论文阅读

钟屿

论文阅读计算机视觉人工智能

用于动态场景去模糊的深度多尺度卷积神经网络摘要针对一般动态场景的非均匀盲去模糊是一个具有挑战性的计算机视觉问题,因为模糊不仅来源于多个物体运动,还来源于相机抖动和场景深度变化。为了去除这些复杂的运动模糊,传统的基于能量优化的方法依赖于简单的假设,例如模糊核是部分均匀或局部线性的。此外,最近的基于机器学习的方法也依赖于在这些假设下生成的合成模糊数据集。这使得传统的去模糊方法在模糊核难以近似或参数化的

- 基于Paillier同态加密算法的金融数据安全共享机制研究【附数据】

金融数据分析与建模专家金融科研助手|论文指导|模型构建✨专业领域:金融数据处理与分析量化交易策略研究金融风险建模投资组合优化金融预测模型开发深度学习在金融中的应用擅长工具:Python/R/MATLAB量化分析机器学习模型构建金融时间序列分析蒙特卡洛模拟风险度量模型金融论文指导内容:金融数据挖掘与处理量化策略开发与回测投资组合构建与优化金融风险评估模型期刊论文✅具体问题可以私信或查看文章底部二维码

- 吴恩达 机器学习cs229-学习笔记-更新中

是娜个二叉树!

机器学习学习笔记

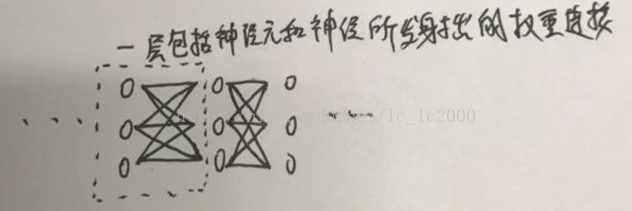

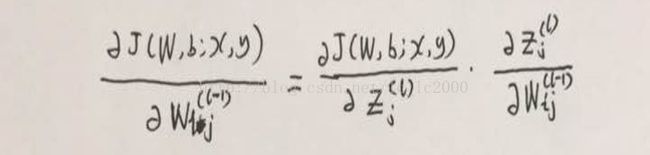

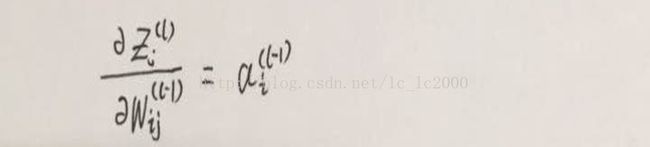

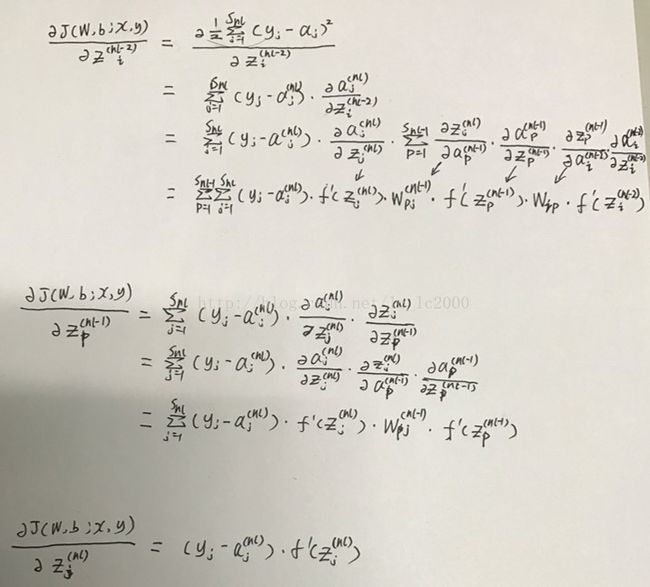

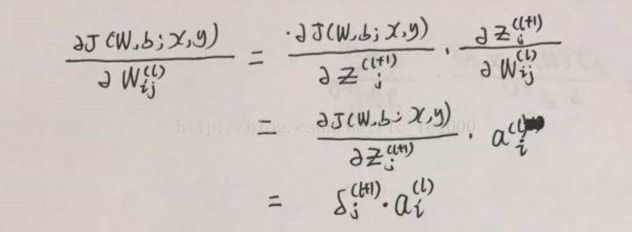

吴恩达机器学习cs22901基础概念语言:Matlab/python监督学习定义:获取一组数据集拟合数据从X到Y的映射回归问题:预测的Y是连续的,Y是实数分类问题:分类指的是Y取离散值,输出是离散的两组,正示例和负示例,把所有样本推到这条直线上,用0,1,标识逻辑回归算法,拟合直线区分正,负示例处理相对大量特征的回归算法或者分类算法支持向量机算法:它使用的不是1,2,3,10个输入特征,而是使用无

- 「日拱一码」033 机器学习——严格划分

胖达不服输

「日拱一码」机器学习人工智能严格划分组划分

目录简单随机划分(train_test_split)分组划分(GroupSplitting)简单分组划分(GroupSplitting)分层分组划分(StratifiedGroupSplitting)交叉验证法(Cross-Validation)分组K折交叉验证(GroupKFold)留一组法(LeaveOneGroupOut)简单随机划分(train_test_split)简单随机分组通过随机分

- 从零开始:搭建你的人工智能开发环境

人工智能教程

人工智能YOLO机器学习transformer线性回归动态规划排序算法

前言在人工智能和机器学习的旅程中,一个稳定且高效的开发环境是成功的关键第一步。无论是初学者还是经验丰富的开发者,一个配置良好的开发环境都能大大提高工作效率,减少遇到的问题。本文将从零开始,逐步指导你如何搭建一个完整的人工智能开发环境,包括操作系统选择、Python安装、常用库的配置以及开发工具的选择。一、选择合适的操作系统(一)主流操作系统介绍在搭建人工智能开发环境时,首先需要选择一个合适的操作系

- 基于机器学习的加密货币资金费率预测与套利策略

云梦量化科技

python

一、资金费率机制解析永续合约的资金费率是加密货币衍生品市场独有的机制,旨在使永续合约价格锚定现货价格。资金费率每8小时结算一次,结算时多空双方互相支付资金费用:费率为正时,多头支付给空头;费率为负时,空头支付给多头。此机制既促使永续合约价格回归现货价格,也反映市场多空情绪。某安永续合约资金费率计算公式通常为:资金费率 F = 平均溢价指数 P + Clamp(综合利率 I − 溢价指数 P, +0

- 机器人-组成结构-感知 - 决策 - 执行

具身智能-查布嘎

具身智能机器人人工智能

目录一、感知系统内部传感器:外部传感器:二、智能决策系统机器学习家族1.1机器学习2.1深度学习2.2深度学习模型(主要属于监督/强化学习范畴,但结构通用):3.1监督学习3.2监督学习模型4.1半监督学习4.2无/半监督学习模型:5.1无监督学习5.2生成模型(可属于监督/无监督):6.1强化学习7.1其他学习三、控制系统(运控)①对应小脑和脊柱一、感知系统①对应人体的五官。由具有不同功能的各种

- 机器学习入门(五):线性回归—从模型函数到目标函数

米饭超人

从数据反推公式假设我们获得了这样一张表格,上面列举了美国纽约若干程序员职位的年薪:enterimagedescriptionhere大家可以看到,表格中列举了职位、经验、技能、国家和城市几项特征。除了经验一项,其他都是一样的。不同的经验(工作年限),薪水不同。而且看起来,工作年头越多,工资也就越高。那么我们把Experience与Salary抽取出来,用x和y来分别指代它们。enterimaged

- Python深度学习实践:LSTM与GRU在序列数据预测中的应用

AI智能应用

Python入门实战计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

Python深度学习实践:LSTM与GRU在序列数据预测中的应用作者:禅与计算机程序设计艺术/ZenandtheArtofComputerProgramming1.背景介绍1.1问题的由来序列数据预测是机器学习领域的一个重要研究方向,涉及时间序列分析、自然语言处理、语音识别等多个领域。序列数据具有时间依赖性,即序列中每个元素都受到前面元素的影响。传统的机器学习算法难以捕捉这种时间依赖性,而深度学习

- 一个例子带你入门机器学习

目录1.为建模选择数据2.选择预测目标3.选择“特征”4.构建您的模型(这篇文章将使用经典墨尔本房价数据集作为例子,引导机器学习的流程,数据集为melb_data.csv,请在csdn的下载区自行下载,运行代码时需要将数据集下载在同个目录下)1.为建模选择数据数据集有太多的变量,多到难以理解,甚至无法很好地打印出来。如何将这海量的数据削减为能够理解的内容?我们将首先凭借直觉选择几个变量。后续将介绍

- 初探机器学习与力学研究的交叉领域

faderbic

机器学习人工智能深度学习

目录关于如何踏入机器学习领域机器学习与力学研究的交叉方向1.使用机器学习加速有限元求解2.结合有限元计算和机器学习预测复杂材料结构与力学性能的关系3.结构健康检测4.疲劳寿命预测总结关于如何踏入机器学习领域因为我本科的专业是力学,所以当我开始关注机器学习领域时,首先考虑的是机器学习和力学的交叉领域。对于很多对人工智能感兴趣的朋友,想加入人工智能的潮流却不知道从何学起,我提供一个思路,我认为将自己学

- [NIPST AI]对抗性机器学习攻击和缓解的分类和术语

Anooyman

人工智能网络安全人工智能大语言模型网络安全安全

原文link:https://nvlpubs.nist.gov/nistpubs/ai/NIST.AI.100-2e2025.pdfIntroduction人工智能(AI)系统在过去几年中持续全球扩展。这些系统正在被众多国家开发并广泛部署于各自的经济体系中,人们在生活的许多领域都获得了更多使用AI系统的机会。本报告区分了两大类AI系统:预测型AI(PredictiveAI,PredAI)和生成型A

- 通俗易懂:什么是决策树?

淦暴尼

算法python决策树算法机器学习

1.引言:决策树就像“选择题”你是否曾经在生活中做过“选择题”?比如:今天要不要带伞?晚饭吃什么?该不该买那件心仪已久的商品?其实,我们的大脑经常会像“决策树”一样,通过一连串问题和判断,逐步缩小选择范围,最终做出决定。**决策树(DecisionTree)**就是这样一种模拟人类决策过程的机器学习模型。它通过“提问-分支-决策”的方式,把复杂问题拆解成一系列简单的判断,广泛应用于分类(如判断邮件

- java毕业设计-基于Javaweb的家常小菜烹饪学习管理系统的设计与实现(源码+LW+部署文档+全bao+远程调试+代码讲解等)

程序猿刘

vuespringboot毕业设计java课程设计学习

博主介绍:✌️码农一枚,专注于大学生项目实战开发、讲解和毕业文撰写修改等。全栈领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java、小程序技术领域和毕业项目实战✌️技术范围::小程序、SpringBoot、SSM、JSP、Vue、PHP、Java、python、爬虫、数据可视化、大数据、物联网、机器学习等设计与开发。主要内容:免费开题报告、任务书、全bao定制+

- java毕业设计源码案例-基于ssm+协同过滤的个性化小说推荐系统设计与实现(源码+LW+部署文档+全bao+远程调试+代码讲解等)

项目帮

springbootjava计算机毕设java课程设计开发语言

博主介绍:✌️码农一枚,专注于大学生项目实战开发、讲解和毕业文撰写修改等。全栈领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java、小程序技术领域和毕业项目实战✌️技术范围::小程序、SpringBoot、SSM、JSP、Vue、PHP、Java、python、爬虫、数据可视化、大数据、物联网、机器学习等设计与开发。主要内容:免费功能设计,开题报告、任务书、全b

- 机器学习中的数据预处理:从入门到实践

耐思nice~

机器学习由浅入深-吴恩达机器学习人工智能

在当今的智能时代,机器学习已经渗透到我们生活的方方面面。比如我们常用的推荐系统,它能根据我们的浏览记录精准推送喜欢的商品或视频,这背后就离不开机器学习的支撑。而一个优秀的机器学习模型,离不开高质量的数据,数据预处理正是保证数据质量的关键环节,它就像烹饪前的食材处理,直接影响着最终“菜品”的口感,也就是模型的性能。今天,我们就来全面学习机器学习中数据预处理的关键步骤。一、数据预处理的重要性数据预处理

- lanqiaoOJ 4330:欧拉函数模板

hnjzsyjyj

信息学竞赛#算法数学基础欧拉函数

【题目来源】https://www.lanqiao.cn/problems/4330/learning/【问题描述】这是一道模板题。首先给出欧拉函数的定义:即φ(n)表示的是小于等于n的数中和n互质的数的个数。比如说φ(6)=2,当n是质数的时候,显然有φ(n)=n-1。【题目大意】给定n个正整数,请你求出每个数的欧拉函数。【输入格式】输入共两行。第一行输入一个整数表示n。第二行输入n个整数。【输

- lanqiaoOJ 2122:数位排序 ← 排序(自定义比较函数)

【题目来源】https://www.lanqiao.cn/problems/2122/learning/【题目描述】小蓝对一个数的数位之和很感兴趣,今天他要按照数位之和给数排序。当两个数各个数位之和不同时,将数位和较小的排在前面,当数位之和相等时,将数值小的排在前面。例如,2022排在409前面,因为2022的数位之和是6,小于409的数位之和13。又如,6排在2022前面,因为它们的数位之和相同

- lanqiaoOJ 2145:求阶乘 ← 二分法

hnjzsyjyj

信息学竞赛#分治算法与双指针算法二分法

【题目来源】https://www.lanqiao.cn/problems/2145/learning/【题目描述】满足N!的末尾恰好有K个0的最小的N是多少?如果这样的N不存在输出-1。【输入格式】一个整数K。【输出格式】一个整数代表答案。【输入样例】2【输出样例】10【评测用例规模与约定】对于30%的数据,1≤K≤10^6.对于100%的数据,1≤K≤10^18.【算法分析】●二分法的应用条件

- 计算机专业大数据毕业设计-基于 Spark 的音乐数据分析项目(源码+LW+部署文档+全bao+远程调试+代码讲解等)

程序猿八哥

数据可视化计算机毕设spark大数据课程设计spark

博主介绍:✌️码农一枚,专注于大学生项目实战开发、讲解和毕业文撰写修改等。全栈领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java、小程序技术领域和毕业项目实战✌️技术范围::小程序、SpringBoot、SSM、JSP、Vue、PHP、Java、python、爬虫、数据可视化、大数据、物联网、机器学习等设计与开发。主要内容:免费功能设计,开题报告、任务书、全b

- Protein FID:AI蛋白质结构生成模型评估新指标

一、引言:蛋白质生成模型面临的评估挑战近年来,AI驱动的蛋白质结构生成模型取得了令人瞩目的进展,但如何有效评估这些模型的质量却一直是一个悬而未决的问题。虽然实验验证仍然是金标准,但计算机模拟评估对于快速开发和比较机器学习模型至关重要。然而,尽管最先进的模型在当前评估指标上表现卓越,但它们在实际设计应用中的成功率仍然相对有限。例如,有研究报告显示生成结构的实验成功率仅为3%,而计算机模拟评分却远高于

- 在 Conda 中删除环境及所有安装的库

Studying 开龙wu

conda

注意事项1.删除环境前确保你没有在该环境中运行任何程序。2.删除操作是不可逆的,所有该环境中的包和配置都会被永久删除。3.如果你想保留环境的配置信息,可以在删除前使用condaenvexport>environment.yml导出环境配置。关于requirements.txt和environment.yaml文件使用介绍详情可参考以往文章,争对机器学习和深度学习里Python项目开发管理项目依赖的

- 怎么样才能成为专业的程序员?

cocos2d-x小菜

编程PHP

如何要想成为一名专业的程序员?仅仅会写代码是不够的。从团队合作去解决问题到版本控制,你还得具备其他关键技能的工具包。当我们询问相关的专业开发人员,那些必备的关键技能都是什么的时候,下面是我们了解到的情况。

关于如何学习代码,各种声音很多,然后很多人就被误导为成为专业开发人员懂得一门编程语言就够了?!呵呵,就像其他工作一样,光会一个技能那是远远不够的。如果你想要成为

- java web开发 高并发处理

BreakingBad

javaWeb并发开发处理高

java处理高并发高负载类网站中数据库的设计方法(java教程,java处理大量数据,java高负载数据) 一:高并发高负载类网站关注点之数据库 没错,首先是数据库,这是大多数应用所面临的首个SPOF。尤其是Web2.0的应用,数据库的响应是首先要解决的。 一般来说MySQL是最常用的,可能最初是一个mysql主机,当数据增加到100万以上,那么,MySQL的效能急剧下降。常用的优化措施是M-S(

- mysql批量更新

ekian

mysql

mysql更新优化:

一版的更新的话都是采用update set的方式,但是如果需要批量更新的话,只能for循环的执行更新。或者采用executeBatch的方式,执行更新。无论哪种方式,性能都不见得多好。

三千多条的更新,需要3分多钟。

查询了批量更新的优化,有说replace into的方式,即:

replace into tableName(id,status) values

- 微软BI(3)

18289753290

微软BI SSIS

1)

Q:该列违反了完整性约束错误;已获得 OLE DB 记录。源:“Microsoft SQL Server Native Client 11.0” Hresult: 0x80004005 说明:“不能将值 NULL 插入列 'FZCHID',表 'JRB_EnterpriseCredit.dbo.QYFZCH';列不允许有 Null 值。INSERT 失败。”。

A:一般这类问题的存在是

- Java中的List

g21121

java

List是一个有序的 collection(也称为序列)。此接口的用户可以对列表中每个元素的插入位置进行精确地控制。用户可以根据元素的整数索引(在列表中的位置)访问元素,并搜索列表中的元素。

与 set 不同,列表通常允许重复

- 读书笔记

永夜-极光

读书笔记

1. K是一家加工厂,需要采购原材料,有A,B,C,D 4家供应商,其中A给出的价格最低,性价比最高,那么假如你是这家企业的采购经理,你会如何决策?

传统决策: A:100%订单 B,C,D:0%

&nbs

- centos 安装 Codeblocks

随便小屋

codeblocks

1.安装gcc,需要c和c++两部分,默认安装下,CentOS不安装编译器的,在终端输入以下命令即可yum install gccyum install gcc-c++

2.安装gtk2-devel,因为默认已经安装了正式产品需要的支持库,但是没有安装开发所需要的文档.yum install gtk2*

3. 安装wxGTK

yum search w

- 23种设计模式的形象比喻

aijuans

设计模式

1、ABSTRACT FACTORY—追MM少不了请吃饭了,麦当劳的鸡翅和肯德基的鸡翅都是MM爱吃的东西,虽然口味有所不同,但不管你带MM去麦当劳或肯德基,只管向服务员说“来四个鸡翅”就行了。麦当劳和肯德基就是生产鸡翅的Factory 工厂模式:客户类和工厂类分开。消费者任何时候需要某种产品,只需向工厂请求即可。消费者无须修改就可以接纳新产品。缺点是当产品修改时,工厂类也要做相应的修改。如:

- 开发管理 CheckLists

aoyouzi

开发管理 CheckLists

开发管理 CheckLists(23) -使项目组度过完整的生命周期

开发管理 CheckLists(22) -组织项目资源

开发管理 CheckLists(21) -控制项目的范围开发管理 CheckLists(20) -项目利益相关者责任开发管理 CheckLists(19) -选择合适的团队成员开发管理 CheckLists(18) -敏捷开发 Scrum Master 工作开发管理 C

- js实现切换

百合不是茶

JavaScript栏目切换

js主要功能之一就是实现页面的特效,窗体的切换可以减少页面的大小,被门户网站大量应用思路:

1,先将要显示的设置为display:bisible 否则设为none

2,设置栏目的id ,js获取栏目的id,如果id为Null就设置为显示

3,判断js获取的id名字;再设置是否显示

代码实现:

html代码:

<di

- 周鸿祎在360新员工入职培训上的讲话

bijian1013

感悟项目管理人生职场

这篇文章也是最近偶尔看到的,考虑到原博客发布者可能将其删除等原因,也更方便个人查找,特将原文拷贝再发布的。“学东西是为自己的,不要整天以混的姿态来跟公司博弈,就算是混,我觉得你要是能在混的时间里,收获一些别的有利于人生发展的东西,也是不错的,看你怎么把握了”,看了之后,对这句话记忆犹新。 &

- 前端Web开发的页面效果

Bill_chen

htmlWebMicrosoft

1.IE6下png图片的透明显示:

<img src="图片地址" border="0" style="Filter.Alpha(Opacity)=数值(100),style=数值(3)"/>

或在<head></head>间加一段JS代码让透明png图片正常显示。

2.<li>标

- 【JVM五】老年代垃圾回收:并发标记清理GC(CMS GC)

bit1129

垃圾回收

CMS概述

并发标记清理垃圾回收(Concurrent Mark and Sweep GC)算法的主要目标是在GC过程中,减少暂停用户线程的次数以及在不得不暂停用户线程的请夸功能,尽可能短的暂停用户线程的时间。这对于交互式应用,比如web应用来说,是非常重要的。

CMS垃圾回收针对新生代和老年代采用不同的策略。相比同吞吐量垃圾回收,它要复杂的多。吞吐量垃圾回收在执

- Struts2技术总结

白糖_

struts2

必备jar文件

早在struts2.0.*的时候,struts2的必备jar包需要如下几个:

commons-logging-*.jar Apache旗下commons项目的log日志包

freemarker-*.jar

- Jquery easyui layout应用注意事项

bozch

jquery浏览器easyuilayout

在jquery easyui中提供了easyui-layout布局,他的布局比较局限,类似java中GUI的border布局。下面对其使用注意事项作简要介绍:

如果在现有的工程中前台界面均应用了jquery easyui,那么在布局的时候最好应用jquery eaysui的layout布局,否则在表单页面(编辑、查看、添加等等)在不同的浏览器会出

- java-拷贝特殊链表:有一个特殊的链表,其中每个节点不但有指向下一个节点的指针pNext,还有一个指向链表中任意节点的指针pRand,如何拷贝这个特殊链表?

bylijinnan

java

public class CopySpecialLinkedList {

/**

* 题目:有一个特殊的链表,其中每个节点不但有指向下一个节点的指针pNext,还有一个指向链表中任意节点的指针pRand,如何拷贝这个特殊链表?

拷贝pNext指针非常容易,所以题目的难点是如何拷贝pRand指针。

假设原来链表为A1 -> A2 ->... -> An,新拷贝

- color

Chen.H

JavaScripthtmlcss

<!DOCTYPE HTML PUBLIC "-//W3C//DTD HTML 4.01 Transitional//EN" "http://www.w3.org/TR/html4/loose.dtd"> <HTML> <HEAD>&nbs

- [信息与战争]移动通讯与网络

comsci

网络

两个坚持:手机的电池必须可以取下来

光纤不能够入户,只能够到楼宇

建议大家找这本书看看:<&

- oracle flashback query(闪回查询)

daizj

oracleflashback queryflashback table

在Oracle 10g中,Flash back家族分为以下成员:

Flashback Database

Flashback Drop

Flashback Table

Flashback Query(分Flashback Query,Flashback Version Query,Flashback Transaction Query)

下面介绍一下Flashback Drop 和Flas

- zeus持久层DAO单元测试

deng520159

单元测试

zeus代码测试正紧张进行中,但由于工作比较忙,但速度比较慢.现在已经完成读写分离单元测试了,现在把几种情况单元测试的例子发出来,希望有人能进出意见,让它走下去.

本文是zeus的dao单元测试:

1.单元测试直接上代码

package com.dengliang.zeus.webdemo.test;

import org.junit.Test;

import o

- C语言学习三printf函数和scanf函数学习

dcj3sjt126com

cprintfscanflanguage

printf函数

/*

2013年3月10日20:42:32

地点:北京潘家园

功能:

目的:

测试%x %X %#x %#X的用法

*/

# include <stdio.h>

int main(void)

{

printf("哈哈!\n"); // \n表示换行

int i = 10;

printf

- 那你为什么小时候不好好读书?

dcj3sjt126com

life

dady, 我今天捡到了十块钱, 不过我还给那个人了

good girl! 那个人有没有和你讲thank you啊

没有啦....他拉我的耳朵我才把钱还给他的, 他哪里会和我讲thank you

爸爸, 如果地上有一张5块一张10块你拿哪一张呢....

当然是拿十块的咯...

爸爸你很笨的, 你不会两张都拿

爸爸为什么上个月那个人来跟你讨钱, 你告诉他没

- iptables开放端口

Fanyucai

linuxiptables端口

1,找到配置文件

vi /etc/sysconfig/iptables

2,添加端口开放,增加一行,开放18081端口

-A INPUT -m state --state NEW -m tcp -p tcp --dport 18081 -j ACCEPT

3,保存

ESC

:wq!

4,重启服务

service iptables

- Ehcache(05)——缓存的查询

234390216

排序ehcache统计query

缓存的查询

目录

1. 使Cache可查询

1.1 基于Xml配置

1.2 基于代码的配置

2 指定可搜索的属性

2.1 可查询属性类型

2.2 &

- 通过hashset找到数组中重复的元素

jackyrong

hashset

如何在hashset中快速找到重复的元素呢?方法很多,下面是其中一个办法:

int[] array = {1,1,2,3,4,5,6,7,8,8};

Set<Integer> set = new HashSet<Integer>();

for(int i = 0

- 使用ajax和window.history.pushState无刷新改变页面内容和地址栏URL

lanrikey

history

后退时关闭当前页面

<script type="text/javascript">

jQuery(document).ready(function ($) {

if (window.history && window.history.pushState) {

- 应用程序的通信成本

netkiller.github.com

虚拟机应用服务器陈景峰netkillerneo

应用程序的通信成本

什么是通信

一个程序中两个以上功能相互传递信号或数据叫做通信。

什么是成本

这是是指时间成本与空间成本。 时间就是传递数据所花费的时间。空间是指传递过程耗费容量大小。

都有哪些通信方式

全局变量

线程间通信

共享内存

共享文件

管道

Socket

硬件(串口,USB) 等等

全局变量

全局变量是成本最低通信方法,通过设置

- 一维数组与二维数组的声明与定义

恋洁e生

二维数组一维数组定义声明初始化

/** * */ package test20111005; /** * @author FlyingFire * @date:2011-11-18 上午04:33:36 * @author :代码整理 * @introduce :一维数组与二维数组的初始化 *summary: */ public c

- Spring Mybatis独立事务配置

toknowme

mybatis

在项目中有很多地方会使用到独立事务,下面以获取主键为例

(1)修改配置文件spring-mybatis.xml <!-- 开启事务支持 --> <tx:annotation-driven transaction-manager="transactionManager" /> &n

- 更新Anadroid SDK Tooks之后,Eclipse提示No update were found

xp9802

eclipse

使用Android SDK Manager 更新了Anadroid SDK Tooks 之后,

打开eclipse提示 This Android SDK requires Android Developer Toolkit version 23.0.0 or above, 点击Check for Updates

检测一会后提示 No update were found