【论文阅读】FFUNet:一种新的特征融合为医学图像分割提供了强大的解码器

参考文献:Xie, J., et al.: FFUNet: a novel feature fusion makes strong decoder for medical image segmentation. IET Signal Process. 16(5), 501–514(2022).https://doi.org/10.1049/sil2.12114

目录

摘要

一、引言

二、相关工作

2.1 基于CNN的编码器和解码器方法

2.2 transformer用于医学分割

2.3 跳跃连接

2.4 特征融合网络

三、研究方法

3.1 结构概述

3.2 带两个分支的编码器

3.3 ConvUpBlock

3.4 特征融合模块(FFM)

四、实验

4.1 数据集

4.2 实现细节

4.3 与现有技术的比较

4.4 消融研究

4.5 泛化到其他数据集

五、 结论

参考文献

摘要

卷积神经网络(CNN)具有很强的提取局部特征的能力,但在提取全局上下文方面稍有欠缺。相比之下,transformer由于全局自注意机制,擅长远距离建模,而其局部性能有限。另一方面,编码器和解码器之间的特征差距对于采用普通跳跃连接的U形网络也具有挑战性。

在卷积网络和transformers的基础上,提出了一种用于医学图像分割的混合网络结构FFUNet,该结构具有一个新的模块,即特征融合模块(FFM)。所提出的FFM由特征注意力选择、交叉偏移生成和可变形卷积层组成,旨在取代原始的简单跳跃连接,以缓解编码器和解码器之间的模糊语义信息,从而实现更强大的医学图像分割网络。

实验表明,文章所提出的FFUNet在Synapse数据集的分割增益方面具有惊人的性能。此外,在其他四个流行的数据集上基于CNN或基于transformer的分割网络一致的实现了改进,这表明所提出的方法在泛化和紧凑性方面具有优势。

关键字:注意机制、一致性、可变形卷积、特征融合、医学图像分割、跳跃连接

一、引言

医学图像分割对患者的诊断和后续治疗计划的制定具有积极作用。分割通常需要有经验的医生进行,这非常耗时,可能会导致一些主观错误。近年来,受益于卷积神经网络(CNN;例如,全卷积网络[1]),医学图像的自动和高精度分割已经成为可能。

在医学图像分割领域,包括具有跳过连接的对称编码器-解码器的U形结构[2,3]已成为主流的分割网络架构。后续网络的主要部分是精细设计这三个部分(即编码器、解码器和跳过连接),以获得更好的分割性能。在transformer[4]应用于计算机视觉(CV)任务之前,编码器和解码器主要依赖卷积运算。编码器用于从原始特征图中提取语义信息,以生成低分辨率和高维图像特征,解码器对编码器的最终输出进行上采样,以逐渐将分辨率恢复到原始特征图大小,以进行密集预测。在编码器过程中,连续下采样操作通常用于获得具有大感受野的高水平语义特征图。然后,在解码过程中,使用相应的跳过连接来弥补由编码器中的下采样引起的空间信息的损失。使用这种简洁的结构,U-Net及其变体(Res‐UNet[5]、MultiResUNet[6]、U-Net++[7]和U-Net3+[8])在各种医学图像数据集上取得了令人鼓舞的结果。

尽管基于CNN的U‐Net结构在多个医学图像数据集上取得了巨大的分割成就,但卷积运算专注于局部特征图的固有缺陷导致缺乏对远距离建模的能力。另一方面,得益于全局自注意力机制,transformer是远程建模的专家。因此,越来越多的研究人员正在尝试采用CNN和transformer的混合组合(例如Conformer[9]、BotNet[10]和TransFuse[11])或纯transformer(如Swin transformer[12]和Shuffle transformer[13])来提取高级语义信息,以进行精确分类,同时消除卷积的固有局部性。基于transformer的识别网络已经在一些大型数据集(例如,ImageNet‐22K)上匹敌或超过了基于CNN的最新网络,同时具有相似或甚至更少的参数和计算成本。为了顺应潮流,在出色性能的激励下,U‐Net结构的编码器和解码器逐渐采用transformer进行分割任务。例如,SwinUNet[14],一种用于医学图像分割任务的U形纯变换器,在Synapse多器官CT数据集(Synapse)[15]和自动心脏诊断挑战数据集(ACDC)[16]上优于最先进的方法。

除了精心设计功能强大的编码器和解码器外,适当的跳跃连接对于正确融合功能也至关重要。由于编码器和解码器级之间的特征差异降低了分割性能,因此提出了一系列方法来探索如何缓解编码器和解码器之间的差异。名为U‐Net++[7]的典型网络在编码器和解码器之间的跳跃连接中使用密集连接,与普通跳跃连接相比,该网络获得了更好的分割结果。UCTransNet[17]从信道方向的角度设计了跳跃连接,该连接包括带变压器的信道交叉融合(CCT)和信道交叉注意(CCA),并在文中提到的数据集上产生了优异的分段性能。

受Conformer‘s[9]惊人成功的启发,我们提出的FFUNet在这项工作中利用CNN和transformer的力量进行二维医学图像分割。FFUNet是一种混合U形架构,由编码器、解码器和跳过连接组成。编码器基于Conformer模块构建,该模块具有双分支(即CNN和变压器分支)。值得一提的是,我们在解码器中没有使用transformer分支。此外,为了增强编码器提取高级语义信息的能力,跳过连接在解码器恢复空间细节的能力中也起着重要作用。不同的渠道和空间维度通常侧重于不同的语义模式;自适应和有效地融合特征有利于复杂的密集预测(如医学图像分割)以提高精度。我们重新思考跳跃连接的特征差距,并重新设计替代架构,而不是简单的连接操作(例如,元素相加或信道级联),以更好地融合编码器和解码器级之间的特征。更具体地,提出了一种名为特征融合模块(FFM)的新模块,该模块通过选择卷积核中具有可学习偏移的每个计算位置来学习将编码器特征映射与解码器对齐,以有效融合编码器和解码器级的不兼容特征集。FFM可以很容易地嵌入并应用于医学图像分割任务中流行的UNet。一系列实验表明,在Synapse、ACDC和Gland segmentation(GlaS)数据集上,FFUNet分别比SwinNet提高了1.50%、0.70%和1.24%的DSC绝对增益,从而大大改善了分割流水线。文章贡献可以总结如下:

- 由于Conformer的优异性能,我们基于Conformer模块构建了编码器,该模块由CNN块、transformer块和特征耦合单元(FCU)组成[9]。解码器仅保留Conformer的CNN块。ConvUpBlock用于通过插值操作对提取的深度特征进行上采样,用于像素级语义预测。

- 为了缓解编码器和解码器级之间的特征差距,精心设计了FFM,该FFM由特征注意选择(FAS)、交叉偏移生成(COG)和可变形卷积层(DCL)组成,以提高跳跃连接的效率。我们引入了一种新的视角,通过与注意力机制[18]和可变形卷积操作[19]进行更有效的特征融合来弥补编码器和解码器之间的特征差距,以捕获更复杂的相关性。

- 我们提出了一项彻底的实验评估,表明FFUNet在五个公共数据集上的优异性能,包括Synapse[15]、ACDC[16]、GlaS[20]、MoNuSeg[21,22]和ISIC‐2017[23]。所提出的FFUNet具有显著的分割精度,在Synapse数据集上,DSC/HD达到80.63/18.15,与最近最先进的SwinNet相比,总体得分提高了1.50/3.40[14]。与基于CNN或基于transformer的分割网络相比,其余四个数据集都取得了一致的改进。通常,对多个数据集的广泛实验表明,我们的网络具有强大的鲁棒性和泛化能力。

本文的其余部分组织如下。在第2节中,我们回顾了关于医学图像分割任务的相关工作。第3节介绍了网络结构和详细方法。然后,第4节介绍了比较和消融实验,第5节总结了我们提出的方法。

二、相关工作

2.1 基于CNN的编码器和解码器方法

在过去的一段时间里,依赖卷积运算和残差连接的CNN[24-29]在图像识别中占据了主流地位。医学图像分割是一项密集的预测任务,用于识别分类中的每个像素。由于U形结构的出色性能和优雅,基于UNet的方法被广泛用于分割任务。Res‐UNet[5]是在原始UNet模型基础上构建的残差网络,并添加了加权注意机制。这种设计允许模型学习更多的信息,以区分血管和非血管像素的特征,并更好地维护视网膜血管树结构。CT体积中的肝脏和肿瘤分割面临两个挑战,即二维CNN无法学习三维空间信息,三维CNN需要高计算成本和GPU内存消耗。为了克服上述问题,Li等人。[30]提出了一种新的混合密集连接UNet(H‐DenseUNet),它由简单的ResNet、2D Dense UNet、3D DenseUNet和混合特征融合层组成。目前,基于CNN的方法由于其强大的特征提取能力,不仅在自然图像分类领域,而且在医学图像分割领域都取得了令人印象深刻的成功。

2.2 transformer用于医学分割

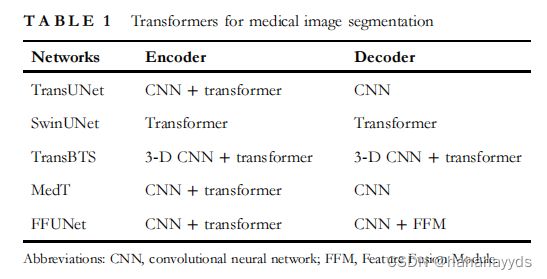

最近,一种开创性的视觉transformer[4]依靠自我注意机制,可以消除卷积运算的有限长距离依赖能力,在自然图像分类方面实现了最先进的性能。受各种CV领域中transformer令人印象深刻的准确性的激励,最近开发了用于医学图像分割的新框架,以便对全局上下文进行建模。例如,Chen等人[15]首次尝试将transformer引入名为TransUNet的编码器,并在Synapse和ACDC数据集上的医学图像分割中取得了良好的性能。与TransUNet不同,TransBTS[31]基于三维CNN,一次处理所有图像切片,从而更好地表示切片之间的连续信息。Medical Transformer[32]旨在满足以下事实:与使用门控轴向注意力模型和局部-全局训练策略的CV数据集相比,医学成像数据相对较低。由于Swin Transformer[12]的出色性能,Cao等人[14]提出了由纯transformer编码器和纯transformer解码器组成的SwinUNet,以揭示U形结构编码器和解码器中纯变压器的可行性和潜力。总之,我们在TABLE 1中介绍了transformer在医学图像分割编码器和解码器中的应用。

值得一提的是,Conformer[9]提出了一种双网络框架(CNN分支和变压器分支),它利用CNN提取局部特征,并利用transformer捕获全局上下文,作为通用主干网络。Conformer利用FCU融合CNN的局部特征和transformer的全局特征,在包括图像分类、对象检测和实例分割在内的各种CV任务中实现了惊人的性能。在这项工作中,我们探索使用Conformer模块作为基本单元,利用精心设计的用于医学图像分割的编码器构建合格的编码器-解码器网络。

2.3 跳跃连接

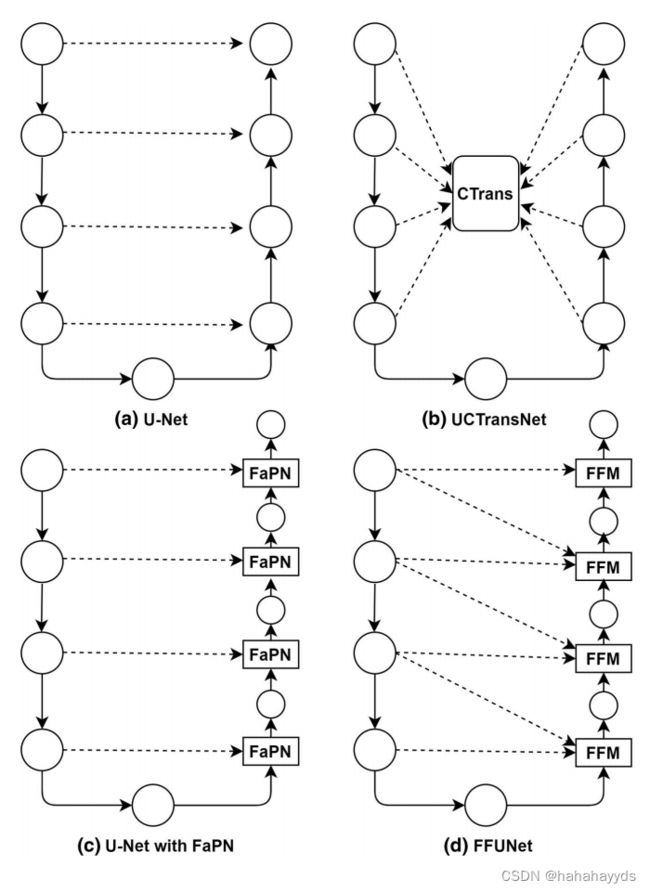

当UNet[2]被提出时,跳过连接机制被应用于桥接编码器和解码器之间的特征,并在恢复更精细的细节方面发挥了重要作用[33]。UNet的跳跃连接强加了不必要的限制性融合方案,仅在编码器和解码器子网的相同尺度特征图上强制融合。为了克服不必要的限制,UNet++[7]不仅结合了深度特征,还结合了浅层特征,用于收集多尺度特征,以缓解语义差距,更有利于特征融合。Wang等人[17]分析了跳过连接到医学图像分割对GlaS和MoNuSeg数据集的影响,并提出了UCTransNet,该网络从信道注意力的角度由CCT和CCA组成,具有优异的分割性能。Huang等人[34]认为,在编码器和解码器之间采用像素相加或信道级联会导致特征图未对齐,并降低分割精度,尤其是在对象边界上。他们提出了特征对齐金字塔网络(FaPN),该网络由特征对齐模块和特征选择模块组成,当与Faster/Mask R‐CNN在平均精度/平均交集上配对时,其性能优于FPN[35]。

2.4 特征融合网络

涉及不同阶段的特征融合是提高分割性能的重要手段。低级别特征具有更高的分辨率,并包含更多得细节信息;然而,它们缺乏语义,并且由于卷积较少而具有更多的噪声。高级特征具有更多的语义信息,而它们的分辨率很低,对细节的感知能力很差。因此,如何有效地整合这两种特征是分割模型的关键。如TABLE 2所示,我们介绍了最近流行的融合方法。

在这项工作中,我们设计了FFM,它不仅利用了当前阶段的特征图,还利用了前一阶段的特征图来有效融合特征,如图1所示。FFM的详细介绍将在第3节中说明。

三、研究方法

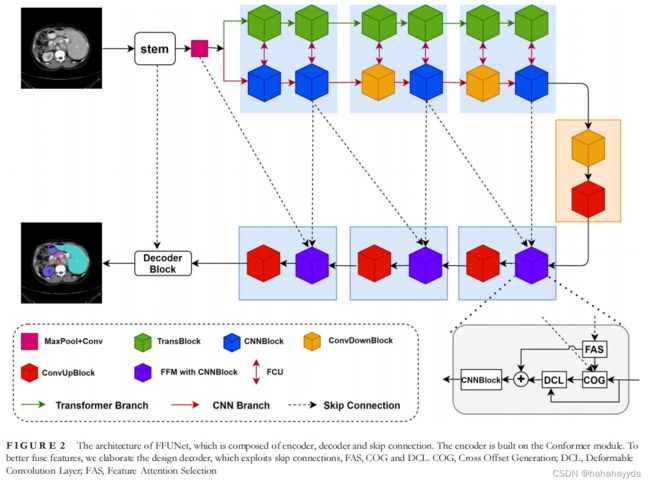

figure.2展示了我们精心设计的FFUNet架构的概述。据信,出色的分割性能需要编码器、解码器和跳过连接三个部分之间的紧密合作。然后,解码器如何有效地使用编码器和跳过连接来执行精确的像素分类,这是密集预测的关键。在这个问题的驱动下,我们详细阐述了解码器的设计,该解码器采用了一个名为FFM的新模块,通过更有效的特征融合与注意力机制[18]和可变形卷积运算[19]来桥接编码器和解码器之间的特征差距,以捕获更复杂的相关性。

在这个问题的驱动下,我们详细阐述了解码器的设计,该解码器采用了一个名为FFM的新模块,通过更有效的特征融合与注意力机制[18]和可变形卷积运算[19]来桥接编码器和解码器之间的特征差距,以捕获更复杂的相关性。

3.1 结构概述

如figure2所示,提出的FFUNet包括四个重要模块:即Conformer模块(由TransBlock和CNNBlock组成),ConvUpBlock,以及FFM(由FAS、COG和DCL组成)和跳跃连接。具体而言,FFUNet编码器的基本单元是Conformer模块[9],用于提取多尺度特征和建模长距离相关性。ConvUpBlock专门设计用于执行像素级语义预测的2×上采样和插值操作。FAS使用注意力机制来选择来自编码器的特征图的重要性,并作为COG的输入来生成DCL的偏移。COG用于融合ConvUpBlock、FAS和最后一级低级特征产生的特征,有效地为DCL生成有益的局部特征。DCL设计用于根据COG学习到的偏移量选择有用的特征。三个部分的有效合作使FFUNet在多个数据集上表现良好。

给定输入图像X∈ ℝ^H×W×C, H× W和C分别表示空间分辨率和通道数。基于使用局部特征和全局上下文的原则,Conformer被设计为双网络结构,包括CNN分支和变压器分支。我们首先使用stem和Conformer模块生成五个层次特征Fi ∈ ℝ^Ci ×H/2i ×W/2i , where i ∈ {1; 2; 3;4; 5}and Ci ∈ {64; 64; 128; 256; 256},最后一个解码器块用于恢复大小为H×W的全空间分辨率.

3.2 带两个分支的编码器

继[9]之后,我们的编码器除主干块外还包括TransBlock、CNNBlock、FCU[9]和ConvDownBlock。输入图像X首先经过干块和最大池层,分别生成特征图F1 ∈ C×H/2i×W/2和F2 ∈ C×H/4×W/4(C=24)。F2被馈送到CNN分支和变换器分支以进一步执行表示学习。具体而言,CNN分支由七个CNNBlock和ConvDownBlock组成,生成特征金字塔结构。ConvDownBlock执行下采样以降低特征图的分辨率并扩展感受野。变压器分支由六个TransBlock组成,旨在为CNN分支提供远距离上下文,而CNN分支则为变压器分支提供详细的本地特征。为了缓解两个分支之间的不一致,建议FCU[9]以交互方式将局部特征与全局上下文进行转换。与之前的文献[36-38]相似,TransBlock中的自我注意如下:

其中Q; K; V ∈ ℝ^M^2×d表示the query, key and value matrices;M2表示窗口中的补丁数;d是query或者key的维度;B取自较小尺寸的偏置矩阵B∈ ℝ^(2M-1)(2M-1) [36]. SoftMax将输入映射到从0到1的实数,并且标准化确保总和为1。

自注意力机制,计算TransBlock内部元素之间的关注度,允许网络整合整个图像中的信息,即使是在最底层。注意力可以解释为将可用计算资源的分配偏向于信号中最有用的分量的一种方式。聚焦过程反映在权重系数的计算中。权重越大,越关注其对应的值,即权重表示信息的重要性,而值就是对应的信息。

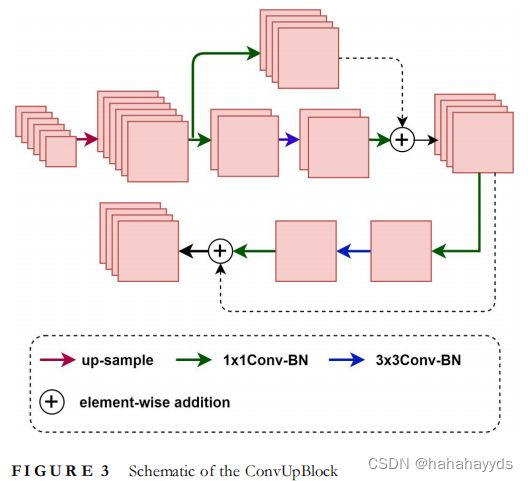

3.3 ConvUpBlock

如图3所示,ConvUpBlock设计为2× 对特征图进行上采样,这在通道数减少的同时增加了地图的分辨率。首先,我们使用双线性插值对输入特征图进行上采样以提高空间分辨率。按照ResNet[25]中的布局,ConvUpBlock由一个上采样层和两个瓶颈组成,其中包括1× 1个卷积以减小信道尺寸(4倍),3×3空间卷积,a 1×1卷积以恢复信道号和使网络更深的剩余连接。

3.4 特征融合模块(FFM)

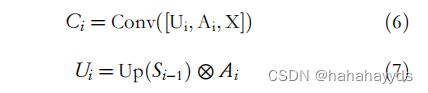

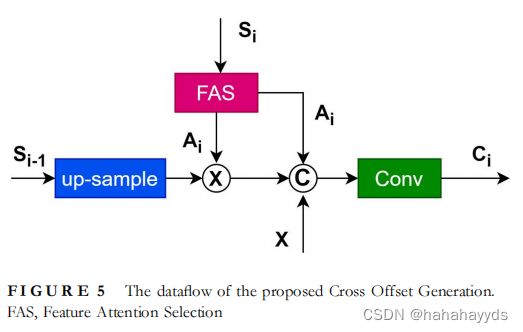

由于ConvDownBlock的下采样操作,编码器和解码器的跳跃连接之间存在可预见的语义差异。为了减少这种差距,提出了FFM(见figure.2),具体来说,我们将跳跃链接的输出定义为Si∈ℝ^Hi×Wi(i∈{1,2,3,4},Hi=H/2^i,Wi=W/2^i),W×H是原始输入图像的空间分辨率。以第一个跳跃链接为例,FFM有三个输入,即来自ConvUpBlock的X∈ℝ^14×14,来自跳跃链接的S4∈R^14×14和S3∈R^28×28。S4通过FAS(表示为fFAS(·)),通向A4∈ℝ^14×14。然后X和COG(表示为fCOG(·))馈入DCL(表示为fd(·))对采样的重点进行预测。简而言之,FFM的流程课制定如下:

其中[]是两个参数的串联。

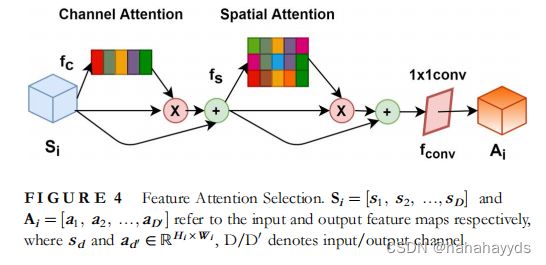

3.4.1 特征注意力选择(FAS)

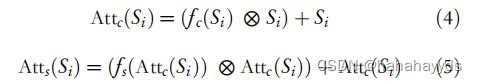

根据参考文献[39–42],注意机制在分割任务中起着重要作用。解码器尝试减少信道数,同时使用跳跃连接提供的详细特征来增加密集预测的空间分辨率。因此,在抑制跳过连接的无用特征的同时,增强有用的特征图以实现精确分配是至关重要的,也是具有挑战性的。如图4所示,FAS旨在克服这一挑战。与参考文献[18]中的CBAM一样,FAS由通道注意力模块和空间注意力模块[43]组成,其公式如下:

其中Conv(·)是1×1卷积层,Atts(·)和Attc(·)分别表示空间关注模块和通道关注模块。根据图4,Atts(·)和Attc(·)可以公式如下:

其中fc(·)和fc(·)的实现与参考文献[18]中的CBAM相同。

值得注意的是,我们FAS的设计灵感来自CBAM,它们之间主要有两个不同。首先,我们在逐元素乘法之后采用加法运算,以增加重要特征的值。其次,在模块的最后,采用1×1的卷积核和组归一化[44]来调整信道数。

3.4.2 交叉偏移生成(COG)

COG的数据流如图5所示。X表示自下而上路径ConvUpBlock、Si和Si的特征图−1来自跳跃连接,COG可数学公式如下:

四、实验

4.1 数据集

Synapse多器官分割数据集(Synapse)包含8个腹部器官(主动脉、胆囊、脾脏、左肾、右肾、肝、胰腺、脾脏、胃),包含3779张中向腹部临床CT图像。参考文献[[14],[15],在我们的实验中,Synapse的18个病例用于训练,其他12个病例用于测试。类似于参考。[[14],[15]]我们使用的ACDC是使用MRI扫描仪从100例患者中收集的。数据集中标记了左心室、右心室和心肌,其中包括 70 个训练样本、10 个验证样本和 20 个用于测试的样本。由国际皮肤图像协作组织(ISIC)档案馆提供的ISIC-2017挑战数据集通常分为2000张训练图像,150张验证图像和600张测试图像。此外,GlaS有85张图像用于训练,80张用于测试,而MoNuSeg数据集有30张用于训练的图像和14张用于测试的图像。

4.2 实现细节

实验中使用的硬件设备是**Intel Intel(R) Xeon(R) CPU E5-2680 v4 2.40GHz和NVIDIA GeForce RTX 3060(12G)。PyTorch 1.9和Python 3.6用于实现所提出的网络。**对于所有实验,输入图像调整为224 ×224,批次大小设置为24,GlaS除外,MoNuSeg在参考文献之后设置为4[[17][32]]。除非另有说明,否则我们使用 ImageNet 上的 Conformer 预训练权重来初始化网络。在训练阶段,采用动量参数为0.9、权重衰减为1e−4的随机梯度下降法对模型进行优化。对于所有实验,仅应用简单的数据增强(例如,随机翻转和旋转)来增加数据多样性,以增强模型的泛化能力。计算骰子损失和二进制交叉熵损失以优化反向传播模型。

值得指出的是,Synapse 和 ACDC 数据集是 3-D 体积,以逐个切片的方式进行训练,最终输出由 2-D 切片重建以进行 3-D 预测。

4.3 与现有技术的比较

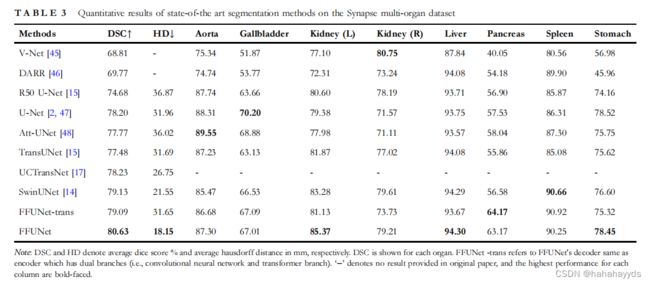

为了验证所提出的FFUNet的整体分割性能,我们对Synapse多器官分割数据集进行了主要实验,并与现有技术进行了比较,特别是TransUNet [15],UCTransNet [17]和SwinUNet [14]的方法。结果如表[3]所示,其中最佳结果以粗体显示。表[3]显示,我们的FFUNet在DSC 80.63%和HD 18.15毫米下实现了最佳性能。与TransUNet [15]、UCTransNet [17]和SwinUNet [14]相比,尽管所提出的方法在DSC评估指标上仅略高于现有技术,但在HD方面增加了[13.5]毫米,这表明FFUNet可以改善医学图像分割任务中的边缘预测。

继SwinUNet [14]之后,一个直观的解决方案是简单地使用具有CNN和变压器分支的对称编码器和解码器进行全分辨率预测。这就是FFUNet-trans设计背后的原则,与TransUNet相比,FFUNet-trans实现了有竞争力的性能[15]。然而,FFUNet-trans的参数量几乎是FFUNet的两倍,而其性能弱于FFUNet。该结果表明解码器中的transformer是一个负担;除了增加网络参数的数量外,它并没有带来任何分段性能的改进。因此,我们采用没有transformer分支的解码器作为最终设计。另一方面,我们使用 Ref. [47] 提供的发布代码来实现 U-Net [[2]],实验结果也如表3 所示。

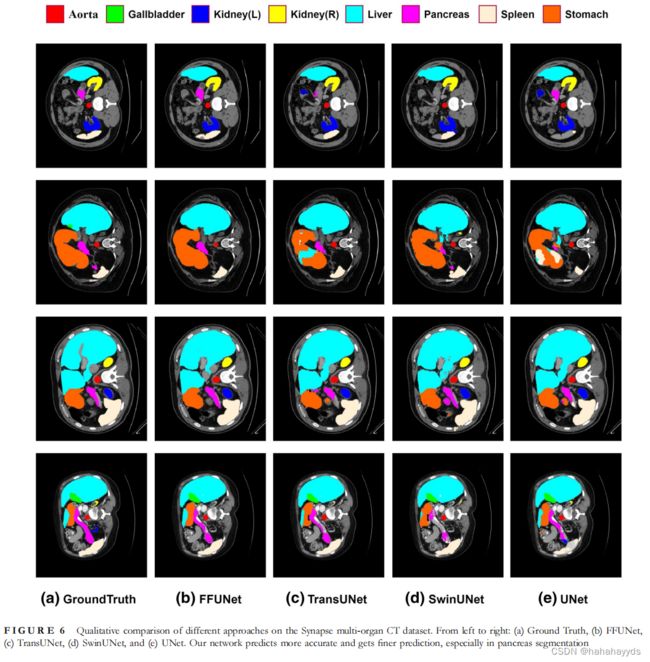

表[3]还显示,在最近的技术中,胰腺分割通常得分最低,甚至比U-Net [2]更差(例如,TransUNet [15]和SwinUNet [14])。但拟议的FFUNet在胰腺分割方面有显着改善(与SwinUNet相比,DSC约为7%)。特别是,与SwinUNet相比,具有双分支(即FFUNet-trans)的编码器产生近8%的DSC,甚至优于FFUNet。这是由于胰腺具有长而扁平的形状,这对于纯基于CNN,纯变压器或混合CNN变压器的简单融合方式难以分割胰腺的精细形状。基于Conformer[9]模块,FFUNet利用FCU逐步融合CNN和变压器分支生成的特征图。由于全局自注意力机制,Transformer可以进行远距离建模,但定位能力有限,而CNN具有很强的获取低级线索的能力,这对于分割任务至关重要。因此,当变压器分支保留在解码器中时,FFUNet-trans获得了更好的胰腺分割,并且优于所提出的FFUNet。四种方法的可视化分割结果如图[6]所示。它揭示了我们的FFUNet产生更好的密集预测,这些预测比其他预测更接近地面真相。更具体地说,FFUNet的胰腺分割在四种情况下实现了最佳性能,特别是图[6]所示的第三行和第四行的分割结果,这与上述分析一致。

我们还对ACDC数据集进行了一系列比较实验,定量结果总结在表[4]中。结果表明,FFUNet仍然能够获得优异的性能,平均Dice得分为90.70%,证明了FFUNet的有效性。

4.4 消融研究

为了彻底研究每个组件的影响并验证不同设置下的性能,对Synapse数据集进行了一系列消融研究。具体来说,FFM的影响,前跳跃连接特征图si-1、FAS 和跳跃连接数。

4.4.1 FFM的影响

如[第3]节所述,开发FFM是为了缩小编码器和相应解码器级之间的差距。我们采用FFM模块来有效地融合特征,而不是逐元素添加或通道级串联。为了探索FFM的有效性,我们分别在Synapse数据集的融合阶段应用了逐元素加法(表示为FFUNet-add)和通道级串联(表示为FFUNet-cat)。结果总结在表[5]中,表明无论是应用逐元素加法还是使用逐通道级串联,性能损失都相对较大,例如*,*使用FFUNet-add的DSC从80.63%急剧下降到74.84%。但如表[5]所示,胰腺分割的性能分别达到58.50%和57.78%,超过了近期优秀的网络SwinUNet(获得56.58%)。这是由于我们使用的主干(即Conformer[[9]),它将CNN与视觉转换器相结合,以提取局部特征并捕获全局上下文。总之,FFM在我们的模型中是必不可少的。

4.4.2 前跳跃连接特征图si-1的影响

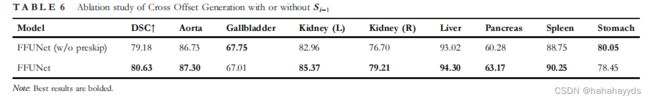

前跳跃连接功能图si-1在最初的U-Net [[2](https://ietresearch.onlinelibrary.wiley.com/doi/10.1049/sil2.12114#sil212114-bib-0002)]设计中没有使用。在这项工作中,使用的目的在融合阶段就是利用它提供的详细特征来引导特征融合,达到缓解语义鸿沟的目的。为了评估效果作为COG的输入,我们对“FFUNet(无预跳过)”版本进行消融实验;结果如表[6]所示。结果发现,前跳跃连接特征图的配置导致性能提升了 1.45% DSC。

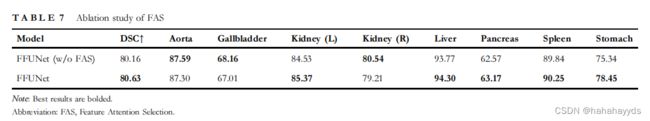

4.4.3 FAS的影响

本工作采用FAS来细化编码器Si到Ai的重要特征。先前的消融实验表明,FFM在我们的模型中是必不可少的。然而,还需要确定FAS是否对FFM不可或缺。为了证明FAS的有效性,我们将其从FFUNet中删除,表示为FFUNet(w/o FAS)。如表[7]所示,与原始 FFUNet 相比,没有 FAS 的模型在 Synapse 数据集上略有下降。具体来说,DSC从80.63%降低到80.16%

4.4.4 跳跃连接数

与TransUNet [15]和SwinUNet [14]不同,我们的FFUNet的跳跃连接集成在1/2,1/4,1/8和1/[16](https://ietresearch.onlinelibrary.wiley.com/doi/10.1049/sil2.12114#sil212114-bib-0015)分辨率的四个位置。在U-Net形状的网络中,跳跃连接可以通过融合编码器级提供的低级线索来增强更精细的分割细节。与前两个出色的网络类似,我们探索了通过将跳跃连接数分别设置为 0、1、2、3 和 4 来验证 FFUNet 中不同跳跃连接的影响。例如,仅在 1/16 的位置添加跳过连接表示为“skip-1”,而“2”的数量是指在 1/8 和 1/16 分辨率比例(表示为“skip-2”)的位置添加跳跃连接。所有实验结果如图[7]所示,通过融合所有四个跳跃连接到FFM来获得最佳DSC。显然,分割性能随着跳跃连接的增加而提高,但并非所有器官都具有相同的优势。例如,当跳跃连接从 0 增加到 4 时,肝脏分割仅改善约 6%,而主动脉和胆囊增加超过 30%。结果是由较大的器官(例如肝脏)引起的,即使没有跳跃连接,也可以在解码器阶段保留低级细节,在某种程度上。但是,小物体(例如主动脉和胆囊)需要使用跳跃连接来恢复特征细节。此外,与TransUNet的结果相比[15],FFUNet中拟议的FFM获得了更多的DSC分数。

4.5 泛化到其他数据集

为了进一步揭示FFUNet的泛化和鲁棒性能力,我们对其他三个数据集进行了各种实验,包括ISIC-2017,GlaS和MoNuSeg。FFUNet的持续改进超越了现有技术,这与Synapse和ACDC数据集的先前性能相似。

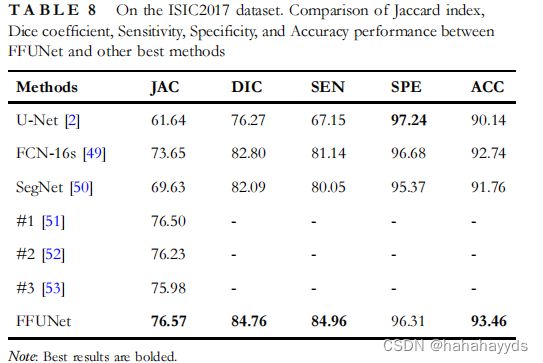

4.5.1 对ISIC-2017的概括

在表[8]中,我们将FFUNet与三种艺术方法和前3名ISIC-2017皮肤病变分割挑战记录进行了比较。请注意,Jaccard 指数 (JAC) 是黄金评估指标,所有参与者都根据该指标进行排名。这些关于ISIC-2017挑战的报告结果可以在一定程度上反映皮肤病变分割任务的最新表现。就JAC而言,我们的方法略好于ISIC-2017皮肤病变分类挑战排行榜中的前1名。

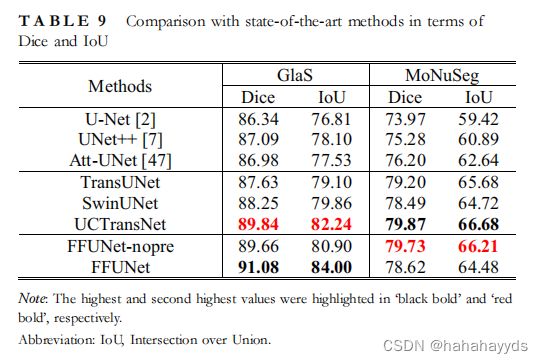

4.5.2 推广到GlaS和MoNuSeg

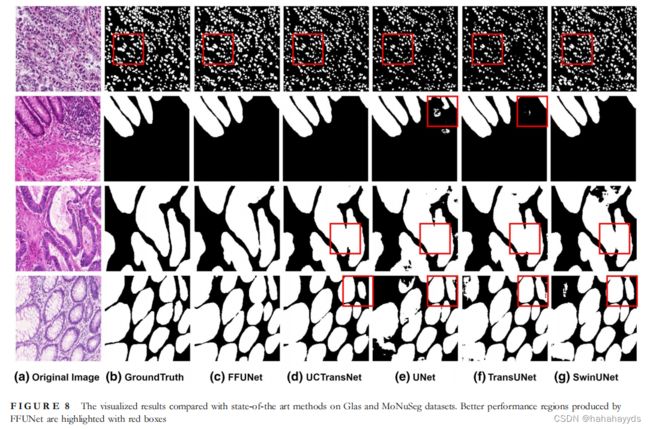

继UCTransNet [17]之后,我们使用Dice系数和IoU作为评估指标来评估FFUNet在GlaS和MoNuSeg数据集上的性能。FFUNet-nopre表示不使用任何预先训练的权重来训练FFUNet。表[9]的实验结果表明,所提方法的泛化能力较好。具体来说,在GlaS数据集上,FFUNet在Dice和IoU方面分别获得了1.24%和1.76%的改善。另一方面,与UCTransNet相比,MoNuSeg数据集上实现了有竞争力的性能,UCTransNet是从头开始训练的,不使用预训练。我们还在图[8]中可视化了 FFUNet 和其他最先进方法的分割结果。

4.6 讨论

在Conformer模块中,我们利用卷积运算符来提取局部特征和自我注意机制来捕获全局上下文。为了减轻由于降采样操作而导致编码器和解码器跳跃连接之间的差距,提出了FFM。FFM的可变形卷积可以根据COG提供的偏移调整其卷积样本位置。如第4.1.1节所述,FFM与其他两种方法相比,性能最佳。由于所提方法的输入是二维的,而大部分医学图像数据是三维的,我们将在未来的研究中探索FFUNet在三维医学图像分割中的应用。

五、 结论

医学图像分割是医疗保健系统发展的重要先决条件,尤其是疾病诊断和治疗计划。在本文中,我们介绍了一种新的混合架构设计,该设计由基于Conformer模块的双分支编码器组成,该编码器将能够提取局部特征并捕获全局上下文;基于CNN的解码器,具有高效的FFM,可学习以下可变形卷积操作的偏移,以减轻编码器和相应解码器之间的特征差距;并跳过当前阶段和上一阶段提供的连接。在Synapse和ACDC数据集上进行的大量实验表明,与各种竞争方法相比,FFUNet具有出色的性能。为了进一步评估泛化能力,在ISIC-2017、GlaS和MoNuSeg数据集上进行了一系列分割实验,结果表明了一致的改进。综上所述,FFUNet具有比最先进的方法更好的分割性能。

参考文献

1. Shelhamer, E., Long, J., Darrell, T.: Fully convolutional networks for semantic segmentation. IEEE Trans. Pattern Anal. Mach. Intell. 39(4), 640–651 (2017)

2. Ronneberger, O., Fischer, P., Brox, T.: U‐net: convolutional networks for biomedical image segmentation. In: Medical Image Computing and ComputerAssisted Intervention (MICCAI), ser. LNCS, vol. 9351, pp.234–241. Springer (2015)

3. Isensee, F., et al.: nnu‐net: a self‐configuring method for deep learning‐ based biomedical image segmentation. Nat. Methods. 18(2), 203–211 (2021)

4. Dosovitskiy, A., et al.: An image is worth 16x16 words: transformers for image recognition at scale. arXiv:2010.11929 (2020). [http://arxiv.org/](http://arxiv.org/) abs/2010.11929

5. Xiao, X., et al.: Weighted res‐unet for high‐quality retina vessel segmentation. In: 2018 9th International Conference on Information Technology in Medicine and Education (ITME), pp.327–331 (2018)

6. Ibtehaz, N., Rahman, M.S.: MultiResUNet : rethinking the U‐Net architecture for multimodal biomedical image segmentation. Neural Network.121, 74–87 (2020). [https://doi.org/10.1016/j.neunet.2019.08.025](https://doi.org/10.1016/j.neunet.2019.08.025)

7. Zhou, Z., et al.: Unet++: a nestedu‐net architecture for medical image segmentation, pp. 3–11. Springer Verlag (2018)

8. Huang, H., et al.: Unet 3+: a full‐scale connected unet for medical image segmentation. arXiv:2004.08790 (2020). [http://arxiv.org/abs/2004.08790](http://arxiv.org/abs/2004.08790)

9. Peng, Z., et al.: Conformer: local features coupling global representations for visual recognition. arXiv:2105.03889 [cs] (2021). [http://arxiv.org/](http://arxiv.org/) abs/2105.03889

10. Srinivas, A., et al.: Bottleneck transformers for visual recognition.arXiv:2101.11605 (2021). [http://arxiv.org/abs/2101.11605](http://arxiv.org/abs/2101.11605)

11. Zhang, Y., et al.: TransFuse: fusing transformers and CNNs for medical image segmentation. arXiv: 2102.08005 (2021). [http://arxiv.org/abs/](http://arxiv.org/abs/) 2102.08005

12. Liu, Z., et al.: Swin transformer: hierarchical vision transformer using shifted windows. arXiv:2103.14030 (2021). [http://arxiv.org/abs/2103](http://arxiv.org/abs/2103).14030

13. Huang, Z., et al.: Shuffle transformer: rethinking spatial shuffle for vision transformer. arXiv:2106.03650 (2021). [http://arxiv.org/abs/2106.03650](http://arxiv.org/abs/2106.03650)

14. Cao, H., et al.: Swin‐Unet: Unet‐like pure transformer for medical image segmentation. arXiv:2105.05537 (2021). [http://arxiv.org/abs/2105](http://arxiv.org/abs/2105).05537

15. Chen, J., et al.: TransUNet: transformers make strong encoders for medical image segmentation. arXiv:2102.04306 (2021). [http://arxiv.org/](http://arxiv.org/) abs/2102.04306

16. Luo, X., et al.: Semi‐supervised medical image segmentation through dual‐ task consistency. In: AAAI Conference on Artificial Intelligence (2021)