脑启发重放,利用人工神经网络进行持续学习

Task IL中,一个agent必须增量学习执行多个不同的任务。

在 MNIST数据集上,强调了回放的惊人效率和鲁棒性:仅回放少量或低质量的样本就足够了。

然而,我们发现将GR扩展到更复杂的问题并不简单。

为了解决这个问题,我们提出了一种新的GR变体,其中内部或隐藏的表示被重放,这些表示是由网络自身的上下文调制反馈连接生成的。

Results

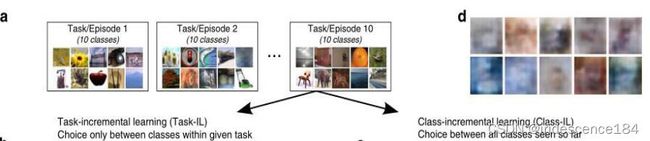

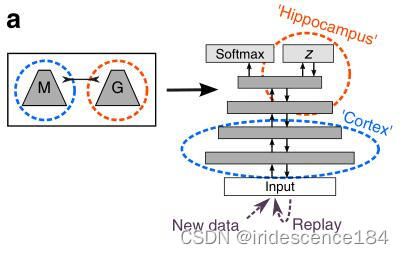

我们重点研究了基于图像分类的持续学习问题。我们遵循 Shin等人 20 ^{20} 20提出的一般框架:除了解决任务的主要模型(即分类器),还训练了一个单独的生成模型来生成要重放的数据(图

2)。我们使用标准的可变自动编码器(V AE) 28 ^{28} 28作为生成器(参见“方法”)。

缓解灾难性遗忘的方法:

弹性权重整合(EWC)25 ^{25} 25和智能突触(SI)29 ^{29} 29,这两种方法都是保护对先前学习任务非常重要的网络参数.从神经科学的角度来看,这些方法可以解释为受启发的变形可塑性。- 另一种最近的、受神经科学启发的使用人工神经网络进行持续学习的方法是

上下文相关门控(XdG)31 ^{31} 31。为了减少任务之间的干扰,该方法为每个任务选择不同的、随机选择的网络节点子集。XdG的一个重要限制是,它假定要执行的特定任务总是已知的,这意味着该方法不能用于 Class IL。 “不忘学习”(LwF)32 ^{32} 32,该方法与基于重放的方法有一个有趣的联系:该方法不是存储或生成要重放的数据,而是使用在前一个任务上训练过的模型对当前任务的输入进行标记后,重放当前任务的输入。

Class-IL might require replay.类增量学习可能需要重放

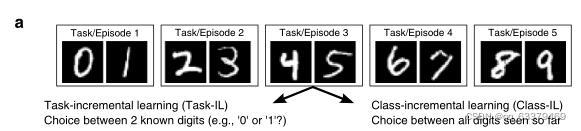

split MINIST的两个场景:

任务增量学习(Task IL)在两个已知数字(例 如“0”或“1”?)之间进行选择.

类增量学习(Class IL)在迄今为止看到的所有数字之间进行选择

在split MNIST的这两个场景(Task IL场景和 Class IL场景)中,我们比较了GR与 EWC、SI和 LwF的实现,以及 Task IL场景与 XdG的实现。

None:下限,用标准方法微调每个新任务的神经网络

Joint:下限,使用迄今为止所有任务的数据训练的网络

b. 对于 Task IL场景,当任务必须增量学习时,所有比较的方法都成功地防止了灾难性遗忘(图 b)。

c. 在 Class IL场景中,当必须以增量方式学习类时,受元塑性启发的方法 EWC和 SI显著失败,只有 GR能够成功地学习所有数字(图 c)

这表明,对于 Class IL,当网络必须学会区分未同时观察到的类时,可能需要某种形式的重放。

Efficiency and robustness of generative replay. GR的效率和稳健性

重要的是,使用 replay并不一定意味着对之前的所有任务进行全面的再训练。重放样本的总数并不依赖于之前任务的数量。对于图 3中的结果,每一次迭代都基于一个小批量(mini-

batch)的 128个当前样本和 128个重放样本(在之前的任务中划分)。

为了检验重放的数量是否可以进一步减少,我们进行了额外的实验,其中每个小批量重放的样本数量是系统性变化的。

图 4生成式重放具有显著的效率和鲁棒性。可以在不严重影响性能的情况下大幅减少重放的数量或质量。a、 b所示为根据task IL和class IL在 split MNIST上执行的生成性重放的平均测试精度(基于所有任务\数字),a是每个小批量重放样本总数的函数,b是用于生成重放的变分自动编码器(V AE)隐藏层中单元数的函数。

我们发现,GR的性能相对稳健(图4 a中的红线):即使每个小批量(mini-batch)有一个重复的样本(即,当前任务中每 128个样本有一个重复的样本),GR在 Task IL场景中的表现也很有竞争力,在 Class IL场景中的表现优于所有非重复方法。

对 GR的另一个常见批评是,它只是“将灾难性遗忘问题转移到生成模型的训练上 。所以培养生成性模型也是一个难题。

LwF在 split MNIST上的合理性能给出了重放并不需要完美才能发挥作用:重放当前任务的输入,例如重放’2’和’3’以避免忘记’0’和’1’优于 EWC和 SI(图 3b,c)。

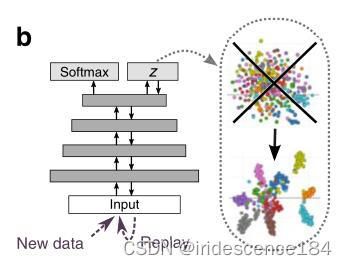

然后,为了进一步、更系统地测试重放的质量需要有多高,我们改变了用于生成回放的 VAE模型中隐藏单元的数量。值得注意的是,将 VAE的隐藏层减少到只有 10个单元会导致低质量的样品(图4 c;左图),但对 GR的性能影响不大(图 4b)。

为什么可以重播如此少或如此低质量的示例?一个可能的原因是,学习新东西比不忘记它要困难得多,在该实验中,我们在对每个新任务进行训练之前(但在生成要重放的样本之后)重新初始化了网络的参数,因此网络必须不断从头开始重新学习之前的所有任务(图 4a,b中的棕色线)。在这种情况下,仅重放少数或低质量的示例确实不足以实现相同的强大性能。

Scaling up to more challenging problems. 扩展到更具挑战性的问题

他们发现,在完成 100项任务后,SI和在线 EWC(EWC的更有效版本)的平均准确率分别为82%和70%。虽然他们提出的方法 XdG本身的性能比两种方法都差(61%),但他们发现,将SI与 XdG结合可以使 SI的性能大幅提高( 95%)。然而,一个重要的警告是,XdG假定在测试时也会告知网络对图像应用了哪种排列。也就是说,虽然 SI和在线 EWC本身是根据域 IL场景执行的,但带有 XdG的变体是根据更简单的 task IL场景执行的。换句话说,使用 XdG获得的性能是否提高取决于测试时额外信息的可用性。

在这里,使用相同的置换MNIST任务协议和100种不同的置换,【我们询问 GR是否可以在测试时不适用额外信息的情况下匹配或改进 SI的性能,】不幸的是,尽管在上一节中给出了令人满意的结果,但我们发现,直接执行 GR并不能很好地扩展到如此长的一系列任务,因为它的性能在执行了大约 15个任务后迅速下降(图 5b中的红线)。

排列 100种排列的 MNIST协议。b根据 Domain-IL场景执行时(即,在测试时没有可用的任务标签),目前执行最好的方法是突触智能(SI)。虽然标准生成式重放(GR)在前 10个任务中性能优于 SI,但在 15个任务之后性能迅速下降。通过我们大脑启发的修改(BI-R;(见下文),生成式重放在 100个任务后也优于 SI。将 BI-R与 SI相结合可以进一步提高性能。在该任务协议下,由于任务之间的输入完全不相关,遗忘学习(LwF)在该任务协议中表现不佳。报告的是迄今为止基于所有排列的平均测试精度。显示的是 5次重复的平均值。

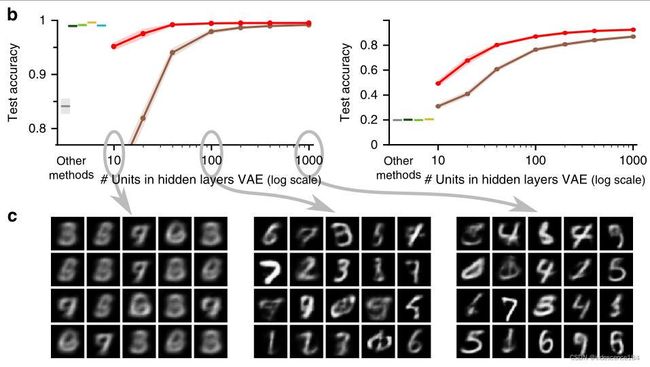

【第二个问题是 GR能否扩展到具有更复杂输入的问题。】为了测试这一点,使用 CIFAR-100数据集,分为 10个任务,每个任务有 10个自然图像类(图 6a)。

a.Task-IL只能在给定任务中的类之间进行选择

d. Class-IL在所有的l类中进行选择

图6b:与split MNIST一样,该任务协议的难度因执行场景的不同而大不相同。根据Task-IL场景执行时(即,始终只能在10个类之间进行选择),我们发现EWC、SI和LwF等方法几乎完全防止了灾难性遗忘(图6b)。而GR的标准版本在使用自然图像的任务协议上失败。但是,通过我们的大脑启发的修改(见下文),生成性重放优于其他方法。

图6c:当按照Class-IL方案执行时(即,目前为止,在所有类别之间进行选择;最后是100种分类),split CIFAR-100协议变得更具挑战性,GR、EWC、SI和LwF表现不佳,遭受严重的灾难性遗忘(图6c)。我们的大脑启发回放(BI-R;见下文),尤其是当与突触智能(SI)相结合时,确实在这个具有挑战性的、未解决的基准上取得了合理的性能

目前,在这个基准上获得可接受性能的唯一方法是显式存储数据的方法,如iCaRL15或经验回放。

Brain-inspired modifications to GR.基于脑启发的 GR修改

上面的结果表明,GR的直接实现对于更具有挑战性的问题是行不通的。

一种可能的解决方案是尝试使用最近在生成模型和深度神经网络的进展,以提高生成器的质量。逐步训练高质量的生成模型也是一个非常具有挑战性的问题,这种解决方案的效率并不高,因为最先进的生成模型往往在计算上非常昂贵,无法进行训练或采样。

考虑到大脑已经实现了一种高效的持续学习算法,这种算法被认为依赖于回放,我们转而向大脑寻求灵感。

第一次修改是受解剖学的启发

大脑中的重放起源于海马体,并从那里传播到皮质。对于当前版本的GR,有人认为主要模型对应于皮质(图 1b)。

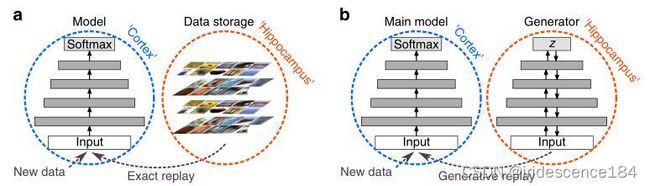

这个类比有一定的道理,但问题是它忽略了海马体位于大脑处理层次的皮层顶部。而我们建议将生成器合并到主要模型中,通过为其配备生成反向或反馈连接。由此产生的模型的前几层可以被解释为对应于视觉皮层的早期层,而顶层对应于海马体(图 7a)。我们将这种“通过反馈重放”模型作为 VAE实现,在编码器的顶层添加了softmax分类层(参见“Methods”)。

图7a Replay-through-feedback(通过反馈进行重放). 通过配备生成反馈或反向连接,生成器被合并到主模型中。

第二次改进

人类可以控制回忆的内容。为了使我们的模型能够控制要生成的类,我们用一个高斯混合模型代替了对 VAE潜在变量的标准正态先验,每个类都有一个单独的模式(图 7b)

这使得通过限制潜在变量的抽样到它们对应的模式来生成特定的类成为可能。此外,对于我们的反馈重放(RtF,replay-through-feedback)模型,这种多模态先验应该鼓励更好地分离不同类别的内部表示,因为它们不再都必须映射到单个连续分布。

图 7b Conditional replay(条件重放). 为了使模型能够生成特定的类,标准正态先验被一个高斯混合模型代替,每个类都有一个单独的模式

第三次改进

背景线索(例如气味、声音)也会影响记忆的重放。在神经网络(ANN)中实现情境相关处理的一种简单但有效的方法是,根据需要执行的任务,在每个隐藏层中完全屏蔽(或“抑制”)不同的、随机选择的神经元子集。这就是 XdG的方法。这种技术只能在任务标识信息始终可用的情况下使用,而对于domain-IL或 class-IL则不是这样。

我们所依赖的内部上下文是要生成或重建的特定任务或类(图 7c;“方法”)。对于新输入进行分类,只需要网络的前馈层,而这些层没有门控。

第四个修改,重放以前学习的类的表示,在内部或“隐藏级别”重放它们(图 7d;参见“方法”)。而不是像之前那样,将生成的图像与对应的标签重新训练。这么做能够减少运算量。之所以能够这样做,是由于最初的特征提取,不论何种任务都是相同的。

Evaluating brain-inspired replay.评估脑启发重放

具有 100个permuted MNIST protoco协议上,我们发现BI-R优于 SI已经很强的性能(图 5b)。将BI-R与 SI相结合,将性能推得更高,当测试时任务标识信息不可用时,在此基准测试中实现最先进的性能。

图5

在split CIFAR-100协议上,我们的大脑启发的修改也大大提高了 GR的性能。在 Task-IL 场景中,BI-R几乎完全缓解了灾难性遗忘,并优于 EWC、SI 和 LwF(图 6b)。在 Class-IL 场景中,BI-R也优于其他方法,尽管它的性能仍然大大低于迄今为止所有类的数据进行训练的“上限”(图 6c)。

最后,对于排列的 MNIST,将BI-R与 SI相结合,再次显着提高了性能,进一步缩小了(Joint)联合训练上限的差距(图 6c)。

Lesion experiments. 损伤实验

为了深入了解我们大脑启发的重放方法的各个组成部分的贡献,我们进行了

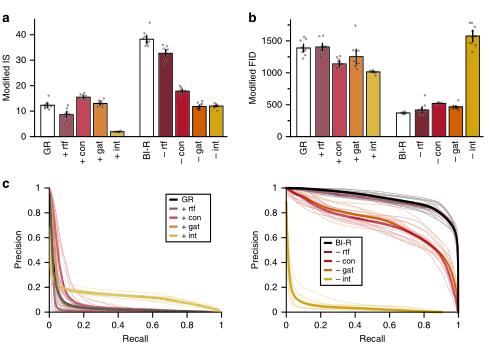

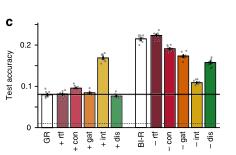

一系列添加和消融实验(图 8)[消融实验]

内部重放似乎是影响最大的修改,因为引入或删除该组件对性能的影响最大,而且不同的修改是相互补充的。对于permuted MNIST (图8a) CIFAR-100上的 Class-IL场景(图 8c),将所有组件组合在一起获得的性能增益大于单独添加每个组件的效果之和。特别是条件重放和基于内部上下文的门控的好处取决于它们与其他组件的组合。

对于 CIFAR-100上的 MNIST和 Class-IL,没有一个单独的修改足以实现大脑启发的重放的性能,而所有这些修改-除了 RtF(通过反馈进行重放)之外-都是必要的。RtF的贡献在于它提高了效率

(即,消除了对单独的生成模型的需求),而不会严重损害性能。

尽管当BI-R与SI结合使用时,消融 RtF确实略微降低了平均准确度(置换 MNIST:0.904±0.005对 0.892±0.004;CIFAR-100上的 IL级:0.344±0.002对 0.334±0.002),因此 RtF实际上获得了最佳的整体性能。

最后,CIFAR-100上的 Task IL场景(图8b)不需要任何单个组件,这反映出在这种场景中防止灾难性遗忘要简单得多。

图8

a.具有 100个排列的排列 MNIST b.为 CIFAR-100上的Task-IL场景,c为 CIFAR-100上的Class-IL场景

内部重放(int重放)没有用于排列 MNIST,因为该 protocol没有使用卷积层。

每个条反映了 5次(排列 MNIST)或 10次(CIFAR-100)重复的平均值,误差条为±1 SEM,单个重复用点表示。

灰色虚线表示机会水平。当基础网络仅在最终任务/片段上训练时(平均超过 5或 10次重复,阴影区域为±1 SEM)时,黑色实线表示性能,这可以解释为除上次看到的数据之外的所有数据的机会性能。

rtf 通过反馈重放、con 条件重放、gat基于内部上下文的 门控、int 内部重放、dis蒸馏。

Quality of generated replay. 生成的重放质量

为了更好地理解为什么脑启发的重放效果如此好,我们开始比较不同修改后的生成器的质量。

我们询问了在内部重放而不是像素级别重放表示是否提高了生成的样本的质量。为了公平地比较在不同水平上生成的样本,首先必须将它们转换为公共嵌入空间。计算用于评估生成模型的最新度量的第一步是将样本嵌入到不同的特征空间中。

评估生成模型的最新度量(如 Inception Score 初始分数(IS)、Fréchet Inception Distance Fréchet初始距离(FID) 和 Precision & Recall curves精度与召回曲线)

对于 CIFAR-100上的 Class-IL场景,我们改进的 IS(图 9a)和改进的 FID(图9b)测量都表明,通过BI-R方法重放的样本确实比标准 GR重放的样本更好。

图9生成的样品的质量和多样性

a我们修改后的初始评分(修改后的 IS)。越高意味着样品越多

。b 我们修改后的 Frechet Inception Distance初始距离(修改后的 FID)。更低意味着更好的样本。

与图 8c中的结果一致,这种改进在很大程度上是由于在内部重放而不是像素级别重放。这两个度量值仅使用单个数字量化生成器性能;它们不区分样品质量和样品多样性。

为了检验生成样本中观察到的改进是否主要是由更好的质量或更好的多样性驱动的,图 9c报告了我们版本的准确率和召回率曲线。这些曲线表明,我们的改进在质量和所生成样本的多样性方面都取得了相似的改善。

Discussion.讨论

这些方法对于必须以增量方式学习任务的场景是成功的,但它们无法以增量方式学习新类.只有另一种受神经科学启发的方法,重放代表以前观察的例子,被发现能够解决 Class IL问题。重要的是,这种重放不需要依赖存储的数据,因为可以生成要重放的样本。``这种重放不需要依赖存储的数据,因为可以生成要重放的样本。

我们发现,重放低质量的样品或在每个小批次中只放一个重放样品就足够了,这进一步加强了重放的必要性。然而,事实证明,GR的直接实现对于更具挑战性的问题来说是行不通的(例如,以自然图像作为输入)。

为了解决这个问题 ,我们从大脑中获得灵感,提出了一系列简单、易于实施且高效的修改,我们证明了这些修改可以使 GR成功地扩展到具有许多任务或复杂输入的问题。

- 虽然分类确实是最终目标,但我们也表明,

GR有助于逐步学习生成模型,并且我们的大脑启发的修改提高了学习生成模型的质量。

但是,应该注意的是,在半监督或无监督设置中,需要修改条件重放和基于内部上下文组件的门控,因为它们的当前实现取决于训练期间类标签的可用性。也可以改为以其他上下文信息为条件。 - 关于输入模式,虽然本研究中确实只报告了基于图像的实验,但大多数结果和建议的方法应该扩展到其他模式.MNIST的实验中没有一个使用了专门用于图像的工具。

内部重放依赖于预先训练的卷积层。

与大脑中独立的感觉处理区域类似,其他输入模式需要不同的预处理层,而内部重放表征是否适用于这些预处理层还有待确认。

内部回放的另一个缺点是,严格的、预先训练的卷积层可能限制了模型学习非分布输入(例如,没有自然图像统计的图像)的能力,尽管在某种程度上这对大脑也是如此。 - 持续学习的表现仅通过迄今为止所见的所有任务或类的平均准确率来量化,这是一个反映遭受灾难性遗忘程度的衡量标准的主要方法。

在 task - IL中,灾难性遗忘可以通过简单地为每个要学习的任务训练不同的网络来预防.对于 Class IL,防止灾难性的遗忘仍然是一个未解决的问题,这证明了我们关注平均准确度测量是正确的。

本研究首次证明重放可能确实是大脑对抗灾难性遗忘的一种可行方法.但重放是否可以扩展到更复杂的现实世界问题,而不必依赖生物学上不可信的机制(如显式存储过去的观察结果),这仍然是一个悬而未决的问题。我们假设大脑中的回放是一个生成过程.

Parisi等人提出了一种最近的持续学习方法,该方法结合了这种序列回放。他们的方法在概念上与我们的内部重放组件有一些相似之处,因为他们还使用预先训练的卷积层作为特征提取器,并且他们重放网络嵌入,而不是像素级的图像。

然而,一个重要的区别是,他们的方法没有学习一个显式的生成模型来生成这些嵌入,而是使用一个循环的自组织网络来存储它们。这种方法的一个缺点是,它依赖于为每一个新的体验生长新的神经元,这使人怀疑他们的方法是否可以扩展到这里考虑的协议。

为什么 GR对 Class IL比基于正则化的方法(如 EWC和SI)更有效,答案可能与这些不同的方法如何存储和维护以前遇到的类的内存有关.

基于正则化的方法完全在网络的参数空间中存储和维护以前类的记忆,因为它们唯一的工具是改变参数的可塑性。特别是对于 Class-IL,因

为未来的类是什么样子是未知的。Task - IL存储的记忆更简单,因为当时只需要记住对学习的特定任务重要的特性。

尽管我们发现当前基于正则化的方法无法单独解决 Class IL问题,但它们与 GR结合时确实提供了独特的贡献.

对于 GR来说,挑战在于学习一个生成网络,该网络能够充分捕捉之前任务/类的本质;

而对于基于正则化的方法来说,挑战在于正确分配网络参数的可信度。

这表明正则化(或元可塑性)和重放是互补的机制,这与经验观察相一致,即大脑同时使用两种策略来保护其记忆——大致分别对应于细胞和系统整合。

Methods.方法

Task protocols.

对于split MINIST:将 MNIST数据集分成 5个任务或片段,每个任务/片段

包含两个数字,使用原始的 28×28像素灰度图像

对于perm MNIST:原始 MNIST图像首先被零填充到 32×32像素

对于 split CIFAR-100:将 CIFAR-100数据集划分为 10个任务或片段,这样每个任务/片

段由 10个类组成。

Network architecture网络架构

对于split MNIST,这是一个完全连接的网络,有两个隐藏层,每个层有 400个节点,

还有一个 softmax输出层。所有隐藏节点都使用了 ReLU非线性。

对于perm MNIST使用了相同的网络体系结构,但每个隐藏层有 2000个节点,与参考文献 31中类似。

对于 split CIFAR-100,基本神经网络架构由五个预先训练的卷积层(见下文)组成,然后是两个全连接层,每个层包含 2000个具有 ReLU非线性的节点和一个softmax输出。