人工神经网络持续学习的脑激励重放

目录

- Brain-inspired replay for continual learning with artificial neural networks

-

- 1、比较连续学习方法

-

- 1.1 对比方法:(Task-IL & Class-IL)

- 2、GR的效率&稳健性

-

- 2.1 重放样本数探究

- 2.2 重放样本质量探究

- 2.3 重置参数影响

- 3、困难问题扩展

-

- 3.1 permuted数据集上表现不佳

- 3.2 更复杂的输入数据CIFAR-100

- 4、Brain-inspired modifications to GR

-

- 4.1 优化1:Replay through Feedback(RtF)

- 4.2 优化2:Conditional replay

- 4.3 优化3: Gating based on internal context

- 4.4 优化4:Internal replay

- 4.5 优化Plus:Distillation蒸馏

- 5、Evaluating BI-R

- 6、Addition- and Ablation-experiments(各方法的effection)

- 7、Replay的质量

-

- 7.1 如何评估Replay

- 7.2 Replay的质量or多样性起作用

- 8、Methods

-

- 8.1 数据集(Task场景)

- 8.2 网络结构

- 8.3 输出单元output units

- 8.4 Training

- 8.5 main model for GR

- 8.6 generator for GR

- 8.7 生成一个重放样本

- 8.8 蒸馏Distillation

- 8.9 RtF

- 8.10 Conditional replay

- 8.11 Gating based on internal context.

- 8.12 Internal replay

- 8.13 Measures for evaluating generator performance

Brain-inspired replay for continual learning with artificial neural networks

作者:Gido M. van de Ven, Hava T. Siegelmann, Andreas S. Tolias

solution1:不断学习以前的例子(效率低)

solution2:以前学习的神经网络模型生成重放数据

task-incremental learning (Task-IL):任务增量学习,需要人为创造场景,区分特定的类别。先区分猫狗和牛羊,再区分猫和羊。

class-incremental learning (Class-IL) :类别增量学习,区分不同学习阶段中的类别。(区分动物失败了)

本文目的:首先确认replay对Class-IL的重要性。在MNIST数据集上的实验,突出了重放的惊人效率和鲁棒性:重放几个或低质量的样本已经足够了。然而,我们也发现将GR扩展到更复杂的问题并不简单。为了解决这个问题,我们提出了一种新的GR变体,其中内部或隐藏的表示被重放,这些表示是由网络自己的、上下文调制的反馈连接生成的。

1、比较连续学习方法

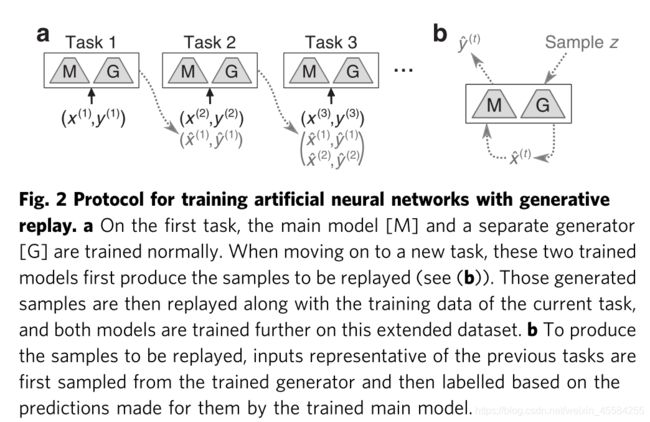

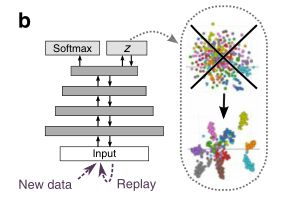

GR模型:一个主模型作为分类器,一个单独的生成模型来生成要replay的数据,使用标准的可变自动编码器(VAE)作为generator。VAE如下图。(即生成许多生成样本)

GR模型如下:

1.1 对比方法:(Task-IL & Class-IL)

- EWC:elastic weight consolidation,在需要被保持的任务上,选择性地降低它们的重要权值的学习率。参考EWC

- SI:synaptic intelligence,类似EWC

- LwF:learning without forgetting,先用θs卷积层和全连接层的共享参数和θo先前学习的任务的特定参数训练θn新任务的特定参数。至收敛,再联合优化θo,θs,θn至收敛。参考LwF。replay current task的x,用上一步训练的模型打soft target,然后一起训练。参考Methods。

- XdG:context-dependent gating (only for Task-IL)为了减少任务之间的干扰,该方法为每个任务选一个不同的随机选择的网络节点子集。XdG的一个限制是它假设要执行的特定任务总是已知的,这意味着这种方法不能用于Class-IL。

- None(下限):在每个新任务中用标准方法微调模型

- Joint(上限):用所有任务数据训练模型

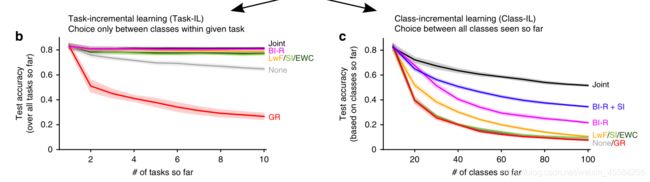

Task-IL:分为5个task,每个task进行二分类

Class-IL:直接十分类(LwF,EWC,SI failed)

split MINST:按顺序排列的MINST

2、GR的效率&稳健性

2.1 重放样本数探究

每一次迭代都是基于128个当前样本和128个重放样本的小批量(在之前的任务中划分)。表明GR不是对所有先前的样本再训练。

为了测试重放的数量是否可以进一步减少,我们运行了额外的实验。改变每个小批量的重放样本的数量。我们发现GR的性能相对稳健(图4a中的红线):即使每个小批量只有一个重放样本(即当前任务中每128个样本对应一个重放样本)。

GR在TaskIL场景中的表现也很有竞争力,并且在Class-IL场景中优于所有非重放方法。

2.2 重放样本质量探究

我们改变了用于产生重放的VAE模型中隐藏单元的数量。将VAE的隐藏层减少到只有10个单位会导致低质量的样本(图4c左),但仅适度影响GR的性能(图4b)。

2.3 重置参数影响

重新学习比不忘记难很多。在该实验中,我们在对每个新任务进行训练之前(但在生成要重放的样本之后)重新初始化了网络的参数,因此网络必须从头开始不断地重新学习所有以前的任务(图4a、b中的棕色线条)。在实验中,仅重放几个或低质量的例子确实不足以实现同样强大的性能。

3、困难问题扩展

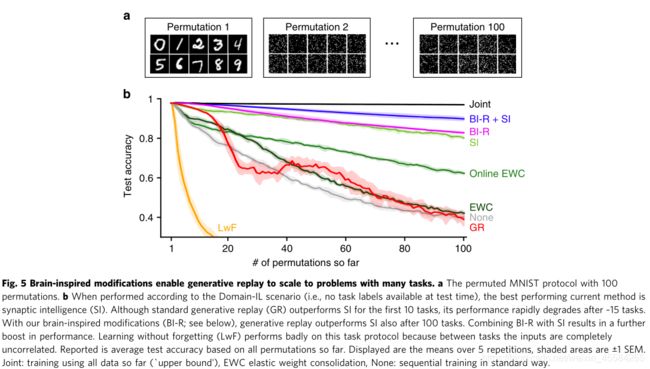

3.1 permuted数据集上表现不佳

permuted MNIST:所有像素被重新排列(图5a)

Domain-IL:域增量学习

模型事先不知道采用10种排列的哪一种。当排列方式数增加,GR表现得不好。

100排列后:SI:82%,online EWC:70%,SI+XdG:95%

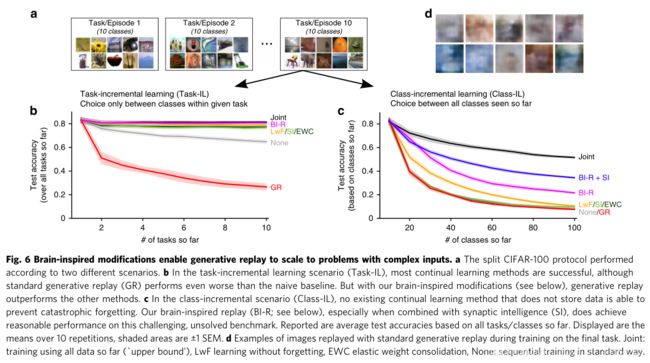

3.2 更复杂的输入数据CIFAR-100

CIFAR-100:分成10个task,每个task中有10个class

难度因场景而异,但在Task-IL和Class-IL中GR表现都不如其他方法。(重放质量过低)

4、Brain-inspired modifications to GR

训练更好的generator,生成高质量replay样本的计算成本过高。

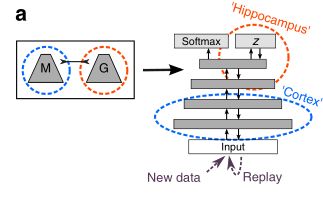

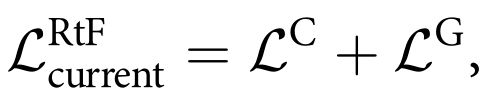

4.1 优化1:Replay through Feedback(RtF)

将VAE(海马体)置于主模型(皮层)顶部,在encoder上增加softmax分类器。

4.2 优化2:Conditional replay

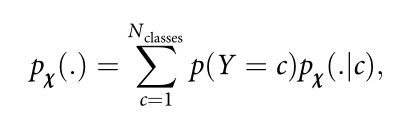

将VAE的标准正态分布替换成高斯混合模型。可以replay指定的类的样本,类内部更好的分离。

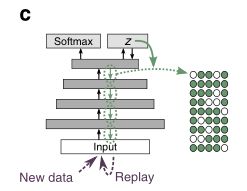

4.3 优化3: Gating based on internal context

根据应该执行的任务,在每个隐藏层中随机选择不同的神经元子集。

4.4 优化4:Internal replay

重放先前学习的类的表示,不是一直重放到输入级别,而是在内部或“隐藏级别”重放它们。

我们在CIFAR-10上预处理了模型的卷积层,与CIFAR-100相比,该数据集包含相似但不重叠的图像。在CIFAR-100上的增量训练期间,这些卷积层被冻结,我们仅通过完全连接的层进行重放。为了公平比较,所有其他方法也使用预训练卷积层用于CIFAR-100实验。

由于split和permuted MNIST没有使用卷积层,所以在这些实验中没有使用预训练和内部重放。

4.5 优化Plus:Distillation蒸馏

我们没有根据主模型将生成的数据标记为最可能的类别(“硬目标”),而是用所有可能类别的预测概率(“软目标”)来标记它们;

5、Evaluating BI-R

6、Addition- and Ablation-experiments(各方法的effection)

- 内部重放似乎是最有影响力的修改,因为引入或删除该组件对性能的影响最大,但我们也发现不同的修改是相辅相成的。

- 对于permuted MNIST(图8a)和CIFAR-100上的Class-IL场景(图8c),通过将所有组件组合在一起获得的性能增益大于单独添加每个组件的效果总和。特别是条件重放和基于内部上下文的门控的好处取决于它们与其他组件的组合。

- 对于permuted MINST和Class-IL的CIFAR-100来说,没有一个单独的修改足以实现大脑启发重放的性能,而除了RtF之外,所有的修改都是必要的。RtF的贡献在于它提高了效率

- CIFAR-100上的Task-IL场景不需要任何单独的组件(图8b)反映了在这种场景中防止灾难性遗忘要容易得多。

7、Replay的质量

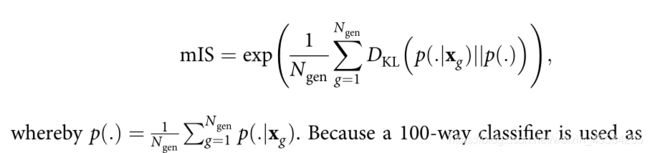

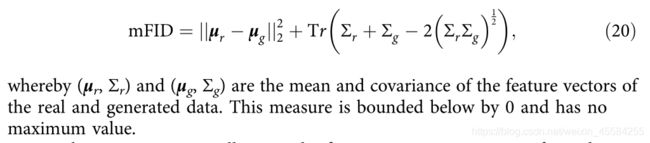

7.1 如何评估Replay

- 为了公平地比较不同级别生成的样本,首先必须将它们转换到一个公共的嵌入空间。

- Inception Score (IS), Fréchet Inception Distance (FID),Precision,Recall,这些度量的原始版本使用Inception Net。

- 将样本嵌入到特征空间中,但是我们生成的内部表示不能被馈送到Inception Net中。因此,我们用不同的神经网络取代了初始网络,该神经网络具有与增量训练模型相同的预训练卷积,因此像素和内部层次的样本都可以被该网络嵌入。

7.2 Replay的质量or多样性起作用

图9c可以看出在相似程度上提高了生成样本的质量和多样性。曲线向上–Precision,曲线向右–Recall。

8、Methods

8.1 数据集(Task场景)

- split MINST :分为5个task,每个Task是二分类,60000 training,10000 testing

- permuted MINST:100组序列,分为10个task,每个task是十分类,60000 training,10000 testing

- CIFAR-100:色彩归一化,100组序列,分为10个task,每个task是十分类,50000 training,10000 testing

8.2 网络结构

- split MINST :全连接网络,2个隐藏层有400 nodes,隐藏节点使用ReLU函数,softmax输出层。

- permuted MINST:全连接网络,2个隐藏层有2000 nodes,隐藏节点使用ReLU函数,softmax输出层。

- CIFAR-100:用CIFAR-10预训练的5个卷积层,2个全连接层2000 nodes,隐藏节点使用ReLU函数,softmax输出层。

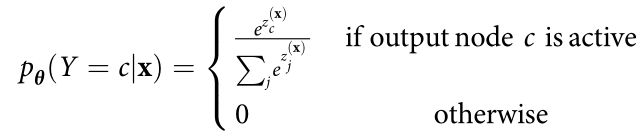

8.3 输出单元output units

- Task-IL:只有当前task中的类输出单元是active

- Class-IL:所有类的输出单元active

- Domain-IL(permuted MINST):输出层每个数字有一个单元(即有10个输出单位),所有输出单元active

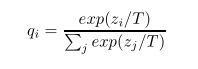

softmax输出层执行的标准化只考虑活动节点。也就是说,由神经网络预测的输入x属于c类的条件概率被计算为:( zc(x)是c类的非标准化概率,分母是所有活动神经元概率和)

8.4 Training

网络参数θ 用 mini-batch 梯度下降方法获得。

特定任务的损失Ltotal使用当前任务的multi-class cross-entropy classification loss 表示:

对每个任务进行2000次(split MNIST和permuted MNIST)或5000次(split CIFAR-100)迭代训练,学习率为0.001(split MNIST)或0.0001(permuted MNIST和split CIFAR-100)。小批量大小被设置为128(split MNIST)或256(permuted MNIST和split CIFAR-100),这意味着在每次迭代中,当前被计算为当前任务中许多样本的平均值。如果使用重播,则使用相同数量的重播样本来计算Lreplay

8.5 main model for GR

Ntasks-so-far为模型到目前为止遇到的tasks数

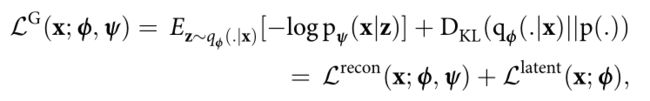

8.6 generator for GR

-

网络结构

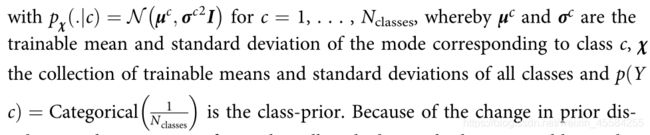

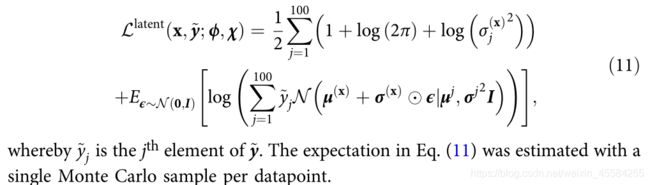

encoder和decoder都是具有两个隐藏层的完全连接的网络,这两个隐藏层包含400(split MNIST)或2000(permuted MNIST)个具有ReLU非线性的单元;对于split CIFAR-100,编码器由五个预先训练的卷积层组成,后面是两个包含2000个ReLU单元的全连接层,解码器由两个包含2000个ReLU单元的全连接层组成,后面是五个去卷积或转置卷积层。随机潜变量层z总是具有100个高斯单位(参数为平均值μ(x)和标准偏差σ(x),是encoder网络qϕ输入x的输出),并且先验是标准正态分布。 -

损失函数

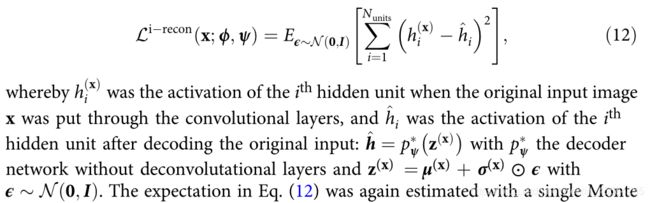

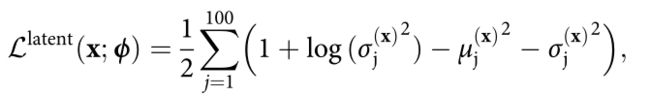

训练VAE的网络参数ϕ与ψ,通过最小化输入x的样本loss:

这是潜在变量z的后验分布:

这是潜在变量z的先验分布:

DKL表示KL散度,在信息论中,相对熵等价于两个概率分布的信息熵的差值,若其中一个概率分布为真实分布,另一个为理论(拟合)分布,则此时相对熵等于交叉熵与真实分布的信息熵之差,表示使用理论分布拟合真实分布时产生的信息损耗 :

潜在变量正则化项Llatent可以计算:

为了简化重构项Lrecon,我们使解码器网络pψ的输出确定,这是VAE常见的修改。我们将重建项重新定义为原始像素值和解码像素值之间的预期二进制交叉熵:

z(x)的替换叫做’ reparameterization trick ’重新参数化技巧,使得Lrecon的Monte Carlo estimate估计对ϕ可微。

为了训练生成器,使用了与训练主模型相同的超参数(即学习率、优化器、迭代、批量)。与主模型相似,生成器也是用重放训练的。

8.7 生成一个重放样本

从潜在变量z采样,main model标记replay的label。

- 任务T需要的replay在T-1之后生成:可以保持两个model副本,或者下个任务前sample都生成好

- 标签生成要看哪些输出单元active:Task-IL要重放的任务的类的输出单元是活动的,从先前的任务中随机选择,Class-IL场景中,直到先前学习的任务的类的输出单元是活动的。在Domain-IL场景中,总是所有输出单元都是活动的。

8.8 蒸馏Distillation

给replay样本打软标签(vector属于各类的概率),temperature T越高,标签越平滑(softer),在softmax是z(x)=z(x)/T,θ是T-1结束后的参数。

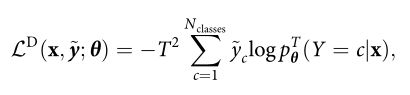

标准loss不能计算软标签,所以最小化当前模型的预测概率和软标签的交叉熵。

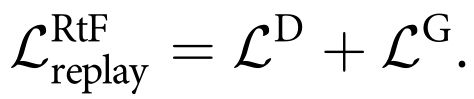

8.9 RtF

LC分类交叉熵,LG生成loss,LD蒸馏loss,以下为当前任务loss和重放数据loss。

8.10 Conditional replay

生成特定类的replay

hard target closed-form

soft target rewritten:

8.11 Gating based on internal context.

每个隐藏层有x%的节点被激活,每个task或者class都有一个mask,生成特定类的replay就使用对应的mask,否则就随机选一个mask

8.12 Internal replay

仅针对于有卷积层的CIFAR-100,卷积层为预训练的。

生成部分的重建loss:the expected squared error between the hidden activations of the original input and the corresponding hidden activations after decoding: