半监督目标检测(三)

目录

ISMT

动机

1. Overview

2. Pseudo Labels Fusion

3. Interactive Self-Training

4. Mean Teacher

Unbiased Teacher

动机

1. Overview

2. Burn-In

3. Teacher-Student Mutual Learning

4. Bias in Pseudo-Label

ISMT

Interactive Self-Training with Mean Teachers for Semi-supervised Object Detection

动机

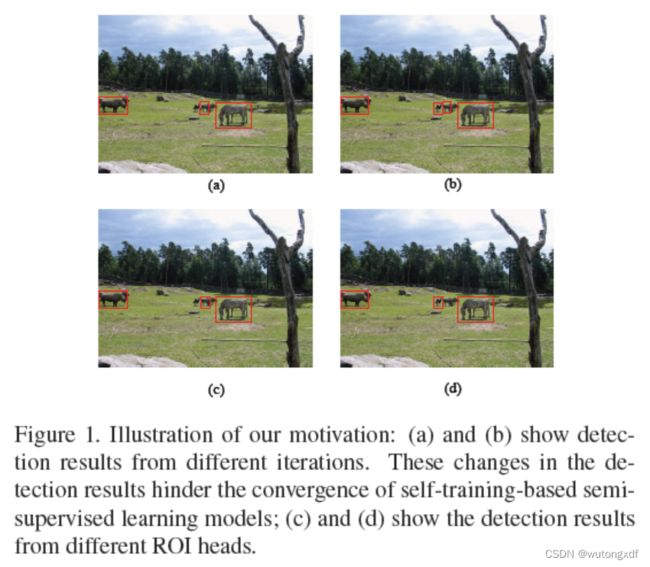

1. 此前 semi-supervised object detection (SSOD) 的方法都忽略了一个问题:对于同一张图像,不同的训练迭代次数所产生的检测结果存在差异;

2. 不同的模型对同一张图像的检测结果不同。

1. Overview

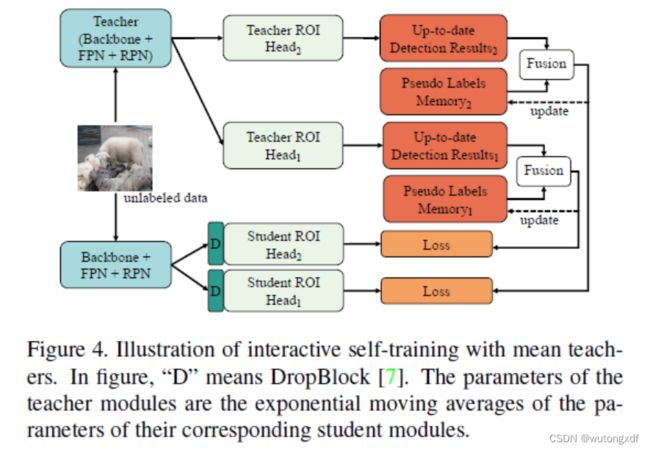

为改善上述问题,作者提出 interactive self-training with mean teachers (ISMT):

首先,作者使用带标签数据预训练监督模型(拥有两个检测头部 ROI Heads 的 Faster R-CNN),并利用这个预训练模型在无标签数据上生成原始的伪标签,以此为基础构成 Pseudo Labels Memory。

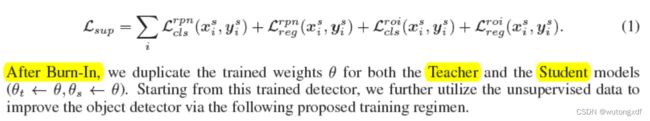

在半监督训练阶段,作者用预训练参数初始化模型,并使用带标签数据和无标签数据共同作为输入训练模型。对于带标注数据,损失函数与监督学习相同。而对于未标注数据,作者采用 ISTM 方法。即利用 Pseudo Labels Memory 和非极大值抑制(NMS)融合不同迭代次数产生的检测结果。此外,对于两个不同结构的 ROI Heads 使用 mean teacher 方法,每一个 teacher ROI head 由相应的 student ROI head 使用指数移动平均(EMA)得到,并且为当前 batch 的未标注数据生成最新的检测结果。然后,使用 NMS 将该检测结果与 Pseudo Labels Memory 中同一张图片的相应历史伪标注融合,得到最终的伪标签。对于每一个 student ROI head,使用的伪标签分别融合自另一个 teacher head。

最终损失函数如下:

其中,γ 为非监督损失的权重。

2. Pseudo Labels Fusion

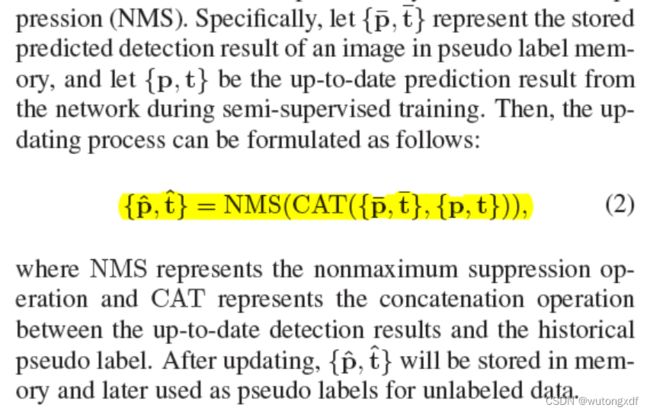

为解决不同训练迭代次数产生的检测结果不稳定的问题,作者设置了 Pseudo Labels Memory 存储历史伪标签,使用 NMS 将历史伪标注与最新的检测结果进行融合和更新。

3. Interactive Self-Training

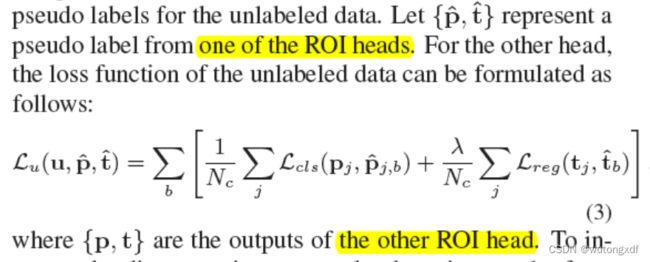

未缓解 self-training 可能产生的过拟合问题,作者首先使用带标签的数据训练带有两个不同结构 ROI Heads 的检测模型,之后再分别用它们在无标签数据上生成伪标签。两个 ROI Heads 可以互相为对方提供有用的互补信息。

另外,作者使用 DropBlock 模块确保不同的 ROI Head 能够获得不同的关键信息,增加两个 ROI Heads 检测结果的差异性。

4. Mean Teacher

为了避免两个 ROI Heads 互相模仿,从而无法独立收敛,同时也为了保证产生的伪标签的稳定性,作者引入了 mean teacher 方法,即教师参数是相应学生参数的移动平均。

如上图,“Teacher ROI Head 1” 是 “Student ROI Head 1” 的指数移动平均(EMA),它为“Student ROI Head 2” 提供伪标签;随后,最新的检测结果将与历史伪标注融合。

Unbiased Teacher

Unbiased Teacher for Semi-Supervised Object Detection

动机

针对此前的半监督目标检测(SSOD)任务,作者主要关注的问题是:

目标检测领域所固有的类别不平衡问题,使得在半监督学习(SSL)情境下训练出的模型做出的预测往往是 biased,而 SSOD 领域普遍采用的伪标签方法进一步加剧了这一问题;此外,在标签数据不足时,目标检测任务往往存在严重的过拟合问题,如 RPN 前景和背景的分类,ROIhead 的多类别分类(不包括预测框回归)。

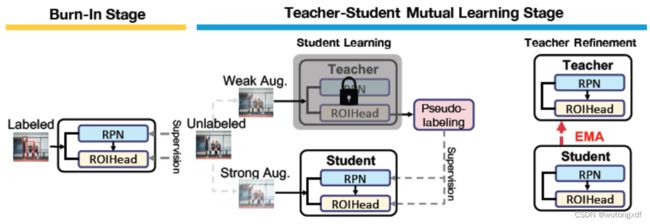

1. Overview

与此前的 SSOD 模型相似,Unbiased Teacher 也使用带 FPN 的 Faster R-CNN,以Res-Net 50 作为主干网络。

模型主要分为两个阶段:

1) Burn-In Stage

使用监督数据进行预训练,初始化模型。

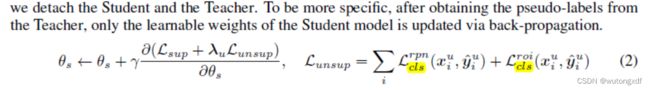

2)Teacher-Student Mutual Learning Stage

使用教师-学生训练模式,首先将初始化参数分别复制给教师模型和学生模型。

Student Learning:利用教师模型生成伪标签,在此基础上训练学生。教师模型的数据采用弱增强,学生模型的数据采用强增强;

Teacher Refinement:使用学生模型参数的指数移动平均(EMA)更新教师模型,稳定地提升伪标签质量。

2. Burn-In

使用带标签数据对模型进行预训练。

3. Teacher-Student Mutual Learning

作者使用的是比较典型的 mean teacher 方法,即采用教师-学生模型共同训练的方式,以及强-弱增强方法,弱增强数据(random horizontal flip)输入教师模型用于生成伪标签,强增强(randomly add color jittering, grayscale, Gaussian blur, and cutout patches)用于训练学生模型。在此基础上,使用学生模型参数的 EMA 更新教师模型,以稳定提升伪标签质量。

比较不同的是,作者认为用以筛选伪标签的置信度阈值只与预测目标的分类有关,而与预测框位置的质量无关,所以作者不对无标签数据计算预测框回归损失,只计算分类损失。

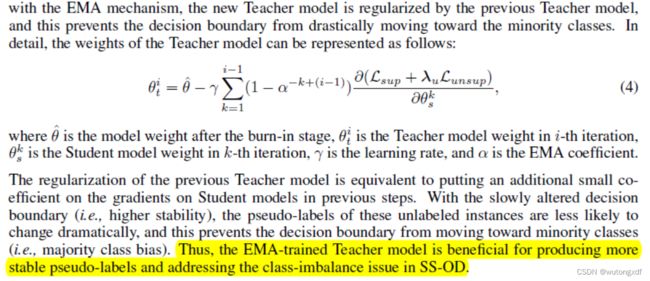

4. Bias in Pseudo-Label

为解决 SSOD 存在的类别不平衡问题,作者将 交叉熵损失 替换为 多类别 Focal Loss,用于优化ROIhead 的分类损失,使得模型可以专注于稀有类别和难例样本。

此外,作者认为, EMA 训练所具有的 “conservative property” 也有助于改善类别不平衡问题:

参考资料:半监督目标检测(Semi-Supervised Object Detection,SSOD)相关方法介绍 - 知乎

半监督目标检测研究进展 - 知乎