Blended Diffusion for Text-driven Editing of Natural Images(CVPR 2022)

1.Blended Diffusion for Text-driven Editing of Natural Images.

混合扩散:用于自然图像的文本驱动编辑.

机构:Hebrew University of Jerusalem

2.github:https : / / omriavrahami . com /blended-diffusion-page/

3.介绍:

文本驱动的对象/背景替换: 给定输入图像和遮罩,我们根据引导文本提示修改遮罩区域,而不会影响未遮罩区域。

4.Abstract

我们通过利用并结合预先训练的语言图像模型 (CLIP) 来实现我们的目标,以引导编辑朝着用户提供的文本提示,并使用去噪扩散概率模型 (DDPM) 来生成自然外观的结果。为了无缝地将编辑区域与图像的未更改部分融合在一起,我们在空间上将输入图像的噪声版本与潜在的局部文本引导扩散混合在一起。

5.Denoising Diffusion Probabilistic Models:

我们的方法使用预训练的 DDPM 和 CLIP 模型,不需要额外的训练。

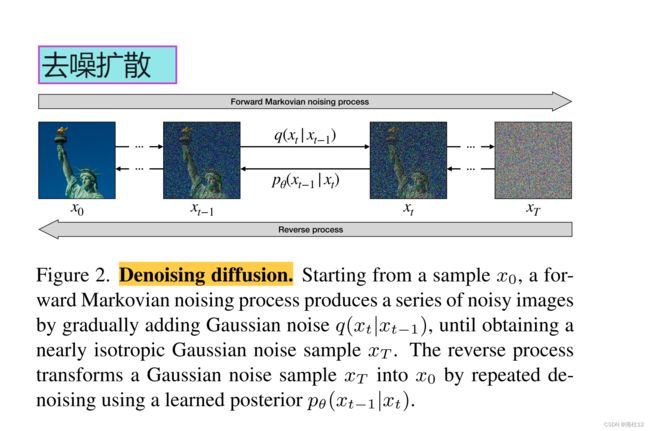

去噪扩散。从样本x0开始,正向马尔可夫噪声过程通过逐渐添加高斯噪声q(xt | xT-1),直到获得几乎各向同性的高斯噪声样本xt,从而产生一系列噪声图像。反向过程通过使用学习的后验p θ (xT − 1 | xt) 重复去噪,将高斯噪声样本xT转换为x0

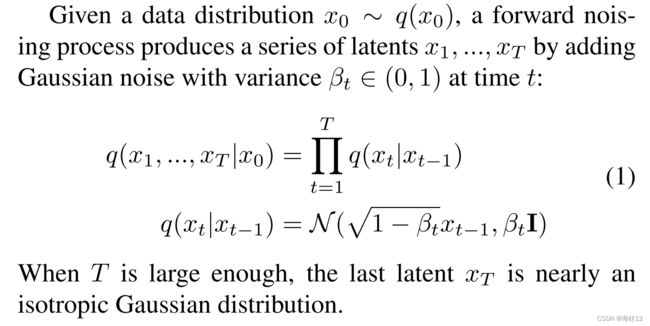

1.正向过程:

2.获得任意步骤的噪声。

正向噪声过程的一个重要特性是,可以直接从x0中采样任何步骤xt,而无需生成中间步骤

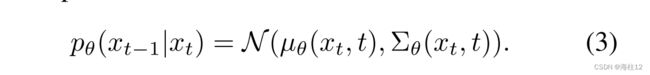

要从分布 q(x0) 中抽取新样本,需逆马尔可夫过程。也就是说,从高斯噪声样本 xT ∼ N(0, I) 开始,通过对后验 q(xt−1|xt) 进行采样生成反向序列,这也被证明是高斯分布

但是,q(xt − 1 | xt) 是未知的,因为它取决于未知的数据分布q(x0)。为了近似此函数,对深度神经网络p θ 进行了训练,以在给定xt作为输入的情况下预测xt-1的均值和协方差。然后,5月1日从这些参数定义的正态分布中采样xt −1 ,

,

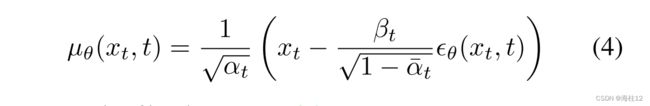

并不是直接推断 µ θ(xt,t),而是提出根据式 (2),预测加入到x0中以获得xt的噪声的 ϵθ(xt, t)。然后可以使用贝叶斯定理导出 µ θ(xt,t)

6.method

Local CLIP-guided diffusion

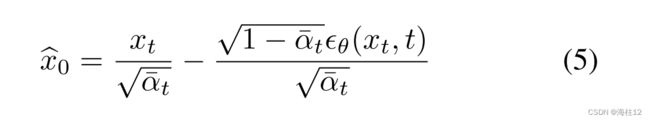

因不能在有噪声的图像重新训练CLIP所以引入噪声转换的概念,把有噪声的图像转为干净的图像。

原始图像X0和马尔科夫噪声图像的相互转换

上式由等式2变形而来。

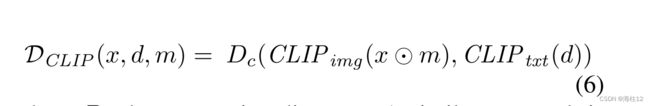

现在,基于 CLIP 的损失 DCLIP 可以定义为文本提示的 CLIP 嵌入与估计的干净图像 bx0 的嵌入之间的余弦距离。

x输入图像,d为文本输入,m为掩蔽区域

其中 Dc 表示余弦距离。在 CLIP 引导扩散 中使用了类似的方法,其中 ![]() 和

和 ![]() 的线性组合用于为扩散提供全局引导。通过仅考虑输入掩码下的

的线性组合用于为扩散提供全局引导。通过仅考虑输入掩码下的 ![]() 梯度,可以在本地进行引导。以这种方式,我们有效地使 CLIP 引导的扩散 适应本地(基于区域的)编辑设置。

梯度,可以在本地进行引导。以这种方式,我们有效地使 CLIP 引导的扩散 适应本地(基于区域的)编辑设置。

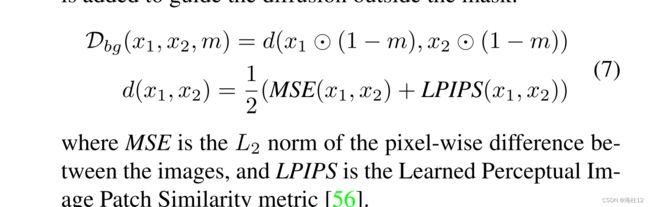

上述过程从各向同性高斯噪声开始,没有背景约束。因此,虽然 ![]() 是在掩蔽区域内评估的,但它会影响整个图像。为了将周围区域转向输入图像,添加了背景保存损失 Dbg 以引导掩膜外的扩散。

是在掩蔽区域内评估的,但它会影响整个图像。为了将周围区域转向输入图像,添加了背景保存损失 Dbg 以引导掩膜外的扩散。

MSE为两图像像素级差异,LPIPS为相似度度量函数

在局部夹导扩散中的作用。给定带有遮罩的输入图像,并提示 “a dog”: 在 λ 设置得太低 (λ = 100) 的情况下,整个图像完全改变,而如果 λ 太高 (λ = 10000),模型无法更改前景 (并且背景保存不完美)。使用中间值 (λ = 1000),模型在类似于原始背景的同时更改前景

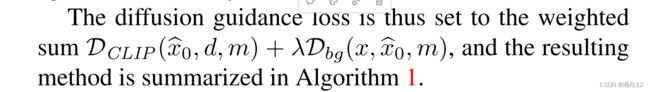

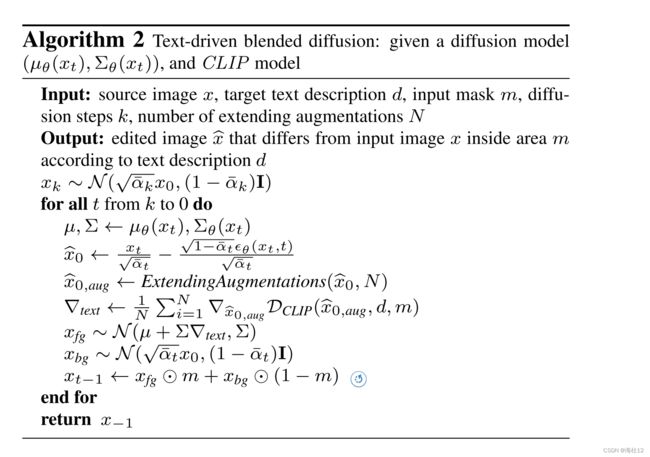

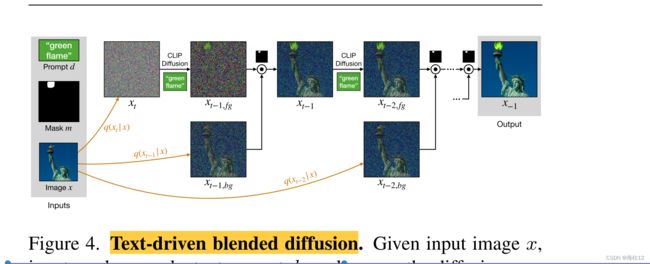

Text-driven blended diffusion

前向噪声过程隐式定义了图像流形的级数,其中每个流形均由噪声较大的图像组成。反向,去噪扩散过程的每一步,都将嘈杂的图像投影到下一个噪声较小的流形上。为了创建无缝结果,其中掩蔽区域符合引导提示,而图像的其余部分与原始输入相同,我们在空间上将剪辑引导过程逐步生成的每个噪声图像与相应的噪声版本混合输入图像。我们的主要见解是,尽管在此过程中的每个步骤中,混合两个嘈杂图像的结果都不能保证是相干的,但在每个混合之后的去噪扩散步骤通过投影到下一个流形上来恢复相干性。该过程如图4所示,并在算法2中进行了总结。

图4。文本驱动的混合扩散。给定输入图像x,输入掩码m和文本提示d,我们利用扩散过程来局部且连贯地编辑图像。我们用 ⊙ 表示使用输入掩码m的两个图像的元素混合。

7.Results 可视化

8.Conclusions

我们针对自然图像的文本驱动编辑问题引入了一种新颖的解决方案,并展示了其优于基线的优势。我们相信使用自由文本编辑自然图像是一种高度直观的交互,它将进一步发展到一定程度,使其成为每个内容创作者不可或缺的工具。