动手学深度学习——多层感知机从零开始实现及简洁实现

多层感知机从零开始实现

#首先需要导入需要的包

import torch

import numpy as np

import sys

sys.path.append("..")

import d2lzh_pytorch as d2l

"""

1、获取数据

使用FashionMNIST数据集,使用多层感知机对图像开始分类

"""

batch_size=256 #批量大小设置为256,也就是每次读取256张图片

train_iter,test_iter =d2l.load_data_fashion_mnist(batch_size)

#设置一个训练集和测试集的迭代器

"""

2、定义模型参数

在softmax回归从零开始中,提到Fashion-MNIST数据集中的图像形状为28x28,类别数为10.

本节依然使用长度为28x28=784的向量表示每一张图像。

"""

num_inputs,num_outputs,num_hiddens=784,10,256

#输入个数784,输出个数10个,超参数隐藏单元个数256

W1=torch.tensor(np.random.normal(0,0.01,(num_inputs,num_hiddens)),dtype=torch.float)

#权重W1初始化为高斯随机分布的一个值,均值为0,方差为0.01,输入层

b1=torch.zeros(num_hiddens,dtype=torch.float)

#偏差b1就是隐藏层的个数,定义数据类型

W2=torch.tensor(np.random.normal(0,0.1,(num_hiddens,num_outputs)),dtype=torch.float)

#权重W2初始化为高斯随机分布的一个值,均值为0,方差为0.01,输出层

b2=torch.zeros(num_outputs,dtype=torch.float)

#偏差b2就是长为10的一个向量,定义数据类型

#下面是模型参数梯度,表示每一个权重w和偏差b都需要求梯度

params=[W1,b1,W2,b2]

for param in params:

param.requires_grad_(requires_grad=True)

"""

3、定义激活函数

这里使用ReLU激活函数,使用基础的max函数实现ReLU,而非直接调用

"""

def relu(X):

return torch.max(input=X,other=torch.tensor(0.0))

#将输入给X

"""

4、定义模型

实现上一节中多层感知机的计算表达式

"""

def net(X):

X=X.view((-1,num_inputs))

#使用view函数将每张原始图像改成长度为NUM_inputs的向量

H=relu(torch.matmul(X,W1)+b1) #先做乘法 输入乘以W1在加上b1

return torch.matmul(H,W2)+b2

#第一层的输出和第二层的权重做乘法再加上第二层的偏差

"""

5、定义损失函数

"""

loss =torch.nn.CrossEntropyLoss()

"""

6、训练模型

多层感知机的训练过程和softmax回归的训练过程是一样的

我们直接调⽤ d2lzh_pytorch包中的 train_ch3 函数,

"""

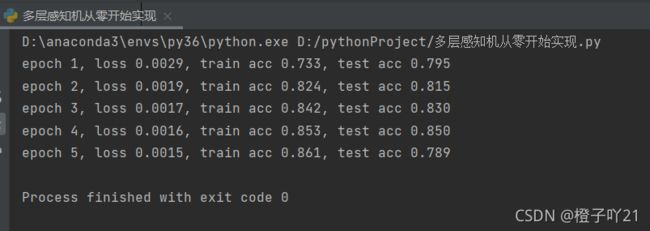

num_epochs,lr=5,100.0 #设置超参数迭代周期为5,学习率为100.0

d2l.train_ch3(net,train_iter,test_iter,loss,num_epochs,batch_size,params,lr)

多层感知机简洁实现

import torch

from torch import nn

from torch.nn import init

import numpy as np

import sys

sys.path.append("..")

import d2lzh_pytorch as d2l

#1、定义模型

#和softmax回归唯⼀的不同在于,我们多加了⼀个全连接层作为隐藏层

num_inputs, num_outputs, num_hiddens = 784, 10, 256

net = nn.Sequential(

d2l.FlattenLayer(),#隐藏层

nn.Linear(num_inputs, num_hiddens), #线性层

nn.ReLU(),

nn.Linear(num_hiddens, num_outputs),

)

for params in net.parameters():

init.normal_(params, mean=0, std=0.01)

#2、读取数据并训练模型

batch_size = 256 #批量大小256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size)

loss = torch.nn.CrossEntropyLoss()

optimizer = torch.optim.SGD(net.parameters(), lr=0.5)

#由于这⾥使⽤的是PyTorch的SGD⽽不是d2lzh_pytorch⾥⾯的sgd,所以就不存在上面那样学习率看起来很⼤的问题了

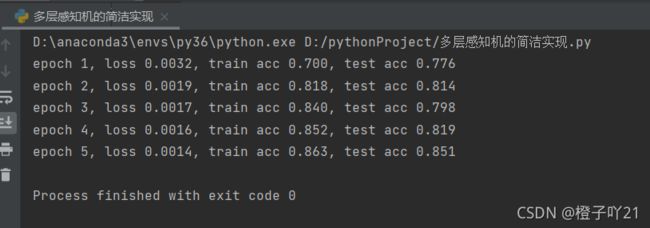

num_epochs = 5

d2l.train_ch3(net, train_iter, test_iter, loss, num_epochs,batch_size, None, None, optimizer)