【11月机器学习】回归

要点:线性模型与非线性模型,模型优化的三个角度

需要进一步理解的地方

简单定义

找到一个这样的函数:输入一些自变量得到一个因变量,其中因变量的数据类型都是数值。

应用

- PM2.5浓度预测(输入:历史PM2.5信息、气象资料;输出:未来某个时间点的PM2.5)

- 股票预测(输入:股票涨跌资料、公司并购信息;输出:明天的点数)

- 无人驾驶(输入:无人车感知信息;输出:驾驶操作)

- 商品推荐(输入:使用者信息,购买商品信息;输出:购买某一个商品的概率)

线性回归模型搭建

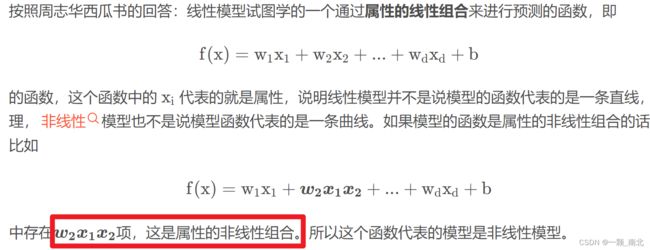

※线性模型&非线性模型

(94条消息) 线性模型和非线性模型的区别_O zil的博客-CSDN博客_线性模型和非线性模型![]() https://blog.csdn.net/weixin_42693876/article/details/117554892

https://blog.csdn.net/weixin_42693876/article/details/117554892

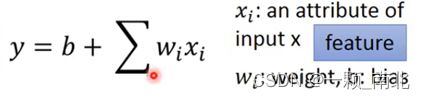

Step 1 建立模型

Step 2 模型评估

评估方式:将真实值和预测值带入某个损失函数,估计模型预测误差。

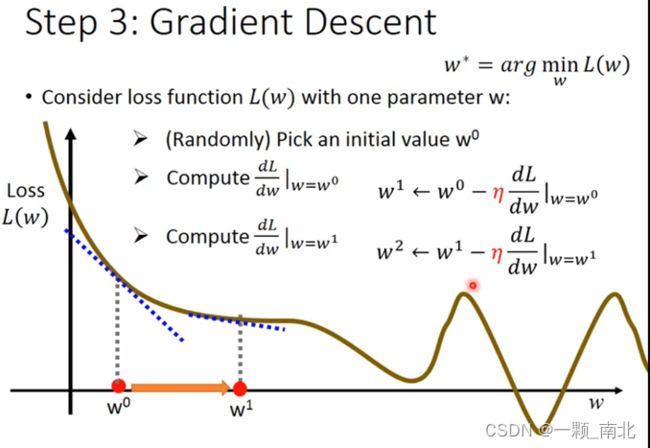

Step 3 梯度下降,更新模型

梯度下降算法用于可微分的函数

在线性回归中“局部最小值”即为“全局最小值”

回归模型优化

从模型角度(Step1)出发

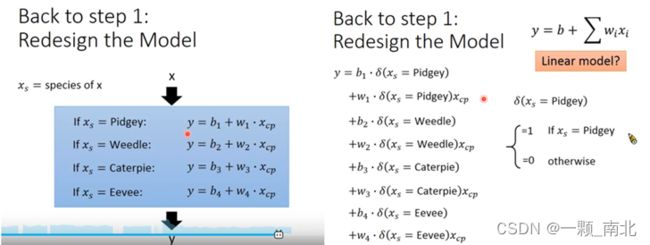

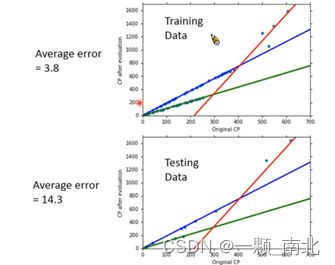

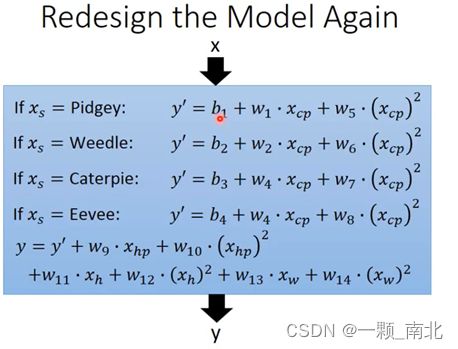

※分类别训练模型

这个是李宏毅老师给出的宝可梦例子一种优化方法。该种方法适用的情形是:自变量中存在非数值数据类型的变量,不同类别的宝可梦进化后的CP值有差异。比如预测男女身高,性别这一自变量就是一种非数值的数据类型。

补充样本特征值

正所谓“打了个信息差”,了解到的信息越多越有利。但过度添加信息也带来冗余,如何筛选有效的特征值,又是另一个研究方向。个人用的比较多的是逐步回归和随机森林的特征重要性排序。

从损失函数角度(Step 2)出发

根据问题选择合适的损失函数

(94条消息) 损失函数(loss function)_iiiLISA的博客-CSDN博客_损失函数![]() https://blog.csdn.net/EmilyHoward/article/details/118367495

https://blog.csdn.net/EmilyHoward/article/details/118367495

常用的损失函数

通常情况下,损失函数的选取应从以下方面考虑:

(1) 选择最能表达数据的主要特征来构建基于距离或基于概率分布度量的特征空间。

(2)选择合理的特征归一化方法,使特征向量转换后仍能保持原来数据的核心内容。

(3)选取合理的损失函数,在实验的基础上,依据损失不断调整模型的参数,使其尽可能实现类别区分。

(4)合理组合不同的损失函数,发挥每个损失函数的优点,使它们能更好地度量样本间的相似性。

(5)将数据的主要特征嵌入损失函数,提升基于特定任务的模型预测精确度。

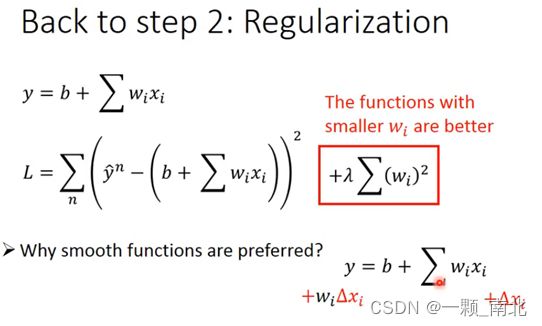

正则化(Regularization)

正则化的目的是尽可能减小参数值,使得函数更加平滑,模型鲁棒性更强。通常用![]() 施以权重。

施以权重。

从正则化上,往往会考虑![]() 的大小以及正则化的方式。

的大小以及正则化的方式。

机器学习必知必会:正则化 - 知乎 (zhihu.com)![]() https://zhuanlan.zhihu.com/p/67931198

https://zhuanlan.zhihu.com/p/67931198

从梯度下降角度(Step 3)出发

※不同的参数使用不同的学习率

4-回归-演示_哔哩哔哩_bilibili![]() https://www.bilibili.com/video/BV1Ht411g7Ef?p=4&vd_source=03ffa2e0d5a752f100d1b1c03f0bc3b1

https://www.bilibili.com/video/BV1Ht411g7Ef?p=4&vd_source=03ffa2e0d5a752f100d1b1c03f0bc3b1

昨天和今天的主要收获在模型优化上,从建立模型的三个步骤对模型进行优化。

2022/11/16 21:23

一文了解回归模型10个重要知识点回归分析为许多机器学习算法提供了坚实的基础。在这篇文章中,我们将总结 10 个重要的回归问题和5个重要的回归问题的评价指标。![]() https://mp.weixin.qq.com/s/RItqExC9m1mO9_dO3ZQr1A关于更本质的回归问题↑

https://mp.weixin.qq.com/s/RItqExC9m1mO9_dO3ZQr1A关于更本质的回归问题↑