JSIS3D:具有多任务点状网络和多值条件随机场的3D点云的联合语义实例分割

论文题目:JSIS3D: Joint Semantic-Instance Segmentation of 3D Point Clouds with Multi-Task Pointwise Networks and Multi-Value Conditional Random Fields

论文链接:https://openaccess.thecvf.com/content_CVPR_2019/papers/Pham_JSIS3D_Joint_Semantic-Instance_Segmentation_of_3D_Point_Clouds_With_Multi-Task_CVPR_2019_paper.pdf

Abstract

深度学习技术已成为大多数与2D图像相关的视觉任务的模型。然而,它们的威力在3D空间中的几个任务上还没有完全发挥出来,例如3D场景理解。在这项工作中,我们共同解决了3D点云的语义和实例分割问题。具体来说,我们开发了一个多任务逐点网络,它同时执行两个任务:预测3D点的语义类并将点嵌入到高维向量中,以便同一对象实例的点由相似的嵌入表示。然后,我们提出了一个多值条件随机场模型,将语义和实例标签结合起来,并将语义和实例分割问题表述为场模型中的联合优化标签。所提出的方法在包括S3DIS和SceneNN在内的不同室内场景数据集上与现有方法进行了彻底的评估和比较。实验结果表明所提出的联合语义实例分割方案在其单个组件上的鲁棒性。我们的方法在语义分割方面也取得了最先进的性能。

1. Introduction

低成本 3D 传感器(例如 Kinect)和光场相机的日益普及开启了许多基于 3D 的应用,例如自动驾驶、机器人技术、基于移动的导航、虚拟现实和 3D 游戏。这一发展还获得了自动理解 3D 数据的能力。在二维领域,常见的场景理解任务,包括图像分类、语义分割或实例分割,都取得了显着的成果 [13, 3]。然而,3D 场景理解的问题带来了更大的挑战,例如大规模和嘈杂的数据处理。

文献表明,3D 场景的数据可以由一组在不同视点 [14、46、42]、规则的体积网格 [47、26、28] 或简单的3D 点云 [33、16、45、17、24]。我们的工作受到基于点的表示的启发,原因有几个。首先,与多视图和体积表示相比,点云提供了更紧凑和直观的 3D 数据表示。其次,最近直接建立在点云上的神经网络 [33, 16, 24, 45, 17, 18, 22, 23, 48] 在对象识别和语义分割等多个任务中显示出有希望的结果。

在本文中,我们解决了 3D 场景理解中的两个基本问题:语义分割和实例分割。语义分割旨在为场景中的每个 3D 点识别类别标签或对象类别(例如椅子、桌子),而实例分割将场景聚类为对象实例。这两个问题通常被分开解决,其中实例分割/检测是语义分割的后处理任务 [31, 30]。然而,我们观察到对象类别和对象实例是相互依赖的。例如,在实例上提取的形状和外观特征将有助于识别该实例的对象类别。另一方面,如果将两个 3D 点分配给不同的对象类别,则它们不太可能属于同一个对象实例。因此,希望将语义和实例分割耦合到单个任务中。针对上述动机,我们在工作中做出以下贡献。

-

一种网络架构,即多任务逐点网络 (MT-PNet),它同时执行两项任务:预测点云中 3D 点的对象类别,并将这些 3D 点嵌入到高维特征向量中,从而将点聚类到对象实例中。

-

一种多值条件随机场 (MV-CRF) 模型,将类标签和对象实例的联合优化制定为一个统一的框架,可以使用变分平均场技术有效解决。据我们所知,我们是第一个在统一框架中探索语义和实例联合优化的人。

-

在不同的基准数据集上进行了广泛的实验,以验证所提出的方法及其主要组件。实验结果表明,联合语义和实例分割优于每个单独的任务,并且所提出的方法在语义分割方面取得了最先进的性能。

本文的其余部分组织如下。第2节简要回顾了相关工作。提议的方法在第3节中描述。实验和结果在第4节中介绍和讨论。论文最后在第五部分进行了总结。

2. Related Work

本节回顾了3D空间中最近的语义和实例分割技术。我们特别关注应用于3D点云的基于深度学习的技术,因为它们已被证明具有鲁棒性,并且是该领域的当代开创性技术。为了简洁起见,我们稍后将传统的、基于类别的语义分割称为语义分割,将基于实例的语义分割称为实例分割。

2.1. Semantic Segmentation

最近室内场景数据集的可用性[37,15,5,1]激发了对3D场景理解的研究兴趣,特别是语义分割。我们根据输入数据的类型将这些近期作品分为三个主要类别,即多视图图像、体积表示和点云。

Multi-view approach. 这种方法通常使用2D域上的预训练模型,并将它们应用于3D空间。通过将来自彩色或RGB-D图像的2D预测反投影和融合到3D空间上,获得每顶点标签。对2D的预测可以通过分类器来完成,例如随机森林[14,36,46,42]或深度神经网络[27,49,30]。这种技术可以与3D场景重建协同实施,从而创建实时语义重建系统。然而,这种方法存在2D预测之间的不一致性,并且其性能可能取决于视图位置。

Volumetric approach. 深度神经网络在解决图像上的若干场景理解任务中的鲁棒性启发了直接在3D空间中应用深度神经网络来解决3D场景理解问题。事实上,规则网格上的卷积,例如图像结构,可以很容易地扩展到3D,这导致了使用体积表示的深度学习[47,26,28]。为了支持高分辨率分割和减少内存占用,提出了一种分层数据结构,如八叉树,以限制卷积运算只对自由空间体素[35]。已经表明,语义分割的性能可以通过与场景完成联合解决问题来提高[39,6]。

Point cloud approach. 与体积相反,点云是一种紧凑而直观的表示,它通过顶点的坐标和法线直接存储3D场景的几何属性。点云自然来自多视图立体声、深度和激光雷达传感器等商用设备。点云也可以转换为其他表示,如体积[40]或网格[41]。虽然卷积可以方便地在体积[40]上进行,但它们不能直接应用于点云。这个问题首先在Qi等人的工作[32]中提出,随后由其他几个人进行了探讨,例如[33,16,45,17,24,23,48]。语义分割可以进一步扩展到图形卷积(graph convolution),以处理大规模的点云[22],并使用kd-tree来处理不均匀的点分布[18,12]。

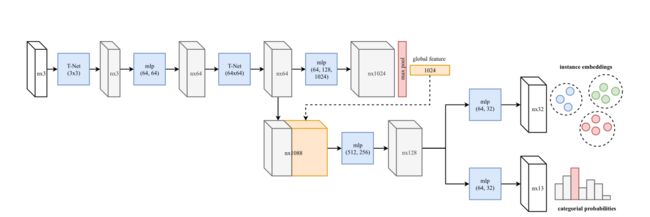

图 2. 我们提出的MT-PNet 架构,它基于 PointNet [32]。点云首先通过前馈神经网络计算每个点的 128 维特征向量。在这里,它分为多个分支:一个用于实例嵌入,另一个用于语义分割。

Conditional Random Fields (CRFs) CRF通常用于3D场景的语义分割,例如[41,14,20,46,42,27,34]。一般来说,CRF利用一元和二元势来捕捉单个3D点[46]或网格[41]的特征,以及它们的共现。为了利用先验知识增强CRF,引入了高阶势[21,11,50,2,49,10,30]。高阶电位,例如,对象检测[21,2,30],作为附加线索来帮助推断CRF中的语义类别标签。

2.2. Instance Segmentation

一般来说,有两种常见的策略来处理实例分割。第一个策略是使用对象检测技术定位对象边界框,然后在每个框内找到一个分隔前景和背景的掩码。这种方法已被证明可以很好地处理图像 [7, 13],同时在 3D 域中被认为具有挑战性。这可能是由于现有的 3D 对象检测器通常不是从头开始训练而是利用图像特征 [9,31,25]。使用掩码扩展此类方法是可能的,但可能会导致次优且更复杂的管道。

相反,鉴于 3D 数据 [32,1,16] 语义分割的有希望的结果,第二种策略是通过添加一个提出对象实例的过程来扩展语义分割框架。在早期的尝试中,Wang 等人 [44] 在 [32] 中提出基于 PointNet 学习语义图和点特征的相似矩阵。然后作者提出了一种启发式和非最大抑制步骤,将相似点合并到实例中。

3. Proposed Method

在这一节中,我们描述了我们提出的三维点云的语义和实例分割方法。给定一个3D点云,我们首先通过重叠3D窗口扫描整个点云。每个窗口(及其关联的3D顶点)被传递到神经网络,用于预测窗口内顶点的语义类别标签,并将顶点嵌入到高维向量中。为了实现这些任务,我们开发了一个多任务逐点网络(MT-PNet),旨在预测场景中每个3D点的对象类别,同时将3D点及其类别标签信息嵌入到矢量中。该网络鼓励属于同一对象实例的3D点被彼此拉近,同时将不同对象实例的3D点彼此推得尽可能远。然后将这些类别标签和嵌入融合成一个多值条件随机场(MVCRF)模型。最后使用变分推理联合执行语义和实例分割。我们在图1中说明了我们方法的管道,并在下面的小节中描述了它的主要组件。

3.1. Multi-Task Pointwise Network (MT-PNet)

我们的 MT-PNet 基于 Qi 等人在 [32] 中提出的 PointNet 的前馈架构(见图 2)。具体来说,对于大小为 N 的输入点云,大小为 N × D N \times D N×D的特征图,其中 D D D每个点的特征维度,首先计算。然后,MT-PNet分成两个不同的分支,执行两个任务:预测3D点的语义标签并创建它们的逐点实例嵌入。我们的MTPNet的损失是它的两个分支的损失之和,

L = L prediction + L embedding (1) \mathcal{L}=\mathcal{L}_{\text {prediction }}+\mathcal{L}_{\text {embedding }} \tag{1} L=Lprediction +Lembedding (1)

预测损失 L prediction \mathcal{L}_{\text {prediction }} Lprediction 像往常一样由交叉熵定义。受 [8] 中工作的启发,我们采用判别函数来呈现嵌入损失 L e m b e d d i n g \mathcal{L}_{e m b e d d i n g} Lembedding。特别地,假设有 K K K个实例, N k , k ∈ { 1 , … , K } N_k, k \in\{1, \ldots, K\} Nk,k∈{1,…,K}是第 k k k个实例中的元素个数, e j ∈ R d \mathbf{e}_j \in \mathbb{R}^d ej∈Rd是点 v j v_j vj的嵌入, μ k \boldsymbol{\mu}_k μk是均值在第 k k k个实例中的嵌入。嵌入损失可以定义如下,

L embedding = α ⋅ L pull + β ⋅ L push + γ ⋅ L reg (2) \mathcal{L}_{\text {embedding }}=\alpha \cdot \mathcal{L}_{\text {pull }}+\beta \cdot \mathcal{L}_{\text {push }}+\gamma \cdot \mathcal{L}_{\text {reg }} \tag{2} Lembedding =α⋅Lpull +β⋅Lpush +γ⋅Lreg (2)

where

L pull = 1 K ∑ k = 1 K 1 N k ∑ j = 1 N k [ ∥ μ k − e j ∥ 2 − δ v ] + 2 (3) \mathcal{L}_{\text {pull }}=\frac{1}{K} \sum_{k=1}^K \frac{1}{N_k} \sum_{j=1}^{N_k}\left[\left\|\boldsymbol{\mu}_k-\mathbf{e}_j\right\|_2-\delta_v\right]_{+}^2 \tag{3} Lpull =K1k=1∑KNk1j=1∑Nk[∥μk−ej∥2−δv]+2(3)

L push = 1 K ( K − 1 ) ∑ k = 1 K ∑ m = 1 , m ≠ k K [ 2 δ d − ∥ μ k − μ m ∥ 2 ] + 2 (4) \mathcal{L}_{\text {push }}=\frac{1}{K(K-1)} \sum_{k=1}^K \sum_{m=1, m \neq k}^K\left[2 \delta_d-\left\|\boldsymbol{\mu}_k-\boldsymbol{\mu}_m\right\|_2\right]_{+}^2 \tag{4} Lpush =K(K−1)1k=1∑Km=1,m=k∑K[2δd−∥μk−μm∥2]+2(4)

L r e g = 1 K ∑ k = 1 K ∥ μ k ∥ 2 (5) \mathcal{L}_{r e g}=\frac{1}{K} \sum_{k=1}^K\left\|\boldsymbol{\mu}_k\right\|_2 \tag{5} Lreg=K1k=1∑K∥μk∥2(5)

其中 [ x ] + = max ( 0 , x ) , δ v [x]_{+}=\max (0, x), \delta_v [x]+=max(0,x),δv 和 δ d \delta_d δd分别是 pull loss L pull \mathcal{L}_{\text {pull }} Lpull 和 push loss L push \mathcal{L}_{\text {push }} Lpush 的边际。我们在我们的实现中设置了 α = β = 1 \alpha=\beta=1 α=β=1 和 γ = 0.001 \gamma=0.001 γ=0.001。

这种嵌入损失的一个简单直觉是,pull loss L pull \mathcal{L}_{\text {pull }} Lpull 将嵌入吸引到质心,即 µk,而 push loss L push \mathcal{L}_{\text {push }} Lpush 使这些质心远离彼此。正则化损失 L r e g \mathcal{L}_{r e g} Lreg充当将所有质心拉向原点的小力量。如 [8] 所示,如果我们设置边距 δ d > 2 δ v \delta_d>2 \delta_v δd>2δv,那么每个嵌入将比其他质心更接近自己的质心。

3.2. Multi-Value Conditional Random Fields (MVCRF)

设 V = { v 1 , … , v N } V=\left\{v_1, \ldots, v_N\right\} V={v1,…,vN}为 3D 重建后得到的 3D 场景的点云。点云中的每个 3D 顶点 v j v_j vj由其 3D 位置 l j = [ x j , y j , z j ] l_j= \left[x_j, y_j, z_j\right] lj=[xj,yj,zj]表示,法线 n j = [ n j , x , n j , y , n j , z ] \mathbf{n}_j=\left[n_{j, x}, n_{j, y}, n_{j, z}\right] nj=[nj,x,nj,y,nj,z]和颜色 c j = [ c j , R , c j , G , c j , B ] \mathbf{c}_j= \left[c_{j, R}, c_{j, G}, c_{j, B}\right] cj=[cj,R,cj,G,cj,B]。通过使用提出的MT-PNet,我们还获得了每个点 v j v_j vj的嵌入 e j ∈ R d \mathbf{e}_j \in \mathbb{R}^d ej∈Rd。令 L S = { l 1 S , … , l N S } L^S=\left\{l_1^S, \ldots, l_N^S\right\} LS={l1S,…,lNS}为需要分配给点云 V V V的一组语义标签,其中 l j S l_j^S ljS表示 v j v_j vj的语义类,例如椅子、桌子等。类似地,令 L I = { l 1 I , … , l N I } L^I=\left\{l_1^I, \ldots, l_N^I\right\} LI={l1I,…,lNI}为 V V V的实例标签集,即同一对象实例的所有顶点将具有相同的实例标签 l j I l_j^I ljI。标签 l j S l_j^S ljS和 l j I l_j^I ljI是在 S S S和 I I I中取值的随机变量,它们分别是语义标签和实例标签的集合。注意 S S S是预定义的,而 I I I是未知的,需要通过实例分割来确定。

E ( L S , L I ∣ V ) = ∑ j φ ( l j S ) + ∑ ( j , k ) , j < k φ ( l j S , l k S ) + ∑ j ψ ( l j I ) + ∑ ( j , k ) , j < k ψ ( l j I , l k I ) + ∑ s ∈ S ∑ i ∈ I ϕ ( s , i ) (6) \begin{aligned} E\left(L^S, L^I \mid V\right)=& \sum_j \varphi\left(l_j^S\right)+\sum_{(j, k), j

我们注意到我们的 MV-CRF 与现有的高阶 CRF 有很大不同,例如 [21,11,2,30]。具体来说,在现有的高阶 CRF 中,高阶,例如对象检测被用作有助于改进分割的先验知识。相比之下,我们的 MV-CRF 将实例标签和语义标签视为未知,并同时优化它们。

(6) 中的能量函数 E ( L S , L I ∣ V ) E\left(L^S, L^I \mid V\right) E(LS,LI∣V)涉及许多势能,这些势能在两者中都包含物理约束(例如,表面光滑度、几何接近度)和语义约束(例如,对象类和实例之间的形状一致性)。语义和实例标记。具体来说,一元势 φ ( l j S ) \varphi\left(l_j^S\right) φ(ljS)是在语义标签 l j S l_j^S ljS上定义的,并直接从MT-PNet的分类分数计算为,

φ ( l j S = s ) ∝ − log p ( v j ∣ l j S = s ) ( 7 ) \varphi\left(l_j^S=s\right) \propto-\log p\left(v_j \mid l_j^S=s\right) \quad\quad\quad\quad(7) φ(ljS=s)∝−logp(vj∣ljS=s)(7)

其中 s s s是 S S S中可能的类标签, p ( v j ∣ l j S = s ) p\left(v_j \mid l_j^S=s\right) p(vj∣ljS=s)是我们的网络将 v j v_j vj分类到语义类 s s s的概率(例如,softmax 值)。

我们发现同一对象类的顶点通常共享相同的分类分数分布,即 p ( v j ∣ l j S ) p\left(v_j \mid l_j^S\right) p(vj∣ljS)。因此,我们通过 v j v_j vj和 v k v_k vk的分类分数对成对势 φ ( l j S , l k S ) \varphi\left(l_j^S, l_k^S\right) φ(ljS,lkS)进行建模。具体来说,我们定义,

φ ( l j S , l k S ) = ω j , k exp { − [ p ( v j ∣ l j S ) − p ( v k ∣ l k S ) ] 2 2 θ 2 } (8) \varphi\left(l_j^S, l_k^S\right)=\omega_{j, k} \exp \left\{-\frac{\left[p\left(v_j \mid l_j^S\right)-p\left(v_k \mid l_k^S\right)\right]^2}{2 \theta^2}\right\} \tag{8} φ(ljS,lkS)=ωj,kexp{−2θ2[p(vj∣ljS)−p(vk∣lkS)]2}(8)

其中 ω j , k \omega_{j, k} ωj,k是从Pott相容性获得的,

ω j , k = { − 1 , if l j S / I = l k S / I 1 , otherwise (9) \omega_{j, k}= \begin{cases}-1, & \text { if } l_j^{S / I}=l_k^{S / I} \\ 1, & \text { otherwise }\end{cases} \tag{9} ωj,k={−1,1, if ljS/I=lkS/I otherwise (9)

一元势 ψ ( l j I ) \psi\left(l_j^I\right) ψ(ljI)强制属于同一实例的嵌入以尽可能接近它们的平均嵌入。直观地说,同一实例的嵌入有望在嵌入空间中转换为它们的模式。同时,鼓励不同实例的嵌入相互分歧。具体来说,假设实例标签集 I = { i 1 , … , i K } I=\left\{i_1, \ldots, i_K\right\} I={i1,…,iK}包括 K K K 个实例。假设 L I L^I LI的当前配置将 V V V中的所有顶点分配给这 K K K个实例。对于每个实例标签 i ∈ I i \in I i∈I,我们定义,

ψ ( l j I = i ) = − exp [ − 1 2 ( e j − μ i ) ⊤ Σ i − 1 ( e j − μ i ) ] ( 2 π ) d ∣ Σ i ∣ − log [ ∑ k 1 ( l k I = i ) ] (10) \begin{aligned} \psi\left(l_j^I=i\right) &=-\frac{\exp \left[-\frac{1}{2}\left(\mathbf{e}_j-\boldsymbol{\mu}_i\right)^{\top} \boldsymbol{\Sigma}_i^{-1}\left(\mathbf{e}_j-\boldsymbol{\mu}_i\right)\right]}{\sqrt{(2 \pi)^d\left|\boldsymbol{\Sigma}_i\right|}} \\ &-\log \left[\sum_k 1\left(l_k^I=i\right)\right] \tag{10} \end{aligned} ψ(ljI=i)=−(2π)d∣Σi∣exp[−21(ej−μi)⊤Σi−1(ej−μi)]−log[k∑1(lkI=i)](10)

其中 μ i \boldsymbol{\mu}_i μi和 Σ i \boldsymbol{\Sigma}_i Σi分别表示分配给标签 i i i的嵌入的均值和协方差矩阵, 1 ( ⋅ ) 1(\cdot) 1(⋅)是一个指标。

(10) 中的术语 ∑ k 1 ( l k I = i ) \sum_k 1\left(l_k^I=i\right) ∑k1(lkI=i)表示实例 i 的区域,用于支持大实例。我们发现这个术语可以帮助消除点云中由噪声引起的微小实例。

实例标签的成对势 ψ ( l j I , l k I ) \psi\left(l_j^I, l_k^I\right) ψ(ljI,lkI)捕获对象实例中的表面的几何属性,并且被定义为顶点 v j v_j vj和 v k v_k vk的位置、法线和颜色的高斯混合。特别是,

ψ ( l j I , l k I ) = ω j , k exp ( − ∥ l j − l k ∥ 2 2 2 λ 1 2 − ∥ n j − n k ∥ 2 2 2 λ 2 2 − ∥ c j − c k ∥ 2 2 2 λ 3 2 ) (11) \begin{aligned} &\psi\left(l_j^I, l_k^I\right)= \\ &\omega_{j, k} \exp \left(-\frac{\left\|\mathbf{l}_j-\mathbf{l}_k\right\|_2^2}{2 \lambda_1^2}-\frac{\left\|\mathbf{n}_j-\mathbf{n}_k\right\|_2^2}{2 \lambda_2^2}-\frac{\left\|\mathbf{c}_j-\mathbf{c}_k\right\|_2^2}{2 \lambda_3^2}\right) \end{aligned} \tag{11} ψ(ljI,lkI)=ωj,kexp(−2λ12∥lj−lk∥22−2λ22∥nj−nk∥22−2λ32∥cj−ck∥22)(11)

其中 ω j , k \omega_{j, k} ωj,k在(9)中给出。

(6) 中的术语 ϕ ( s , i ) \phi(s, i) ϕ(s,i)将基于语义的电位与基于实例的电位相关联,并鼓励语义标签和实例标签之间的一致性。例如,如果将两个顶点分配给同一个对象实例,则它们应该分配给同一个对象类。从技术上讲,如果我们为对象实例 i i i 的所有顶点计算语义标签 s s s频率的直方图 h i h_i hi,我们可以定义 ϕ ( s , i ) \phi(s, i) ϕ(s,i)基于 s s s和 i i i之间的互信息,

ϕ ( s , i ) = − h i ( s ) log h i ( s ) (12) \phi(s, i)=-h_i(s) \log h_i(s) \tag{12} ϕ(s,i)=−hi(s)loghi(s)(12)

其中 h i ( s ) h_i(s) hi(s)是语义标签 s s s在实例标签为 i i i的顶点中出现的频率。

如(12)所示,给定实例标签 i i i,所有语义标签 s ∈ S s \in S s∈S上的 ϕ ( s , i ) \phi(s, i) ϕ(s,i)之和是标签 s s s相对于的信息熵。对象实例 i i i,即 ∑ s ∈ S ϕ ( s , i ) = − ∑ s ∈ S h i ( s ) log h i ( s ) \sum_{s \in S} \phi(s, i)=-\sum_{s \in S} h_i(s) \log h_i(s) ∑s∈Sϕ(s,i)=−∑s∈Shi(s)loghi(s)。因此,一个好的标注应该最小化这样的熵,导致相同对象实例中语义标签的低变化。由于(6)中的能量 E ( L S , L I ∣ V ) E\left(L^S, L^I \mid V\right) E(LS,LI∣V)对所有语义标签 s s s和实例标签 i i i求和,这将有利于高度一致的标签。

3.3. Variational Inference

(6)中 E ( L S , L I ∣ V ) E\left(L^S, L^I \mid V\right) E(LS,LI∣V)的最小化等价于后验条件 p ( L S , L I ∣ V ) p\left(L^S, L^I \mid V\right) p(LS,LI∣V)的最大化,这很难使用简单实现来解决。在本文中,我们采用平均场变分法来解决这个优化问题[43]。一般来说,平均场变分推断的思想是用一个变分分布 Q ( L S , L I ) Q\left(L^S, L^I\right) Q(LS,LI)来近似概率分布 p ( L S , L I ∣ V ) p\left(L^S, L^I \mid V\right) p(LS,LI∣V),这个变分分布 Q ( L S , L I ) Q\left(L^S, L^I\right) Q(LS,LI)可以在 ( L S , L I ) \left(L^S, L^I\right) (LS,LI)中的所有随机变量上完全分解,即 Q ( L S , L I ) = ∏ j Q j ( l j S , l j I ) Q\left(L^S, L^I\right)=\prod_j Q_j\left(l_j^S, l_j^I\right) Q(LS,LI)=∏jQj(ljS,ljI)。

然而, Q ( L S , L I ) Q\left(L^S, L^I\right) Q(LS,LI)在 ( L S , L I ) \left(L^S, L^I\right) (LS,LI)中所有对上的因式分解导致每个顶点的计算复杂度为 ∣ S ∣ × ∣ I ∣ |S| \times|I| ∣S∣×∣I∣。此外,由于我们提出的MV-CRF模型是完全连接的,在平均场近似的传统实现中使用的消息传递步骤需要随机变量数量的二次复杂度(即 2 N 2N 2N)。幸运的是,由于我们在(8)和(11)中定义的成对势以高斯形式表示,因此可以通过对 Q Q Q的下采样版本应用高斯滤波器的卷积运算,然后进行上采样来有效地执行消息传递步骤[19]。截断高斯也可以用来近似这些高斯滤波器,以进一步加快消息传递过程[29]。

我们首先假设 L S L^S LS和 L I L^I LI在联合变分分布 Q ( L S , L I ) Q\left(L^S, L^I\right) Q(LS,LI)中是独立的,因此 Q ( L S , L I ) Q\left(L^S, L^I\right) Q(LS,LI)可以分解为,

Q ( L S , L I ) = [ ∏ j = 1 N Q j S ( l j S ) ] [ ∏ j = 1 N Q j I ( l j I ) ] (13) Q\left(L^S, L^I\right)=\left[\prod_{j=1}^N Q_j^S\left(l_j^S\right)\right]\left[\prod_{j=1}^N Q_j^I\left(l_j^I\right)\right] \tag{13} Q(LS,LI)=[j=1∏NQjS(ljS)][j=1∏NQjI(ljI)](13)

(13)中的假设允许我们导出语义和实例变分分布 Q S Q^S QS 和 Q L Q^L QL的平均场更新方程。

由于(6)中的项 ∑ s ∈ S ∑ i ∈ I ϕ ( s , i ) \sum_{s \in S} \sum_{i \in I} \phi(s, i) ∑s∈S∑i∈Iϕ(s,i)没有相对于索引 j j j表示,为了方便计算平均场更新,对于每个顶点 v j v_{j} vj,我们定义一个新的项 m j m_j mj为,

m j = ∑ s ∈ S h l j I ( s ) log h l j I ( s ) ∑ v k ∈ V 1 ( l k I = l j I ) (14) m_j=\frac{\sum_{s \in S} h_{l_j^I}(s) \log h_{l_j^I}(s)}{\sum_{v_k \in V} 1\left(l_k^I=l_j^I\right)} \tag{14} mj=∑vk∈V1(lkI=ljI)∑s∈ShljI(s)loghljI(s)(14)

通过使用 m j m_{j} mj,(6) 中的项 ∑ s ∈ S ∑ i ∈ I ϕ ( s , i ) \sum_{s \in S} \sum_{i \in I} \phi(s, i) ∑s∈S∑i∈Iϕ(s,i)可以重写为:

∑ s ∈ S ∑ i ∈ I ϕ ( s , i ) = ∑ v j ∈ V m j (15) \sum_{s \in S} \sum_{i \in I} \phi(s, i)=\sum_{v_j \in V} m_j \tag{15} s∈S∑i∈I∑ϕ(s,i)=vj∈V∑mj(15)

然后我们获得平均场更新,

Q j S ( l j S = s ) ← 1 Z j exp [ − φ ( l j S = s ) − ∑ s ′ ∈ S ∑ k ≠ j Q k S ( l k S = s ′ ) φ ( l j S , l k S ) − m j ] (16) \begin{aligned} Q_j^S\left(l_j^S=s\right) \leftarrow & \frac{1}{Z_j} \exp \left[-\varphi\left(l_j^S=s\right)\right.\\ &\left.-\sum_{s^{\prime} \in S} \sum_{k \neq j} Q_k^S\left(l_k^S=s^{\prime}\right) \varphi\left(l_j^S, l_k^S\right)-m_j\right] \end{aligned} \tag{16} QjS(ljS=s)←Zj1exp[−φ(ljS=s)−s′∈S∑k=j∑QkS(lkS=s′)φ(ljS,lkS)−mj⎦⎤(16)

and

Q j I ( l j I = i ) ← 1 Z j exp [ − ψ ( l j I = i ) − ∑ i ′ ∈ I ∑ k ≠ j Q k I ( l k I = i ′ ) ψ ( l j I , l k I ) − m j ] (17) \begin{aligned} Q_j^I\left(l_j^I=i\right) \leftarrow & \frac{1}{Z_j} \exp \left[-\psi\left(l_j^I=i\right)\right.\\ &\left.-\sum_{i^{\prime} \in I} \sum_{k \neq j} Q_k^I\left(l_k^I=i^{\prime}\right) \psi\left(l_j^I, l_k^I\right)-m_j\right] \end{aligned} \tag{17} QjI(ljI=i)←Zj1exp[−ψ(ljI=i)−i′∈I∑k=j∑QkI(lkI=i′)ψ(ljI,lkI)−mj⎦⎤(17)

其中 Z j Z_j Zj是使 Q ( L S , L I ) Q\left(L^S, L^I\right) Q(LS,LI)在优化期间成为概率质量函数的配分函数。

5. Conclusion

点云的语义分割和实例分割是三维场景理解中至关重要的基本步骤。本文提出了一种语义实例切分方法,通过一种新的多任务点式网络和多值条件随机场模型联合执行这两项任务。多任务逐点网络同时学习3D点的类标签和它们的嵌入表示,这使得能够将3D点聚类成对象实例。多值条件随机场模型集成了3D和高维嵌入特征,以联合执行语义和实例分割。我们对提出的方法进行了评估,并在不同的室内数据集上将它与现有方法进行了比较。实验结果有利地显示了我们的方法与最先进的方法相比的进步,并且联合语义实例分割方法优于其单独的组件。