基于Paddle2.0的手写数字识别

- 目录

-

- 1 准备数据

- 2 网络配置

目录

首先导入必要的包

numpy---------->python第三方库,用于进行科学计算

PIL------------> Python Image Library,python第三方图像处理库

matplotlib----->python的绘图库 pyplot:matplotlib的绘图框架

os------------->提供了丰富的方法来处理文件和目录

#导入需要的包

import numpy as np

from PIL import Image

import matplotlib.pyplot as plt

import os

import paddle

import paddle.nn.functional as F

1 准备数据

(1)数据集介绍

MNIST数据集包含60000个训练集和10000测试数据集。分为图片和标签,图片是28*28的像素矩阵,标签为0~9共10个数字。

(2)transform函数是定义了一个归一化标准化的标准

(3)train_dataset和test_dataset

paddle.vision.datasets.MNIST()中的mode='train’和mode='test’分别用于获取mnist训练集和测试集

transform=transform参数则为归一化标准

#导入数据集Compose的作用是将用于数据集预处理的接口以列表的方式进行组合。

#导入数据集Normalize的作用是图像归一化处理,支持两种方式: 1. 用统一的均值和标准差值对图像的每个通道进行归一化处理; 2. 对每个通道指定不同的均值和标准差值进行归一化处理。

from paddle.vision.transforms import Compose, Normalize

transform = Compose([Normalize(mean=[127.5],std=[127.5],data_format='CHW')])

# 使用transform对数据集做归一化

print('下载并加载训练数据')

train_dataset = paddle.vision.datasets.MNIST(mode='train', transform=transform)

test_dataset = paddle.vision.datasets.MNIST(mode='test', transform=transform)

print('加载完成')

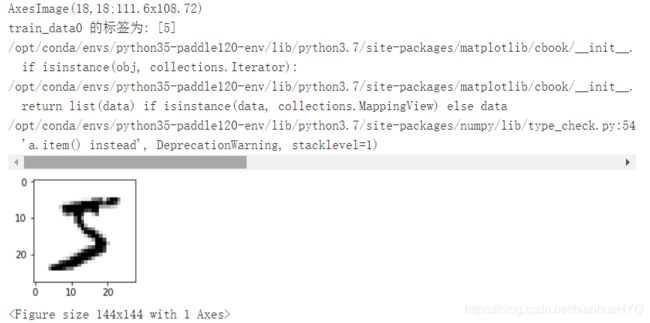

#让我们一起看看数据集中的图片是什么样子的

train_data0, train_label_0 = train_dataset[0][0],train_dataset[0][1]

train_data0 = train_data0.reshape([28,28])

plt.figure(figsize=(2,2))

print(plt.imshow(train_data0, cmap=plt.cm.binary))

print('train_data0 的标签为: ' + str(train_label_0))

2 网络配置

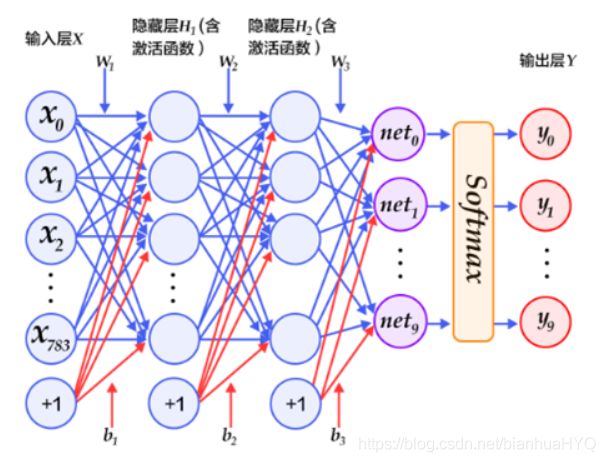

以下的代码判断就是定义一个简单的多层感知器,一共有三层,两个大小为100的隐层和一个大小为10的输出层,因为MNIST数据集是手写0到9的灰度图像,类别有10个,所以最后的输出大小是10。最后输出层的激活函数是Softmax,所以最后的输出层相当于一个分类器。加上一个输入层的话,多层感知器的结构是:输入层–>>隐层–>>隐层–>>输出层。

# 定义多层感知器

#动态图定义多层感知器

class multilayer_perceptron(paddle.nn.Layer):

def __init__(self):

super(multilayer_perceptron,self).__init__()

self.flatten = paddle.nn.flatten()

self.hidden = paddle.nn.Linear(in_features=784,out_features=128)

self.output = paddle.nn.Linear(in_features=128,out_features=10)

def forward(self, x):

x=self.flatten(x)

x=self.hidden(x)

x=F.relu(x)

x=self.output(x)

return y

#请在这里定义卷积网络的代码

class LeNet(paddle.nn.Layer):

def __init__(self):

super(LeNet, self).__init__()

self.conv1 = paddle.nn.Conv2D(in_channels=1,out_channels=6,kernel_size=5,stride=1)

#池化层L2

self.pool1 = paddle.nn.MaxPool2D(kernel_size=2,stride=2)

#卷积层L3

self.conv2 = paddle.nn.Conv2D(in_channels=6,out_channels=16,kernel_size=5,stride=1)

#池化层L4

self.pool2 = paddle.nn.MaxPool2D(kernel_size=2,stride=2)

#线性层L5

self.fc1=paddle.nn.Linear(256,120)

#线性层L6

self.fc2=paddle.nn.Linear(120,84)

#线性层L7

self.fc3=paddle.nn.Linear(84,10)

def forward(self, x):

x = self.conv1(x)

x = F.relu(x)

x = self.pool1(x)

x = F.relu(x)

x = self.conv2(x)

x = self.pool2(x)

x = paddle.flatten(x, start_axis=1,stop_axis=-1)

x = self.fc1(x)

x = F.relu(x)

x = self.fc2(x)

x = F.relu(x)

out = self.fc3(x)

return out

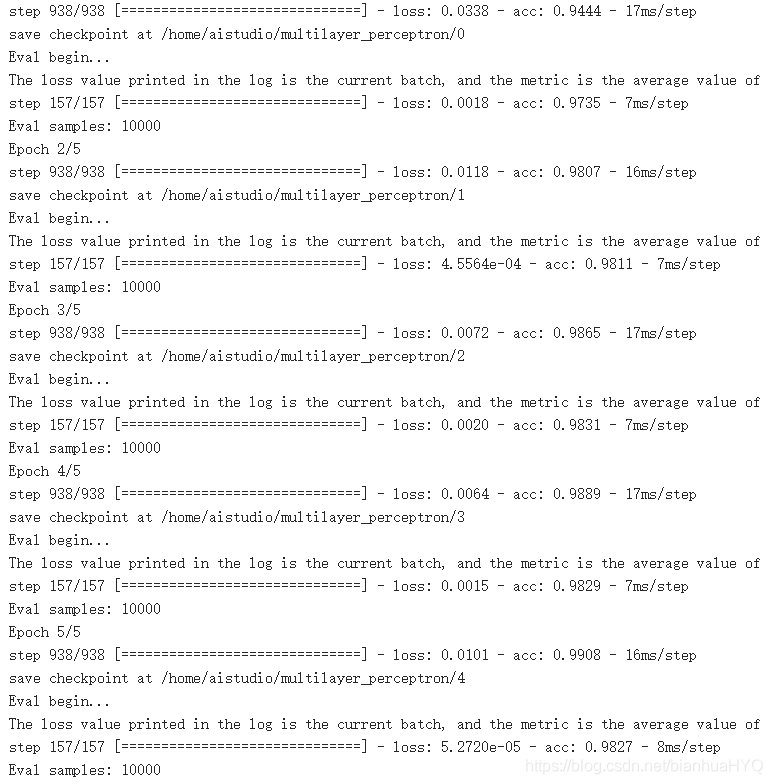

封装模型与训练

from paddle.metric import Accuracy

# 用Model封装模型

model = paddle.Model(LeNet())

# 定义损失函数

optim = paddle.optimizer.Adam(learning_rate=0.001, parameters=model.parameters())

# 配置模型

model.prepare(optim,paddle.nn.CrossEntropyLoss(),Accuracy())

# 训练保存并验证模型

model.fit(train_dataset,test_dataset,epochs=5,batch_size=64,save_dir='multilayer_perceptron',verbose=1)

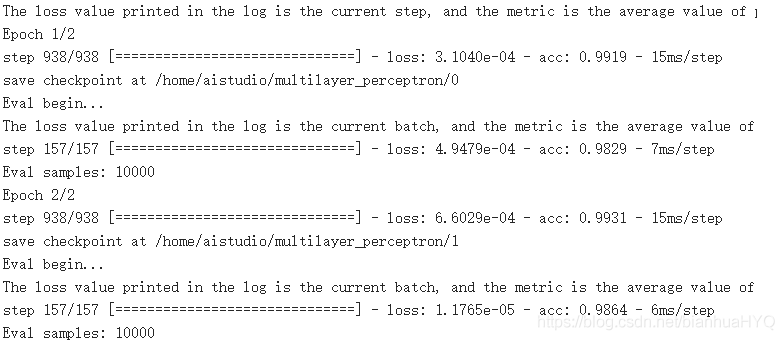

# 训练保存并验证模型

model.fit(train_dataset,test_dataset,epochs=2,batch_size=64,save_dir='multilayer_perceptron',verbose=1)

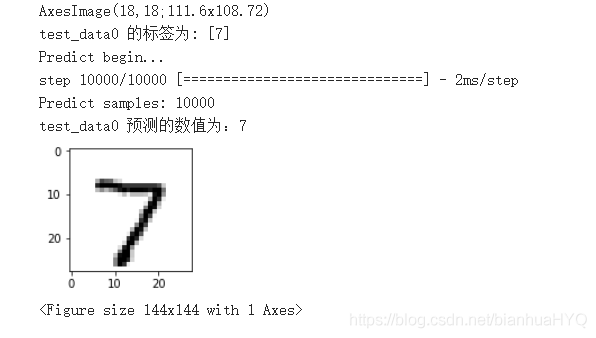

#获取测试集的第一个图片

test_data0, test_label_0 = test_dataset[0][0],test_dataset[0][1]

test_data0 = test_data0.reshape([28,28])

plt.figure(figsize=(2,2))

#展示测试集中的第一个图片

print(plt.imshow(test_data0, cmap=plt.cm.binary))

print('test_data0 的标签为: ' + str(test_label_0))

#模型预测

result = model.predict(test_dataset, batch_size=1)

#打印模型预测的结果

print('test_data0 预测的数值为:%d' % np.argsort(result[0][0])[0][-1])