机器学习(二)多元线性回归算法预测房价

机器学习(二)多元线性回归算法预测房价

本篇文章已作为重庆交通大学19级微课《机器视觉》大作业提交,提前声明,避免抄袭误会

“garbage in garbage out”(简称GIGO),是计算机术语常用的俚语,意思是如果你输入错误的数据,那么(计算机)输出的结果也是错误的。这个结论在机器学习领域也成立。多元线性回归属于监督机器学习算法,通过已知数据训练得到模型或决策函数。应用此算法时,不能盲目地套用算法,必须对数据的有效性、正确性、假设合理性进行验证,如果发现数据本身不正确,就需要纠正。

文章目录

- 机器学习(二)多元线性回归算法预测房价

-

- 〇、理论基础

-

- 1. 线性回归理论基础

- 一、利用Excel线性回归

- 二、基于Statsmodels库实现线性回归

-

- 1. 基础包与数据导入:

- 2. 数据清洗

- 3. 分析数据

- 4. 拟合

-

- 4.1 引入模型

- 4.2 建模

- 4.3 模型优化

- 4.4 再次建模

- 4.5 处理多元共线性:

- 三、基于Sklearn库实现线性回归

-

- 1. 不清洗数据直接求解

- 2. 清洗数据再求解

- 3. 结果对比

- 四、总结

- 五、参考文章

〇、理论基础

多元线性回归适用于受多种因素影响的数据进行分析的场景,而市场的房价走向恰好受到多种因素影响。所以用多元线性回归得到多个自变量的最优组合来预测房价或估计它的因变量会更加有效,更加符合实际。

1. 线性回归理论基础

一元线性回归是分析只有一个自变量(自变量x和因变量y)线性相关关系的方法。一元线性回归分析的数学模型为:y = a+bx+ε。

使用偏差平方和分别对参数a和参数b求偏导,可以得到线性模型的未知参数a、b的最小二乘估计值,其中,偏差平方和定义为∑(yi-a-bXi)2,a和b的唯一解如下图所示

![]()

为了方便回归效果显著性检验,根据b的估计,引入LXX、LYY、LXY三个数学符号,这三个数学符号定义如下图所示。

![]()

而在现实应用中,因变量的变化往往受多个自变量影响,此时就需要用到两个或两个以上的因素作为自变量来解释因变量的变化,这就叫做多元回归。也就是说,多元线性回归就是当多个自变量与因变量之间是线性关系时,所进行的回归就是多元线性回归。它的数学模型便是:y=β0+β1X1+β2X2+…+βpXp+ε

再使用残差平方和分别对参数βi求偏导,可得到线性模型的未知参数βi的估计值,此时β居矩阵的估计值就为:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-v8lSXM8a-1635233598829)(C:\Users\12711\AppData\Roaming\Typora\typora-user-images\image-20211026151258130.png)]

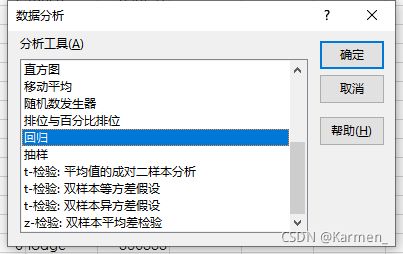

一、利用Excel线性回归

因为本数据文档共有6029行,所以X直接输入

$C$1:$E$6029,Y则$G$1:$G$6029

- 点击确定后得到如下结果:

二、基于Statsmodels库实现线性回归

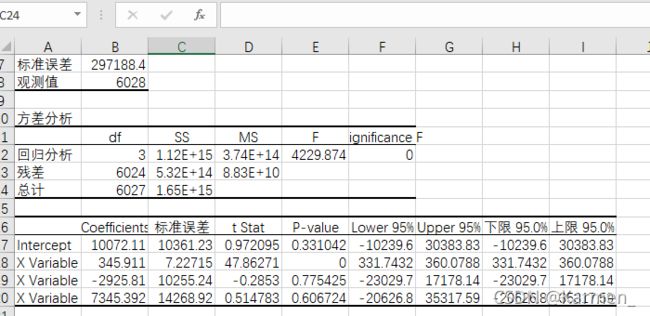

1. 基础包与数据导入:

import pandas as pd

import numpy as np

import seaborn as sns

import matplotlib.pyplot as plt

读取数据文件

df = pd.read_csv('house_prices.csv')

df.info();df.head()

2. 数据清洗

数据清洗(Data cleaning)- 对数据进行重新审查和校验的过程,目的在于删除重复信息、纠正存在的错误,并提供数据一致性。 数据清洗从名字上也看的出就是把"脏"的"洗掉",指发现并纠正数据文件中可识别的错误的最后一道程序,包括检查数据一致性,处理无效值和缺失值等。

清洗方法

-

数字异常值方法

数字异常值方法是一维特征空间中最简单的非参数异常值检测方法,异常值是通过IQR(InterQuartile Range)计算得的。 计算第一和第三四分位数(Q1、Q3),异常值是位于四分位数范围之外的数据点x i: 使用四分位数乘数值k=1.5,范围限制是典型的上下晶须的盒子图。——知乎

-

Z 分数法

z分数(z-score),也叫标准分数(standard score)是一个数与平均数的差再除以标准差的过程。 在统计学中,标准分数是一个观测或数据点的值高于被观测值或测量值的平均值的标准偏差的符号数。

z分数可以回答这样一个问题:"一个给定分数距离 平均数 多少个标准差?"在平均数之上的分数会得到一个正的标准分数,在平均数之下的分数会得到一个负的标准分数。 z分数是一种可以看出某分数在分布中相对位置的方法。 z分数能够真实的反应一个分数距离平均数的相对标准距离。 如果我们把每一个分数都转换成z分数,那么每一个z分数会以 标准差 为单位表示一个具体分数到平均数的距离或 离差 。——百度百科

# 异常值处理

# ================ 异常值检验函数:iqr & z分数 两种方法 =========================

def outlier_test(data, column, method=None, z=2):

""" 以某列为依据,使用 数字异常值法 检测异常值(索引) """

"""

full_data: 完整数据

column: full_data 中的指定行,格式 'x' 带引号

return 可选; outlier: 异常值数据框

upper: 上截断点; lower: 下截断点

method:检验异常值的方法(可选, 默认的 None 为上下截断点法),

选 Z 方法时,Z 默认为 2

"""

# ================== 数字异常值法检验异常值 ==============================

if method == None:

print(f'以 {column} 列为依据,使用 上下截断点法(iqr) 检测异常值...')

print('=' * 70)

# 四分位点;这里调用函数会存在异常

column_iqr = np.quantile(data[column], 0.75) - np.quantile(data[column], 0.25)

# 1,3 分位数

(q1, q3) = np.quantile(data[column], 0.25), np.quantile(data[column], 0.75)

# 计算上下截断点

upper, lower = (q3 + 1.5 * column_iqr), (q1 - 1.5 * column_iqr)

# 检测异常值

outlier = data[(data[column] <= lower) | (data[column] >= upper)]

print(f'第一分位数: {q1}, 第三分位数:{q3}, 四分位极差:{column_iqr}')

print(f"上截断点:{upper}, 下截断点:{lower}")

return outlier, upper, lower

# ===================== Z 分数检验异常值 ==========================

if method == 'z':

""" 以某列为依据,传入数据与希望分段的 z 分数点,返回异常值索引与所在数据框 """

"""

params

data: 完整数据

column: 指定的检测列

z: Z分位数, 默认为2,根据 z分数-正态曲线表,可知取左右两端的 2%,

根据您 z 分数的正负设置。也可以任意更改,知道任意顶端百分比的数据集合

"""

print(f'以 {column} 列为依据,使用 Z 分数法,z 分位数取 {z} 来检测异常值...')

print('=' * 70)

# 计算两个 Z 分数的数值点

mean, std = np.mean(data[column]), np.std(data[column])

upper, lower = (mean + z * std), (mean - z * std)

print(f"取 {z} 个 Z分数:大于 {upper} 或小于 {lower} 的即可被视为异常值。")

print('=' * 70)

# 检测异常值

outlier = data[(data[column] <= lower) | (data[column] >= upper)]

return outlier, upper, lower

清洗结果:

outlier, upper, lower = outlier_test(data=df, column='price', method='z')

outlier.info(); outlier.sample(5)

丢掉垃圾数据:

df.drop(index=outlier.index, inplace=True)

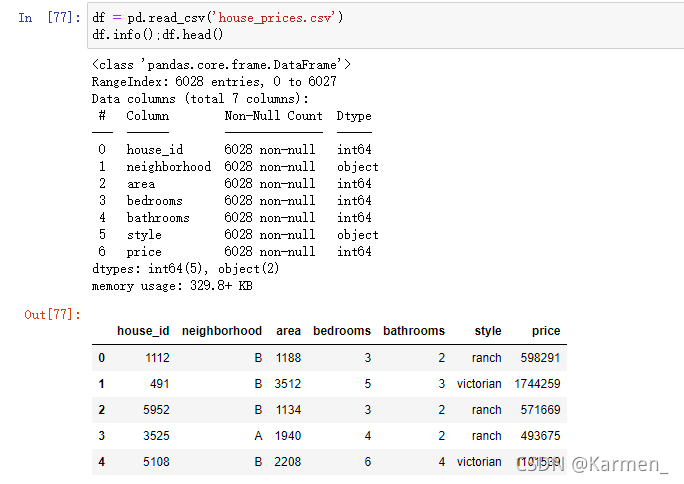

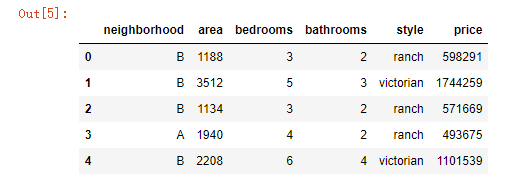

3. 分析数据

这里我们通过热力图来分析变量

# 热力图

def heatmap(data, method='pearson', camp='YlGnBu', figsize=(10 ,8)):

"""

data: 整份数据

method:默认为 pearson 系数

camp:默认为:RdYlGn-红黄蓝;YlGnBu-黄绿蓝;Blues/Greens 也是不错的选择

figsize: 默认为 10,8

"""

## 消除斜对角颜色重复的色块

# mask = np.zeros_like(df2.corr())

# mask[np.tril_indices_from(mask)] = True

plt.figure(figsize=figsize, dpi= 80)

sns.heatmap(data.corr(method=method, mask=mask), \

xticklabels=data.corr(method=method).columns, \

yticklabels=data.corr(method=method).columns, cmap=camp, \

center=0, annot=True)

# 要想实现只是留下对角线一半的效果,括号内的参数可以加上 mask=mask

调出热力图

heatmap(data=df, figsize=(6,5))

通过热力图我们可以看出area、bedroom、bathroom这三个变量与房屋价格price关系还比较强,所以值得我们放入模型中,但是分类变量style和neighborhood等两个变量与price关系还未知

4. 拟合

4.1 引入模型

style与neighborhood的类别都是三类,如果只是两类的话我们可以进行卡方检验,所以这里我们使用方差分析

## 利用回归模型中的方差分析

## 只有 statsmodels 有方差分析库

## 从线性回归结果中提取方差分析结果

import statsmodels.api as sm

from statsmodels.formula.api import ols # ols 为建立线性回归模型的统计学库

from statsmodels.stats.anova import anova_lm

这里要注意:样本量和置信水平 α_level 一些要点(置信水平 α 的选择经验)

样本量过大,α-level 就没什么意义了。数据量很大时,p 值就没用了,样本量通常不超过 5000,

为了证明两变量间的关系是稳定的,样本量要控制好。

4.2 建模

from statsmodels.formula.api import ols

lm = ols('price ~ area + bedrooms + bathrooms', data=df).fit()

lm.summary()

4.3 模型优化

# 设置虚拟变量

# 以名义变量 neighborhood 街区为例

nominal_data = df['neighborhood']

# 设置虚拟变量

dummies = pd.get_dummies(nominal_data)

dummies.sample() # pandas 会自动帮你命名

# 每个名义变量生成的虚拟变量中,需要各丢弃一个,这里以丢弃C为例

dummies.drop(columns=['C'], inplace=True)

dummies.sample()

# 将结果与原数据集拼接

results = pd.concat(objs=[df, dummies], axis='columns') # 按照列来合并

results.sample(3)

# 对名义变量 style 的处理可自行尝试

4.4 再次建模

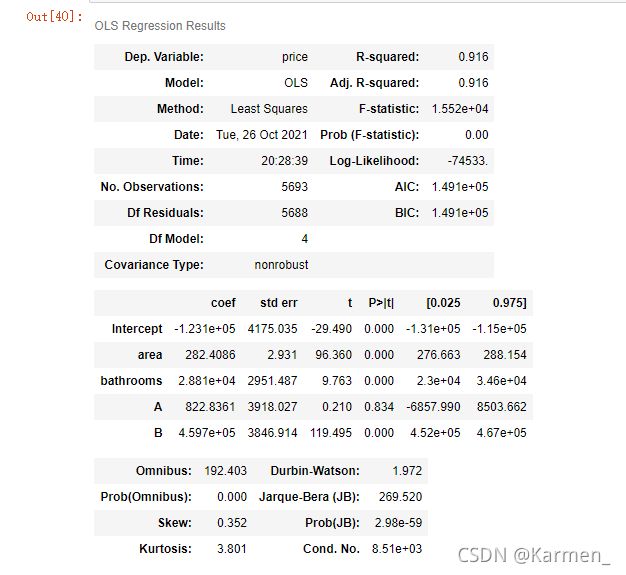

lm = ols('price ~ area + bedrooms + bathrooms + A + B', data=results).fit()

lm.summary()

4.5 处理多元共线性:

自定义方差膨胀因子的检测公式

def vif(df, col_i):

"""

df: 整份数据

col_i:被检测的列名

"""

cols = list(df.columns)

cols.remove(col_i)

cols_noti = cols

formula = col_i + '~' + '+'.join(cols_noti)

r2 = ols(formula, df).fit().rsquared

return 1. / (1. - r2)

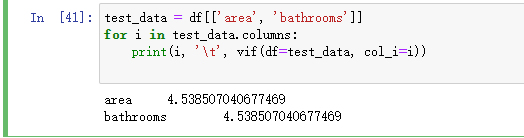

test_data = results[['area', 'bedrooms', 'bathrooms', 'A', 'B']]

for i in test_data.columns:

print(i, '\t', vif(df=test_data, col_i=i))

发现 bedrooms 和 bathrooms 存在强相关性,可能这两个变量是解释同一个问题:

再次拟合

lm = ols(formula='price ~ area + bathrooms + A + B', data=results).fit()

lm.summary()

还是存在多元共线性

再次进行多元共线性检测

test_data = df[['area', 'bathrooms']]

for i in test_data.columns:

print(i, '\t', vif(df=test_data, col_i=i))

精度没变,但具体问题还是需要结合具体业务来分析

三、基于Sklearn库实现线性回归

1. 不清洗数据直接求解

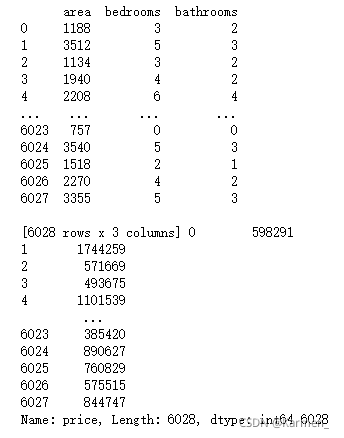

导入Sklearn库并读取数据文件:

import pandas as pd

import numpy as np

import math

import matplotlib.pyplot as plt

from sklearn import linear_model

data = pd.read_csv('house_prices.csv')

data.head()

new_data=data.iloc[:,1:]

new_data.head()

import seaborn as sns

def heatmap(data, method='pearson', camp='RdYlGn', figsize=(10 ,8)):

"""

data: 整份数据

method:默认为 pearson 系数

camp:默认为:RdYlGn-红黄蓝;YlGnBu-黄绿蓝;Blues/Greens 也是不错的选择

figsize: 默认为 10,8

"""

## 消除斜对角颜色重复的色块

# mask = np.zeros_like(df2.corr())

# mask[np.tril_indices_from(mask)] = True

plt.figure(figsize=figsize, dpi= 80)

sns.heatmap(data.corr(method=method), \

xticklabels=data.corr(method=method).columns, \

yticklabels=data.corr(method=method).columns, cmap=camp, \

center=0, annot=True, \

fmt='.6f')

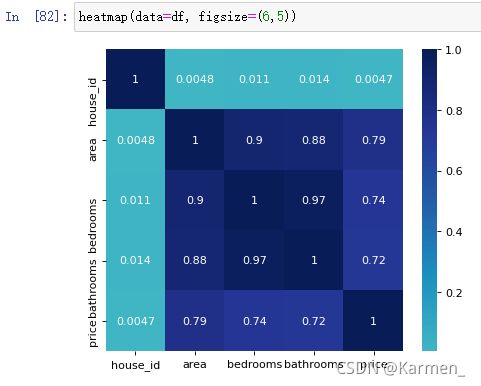

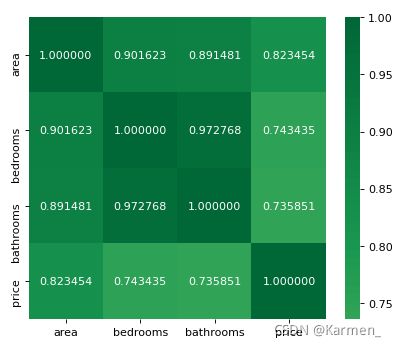

heatmap(data=new_data, figsize=(6,5))

我们发现这三个自变量和因变量的相关系数分别为0.82,0.74,0.73,说明具有很强的相关性

下面我们去这三个因变量作为X,price为Y来求线性回归:

x_data = new_data.iloc[:, 1:4] #are、bedrooms、bathroom对应列

y_data = new_data.iloc[:, -1] #price对应列

print(x_data, y_data, len(x_data))

# 应用模型

model = linear_model.LinearRegression()

model.fit(x_data, y_data)

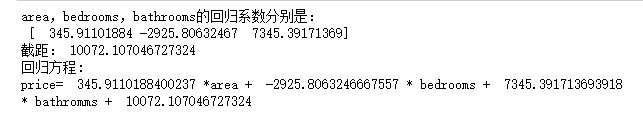

print("area,bedrooms,bathrooms的回归系数分别是:\n", model.coef_)

print("截距:", model.intercept_)

print('回归方程: price=',model.coef_[0],'*area +',model.coef_[1],'*bedrooms +',model.coef_[2],'*bathromms +',model.intercept_)

求的线性回归方程为:

price = 345.9110188400237 *area + -2925.8063246667557 * bedrooms + 7345.391713693918 * bathromms + 10072.107046727324

2. 清洗数据再求解

new_data_Z=new_data.iloc[:,0:]

new_data_IQR=new_data.iloc[:,0:]

# 异常值处理

# ================ 异常值检验函数:iqr & z分数 两种方法 =========================

def outlier_test(data, column, method=None, z=2):

""" 以某列为依据,使用 上下截断点法 检测异常值(索引) """

"""

full_data: 完整数据

column: full_data 中的指定行,格式 'x' 带引号

return 可选; outlier: 异常值数据框

upper: 上截断点; lower: 下截断点

method:检验异常值的方法(可选, 默认的 None 为上下截断点法),

选 Z 方法时,Z 默认为 2

"""

# ================== 上下截断点法检验异常值 ==============================

if method == None:

print(f'以 {column} 列为依据,使用 上下截断点法(iqr) 检测异常值...')

print('=' * 70)

# 四分位点;这里调用函数会存在异常

column_iqr = np.quantile(data[column], 0.75) - np.quantile(data[column], 0.25)

# 1,3 分位数

(q1, q3) = np.quantile(data[column], 0.25), np.quantile(data[column], 0.75)

# 计算上下截断点

upper, lower = (q3 + 1.5 * column_iqr), (q1 - 1.5 * column_iqr)

# 检测异常值

outlier = data[(data[column] <= lower) | (data[column] >= upper)]

print(f'第一分位数: {q1}, 第三分位数:{q3}, 四分位极差:{column_iqr}')

print(f"上截断点:{upper}, 下截断点:{lower}")

return outlier, upper, lower

# ===================== Z 分数检验异常值 ==========================

if method == 'z':

""" 以某列为依据,传入数据与希望分段的 z 分数点,返回异常值索引与所在数据框 """

"""

params

data: 完整数据

column: 指定的检测列

z: Z分位数, 默认为2,根据 z分数-正态曲线表,可知取左右两端的 2%,

根据您 z 分数的正负设置。也可以任意更改,知道任意顶端百分比的数据集合

"""

print(f'以 {column} 列为依据,使用 Z 分数法,z 分位数取 {z} 来检测异常值...')

print('=' * 70)

# 计算两个 Z 分数的数值点

mean, std = np.mean(data[column]), np.std(data[column])

upper, lower = (mean + z * std), (mean - z * std)

print(f"取 {z} 个 Z分数:大于 {upper} 或小于 {lower} 的即可被视为异常值。")

print('=' * 70)

# 检测异常值

outlier = data[(data[column] <= lower) | (data[column] >= upper)]

return outlier, upper, lower

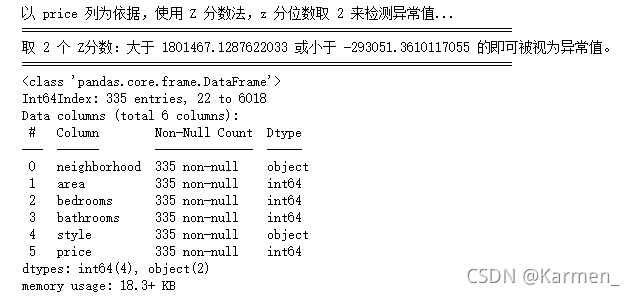

outlier, upper, lower = outlier_test(data=new_data_Z, column='price', method='z')

outlier.info(); outlier.sample(5)

# 这里简单的丢弃即可

new_data_Z.drop(index=outlier.index, inplace=True)

再调出原数据热力图

def heatmap(data, method='pearson', camp='Reds', figsize=(10 ,8)):

"""

data: 整份数据

method:默认为 pearson 系数

camp:默认为:RdYlGn-红黄蓝;YlGnBu-黄绿蓝;Blues/Greens 也是不错的选择

figsize: 默认为 10,8

"""

plt.figure(figsize=figsize, dpi= 80)

sns.heatmap(data.corr(method=method), \

xticklabels=data.corr(method=method).columns, \

yticklabels=data.corr(method=method).columns, cmap=camp, \

center=0, annot=True, \

fmt='.6f')

# 要想实现只是留下对角线一半的效果,括号内的参数可以加上 mask=mask

heatmap(data=new_data, figsize=(6,5))

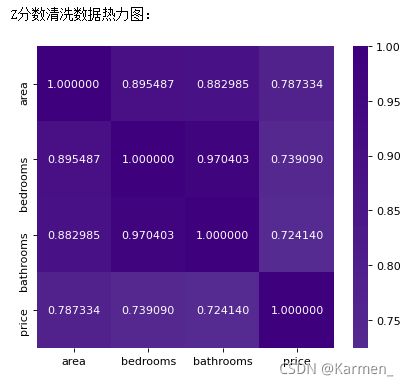

调出Z分数法清洗数据后的热力图

print("Z分数清洗数据热力图:"")

def heatmap(data, method='pearson', camp='Purples', figsize=(10 ,8)):

"""

data: 整份数据

method:默认为 pearson 系数

camp:默认为:RdYlGn-红黄蓝;YlGnBu-黄绿蓝;Blues/Greens 也是不错的选择

figsize: 默认为 10,8

"""

plt.figure(figsize=figsize, dpi= 80)

sns.heatmap(data.corr(method=method), \

xticklabels=data.corr(method=method).columns, \

yticklabels=data.corr(method=method).columns, cmap=camp, \

center=0, annot=True, \

fmt='.6f')

# 要想实现只是留下对角线一半的效果,括号内的参数可以加上 mask=mask

heatmap(data=new_data_Z, figsize=(6,5))

print("IQR法清洗数据热力图:")

def heatmap(data, method='pearson', camp='Blues', figsize=(10 ,8)):

"""

data: 整份数据

method:默认为 pearson 系数

camp:默认为:RdYlGn-红黄蓝;YlGnBu-黄绿蓝;Blues/Greens 也是不错的选择

figsize: 默认为 10,8

"""

plt.figure(figsize=figsize, dpi= 80)

sns.heatmap(data.corr(method=method), \

xticklabels=data.corr(method=method).columns, \

yticklabels=data.corr(method=method).columns, cmap=camp, \

center=0, annot=True, \

fmt='.6f')

# 要想实现只是留下对角线一半的效果,括号内的参数可以加上 mask=mask

heatmap(data=new_data_IQR, figsize=(6,5))

显而易见,清洗数据后各个自变量的相关性变弱了,但也代表我们获得了更加精确的结果。

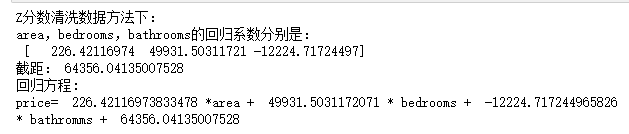

Z分数法的线性回归方程:

x_data = new_data_Z.iloc[:, 1:4]

y_data = new_data_Z.iloc[:, -1]

# 应用模型

model = linear_model.LinearRegression()

model.fit(x_data, y_data)

print("Z分数清洗数据方法下:")

print("area,bedrooms,bathrooms的回归系数分别是:\n", model.coef_)

print("截距:", model.intercept_)

print('回归方程: \nprice= ',model.coef_[0],'*area + ',model.coef_[1],'* bedrooms + ',model.coef_[2],'* bathromms + ',model.intercept_)

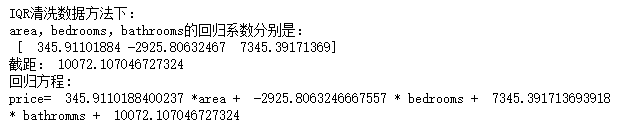

IQR法的线性回归方程:

x_data = new_data_IQR.iloc[:, 1:4]

y_data = new_data_IQR.iloc[:, -1]

# 应用模型

model = linear_model.LinearRegression()

model.fit(x_data, y_data)

print("IQR清洗数据方法下:")

print("area,bedrooms,bathrooms的回归系数分别是:\n", model.coef_)

print("截距:", model.intercept_)

print('回归方程: \nprice= ',model.coef_[0],'*area + ',model.coef_[1],'* bedrooms + ',model.coef_[2],'* bathromms + ',model.intercept_)

3. 结果对比

- 不清洗数据:

price = 345.9110188400237 *area + -2925.8063246667557 * bedrooms + 7345.391713693918 * bathromms + 10072.107046727324 - Z分数法清洗数据:

price= 226.42116973833478 *area + 49931.5031172071 * bedrooms + -12224.717244965826 * bathromms + 64356.04135007528 - IQR法清洗数据:

price= 345.9110188400237 *area + -2925.8063246667557 * bedrooms + 7345.391713693918 * bathromms + 10072.107046727324

四、总结

用Excel来做多元线性回归相对简单,但不能清洗数据,会有很多垃圾数据影响我们得到不准确的结果;而选择Python来做多元线性回归可以进行数据清洗,得到的结果会更加准确,更加贴合实际,并且可以结合matplotlib库中的数据图来使结果通俗易懂,更加美观。

而在Python3中,我们又使用了两种不同的库来做线性回归,一个是Statsmodels库,一个是Sklearn库:前者操作相对复杂,后者因为拥有一个线性模型库而变得相对简单,对于线性回归更具有针对性。

五、参考文章

最烦起名字嗄:基于多元线性回归的房价预测

萝 卜:【经典案例】 | 多元线性回归模型预测房价(附Python代码与数据)

醉意丶千层梦:sklearn多元线性回归预测房价