《吴恩达深度学习》学习笔记003_浅层神经网络(Shallow neural networks)

http://www.ai-start.com/dl2017/html/lesson1-week3.html

浅层神经网络(Shallow neural networks)

神经网络概述(Neural Network Overview)

公式3.1建立联系。 图3.1.1 :

公式3.1: KaTeX parse error: Expected group after '\right' at position 52: …d{array} \right}̲ \implies{z={w}…

如上所示,首先你需要输入特征 x x x,参数 w w w和 b b b,通过这些你就可以计算出 z z z,公式3.2: KaTeX parse error: Expected group after '\right' at position 52: …d{array} \right}̲ \implies{z={w}…

接下来使用 z z z就可以计算出 a a a。我们将的符号换为表示输出 y ^ ⟹ a = σ ( z ) \hat{y}\implies{a = \sigma(z)} y^⟹a=σ(z),然后可以计算出loss function L ( a , y ) L(a,y) L(a,y)

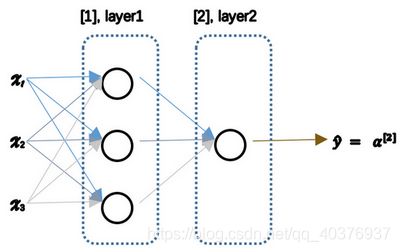

神经网络看起来是如下这个样子(图3.1.2)。正如我之前已经提到过,你可以把许多sigmoid单元堆叠起来形成一个神经网络。对于图3.1.1中的节点,它包含了之前讲的计算的两个步骤:首先通过公式3.1计算出值 z z z,然后通过 σ ( z ) \sigma(z) σ(z)计算值 a a a。

在这个神经网络(图3.1.2)对应的3个节点,首先计算第一层网络中的各个节点相关的数 z [ 1 ] z^{[1]} z[1],接着计算 α [ 1 ] \alpha^{[1]} α[1],在计算下一层网络同理; 我们会使用符号 [ m ] ^{[m]} [m]表示第 m m m层网络中节点相关的数,这些节点的集合被称为第 m m m层网络。这样可以保证 [ m ] ^{[m]} [m]不会和我们之前用来表示单个的训练样本的 ( i ) ^{(i)} (i)(即我们使用表示第 i i i个训练样本)混淆; 整个计算过程,公式如下: 公式3.3: KaTeX parse error: Expected group after '\right' at position 71: …d{array} \right}̲ \implies{z^{[1… 公式3.4: KaTeX parse error: Expected group after '\right' at position 116: …d{array} \right}̲ \implies{z^{[2…

类似逻辑回归,在计算后需要使用计算,接下来你需要使用另外一个线性方程对应的参数计算 z [ 2 ] z^{[2]} z[2], 计算 a [ 2 ] a^{[2]} a[2],此时 a [ 2 ] a^{[2]} a[2]就是整个神经网络最终的输出,用 y ^ \hat{y} y^表示网络的输出。

公式3.5: KaTeX parse error: Expected group after '\right' at position 101: …d{array} \right}̲ \impliedby{{dz…

我知道这其中有很多细节,其中有一点非常难以理解,即在逻辑回归中,通过直接计算 z z z得到结果 a a a。而这个神经网络中,我们反复的计算 z z z和 a a a,计算 a a a和 z z z,最后得到了最终的输出loss function。

你应该记得逻辑回归中,有一些从后向前的计算用来计算导数 d a da da、 d z dz dz。同样,在神经网络中我们也有从后向前的计算,看起来就像这样,最后会计算 d a [ 2 ] da^{[2]} da[2] 、 d z [ 2 ] dz^{[2]} dz[2],计算出来之后,然后计算计算 d W [ 2 ] dW^{[2]} dW[2]、 d b [ 2 ] db^{[2]} db[2] 等,按公式3.4、3.5箭头表示的那样,从右到左反向计算。

现在你大概了解了一下什么是神经网络,基于逻辑回归重复使用了两次该模型得到上述例子的神经网络。我清楚这里面多了很多新符号和细节,如果没有理解也不用担心,在接下来的视频中我们会仔细讨论具体细节。

那么,下一个视频讲述神经网络的表示。

神经网络的表示(Neural Network Representation)

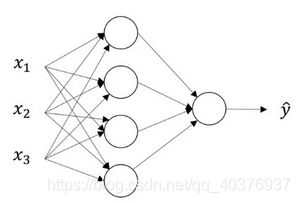

我们有输入特征 x 1 x_1 x1、 x 2 x_2 x2、 x 3 x_3 x3,它们被竖直地堆叠起来,这叫做神经网络的输入层。它包含了神经网络的输入;然后这里有另外一层我们称之为隐藏层(图3.2.1的四个结点)。待会儿我会回过头来讲解术语"隐藏"的意义;在本例中最后一层只由一个结点构成,而这个只有一个结点的层被称为输出层,它负责产生预测值。解释隐藏层的含义:在一个神经网络中,当你使用监督学习训练它的时候,训练集包含了输入 x x x也包含了目标输出 y y y,所以术语隐藏层的含义是在训练集中,这些中间结点的准确值我们是不知道到的,也就是说你看不见它们在训练集中应具有的值。你能看见输入的值,你也能看见输出的值,但是隐藏层中的东西,在训练集中你是无法看到的。所以这也解释了词语隐藏层,只是表示你无法在训练集中看到他们。

现在我们再引入几个符号,就像我们之前用向量 x x x表示输入特征。这里有个可代替的记号 a [ 0 ] a^{[0]} a[0]可以用来表示输入特征。 a a a表示激活的意思,它意味着网络中不同层的值会传递到它们后面的层中,输入层将 x x x传递给隐藏层,所以我们将输入层的激活值称为 a [ 0 ] a^{[0]} a[0];下一层即隐藏层也同样会产生一些激活值,那么我将其记作 a [ 1 ] a^{[1]} a[1],所以具体地,这里的第一个单元或结点我们将其表示为 a [ 1 ] 1 a^{[1]}{1} a[1]1,第二个结点的值我们记为 a [ 1 ] 2 a^{[1]}{2} a[1]2以此类推。所以这里的是一个四维的向量如果写成Python代码,那么它是一个规模为4x1的矩阵或一个大小为4的列向量,如下公式,它是四维的,因为在本例中,我们有四个结点或者单元,或者称为四个隐藏层单元; 公式3.7 a [ 1 ] = [ a [ 1 ] 1 a [ 1 ] 2 a [ 1 ] 3 a [ 1 ] 4 ] a^{[1]} = \left[ \begin{array}{ccc} a^{[1]}{1}\ a^{[1]}{2}\ a^{[1]}{3}\ a^{[1]}{4} \end{array} \right] a[1]=[a[1]1 a[1]2 a[1]3 a[1]4]

最后输出层将产生某个数值 a a a,它只是一个单独的实数,所以的 y ^ \hat{y} y^值将取为 a [ 2 ] a^{[2]} a[2]。这与逻辑回归很相似,在逻辑回归中,我们有 y ^ \hat{y} y^直接等于 a a a,在逻辑回归中我们只有一个输出层,所以我们没有用带方括号的上标。但是在神经网络中,我们将使用这种带上标的形式来明确地指出这些值来自于哪一层,有趣的是在约定俗成的符号传统中,在这里你所看到的这个例子,只能叫做一个两层的神经网络(图3.2.2)。原因是当我们计算网络的层数时,输入层是不算入总层数内,所以隐藏层是第一层,输出层是第二层。第二个惯例是我们将输入层称为第零层,所以在技术上,这仍然是一个三层的神经网络,因为这里有输入层、隐藏层,还有输出层。但是在传统的符号使用中,如果你阅读研究论文或者在这门课中,你会看到人们将这个神经网络称为一个两层的神经网络,因为我们不将输入层看作一个标准的层。

最后,我们要看到的隐藏层以及最后的输出层是带有参数的,这里的隐藏层将拥有两个参数 W W W和 b b b,我将给它们加上上标 [ 1 ] ^{[1]} [1]( W [ 1 ] W^{[1]} W[1], b [ 1 ] b^{[1]} b[1]),表示这些参数是和第一层这个隐藏层有关系的。之后在这个例子中我们会看到 W W W是一个4x3的矩阵,而 b b b是一个4x1的向量,第一个数字4源自于我们有四个结点或隐藏层单元,然后数字3源自于这里有三个输入特征,我们之后会更加详细地讨论这些矩阵的维数,到那时你可能就更加清楚了。相似的输出层也有一些与之关联的参数 W [ 2 ] W^{[2]} W[2]以及 b [ 2 ] b^{[2]} b[2]。从维数上来看,它们的规模分别是1x4以及1x1。1x4是因为隐藏层有四个隐藏层单元而输出层只有一个单元,之后我们会对这些矩阵和向量的维度做出更加深入的解释,所以现在你已经知道一个两层的神经网络什么样的了,即它是一个只有一个隐藏层的神经网络。

计算一个神经网络的输出(Computing a Neural Network’s output)

多样本向量化(Vectorizing across multiple examples)

向量化实现的解释(Justification for vectorized implementation)

激活函数(Activation functions)

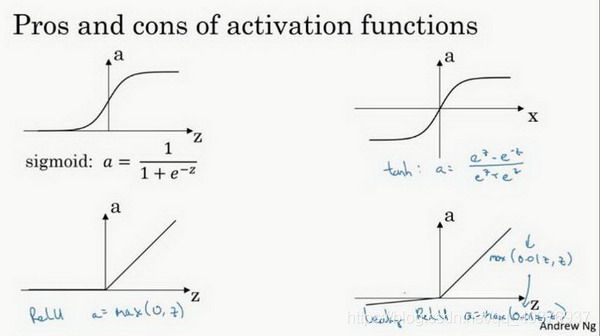

使用一个神经网络时,需要决定使用哪种激活函数用隐藏层上,哪种用在输出节点上。到目前为止,之前的视频只用过sigmoid激活函数,但是,有时其他的激活函数效果会更好。

在神经网路的前向传播中,的 a [ 1 ] = σ ( z [ 1 ] ) a^{[1]} = \sigma(z^{[1]}) a[1]=σ(z[1])和 a [ 2 ] = σ ( z [ 2 ] ) a^{[2]} =\sigma(z^{[2]}) a[2]=σ(z[2])这两步会使用到sigmoid函数。sigmoid函数在这里被称为激活函数。 公式3.18: a = σ ( z ) = 1 1 + e − z a = \sigma(z) = \frac{1}{{1 + e}^{- z}} a=σ(z)=1+e−z1

更通常的情况下,使用不同的函数 g ( z [ 1 ] ) g( z^{[1]}) g(z[1]), g g g可以是除了sigmoid函数以外的非线性函数。tanh函数或者双曲正切函数是总体上都优于sigmoid函数的激活函数。

如图, a = t a n ( z ) a = tan(z) a=tan(z)的值域是位于+1和-1之间。 公式3.19: a = t a n h ( z ) = e z − e − z e z + e − z a= tanh(z) = \frac{e^{z} - e^{- z}}{e^{z} + e^{- z}} a=tanh(z)=ez+e−zez−e−z

事实上,tanh函数是sigmoid的向下平移和伸缩后的结果。对它进行了变形后,穿过了 ( 0 , 0 ) (0,0) (0,0)点,并且值域介于+1和-1之间。

结果表明,如果在隐藏层上使用函数 公式3.20: $g(z^{[1]}) = tanh(z^{[1]}) $ 效果总是优于sigmoid函数。因为函数值域在-1和+1的激活函数,其均值是更接近零均值的。在训练一个算法模型时,如果使用tanh函数代替sigmoid函数中心化数据,使得数据的平均值更接近0而不是0.5.

这会使下一层学习简单一点,在第二门课中会详细讲解。

在讨论优化算法时,有一点要说明:我基本已经不用sigmoid激活函数了,tanh函数在所有场合都优于sigmoid函数。

但有一个例外:在二分类的问题中,对于输出层,因为 y y y的值是0或1,所以想让 y ^ \hat{y} y^的数值介于0和1之间,而不是在-1和+1之间。所以需要使用sigmoid激活函数。这里的 公式3.21: g ( z [ 2 ] ) = σ ( z [ 2 ] ) g(z^{[2]}) = \sigma(z^{[2]}) g(z[2])=σ(z[2]) 在这个例子里看到的是,对隐藏层使用tanh激活函数,输出层使用sigmoid函数。

所以,在不同的神经网络层中,激活函数可以不同。为了表示不同的激活函数,在不同的层中,使用方括号上标来指出 g g g上标为 [ 1 ] [1] [1]的激活函数,可能会跟 g g g上标为 [ 2 ] [2] [2]不同。方括号上标 [ 1 ] [1] [1]代表隐藏层,方括号上标 [ 2 ] [2] [2]表示输出层。

sigmoid函数和tanh函数两者共同的缺点是,在 z z z特别大或者特别小的情况下,导数的梯度或者函数的斜率会变得特别小,最后就会接近于0,导致降低梯度下降的速度。

在机器学习另一个很流行的函数是:修正线性单元的函数(ReLu),ReLu函数图像是如下图。 公式3.22: $ a =max( 0,z) $ 所以,只要 z z z是正值的情况下,导数恒等于1,当 z z z是负值的时候,导数恒等于0。从实际上来说,当使用 z z z的导数时, z z z=0的导数是没有定义的。但是当编程实现的时候, z z z的取值刚好等于0.00000001,这个值相当小,所以,在实践中,不需要担心这个值, z z z是等于0的时候,假设一个导数是1或者0效果都可以。

这有一些选择激活函数的经验法则:

如果输出是0、1值(二分类问题),则输出层选择sigmoid函数,然后其它的所有单元都选择Relu函数。

这是很多激活函数的默认选择,如果在隐藏层上不确定使用哪个激活函数,那么通常会使用Relu激活函数。有时,也会使用tanh激活函数,但Relu的一个优点是:当 z z z是负值的时候,导数等于0。

这里也有另一个版本的Relu被称为Leaky Relu。

当 z z z是负值时,这个函数的值不是等于0,而是轻微的倾斜,如图。

这个函数通常比Relu激活函数效果要好,尽管在实际中Leaky ReLu使用的并不多。

第一,在 z z z的区间变动很大的情况下,激活函数的导数或者激活函数的斜率都会远大于0,在程序实现就是一个if-else语句,而sigmoid函数需要进行浮点四则运算,在实践中,使用ReLu激活函数神经网络通常会比使用sigmoid或者tanh激活函数学习的更快。

第二,sigmoid和tanh函数的导数在正负饱和区的梯度都会接近于0,这会造成梯度弥散,而Relu和Leaky ReLu函数大于0部分都为常数,不会产生梯度弥散现象。(同时应该注意到的是,Relu进入负半区的时候,梯度为0,神经元此时不会训练,产生所谓的稀疏性,而Leaky ReLu不会有这问题)

z z z在ReLu的梯度一半都是0,但是,有足够的隐藏层使得z值大于0,所以对大多数的训练数据来说学习过程仍然可以很快。

快速概括一下不同激活函数的过程和结论。

sigmoid激活函数:除了输出层是一个二分类问题基本不会用它。

tanh激活函数:tanh是非常优秀的,几乎适合所有场合。

ReLu激活函数:最常用的默认函数,,如果不确定用哪个激活函数,就使用ReLu或者Leaky ReLu。公式3.23: a = m a x ( 0.01 z , z ) a = max( 0.01z,z) a=max(0.01z,z) 为什么常数是0.01?当然,可以为学习算法选择不同的参数。

在选择自己神经网络的激活函数时,有一定的直观感受,在深度学习中的经常遇到一个问题:在编写神经网络的时候,会有很多选择:隐藏层单元的个数、激活函数的选择、初始化权值……这些选择想得到一个对比较好的指导原则是挺困难的。

鉴于以上三个原因,以及在工业界的见闻,提供一种直观的感受,哪一种工业界用的多,哪一种用的少。但是,自己的神经网络的应用,以及其特殊性,是很难提前知道选择哪些效果更好。所以通常的建议是:如果不确定哪一个激活函数效果更好,可以把它们都试试,然后在验证集或者发展集上进行评价。然后看哪一种表现的更好,就去使用它。

为自己的神经网络的应用测试这些不同的选择,会在以后检验自己的神经网络或者评估算法的时候,看到不同的效果。如果仅仅遵守使用默认的ReLu激活函数,而不要用其他的激励函数,那就可能在近期或者往后,每次解决问题的时候都使用相同的办法。