用于恶劣天气条件下目标检测的图像自适应 YOLO

目录

Abstract

Introduction

Related Work

Object Detection

Image Adaptation

Object Detection in Adverse Conditions

Proposed Method

DIP Module

CNN-PP Module

Detection Network Module

Hybrid Data Training

Conclusion

论文原文

论文代码

Abstract

尽管基于深度学习的目标检测方法已经在传统数据集上取得了可喜的结果,但现在从低质量图像,例如在恶劣的天气条件下捕获定位对象,仍然具有挑战性。现有方法要么难以平衡图像增强和目标检测,或者经常忽略潜在的有利于检测的信息。为了缓解这个问题,我们提出了一种新颖的图像自适应 YOLO (IA-YOLO)框架,其中每个图像都可以自适应地增强更好的检测性能。具体来说,提出了一个可微分图像处理(DIP)模块来考虑YOLO 探测器的恶劣天气条件,其参数由小型卷积神经网络 (CNN-PP) 预测。我们联合学习 CNN-PP 和 YOLOv3一种端到端的方式,确保 CNN-PP 可以以弱监督方式学习适当的 DIP 以增强图像。我们提出的 IA-YOLO 方法可以自适应地处理正常和不利的图像天气状况。实验结果非常好,证明了我们提出的 IA YOLO 方法在有雾和弱光场景中的有效性。

Introduction

基于 CNN 的方法已在目标检测中盛行(Ren et al. 2015; Redmon and Farhadi 2018)。他们不仅在基准数据集测试中取得了可喜的表现(Deng 等人,2009;Everingham 等人,2010;Lin 等人,2014),也在已部署在实际应用中,例如自动驾驶(Wang et al. 2019)。由于输入图像的域偏移(Sindagi et al. 2020),由高质量图像训练的通用目标检测模型在不利的天气条件下(例如,有雾和暗光)往往无法取得令人满意的结果。Narasimhan 和 Nayar (2002) 和 You 等人(2015)建议在恶劣天气下捕获的图像可以分解为清晰的图像及其对应的天气信息,而恶劣天气下的图像质量下降主要是由天气下信息和对象之间的相互作用引起的,这导致检测性能不佳。图 1 显示了一个在有雾的条件下对象检测示例。以看出,如果图像能够针对天气状况进行适当的增强,更多关于原始模糊对象的潜在信息和识别错误的对象可以恢复。

为了解决这个具有挑战性的问题,Huang、Le 和 Jaw(2020)采用两个子网络来共同学习可见性增强和对象检测,其中通过共享特征提取层来减少图像退化。但是训练的参数很难平衡检测和恢复。另一种方法是稀释影响通过预处理图像来获取特定于天气的信息,现有方法,例如图像去雾(Hang et al. 2020;刘等人。 2019)和图像增强(Guo et al. 2020)。然而,在这些方法中复杂的图像恢复网络需要通过像素级监督单独训练。这需要手动标记图像以进行恢复。这个问题也可以被视为无监督的域适应任务(Chen等。 2018; Hnewa 和 Radha 2021)。与训练有清晰图像(源图像)的探测器相比,假设在恶劣天气下拍摄的图像(目标图像)有分布转变。这些方法大多采用域适应原则,侧重于对齐两个分布的特征,而在基于天气的图像恢复过程中可以获得的潜在信息通常被忽略。

为了解决上述限制,我们提出了一个巧妙的图像自适应目标检测方法,称为 IA-YOLO。具体来说,我们建议使用完全可微分的图像处理模块(DIP),其超参数是自适应的,由基于 CNN 的小型参数预测器 (CNN PP) 学习。 CNN-PP 根据输入图像的亮度、颜色、色调和天气特定信息自适应地预测 DIP 的超参数。经DIP模块处理后,可以抑制图像中特定天气信息的干扰,同时恢复潜在信息。我们提出了一个联合优化方案学习 DIP、CNN-PP 和 YOLOv3 主干检测网络(Redmon 和 Farhadi 2018)以端到端的方式。为了增强图像进行检测,CNN-PP 是一种弱监督方式通过边界框注释,学习适当的 DIP。此外,我们利用在正常和恶劣的天气条件下的图像进行训练。通过利用 CNN-PP 网络,我们提出的 IA-YOLO 方法能够自适应地处理受不同程度天气影响的图像。图 1 显示了通过我们提出的方法的检测结果的示例。

这项工作的亮点是:1)提出了一个图像自适应检测框架,在正常和恶劣天气条件下有很好的表现;2) 提出一个 white-box 可微分图像处理模块,其超参数由弱监督预测网络训练得到; 3) 与以前的方法进行比较,在两个合成数据集上(VOC_Foggy 和 VOC_Dark)和真实世界数据集(RTTS 和 ExDark)都获得了很好的实验结果。

Object Detection

作为计算机视觉中的一项基本任务,目标检测受到了广泛的关注。目标检测方法大致可以分为两类(Zhao et al. 2019)。一类是基于区域提议的方法(Girshick et al. 2014; Girshick 2015; Ren et al. 2015),它首先从图像中生成感兴趣区域(RoI),然后通过训练神经网络对它们进行分类。另一类是基于单阶段回归的方法,例如 YOLO 系列 (Redmon et al. 2016; Redmon and Farhadi 2017, 2018; Bochkovskiy, Wang, and Liao 2020) 和 SSD (Liu et al. 2016),其中对象标签和边界框坐标由单个 CNN 预测。在本文中,我们采用经典的单级检测器 YOLOv3(Redmon 和 Farhadi 2018)作为基线检测器,并提高其在不利条件下的性能。

Image Adaptation

图像自适应广泛应用于图像增强。为了适当增强图像,一些传统方法(Polesel, Ramponi, and Mathews 2000; Yu and Bajaj 2004; Wang et al. 2021)根据对应的图像特征。例如,王等人(2021)提出了一种亮度调整函数,根据输入图像的光照分布特征自适应地调整增强参数。为了实现自适应图像增强,(Hu et al. 2018; Yu et al. 2018; Zeng et al. 2020)采用小型 CNN 来灵活学习图像变换的超参数。胡等人(2018)提出了一种具有一组可微过滤器的后处理框架,其中使用深度强化学习(DRL)根据当前修饰图像的质量生成图像操作和过滤器参数。曾等人 (2020) 利用小型 CNN 根据亮度、颜色和色调等全局上下文来学习图像自适应 3D LUT。

Object Detection in Adverse Conditions

与一般的目标检测相比,关于恶劣天气条件下的目标检测的研究很少。一种直接的方法是使用经典的去雾或图像增强方法对图像进行预处理(Guo et al. 2020; He, Sun, and Tang 2009; Liu et al. 2019; Hang et al. 2020; Qin et al. 2020; 2020),最初旨在去除雾气并提高图像质量。然而,图像质量的提高不一定有利于检测性能。一些基于先验的方法(Li et al. 2017; Huang, Le, and Jaw 2020)联合执行图像增强和检测,以减弱不利天气特定信息的干扰。辛达吉等人。 (2020)提出了一种无监督的基于先验的域对抗对象检测框架,用于在朦胧和多雨的条件下进行检测。一些方法(Chen et al. 2018; Zhang et al. 2021; Hnewa and Radha 2021)利用域适应来解决这个问题。 Hnewa 和 Radha (2021) 假设在正常和不利天气条件下捕获的图像之间存在域偏移。他们设计了一个多尺度域自适应 YOLO,在特征提取阶段支持不同层的域自适应。

Proposed Method

在恶劣天气条件下拍摄的图像,由于天气特定信息的干扰,能见度差,导致目标检测困难。 为了应对这一挑战,我们建议通过去除天气特定信息并揭示更多潜在信息来使用图像自适应检测框架。 如图 2 所示,整个网络由基于 CNN 的参数预测器(CNN PP)、可微分图像处理模块(DIP)和检测网络组成。 我们首先将输入图像调整为 256 × 256 的大小,并将其输入 CNN-PP 以预测 DIP 的参数。 然后,将经过 DIP 模块过滤的图像作为 YOLOv3 检测器的输入。 我们提出了一种具有检测损失的端到端混合数据训练方案,以便 CNN-PP 可以学习适当的 DIP 以增强图像以进行弱监督的目标检测。

DIP Module

与 (Hu et al. 2018) 一样,图像过滤器的设计应该符合可微性和分辨率独立的原则。对于 CNN-PP 的基于梯度的优化,滤波器应该是可微的,以允许通过反向传播训练网络。由于 CNN 处理高分辨率图像(例如 4000×3000)会消耗大量计算资源,因此本文从 256×256 的下采样低分辨率图像中学习滤波器参数,然后将相同的滤波器应用于原始分辨率的图像。因此,这些过滤器需要独立于图像分辨率。

我们提出的 DIP 模块由六个具有可调节超参数的可微滤波器组成,包括去雾、白平衡 (WB)、伽玛、对比度、色调和锐化。与 (Hu et al. 2018) 一样,WB、Gamma、Contrast 和 Tone 等标准颜色和色调算子可以表示为像素级过滤器。因此,我们设计的滤镜可以分为去雾、像素级滤镜和锐化。在这些滤镜中,去雾滤镜是专门为有雾的场景设计的。详细情况如下。

Pixel-wise Filters.像素级过滤器映射输入像素值 Pi = (ri, gi, bi) 转化为输出像素值Po = (ro, go, bo),其中 (r, g, b) 表示三个颜色通道分别为红色、绿色和蓝色。表 1 列出了四个像素级过滤器的映射函数,其中第二列列出了我们方法中要优化的参数。 WB 和 Gamma 是简单的乘法和幂变换。 显然,它们的映射函数对于输入图像和参数都是可微的。

可微对比度滤波器设计有一个输入参数来设置原始图像和完全增强图像之间的线性插值。 如表1所示,映射函数中En(Pi)的定义如下:

与 (Hu et al. 2018) 一样,我们将色调滤波器设计为单调和分段线性函数。 我们学习带有 L 个参数的色调滤波器,表示为 {t0, t1, . . . , tL-1}。 色调曲线的点表示为 (k/L, Tk/TL)。此外,映射函数由可微参数表示,这使得

函数对于图像和参数 {t0, t1, . . . , tL-1}两个输入都是可微的,如下:

Sharpen Filter. 图像锐化可以突出图像细节。 与不锐化蒙版技术(Polesel、Ram poni 和 Mathews 2000)一样,锐化过程可以描述如下:

其中 I(x) 是输入图像,Gau(I(x)) 表示高斯滤波器,λ 是正比例因子。 这种锐化操作对于 x 和 λ 都是可微的。 请注意,可以通过优化 λ 来调整锐化度以获得更好的目标检测性能。

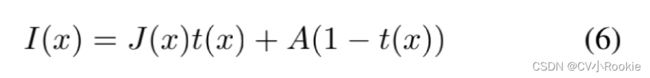

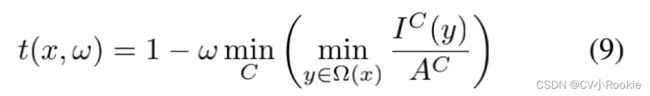

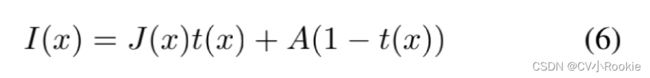

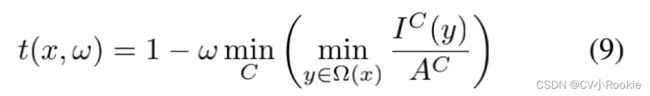

Defog Filter. 受暗通道先验方法 (He, Sun, and Tang 2009) 的启发,我们设计了一个具有可学习参数的除雾过滤器。 基于大气散射模型(McCartney 1976;Narasimhan 和 Nayar 2002),模糊图像的形成可以表述如下:

其中 I(x) 是有雾的图像,J(x) 表示场景辐射度(干净的图像)。 A为全球大气光,t(x)为介质透射图,定义为:

其中 β 表示大气的散射系数,d(x) 是场景深度。

为了恢复干净的图像J(x),关键是获得大气光A和透射图t(x)。 为此,我们首先计算暗通道图并选择前 1000 个最亮的像素。 然后,通过平均雾度图像 I(x) 的这 1000 个像素来估计 A。

根据方程式 (6), 可以推导出 t(x) 的近似解如下(He, Sun, and Tang 2009):

我们进一步引入一个参数 ω 来控制去雾,如下所示:

由于上述操作是可微分的,我们可以通过反向传播优化 ω,使去雾滤波器更有利于雾图像检测。

CNN-PP Module

在相机图像信号处理 (ISP) 管道中,通常采用一些可调整的滤波器来进行图像增强,其超参数由经验丰富的工程师通过目视检查手动调整 (Mosleh et al. 2020)。通常,这样的调整过程对于为广泛的场景寻找合适的参数是非常尴尬和昂贵的。为了解决这个限制,我们建议使用一个小的 CNN 作为参数预测器来估计超参数,这是非常有效的。

以有雾的场景为例,CNN-PP 的目的是通过了解图像的全局内容,如亮度、颜色和色调,以及雾的程度来预测 DIP 的参数。 因此,下采样的图像足以估计这些信息,可以大大节省计算成本。 给定任何分辨率的输入图像,我们只需使用双线性插值将其下采样到 256 × 256 分辨率。 如图 2 所示,CNN-PP 网络由五个卷积块和两个全连接层组成。 每个卷积块包括一个步长为 2 的 3×3 卷积层和一个LeakyRelu。 最后的全连接层输出 DIP 模块的超参数。 这五个卷积层的输出通道分别为 16、32、32、32 和 32。 当参数总数为 15 时,CNN-PP 模型仅包含 165K 参数。

Detection Network Module

在本文中,我们选择单级检测器 YOLOv3 作为检测网络,该检测器广泛应用于实际应用,包括图像编辑、安全监控、人群检测和自动驾驶(Zhang et al. 2021)。与之前的版本相比,YOLOv3 基于 Resnet 的思想(He et al. 2016)设计了由连续的 3×3 和 1×1 卷积层组成的darknet 53。它通过对多尺度特征图进行预测来实现多尺度训练,从而进一步提高检测精度,尤其是对小物体的检测精度。我们采用与原始 YOLOv3 (Redmon and Farhadi 2018) 相同的网络架构和损失函数。

Hybrid Data Training

为了在正常和不利的天气条件下都达到理想的检测性能,我们对 IA-YOLO 采用了混合数据训练方案。每张图像有 2/3 的概率被随机添加某种雾或被转换为低光图像,然后再输入到网络进行训练。使用正常和合成的低质量训练数据,整个网络使用 YOLOv3 检测损失进行端到端训练,确保 IA-YOLO 中的所有模块能够相互适应。因此,CNN-PP 模块受到检测损失的弱监督,而无需手动标记地面真实图像。混合数据训练模式保证了IA-YOLO能够根据每张图像的内容对图像进行自适应处理,从而达到较高的检测性能。

Conclusion

我们提出了一种新颖的 IA-YOLO 方法来改进恶劣天气条件下的对象检测,其中每个输入图像都经过自适应增强以获得更好的检测性能。 开发了一个完全可微分的图像处理模块,通过删除 YOLO 检测器的天气特定信息来恢复潜在内容,其超参数由小型卷积神经网络预测。 此外,整个框架以端到端的方式进行训练,其中参数预测网络受到弱监督,以通过检测损失学习适当的 DIP 模块。 通过利用混合训练和参数预测网络,我们提出的方法能够自适应地处理正常和不利的天气条件。 实验结果表明,我们的方法在有雾和弱光场景中的表现都比以前的方法好得多。